Các tổ chức hiện đại đang chiếm lấy lợi thế cạnh tranh đáng kể bằng cách sử dụng các ứng dụng tiên tiến và xử lý dữ liệu trong hoạt động kinh doanh và quản lý hàng ngày. Các ứng dụng này bao gồm các mô hình ngôn ngữ lớn dựa trên Trí Tuệ Nhân Tạo (AI) như ChatGPT, LLaMa và nhiều ứng dụng khác, phân tích máy học dựa trên dữ liệu đào tạo và dữ liệu thực tế lớn, mô hình phức tạp và mô phỏng 3D, cùng với các ứng dụng yêu cầu xử lý dữ liệu và tính toán cao cấp.

Tất cả những khối công việc này có điểm chung: họ đều tận hưởng sự hỗ trợ đáng kể từ việc truy cập lưu trữ nhanh chóng qua bất kỳ mô hình phân cấp nào bạn có thể sử dụng. Đây là một trong những lý do chính tại sao nhiều tổ chức và nhà cung cấp dịch vụ đã chuyển sang sử dụng máy chủ dựa trên GPU để xử lý các tập dữ liệu lớn và các khối công việc khác nhau. Chúng có khả năng xử lý những công việc này hiệu quả hơn và hoàn thành nhanh hơn so với các máy chủ thông thường có cấu hình lưu trữ tiêu chuẩn hơn (như RAM cục bộ và ổ đĩa NVMe SSD, với các tầng lưu trữ bổ sung trên mạng LAN hoặc đám mây).

Bí quyết để tăng hiệu suất là giảm độ trễ và tăng băng thông lưu trữ. Điều này dẫn đến cải thiện năng suất và khả năng, chủ yếu thông qua các kỹ thuật thông minh về IO và mạng sử dụng truy cập bộ nhớ trực tiếp và từ xa. Việc đào tạo mô hình và hoàn thành công việc nhanh chóng có nghĩa là các ứng dụng được hỗ trợ bởi trí tuệ nhân tạo có thể triển khai nhanh hơn và thực hiện công việc nhanh hơn, giúp tiết kiệm thời gian và tối ưu hóa giá trị sáng tạo.

Truy Cập Bộ Nhớ Trực Tiếp và Các Phương Thức Từ Xa

Truy cập bộ nhớ trực tiếp (DMA) đã từ lâu là một công cụ hữu ích để tăng cường hiệu suất IO kể từ những ngày đầu của máy tính. Đơn giản, DMA liên quan đến việc di chuyển dữ liệu từ một bộ nhớ này sang một bộ nhớ khác thông qua một bus (hoặc giao diện khác) từ một thiết bị sang một thiết bị khác. Nó hoạt động bằng cách sao chép một dãy địa chỉ bộ nhớ trực tiếp từ bộ nhớ của thiết bị gửi sang bộ nhớ của thiết bị nhận (hoặc giữa hai bên cho truyền dữ liệu hai chiều). Tính năng này loại bỏ sự tham gia của CPU trong quá trình này và tăng tốc truyền dữ liệu bằng cách giảm số lần sao chép (điều này có nghĩa là CPU không cần sao chép dữ liệu từ thiết bị gửi vào bộ nhớ của nó, sau đó sao chép dữ liệu đó từ bộ nhớ của nó vào bộ nhớ của thiết bị nhận).

Thực tế, hiệu suất của DMA trên một hệ thống duy nhất chỉ bị giới hạn bởi tốc độ của bus (hoặc giao diện khác) kết nối giữa các thiết bị gửi và thiết bị nhận liên quan đến việc truyền dữ liệu. Với PCIe 4.0, tốc độ đó là 16 gigatransfers/giây (GT/s), và gấp đôi số lượng đó cho PCIe 5.0 (32 GT/s). Tốc độ truyền dữ liệu thực tế chậm hơn một chút do chi phí mã hóa và đóng gói, nhưng băng thông định mức cho hai phiên bản PCIe này là 64 Gbps (4.0) và 128 Gbps (5.0) lần lượt. Điều đó thật nhanh chóng!

Truy cập bộ nhớ từ xa (RDMA) mở rộng khả năng của DMA từ một máy tính duy nhất để làm việc giữa một cặp thiết bị qua kết nối mạng. RDMA thường dựa trên một giao diện lập trình ứng dụng (API) riêng biệt hoạt động với phần cứng và phần mềm mạng chuyên biệt để cung cấp nhiều lợi ích tương tự của DMA cục bộ trong phạm vi công nghệ mạng cơ bản cho phép.

GPU của NVIDIA hỗ trợ ba công nghệ mạng như vậy, theo thứ tự từ nhanh đến chậm (và đắt tiền hơn):

- NVIDIA NVLink sử dụng các giao diện và công nghệ chuyển mạch chủ quyền tốc độ cao nhất để tăng tốc truyền dữ liệu giữa các GPU trên mạng tốc độ cao. Hiện tại, nó đạt hiệu suất cao nhất trên các tiêu chuẩn thử nghiệm MLPerf Training v3.0 cho bất kỳ công nghệ nào. Một GPU Tensor Core H100 của NVIDIA hỗ trợ đến 18 kết nối NVLink cho tới 900 Gbps (gấp 7 lần tốc độ hiệu quả của PCIe 5.0).

- InfiniBand là một tiêu chuẩn mạng tốc độ cao được giám sát bởi Hiệp hội Thương mại InfiniBand (IBTA) và được triển khai rộng rãi trên các mạng hiệu suất cao. Tốc độ dữ liệu đo lường cao nhất của nó khoảng (1,2 Tbps, ~154 GBps) tính đến năm 2020.

- Ethernet là một công nghệ mạng tiêu chuẩn với nhiều biến thể, bao gồm TbE (~125 GBps ít được sử dụng) và 400 GbE (50 GBps phổ biến hơn). Nó có lợi thế về chi phí hơn, được triển khai rộng rãi và là công nghệ quen thuộc trong nhiều trung tâm dữ liệu.

Sử Dụng GPU NVIDIA trong Máy Chủ Supermicro

Công nghệ RDMA của NVIDIA là một bước tiến quan trọng giúp tối ưu hóa truy cập dữ liệu dựa trên GPU thông qua ba công nghệ mạng mạnh mẽ. Mỗi công nghệ mạng này đem lại sự kết hợp độc đáo giữa hiệu suất và giá trị, với hiệu suất càng cao thì giá trị càng tăng, và tổ chức có sự lựa chọn tốt hơn khi chọn kết nối phù hợp với ngân sách và yêu cầu cụ thể của họ. Hiểu rõ rằng mỗi lựa chọn đại diện cho một sự cân đối độc đáo giữa giá cả và hiệu suất mà tổ chức có thể tận dụng. Các ứng dụng dựa trên trí tuệ nhân tạo hoặc học máy, cũng như các ứng dụng khác đòi hỏi tính toán và xử lý dữ liệu cao, khi chạy trên máy chủ, có thể tận dụng mô hình lưu trữ GPU phân cấp.

Mô hình lưu trữ GPU phân cấp này bao gồm các tầng sau đây (sắp xếp theo thứ tự từ hiệu suất cao nhất đến thấp nhất, và từ nhỏ đến lớn về dung lượng):

- Tầng 1 – Bộ nhớ GPU: Đây là tầng nhanh nhất và có dung lượng nhỏ nhất, nhưng cũng đắt nhất. Ví dụ, GPU Tensor H100 của NVIDIA có bộ nhớ RAM HBM3 lên đến 188GB.

- Tầng 2 – Ổ cứng SSD cục bộ trên bus PCIe: Tầng này nhanh chóng hơn so với tầng 1, nhưng vẫn đắt tiền và có dung lượng lớn hơn nhiều lần so với GPU cao cấp.

- Tầng 3 – Máy chủ lưu trữ từ xa trên mạng LAN: Tầng này có thể hỗ trợ dung lượng lớn hơn hẳn so với GPU, lên đến hơn 1.000 lần.

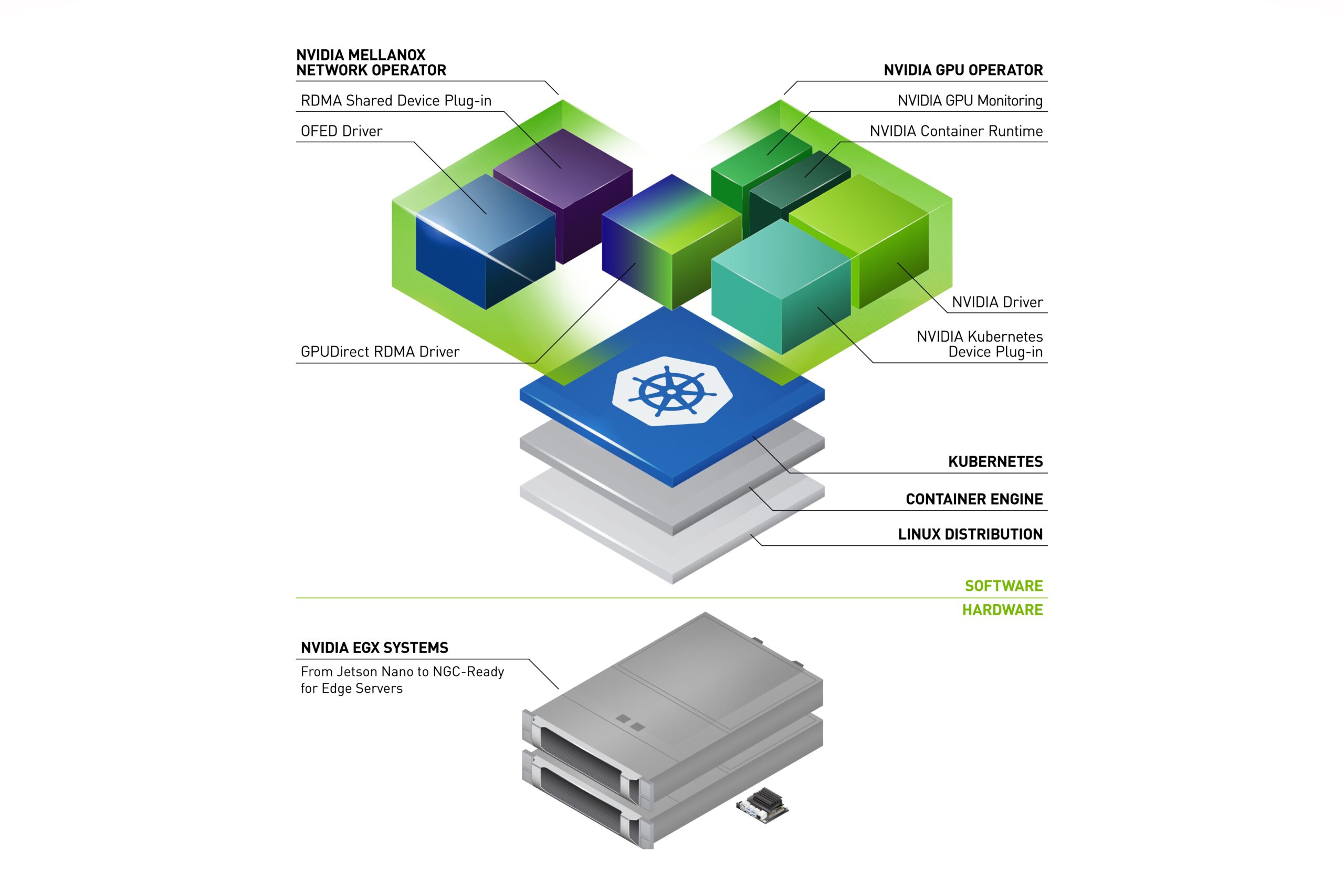

Với sự cần thiết của cả độ trễ thấp và băng thông cao trong các ứng dụng AI và ML, RDMA là một công nghệ quan trọng giúp mở rộng lợi ích của DMA cục bộ đến các tài nguyên mạng. Điều này cho phép truy cập nhanh chóng vào dữ liệu từ bên ngoài thông qua việc truyền dữ liệu từ bộ nhớ này sang bộ nhớ kia qua các thiết bị (GPU ở một đầu và thiết bị lưu trữ ở đầu kia). Khi sử dụng kết nối NVLink, InfiniBand hoặc Ethernet tốc độ cao, dữ liệu được truyền từ bộ nhớ trong một hệ thống từ xa vào bộ nhớ trên GPU cục bộ. NVIDIA Magnum IO cung cấp nền tảng tăng tốc IO cho các trung tâm dữ liệu, hỗ trợ IO song song thông minh để tối ưu hóa lưu trữ, mạng và giao tiếp đa nút, đa GPU cho các ứng dụng đòi hỏi hiệu suất cao.

Trong các máy chủ GPU của Supermicro, công ty sử dụng GPU NVIDIA và các phương thức truy cập mạng của chúng. Ngoài ra, máy chủ GPU Supermicro có thêm ASIC đặc biệt gọi là Đơn vị Xử lý Dữ liệu (DPUs) để hỗ trợ IO tăng tốc mà GPU cung cấp. DPUs giúp giảm công việc IO thừa từ CPU của máy chủ và hỗ trợ nhiều bộ điều hợp mạng cho mỗi máy chủ, đảm bảo không có hạn chế, thậm chí trên bus PCIe, và giúp tối ưu hóa băng thông và giảm độ trễ.

Những cải tiến này có tác động tích cực đối với hiệu suất tổng thể. Sự tăng cường hiệu suất từ việc sử dụng IO được tăng tốc của NVIDIA dao động từ 20% đến 30% ít nhất đối với các khối công việc chất lượng cao. Tóm lại, việc sử dụng máy chủ dựa trên DPU và GPU trong các ứng dụng AI, ML và các khối công việc đòi hỏi cao cấp mang lại lợi ích rõ rệt bằng cách tách biệt các thành phần hạ tầng khỏi các hoạt động ứng dụng. Điều này giúp giải phóng tài nguyên và tăng tốc

Máy Chủ GPU Supermicro: Tối Ưu Hóa Deep Learning cho Trung Tâm Dữ Liệu Hiện Đại

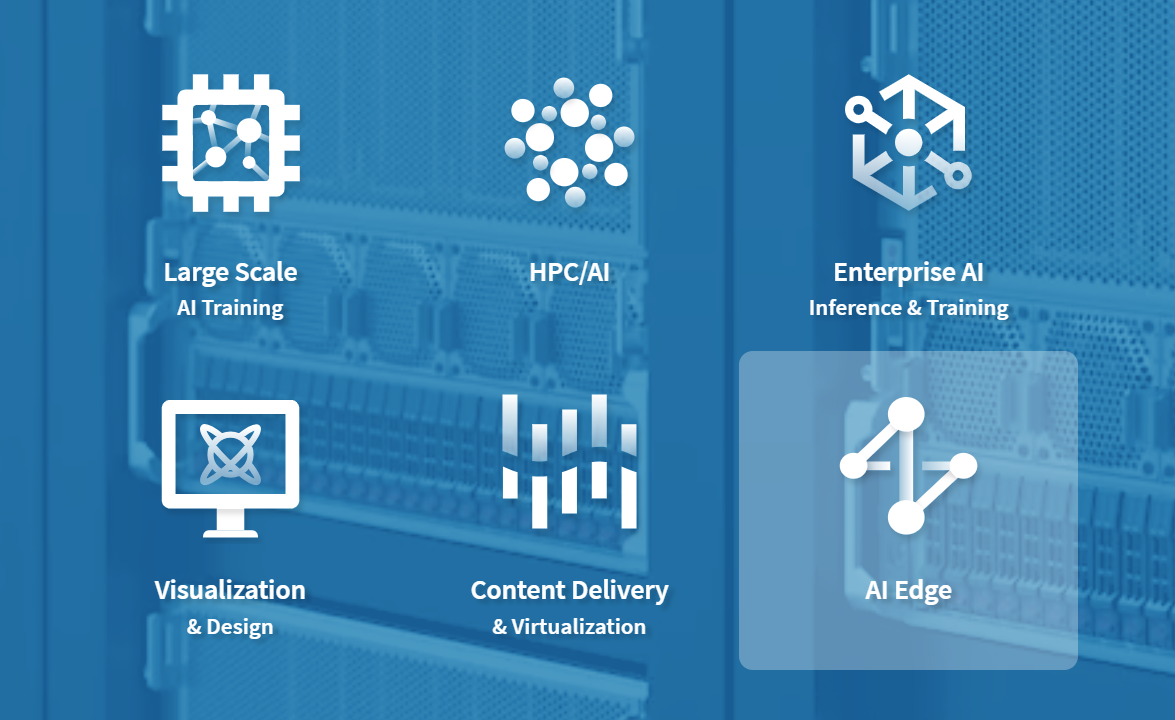

Supermicro GPU Server giúp mở khả năng toàn diện của Trí tuệ Nhân tạo với các giải pháp hạ tầng sẵn sàng cho AI hàng đầu của Supermicro. Từ việc đào tạo quy mô lớn đến suy luận thông minh tại lề thống, các thiết kế tham chiếu có sẵn của chúng tôi giúp tối ưu hóa và tăng tốc quá trình triển khai AI.

Cung cấp sức mạnh cho khối công việc của bạn với hiệu suất và khả năng mở rộng tối ưu hóa chi phí và giảm thiểu tác động môi trường. Khám phá một thế giới của tiềm năng với sự lựa chọn đa dạng về các giải pháp được tối ưu hóa cho khối công việc AI từ Supermicro và tăng tốc mọi khía cạnh của doanh nghiệp của bạn.

Universal GPU Systems

Thiết Kế Khối Xây Dựng Linh Hoạt, Nền Tảng Dựa Trên Tiêu Chuẩn Mở Cho Trạm 4U, 5U, hoặc 8U cho Quá Trình Đào Tạo Trí Tuệ Nhân Tạo và Ứng Dụng Tính Toán Siêu Máy Tính Trên Quy Mô Lớn

- GPU:NVIDIA HGX H100/A100 4-GPU/8-GPU, AMD Instinct MI250 OAM Accelerator

- CPU:Intel® Xeon® or AMD EPYC™

- Memory:Up to 32 DIMMs, 8TB

- Drives:Up to 24 Hot-swap U.2 or 2.5″ NVMe/SATA drives

4U/5U GPU Lines with PCIe 5.0

Sự Tăng Tốc Tối Đa và Linh Hoạt Cho Ứng Dụng Trí Tuệ Nhân Tạo/Deep Learning và Tính Toán Siêu Máy Tính Trên Quy Mô Lớn

- GPU:Up to 10 NVIDIA H100 PCIe GPUs, or up to 10 double-width PCIe GPUs

- CPU:Intel® Xeon® or AMD EPYC™

- Memory:Up to 32 DIMMs, 8TB DRAM or 12TB DRAM + PMem

- Drives:Up to 24 Hot-swap 2.5″ SATA/SAS/NVMe

NVIDIA MGX™ Systems

Nền Tảng Khối Xây Dựng Linh Hoạt Hỗ Trợ GPU, CPU và DPUs Hiện Tại và Tương Lai

- GPU:Up to 4 NVIDIA PCIe GPUs including H100, H100 NVL, and L40S

- CPU:Intel® Xeon® or NVIDIA Grace Superchip

- Memory:Up to 16 DIMMs, 4TB DRAM or 960GB on-chip memory

- Drives:Up to 8 E1.S + 2 M.2 drives

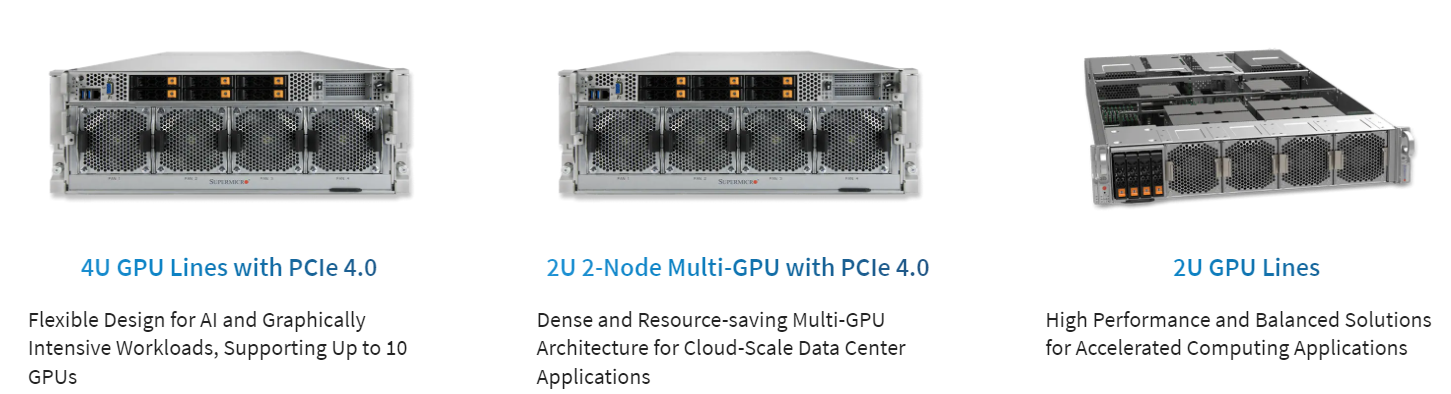

4U GPU Lines with PCIe 4.0

Thiết Kế Linh Hoạt Cho Các Khối Lượng Công Việc Trí Tuệ Nhân Tạo và Công Việc Đồ Họa Tính Toán Mạnh, Hỗ Trợ Lên Đến 10 GPUs

- GPU:NVIDIA HGX A100 8-GPU with NVLink, or up to 10 double-width PCIe GPUs

- CPU:Intel® Xeon® or AMD EPYC™

- Memory:Up to 32 DIMMs, 8TB DRAM or 12TB DRAM + PMem

- Drives:Up to 24 Hot-swap 2.5″ SATA/SAS/NVMe

2U 2-Node Multi-GPU with PCIe 4.0

Kiến Trúc Multi-GPU Dày Đặc và Tiết Kiệm Tài Nguyên Cho Các Ứng Dụng Trung Tâm Dữ Liệu Quy Mô Máy Chủ Đám Mây

- GPU:Up to 3 double-width PCIe GPUs per node

- CPU:Intel® Xeon® or AMD EPYC™

- Memory:Up to 8 DIMMs, 2TB per node

- Drives:Up to 2 front hot-swap 2.5” U.2 per node

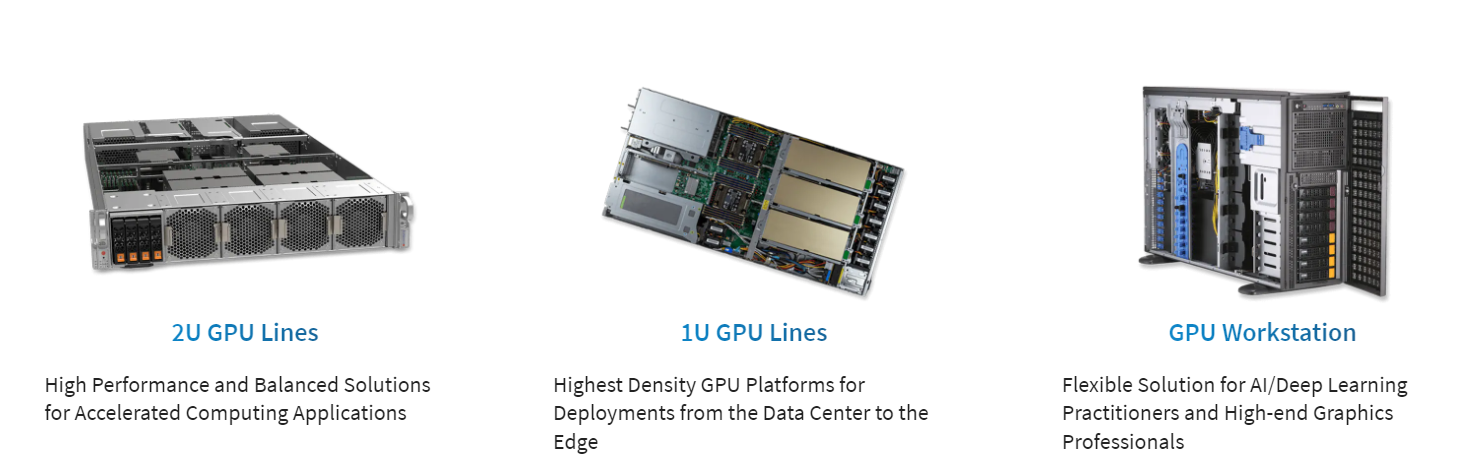

2U GPU Lines

Giải Pháp Hiệu Suất Cao và Cân Đối Cho Các Ứng Dụng Tính Toán Tăng Cường

- GPU:NVIDIA HGX A100 4-GPU with NVLink, or up to 6 double-width PCIe GPUs

- CPU:Intel® Xeon® or AMD EPYC™

- Memory:Up to 32 DIMMs, 8TB

- Drives:Up to 10 Hot-swap 2.5″ SATA/SAS/NVMe

1U GPU Lines

Nền Tảng GPU Mật Độ Cao Nhất Cho Triển Khai Từ Trung Tâm Dữ Liệu Đến Edge

- GPU:Up to 4 double-width PCIe GPUs

- CPU:Intel® Xeon®

- Memory:Up to 16 DIMMs, 4TB

- Drives:Up to 6 x 2.5″ Hot-swap SAS/SATA, or 2 x 2.5″ Hot-swap NVMe SATA/SAS/NVMe

GPU Workstation

Giải Pháp Linh Hoạt Cho Các Chuyên Gia Trí Tuệ Nhân Tạo/Deep Learning và Chuyên Nghiệp Đồ Họa Cao Cấp

- GPU:Up to 4 double-width PCIe GPUs

- CPU:Intel® Xeon®

- Memory:Up to 16 DIMMs, 6TB

- Drives:Up to 8 hot-swap 2.5” SATA/NVMe

→ Để biết thêm thông tin về các GPU Sevẻ của Supermicro tối ưu cho AI/HPC, hãy truy cập: https://thegioimaychu.vn/server/supermicro/

→ Để biết thêm thông tin về các GPU của NVIDIA, hãy truy cập: https://thegioimaychu.vn/linh-kien-may-chu/gpu-card-may-chu

→ Để biết thêm thông tin về danh mục giải pháp NVIDIA của Supermicro, hãy truy cập: https://thegioimaychu.vn/solution/nvidia-hpc/

Bài viết liên quan

- Huấn luyện mô hình hàng trăm tỷ tham số ngay tại bàn với MSI EdgeXpert

- NVIDIA Merlin: Tổng quan về toolkit cho hệ thống gợi ý quy mô lớn

- Hướng dẫn triển khai máy chủ GPU tại chỗ trong các phòng máy doanh nghiệp

- NVIDIA ConnectX-8 SuperNIC: Đột phá kiến trúc hạ tầng AI với PCIe Gen6

- OpenAI lần đầu phát hành miễn phí mô hình ngôn ngữ mới với tên gọi là GPT-OSS

- NVIDIA hiện đang cung cấp những dòng GPU nào?