Các máy chủ GPU mang lại lợi ích rất lớn về hiệu suất đối với các ứng dụng Trí tuệ nhân tạo (AI) và điện toán hiệu năng cao (HPC) so với máy chủ truyền thống chỉ có CPU. Rất nhiều các ứng dụng khác nhau có thể được thực thi trên những hệ thống này, và việc hiệu suất gia tăng cho các ứng dụng tận dụng GPU đã được minh chứng rộng rãi.

Với các máy chủ GPU chuyên dụng hỗ trợ một hoặc hai CPU và với tối đa 10 card GPU PCIe, cách thức hệ thống được thiết kế ảnh hưởng rất lớn đến tốc độ và tính linh hoạt của hệ thống. Có ba kiểu để thiết kế một máy chủ GPU, qua đó tạo ra các hệ thống tối ưu hơn cho các tải xử lý khác nhau. Dòng dữ liệu giữa CPU và GPU chính là nhân tố quan trọng khi lựa chọn máy chủ GPU.

Các lựa chọn truy cập đến GPU PCIe

Máy chủ GPU của Supermicro được thiết kế cho các ứng dụng thường yêu cầu sử dụng số lượng nhiều GPU trong một máy chủ. Thông thường máy chủ có thể xử lý tỷ lệ 1:1 giữa CPU và GPU thông qua khe cắm PCIe, nhưng khi được thiết kế để tăng tốc thì thường yêu cầu số lượng GPU/CPU cao hơn đáng kể.

Về cơ bản, máy chủ GPU có hai kiến trúc:

• GPU dựa trên PCIe, với tối đa 10 GPU được cài đặt trong các khe cắm PCIe.

• Máy chủ GPU dựa trên giao diện SXM / OAM, với GPU được gắn trên một bo mạch riêng của nó và chỉ có một kết nối PCIe với CPU.

Hầu hết máy chủ GPU có hai CPU socket, với bộ nhớ DRAM được gắn kèm vào mỗi socket. Các CPU giao tiếp thông qua các đường truyền dẫn tốc độ cao (UPI cho hệ thống dựa trên Intel và xGMI cho hệ thống dựa trên AMD).

Nghiên cứu sâu hơn vào các máy chủ dựa trên PCIe, có ba kiến trúc hệ thống khác nhau được thiết kế cho các tải xử lý khác nhau.

- Single Root

- Dual Root

- Direct Attach

Giải thích về tùy chọn Single Root

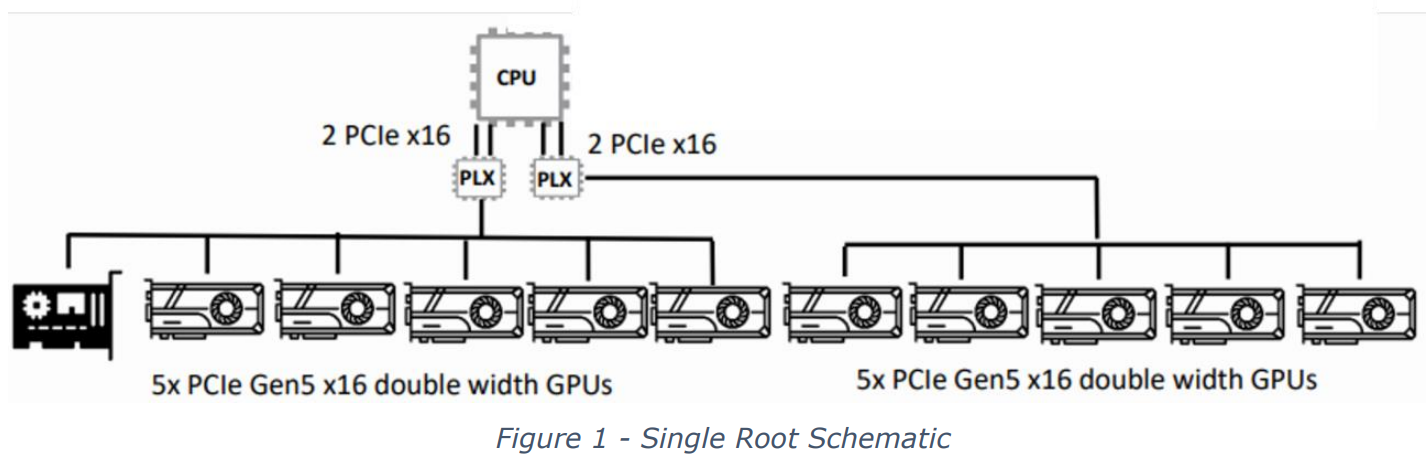

Kiến trúc Single Root (SR) là lựa chọn lý tưởng cho các ứng dụng tồn tại trên một CPU duy nhất nhưng yêu cầu truy cập vào nhiều GPU. Hệ thống SR dành riêng một trong hai CPU để quản lý tất cả các truyền thông với các GPU. Như được thể hiện trong Hình 1, CPU giao tiếp với các GPU thông qua một switch PCI (PLX). Mỗi switch PLX được kết nối với CPU qua 2 làn PCIe x16 và sau đó có thể giao tiếp với tối đa năm GPU có chiều rộng gấp đôi. Điều này dẫn đến việc sử dụng tối đa 10 GPU trong một máy chủ duy nhất. Hệ thống SR được tùy chỉnh cho các ứng dụng học sâu (deep learning) nơi mà hầu hết tính toán diễn ra trên GPU.

Ưu điểm của cấu hình Single Root:

- Một CPU duy nhất có truy cập tới tối đa 10 GPU. Các ứng dụng cần truy cập trực tiếp đến tất cả các GPU sẽ được hưởng lợi từ cấu hình này.

- Các ứng dụng mà hiệu suất giao tiếp từ GPU sang GPU (pier-to-pier) không quá quan trọng.

Hình 1 cho thấy cấu hình tổng quan của hệ thống Single Root.

Giải thích về tùy chọn Dual Root

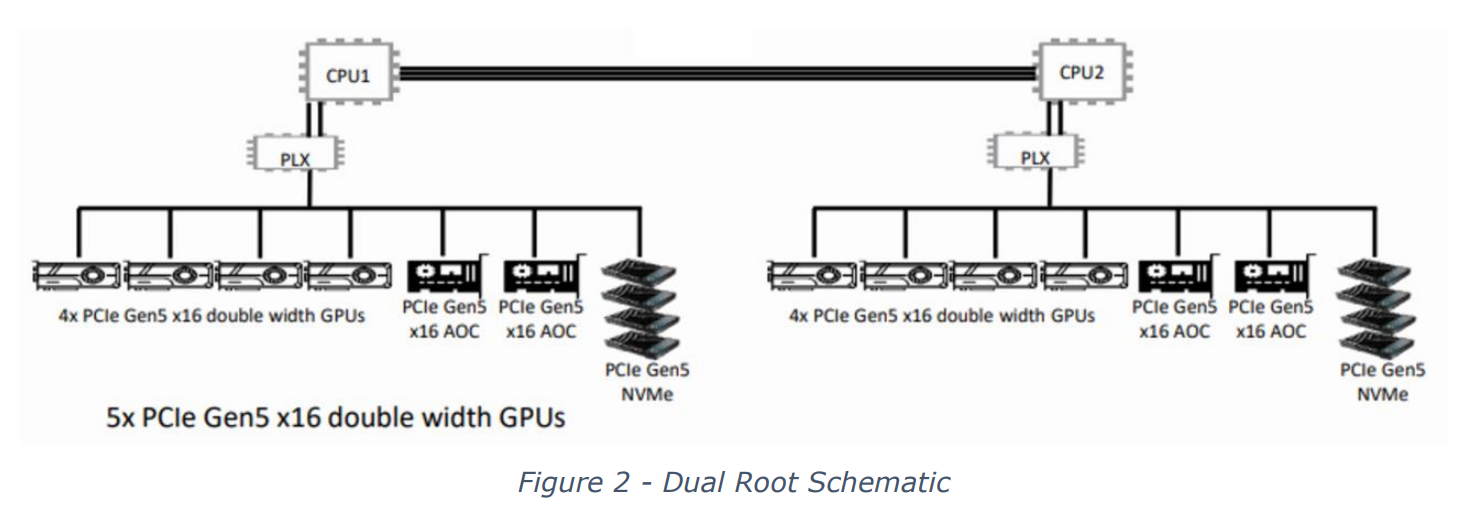

Tùy chọn Dual Root (DR) kết nối mỗi CPU tới một số lượng lớn GPU thông qua một switch PLX. Hiện nay, số lượng tối đa GPU có thể được quản lý là 10. Việc phân phối GPU được kết nối thông qua switch PLX không nhất thiết phải bằng nhau giữa các CPU, vì một tải công việc đã được gán cho hệ thống có thể không dễ dàng được phân phối đều nhau giữa các CPU. Mỗi CPU có thể dễ dàng giao tiếp với nhau, và sự kết hợp của các thiết bị PCIe được kết nối với mỗi switch PLX có thể rất linh hoạt. Trong hình dưới đây, mỗi CPU (và switch PLX) có 4 GPU, 2 thẻ AOC và 4 thiết bị lưu trữ NVMe. Loại hệ thống này là cấu hình phổ biến nhất cho các môi trường Omniverse. Cấu hình này sẽ hỗ trợ các ứng dụng có sự cân bằng giữa CPU và GPU.

Ưu điểm của cấu hình Dual Root:

- Các tải công việc có thể được gán cho một CPU, mỗi CPU có tối đa 10 GPU hoặc các thiết bị khác có thể truy cập thông qua switch PLX. Các ứng dụng – Khi dữ liệu cần được chia sẻ và truyền thông giữa hai CPU. Hệ thống cân bằng này cho phép CPU giao tiếp hiệu quả với GPU, thẻ mạng hoặc các thiết bị lưu trữ. Ví dụ bao gồm AI Compute/Model Training/Deep Learning và High-performance Computing (HPC).

Giải thích về Tùy chọn Direct Attached

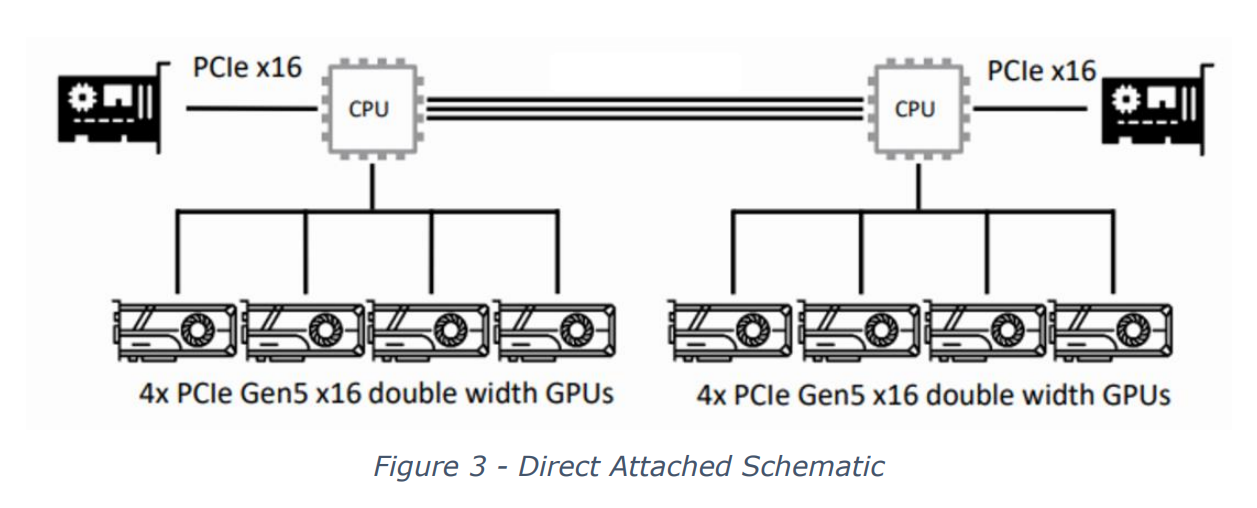

Trong tùy chọn Direct Attached, mỗi CPU có truy cập PCIe trực tiếp tới tối đa bốn GPU có kích thước đầy đủ, tổng cộng là tám GPU cho một hệ thống. Lợi ích của cấu hình này là không cần các switch PLX, và mỗi CPU có kết nối trực tiếp tới bốn GPU. Cấu hình direct attached này thường được sử dụng phổ biến cho các ứng dụng tính toán hiệu năng cao (HPC). Trong trường hợp này, chip PLX, mặc dù cho phép nhiều thiết bị PCIe hơn, có thể làm tăng độ trễ giữa các CPU và các thiết bị.

Ưu điểm của cấu hình Direct Attached:

- Mỗi ứng dụng chạy trên một CPU có truy cập tới bốn GPU.

- Mỗi CPU có truy cập bằng nhau vào GPU và khả năng I/O.

Các ứng dụng – Tuyệt vời cho các môi trường tính toán nơi mà nhiều ứng dụng có thể chạy đồng thời, hoặc một ứng dụng duy nhất có thể được chia tách và gán cho các CPU khác nhau.

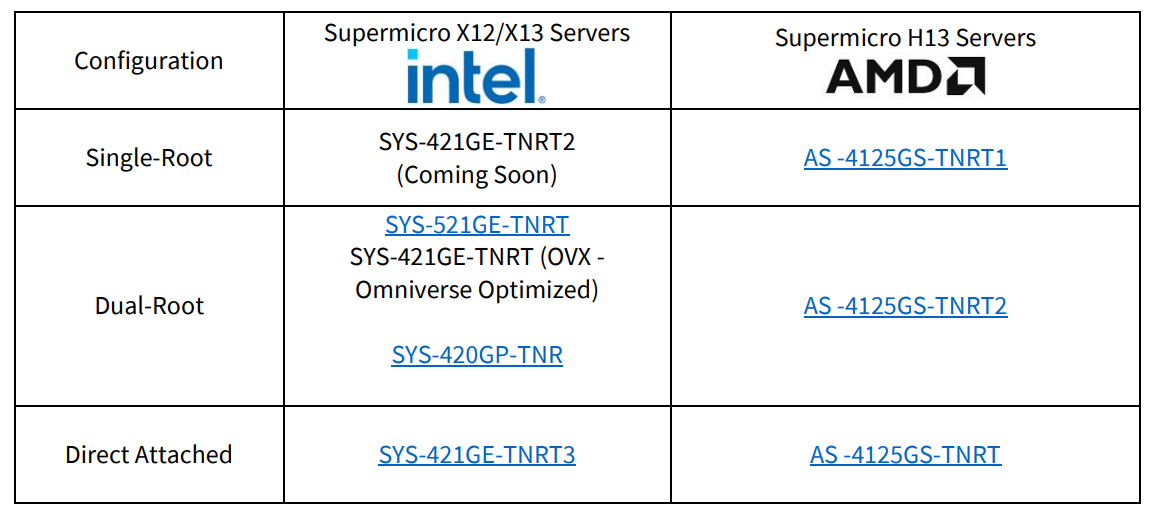

Supermicro GPU 4U/5U Systems with PCIE GPU Options

Tùy chọn hỗ trợ GPU PCIe

Các máy chủ GPU Supermicro X13 hỗ trợ các GPU sau đây trong các cấu hình đã nêu:

- NVIDIA® H100 Tensor Core GPU dạng PCIe

Các máy chủ GPU Supermicro H13 hỗ trợ các GPU sau đây trong các cấu hình đã nêu:

- NVIDIA® H100 Tensor Core GPU dạng PCIe

- AMD Instinct™ MI200 Series

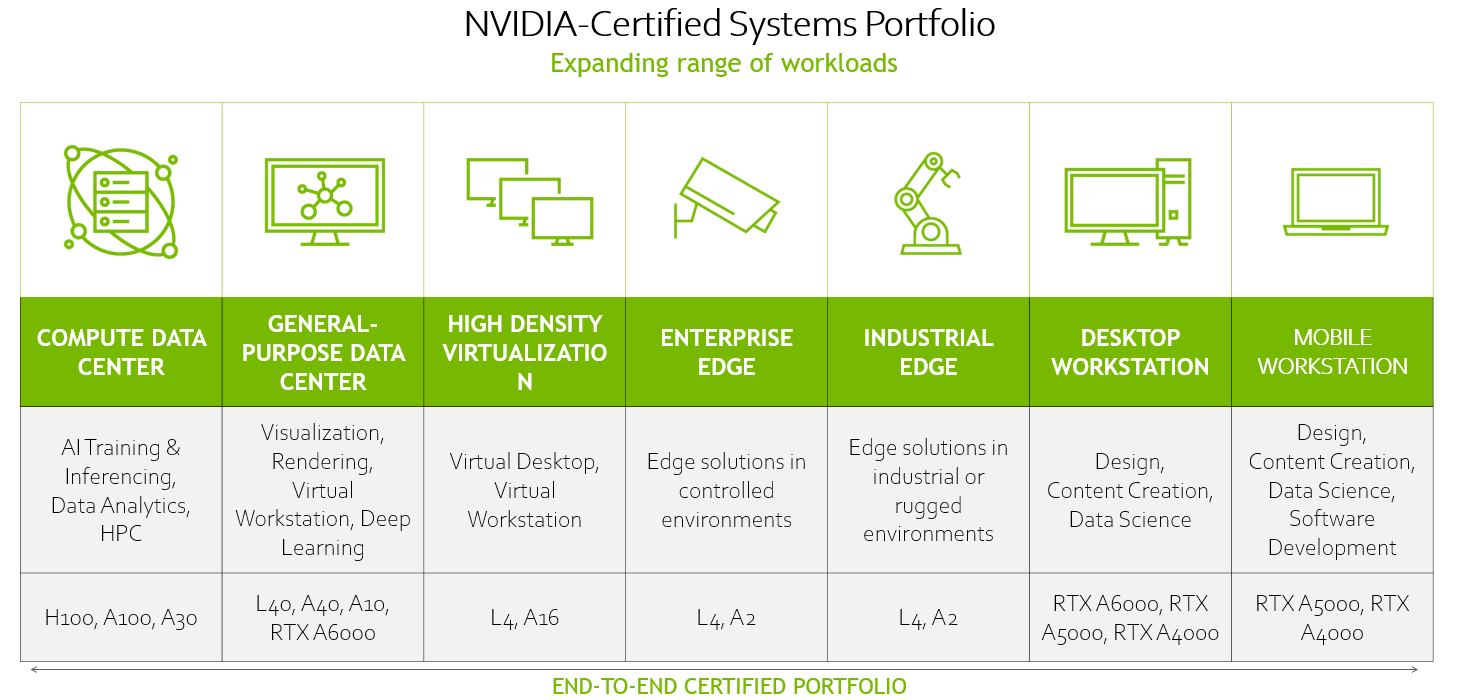

Ngoài ra, các máy chủ này còn hỗ trợ đa dạng danh mục GPU Data Center của NVIDIA để đáp ứng các nhu cầu sử dụng đa dạng trong các ứng dụng Trí tuệ nhân tạo (AI) của doanh nghiệp. Có thể chia theo các tải công việc như sau:

Tóm tắt

Tùy vào tải xử lý của ứng dụng, khách hàng có thể lựa chọn các cấu hình máy chủ GPU khác nhau từ Supermicro. Dựa vào lựa chọn Direct Attached, Single Root hoặc Dual Root, các ứng dụng sẽ hoạt động tốt nếu khách hàng chọn đúng sự kết hợp giữa CPU và GPU phù hợp với yêu cầu công việc. Khách hàng cũng cần hiểu rõ các khác biệt và điều chỉnh tải xử lý của họ cho phù hợp với máy chủ.

→ Để biết thêm thông tin về các máy chủ GPU của Supermicro, hãy truy cập: https://thegioimaychu.vn/server/supermicro/

→ Để biết thêm thông tin về danh mục giải pháp NVIDIA của Supermicro, hãy truy cập: https://thegioimaychu.vn/solution/nvidia-hpc/

Bài viết liên quan

- Máy chủ Supermicro X14: Hiệu suất mạnh mẽ, hiệu quả tối đa cho AI, Cloud, Storage, 5G/Edge

- NVIDIA HGX AI Supercomputer: Nền tảng điện toán AI hàng đầu thế giới

- NVIDIA SuperPOD DGX GB200: Kỷ nguyên của AI nghìn tỷ tham số

- Nền tảng NVIDIA Blackwell: Tạo nên kỷ nguyên điện toán mới

- NVIDIA DGX B200: Nền tảng AI thống nhất cho Training, Fine-tuning và Inference AI

- NVIDIA GB200 NVL72: Tối đa hóa đào tạo và suy luận LLM với hàng nghìn tỷ tham số