Hiện nay các doanh nghiệp đều đang sử dụng trí tuệ nhân tạo tạo ngẫu nhiên để phát triển chatbot và cộng tác viên, cá nhân hóa nội dung, tăng tốc khám phá thuốc, tạo ứng dụng hình ảnh và nhiều hơn nữa. Các mô hình cơ sở tiên tiến ngày nay có hàng nghìn tỷ tham số và được huấn luyện trên đến một petabyte dữ liệu.

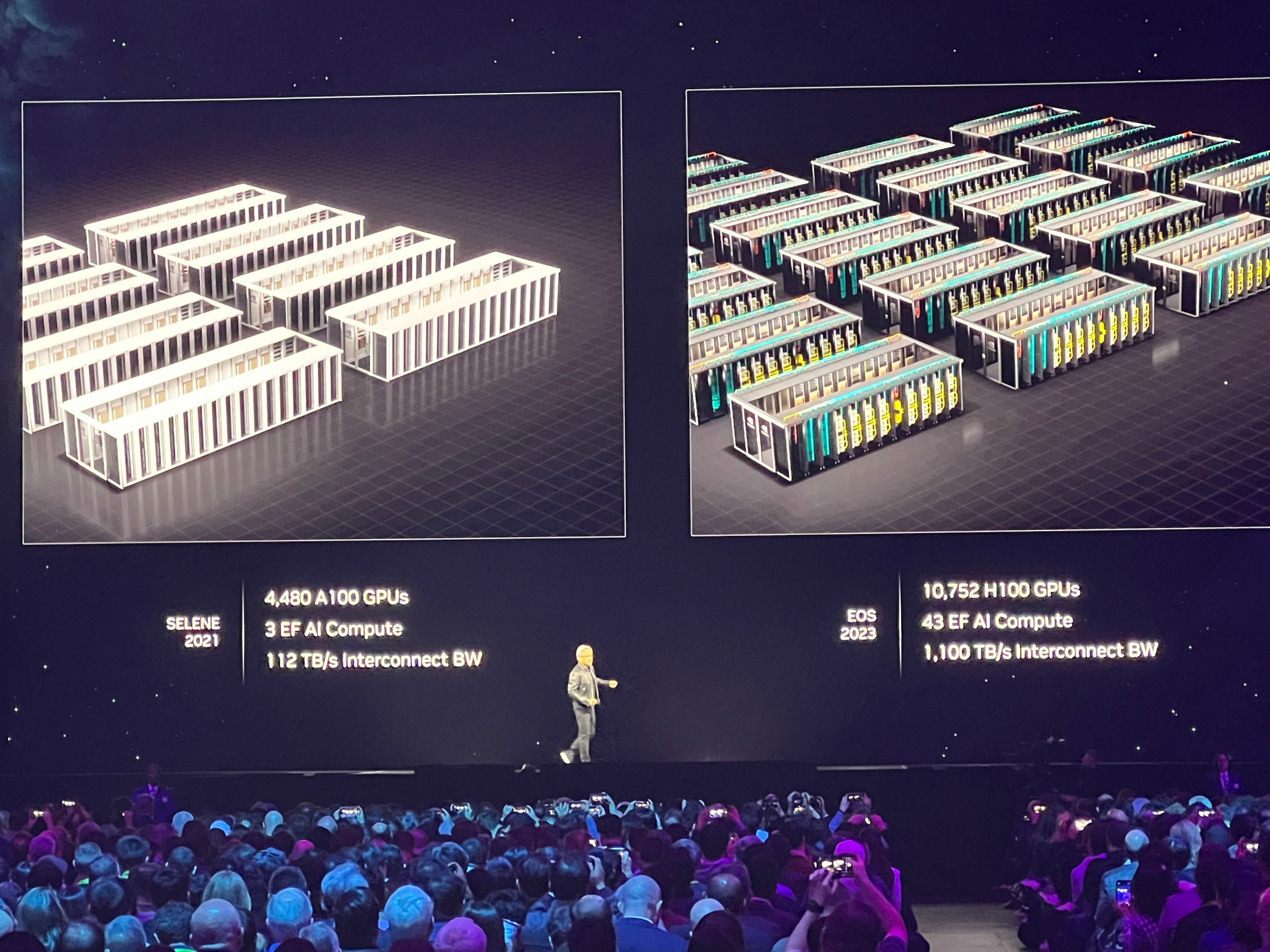

Thế hệ mới của các mô hình trí tuệ nhân tạo có khả năng cao cần hạ tầng huấn luyện và suy luận với hàng nghìn GPU để lặp lại hiệu quả hơn trên các ý tưởng mới, tăng tốc thời gian đạt được kết quả và đạt được suy luận gần thời gian thực.

Hạ tầng trí tuệ nhân tạo cấp doanh nghiệp Enterprise

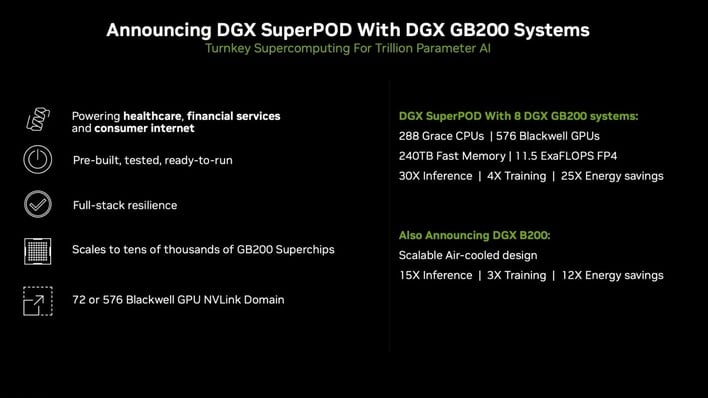

NVIDIA DGX SuperPOD™ với các hệ thống DGX™ GB200 cho phép các doanh nghiệp đạt được hiệu suất chưa từng có và thời gian hoạt động dự đoán được, tăng đáng kể sự sử dụng và năng suất và tăng lợi nhuận đầu tư của các dự án trí tuệ nhân tạo của họ. Nó tạo ra một tiêu chuẩn mới cho hiệu suất trí tuệ nhân tạo, độ tin cậy và khả năng mở rộng.

Với khả năng mở rộng lên đến hàng ngàn GPU, thiết kế tản nhiệt bằng chất lỏng hiệu quả, quy mô rack của nó tận dụng các Siêu Chip Grace Blackwell của NVIDIA GB200 để giải quyết các mô hình trí tuệ nhân tạo hàng tỷ tham số cần thiết cho các ứng dụng trí tuệ nhân tạo tạo ngẫu nhiên tiên tiến ngày nay.

Thế hệ tiếp theo của DGX SuperPOD này được xây dựng với mục đích cung cấp hiệu suất cực kỳ cao và thời gian hoạt động ổn định cho các công việc huấn luyện và suy luận trí tuệ nhân tạo quy mô lớn. Được xây dựng trên các thiết kế cụm nội bộ của NVIDIA, các khả năng độ tin cậy toàn diện – có sẵn lần đầu tiên trong hạ tầng trí tuệ nhân tạo doanh nghiệp – cho phép các doanh nghiệp tập trung vào sự đổi mới thay vì phức tạp về hoạt động.

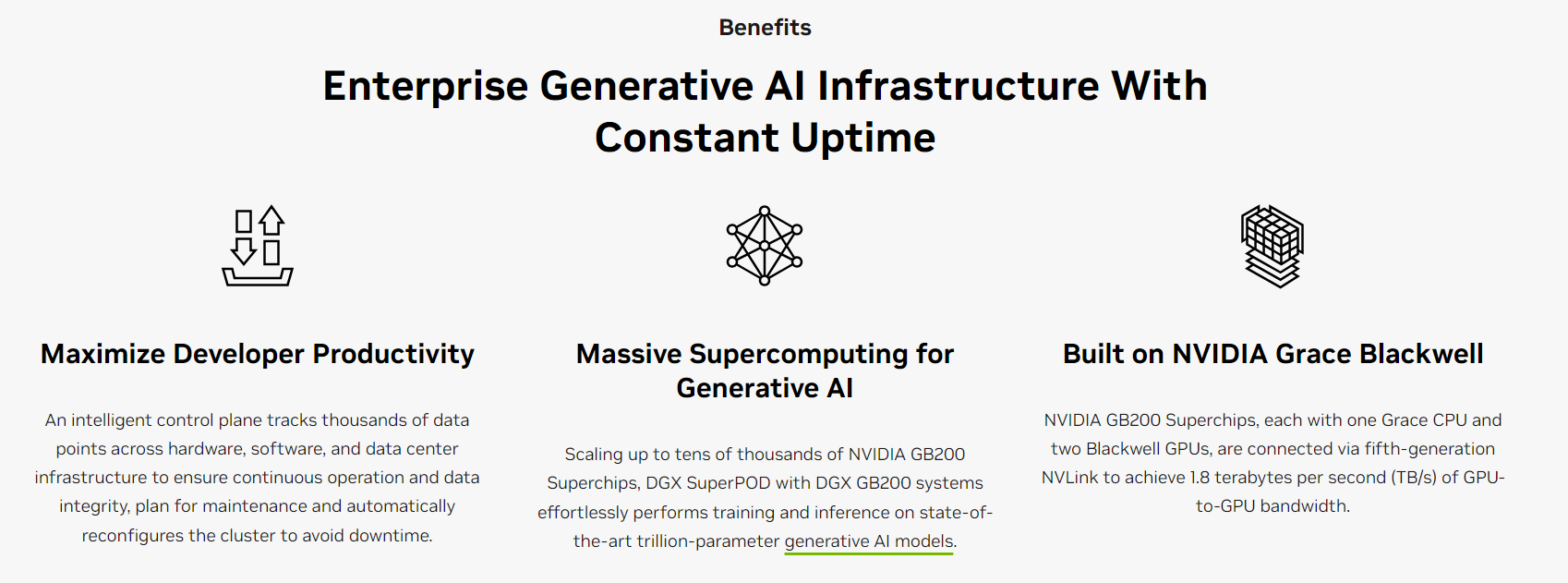

Tối đa hóa năng suất phát triển với thời gian hoạt động liên tục

DGX SuperPOD với các hệ thống DGX GB200 cung cấp thời gian hoạt động liên tục với khả năng độ tin cậy toàn diện cho hạ tầng trí tuệ nhân tạo. Mặt phẳng điều khiển thông minh liên tục theo dõi hàng nghìn điểm dữ liệu trên phần cứng, phần mềm và hạ tầng trung tâm dữ liệu để đảm bảo hoạt động liên tục và tính toàn vẹn dữ liệu. Nó tích hợp chế độ chuyển đổi tự động sử dụng phần cứng dự phòng và cơ chế kiểm tra và khởi động lại mạnh mẽ – tránh thời gian chết, ngay cả khi các quản trị hệ thống không có sẵn.

Siêu tính toán cho trí tuệ nhân tạo sáng tạo

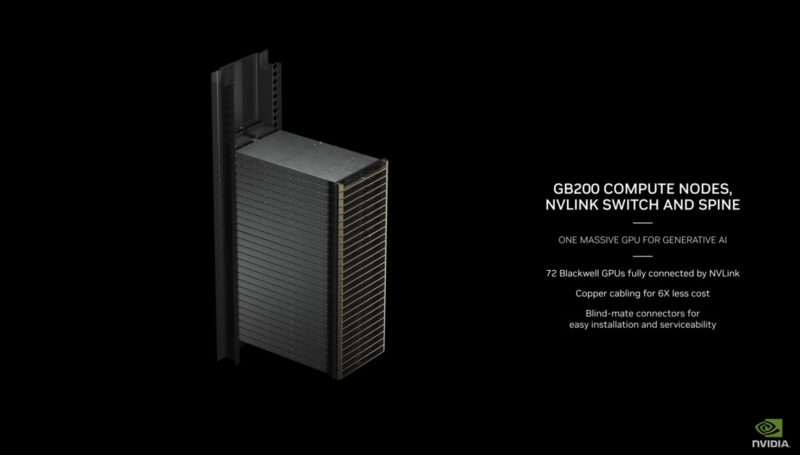

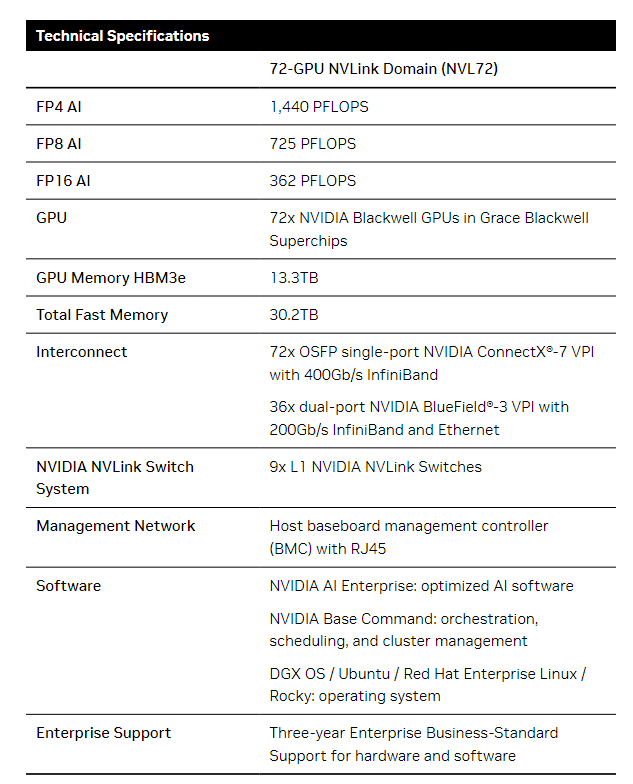

Để đạt được quá trình huấn luyện và suy luận nhạy cảm với độ trễ trên các mô hình hàng tỷ tham số tiên tiến nhất, DGX SuperPOD với các hệ thống DGX GB200 có thể mở rộng lên đến hàng ngàn Siêu Chip Grace Blackwell của NVIDIA. Lí tưởng cho các mô hình ngôn ngữ lớn (LLMs), mỗi hệ thống DGX GB200 trong DGX SuperPOD có 36 CPU Grace và 72 GPU Blackwell của NVIDIA được kết nối với nhau qua NVLink thế hệ thứ năm, cung cấp 1.4 exaFLOPS hiệu suất trí tuệ nhân tạo, 30 terabyte (TB) bộ nhớ nhanh và 130 terabyte mỗi giây (TB/s) băng thông GPU hai chiều.

DGX SuperPOD có thể được cấu hình tùy chọn bằng cách sử dụng các hệ thống DGX GB200 với 576 GPU Blackwell được kết nối qua NVLink để tạo ra một bể nhớ chia sẻ khổng lồ để cung cấp tăng tốc đáng kể cho các công việc phụ thuộc vào bộ nhớ như các mô hình khuyến nghị, mạng neural đồ thị (GNNs), và các mô hình Mixture-of-Experts (MoE) LLMs với hàng tỷ tham số.

DGX SuperPOD với DGX GB200 cho phép các doanh nghiệp thực hiện một cách dễ dàng quá trình huấn luyện và suy luận trên các mô hình trí tuệ nhân tạo tạo ngẫu nhiên lớn nhất hiện nay và trong tương lai.

Xây dựng trên Grace Blackwell của NVIDIA

Với quy trình sản xuất 4 nanômét đột phá, NVLink thế hệ thứ năm và một động cơ Transformer thế hệ thứ hai, các Siêu Chip Grace Blackwell của NVIDIA làm nên sức mạnh của DGX SuperPOD được tích hợp vào một thiết kế tản nhiệt bằng chất lỏng, quy mô rack, tạo ra siêu máy tính trí tuệ nhân tạo hiệu quả nhất thế giới cho trí tuệ nhân tạo tạo ngẫu nhiên.

Mỗi Siêu Chip có hai GPU Blackwell hiệu suất cao và một CPU Grace của NVIDIA. Mỗi GPU Blackwell trong một Siêu Chip GB200 đem lại 1.8TB/s băng thông hai chiều sử dụng NVLink cho kết nối GPU-to-GPU.

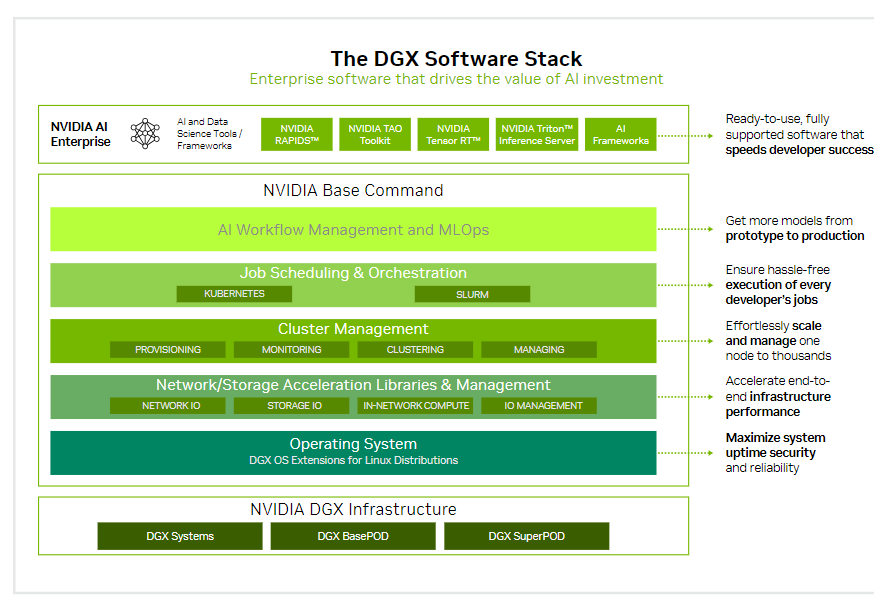

Tối ưu với phần mềm dành cho AI

NVIDIA Base Command™ làm nền tảng cho nền tảng DGX, cho phép các tổ chức tận dụng tốt nhất của sự đổi mới phần mềm của NVIDIA. Các doanh nghiệp có thể triển khai toàn bộ tiềm năng của hạ tầng DGX của mình với một nền tảng đã được chứng minh bao gồm việc điều khiển và quản lý cụm cấp doanh nghiệp, các thư viện tăng tốc tính toán, lưu trữ và hạ tầng mạng, và một hệ điều hành được tối ưu hóa cho các công việc trí tuệ nhân tạo.

Ngoài ra, hạ tầng DGX bao gồm NVIDIA AI Enterprise, một bộ phần mềm được tối ưu hóa để tối ưu hóa quy trình phát triển và triển khai trí tuệ nhân tạo.

Key Features

> Built on NVIDIA GB200 Grace™ Blackwell Superchips

> Scalable up to tens of thousands of GB200 Superchips

> 72 NVIDIA Blackwell GPUs connected as one with NVIDIA® NVLink®

> Efficient, liquid-cooled, rack- scale design

> NVIDIA networking

> Integrated predictive maintenance to maximize uptime

> Includes NVIDIA AI Enterprise and NVIDIA Base Command™ software

> Each DGX SuperPOD is fully assembled and tested at the factory to speed on-site deployment

Bài viết liên quan

- Máy chủ Supermicro X14: Hiệu suất mạnh mẽ, hiệu quả tối đa cho AI, Cloud, Storage, 5G/Edge

- NVIDIA Omniverse ft Apple Vision Pro: Mở rộng thế giới quan với VR/AR

- NVIDIA NIM: Vi dịch vụ suy luận tối ưu hóa cho triển khai mô hình AI quy mô lớn

- NVIDIA HGX AI Supercomputer: Nền tảng điện toán AI hàng đầu thế giới

- Nền tảng NVIDIA Blackwell: Tạo nên kỷ nguyên điện toán mới