Là thư viện học máy (ML) dành cho ngôn ngữ lập trình Python, Scikit-learn có số lượng lớn thuật toán mà các lập trình viên và nhà khoa học dữ liệu có thể dễ dàng triển khai trong các mô hình học máy.

Scikit-learn là gì?

Scikit-learn là một thư viện học máy phổ biến và mạnh mẽ, hỗ trợ nhiều loại thuật toán cũng như các công cụ để trực quan hóa Machine Learning, tiền xử lý, điều chỉnh, lựa chọn và đánh giá mô hình.

Dựa trên NumPy, SciPy và Matplotlib, Scikit-learn có một số thuật toán hiệu quả để phân loại, phân tích hồi quy và phân cụm. Bao gồm các vector machines, rain forests, gradient boosting, k-means, và DBSCAN.

Scikit-learn được biết đến với tính dễ phát triển tương đối nhờ các API được thiết kế nhất quán và hiệu quả, tài liệu mở rộng cho hầu hết các thuật toán và nhiều hướng dẫn online.

Hiện tại các phiên bản cho các nền tảng phổ biến bao gồm Linux, MacOS và Windows đang được phát hành.

Tại sao lại là Scikit-learn?

API Scikit-learn đã trở thành tiêu chuẩn thực tế cho việc triển khai học máy nhờ tính dễ sử dụng, thiết kế chỉnh chu và sự hỗ trợ đông đảo trong cộng đồng Scikit-learn.

Scikit-learn cung cấp các mô-đun để xây dựng, điều chỉnh và đánh giá mô hình ML:

- Preprocessing đề cập đến các công cụ Scikit-learn hữu ích trong việc trích xuất và chuẩn hóa features trong quá trình phân tích dữ liệu.

- Classification đề cập đến một bộ công cụ xác định danh mục liên kết với dữ liệu trong mô hình học máy. Ví dụ: những công cụ này được sử dụng để phân loại email hợp lệ hoặc thư rác. Về cơ bản, Classification xác định đối tượng thuộc về loại nào.

- Regression (Phân tích hồi quy) đề cập đến việc tạo ra một mô hình học máy để tìm hiểu mối quan hệ giữa dữ liệu đầu vào và đầu ra, chẳng hạn như hành vi hoặc giá cổ phiếu. Hồi quy dự đoán một thuộc tính có giá trị liên tục được liên kết với một đối tượng.

- Các công cụ Clustering trong Scikit-learn tự động nhóm dữ liệu có đặc điểm tương tự thành các bộ (sets), chẳng hạn như dữ liệu khách hàng được sắp xếp theo bộ dựa trên vị trí thực tế.

- Dimensionality Reduction làm giảm số lượng biến ngẫu nhiên để phân tích. Ví dụ: để tăng hiệu quả trực quan hóa, dữ liệu bên ngoài có thể bị loại bỏ.

- Model selection đề cập đến các thuật toán và khả năng cung cấp các công cụ so sánh, xác thực và chọn tham số tối ưu để sử dụng trong các dự án học máy khoa học dữ liệu.

- Pipeline đề cập đến các tiện ích để xây dựng quy trình làm việc mô hình.

- Visualization cho học máy cho phép vẽ đồ thị và điều chỉnh trực quan nhanh chóng.

Scikit-learn hoạt động như thế nào?

Scikit-learn được viết chủ yếu bằng Python và sử dụng NumPy cho đại số tuyến tính hiệu suất cao cũng như cho các phép tính array. Một số thuật toán Scikit-learn cốt lõi được viết bằng Cython để tăng hiệu suất tổng thể.

Là một thư viện cấp cao bao gồm một số triển khai các thuật toán học máy khác nhau, Scikit-learn cho phép người dùng xây dựng, đào tạo và đánh giá mô hình bằng một vài dòng mã.

Scikit-learn cung cấp một bộ API cấp cao thống nhất để xây dựng quy trình hoặc quy trình ML.

Người dùng sử dụng ML Scikit-learn Pipeline để truyền dữ liệu qua các transformers nhằm trích xuất các đặc điểm và công cụ ước tính để tạo ra mô hình, sau đó đánh giá các dự đoán để đo lường độ chính xác của mô hình.

- Transformer: Đây là thuật toán biến đổi hoặc nhập vào dữ liệu để xử lý.

- Estimator: Đây là thuật toán học máy đào tạo hoặc điều chỉnh dữ liệu để xây dựng mô hình, mô hình này có thể được sử dụng để dự đoán.

- Pipeline: Một đường dẫn kết nối các Transformer và Estimator lại với nhau để chỉ định quy trình làm việc ML.

Sử dụng GPU để tăng tốc Scikit-learn APIs và Khoa học dữ liệu đầu cuối

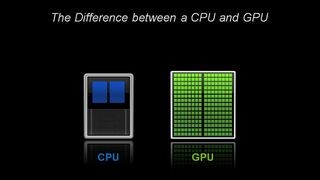

Về mặt kiến trúc, CPU chỉ bao gồm một vài cores với nhiều bộ nhớ đệm có thể xử lý một số threads phần mềm cùng một lúc. Ngược lại, GPU bao gồm hàng trăm cores có thể xử lý hàng nghìn threads cùng một lúc.

Bộ thư viện phần mềm nguồn mở NVIDIA RAPIDS, được xây dựng trên CUDA-X AI, cung cấp khả năng thực thi các quy trình phân tích và khoa học dữ liệu từ đầu đến cuối hoàn toàn trên GPU. Dựa trên các nguyên hàm NVIDIA CUDA để tối ưu hóa điện toán ở mức độ thấp, nhưng thể hiện tính song song của GPU và tốc độ bộ nhớ băng thông cao thông qua giao diện Python thân thiện với người dùng.

Các thuật toán học máy cuML và các phép toán nguyên thủy của RAPIDS tuân theo API tương tự như Scikit-learn quen thuộc. Các thuật toán phổ biến như XGBoost, Random Forest và nhiều thuật toán khác được hỗ trợ cho cả triển khai GPU đơn và trung tâm dữ liệu lớn. Đối với các tập dữ liệu lớn, việc triển khai dựa trên GPU này có thể hoàn thành nhanh hơn 10-50 lần so với CPU tương đương.

Với RAPIDS GPU DataFrame, dữ liệu có thể được tải lên GPU bằng giao diện như Pandas, sau đó được sử dụng cho các thuật toán phân tích biểu đồ và học máy được kết nối khác nhau mà không cần tách khỏi GPU. Mức độ tương tác này có thể thực hiện được thông qua các thư viện như Apache Arrow và cho phép tăng tốc quy trình từ đầu đến cuối từ khâu chuẩn bị dữ liệu, học máy đến học sâu.

RAPIDS hỗ trợ chia sẻ bộ nhớ thiết bị giữa nhiều thư viện khoa học dữ liệu phổ biến. Điều này giúp lưu trữ dữ liệu trên GPU và tránh việc sao chép qua lại vào bộ nhớ máy chủ.

Bài viết liên quan

- Giới thiệu giải pháp Training AI trên các máy chủ thông dụng

- NVIDIA Omniverse ft Apple Vision Pro: Mở rộng thế giới quan với VR/AR

- NVIDIA NIM: Vi dịch vụ suy luận tối ưu hóa cho triển khai mô hình AI quy mô lớn

- NVIDIA HGX AI Supercomputer: Nền tảng điện toán AI hàng đầu thế giới

- NVIDIA SuperPOD DGX GB200: Kỷ nguyên của AI nghìn tỷ tham số

- Nền tảng NVIDIA Blackwell: Tạo nên kỷ nguyên điện toán mới