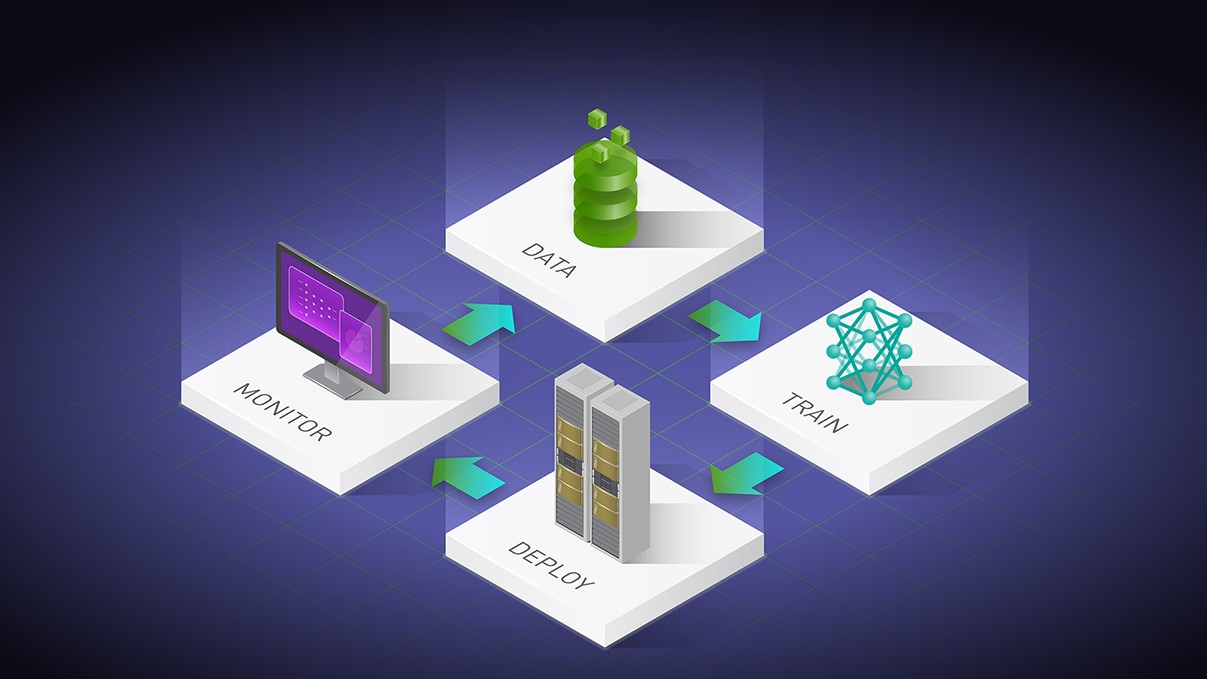

Phát triển các mô hình và ứng dụng Generative AI (GenAI) tùy biến là một hành trình, không phải là đích đến. Nó bắt đầu bằng việc chọn một mô hình được đào tạo trước (pretrained), chẳng hạn như Mô hình ngôn ngữ lớn (Large Language Model) cho những mục đích khám phá – sau đó, các developer thường muốn điều chỉnh mô hình đó cho trường hợp sử dụng cụ thể của họ. Bước đầu tiên này thường yêu cầu việc sử dụng hạ tầng tính toán có thể tiếp cận được, chẳng hạn như PC hoặc máy trạm (workstation). Nhưng khi các job đào tạo ngày càng lớn, developer buộc phải mở rộng sang hạ tầng tính toán bổ sung trong data center hoặc cloud.

Quá trình này có thể trở nên vô cùng phức tạp và tốn thời gian, đặc biệt là khi cố gắng cộng tác và triển khai trên nhiều môi trường và nền tảng. NVIDIA AI Workbench giúp đơn giản hóa quy trình bằng việc cung cấp một nền tảng duy nhất để quản lý dữ liệu, mô hình, tài nguyên và nhu cầu tính toán. Điều này cho phép các developer cộng tác và triển khai liền mạch để nhanh chóng phát triển các mô hình GenAI có thể mở rộng với hiệu quả về chi phí.

NVIDIA AI Workbench là gì?

NVIDIA AI Workbench là bộ công cụ hợp nhất, dễ sử dụng dành cho developer để tạo, thử nghiệm và tùy biến các mô hình AI được đào tạo trước trên PC hoặc máy trạm. Sau đó, người dùng có thể mở rộng các mô hình đến hầu hết mọi data center, public cloud hoặc NVIDIA DGX Cloud. Nó cho phép các developer ở mọi cấp độ tạo và triển khai các mô hình GenAI có khả năng mở rộng và hiệu quả về chi phí một cách nhanh chóng và dễ dàng.

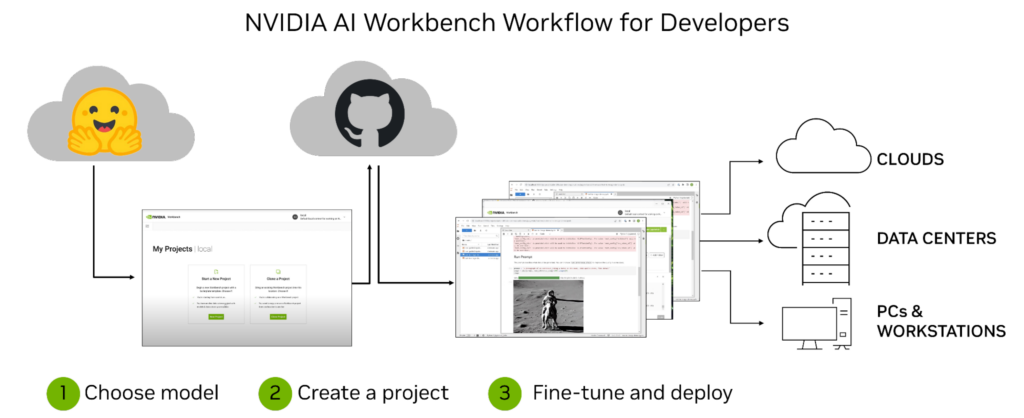

Hình 1. Các developer AI chọn một mô hình, tạo một dự án trong NVIDIA AI Workbench và tùy biến mô hình đó trên hạ tầng của họ

Sau khi cài đặt, nền tảng này cung cấp khả năng quản lý và triển khai cho các môi trường phát triển được đóng gói để đảm bảo mọi thứ hoạt động, bất kể máy của người dùng là gì. AI Workbench tích hợp với các nền tảng như GitHub, Hugging Face và NVIDIA NGC, cũng như với các self-hosted registry và máy chủ Git.

Người dùng có thể phát triển một cách tự nhiên trong cả JupyterLab và VS Code trong khi quản lý công việc trên nhiều loại máy với mức độ tái lập và minh bạch cao. Developer với NVIDIA RTX PC hoặc máy trạm cũng có thể khởi chạy, thử nghiệm và tinh chỉnh các dự án GenAI cấp doanh nghiệp trên những hệ thống local của họ, đồng thời truy cập tài nguyên điện toán đám mây và trung tâm dữ liệu khi mở rộng quy mô.

Các doanh nghiệp có thể kết nối AI Workbench với NVIDIA AI Enterprise, đẩy nhanh việc áp dụng GenAI và mở đường cho việc tích hợp liền mạch trong sản xuất. Đăng ký để nhận thông báo khi AI Workbench có sẵn để truy cập sớm.

Tinh chỉnh Generative AI với NVIDIA AI Workbench

Những thách thức về quy trình phát triển AI trong doanh nghiệp

Mặc dù các mô hình GenAI mang lại tiềm năng đáng kinh ngạc cho các doanh nghiệp, nhưng quá trình phát triển có thể phức tạp và tốn thời gian.

Một số thách thức mà các doanh nghiệp phải đối mặt khi họ bắt đầu hành trình phát triển GenAI tuỳ biến bao gồm những điều sau:

Chuyên môn kỹ thuật: Có những kỹ năng kỹ thuật phù hợp là chìa khóa khi làm việc trên các mô hình GenAI. Các developer phải có hiểu biết sâu sắc về các thuật toán Học máy, kỹ thuật can thiệp dữ liệu, các ngôn ngữ như Python và các framework như TensorFlow.

Truy cập và bảo mật dữ liệu: Đối với sự gia tăng dữ liệu khách hàng nhạy cảm – điều quan trọng là phải đảm bảo các biện pháp bảo mật phù hợp được thực hiện trong các dự án như vậy. Ngoài ra, các doanh nghiệp phải xem xét cách họ sẽ truy cập các bộ dữ liệu cần thiết để đào tạo mô hình của mình, điều này có thể liên quan đến việc xử lý một lượng lớn dữ liệu phi cấu trúc hoặc bán cấu trúc từ nhiều nguồn.

Di chuyển quy trình công việc và ứng dụng: Phát triển và triển khai trên các máy (machine) và các môi trường có thể phức tạp do sự phụ thuộc giữa các thành phần. Việc theo dõi các phiên bản khác nhau của cùng một ứng dụng hoặc quy trình làm việc có thể khó khăn, đặc biệt là trong các môi trường phân tán hơn chẳng hạn như các nền tảng điện toán đám mây như Amazon AWS, Google Cloud Platform hoặc Microsoft Azure. Ngoài ra, việc quản lý thông tin đăng nhập và thông tin mật là điều cần thiết để bảo vệ quyền truy cập an toàn vào tài nguyên trên các máy và các môi trường.

Những thách thức này nhấn mạnh tầm quan trọng của việc có một nền tảng toàn diện như NVIDIA AI Workbench – giúp đơn giản hóa toàn bộ quy trình phát triển Generative AI. Điều này giúp quản lý dữ liệu, mô hình, tài nguyên tính toán, sự phụ thuộc giữa các thành phần và phiên bản dễ dàng hơn. Đồng thời cung cấp khả năng cộng tác và triển khai liền mạch trên các máy và các môi trường.

Lợi ích chính của NVIDIA AI Workbench

Phát triển các mô hình GenAI là một quá trình phức tạp và AI Workbench chuẩn hoá nó. Với nền tảng hợp nhất để quản lý dữ liệu, mô hình và tài nguyên tính toán, các developer ở mọi cấp độ kỹ năng có thể nhanh chóng và dễ dàng tạo cũng như triển khai các mô hình AI có thể mở rộng, tiết kiệm chi phí.

Một số lợi ích chính của việc sử dụng AI Workbench bao gồm:

Nền tảng phát triển dễ sử dụng: AI Workbench đơn giản hóa quá trình phát triển bằng việc cung cấp một nền tảng duy nhất để quản lý dữ liệu, mô hình và tài nguyên tính toán để hỗ trợ cộng tác giữa các máy và các môi trường.

Tích hợp với kho lưu trữ và công cụ phát triển AI: AI Workbench tích hợp với các dịch vụ như GitHub, NVIDIA NGC và Hugging Face, các self-hosted registry và máy chủ Git. Người dùng có thể phát triển bằng cách sử dụng các công cụ như JupyterLab và VS Code, trên các nền tảng và cơ sở hạ tầng với mức độ tái lập và minh bạch cao.

Cộng tác nâng cao: AI Workbench sử dụng kiến trúc tập trung xung quanh một dự án, là một Git repository với các file metadata mô tả nội dung và mối quan hệ của chúng, các tập lệnh dành cho cấu hình và thực thi. Vị trí hoặc dữ liệu phụ thuộc vào người dùng được AI Workbench xử lý minh bạch và được đưa vào trong thời gian chạy để thông tin đó không bị mã hóa cứng vào các dự án. Cấu trúc dự án giúp tự động hóa các tác vụ phức tạp xung quanh việc lập phiên bản, quản lý container và xử lý thông tin mật đồng thời cho phép cộng tác giữa các nhóm.

Truy cập tính toán tăng tốc: Triển khai AI Workbench là mô hình client-server. Giao diện người dùng Workbench chạy trên hệ thống local và giao tiếp với Dịch vụ Workbench từ xa. Cả giao diện người dùng và dịch vụ đều chạy local trên tài nguyên chính của người dùng, chẳng hạn như laptop làm việc. Dịch vụ có thể được cài đặt trên các máy từ xa có thể truy cập thông qua kết nối SSH. Điều này cho phép các nhóm bắt đầu phát triển trên tài nguyên tính toán local trong các máy trạm của họ và chuyển sang tài nguyên data center hoặc cloud khi các job đào tạo lớn hơn.

NVIDIA AI Workbench đang hoạt động

Tại SIGGRAPH 2023, chúng tôi đã chứng minh sức mạnh của AI Workbench để tùy biến Generative AI trên cả quy trình công việc văn bản và hình ảnh.

Tạo hình ảnh tùy biến với Stable Diffusion XL

Mặc dù các ứng dụng Gradio trên các dịch vụ như Hugging Face Spaces cung cấp khả năng tương tác one-click với các mô hình như Stable Diffusion XL, nhưng để các mô hình và ứng dụng này chạy ở local có thể khó khăn.

Người dùng phải thiết lập môi trường local bằng phần mềm NVIDIA thích hợp, chẳng hạn như NVIDIA TensorRT và NVIDIA Triton. Sau đó, họ cần các mô hình từ Hugging Face, code từ GitHub và các container từ NVIDIA NGC. Cuối cùng, họ phải cấu hình container, xử lý các ứng dụng như JupyterLab và đảm bảo GPU của họ hỗ trợ kích thước của mô hình.

Chỉ khi đó họ mới sẵn sàng bắt tay vào công việc. Đó là rất nhiều việc phải làm, ngay cả đối với các chuyên gia.

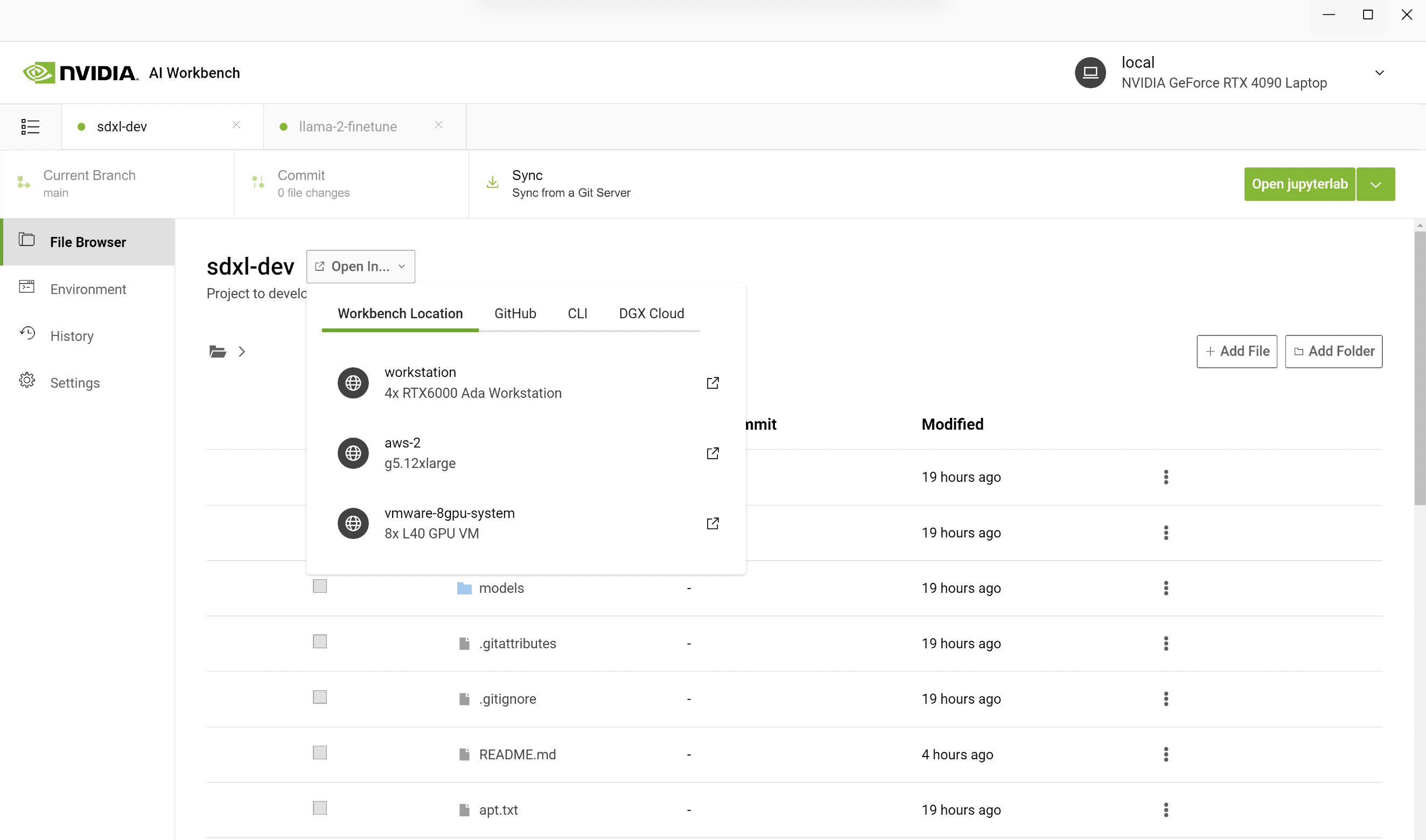

AI Workbench giúp dễ dàng hoàn thành toàn bộ quy trình bằng việc clone một dự án Workbench từ GitHub. Ví dụ sau đây phác thảo các bước mà nhóm của chúng tôi đã thực hiện khi tạo hình ảnh Toy Jensen.

Chúng tôi bắt đầu bằng cách mở AI Workbench trên PC và clone một repo với URL. Thay vì chạy Jupyter Notebook local, chúng tôi đã mở nó trên một máy trạm từ xa với nhiều GPU hơn. Trong AI Workbench, bạn có thể chọn máy trạm của mình và mở Jupyter Notebook.

Hình 2. Screenshot hiển thị AI Workbench chạy trên Jupyter Notebook

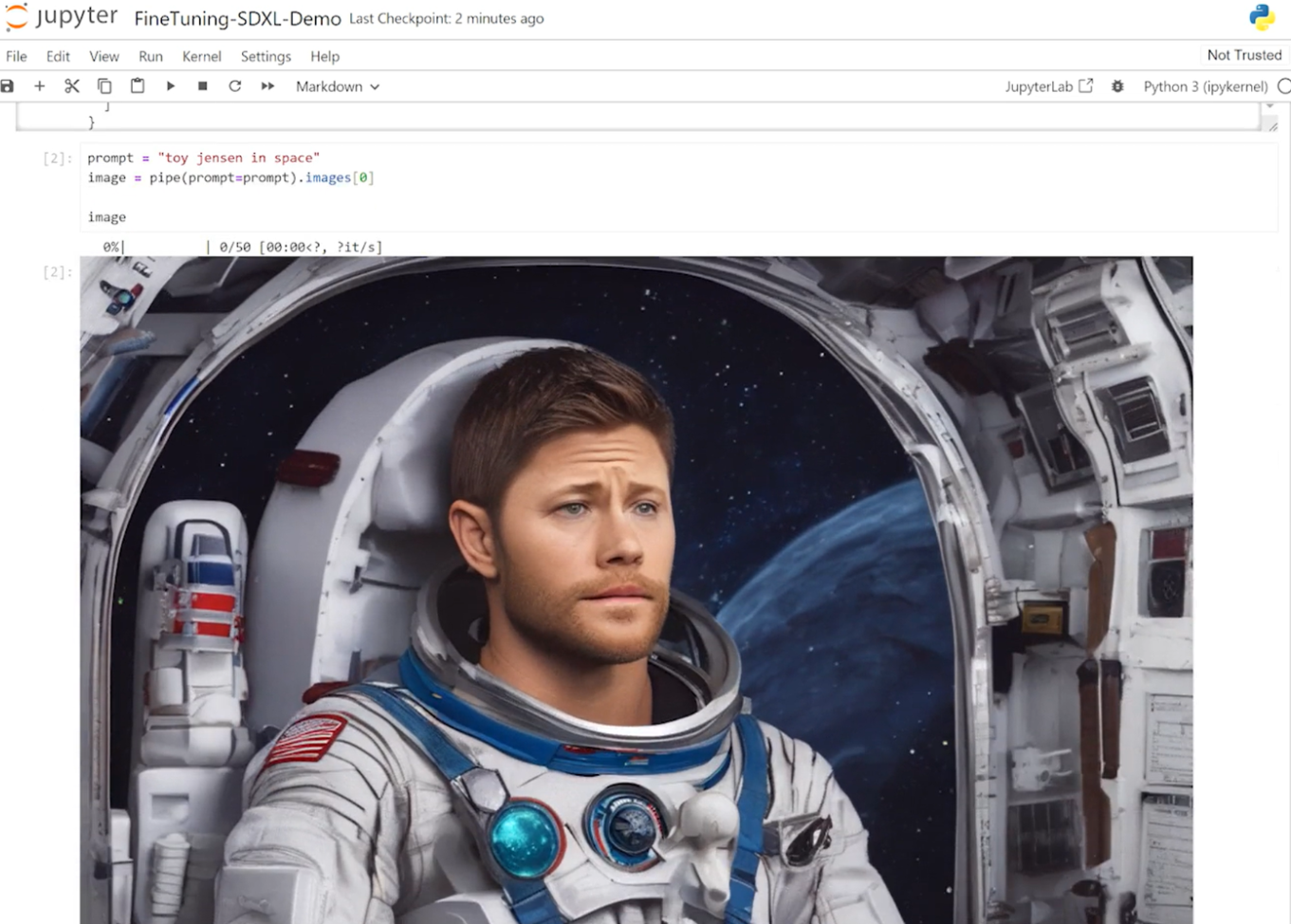

Trong Jupyter Notebook, chúng tôi đã tải mô hình Stable Diffusion XL được đào tạo trước từ Hugging Face và yêu cầu nó tạo ra hình ảnh “Toy Jensen trong không gian”. Tuy nhiên, dựa trên hình ảnh đầu ra (output image), mô hình không biết Toy Jensen là ai.

Hình 3. Screenshot hiển thị AI Workbench chạy Jupyter Notebook với output từ mô hình Stable Diffusion XL

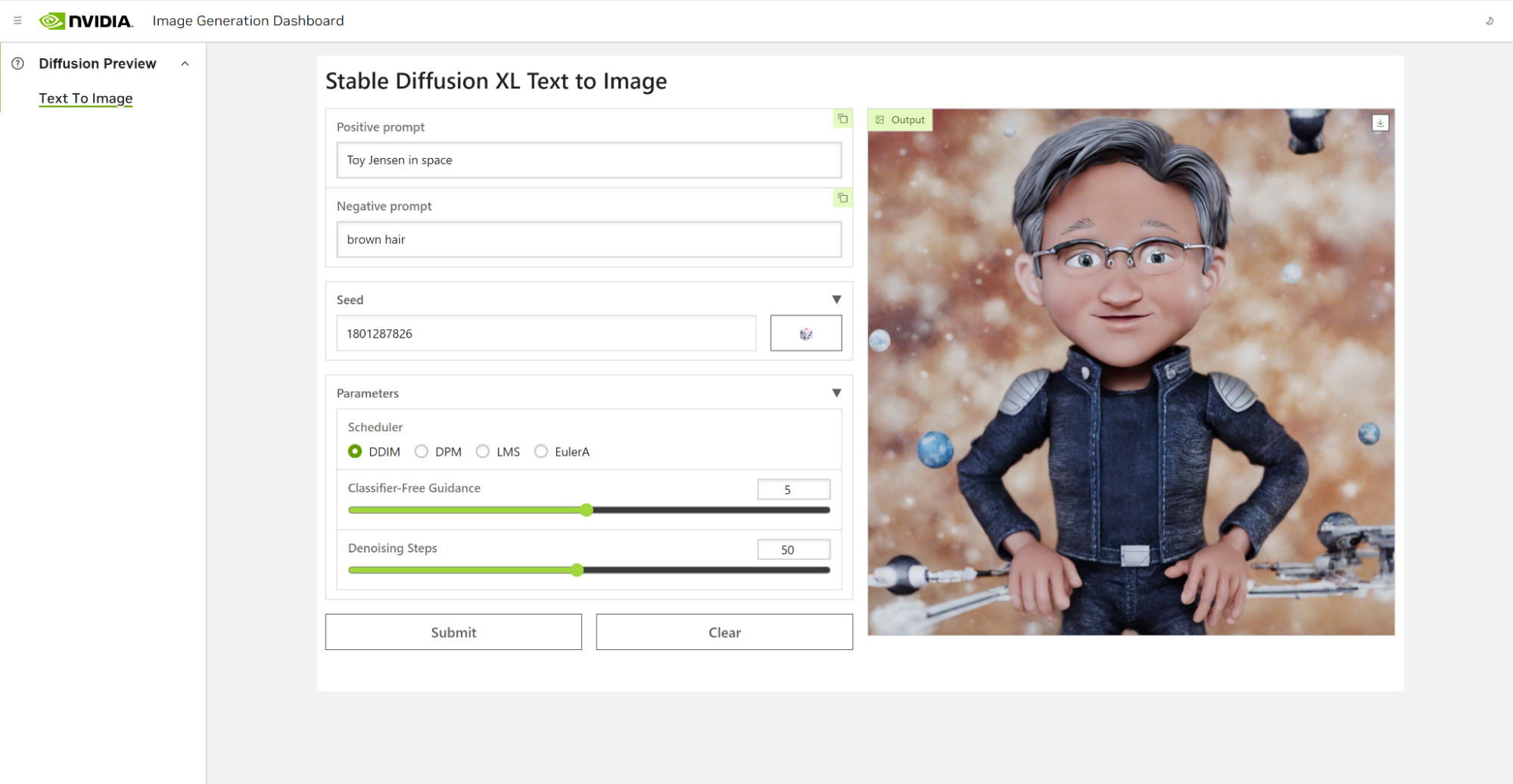

Việc sử dụng DreamBooth để tinh chỉnh mô hình, cho phép chúng tôi cá nhân hóa nó theo một chủ đề quan tâm cụ thể. Trong trường hợp của Toy Jensen, chúng tôi đã sử dụng 8 bức ảnh của Toy Jensen để tinh chỉnh mô hình và thu được kết quả tốt. Bây giờ chúng tôi sẵn sàng để chạy lại suy luận với giao diện người dùng. Giờ đây, mô hình đã biết Toy Jensen trông như thế nào và có thể tạo ra những bức ảnh đẹp hơn, như trong Hình 4.

Hình 4. Screenshot hiển thị AI Workbench chạy Jupyter Notebook với output từ mô hình Stable Diffusion XL của hình ảnh Toy Jensen sau khi đào tạo

Tinh chỉnh Llama 2 cho Y tế

Các mô hình lớn hơn như Llama 2 70B yêu cầu sức mạnh tính toán được tăng tốc hơn một chút cho cả tinh chỉnh và suy luận. Trong bản demo này, chúng tôi cần thiết lập các GPU trong data center để có thể tùy chỉnh mô hình.

Thông thường, công việc thiết lập các môi trường, kết nối dịch vụ, tải xuống tài nguyên, cấu hình container,… được thực hiện trên tài nguyên từ xa. Với AI Workbench, chúng tôi chỉ phải clone một dự án từ GitHub và nhấn Start JupyterLab.

Mục tiêu của bản demo này là sử dụng mô hình Llama-2 để xây dựng một chatbot chuyên dụng cho trường hợp sử dụng y tế. Nhìn chung, mô hình Llama-2 không đáp ứng tốt các câu hỏi y tế về tài liệu nghiên cứu, vì vậy chúng tôi phải tùy chỉnh mô hình.

Bắt đầu trên laptop, chúng tôi kết nối với 8 GPU NVIDIA L40 chạy trong data center hoặc cloud. Các dự án local được migrate sang một máy từ xa nhờ sử dụng AI Workbench.

Hình 5. Screenshot hiển thị AI Workbench tùy chỉnh mô hình Llama 2 với dữ liệu từ bộ dữ liệu PubMedQA

Từ AI Workbench, một môi trường Jupyter được khởi chạy và bao gồm P-tuning notebook, nơi chúng tôi tải mô hình Llama-2 đã được đào tạo trước.

Tiếp theo, chúng tôi sử dụng NeMo để P-tune nó với bộ dữ liệu PubMedQA mã nguồn mở. Sau đó, chúng tôi mở giao diện người dùng để chạy lại suy luận và giờ đây, mô hình của chúng tôi trả lời chính xác hơn các câu hỏi về các bệnh chưa biết trước đây dựa trên bối cảnh y tế nhất định.

Với AI Workbench, người dùng có thể nhanh chóng tạo hoặc clone các dự án GenAI có sẵn để bắt đầu. Các developer có thể đi từ khám phá ban đầu trên các máy local, cho đến điều chỉnh mô hình trên máy trạm và đưa vào các tài nguyên có thể mở rộng trong cloud và data center để đào tạo theo quy mô lớn.

Khả năng mở rộng hiệu quả chi phí của GenAI – sử dụng NVIDIA AI Workbench

Khi các mô hình AI ngày càng trở nên phức tạp và chuyên sâu về tính toán, điều cần thiết đối với các developer là phải có các công cụ tiết kiệm chi phí, cho phép họ mở rộng quy mô nhanh chóng và hiệu quả. AI Workbench cung cấp một nền tảng duy nhất để quản lý dữ liệu, mô hình và tài nguyên tính toán dành cho cộng tác và triển khai liền mạch trên các máy và các môi trường. Với nền tảng này, developer thuộc mọi cấp độ kỹ năng có thể nhanh chóng tạo và triển khai các mô hình Generative AI có thể mở rộng, tiết kiệm chi phí.

Để tìm hiểu thêm về AI Workbench hoặc đăng ký để được thông báo về khả năng truy cập sớm, hãy truy cập trang AI Workbench.

Theo NVIDIA

Bài viết liên quan

- Giới thiệu giải pháp Training AI trên các máy chủ thông dụng

- PowerScale: Nền tảng kiến trúc cho các tác vụ Generative AI

- NVIDIA Hopper tiếp tục dẫn đầu hiệu suất Generative AI trong MLPerf

- NVIDIA hỗ trợ hành trình hướng tới Generative AI thuận lợi hơn cho các doanh nghiệp

- NVIDIA NIM: Vi dịch vụ suy luận tối ưu hóa cho triển khai mô hình AI quy mô lớn

- Đơn giản hóa phát triển Generative AI tuỳ chỉnh với NVIDIA NeMo Microservices