TensorFlow là một thư viện mã nguồn mở hàng đầu được thiết kế để phát triển và triển khai các ứng dụng học máy (machine learning) tiên tiến nhất.

TensorFlow là gì ?

Được các nhà khoa học dữ liệu, nhà phát triển phần mềm và môi trường đào tạo sử dụng nhiều, TensorFlow là một nền tảng mã nguồn mở dành cho học máy, sử dụng biểu đồ luồng dữ liệu (data flow graphs). Các node trong biểu đồ biểu thị các hoạt động toán học, trong khi các cạnh của biểu đồ biểu thị các mảng dữ liệu đa chiều (tensor) chạy giữa chúng. Kiến trúc linh hoạt này cho phép các thuật toán máy học được mô tả dưới dạng biểu đồ các hoạt động được kết nối. Chúng có thể được đào tạo và thực thi trên GPU, CPU và TPU trên nhiều nền tảng khác nhau mà không cần viết lại mã, từ thiết bị di động đến máy tính để bàn đến máy chủ cao cấp. Điều này có nghĩa là các lập trình viên thuộc mọi nền tảng có thể sử dụng cùng một bộ công cụ để cộng tác, nâng cao hiệu quả một cách đáng kể. Ban đầu được phát triển bởi Nhóm Google Brain với mục đích tiến hành nghiên cứu máy học và mạng lưới thần kinh sâu (deep neural networks), hệ thống này đủ để có thể áp dụng trong nhiều lĩnh vực khác.

Cách thức hoạt động của TensorFlow

Có ba phần riêng biệt xác định quy trình làm việc của TensorFlow, cụ thể là xử lý dữ liệu, xây dựng mô hình và đào tạo mô hình để đưa ra dự đoán. Khung (framework) nhập dữ liệu dưới dạng một mảng đa chiều được gọi là tensor và thực thi theo hai kiểu khác nhau. Phương pháp chính là xây dựng biểu đồ tính toán xác định luồng dữ liệu để huấn luyện mô hình. Phương pháp thứ hai trực quan hơn là chấp hành tuân theo các nguyên tắc lập trình bắt buộc và đánh giá các hoạt động ngay lập tức.

Sử dụng kiến trúc TensorFlow, đào tạo (training) được thực hiện trên máy tính để bàn hoặc trong trung tâm dữ liệu. Trong cả hai trường hợp, quá trình này được tăng tốc bằng cách đặt các tensor trên GPU. Sau đó, các mô hình được đào tạo có thể chạy trên nhiều nền tảng, từ máy tính để bàn đến thiết bị di động và cho đến đám mây.

TensorFlow cũng chứa nhiều tính năng hỗ trợ. Ví dụ: TensorBoard , cho phép người dùng theo dõi trực quan quá trình đào tạo, đồ thị tính toán cơ bản và số liệu cho mục đích chạy gỡ lỗi và đánh giá hiệu suất mô hình. Tensor board là khung trực quan thống nhất cho Tensorflow và Keras.

Keras là một API cấp cao chạy trên TensorFlow. Keras tăng cường sự trừu tượng hóa của TensorFlow bằng cách cung cấp một API đơn giản hóa nhằm xây dựng các mô hình cho các trường hợp sử dụng phổ biến. Ý tưởng thúc đẩy đằng sau API là có thể dịch từ ý tưởng thành kết quả trong thời gian ngắn nhất có thể.

Lợi ích của TensorFlow

TensorFlow có thể được sử dụng để phát triển các mô hình cho các tác vụ khác nhau, bao gồm xử lý ngôn ngữ tự nhiên, nhận dạng hình ảnh, nhận dạng chữ viết tay và các mô phỏng dựa trên tính toán khác nhau như phương trình vi phân từng phần.

Lợi ích chính của TensorFlow là khả năng thực hiện các hoạt động cấp thấp trên nhiều nền tảng tăng tốc, tự động tính toán độ dốc, khả năng mở rộng ở cấp độ sản xuất và xuất biểu đồ có thể tương tác. Bằng cách cung cấp Keras dưới dạng API cấp cao và thực thi như một giải pháp thay thế cho mô hình luồng dữ liệu trên TensorFlow, bạn luôn dễ dàng viết mã một cách thoải mái.

Với tư cách là nhà phát triển ban đầu của TensorFlow, Google vẫn ủng hộ mạnh mẽ thư viện và đã thúc đẩy tốc độ phát triển nhanh chóng của nó. Ví dụ: Google đã tạo một trung tâm trực tuyến để chia sẻ nhiều mô hình khác nhau do người dùng tạo.

Các doanh nghiệp sử dụng TensorFlow

- Xử lý hình ảnh và phát hiện video. Nhà sản xuất máy bay khổng lồ Airbus đang sử dụng TensorFlow để trích xuất và phân tích thông tin từ hình ảnh vệ tinh nhằm cung cấp thông tin có giá trị theo thời gian thực cho khách hàng.

- Các thuật toán chuỗi thời gian. Kakao sử dụng TensorFlow để dự đoán tỷ lệ hoàn thành các yêu cầu gọi xe.

- Khả năng quy mô to lớn. NERSC đã mở rộng ứng dụng học sâu khoa học cho hơn 27.000 GPU NVIDIA V100 Tensor Core bằng cách sử dụng TensorFlow.

- Modeling. Bằng cách sử dụng TensorFlow để học chuyển giao sâu và tạo mô hình tổng quát, PayPal đã có thể nhận ra các kiểu lừa đảo phức tạp, thay đổi tạm thời và đồng thời cải thiện trải nghiệm của khách hàng hợp pháp thông qua nhận dạng khách hàng một cách nhanh chóng.

- Nhận dạng văn bản. SwissCom đã xây dựng mô hình tensorFlow một cách tuỳ chỉnh đã cải thiện hoạt động kinh doanh bằng cách phân loại văn bản, xác định ý định của khách hàng khi nhận cuộc gọi.

- Tweet prioritization. Twitter đã sử dụng TensorFlow để xây dựng xếp hạng các dòng thời gian, đảm bảo rằng người dùng không bỏ lỡ các tweet quan trọng nhất, ngay cả khi theo dõi hàng nghìn người dùng.

Tại sao TensorFlow lại quan trọng

Các nhà khoa học dữ liệuCó nhiều lộ trình khác nhau để phát triển mô hình với TensorFlow nghĩa là luôn có sẵn công cụ phù hợp cho công việc, thể hiện các ý tưởng đổi mới và thuật toán mới nhanh nhất có thể. Là một trong những thư viện phổ biến nhất để phát triển các mô hình máy học, người dùng dễ dàng tìm thấy mã TensorFlow từ các nhà nghiên cứu trước đây khi cố gắng mô phỏng công việc của họ, tránh mất thời gian cho mã soạn sẵn và mã dự phòng.

Các nhà phát triển phần mềmTensorFlow có thể chạy trên nhiều nền tảng phần cứng và môi trường hoạt động phổ biến. Với việc phát hành TensorFlow 2.0 vào cuối năm 2019, việc triển khai các mô hình TensorFlow trên nhiều nền tảng thậm chí còn dễ dàng hơn. Khả năng tương tác của các mô hình được tạo bằng TensorFlow có nghĩa là việc triển khai không bao giờ là một nhiệm vụ khó khăn.

TensorFlow và NVIDIA

Các đơn vị xử lý đồ họa, hay GPU, với kiến trúc song song khối lượng bao gồm hàng nghìn lõi nhỏ hiệu quả, có thể khởi chạy đồng thời hàng nghìn luồng xử lý song song để tăng tốc các tác vụ điện toán chuyên sâu.

Một thập kỷ trước, các nhà nghiên cứu đã phát hiện ra rằng GPU rất thành thạo trong các phép toán ma trận, cũng như tính toán đại số và học sâu phụ thuộc rất nhiều vào cả hai.

TensorFlow chạy nhanh hơn tới 50% trên GPU NVIDIA Pascal mới nhất và mở rộng tốt trên các GPU. Bây giờ người dùng có thể đào tạo các mô hình trong vài giờ thay vì vài ngày.

TensorFlow được viết bằng cả C++ được tối ưu hóa và Bộ công cụ NVIDIA CUDA, cho phép các mô hình chạy trên GPU tại thời điểm đào tạo và suy luận để tăng tốc độ.

TensorFlow GPU yêu cầu một số trình điều khiển và thư viện. Để đơn giản hóa việc cài đặt và tránh xung đột thư viện, người dùng nên tận dụng hình ảnh TensorFlow Docker có hỗ trợ GPU. Thiết lập này chỉ yêu cầu trình điều khiển GPU NVIDIA và cài đặt NVIDIA-docker . Người dùng có thể sử dụng containers từ NGC (Đám mây GPU NVIDIA) được cấu hình sẵn với các mô hình được đào tạo trước và hỗ trợ thư viện TensorFlow.

NVIDIA Deep Learning dành cho nhà phát triển

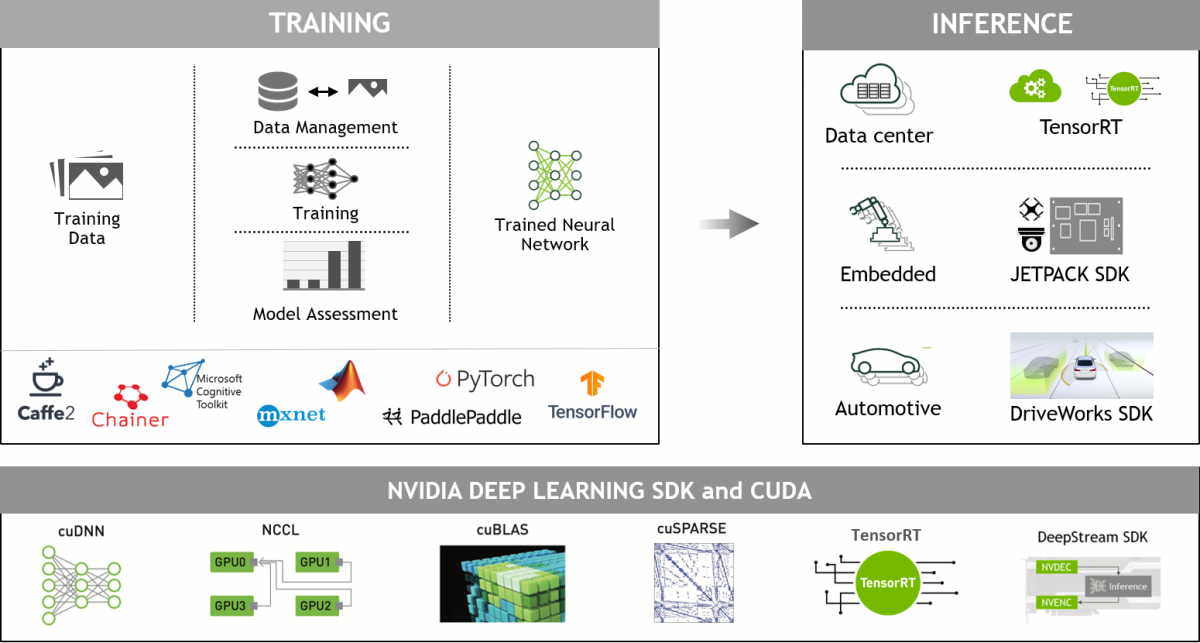

Các khung deep learning được GPU tăng tốc mang đến sự linh hoạt để thiết kế và đào tạo các mạng thần kinh chuyên sâu, đồng thời cung cấp giao diện cho các ngôn ngữ lập trình thường được sử dụng như Python và C/C++. Các khung học sâu (Deep Learning Frameworks) được sử dụng rộng rãi như MXNet, PyTorch, TensorFlow và các khung khác dựa trên các thư viện được tăng tốc bởi NVIDIA GPU cung cấp khả năng đào tạo tăng tốc multi-GPU với hiệu suất cao.

Khoa học dữ liệu toàn diện, được tăng tốc bởi NVIDIA GPU

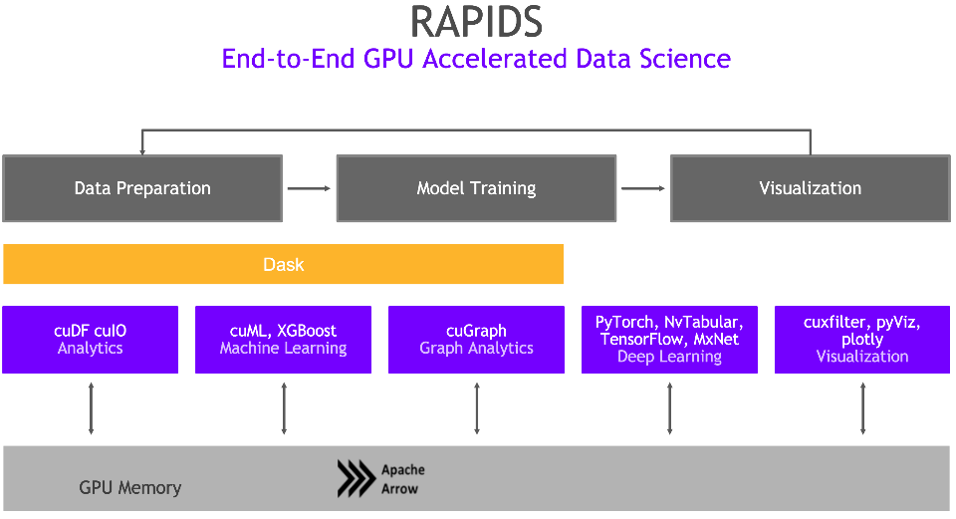

Bộ thư viện phần mềm mã nguồn mở NVIDIA RAPIDS, được xây dựng trên CUDA-X AI , mang đến cho người dùng khả năng thực thi các quy trình phân tích và khoa học dữ liệu từ đầu đến cuối hoàn toàn trên GPU. Nó dựa trên các nguyên mẫu NVIDIA CUDA để tối ưu hóa điện toán ở mức độ thấp, nhưng thể hiện tính song song của GPU và tốc độ bộ nhớ băng thông cao thông qua các giao diện Python thân thiện với người dùng.

Với Khung dữ liệu RAPIDS GPU, dữ liệu có thể được tải lên GPU bằng giao diện giống Pandas, sau đó được sử dụng cho các thuật toán phân tích đồ thị và máy học được kết nối khác nhau mà không phải rời khỏi GPU. Mức độ khả năng tương tác này có thể thực hiện được thông qua thư viện như Apache Arrow và cho phép tăng tốc cho các quy trình từ đầu đến cuối từ chuẩn bị dữ liệu đến học máy đến học sâu.

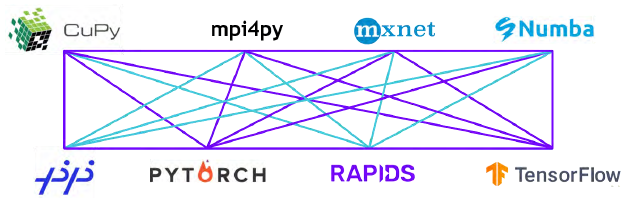

RAPIDS hỗ trợ chia sẻ bộ nhớ thiết bị giữa nhiều thư viện khoa học dữ liệu phổ biến. Điều này giữ cho dữ liệu trên GPU và tránh sao chép qua lại vào bộ nhớ máy chủ.

Bài viết liên quan

- 5 điều bạn cần biết về NVIDIA DGX Spark – Chiếc máy tính mơ ước của các nhà phát triển AI

- SLM và AI tại biên: Bình minh của một kỷ nguyên mới hay chỉ là cơn sốt nhất thời?

- NVIDIA tại Computex 2025: “Gã khổng lồ xanh” đặt cược tất cả vào AI, GeForce liệu có bị ra rìa?

- Tư vấn lựa chọn máy chủ GPU cho đào tạo AI trong ngành bán lẻ

- Khoa học đời sống: Khi đột phá nằm trong biển dữ liệu và chìa khóa mang tên hạ tầng AI

- Tổng quan về hệ thống giám sát an ninh bằng AI