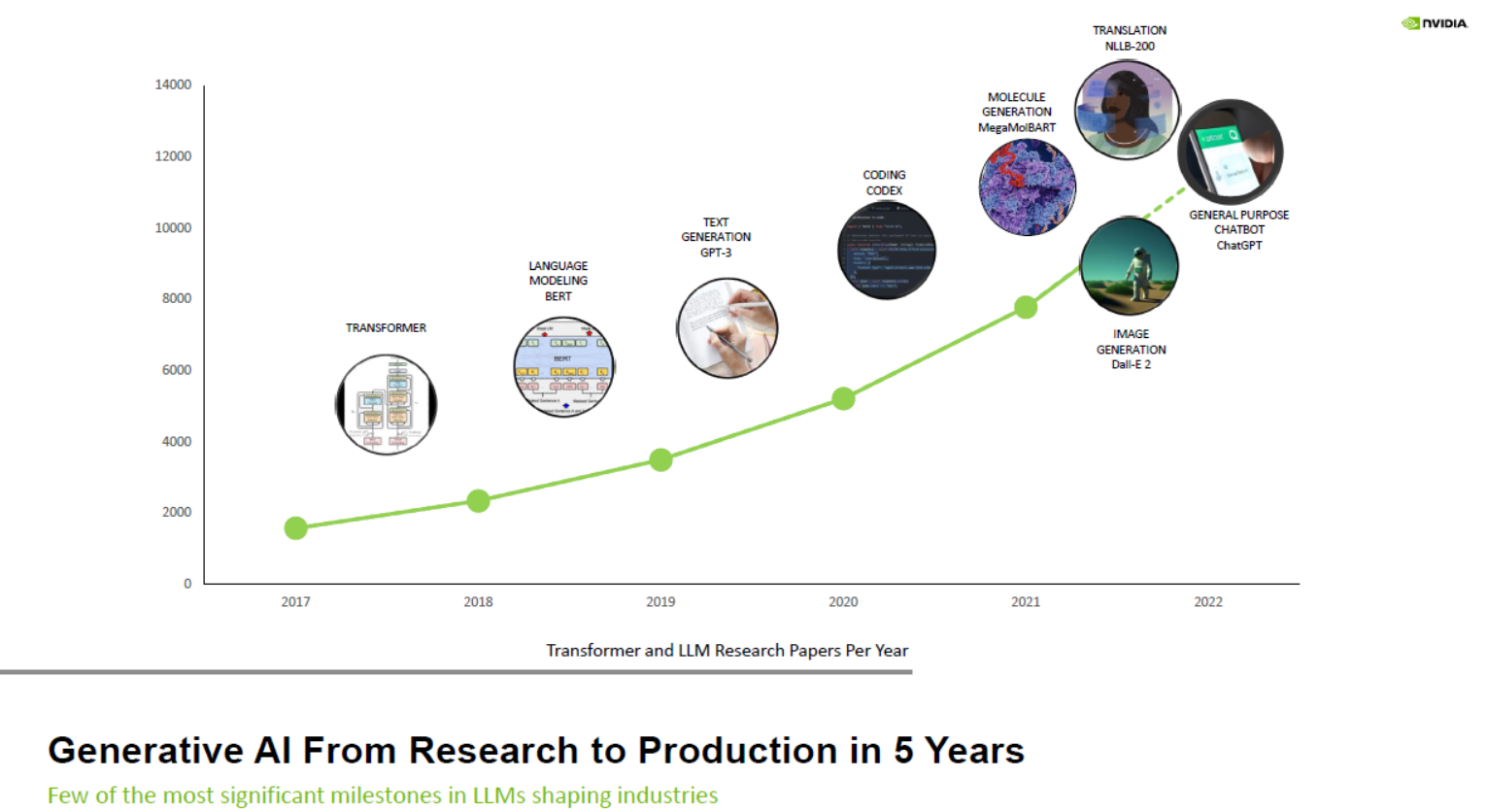

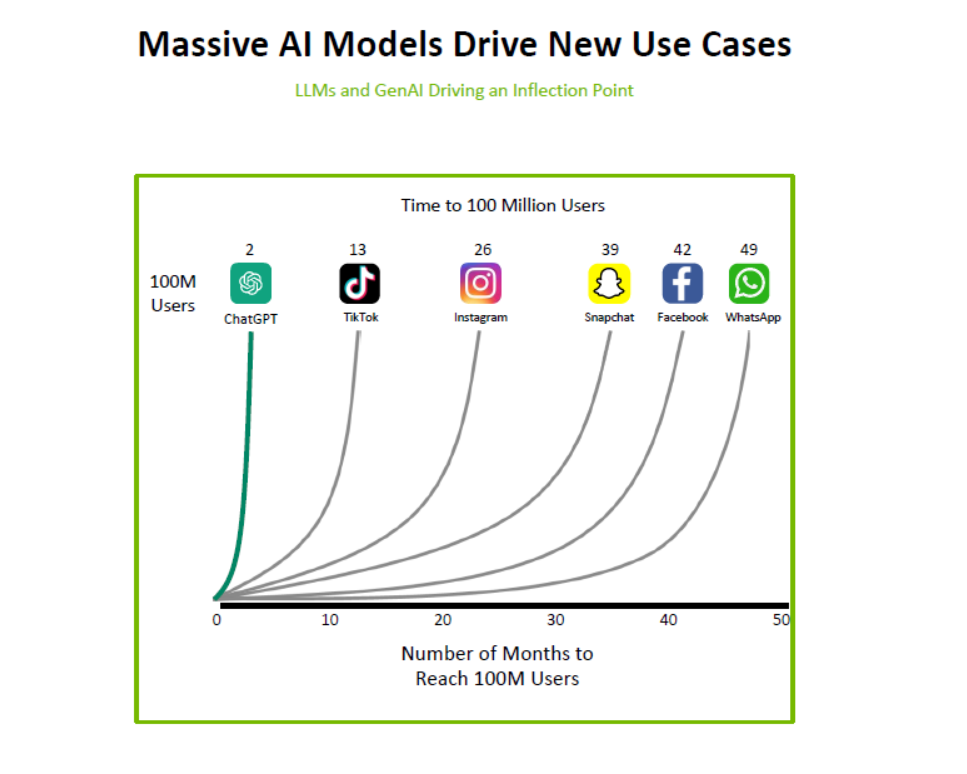

Trí Tuệ Nhân Tạo Sáng Tạo (Generative AI) đã trở thành một lực lượng biến đổi của thời đại chúng ta, trang bị cho các tổ chức trong mọi ngành công nghiệp khả năng nâng cao sản xuất, nâng tầm trải nghiệm khách hàng và cung cấp hiệu suất hoạt động vượt trội.

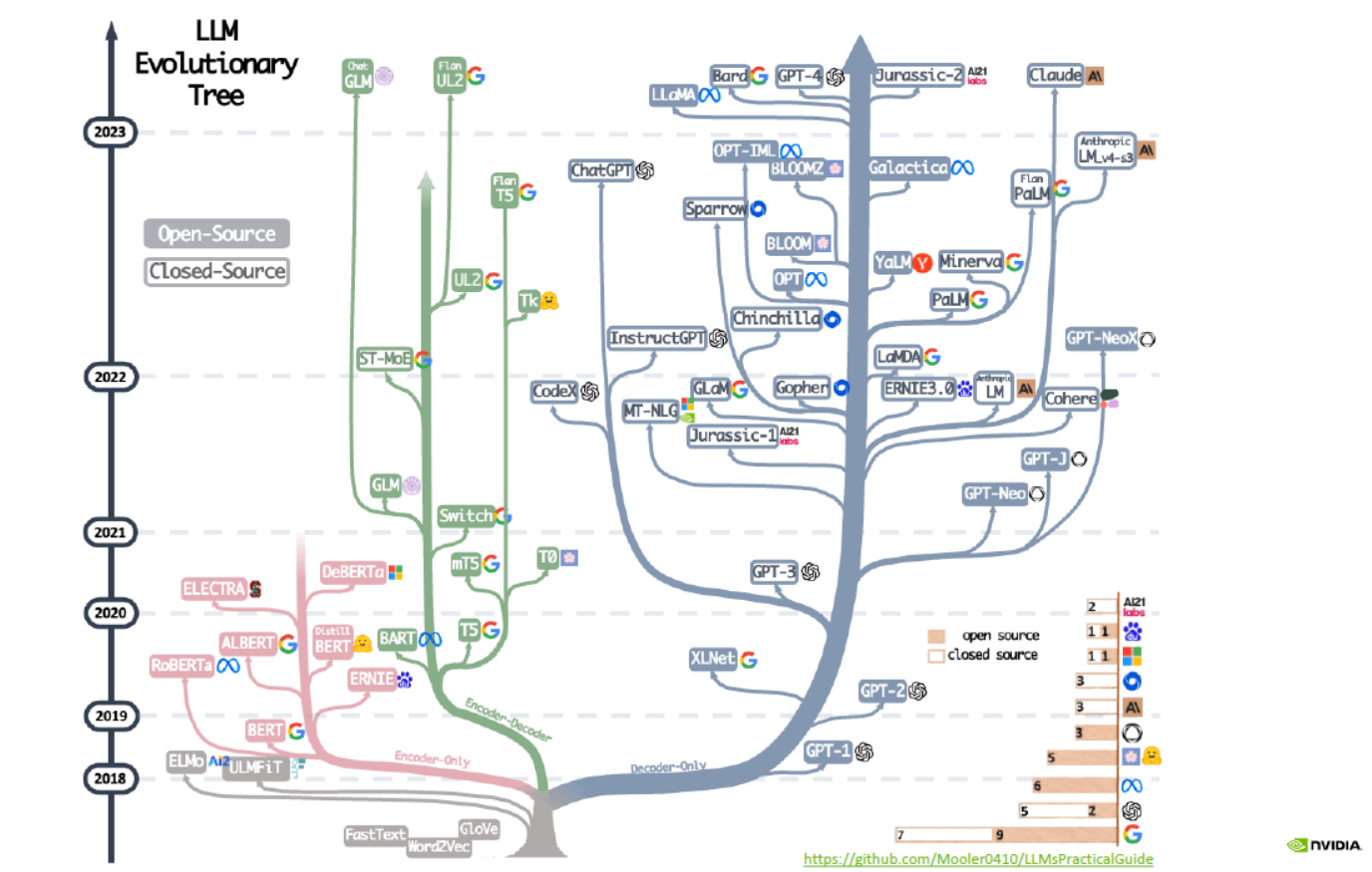

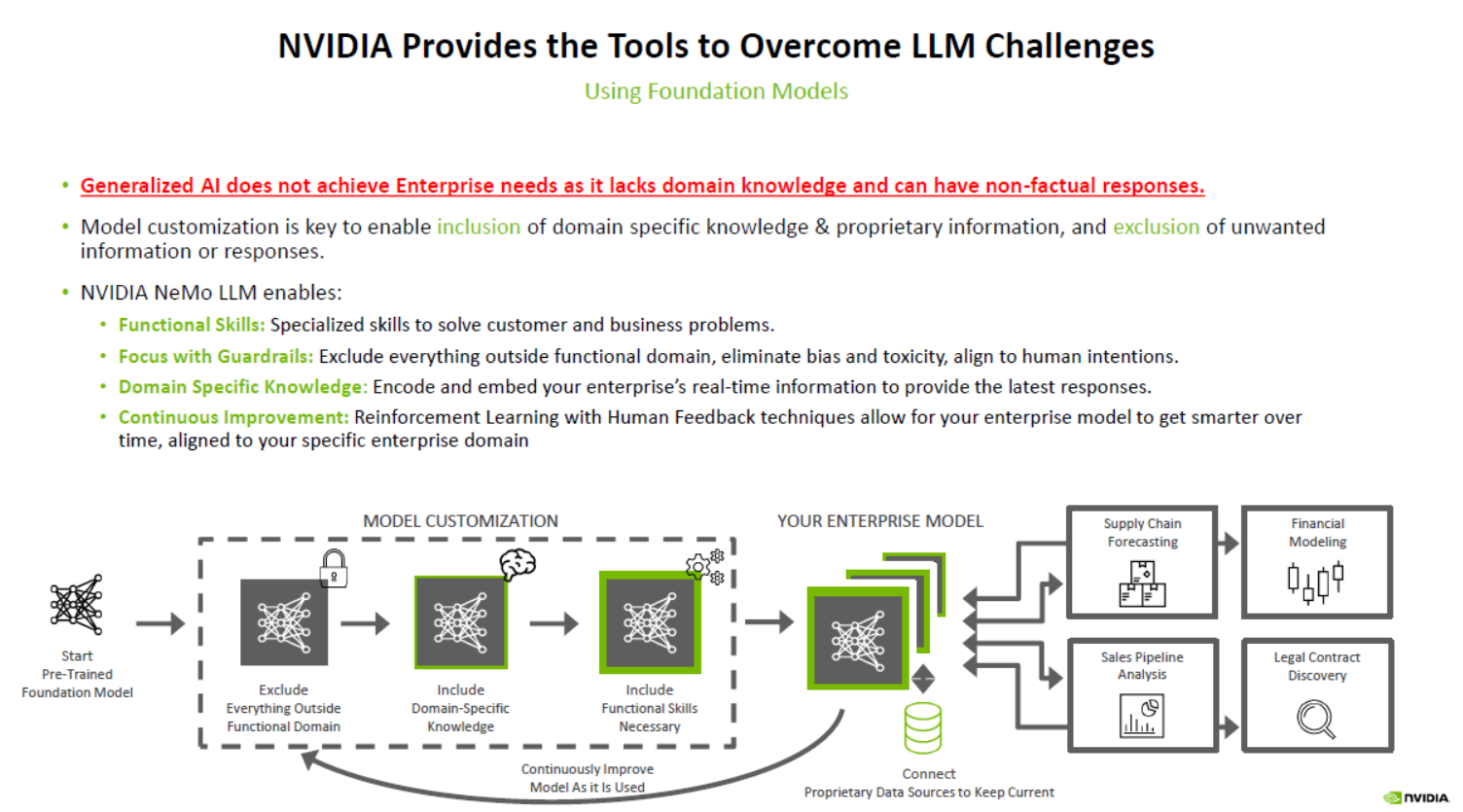

Các mô hình ngôn ngữ lớn (LLMs) đóng vai trò trí tuệ đằng sau Trí Tuệ Nhân Tạo Sáng Tạo. Khả năng tiếp cận các mô hình cơ sở vô cùng mạnh mẽ và thông minh, như Llama và Falcon, đã mở ra cánh cửa cho những cơ hội tuyệt vời. Tuy nhiên, những mô hình này thiếu kiến thức cụ thể về lĩnh vực cần thiết để phục vụ các trường hợp sử dụng của doanh nghiệp.

Những nhà phát triển có ba lựa chọn để đưa ứng dụng Trí Tuệ Nhân Tạo Sáng Tạo của họ vào hoạt động:

- LLMs đã được tiền xử lý: lựa chọn dễ dàng nhất là sử dụng các mô hình cơ sở, hoạt động rất tốt cho các trường hợp sử dụng dựa trên kiến thức chung.

- Tùy chỉnh LLMs: các mô hình đã được tiền xử lý được tùy chỉnh với kiến thức cụ thể về lĩnh vực, và các kỹ năng cụ thể nhiệm vụ, kết nối với cơ sở kiến thức của doanh nghiệp thực hiện nhiệm vụ và cung cấp câu trả lời dựa trên thông tin độc quyền mới nhất.

- Xây dựng LLMs: các tổ chức có dữ liệu chuyên biệt (ví dụ, các mô hình phục vụ cho ngôn ngữ khu vực) không thể sử dụng các mô hình cơ sở đã được tiền xử lý và phải xây dựng mô hình riêng từ đầu.

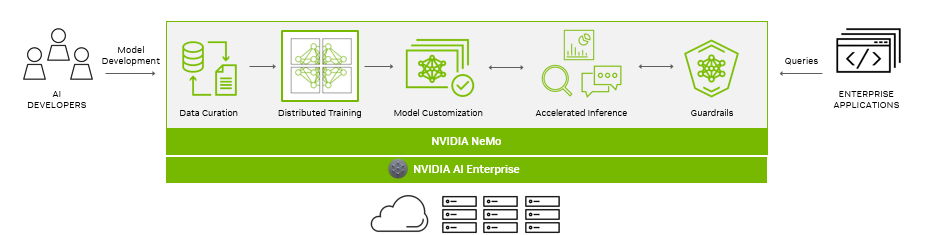

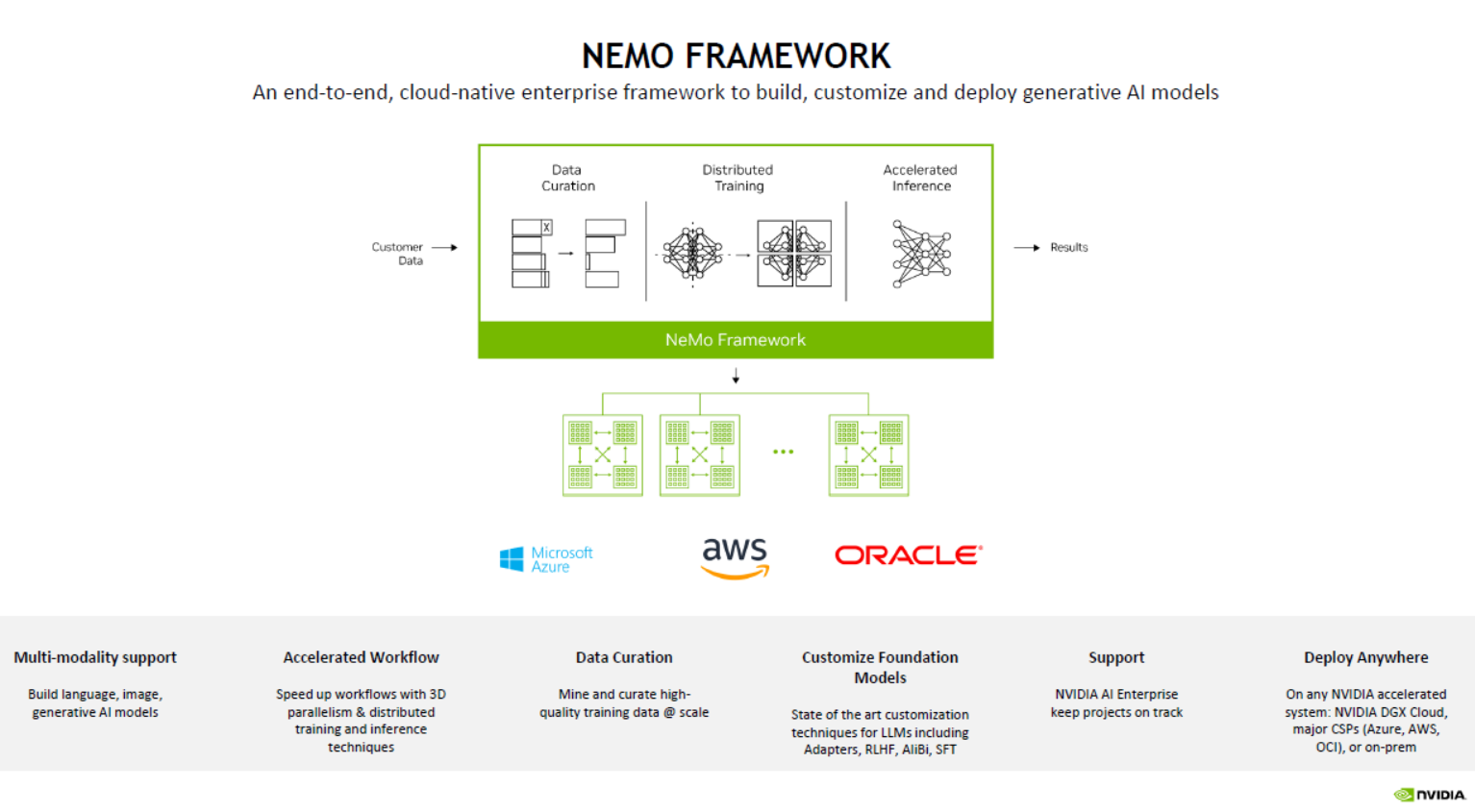

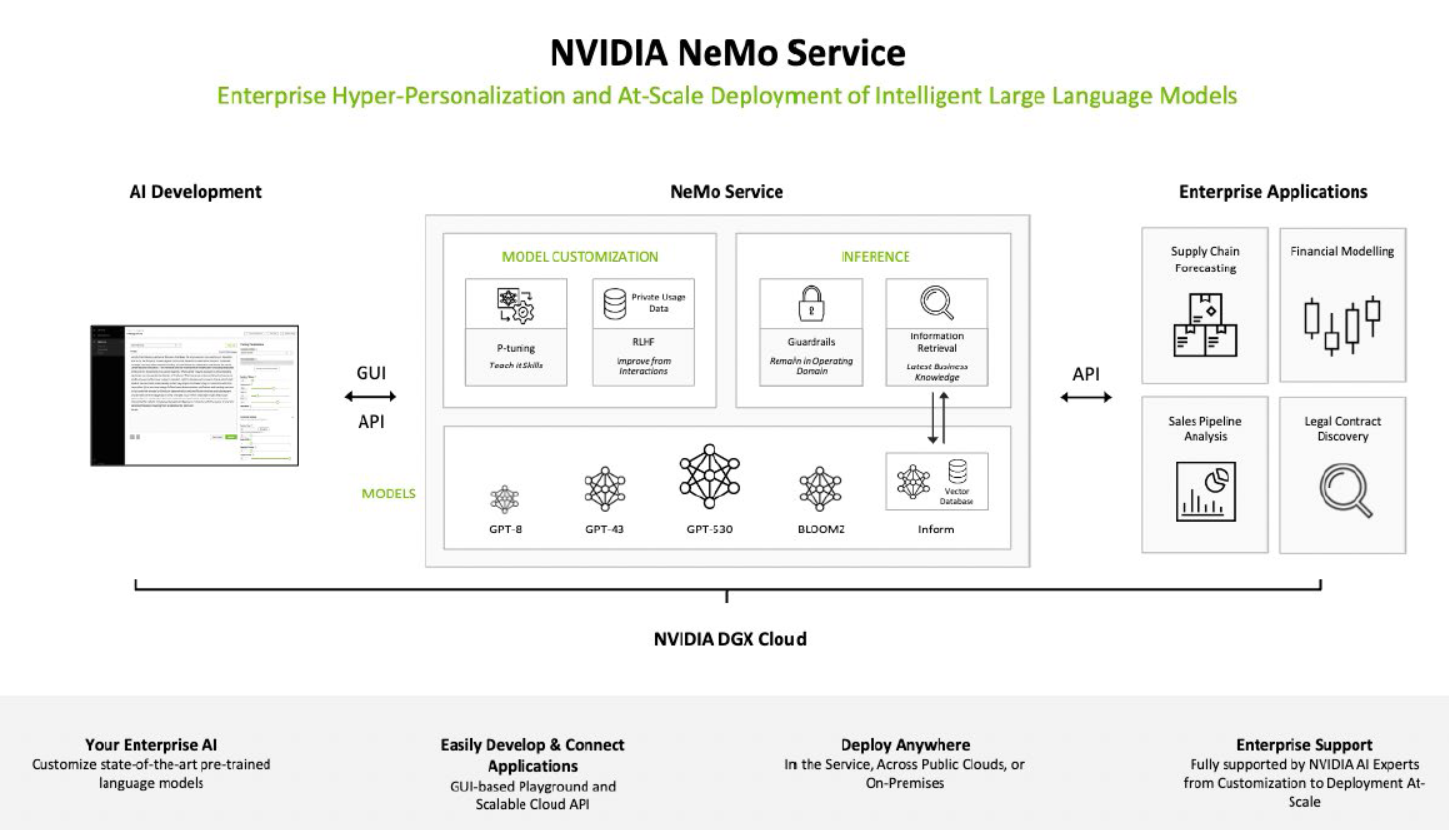

NVIDIA NeMo là một framework toàn diện, tích hợp trên nền đám mây cho việc xây dựng, tùy chỉnh và triển khai các mô hình Trí Tuệ Nhân Tạo Sáng Tạo. Nó bao gồm các framework huấn luyện và suy luận, bộ khung kiểm soát và công cụ chăm sóc dữ liệu, giúp dễ dàng, hiệu quả về chi phí và nhanh chóng áp dụng Trí Tuệ Nhân Tạo Sáng Tạo.

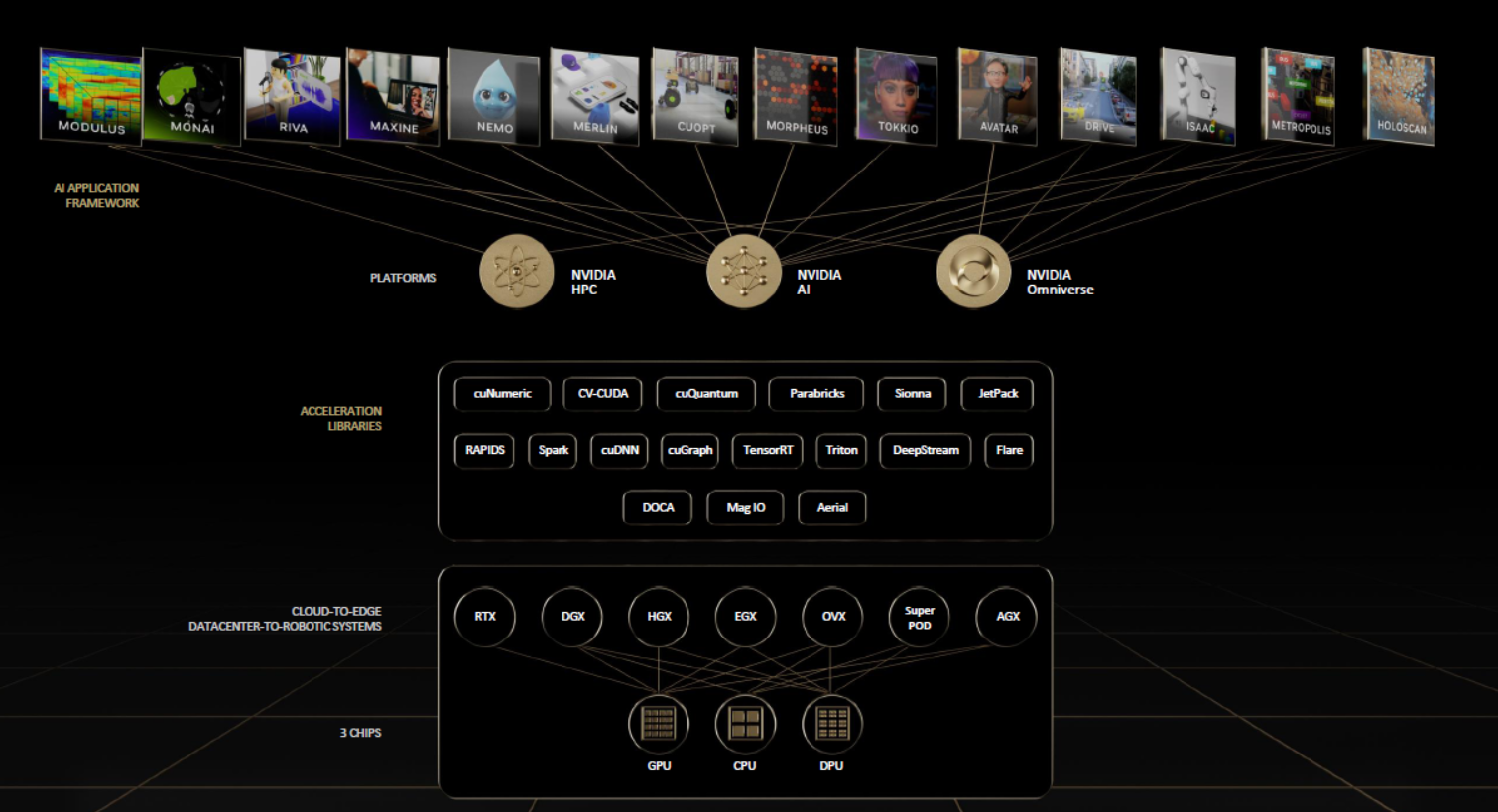

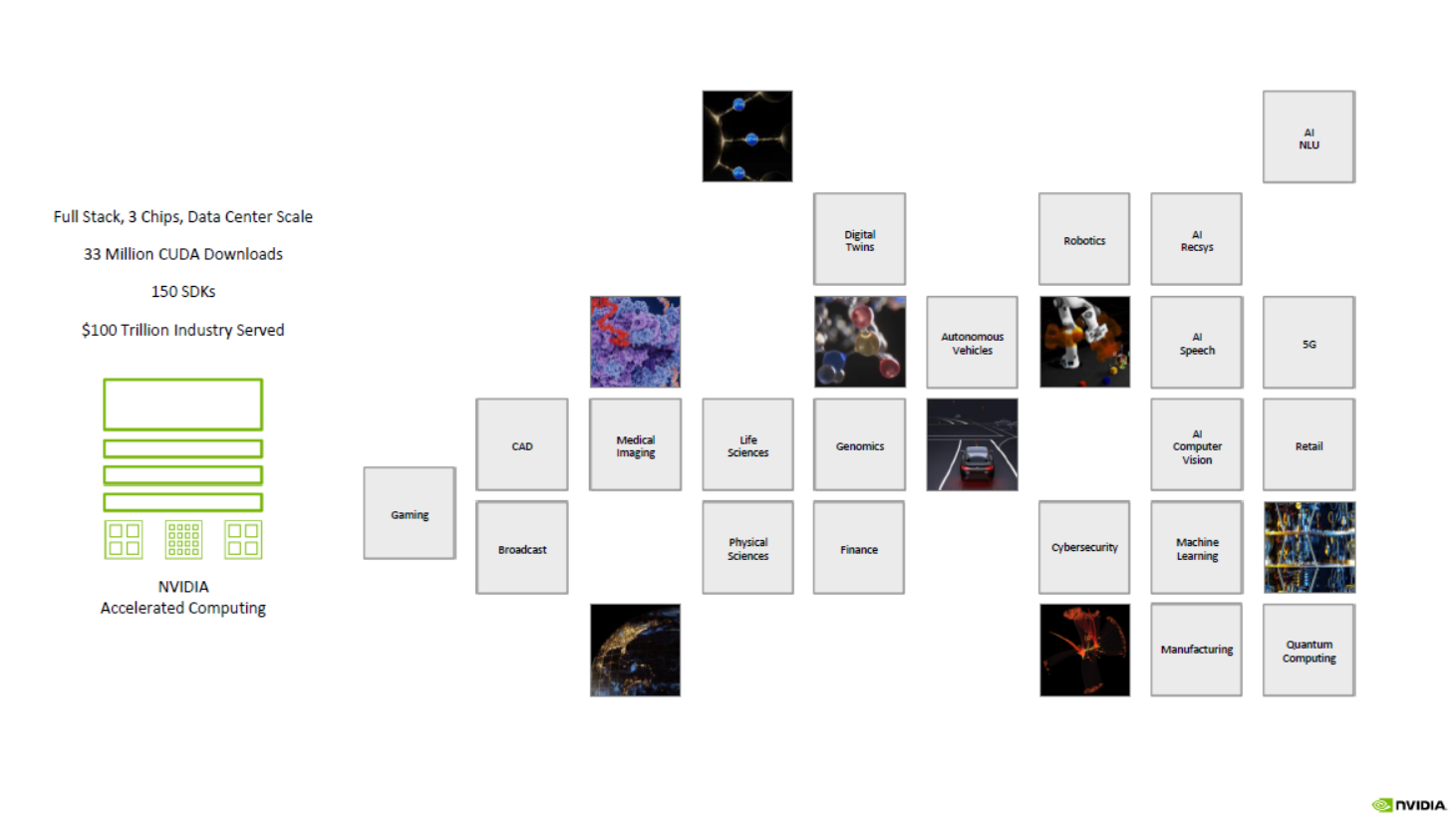

Khi các mô hình Trí Tuệ Nhân Tạo Sáng Tạo và quá trình phát triển chúng tiếp tục tiến bộ, ngăn xếp Trí Tuệ Nhân Tạo và các phụ thuộc của nó trở nên ngày càng phức tạp. Đối với các doanh nghiệp đang vận hành hoạt động dựa trên Trí Tuệ Nhân Tạo, NVIDIA cung cấp một giải pháp phần mềm toàn diện, an toàn và từ đầu đến cuối với NVIDIA AI Enterprise.

Các tổ chức đang triển khai các ứng dụng doanh nghiệp quan trọng của họ trên Google Cloud, một nhà cung cấp hàng đầu về nền tảng đám mây được tăng tốc bằng GPU. NVIDIA AI Enterprise, bao gồm NeMo và có sẵn trên Google Cloud, giúp các tổ chức áp dụng Trí Tuệ Nhân Tạo Sáng Tạo một cách nhanh chóng hơn.

Xây dựng một giải pháp Trí Tuệ Nhân Tạo Sáng Tạo yêu cầu toàn bộ ngăn xếp, từ việc tính toán đến mạng, hệ thống, phần mềm quản lý, các SDK huấn luyện và suy luận hoạt động một cách hòa hợp.

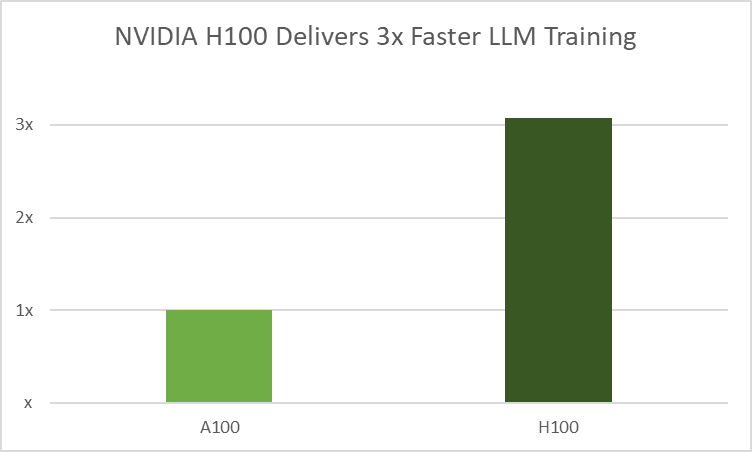

Tại sự kiện Google Cloud Next 2023, Google Cloud thông báo về tính sẵn có của các phiên bản A3 được trang bị GPU NVIDIA H100 Tensor Core. Các nhóm kỹ thuật từ cả hai công ty đang hợp tác để đưa NeMo vào các phiên bản A3 để tăng tốc huấn luyện và suy luận.

Trong bài viết này, chúng ta sẽ đề cập đến các tối ưu hóa trong việc huấn luyện và suy luận mà các nhà phát triển có thể trải nghiệm khi xây dựng và chạy mô hình Trí Tuệ Nhân Tạo Sáng Tạo tùy chỉnh trên GPU NVIDIA H100.

Xử lý dữ liệu với quy mô lớn

Khả năng của một LLM đơn lẻ đạt được kết quả xuất sắc trên nhiều nhiệm vụ đa dạng đến từ việc huấn luyện trên lượng dữ liệu quy mô Internet khổng lồ.

NVIDIA NeMo Data Curator giúp xử lý dữ liệu huấn luyện đa ngôn ngữ với hàng nghìn tỷ từ cho LLMs. Nó bao gồm một bộ sưu tập các module Python sử dụng MPI, Dask và một cụm Redis để mở rộng các tác vụ liên quan đến việc chăm sóc dữ liệu một cách hiệu quả. Các tác vụ này bao gồm tải xuống dữ liệu, trích xuất văn bản, định dạng lại văn bản, lọc chất lượng và loại bỏ dữ liệu trùng lặp chính xác hoặc mờ. Công cụ này có thể phân phát các tác vụ này trên hàng ngàn lõi tính toán.

Việc sử dụng các module này giúp các nhà phát triển nhanh chóng lọc qua các nguồn dữ liệu không cấu trúc. Công nghệ này tăng tốc quá trình huấn luyện mô hình, giảm chi phí thông qua việc chuẩn bị dữ liệu hiệu quả và mang lại kết quả chính xác hơn.

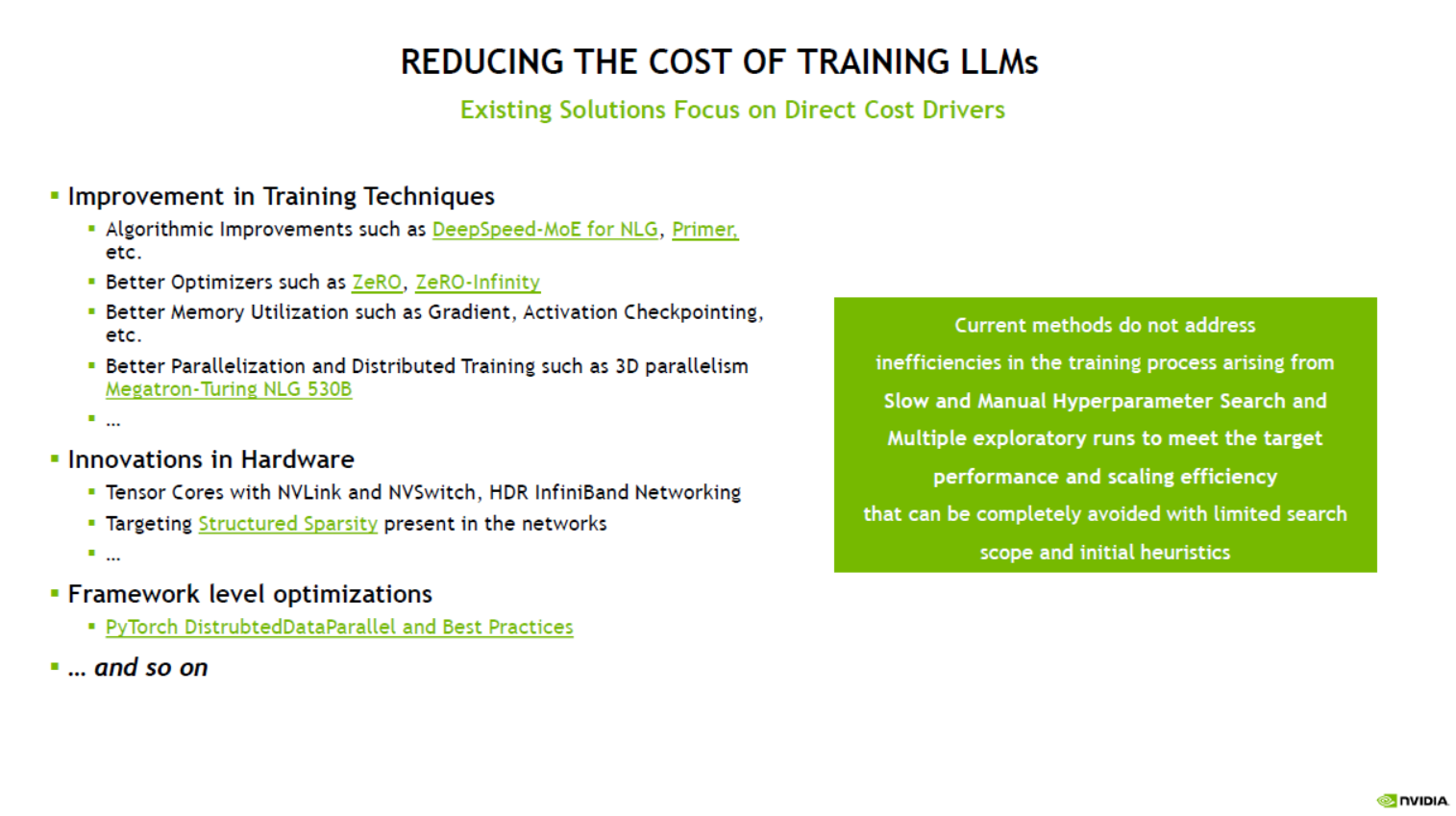

Tăng tốc huấn luyện mô hình

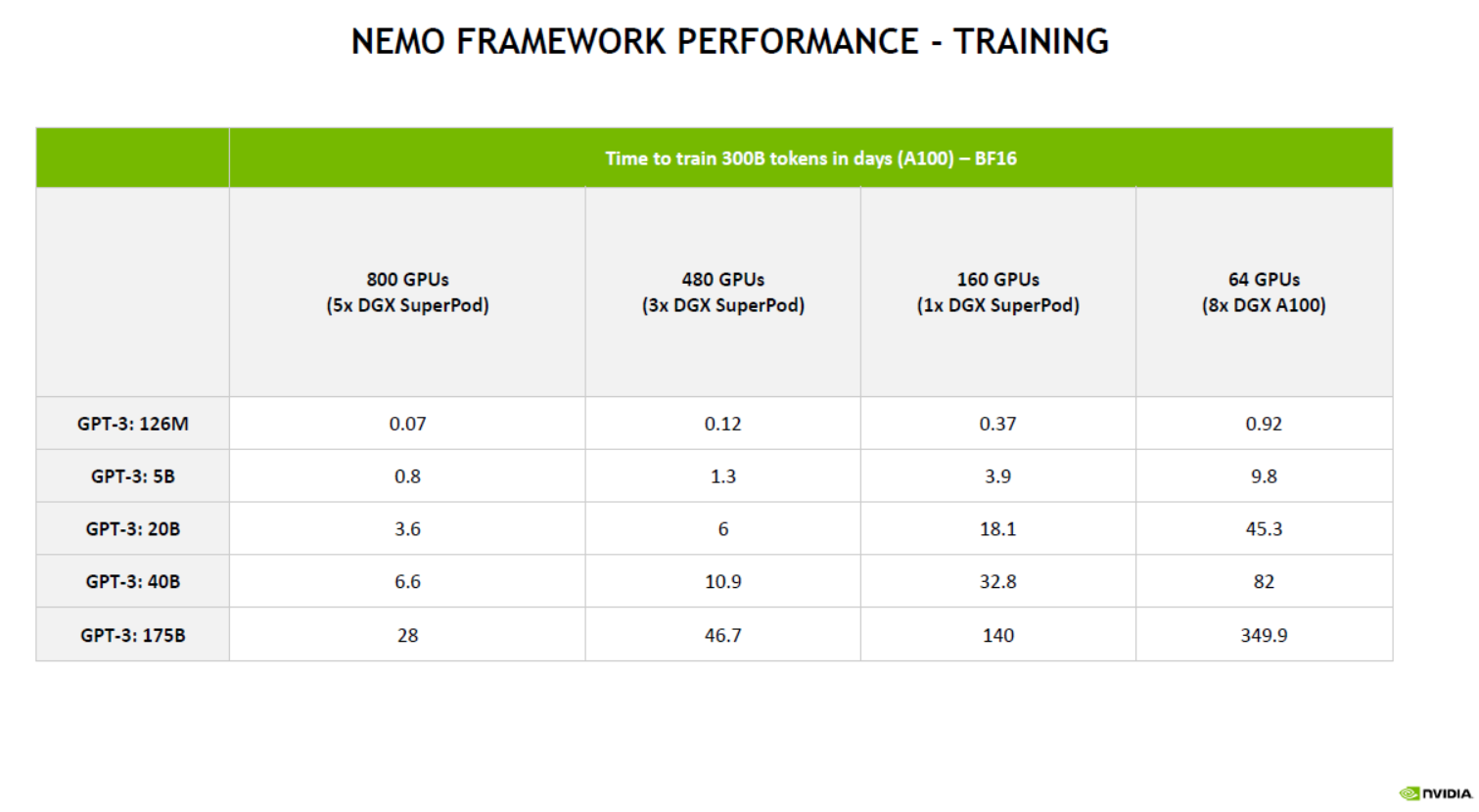

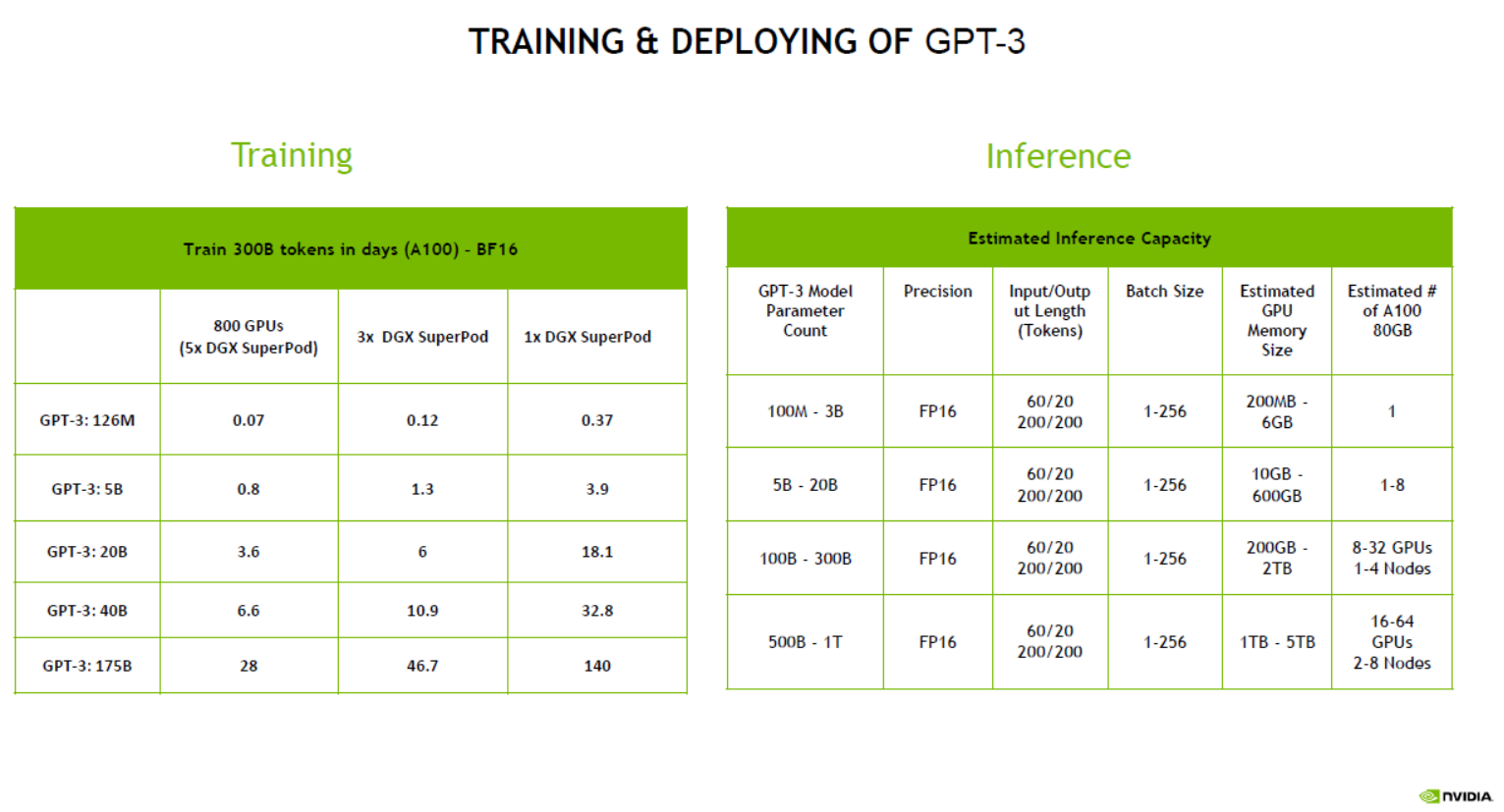

NeMo sử dụng việc huấn luyện phân tán bằng cách sử dụng các phương pháp song song phức tạp để sử dụng tài nguyên GPU và bộ nhớ trên nhiều nút trên quy mô lớn. Bằng cách phân tách mô hình và dữ liệu huấn luyện, NeMo cho phép thông lượng tối ưu và giảm thiểu đáng kể thời gian cần thiết cho huấn luyện, đồng thời tăng tốc TTM.

GPU H100 sử dụng NVIDIA Transformer Engine (TE), một thư viện cải tiến hiệu suất Trí Tuệ Nhân Tạo bằng cách kết hợp các định dạng điểm động 16 bit và 8 bit với các thuật toán tiên tiến. Nó đạt được việc huấn luyện LLM nhanh hơn mà không mất đi tính chính xác bằng cách giảm số lượng phép tính đối với FP8 so với các định dạng FP16 và FP32 thông thường được sử dụng trong khối lượng công việc Trí Tuệ Nhân Tạo. Tối ưu hóa này sử dụng phân tích thống kê theo từng lớp để tăng độ chính xác cho mỗi lớp mô hình, mang lại hiệu suất và độ chính xác tối ưu.

AutoConfigurator mang lại năng suất cho nhà phát triển

Tìm cấu hình mô hình cho LLM trên hạ tầng phân tán là quá trình tốn thời gian. NeMo cung cấp AutoConfigurator, một công cụ siêu tham số để tìm kiếm tự động cấu hình huấn luyện tối ưu, giúp LLMs có thông lượng cao huấn luyện nhanh hơn. Điều này tiết kiệm thời gian cho nhà phát triển trong việc tìm kiếm cấu hình mô hình hiệu quả.

Công cụ này áp dụng các phương pháp đánh giá và tìm kiếm lưới cho các tham số khác nhau, chẳng hạn như phân tích song song các tensor, phân tích song song dòng, kích thước micro-batch và các lớp kiểm tra điểm kích hoạt, nhằm xác định các cấu hình có thông lượng cao nhất.

AutoConfigurator cũng có thể tìm cấu hình mô hình có thể đạt được thông lượng cao nhất hoặc độ trễ thấp nhất trong quá trình suy luận. Ràng buộc độ trễ và thông lượng có thể được cung cấp để triển khai mô hình, và công cụ sẽ đề xuất các cấu hình thích hợp.

Xem xét các hướng dẫn để xây dựng các mô hình Trí Tuệ Nhân Tạo Sáng Tạo đa dạng về kích thước cho các kiến trúc GPT, MT5, T5 và BERT.

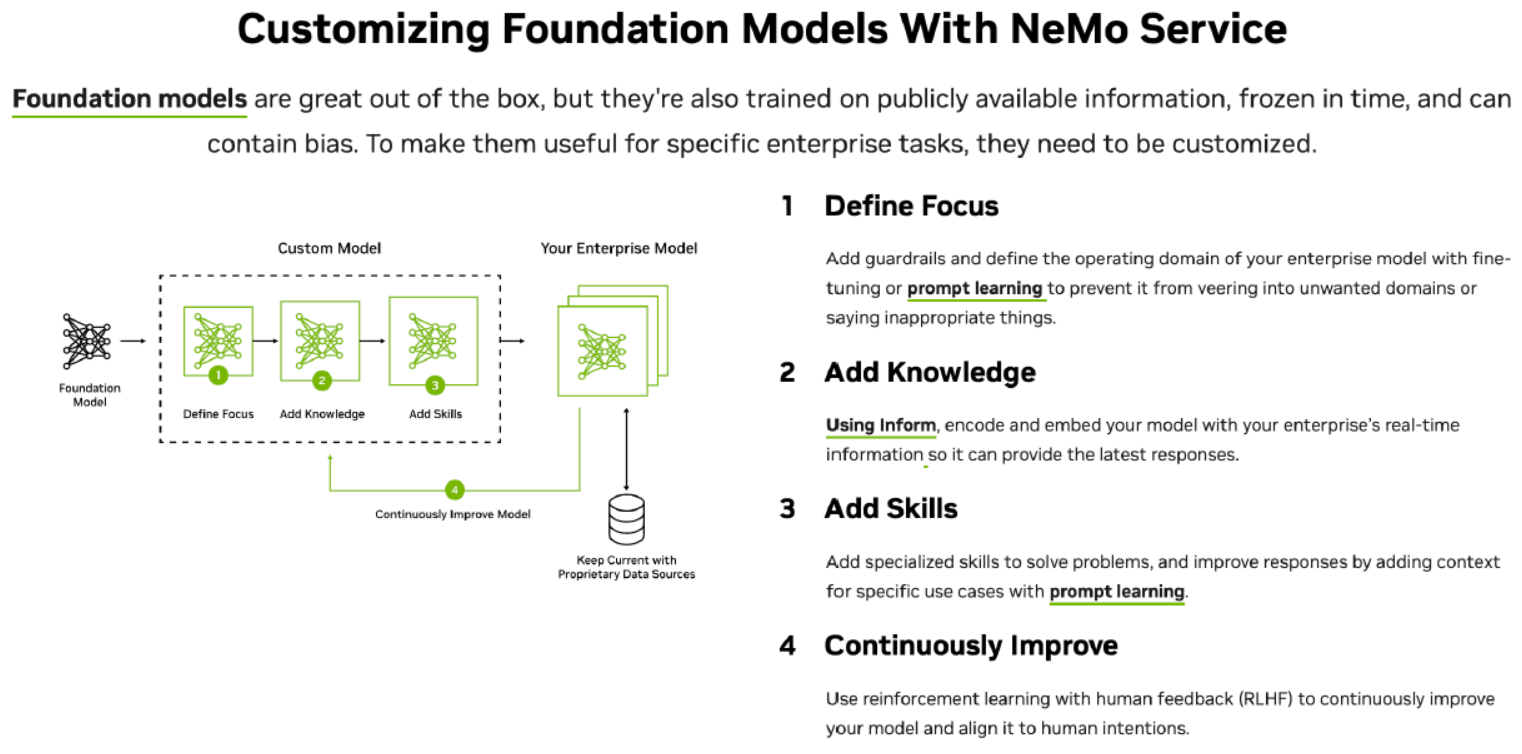

Tùy chỉnh mô hình

Trong lĩnh vực LLM, một kích thước hiếm khi phù hợp với tất cả, đặc biệt là trong các ứng dụng doanh nghiệp. Các LLM gồm sẵn thường không đáp ứng đủ yêu cầu đặc thù của các tổ chức, cho dù đó là những tinh hoa của kiến thức chuyên môn, ngôn ngữ ngành hoặc tình huống hoạt động độc đáo.

Đây chính xác là nơi sự quan trọng của LLM tùy chỉnh đang đến. Các doanh nghiệp phải điều chỉnh mô hình để hỗ trợ khả năng cho các trường hợp sử dụng cụ thể và chuyên môn. Những mô hình tùy chỉnh này cung cấp cho doanh nghiệp cách để tạo ra các giải pháp được cá nhân hóa để phù hợp với giọng văn thương hiệu của họ và tối ưu hóa luồng làm việc, để có thông tin chính xác hơn và trải nghiệm người dùng đa dạng hơn.

NeMo hỗ trợ nhiều kỹ thuật tùy chỉnh, cho các nhà phát triển sử dụng các mô hình do NVIDIA xây dựng bằng cách thêm kỹ năng chức năng, tập trung vào các lĩnh vực cụ thể và thực hiện các phương án an toàn để ngăn cản các phản hồi không thích hợp.

Ngoài ra, framework này hỗ trợ các mô hình tiền huấn luyện được xây dựng bởi cộng đồng bao gồm Llama 2, BLOOM và Bart, và hỗ trợ các kiến trúc GPT, T5, mT5, T5-MoE và Bert.

- P-Tuning huấn luyện một mô hình trợ thủ nhỏ để thiết lập ngữ cảnh cho LLM đã đóng băng để tạo ra phản hồi phù hợp và chính xác.

- Adapters/IA3 giới thiệu các lớp feedforward nhỏ, cụ thể cho nhiệm vụ trong kiến trúc lõi của transformer, thêm số lượng tham số huấn luyện tối thiểu cho mỗi nhiệm vụ. Điều này làm cho việc tích hợp các nhiệm vụ mới trở nên dễ dàng mà không cần làm lại các nhiệm vụ hiện có.

- Low-Rank Adaption sử dụng các module bổ sung nhỏ gọn để tăng hiệu suất mô hình trên các nhiệm vụ cụ thể mà không cần thay đổi đáng kể về mô hình gốc.

- Supervised Fine-tuning điều chỉnh các tham số mô hình trên dữ liệu được gắn nhãn về đầu vào và đầu ra, dạy mô hình về các thuật ngữ cụ thể của lĩnh vực và cách thực hiện theo hướng dẫn được chỉ định bởi người dùng.

- Reinforcement Learning với Phản Hồi Từ Con Người cho phép LLM đạt được sự cân bằng tốt hơn với giá trị và ưa thích của con người.

Suy luận tăng tốc

Các LLM của cộng đồng đang phát triển với tốc độ nổ lực, với nhu cầu tăng về việc triển khai các mô hình này vào sản xuất. Kích thước của những LLM này đang làm tăng chi phí và độ phức tạp của việc triển khai, đòi hỏi hiệu suất suy luận tối ưu cho các ứng dụng sản xuất. Hiệu suất cao không chỉ giúp giảm chi phí mà còn cải thiện trải nghiệm người dùng.

LLMs như LLaMa, BLOOM, ChatGLM, Falcon, MPT và Starcoder đã thể hiện tiềm năng của các kiến trúc và toán tử tiên tiến. Điều này đã tạo ra một thách thức trong việc tạo ra một giải pháp có thể tối ưu hóa mô hình này cho suy luận, điều đó là điều rất mong muốn trong hệ sinh thái.

NeMo sử dụng các tối ưu hóa MHA và KV cache, attention flash, KV cache số hóa, và attention phân trang, cùng với các kỹ thuật khác để giải quyết bộ lớn thách thức tối ưu hóa LLM. Nó cho phép nhà phát triển thử nghiệm LLM mới và tùy chỉnh các mô hình nền tảng cho hiệu suất tối đa mà không cần kiến thức sâu về tối ưu hóa C++ hoặc NVIDIA CUDA.

Ngoài ra, NeMo còn sử dụng trình biên dịch học sâu TensorRT của NVIDIA, tối ưu hóa tiền xử lý và sau xử lý, và giao tiếp đa GPU đa nút. Trong một API Python mã nguồn mở, nó xác định, tối ưu hóa và thực thi LLMs để suy luận trong các ứng dụng sản xuất.

NeMo Guardrails

LLMs có thể thiên vị, cung cấp phản hồi không thích hợp và gây ảo giác. NeMo Guardrails là một bộ công cụ mã nguồn mở, có thể lập trình để giải quyết những thách thức này. Nó nằm giữa người dùng và LLM, sàng lọc và lọc các yêu cầu không thích hợp của người dùng cũng như phản hồi của LLM.

Xây dựng guardrails cho các tình huống khác nhau là điều đơn giản. Trước tiên, định nghĩa guardrail bằng cách cung cấp một vài ví dụ bằng ngôn ngữ tự nhiên. Sau đó, định nghĩa một phản hồi khi có câu hỏi về chủ đề đó được tạo ra. Cuối cùng, định nghĩa một luồng, quy định tập hợp các hành động cần thực hiện khi chủ đề hoặc luồng được kích hoạt.

NeMo Guardrails có thể giúp LLM tập trung vào các chủ đề, ngăn cản phản hồi độc hại và đảm bảo rằng các phản hồi được tạo ra từ các nguồn đáng tin cậy trước khi được trình bày cho người dùng. Đọc về việc xây dựng các hệ thống hội thoại LLM đáng tin cậy, an toàn và bảo mật hơn.

Đơn giản hóa việc triển khai với các công cụ hệ sinh thái

NeMo hoạt động với các công nghệ hệ sinh thái MLOps như Weights & Biases (W&B) cung cấp khả năng mạnh mẽ để tăng tốc quá trình phát triển, điều chỉnh và áp dụng LLMs.

Các nhà phát triển có thể gỡ lỗi, điều chỉnh, so sánh và tái tạo mô hình bằng nền tảng MLOps W&B. W&B Prompts giúp các tổ chức hiểu, điều chỉnh và phân tích hiệu suất của LLMs. W&B tích hợp với các sản phẩm của Google Cloud thường được sử dụng trong phát triển ML.

Ứng dụng Trí tuệ Nhân tạo sáng tạo

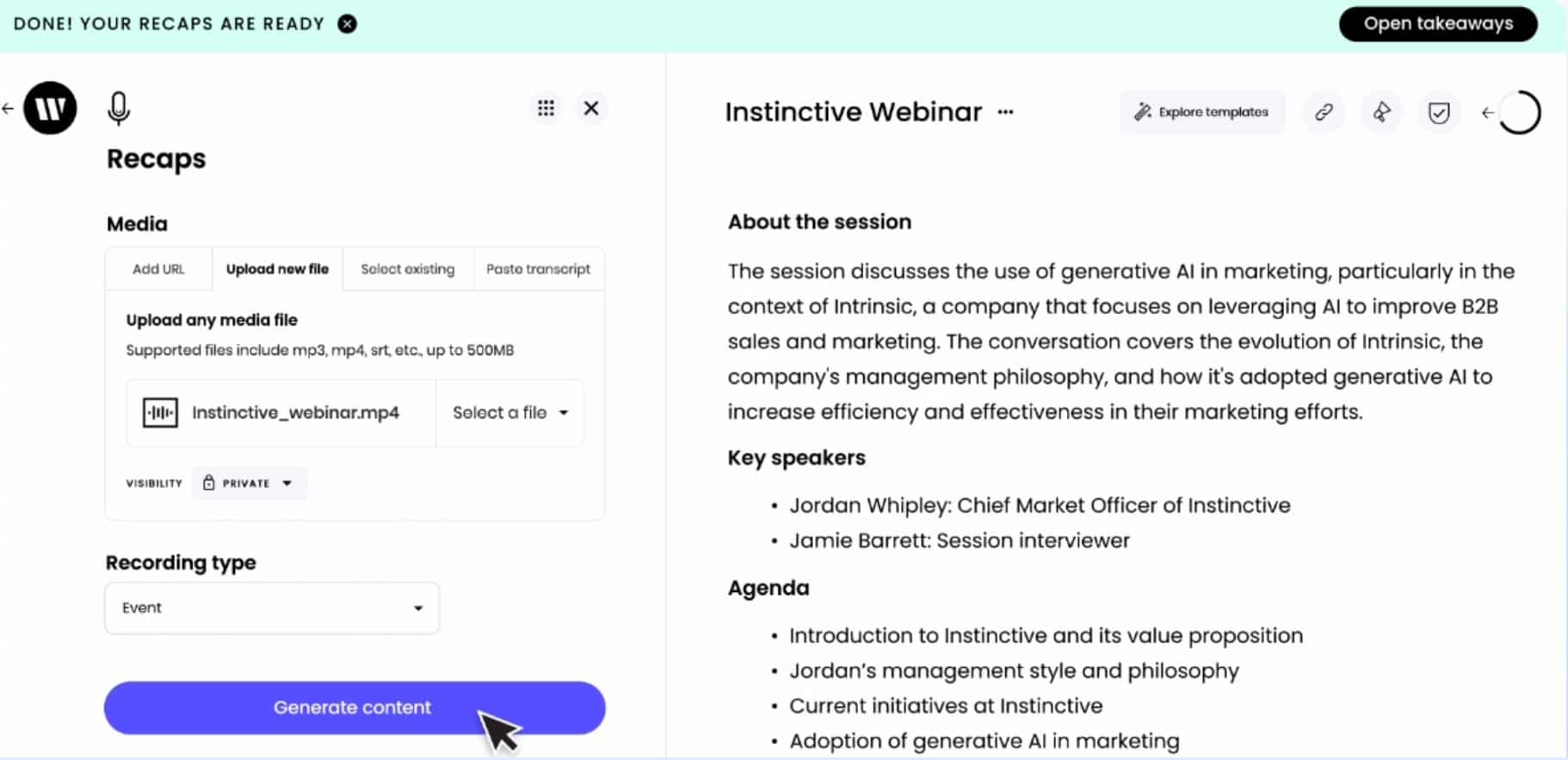

Writer, một dịch vụ tạo nội dung hàng đầu dựa trên Trí tuệ Nhân tạo sáng tạo, đang tận dụng khả năng của NeMo và tính toán tăng tốc trên Google Cloud. Họ đã xây dựng các mô hình ngôn ngữ có đến 40 tỷ tham số, phục vụ hàng trăm khách hàng, thay đổi cách tạo nội dung.

APMIC là một câu chuyện thành công khác với NeMo là trung tâm. Với hai mục tiêu, họ tận dụng NeMo cho hai trường hợp sử dụng khác biệt. Họ đã tăng tốc quy trình xác minh hợp đồng và tóm tắt phán quyết thông qua việc liên kết thực thể, trích xuất thông tin quan trọng từ tài liệu một cách nhanh chóng. Họ cũng sử dụng NeMo để tùy chỉnh các mô hình GPT, cung cấp giải pháp dịch vụ khách hàng và tương tác với con người kỹ thuật số bằng cách đưa ra câu trả lời thông qua hệ thống trả lời câu hỏi.

Bắt đầu xây dựng ứng dụng Trí tuệ Nhân tạo sáng tạo của bạn

Sử dụng AI Playground, bạn có thể trải nghiệm tiềm năng toàn diện của cộng đồng và các mô hình Trí tuệ Nhân tạo sáng tạo do NVIDIA xây dựng, được tối ưu hóa cho bộ công cụ tăng tốc NVIDIA, trực tiếp thông qua trình duyệt web của bạn.

Tùy chỉnh các LLM đã được huấn luyện trước dựa trên GPT, mT5 hoặc BERT từ Hugging Face bằng cách sử dụng NeMo trên Google Cloud:

- Truy cập NeMo từ GitHub.

- Trích dẫn container NeMo từ NGC để chạy trên các nền tảng được tăng tốc bằng GPU.

- Truy cập NeMo từ NVIDIA AI Enterprise có sẵn trên Google Cloud Marketplace với sự hỗ trợ và bảo mật cấp doanh nghiệp.

→ Hãy bắt đầu với NVIDIA NeMo ngay hôm nay.

Bài viết liên quan

- Giới thiệu giải pháp Training AI trên các máy chủ thông dụng

- Máy chủ Supermicro X14: Hiệu suất mạnh mẽ, hiệu quả tối đa cho AI, Cloud, Storage, 5G/Edge

- PowerScale: Nền tảng kiến trúc cho các tác vụ Generative AI

- NVIDIA Hopper tiếp tục dẫn đầu hiệu suất Generative AI trong MLPerf

- NVIDIA hỗ trợ hành trình hướng tới Generative AI thuận lợi hơn cho các doanh nghiệp

- NVIDIA Omniverse ft Apple Vision Pro: Mở rộng thế giới quan với VR/AR