Hiệu ứng của Trí tuệ Nhân tạo (AI) ngày càng phức tạp hơn, kích thước và độ phức tạp của các mô hình AI cũng ngày càng tăng cao. Trong khi hầu hết các tổ chức cần xử lý nhiều khối lượng công việc AI song song, một số người dùng lại có yêu cầu về bộ nhớ lớn cho một khối lượng công việc duy nhất vượt quá giới hạn của một GPU hoặc thậm chí một hệ thống nhiều GPU lớn. Những người dùng này cần một phương pháp mới có thể mở rộng bộ nhớ và sức mạnh xử lý của hàng trăm GPU và CPU mà không gặp hiện tượng cản trở hiệu suất khi quy mô tăng lên, đồng thời giữ nguyên mô hình lập trình trên một GPU duy nhất để đơn giản hóa quy trình.

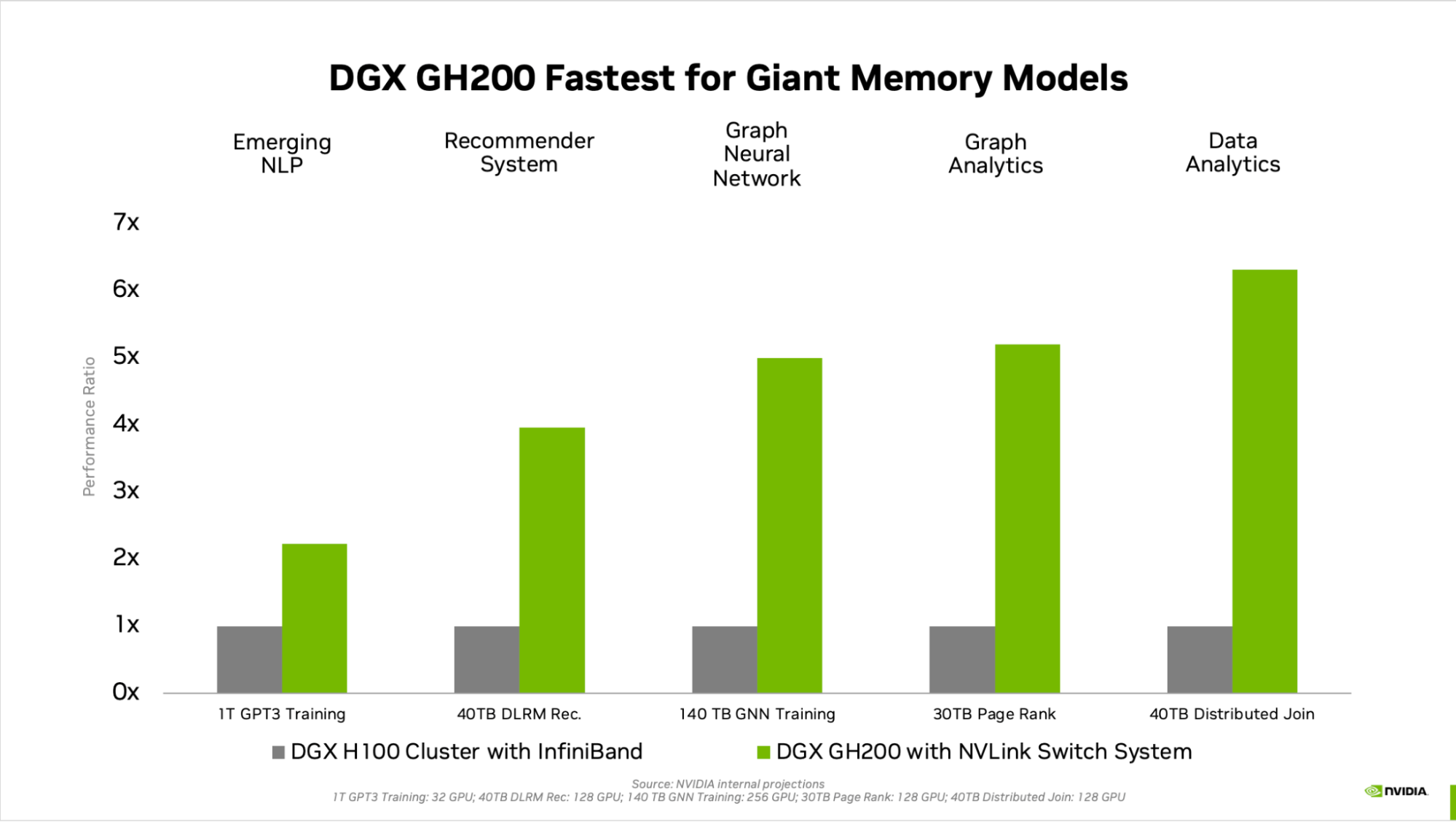

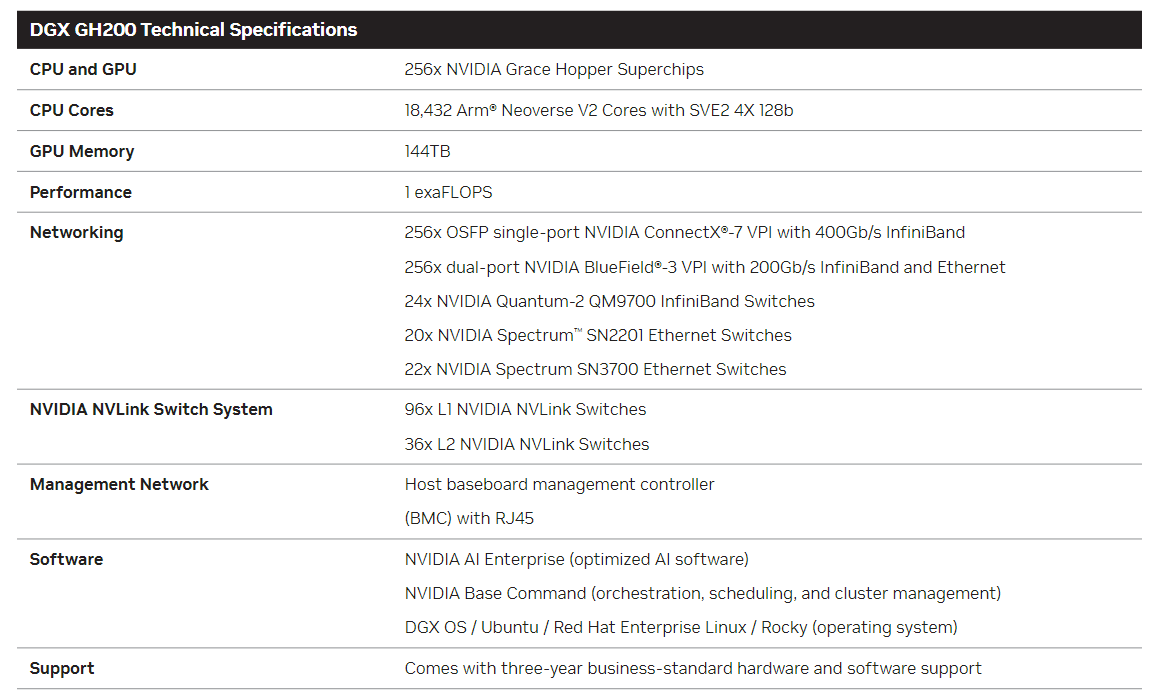

Với các tổ chức như nhà cung cấp dịch vụ đám mây (CSPs), các nhà quy mô lớn, tổ chức nghiên cứu lớn và các doanh nghiệp hàng đầu đang đẩy ranh giới của AI, NVIDIA DGX™ GH200 cung cấp một bản thiết kế mới cho việc phát triển AI với các mô hình khổng lồ. Sử dụng vi mạch Superchip NVIDIA Grace Hopper™ tích hợp công nghệ NVIDIA® NVLink® thế hệ thứ 4, cung cấp tính mở rộng tuyến tính và không gian bộ nhớ chia sẻ lớn trên tất cả các GPU, loại siêu máy tính AI mới này cung cấp các khả năng cần thiết để phát triển các mạng neural đồ thị lớn nhất thế giới, các ứng dụng giới thiệu, các mô hình mô phỏng và ứng dụng AI tự tạo.

Là một phần của nền tảng DGX, DGX GH200 không chỉ là phần cứng – đó còn là một giải pháp phần cứng và phần mềm hoàn chỉnh được thiết kế và cung cấp bởi NVIDIA, với trải nghiệm hoàn toàn tự động, giúp loại bỏ sự phức tạp, tăng tốc triển khai và đơn giản hóa hoạt động; và hiệu quả năng lượng xuất sắc cho một siêu máy tính có bộ nhớ lớn. DGX GH200 mở ra một thời kỳ mới trong lĩnh vực AI, nâng cao trạng thái của nghệ thuật về kích thước và độ phức tạp mô hình lên một cấp độ chưa từng có.

Bộ nhớ khổng lồ cho các mô hình khổng lồ

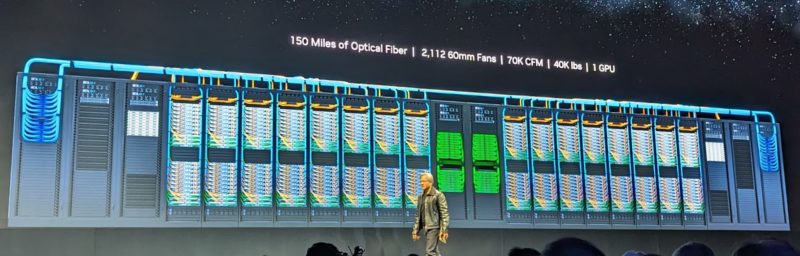

Khác với các siêu máy tính Trí tuệ Nhân tạo (AI) hiện có được thiết kế để hỗ trợ các khối công việc vừa vặn với bộ nhớ của một hệ thống duy nhất, NVIDIA DGX GH200 là duy nhất siêu máy tính AI cung cấp không gian bộ nhớ chia sẻ lên đến 144TB trên 256 vi mạch Superchip Grace Hopper, cung cấp cho các nhà phát triển gần 500 lần bộ nhớ truy cập nhanh hơn để xây dựng các mô hình khổng lồ. DGX GH200 là siêu máy tính đầu tiên kết hợp vi mạch Superchip Grace Hopper với Hệ thống Chuyển đổi NVIDIA NVLink, cho phép kết hợp lên đến 256 GPU thành một GPU có kích thước trung tâm dữ liệu. Kiến trúc này cung cấp băng thông lớn hơn 48 lần so với thế hệ trước đó, mang đến sức mạnh của một siêu máy tính AI khổng lồ với sự đơn giản trong việc lập trình một GPU duy nhất.

Máy tính siêu hiệu quả năng lượng

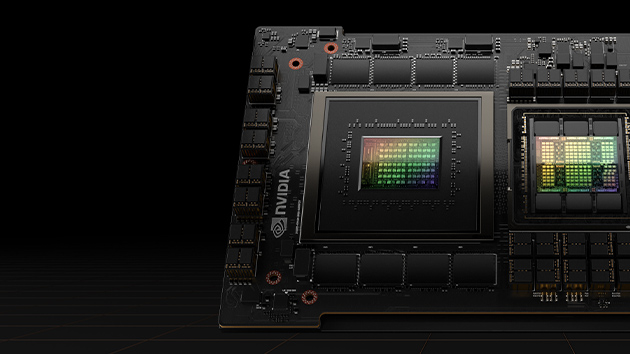

Khi độ phức tạp của các mô hình AI tăng lên, công nghệ để phát triển và triển khai chúng cũng đòi hỏi nhiều tài nguyên hơn. Tuy nhiên, với kiến trúc NVIDIA Grace Hopper, DGX GH200 đạt được hiệu quả năng lượng xuất sắc. Mỗi vi mạch Superchip Grace Hopper của NVIDIA là cả CPU và GPU trong một đơn vị, kết nối với công nghệ siêu nhanh NVIDIA NVLink-C2C. CPU Grace™ sử dụng bộ nhớ LPDDR5X, tiêu thụ chỉ một phần tám năng lượng so với bộ nhớ hệ thống DDR5 truyền thống, đồng thời cung cấp băng thông lớn hơn 50% so với DDR5 8 kênh. Và với việc nằm trên cùng một gói, kết nối giữa CPU Grace và GPU Hopper™ tiêu thụ ít tới 5 lần năng lượng và cung cấp băng thông lên đến 7 lần so với công nghệ PCIe mới nhất được sử dụng trong các hệ thống khác.

Tích hợp và Sẵn sàng hoạt động

Thiết kế, tích hợp và vận hành một trung tâm dữ liệu tỷ lệ lớn được điều chỉnh cho việc phát triển ứng dụng có bộ nhớ khổng lồ có thể phức tạp và tốn nhiều thời gian. Với DGX GH200, NVIDIA không chỉ là nhà cung cấp công nghệ mà còn là đối tác đáng tin cậy giúp đảm bảo thành công. Với giải pháp đã được kiểm tra và tích hợp đầy đủ với phần mềm, tính toán và mạng, bao gồm các dịch vụ chất lượng cao giúp cài đặt và quản lý cơ sở hạ tầng, cùng với lời khuyên chuyên môn về tối ưu hóa khối công việc, DGX GH200 giúp nhóm làm việc có thể bắt đầu công việc một cách nhanh chóng.

Bài viết liên quan

- NVIDIA NGC‑ready Low‑latency Edge AI: Giải pháp cho Retail, Manufacturing và Smart Cities

- So sánh sức mạnh của máy tính AI DGX Spark với các card GPU máy trạm chuyên nghiệp của NVIDIA

- Từ Orin đến Thor: Bước nhảy vọt kiến trúc của NVIDIA JetPack 7.0 và tương lai của robot hình người

- Tại sao gọi NVIDIA DGX Spark là Siêu máy tính AI cá nhân?

- Cơ chế quản lý bộ nhớ trên các nền tảng phần cứng nhất quán – Hardware-coherent

- Kiến trúc NVIDIA Blackwell với GB200 NVL72: Định nghĩa lại điện toán AI cấp độ Exascale