Với những chuyển biến của thị trường gần đây, NVIDIA H100 80GB PCIe đang được bán với mức giá trên 30 nghìn USD tại các cửa hàng trực tuyến và đang trong tình trạng chờ đợi khoảng sáu tháng để nhận hàng. Dễ hiểu khi giá của dòng GPU đầu bảng này của NVIDIA cao đến như vậy, cùng với việc nhu cầu sử dụng nó rất lớn.

NVIDIA đã giới thiệu một lựa chọn khác cho các khách hàng ứng dụng trí tuệ nhân tạo và những khách hàng chạy các công việc đa dạng trong doanh nghiệp, một lựa chọn mà không nhiều người biết đến, nhưng cũng rất xuất sắc. Đó chính là NVIDIA L40S, một biến thể của dòng card đồ họa L40, đang trở thành lựa chọn tốt hơn trong lĩnh vực trí tuệ nhân tạo. Hãy cùng khám phá lý do tại sao điều này lại đúng.

NVIDIA A100, NVIDIA L40S và NVIDIA H100

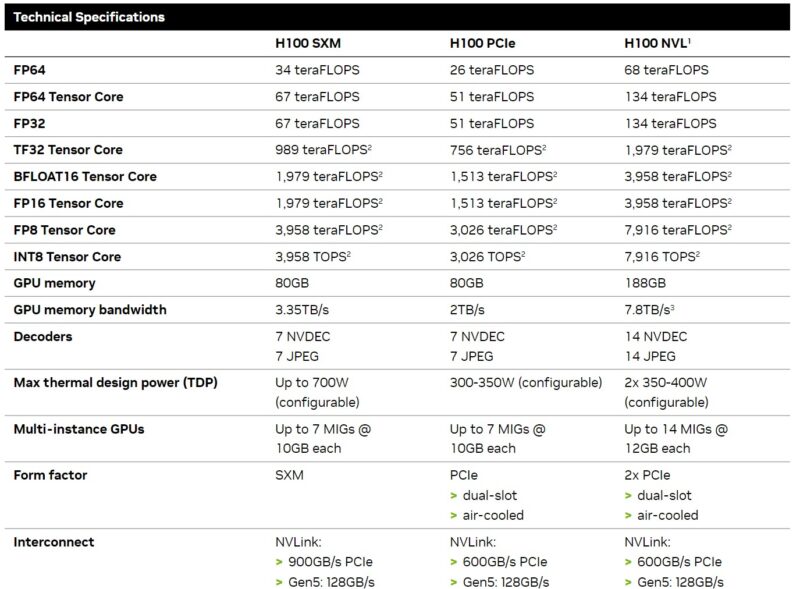

Trước tiên, hãy bắt đầu bằng việc đề cập đến tình huống nếu bạn muốn huấn luyện các mô hình cơ bản ngày nay, như ChatGPT chẳng hạn, thì NVIDIA H100 80GB SXM5 vẫn là lựa chọn hàng đầu. Khi mô hình cơ bản đã được huấn luyện, việc tùy chỉnh mô hình dựa trên dữ liệu chuyên ngành hoặc thực hiện các công việc dự đoán thường có thể được thực hiện trên các phần vật lý có chi phí và công suất điện tiêu thụ thấp hơn nhiều.

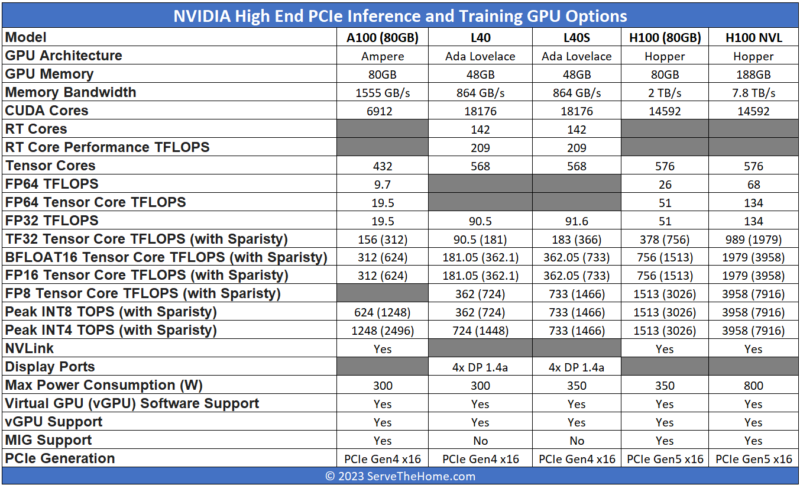

Hiện nay, có ba loại GPU chính được sử dụng cho các công việc dự đoán nâng cao: NVIDIA A100, NVIDIA H100 và NVIDIA L40S mới. Chúng tôi sẽ bỏ qua NVIDIA L4 24GB vì đó là một phiên bản dành cho các ứng dụng dự đoán cấp thấp hơn.

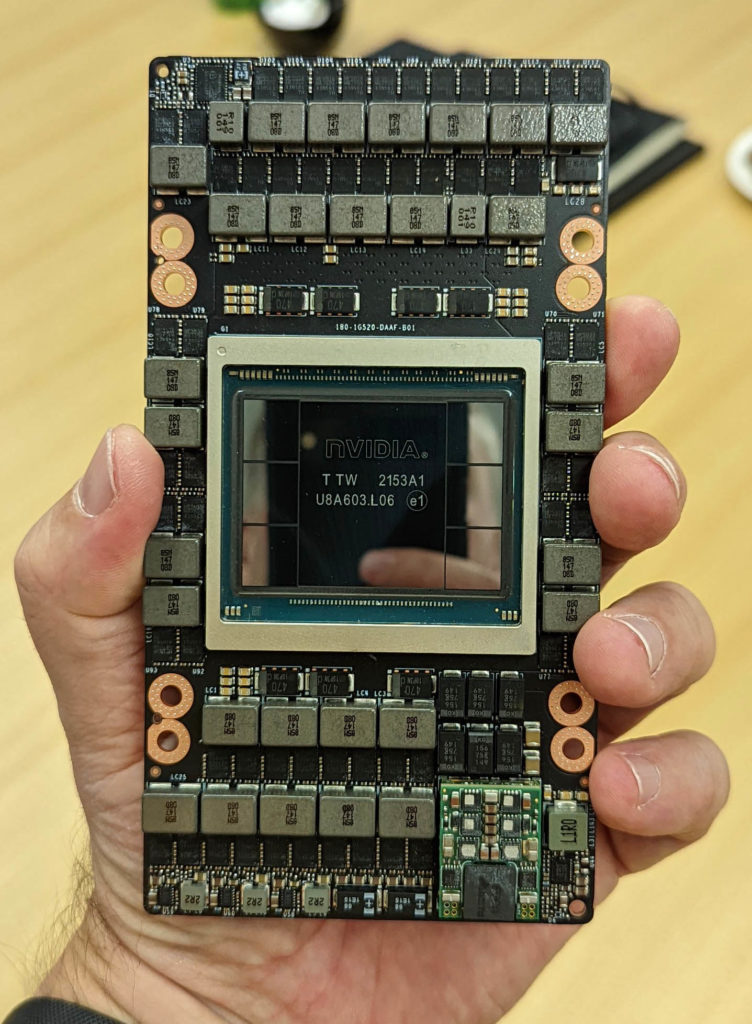

Cả hai mẫu NVIDIA A100 và H100 đều dựa trên dòng GPU hàng đầu của hãng trong các thế hệ tương ứng của chúng. Vậy nên chúng ta sẽ bàn về chuẩn PCIe thay vì các mô-đun SXM, hai điểm khác biệt quan trọng nhất giữa các hình thức này là NVLink và công suất tiêu thụ điện. Các mô-đun SXM được thiết kế để tiêu thụ công suất cao hơn (gần gấp đôi so với các phiên bản PCIe) và được kết nối thông qua các mạch NVLink và thường là các cấu trúc NVSwitch trong các hệ thống đa GPU.

Phiên bản PCIe của NVIDIA A100 được giới thiệu vào năm 2020 với dung lượng 40GB, và sau đó, vào giữa năm 2021, hãng đã cập nhật phiên bản thành card PCIe A100 80GB. Đến nay, những chiếc card này vẫn rất phổ biến.

Với mô-đun NVIDIA H100 SXM5 ra mắt vào đầu năm 2022, nhưng các hệ thống sử dụng nó bắt đầu xuất hiện vào cuối năm 2022 và đầu năm 2023 khi các CPU hỗ trợ PCIe Gen5 bắt đầu xuất hiện.

NVIDIA H100 PCIe là phiên bản H100 tiêu thụ công suất điện thấp hơn, được thiết kế cho các máy chủ thông dụng. Nói về các phiên bản card PCIe này có thể xem như một lượng silicon tương đương chạy ở mức điện áp và xung nhịp khác đi, được thiết kế để cung cấp hiệu suất thấp hơn nhưng cũng tiêu thụ công suất điện thấp hơn nhiều.

Có một số khác biệt ngay cả trong dòng H100. NVIDIA H100 PCIe vẫn là một gpu H100, nhưng trong hình thức PCIe, nó có hiệu suất giảm, tiêu thụ công suất điện thấp hơn và trang bị một số kết nối giữa các card (ví dụ như NVLink.)

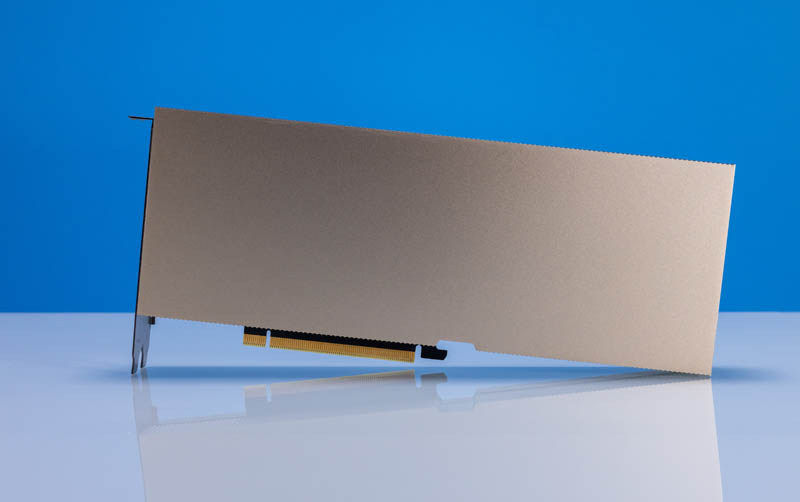

L40S thì hoàn toàn khác biệt. NVIDIA đã lấy thẻ gốc L40, một card GPU tập trung vào đồ họa dành cho trung tâm dữ liệu, sử dụng kiến trúc Ada Lovelace mới nhất của hãng và điều chỉnh lại để chúng phù hợp hơn với tác vụ trí tuệ nhân tạo thay vì đồ họa.

NVIDIA L40S là một mẫu GPU thú vị vì nó giữ lại các tính năng như nhân xử lý Ray Tracing và các đầu ra DisplayPort cùng với NVENC/NVDEC hỗ trợ AV1 từ L40. Đồng thời, NVIDIA chuyển sức mạnh nhiều hơn vào việc tăng tốc các thành phần AI của GPU.

Có một số điểm quan trọng đáng chú ý ở đây:

- L40S là một card cải thiện đáng kể cho việc huấn luyện và dự đoán trí tuệ nhân tạo so với L40, mặc dù chúng cùng chia sẻ nguồn gốc chung.

- L40 và L40S không phải là các card nếu bạn cần bộ nhớ tuyệt đối lớn, băng thông lớn hoặc hiệu suất FP64 cao. Với sự chuyển đổi tương đối lớn mà các ứng dụng AI đang chiếm lĩnh so với việc tính toán truyền thống FP64, hầu hết mọi người đều sẽ chấp nhận được sự đánh đổi này.

- L40S có vẻ như có ít bộ nhớ hơn nhiều so với NVIDIA A100, và về mặt vật lý, nó thật sự như vậy, nhưng đó không phải là toàn bộ câu chuyện. NVIDIA L40S hỗ trợ NVIDIA Transformer Engine và FP8. Sử dụng FP8 giảm đáng kích thước dữ liệu và do đó, giá trị FP8 có thể sử dụng ít bộ nhớ hơn và yêu cầu ít băng thông bộ nhớ hơn để di chuyển so với giá trị FP16. NVIDIA đang thúc đẩy Transformer Engine vì H100 cũng hỗ trợ nó và giúp giảm giá hoặc tăng hiệu suất cho các linh kiện AI của hãng.

- L40S có một bộ mã hóa/giải mã video tương đối lớn về hiển thị, trong khi H100 tập trung vào phần giải mã.

- NVIDIA H100 nhanh hơn. Nó cũng có giá cao hơn rất nhiều. Để có cái nhìn, trên CDW, nơi liệt kê giá công bố, H100 có giá gấp khoảng 2.6 lần giá của L40S

- Một điểm quan trọng khác là sự sẵn có. NVIDIA L40S hiện nay nhanh hơn rất nhiều so với việc chờ đợi mua NVIDIA H100.

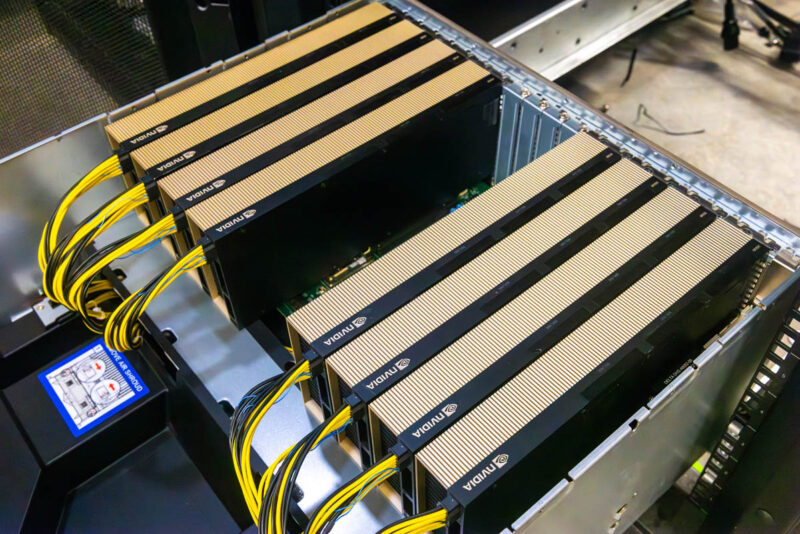

Một điểm đặc biệt của các hệ thống hiện nay là chúng đã đầy đủ 5U. Điều này chủ yếu là do công suất tiêu thụ nhiệt động (TDP) của mỗi GPU, H100 hoặc L40S, là 350W. Thông thường, các hệ thống này có tám GPU, tương đương với khoảng 2.8kW công suất tiêu thụ của các GPU. Lý do khác là giữa hai tùy chọn này, các hệ thống này thường sử dụng công suất trong khoảng từ 4.3-5kW. Điều này đủ để duy trì một máy chủ duy nhất trên mỗi rack 208V 30A hoặc nhiều máy chủ trên một rack có công suất cao hơn. Mật độ không gian không phải là thách thức lớn với các máy chủ trí tuệ nhân tạo hiện đại vì thường xuyên công suất và hệ thống làm mát trong các rack là yếu tố hạn chế lớn hơn.

Không gian thêm 1U cho phép hệ thống có thêm nhiều không gian làm mát cho các GPU. Cả các GPU của NVIDIA và các phiên bản H100 và L40S đều tuân thủ quy định này và thường có thể sử dụng công suất tối đa được đánh giá, nhưng chúng thường sử dụng ít hơn công suất được đánh giá của chúng trên trung bình.

Supermicro có cả phiên bản dành cho các dòng vi xử lý Intel Xeon và AMD EPYC của bộ khung này. Chúng tôi đã thiết lập hai phiên bản với vi xử lý Intel Xeon, một phiên bản với 8 GPU NVIDIA H100 và phiên bản khác với các thẻ NVIDIA L40S.

Nhìn vào, bạn có thể thấy rằng chúng tôi chỉ thiết lập với tám thẻ, nhưng các hệ thống này có thể mở rộng lên đến 10 thẻ. Trong các máy chủ GPU PCIe, cách kết nối GPU rất quan trọng đối với các chức năng như giao tiếp điểm-điểm thông qua một công tắc PCIe mà không có NVLink, và hiệu suất của NVIDIA NCCL trên công việc làm việc. NCCL là quan trọng để mở rộng các công việc lên nhiều GPU. Supermicro SYS-521GE-TNRT sử dụng các công tắc PCIe Gen5 trong cấu hình gốc kép. Bạn có thể thấy hai công tắc PCIe được làm mát bằng tấm tản nhiệt trên bo mạch GPU, và bo mạch này được kết nối qua dây cáp giữa các công tắc và các vi xử lý trong hệ thống.

Tóm Tắt Hiệu Năng

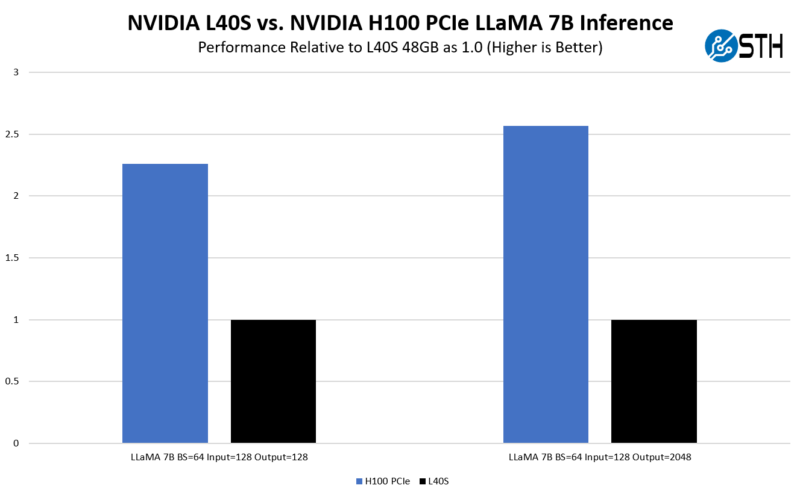

Chúng tôi đã thử nghiệm LLaMA 7B trên những GPU này. Thời gian chúng tôi có để tiếp cận chúng khá ngắn, điều này giới hạn việc thử nghiệm của chúng tôi. NVIDIA đã công bố rất nhiều con số về trí tuệ nhân tạo, vì vậy hãy thoải mái xem qua những con số đó.

Chúng tôi đã kiểm tra kết quả của mình so với con số chính thức của NVIDIA. Trên kết quả chính thức, NVIDIA đang sử dụng phiên bản H100 SXM5 của mình, không phải là phiên bản PCIe. Tuy nhiên, chúng tôi dùng một quy tắc sơ bộ rằng phiên bản SXM5 nhanh khoảng 25% so với phiên bản PCIe (nhưng nó thay đổi tùy thuộc vào công việc cụ thể). Điều này giúp chúng tôi có cái nhìn tổng quan về tốc độ của chúng.

Điều này đưa chúng ta đến một điều rõ ràng: tại sao chúng ta chọn L40S nếu H100 nhanh hơn? Hóa ra, mọi người đang triển khai L40S vì 48GB bộ nhớ là đủ, đặc biệt khi sử dụng FP8, để cạnh tranh với A100, ngay cả phiên bản SXM sử dụng FP16. Ngược lại, chúng tôi thường thấy H100 PCIe nhanh từ 2.0-2.7 lần so với L40S, nhưng giá của nó cũng cao gấp 2.6 lần. L40S cũng sẵn có sớm hơn H100, và một số ưu đãi giá làm cho L40S cạnh tranh hơn H100, làm nghiêng cân nhiều hơn về L40S.

Tuy có một số lưu ý. Nếu bạn triển khai hơn 10,000 GPU, NVIDIA đang tập trung không chỉ vào H100 mà còn vào H100 SXM5 trong các nền tảng Delta Next với NVSwitch và các công nghệ khác. Chúng tôi đã hỏi NVIDIA về điều này, và nếu bạn chỉ triển khai 4000 GPU (đáng chú ý ~$50M+ về phần cứng), ví dụ, thì L40S là lựa chọn đúng.

Sự Khác Biệt Giữa NVIDIA L40S và H100

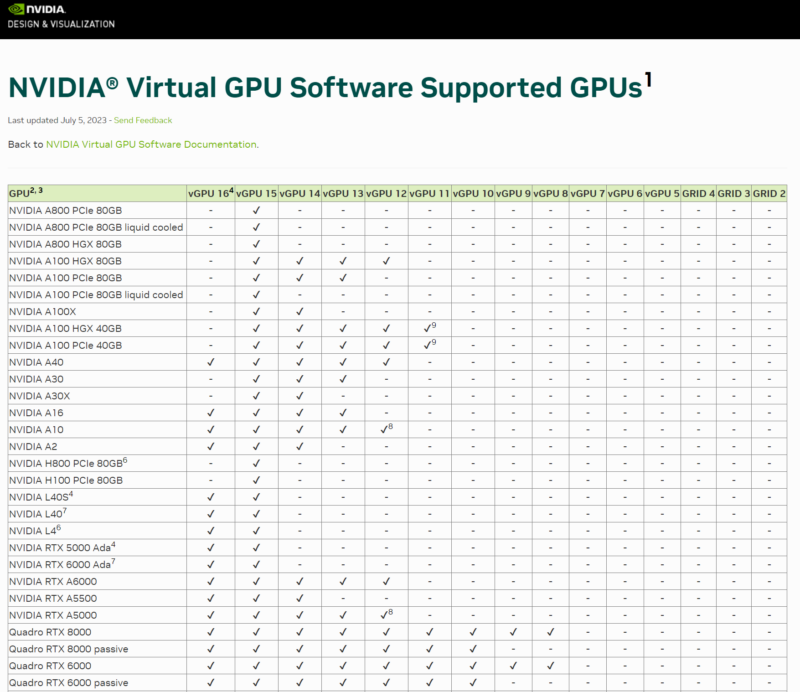

Có một số khía cạnh khác cần xem xét về L40S. Một trong số đó là nó hỗ trợ NVIDIA Virtual GPU vGPU 16.1, trong khi H100 chỉ được hỗ trợ với vGPU 15. NVIDIA đang phân chia chip trí tuệ nhân tạo của mình một chút từ phía hỗ trợ vGPU.

Đối với những người muốn triển khai một loại máy chủ GPU và sau đó có thể chạy các loại công việc khác nhau, thì một sản phẩm như L40S là lựa chọn hợp lý. Nó cũng có các động cơ mã hóa video của NVIDIA với hỗ trợ AV1 và các lõi RT, với nguồn gốc trong lĩnh vực visual.

Có một tính năng mà L40S không hỗ trợ, đó là MIG. Chúng tôi đã xem xét MIG trước đây, nhưng nó cho phép một H100 được chia thành tới 7 phân vùng với các kích thước khác nhau. Điều này thường hữu ích để chia H100 GPU trong các đám mây công cộng để tài nguyên GPU có thể được chia sẻ giữa các khách hàng. Đối với doanh nghiệp, đây thường là một tính năng không được chú ý nhiều.

Ngoài ra, việc triển khai L40S tiêu thụ ít công suất hơn, chỉ bằng một nửa so với các hệ thống SXM5. Điều này khiến cho nó trở nên hấp dẫn đối với những người muốn mở rộng quy mô nhưng có thể không có ngân sách công suất lớn cho mỗi rack.

Điểm chính ở đây là L40S không nhanh như H100, nhưng với FP8 và hỗ trợ Transformer Engine từ NVIDIA, đó là một lựa chọn có sẵn và dễ triển khai hơn đối với nhiều người hơn là H100, và thường thấp hơn về chi phí.

Kết luận

Hiện nay, có rất nhiều thông tin không chính xác về NVIDIA H100 PCIe so với L40S và tại sao người ta lại sử dụng phiên bản nào. Hy vọng, điều này sẽ giúp giải quyết thắc mắc đó một cách rõ ràng hơn. Đối với chúng tôi, L40S không giản dị, nhưng nó nhắc nhở chúng tôi về hơn 6 năm trước, khi trong lĩnh vực trí tuệ nhân tạo, xu hướng là sử dụng các GPU NVIDIA giá rẻ hơn trong các máy chủ, nhưng lại sử dụng nhiều hơn. NVIDIA đã áp dụng lại mô hình đó, sử dụng L40S và một kiến trúc được chính thức chấp nhận, hỗ trợ lên đến vài nghìn GPU.

→ Mua card GPU NVIDIA L40s tại đây.

→ Danh mục các dòng GPU hiệu suất cao của NVIDIA: https://thegioimaychu.vn/linh-kien-may-chu/gpu-card-may-chu

→ Để biết thêm thông tin về các GPU Sever của Supermicro tối ưu cho AI/HPC, hãy truy cập: https://thegioimaychu.vn/server/supermicro/

→ Để biết thêm thông tin về danh mục giải pháp NVIDIA của Supermicro, hãy truy cập: https://thegioimaychu.vn/solution/nvidia-hpc/

Nguồn STH

Bài viết liên quan

- NVIDIA NGC‑ready Low‑latency Edge AI: Giải pháp cho Retail, Manufacturing và Smart Cities

- So sánh sức mạnh của máy tính AI DGX Spark với các card GPU máy trạm chuyên nghiệp của NVIDIA

- Từ Orin đến Thor: Bước nhảy vọt kiến trúc của NVIDIA JetPack 7.0 và tương lai của robot hình người

- Tại sao gọi NVIDIA DGX Spark là Siêu máy tính AI cá nhân?

- Cơ chế quản lý bộ nhớ trên các nền tảng phần cứng nhất quán – Hardware-coherent

- Kiến trúc NVIDIA Blackwell với GB200 NVL72: Định nghĩa lại điện toán AI cấp độ Exascale