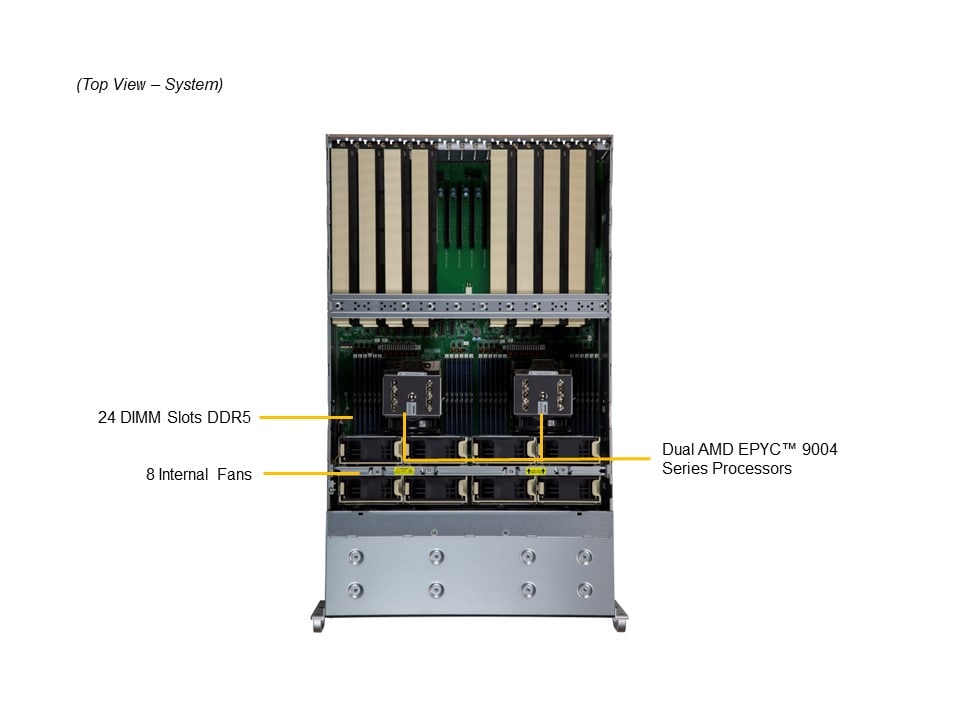

Supermicro từ lâu đã được biết đến là một nhà cung cấp các dòng máy chủ GPU với nhiều hình dạng và kích thước khác nhau, đặc biệt để tối ưu cho các khách hàng sử dụng cho mục đích AI. Ở bài viết này, chúng ta sẽ xem xét máy chủ GPU 4U tản nhiệt bằng không khí khá mới của Supermicro với sản phẩm AS-4125GS-TNRT, hỗ trợ hai CPU AMD EPYC 9004 Series, PCIe Gen5. Có hai lựa chọn giữa 8x GPU double-width hoặc 12x GPU single-width. AS-4125GS-TNRT với nền tảng CPU AMD là máy chủ duy nhất trong phân khúc này hỗ trợ GPU NVIDIA H100 và AMD Instinct Mi210.

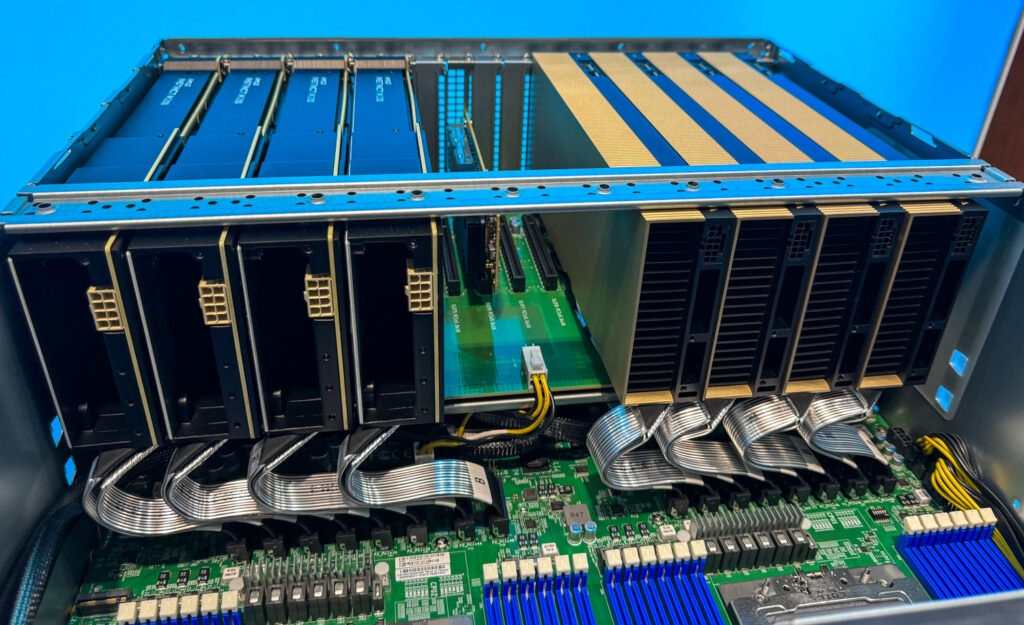

Máy chủ GPU Supermicro AS-4125GS-TNRT có một số điểm nổi bật về phần cứng như mạng 10GbE tích hợp, quản lý out-of-band, 9 khe PCIe Gen5 loại FHFL, 24 ổ cứng 2.5″, trong đó có bốn ổ NVMe, phần còn lại là SATA/SAS. Ngoài ra, máy chủ này có 4 nguồn điện dự phòng cấp titanium 2000W. Trên bo mạch chủ, có một khe M.2 NVMe duy nhất cho việc khởi động. Cùng sử dụng một bo mạch chủ, AS-4125GS-TNRT1 là một cấu hình single-socket với một bộ switch PCIe hỗ trợ tới 10 GPU double-width và 8 ổ SSD NVMe.

Dù ở bất kỳ cấu hình nào, máy chủ GPU Supermicro AS-4125GS-TNRT đều rất linh hoạt nhờ vào thiết kế và khả năng lựa chọn giữa các model với PCIe switch. Loại máy chủ GPU này phổ biến vì nó cho phép tổ chức doanh nghiệp bắt đầu với quy mô nhỏ và sau đó mở rộng dần, kết hợp các GPU cho các nhu cầu khác nhau hoặc thực hiện bất kỳ điều gì họ muốn. Hệ thống GPU dựa trên socket mang lại khả năng tập trung GPU tốt hơn cho các tải xử lý lớn về AI. Nhưng với hệ thống kiểu “add-in cards” này, nó là “vô đối” về tính linh hoạt cho hệ thống.

Hơn nữa, mặc dù điều này có thể là điều làm một số người không thích, máy chủ GPU card add-in của Supermicro thậm chí còn có thể được sử dụng với GPU từ cả AMD và NVIDIA trong cùng một hệ thống duy nhất. Mặc dù ít phổ biến hơn so với máy chủ GPU, các khe cắm này chỉ là các khe PCIe; không khó để tưởng tượng các tình huống mà khách hàng có thể ưa thích FPGA, DPU hoặc một hình thức tăng tốc khác trong cấu hình này. Một lần nữa, tính linh hoạt là ưu điểm cốt lõi của thiết kế này.

| Specifications | |

| CPU | Dual Socket SP5 CPUs up to 128C / 256T Each |

| Memory | Up to 24x 256GB 4800MHz ECC DDR5 RDIMM/LRDIMM (Total 6TB Memory) |

| GPU |

|

| Expansion Slots | 9x PCIE 5.0 x16 FHFL Slots |

| Power Supplies | 4x 2000W Redundant Power Supplies |

| Networking | 2x 10GbE |

| Storage |

|

| Motherboard | Super H13DSG-O-CPU |

| Management |

|

| Security |

|

| Chassis Size | 4U |

Cấu hình đánh giá Supermicro AS-4125GS-TNRT ở phòng thí nghiệm, là một cặp CPU AMD EPYC 9374F 32C 64T. Những chiếc CPU này được chọn vì tốc độ đồng hồ cao và hiệu suất đa lõi đáng kể. Đối với các bộ gia tốc, chúng tôi có rất nhiều lựa chọn, từ các Coprocessor Intel Phi cũ đến các GPU PCIe RTX 6000 cho đến các GPU Workstation RTX 6000 hiệu suất cao nhất. Chúng tôi nhắm mục tiêu cân bằng giữa sức mạnh tính toán tinh thể với hiệu suất và tính linh hoạt. Cuối cùng, chúng tôi quyết định bắt đầu với bốn GPU NVIDIA RTX A6000 và sau đó chuyển sang bốn GPU PCIe H100 . Sự kết hợp này thể hiện tính linh hoạt của nền tảng Supermicro và các GPU tăng tốc của NVIDIA.

GPU RTX A6000, được thiết kế chủ yếu để hiệu suất trong các công việc làm việc đồ họa, cũng xuất sắc trong các ứng dụng trí tuệ nhân tạo và HPC với kiến trúc Ampere của nó. Nó cung cấp 48GB bộ nhớ GDDR6, làm cho nó lý tưởng để xử lý các bộ dữ liệu lớn và mô phỏng phức tạp. 10.752 CUDA và 336 lõi Tensor của nó cho phép tính toán được tăng cường, điều này rất quan trọng cho các bài kiểm tra AI và học sâu của chúng tôi.

Ngược lại, GPU PCIe H100 của NVIDIA là những chiếc GPU chuyển giao hiện đại nhất trong bộ sưu tập kiến trúc Hopper, được thiết kế chủ yếu cho các công việc làm việc AI. Mỗi GPU có 80 tỷ transistor 80GB bộ nhớ HBM3 và Transformer Engine đột phá, được tối ưu cho các mô hình AI như GPT-4. Lõi Tensor thế hệ thứ 4 và các lệnh DPX của H100 tăng đáng kể hiệu suất suy luận và nhiệm vụ đào tạo AI.

Khi tích hợp những GPU này vào hệ thống barebones Supermicro của chúng tôi, chúng tôi tập trung vào việc đảm bảo quản lý nhiệt và phân phối điện năng tối ưu, do có lực lượng vẽ và phát nhiệt đáng kể từ những thành phần cao cấp này. Thùng máy Supermicro, mặc dù không chính thức hỗ trợ cấu hình như vậy, đã chứng minh được tính linh hoạt đủ để chứa đựng cấu hình của chúng tôi. Để kiểm soát nhiệt độ của các GPU A6000, chúng tôi phải giữ khoảng cách giữa chúng bằng một chiều rộng GPU do thiết kế quạt lồi, nhưng H100 có thể được đóng gói với lớp làm mát ch pass-through của nó.

Bộ công cụ đánh giá của chúng tôi bao gồm một loạt các trường hợp sử dụng cụ thể cho HPC và AI. Những trường hợp này đa dạng từ các công việc kiểm thử truyền thống đến các nhiệm vụ đào tạo và suy luận AI sử dụng mô hình mạng nơ-ron tích chập. Chúng tôi nhằm mục tiêu đẩy những GPU này đến giới hạn của chúng, đánh giá hiệu suất và hiệu suất, khả năng mở rộng và sự dễ dàng tích hợp với máy chủ Supermicro A+.

Trong quá trình tiếp cận các GPU hàng đầu từ NVIDIA trong khi làm việc trên mô hình cơ bản CNN trong phòng thí nghiệm, chúng tôi bắt đầu với một số bài huấn luyện cấp trạm trên cặp GPU RTX8000 cũ nhưng rất mạnh mẽ.

Trong quá trình phân tích hiệu suất AI của chúng tôi, chúng tôi đã quan sát một sự tiến triển đáng chú ý nhưng dễ dự đoán trong khả năng, chuyển từ NVIDIA RTX 8000 sang bốn GPU RTX A6000 và cuối cùng là bốn GPU PCIe NVIDIA H100. Sự tiến triển này thể hiện sức mạnh tinh thần của những bộ gia tốc này và sự phát triển của các bộ gia tốc NVIDIA qua những năm gần đây khi ngày càng nhiều sự chú ý được đặt vào các công việc làm việc AI.

Bắt đầu với RTX 8000, chúng tôi ghi nhận mức hiệu suất đáng kể. Với cấu hình này, quá trình đào tạo mô hình AI trên một bộ dữ liệu hình ảnh 6,36GB mất khoảng 45 phút mỗi epoch. Tuy nhiên, nhược điểm của RTX 8000 xuất hiện ở các giới hạn về kích thước batch và độ phức tạp của các nhiệm vụ nó có thể xử lý. Chúng tôi bị ràng buộc về kích thước batch nhỏ và hạn chế trong việc đào tạo hiệu quả các mô hình mạng nơ-ron phức tạp.

Sự chuyển đổi sang bốn GPU RTX A6000 đánh dấu một bước nhảy đáng kể về hiệu suất. Băng thông bộ nhớ và bộ nhớ GDDR6 lớn hơn của A6000 cho phép chúng tôi tăng kích thước batch gấp bốn lần trong khi vẫn giữ nguyên thời gian epoch và độ phức tạp của mô hình. Cải tiến này đã cải thiện quá trình đào tạo và cho phép chúng tôi thử nghiệm với các mô hình phức tạp hơn mà không kéo dài thời gian đào tạo.

Tuy nhiên, bước tiến đáng kể nhất đến từ việc giới thiệu bốn GPU PCIe NVIDIA H100. Tận dụng khả năng AI nâng cao của kiến trúc Hopper, những GPU này cho phép chúng tôi tăng kích thước batch lên gấp đôi. Điều ấn tượng hơn, chúng tôi có thể tăng độ phức tạp của mô hình AI mà không có thay đổi đáng kể trong thời gian epoch. Khả năng này là minh chứng cho các tính năng AI cấp tiến của H100, như Transformer Engine và Lõi Tensor thế hệ thứ 4, được tối ưu hóa để xử lý hiệu quả các hoạt động AI phức tạp.

Trong suốt những bài kiểm tra này, bộ dữ liệu hình ảnh 6,36GB và các tham số mô hình đã là một tiêu chí kiểm định nhất quán, cho phép chúng tôi so sánh trực tiếp hiệu suất qua các cấu hình GPU khác nhau. Sự tiến triển từ RTX 8000 đến A6000s, và sau đó là H100s, làm nổi bật sự cải thiện về sức mạnh xử lý thô và khả năng của GPU để xử lý các công việc AI lớn, phức tạp mà không làm giảm tốc độ hoặc hiệu suất. Điều này khiến cho những GPU này đặc biệt phù hợp cho nghiên cứu AI tiên tiến và ứng dụng học sâu quy mô lớn.

Máy chủ Supermicro được sử dụng trong bài kiểm tra của chúng tôi có kết nối PCIe trực tiếp với CPU, loại bỏ sự cần thiết của một công tắc PCIe. Sự kết nối trực tiếp này đảm bảo rằng mỗi GPU đều có một đường truyền riêng cho CPU, tạo điều kiện cho việc truyền dữ liệu nhanh chóng và hiệu quả. Kiến trúc này quan trọng trong một số công việc AI và HPC để giảm thiểu độ trễ và tối đa hóa sử dụng băng thông, đặc biệt hữu ích khi xử lý các nhiệm vụ có công suất lớn như đào tạo mô hình AI hoặc môi trường VDI phức tạp khi tất cả các công việc đều nằm trong máy chủ.

Kết Luận

Sự mở rộng và linh hoạt của máy chủ Supermicro GPU A+ Server AS-4125GS-TNRT chính là những tính năng nổi bật ở đây. Điều này đặc biệt hữu ích đối với khách hàng cần thích ứng với các yêu cầu công việc ngày càng phức tạp, cho dù trong lĩnh vực trí tuệ nhân tạo (AI), hạ tầng máy tính ảo (VDI), hay các nhiệm vụ đòi hỏi hiệu suất cao khác.

Bằng cách bắt đầu với một cấu hình khiêm tốn, người dùng có thể hiệu quả xử lý các công việc AI cấp độ nhập môn hoặc nhiệm vụ VDI, mang lại một giải pháp tiết kiệm chi phí cho các khối công việc nhỏ hoặc cho những người mới bắt đầu tiếp cận lĩnh vực trí tuệ nhân tạo và hạ tầng máy tính ảo. Thiết lập ban đầu này cung cấp một nền tảng vững chắc và có thể mở rộng, cho phép người dùng tương tác với các ứng dụng AI và VDI cơ bản nhưng quan trọng.

→ Máy chủ Supermicro AS-4125GS-TNRTđã sẵn sàng để đặt hàng, hãy truy cập tại đây: https://thegioimaychu.vn/gpu-a-server-as-4125gs-tnrt-tm8957.html

→ Để tìm hiểu thêm về toàn bộ dòng máy chủ Supermicro dựa trên AMD, hãy truy cập: https://thegioimaychu.vn/server/supermicro/

Bài viết liên quan

- Huấn luyện mô hình hàng trăm tỷ tham số ngay tại bàn với MSI EdgeXpert

- NVIDIA Merlin: Tổng quan về toolkit cho hệ thống gợi ý quy mô lớn

- Hướng dẫn triển khai máy chủ GPU tại chỗ trong các phòng máy doanh nghiệp

- NVIDIA ConnectX-8 SuperNIC: Đột phá kiến trúc hạ tầng AI với PCIe Gen6

- OpenAI lần đầu phát hành miễn phí mô hình ngôn ngữ mới với tên gọi là GPT-OSS

- NVIDIA hiện đang cung cấp những dòng GPU nào?