Quy trình làm việc hợp nhất giữa trí tuệ nhân tạo, phân tích dữ liệu và mô hình hóa / mô phỏng sẽ làm cho điện toán hiệu năng cao trở nên thiết yếu và phổ biến hơn bao giờ hết.

Điện toán hiệu năng cao (HPC) từ lâu đã rất quan trọng để vận hành khối lượng công việc mô phỏng và phân tích quy mô lớn nhằm thúc đẩy các tiến bộ khoa học, đổi mới sản phẩm và khả năng cạnh tranh giữa các quốc gia. Với quy mô trí tuệ nhân tạo (AI), phân tích dữ liệu hiệu suất cao (High Performance Data Analytics, HPDA) và quy trình mô hình hóa / mô phỏng ngày càng tăng, cần phải mở rộng cơ sở hạ tầng điện toán hiệu năng cao để giải quyết các thách thức của các quy trình công việc này. Sự hội tụ này đang mở rộng phạm vi của HPC và làm cho cơ sở hạ tầng HPC trở nên thiết yếu hơn bao giờ hết.

Hai yếu tố chính đang thúc đẩy việc mở rộng phạm vi của HPC. Một là sự bung nổ dữ liệu. Sản lượng dữ liệu kỹ thuật số hàng năm được dự đoán sẽ đạt hoặc vượt quá 163 zettabyte vào năm 2025. Dữ liệu này phải được phân tích để trích xuất những nắm bắt có thể giúp đưa ra các quyết định chính xác, làm tăng nhu cầu về cơ sở hạ tầng hiệu suất cao.

Các dự án khoa học lớn là nguồn đóng góp quan trọng cho sự bùng nổ đó. Dự án Large Hadron Collider của CERN sẽ tạo ra 50 petabyte dữ liệu vào năm 2018, và một bản nâng cấp theo kế hoạch trong năm 2026 sẽ tăng số lượng các sự kiện phát hiện mỗi giây gấp mười lần. Kính viễn vọng vô tuyến lớn nhất thế giới, Square Kilometer Array (SKA), sẽ phân tích 10 tỷ luồng dữ liệu hình ảnh được ghi nhận, soi xét kỹ hơn 1,5 triệu vật thể cứ sau mười phút để phát hiện các hiện tượng vật lý thiên văn như tín hiệu xung hoặc các tia chớp của sóng ánh sáng. Các trường hợp sử dụng thế hệ tiếp theo cũng đang tăng cường tạo ra dữ liệu. Một chiếc xe không người lái được ước tính tạo ra 4 TB mỗi ngày. Một chiếc máy bay được kết nối sẽ tạo ra số lượng gấp mười lần số đó và một nhà máy tự động hóa sẽ tạo ra khoảng một petabyte mỗi ngày. Một bệnh viện thông minh sẽ tạo ra 3 TB mỗi ngày.

Một yếu tố quan trọng khác thúc đẩy việc mở rộng phạm vi của HPC là sự gia tăng sức mạnh xử lý với chi phí ngày càng phải chăng, đó là khả năng trích xuất kiến thức từ khối lượng dữ liệu ngày càng tăng và hỗ trợ các trường hợp sử dụng dữ liệu mới. Điều này đã kích thích gia tăng hoạt động nghiên cứu trong các thuật toán AI, tiếp tục thúc đẩy sự phát triển trong lĩnh vực này. Ngoài các phân tích truyền thống cần thiết để hiểu rõ hơn về mô hình, tài nguyên HPC đang tạo ra một thế hệ khối lượng công việc hội tụ mới tích hợp AI và HPDA với khối lượng công việc mô phỏng và tạo mô hình của HPC. Các nền tảng HPC cung cấp hiệu suất tính toán và thông lượng để đào tạo các mô hình học tập sâu, nhập và xử lý các luồng dữ liệu thời gian thực và quy mô khối lượng công việc AI chuyên sâu về tài nguyên. Trong nhiều quy trình công việc hội tụ, AI và HPDA cũng cho phép tạo và tinh chỉnh các mô hình HPC mạnh hơn.

Tầm quan trọng của AI và khối lượng công việc hội tụ được phản ánh trong các dự báo tăng trưởng của HPC. Thị trường HPC tổng thể dự kiến sẽ đạt mức tăng trưởng tích lũy hàng năm 7% (CAGR) đều đặn đến năm 2021. Phân khúc AI-HPC được dự kiến sẽ tăng trưởng 30% CAGR trong cùng thời gian. Phân khúc HPC dành cho học sâu / Deep Learning đang tăng nhanh hơn nữa, với 81% CAGR. Phân tích riêng của Intel cho thấy chu kỳ tính toán AI sẽ tăng 12 lần vào năm 2020.

Một số trường hợp điển hình cho sự giao thoa của các quy trình công việc AI / HPC / HPDA này là gì? Và chúng ta, những người dẫn dắt lĩnh vực HPC cần làm gì để đẩy nhanh sự hội tụ này?

Các trường hợp cho sự hội tụ

AI vẫn đang trưởng thành và sự hội tụ đang ở giai đoạn đầu. Nhưng những đổi mới mang tính thay đổi cuộc chơi này đã làm thay đổi các ngành công nghiệp và mang lại khả năng nghiên cứu mới. Dưới đây là một vài ví dụ thú vị:

Lái xe tự động là trường hợp sử dụng AI được biết đến rõ nhất và hầu hết chúng ta có thể liên quan đến. Các tài xế Mỹ đã mất trung bình khoảng 283 giờ sau tay lái vào năm 2016 và những người lái xe ở Anh đã dành trung bình 30 giờ trong năm 2017 để ngồi trong tình trạng kẹt xe. Mặc dù các hệ thống điều hướng và các tính năng an toàn dựa trên AI đã nâng cao nhận thức và phản ứng của người lái, các phương tiện tự trị sẽ tạo ra lượng dữ liệu khổng lồ sẽ yêu cầu cơ sở hạ tầng HPC phân tích và dự đoán. Sau khi các nhà phát triển đã sử dụng các hệ thống HPC và mạng lưới thần kinh để phát triển và đào tạo các mô hình học tập sâu, các hệ thống HPC trên tàu sẽ ăn và phân tích nhiều nguồn dữ liệu được truyền phát, bao gồm radar, sonar, GPS, máy ảnh và dữ liệu khảo sát trên nền tảng laser. Các hệ thống này sẽ thực hiện các thuật toán phức tạp, rút ra các kết luận từ dữ liệu và đưa ra các quyết định theo thời gian thực để đáp ứng với các thay đổi về điều kiện đường xá, tình huống giao thông, hoạt động của người đi bộ và các khía cạnh khác của môi trường lái xe. Các hệ thống này sẽ mang lại những đột phá về sử dụng nhiên liệu, chất lượng không khí, hiệu quả, năng suất của con người, giải trí, thiết kế đô thị,

Thế giới sinh học ngày càng được số hóa và có thể đo lường được, tạo ra những luồng dữ liệu khổng lồ từ kính hiển vi điện tử cryo-electron, bộ giải mã gen, máy theo dõi bệnh nhân trên giường, thiết bị y tế chẩn đoán, thiết bị y tế có thể đeo được và một loạt các nguồn khác. Chạy các phân tích dựa trên AI trên các hệ thống HPC, các nhà nghiên cứu khoa học cho đời sống đang sử dụng dữ liệu này để xây dựng và tinh chỉnh các mô hình phức tạp để mô phỏng chức năng và quy trình của các cấu trúc sinh học ở cấp độ tế bào và tế bào phụ. Bằng cách kết hợp những kết quả nắm bắt với phân tích AI của các bộ dữ liệu khổng lồ được rút ra từ các nguồn lâm sàng, dịch tễ học và các nguồn khác, khối lượng công việc hội tụ sẽ giúp thay đổi cách chúng ta hiểu, điều trị và ngăn ngừa bệnh tật. Các giải pháp AI thực tế đã được tích hợp vào quy trình công việc lâm sàng,

Một bệnh viện hiện đại là một công cụ tạo dữ liệu, chủ yếu từ việc cung cấp dịch vụ chăm sóc sức khỏe hàng ngày, mà còn từ các quá trình nghiên cứu và phân tích như thử nghiệm lâm sàng. Dữ liệu không đồng nhất và bao gồm dữ liệu có cấu trúc (như kết quả xét nghiệm và mã chẩn đoán), văn bản không có cấu trúc (như ghi chú của bác sĩ), hình ảnh y tế, bộ gen (genomic), dữ liệu “omics” và các nguồn khác. Các bệnh viện, đặc biệt là những nơi có nhiệm vụ nghiên cứu, cũng đòi hỏi một khả năng điện toán lớn để xử lý các quy trình tính toán đa dạng của họ, tất cả mọi thứ từ phân tích thống kê cơ bản của hồ sơ bệnh án, đến xử lý hình ảnh, HPC và AI. Tuy nhiên, mục tiêu cung cấp thông tin hành động tại điểm chăm sóc vẫn khó nắm bắt. Dữ liệu thường bị bỏ qua và các nhóm tin học y tế thường làm việc tách biệt với các nhà cung cấp dịch vụ chăm sóc. Các phân tích của họ có lợi cho các hoạt động của bệnh viện, nhưng kết quả thường khó chuyển thành chăm sóc bệnh nhân tốt hơn. Các bệnh viện nghiên cứu lớn đang nỗ lực để tích hợp HPC, HPDA và AI để liên tục cung cấp thông tin hành động cho các bác sĩ tại điểm chăm sóc. Ví dụ, hãy tưởng tượng một tác nhân AI truy cập không chỉ dữ liệu sức khỏe của từng bệnh nhân mà cả dữ liệu từ nhiều nguồn (bao gồm cả các bệnh nhân khác) để dự đoán một cách linh hoạt, ví dụ, cách bệnh nhân sẽ đáp ứng với một điều trị cụ thể. Với đủ dữ liệu và sức mạnh tính toán, các tác nhân AI như vậy có khả năng cải thiện đáng kể kết quả của bệnh nhân. và AI để liên tục cung cấp thông tin hành động cho các bác sĩ tại điểm chăm sóc. Ví dụ, hãy tưởng tượng một tác nhân AI truy cập không chỉ dữ liệu sức khỏe của từng bệnh nhân mà cả dữ liệu từ nhiều nguồn (bao gồm cả các bệnh nhân khác) để dự đoán một cách linh hoạt, ví dụ, cách bệnh nhân sẽ đáp ứng với một điều trị cụ thể. Với đủ dữ liệu và sức mạnh tính toán, các tác nhân AI như vậy có khả năng cải thiện đáng kể kết quả của bệnh nhân và AI để liên tục cung cấp thông tin hành động cho các bác sĩ tại điểm chăm sóc.

Các kỹ thuật AI được hỗ trợ bởi HPC rất quan trọng để tồn tại trên một hành tinh luôn thay đổi. Khối lượng công việc hội tụ đang giúp các nhà nghiên cứu về biến đổi khí hậu xây dựng các mô hình tinh vi và chính xác hơn cũng như khám phá kỹ lưỡng hơn đầu ra của các mô phỏng của họ. Điều này củng cố khả năng của các nhà khoa học để dự đoán các tác động của thay đổi môi trường và đưa ra các đầu vào dựa trên bằng chứng cho các chiến lược lập kế hoạch và quản lý. Áp dụng HPC và AI vào dữ liệu cảm biến âm thanh và các mô hình dự trữ phức tạp giúp tăng khả năng phục hồi tài nguyên thiên nhiên trong khi giảm thiểu tác động môi trường. Các ứng dụng AI / HPC hội tụ tăng thời-gian-đến-thành-công cho các nguồn năng lượng sáng tạo và vật liệu tiết kiệm năng lượng.

Trong nhiều quy trình công việc hội tụ này, các nhà khoa học và nhà nghiên cứu sử dụng AI và HPDA để thực hiện đánh giá tinh vi dữ liệu dụng cụ thời gian thực khi nó được thu thập từ các thiết bị dựa trên cảm biến được kết nối. Với phân tích nâng cao và tổng hợp dữ liệu trong chuyến bay, các nhóm nghiên cứu có thể tương tác điều khiển các mô phỏng của họ, tinh chỉnh các mô hình của họ một cách nhanh chóng. Điều này có thể giúp cải thiện việc sử dụng tài nguyên và tăng tốc độ hiểu biết về thời gian. Các trường hợp sử dụng tương tự đang xuất hiện trong các lĩnh vực như sản xuất, trong đó công nghệ máy học và thị giác máy tính xác định và sửa lỗi sản phẩm trong thời gian thực và dịch vụ tài chính, trong đó phân tích các luồng dữ liệu trong chuyến bay có thể phát hiện và ngăn chặn các mối đe dọa bảo mật và phản ứng với các bất thường khác Hoạt động.

Thúc đẩy sự hội tụ

Hiện tại, HPC và AI / HPDA được phát triển trong môi trường phần cứng và phần mềm khác nhau. Tuy nhiên, các trường hợp sử dụng hội tụ sẽ yêu cầu các nền tảng hội tụ kết hợp các công nghệ nền tảng không đồng nhất và các nỗ lực đang được tiến hành để cho phép phát triển cả hai nền tảng này trên cùng một cơ sở hạ tầng thông qua các ngăn xếp phần mềm hội tụ và tính toán cơ sở hạ tầng. Một ví dụ gần đây là Intel® Deep Learning Boost, một phần mở rộng AI mới cho bộ xử lý Intel® Xeon® giúp tăng tốc các ứng dụng AI trong khi cung cấp hiệu suất HPC dẫn đầu thông qua các tính năng như Intel® AVX-512.

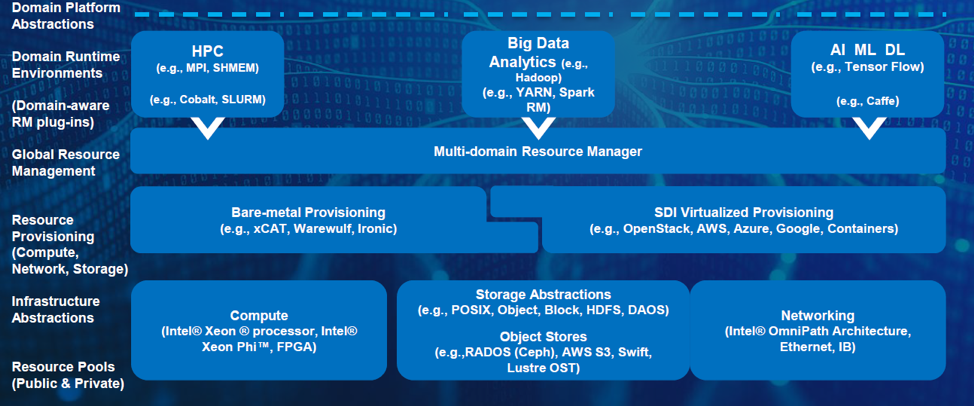

Các hệ thống hội tụ này phải triển khai đầy đủ và một cách hiệu quả về chi phí các ứng dụng điện toán khoa học và kỹ thuật, từ mô phỏng xử lý theo phương trình, xử lý hàng loạt đến phân tích tự động, cung cấp dữ liệu cần thiết để hỗ trợ quá trình ra quyết định của con người trong thời gian thực. Hình 1 cho thấy khuôn khổ mà Intel và các đối tác hệ sinh thái của chúng ta đang sử dụng khi chúng ta làm việc để tạo ra một kỷ nguyên mới của điện toán hội tụ, exascale.

Hình 1. Sự giao thoa của HPC-HPDA-AI

Sự hội tụ của HPC, HPDA và AI đòi hỏi một khả năng quản lý tài nguyên và software stack thống nhất, cùng với các công nghệ nền tảng mạnh mẽ và kiến trúc nhất quán.

Trái ngược với các nền tảng HPC truyền thống nhấn mạnh hiệu năng của bộ xử lý và kết nối, các nền tảng hội tụ này phải cân bằng hiệu năng của bộ xử lý, bộ nhớ, kết nối và I/O trong khi cung cấp khả năng mở rộng, khả năng phục hồi, mật độ và hiệu quả năng lượng cho điện toán thế hệ tiếp theo. Họ cũng phải cung cấp các khả năng linh hoạt, thống nhất để quản lý và cung cấp tài nguyên. Các cách tiếp cận sáng tạo để lưu trữ sẽ là cần thiết để thúc đẩy việc quản lý và lưu trữ dữ liệu và cho phép các tổ chức tối đa hóa giá trị của dữ liệu bị bắt trong suốt tuổi thọ của nó.

Cơ sở hạ tầng dựa trên đám mây – cho dù tại chỗ hoặc trong đám mây công cộng, sẽ đóng vai trò quan trọng trong việc cung cấp quyền truy cập vào tài nguyên HPC. Phần lớn các trang web HPC hiện chạy hơn 10 phần trăm khối lượng công việc HPC của họ trên cơ sở hạ tầng đám mây và một phần tư chạy khối lượng công việc HPC quan trọng nhất của họ trong một đám mây riêng. Học máy và AI đã là khối lượng công việc dựa trên đám mây phát triển nhanh nhất và sự hội tụ khối lượng công việc chắc chắn sẽ thúc đẩy sự mở rộng hơn nữa.

Sự phổ biến của HPC

AI đang nhanh chóng trở thành lĩnh vực xu thế và chủ đạo. Nó được tích hợp vào một loạt các ứng dụng doanh nghiệp đang phát triển và chúng ta tương tác với nó trong cuộc sống hàng ngày. Khi chúng ta tiến tới cấp độ exascale và sự hội tụ của AI, HPDA và mô hình hóa / mô phỏng, tài nguyên HPC sẽ trở thành nhiệm vụ quan trọng vượt xa các lĩnh vực khoa học và công nghệ truyền thống. Các nền tảng và giải pháp HPC hội tụ sẽ cung cấp các khả năng cần thiết trong toàn bộ nền kinh tế và xã hội, mang lại nhiều cơ hội hơn bao giờ hết cho các nhà nghiên cứu để đạt được tiến bộ về những thách thức và doanh nghiệp khó khăn nhất để cung cấp các sản phẩm và dịch vụ sáng tạo sâu sắc. Có rất nhiều việc phải làm, nhưng tầm nhìn rất rõ ràng và phần thưởng sẽ rất lớn.

Bài viết bởi tác giả Patricia A. Damkroger, Extreme Computing Intel Datacenter Group

Biên dịch bởi Bộ phận Giải pháp – Thế Giới Máy Chủ

Bài viết liên quan

- Máy chủ Supermicro X14: Hiệu suất mạnh mẽ, hiệu quả tối đa cho AI, Cloud, Storage, 5G/Edge

- NVIDIA HGX AI Supercomputer: Nền tảng điện toán AI hàng đầu thế giới

- NVIDIA SuperPOD DGX GB200: Kỷ nguyên của AI nghìn tỷ tham số

- Nền tảng NVIDIA Blackwell: Tạo nên kỷ nguyên điện toán mới

- NVIDIA DGX B200: Nền tảng AI thống nhất cho Training, Fine-tuning và Inference AI

- NVIDIA GB200 NVL72: Tối đa hóa đào tạo và suy luận LLM với hàng nghìn tỷ tham số