Trí tuệ nhân tạo (AI) ngày càng trở nên phổ biến hơn – từ trợ lý cá nhân thông minh đến tự động hóa quy trình, đến bảo trì dự đoán, v.v… Nhiều công ty biết rằng họ cần phải thực hiện nó nhưng phải đối mặt với những thách thức khi thực hiện dự án từ PoC (proof-of-concept) đến giai đoạn triển khai.

Để giúp các doanh nghiệp vượt qua rào cản về việc kết hợp một giải pháp AI từ các sản phẩm khác nhau và tích hợp chúng với cơ sở hạ tầng hiện có, NVIDIA® và VMWare® đã hợp tác để cung cấp bộ phần mềm NVIDIA AI Enterprise giúp mở ra sức mạnh của AI bằng cách cung cấp một nền tảng phần mềm cấp doanh nghiệp toàn diện được tối ưu hóa cho các workload phục vụ AI.

NVIDIA AI Enterprise 1.1

NVIDIA AI Enterprise là bộ ứng dụng và framework cho AI và khoa học dữ liệu toàn diện, được tối ưu hóa và chứng nhận độc quyền bởi NVIDIA để chạy trên VMware vSphere® với NVIDIA-Certified Systems. Nó bao gồm các công nghệ và phần mềm từ NVIDIA để triển khai, quản lý và mở rộng nhanh chóng các tải công việc AI trong mô hình hybrid-cloud hiện đại.

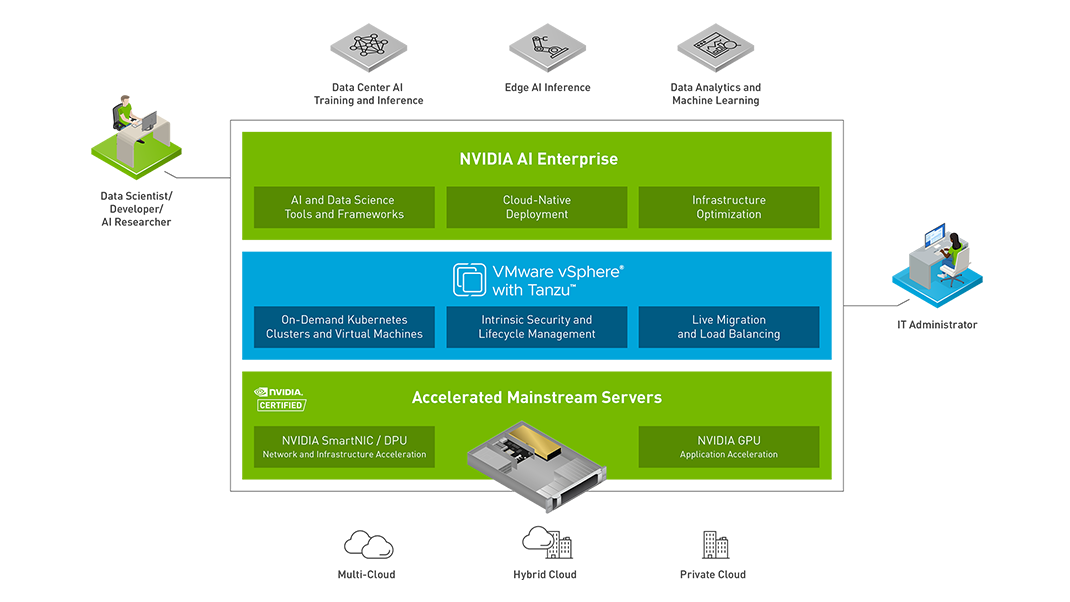

Phiên bản mới nhất của bộ phần mềm mang đến các bản cập nhật mới bao gồm hỗ trợ cấp vận hành cho AI ở dạng container trong phần mềm NVIDIA và VMWare vSphere® với VMWare Tanzu™. Trước đây chỉ khả dụng trên cơ sở thử nghiệm, VMWare vSphere with Tanzu™ là nền tảng ảo hóa hàng đầu trong ngành có thể chuyển đổi các máy chủ vật lý thành các nhóm hạ tầng AI và học máy được quản lý tập trung cho phép các nhà phát triển chạy tải công việc AI trên các container Kubernetes trong môi trường VMWare của họ.

Mô hình kiến trúc của NVIDIA AI Enterprise

Bộ phần mềm NVIDIA AI Enterprise 1.1 giúp các doanh nghiệp có thể chạy khối lượng công việc AI nâng cao trên các máy chủ tăng tốc chính thống, từ đó giúp các tổ chức ở mọi loại hình thêm các dịch vụ mới do AI hỗ trợ mà trước đây cần có hạ tầng hoặc hỗ trợ hoạt động chuyên biệt.

Để đơn giản hóa hơn nữa việc phát triển AI trong doanh nghiệp, NVIDIA AI Enterprise cũng giới thiệu hỗ trợ cho NVIDIA RAPIDS như một container học máy và học sâu tích hợp bao gồm các thư viện TensorFlow và PyTorch, cũng như các framework dành cho khoa học dữ liệu hàng đầu như Apache Spark và cuPY. RAPIDS cũng tận dụng NVIDIA CUDA® để tăng tốc quy trình công việc bằng cách chạy toàn bộ quy trình đào tạo về khoa học dữ liệu trên GPU, do đó giảm thời gian đào tạo và tần suất triển khai mô hình từ vài ngày xuống còn vài phút. Và vì RAPIDS có thể chạy ở mọi nơi – trên đám mây hoặc tại chỗ – việc mở rộng quy mô từ một máy trạm đến các máy chủ đa GPU thành các cụm đa node thật dễ dàng.

Bài viết liên quan

- NVIDIA NGC‑ready Low‑latency Edge AI: Giải pháp cho Retail, Manufacturing và Smart Cities

- So sánh sức mạnh của máy tính AI DGX Spark với các card GPU máy trạm chuyên nghiệp của NVIDIA

- Từ Orin đến Thor: Bước nhảy vọt kiến trúc của NVIDIA JetPack 7.0 và tương lai của robot hình người

- Tại sao gọi NVIDIA DGX Spark là Siêu máy tính AI cá nhân?

- Cơ chế quản lý bộ nhớ trên các nền tảng phần cứng nhất quán – Hardware-coherent

- Kiến trúc NVIDIA Blackwell với GB200 NVL72: Định nghĩa lại điện toán AI cấp độ Exascale