Khai thác sức mạnh của GPU để dễ dàng tăng tốc các quy trình làm việc Khoa học dữ liệu (data science), Học máy (machine learning) và AI của bạn. Thực thi toàn bộ quy trình làm việc Khoa học dữ liệu với sự hỗ trợ xử lý của GPU tốc độ cao, nạp dữ…

AI – HPC

Cần bao nhiêu bộ thu phát quang cho một GPU?

Trên thị trường, có các phiên bản khác nhau về tỷ lệ của bộ thu phát quang so với số lượng GPU và số liệu của các phiên bản khác nhau không nhất quán chủ yếu do số lượng mô-đun quang học cần thiết trong các kiến trúc mạng khác nhau là không giống nhau….

NVIDIA Metropolis: Giải pháp AI tại biên dành cho smart city, bán lẻ và các ngành liên quan

NVIDIA Metropolis là một framework ứng dụng, bộ công cụ dành cho các nhà phát triển và hệ sinh thái đối tác, kết hợp dữ liệu trực quan (visual) và AI để cải thiện hiệu quả vận hành và độ an toàn trong nhiều ngành công nghiệp. Nó giúp lượng lớn dữ liệu được tạo ra…

TensorFlow là gì? Nó có ý nghĩa như thế nào đối với Trí tuệ Nhân tạo?

TensorFlow là một thư viện mã nguồn mở hàng đầu được thiết kế để phát triển và triển khai các ứng dụng học máy (machine learning) tiên tiến nhất. TensorFlow là gì ? Được các nhà khoa học dữ liệu, nhà phát triển phần mềm và môi trường đào tạo sử dụng nhiều, TensorFlow là một…

NVIDIA DGX GH200: Máy chủ siêu tiên tiến cho Trí tuệ Nhân tạo AI

Hiệu ứng của Trí tuệ Nhân tạo (AI) ngày càng phức tạp hơn, kích thước và độ phức tạp của các mô hình AI cũng ngày càng tăng cao. Trong khi hầu hết các tổ chức cần xử lý nhiều khối lượng công việc AI song song, một số người dùng lại có yêu cầu…

NVIDIA NeMo framework: Xây dựng, tùy chỉnh và triển khai các mô hình Generative AI

NVIDIA NeMo framework là gì? NVIDIA NeMo, một phần của nền tảng NVIDIA AI, là một framework phát triển ứng dụng AI toàn diện cấp doanh nghiệp, cloud-native, xây dựng có mục đích cho việc tùy biến và triển khai các mô hình AI tạo sinh (Generative AI) với hàng tỷ tham số. Framework NeMo cung cấp…

Generative AI mở ra kỷ nguyên mới về hiệu quả trong các ngành công nghiệp

Một bước ngoặt vào ngày 22 tháng 11 năm 2022, phần lớn diễn ra trên không gian mạng, nhưng nó đã làm rung chuyển nền móng của hầu hết mọi ngành công nghiệp trên thế giới. Vào ngày đó, OpenAI đã phát hành ChatGPT, chatbot Trí tuệ nhân tạo tiên tiến nhất từng được phát triển. Việc…

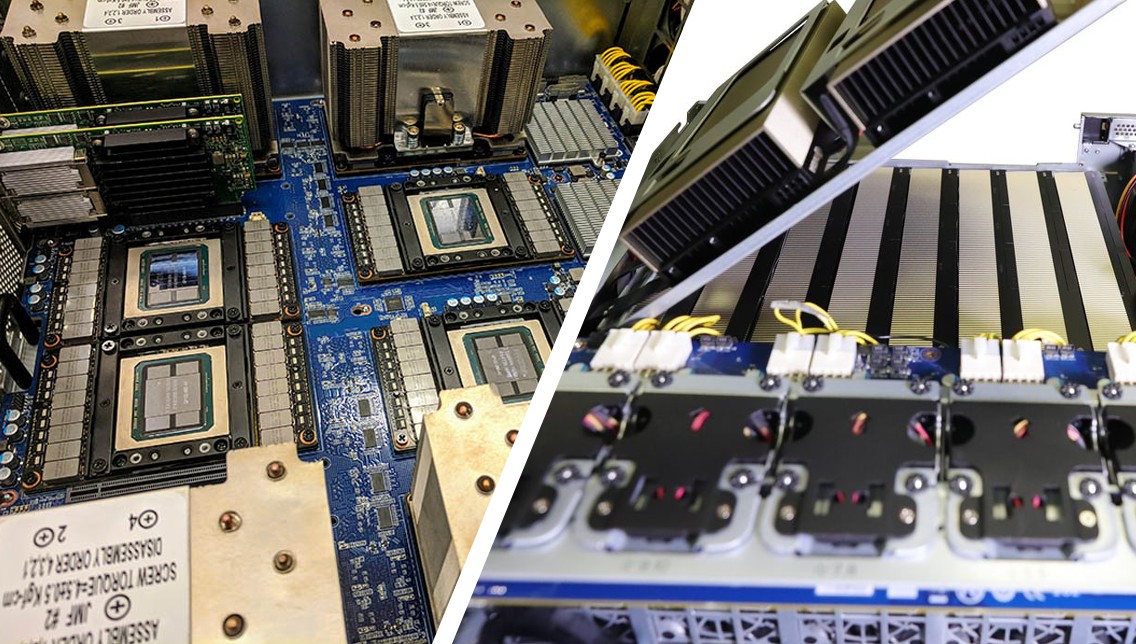

SXM vs PCIe: GPU nào tốt nhất cho đào tạo các mô hình ngôn ngữ lớn (LLM) như GPT-4?

NLP là gì và LLM là gì? Xử lý ngôn ngữ tự nhiên (NLP) là một nhánh của Trí tuệ nhân tạo (AI) cho phép máy móc hiểu và diễn giải ngôn ngữ của con người. Những tiến bộ gần đây trong học sâu đã dẫn đến sự xuất hiện của các mô hình ngôn ngữ…

Máy chủ ASUS với Bộ Vi xử lý và Giải pháp làm mát bằng chất lỏng thế hệ mới: Hiệu năng vượt trội và tối ưu

ASUS, một trong những nhà cung cấp hàng đầu về giải pháp máy chủ, đã đưa ra một dòng sản phẩm máy chủ đột phá với hiệu suất vượt trội và các giải pháp làm mát tiên tiến. Thông qua việc sử dụng bộ vi xử lý Intel® Xeon® Scalable thế hệ thứ 4, cùng…

AI, Digital Twin kích hoạt làn sóng mới về nghiên cứu khí hậu

CEO NVIDIA Jensen Huang vừa có bài trình bày về chủ đề này tại sự kiện Berlin Summit về các sáng kiến và công cụ “ảo hóa trái đất” (Earth Virtualization). “AI và điện toán tăng tốc sẽ giúp các nhà nghiên cứu khí hậu vươn tới những điều kỳ diệu mà họ cần để…