Không có câu trả lời rạch ròi nào cho việc chọn GPU nào là tốt nhất để suy luận AI (inference), vì các GPU khác nhau có thể có những ưu điểm và nhược điểm khác nhau tùy thuộc vào loại, kích thước và độ phức tạp của mô hình bạn muốn chạy. Tuy nhiên, một số yếu tố chung có thể ảnh hưởng đến hiệu suất suy luận của GPU là:

• Tốc độ xử lý: Đây là thước đo tốc độ GPU có thể thực hiện các lệnh và thực hiện phép tính. Nó thường được đo bằng FLOPS (các phép tính dấu chấm động trên giây). Tốc độ xử lý cao hơn có nghĩa là suy luận nhanh hơn, nhưng nó cũng tiêu thụ nhiều năng lượng hơn và sinh ra nhiều nhiệt hơn. Một số GPU có các đơn vị phần cứng chuyên dụng được gọi là Tensor Core có thể tăng tốc một số kiểu phép toán ma trận phổ biến trong học sâu.

• Băng thông bộ nhớ: Đây là thước đo tốc độ GPU có thể truyền dữ liệu giữa bộ nhớ và các đơn vị xử lý của nó. Nó thường được đo bằng GB/s (gigabyte trên giây). Băng thông bộ nhớ cao hơn có nghĩa là truy cập dữ liệu nhanh hơn và ít tắc nghẽn hơn khi suy luận, nhưng nó cũng tiêu thụ nhiều năng lượng hơn và tạo ra nhiều nhiệt hơn. Một số GPU có băng thông bộ nhớ cao hơn các GPU khác do cấu hình và loại bộ nhớ khác nhau.

• Dung lượng bộ nhớ: Đây là thước đo lượng dữ liệu mà GPU có thể lưu trữ trong bộ nhớ của nó tại một thời điểm nhất định. Nó thường được đo bằng GB (gigabyte). Dung lượng bộ nhớ cao hơn có nghĩa là nhiều mô hình hoặc mô hình lớn hơn có thể được tải và chạy trên GPU mà không bị hoán đổi hoặc lỗi hết bộ nhớ, nhưng nó cũng làm tăng chi phí và mức tiêu thụ năng lượng của GPU. Một số GPU có dung lượng bộ nhớ lớn hơn các GPU khác do cấu hình và loại bộ nhớ khác nhau.

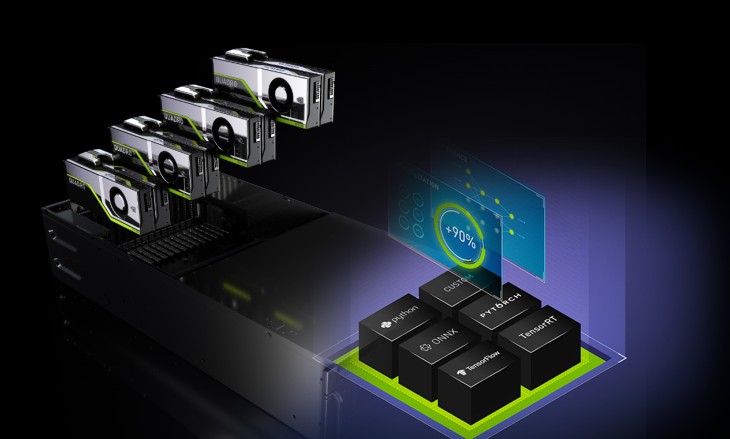

• Khả năng tương thích phần mềm: Đây là thước đo mức độ GPU có thể chạy các khung phần mềm và thư viện khác nhau được sử dụng để suy luận học sâu . Một số GPU có thể hỗ trợ hoặc tối ưu hóa tốt hơn cho một số phần mềm nhất định so với các GPU khác do các trình điều khiển, bộ công cụ hoặc API khác nhau. Ví dụ: GPU NVIDIA được hỗ trợ rộng rãi bởi các khung phổ biến như TensorFlow, PyTorch và Stable Diffusion, trong khi GPU AMD và Intel có thể yêu cầu các bước bổ sung hoặc sửa đổi để chạy chúng.

Dựa trên các yếu tố này, một số GPU hiện tại được coi là tốt để suy luận là:

• NVIDIA L4: Đây là GPU suy luận chuyên dụng được thiết kế cho các ứng dụng video AI. Nó có bộ nhớ GDDR6X 32 GB, tốc độ xử lý FP32 16 TFLOPS, băng thông bộ nhớ 512 GB/s và 256 Tensor Cores. Nó hỗ trợ NVIDIA DeepStream SDK để phân tích video và NVIDIA Jarvis SDK dành cho AI đàm thoại.

• NVIDIA L40: Đây là GPU suy luận chuyên dụng được thiết kế cho các ứng dụng tạo sinh hình ảnh. Nó có bộ nhớ GDDR6X 48 GB, tốc độ xử lý FP32 24 TFLOPS, băng thông bộ nhớ 768 GB/s và 384 Tensor Cores. Nó hỗ trợ nền tảng NVIDIA Omniverse để tạo hình ảnh chân thực và NVIDIA Maxine SDK cho hội nghị truyền hình.

• NVIDIA H100 NVL: Đây là GPU suy luận chuyên dụng được thiết kế để triển khai mô hình ngôn ngữ lớn (LLM). Nó có bộ nhớ HBM2e 80 GB, tốc độ xử lý FP32 19,5 TFLOPS, băng thông bộ nhớ 1,6 TB/s và 640 Tensor Cores. Nó hỗ trợ khung NVIDIA Megatron để đào tạo và triển khai các mô hình ngôn ngữ lớn như GPT-3.

• NVIDIA Grace Hopper: Đây là GPU suy luận chuyên dụng được thiết kế cho các kiểu máy đề xuất. Nó có bộ nhớ HBM3 128 GB, tốc độ xử lý FP32 25 TFLOPS, băng thông bộ nhớ 2 TB/s và 768 Tensor Cores. Nó hỗ trợ khung NVIDIA Merlin để xây dựng và triển khai các hệ thống đề xuất.

• NVIDIA RTX 4090: Đây là GPU chơi game dành cho người tiêu dùng, nhưng nó cũng có thể được sử dụng để suy luận. Nó có bộ nhớ GDDR6X 24 GB, tốc độ xử lý FP32 36 TFLOPS, băng thông bộ nhớ 936 GB/s và 288 Tensor Cores. Nó hỗ trợ CUDA và các thư viện NVIDIA khác để suy luận học sâu.

• AMD Radeon RX 7900 XT: Đây là GPU chơi game, cũng có thể được sử dụng để suy luận. Nó có bộ nhớ GDDR6 16 GB, tốc độ xử lý FP32 23 TFLOPS, băng thông bộ nhớ 512 GB/s và không có Tensor Core. Nó hỗ trợ Vulkan và các thư viện AMD khác để suy luận học sâu .

• Intel Arc Alchemist Xe HPG: Một GPU chơi game khác, cũng có thể được sử dụng để suy luận. Nó có bộ nhớ GDDR6 16 GB, tốc độ xử lý FP32 18 TFLOPS, băng thông bộ nhớ 448 GB/s và cũng không có Tensor Core. Nó hỗ trợ OpenVINO và các thư viện khác của Intel để suy luận học sâu.

Trên đây là một số mẫu GPU có sẵn hoặc dự kiến ra mắt trong năm 2023. Tuy nhiên, bạn cũng nên xem xét ngân sách, mức tiêu thụ điện năng, yêu cầu làm mát và tùy chọn phần mềm khi chọn GPU để suy luận. Bạn cũng có thể muốn so sánh điểm benchmark và đánh giá của các GPU khác nhau trên các kiểu máy và tác vụ khác nhau để có được bức tranh chính xác hơn về hiệu suất của chúng.

Nguồn tham khảo:

https://lambdalabs.com/blog/best-gpu-2022-sofar

https://www.nvidia.com/en-us/deep-learning-ai/solutions/inference-platform

https://www.tomshardware.com/news/stable-diffusion-gpu-benchmarks

https://timdettmers.com/2023/01/30/which-gpu-for-deep-learning

Bài viết liên quan

- Máy chủ Supermicro X14: Hiệu suất mạnh mẽ, hiệu quả tối đa cho AI, Cloud, Storage, 5G/Edge

- Hướng dẫn build một cụm GPU cho AI

- AI: Giải pháp inference trên các máy chủ thông dụng của HPE, Dell và Supermicro

- NVIDIA Hopper tiếp tục dẫn đầu hiệu suất Generative AI trong MLPerf

- GDDR6 vs HBM – Định nghĩa các loại bộ nhớ GPU

- NVIDIA NIM: Vi dịch vụ suy luận tối ưu hóa cho triển khai mô hình AI quy mô lớn