Nvidia ra mắt kiến trúc GPU mới có tên là Ampere, cung cấp hiệu suất AI tăng gấp 20 lần so với các nền tảng hiện có.

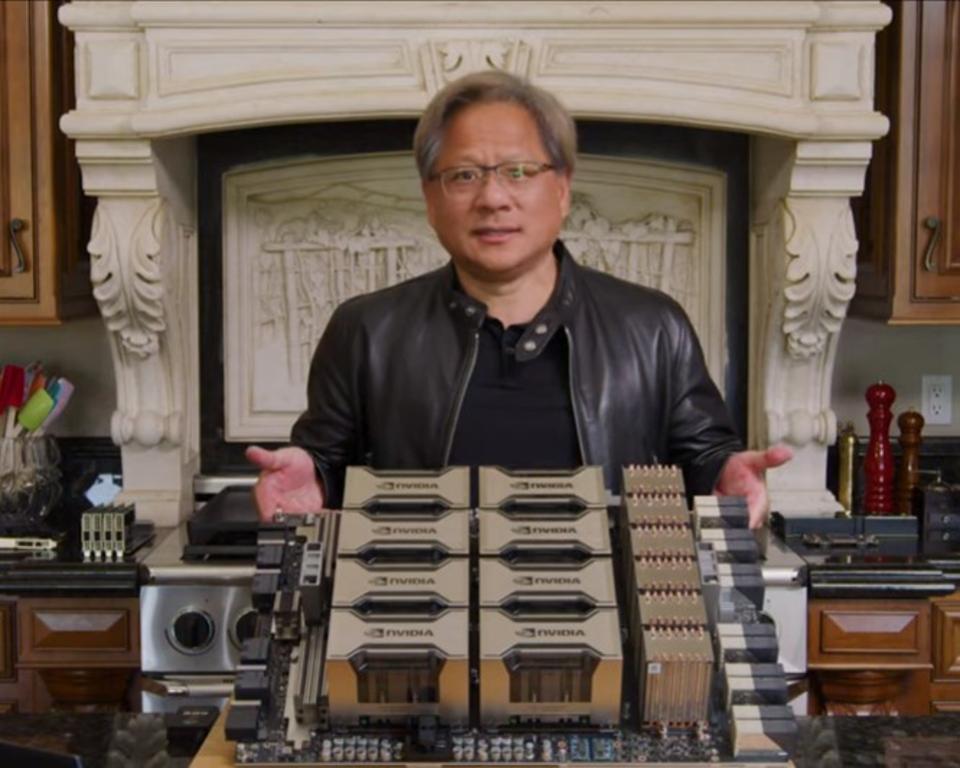

Một trong những truyền thống của mùa xuân là sự kiện Nvidia GPU Technology Conference (GTC) được tổ chức hàng năm tại San Jose, California. Trong khi công ty tổ chức các sự kiện khác trong suốt cả năm ở các khu vực khác, sự kiện ở San Jose hàng năm là nơi mà Nvidia thường giới thiệu các sản phẩm mới quan trọng nhất của mình. Sự kiện năm nay được tổ chức trực tuyến do ảnh hưởng của Covid-19, nhưng bài phát biểu và giới thiệu sản phẩm của CEO Jensen Huang đã bị hoãn lại cho đến hôm nay và như thường lệ, chúng đã không gây thất vọng. Tất cả trong một sự kiện, Nvidia đã giới thiệu không chỉ một kiến trúc điện toán GPU mới, Ampere, mà còn giới thiệu các sản phẩm cho phép mọi thứ từ robot nhỏ nhất đến các dịch vụ trên đám mây với một chủ đề cơ bản xuyên suốt – Trí tuệ Nhân tạo (AI).

Trong vòng một thập kỷ qua, Nvidia đã chuyển mình từ một công ty thiên về hỗ trợ đồ họa và gaming sang tập trung vào AI bằng cách phát triển các kiến trúc đồ họa để tăng tốc xử lý và xây dựng nền tảng lập trình CUDA framework độc quyền. Do đó, hãng này đã nổi lên như một nhà dẫn đầu trong đào tạo học sâu và suy luận AI cho các trung tâm dữ liệu, và các giải pháp phương tiện không người lái. Hiện giờ, công ty đang tiếp tục mở rộng sang các lĩnh vực điện toán biên, mạng hiệu suất cao và điện toán hiệu năng cao đa mục đích trong trung tâm dữ liệu.

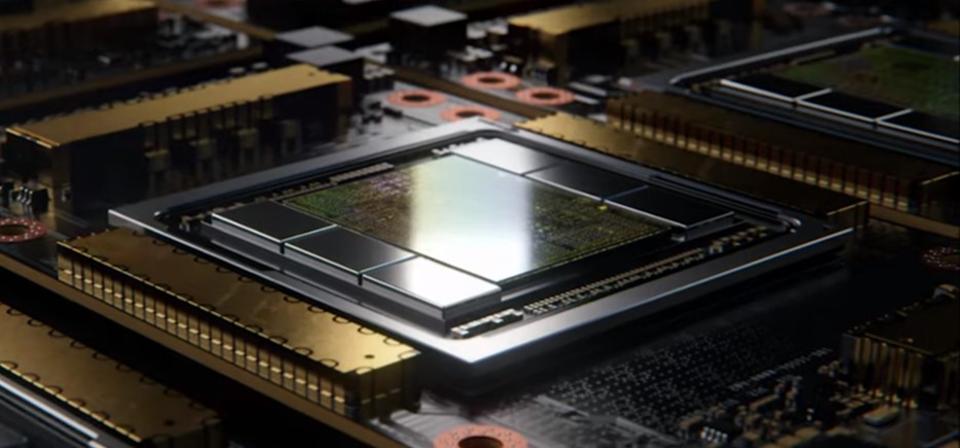

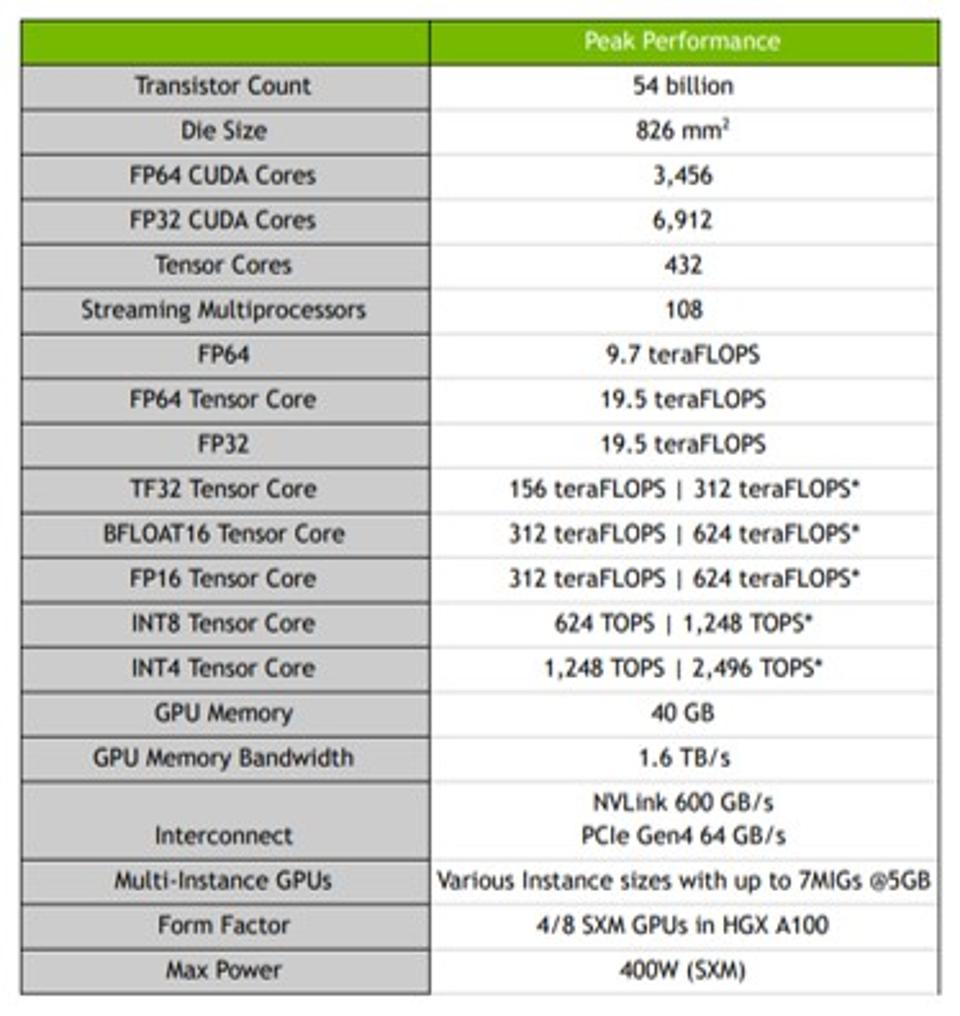

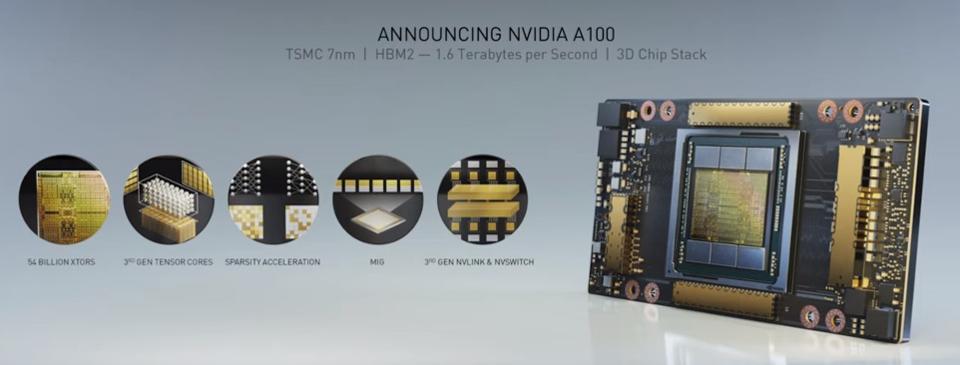

Trọng tâm của bài thuyết trình của Jensen là cách Nvidia tận dụng AI trong mọi thứ công ty thiết kế ra, ngay cả các giải pháp đồ họa GeForce RTX hàng đầu của công ty cũng tận dụng AI để mở rộng khả năng đồ họa, kết hợp với công nghệ ray-tracing rendering. Nhưng chủ đề quan trọng nhất là sự ra đời của kiến trúc điện toán tăng tốc Ampere mới của NVIDIA. Sản phẩm đầu tiên là A100 nhắm đến các ứng dụng trong trung tâm dữ liệu. A100 sử dụng hơn 54 tỷ transistors, được xây dựng trên công nghệ xử lý TSMC 7nm với khả năng xếp chồng 3D. Sử dụng công nghệ mới gọi là Multi-Instance GPU (MIG), cho phép A100 hoạt động như từ một đến bảy GPU riêng biệt hoặc kết hợp với các A100 khác như một GPU lớn. Điều này cho phép A100 giải quyết cả các ứng dụng máy chủ có khả năng scale-out và scale-up. Nó cũng có Tensor Core thế hệ thứ 3, bổ sung thêm một kiểu dữ liệu mới gọi là Tensor Float 32 (TF32) và có băng thông bộ nhớ lên đến 1.6TB/s. Kết quả là cho phép tăng tốc 20x cả đào tạo và suy luận. Theo tin từ NVIDIA thì A100 đã được bán ra thị trường.

Về phía sản phẩm, Nvidia đã giới thiệu một loạt các giải pháp mới. Bắt đầu với các thiết bị edge công suất thấp, công ty đã giới thiệu kit phát triển mới cho nền tảng Jetson Xavier NX được giới thiệu vào tháng 11. Giống như các kit Jetson khác, nó bao gồm một bảng mạch có thể được sử dụng trong hệ thống vận hành thực tế, các thư viện phần mềm và các bộ kit. Tuy nhiên, điểm mới của nền tảng là hỗ trợ native cloud – khả năng sử dụng các ứng dụng được đóng gói trong các “container” và cập nhật phần mềm dễ dàng cho các ứng dụng nhúng sử dụng bất kỳ sản phẩm nào của Jetson. Nền tảng Jetson đã trở nên phổ biến đến mức có hơn 3000 công ty và hơn nửa triệu nhà phát triển đang sử dụng nền tảng này.

Hơn nữa một giải pháp hiệu suất từ Jetson là nền tảng dành cho nhà phát triển Isaac for Robotics của Nvidia. Mặc dù công ty không công bố phiên bản mới của nền tảng, nhưng họ đã công bố chiến thắng về thiết kế lớn đầu tiên với BMW. BMW đang sử dụng nền tảng Isaac cho khâu hậu cần của các nhà máy, đặc biệt là xử lý vật liệu. Số liệu thống kê thuần túy xử lý hơn 230.000 bộ phận khác nhau cho hơn 40 mẫu xe khác nhau, mỗi mẫu được tùy chỉnh theo yêu cầu của khách hàng là một ứng dụng chính cho AI và robot. Theo Nvidia, công ty có những cam kết tương tự với các khách hàng khác và nền tảng Isaac cũng có thể sẽ được sử dụng trong sản xuất robot.

Trong ngành ô tô, Nvidia đã giới thiệu một System-on-Chip (SoC) mới – Orin. Orin là một SoC công suất thấp với GPU Ampere tích hợp mang lại hiệu suất 10 TOPS chỉ với 5W. Orin có thể được sử dụng riêng cho hệ thống ADAS hoặc kết hợp với các GPU Orin SoC và A100 bổ sung để mở rộng lên đến hệ thống điều khiển tự động hoàn toàn cấp 5 SAE. Đây là nền tảng đầu tiên từ Nvidia có thể mở rộng toàn bộ hệ thống điều khiển ô tô. Chúng tôi sẽ chia sẻ thêm thông tin về nền tảng Orin khi có sẵn.

Lấn sân vào lĩnh vực mạng, Nvidia đã công bố Edge EGX. Công ty mô tả đây là một máy tăng tốc trung tâm dữ liệu biên từ xa kết hợp GPU Ampere và kết nối Mellanox ConnectX-6 DX. EGX có thể được sử dụng trên toàn mạng như một trung tâm dữ liệu nhỏ có khả năng chạy các framework AI, bao gồm cả các framework do Nvidia cung cấp. Một trong những thị trường mục tiêu cho EGX là máy chủ cạnh 5G chạy phần mềm Aerial CloudRAN của Nvidia.

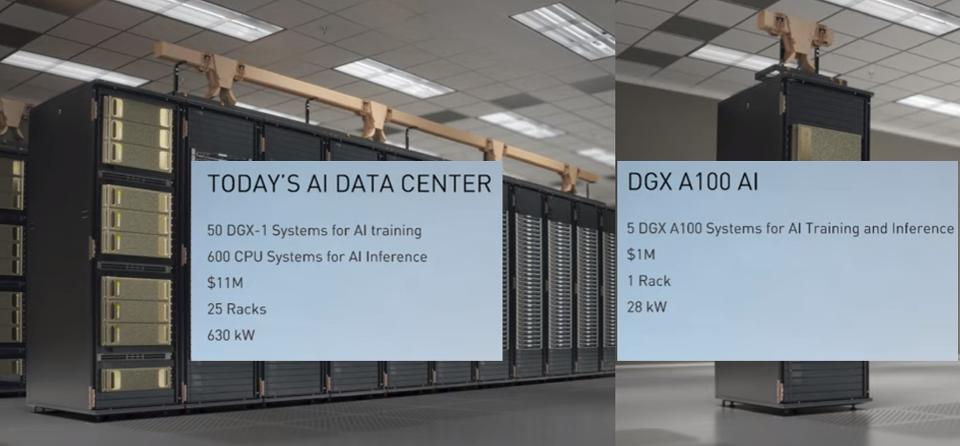

Và cuối cùng, một lĩnh vực trọng tâm chính cho Nvidia – trung tâm dữ liệu. Kết hợp với Ampere A100 mới, Nvidia đã giới thiệu nền tảng máy chủ HGX A100 mới và máy chủ DGX A100 của riêng công ty. Cả hai đều tận dụng tối đa tám GPU A100 với bộ xử lý AMD Epyc Rome 64 lõi kép và bộ nhớ 1TB. Cùng với nhau, chúng có thể được sử dụng cho bất kỳ ứng dụng điện toán tăng tốc nào trong trung tâm dữ liệu. Và như Nvidia chỉ ra, DGX cung cấp giá trị đáng kể bằng cách chỉ tiêu thụ 1/20 điện năng, một phần nhỏ của không gian, và có giá ít hơn 1/10 so với các máy chủ truyền thống với hiệu suất tương tự.

Ngoài ra, Nvidia tiếp tục xây dựng các framework AI cho các trung tâm dữ liệu. Spark 3.0 hiện đã hỗ trợ GPU-aware và có khả năng khai thác điện toán tăng tốc. Ngoài ra, Nvidia đã giới thiệu về Merlin, một deep learning framework cho các hệ thống gợi ý và Jarvis, một conversational framework model. Jarvis cũng bao gồm một bot theo dõi 3D có khả năng biểu cảm khuôn mặt và học biểu cảm khuôn mặt từ việc xem biểu cảm của con người. Những sản phẩm này tham gia các framework AI khác từ Nvidia, bao gồm các công cụ phân tích dữ liệu, Clara cho khoa học đời sống, Drive cho xe tự hành, Aerial cho radio 5G Baseband, Isaac cho robot và Metropolis cho các nền tảng biên.

Mặc dù vẫn được công nhận là hãng dẫn đầu về đồ họa hiệu năng cao, đặc biệt là chơi game và thiết kế, Nvidia đã chứng minh rằng giờ đây họ là một công ty AI từ gốc tới ngọn và tập trung vào AI cho hầu hết mọi ứng dụng.

Bạn có thể xem loạt video NVIDIA GTC 2020 Keynote trên YouTube, lưu ý series này bao gồm 8 phần.

Theo Forbes

Bài viết liên quan

- Máy chủ Supermicro X14: Hiệu suất mạnh mẽ, hiệu quả tối đa cho AI, Cloud, Storage, 5G/Edge

- NVIDIA Omniverse ft Apple Vision Pro: Mở rộng thế giới quan với VR/AR

- Tôi có cần CPU kép không?

- NVIDIA NIM: Vi dịch vụ suy luận tối ưu hóa cho triển khai mô hình AI quy mô lớn

- NVIDIA HGX AI Supercomputer: Nền tảng điện toán AI hàng đầu thế giới

- NVIDIA SuperPOD DGX GB200: Kỷ nguyên của AI nghìn tỷ tham số