Sự bùng nổ của các ứng dụng và dịch vụ được cung cấp bởi trí tuệ nhân tạo (AI) đang thay đổi nhanh chóng cách thế giới chuyển đổi dữ liệu thành nắm bắt sâu xa và thúc đẩy đổi mới trong nhiều ngành công nghiệp. Nhiều hãng máy chủ đã hợp tác và cùng NVIDIA® (Supermicro, HPE, Dell) cam kết cung cấp các hệ thống sẵn sàng cho AI kết hợp các nền tảng máy chủ mạnh nhất thế giới với các công nghệ GPU tiên tiến nhất, chia sẻ mục tiêu giúp mọi khách hàng khám phá toàn bộ tiềm năng của điện toán GPU.

Các hệ thống AI dựa vào các tập dữ liệu lớn và sức mạnh xử lý song song để mô phỏng trí thông minh của con người và giải quyết các vấn đề rất phức tạp. Những kỹ thuật này liên tục phát triển khi máy tính đạt được những nắm bắt sâu xa về dữ liệu và có thể suy nghĩ, học hỏi theo cách tương tự như cách bộ não con người xây dựng kiến thức từ kinh nghiệm sống. Sức mạnh tính toán và khả năng lưu trữ dữ liệu đã phát triển đến mức các kỹ thuật AI chuyên dụng như học sâu hiện đang được sử dụng hàng ngày để thúc đẩy các bước đột phá trong các lĩnh vực như nhận dạng giọng nói, thị giác máy tính và phân tích dự đoán.

Khi các mạng thần kinh sâu (DNN) phát triển và trở nên tốt hơn trong việc nhận dạng các hình mẫu trong một lượng lớn dữ liệu, các công nghệ CPU truyền thống không phù hợp với các nhu cầu tính toán ngày càng tăng này. Học sâu, tính toán hiệu năng cao (HPC) và đồ họa đòi hỏi tính toán song song ồ ạt và chỉ có tính toán GPU cung cấp năng lượng cần thiết để thúc đẩy các khối lượng công việc này. GPU cũng có hiệu quả cao trong việc nhanh chóng đào tạo các mô hình học tập sâu bằng cách sử dụng các bộ đào tạo lớn hơn nhiều và một phần cơ sở hạ tầng điện toán.

Khi các mô hình được đào tạo này được triển khai trong sản xuất, việc đạt được tốc độ xử lý nhanh trở nên quan trọng bởi vì các hệ thống này liên tục bị thách thức để cung cấp các phản hồi nhanh chóng với trải nghiệm trực quan từ người dùng. Khả năng đáp ứng nhanh này là cần thiết cùng với thông lượng lớn để mở rộng khối lượng dữ liệu bùng nổ cần thiết để phục vụ cho các dịch vụ do AI cung cấp như tìm kiếm trực quan, các gợi ý được cá nhân hóa và dịch vụ khách hàng tự động.

SO SÁNH PCIE VÀ SXM2

Các bus dữ liệu nội bộ, mang dữ liệu và hoạt động giữa các thành phần bên trong của máy tính, có thể có ảnh hưởng đáng kể đến thông lượng chung của hệ thống. PCI Express (PCIe) là tiêu chuẩn bus mở rộng máy tính nối tiếp tốc độ cao hiện hành, cung cấp độ trễ thấp hơn và tốc độ truyền dữ liệu cao hơn so với các bus cũ như PCI và PCI-X. Các thiết bị được kết nối qua các làn PCIe có kết nối điểm-điểm riêng, có nghĩa là các thiết bị không cạnh tranh về băng thông vì chúng không chia sẻ cùng một bus chung.

PCIe là đủ cho nhu cầu của nhiều hệ thống máy tính hiện đại, và là tiêu chuẩn được sử dụng phổ biến nhất trong toàn ngành. Nhiều thiết bị trong một hệ thống (bao gồm cả GPU) được kết nối bằng các làn PCIe và đối với một số thiết lập GPU, sử dụng các làn có sẵn này cung cấp đủ băng thông. Tuy nhiên, đối với các GPU cao cấp và hệ thống đa GPU chạy các phép toán song song được băm nhỏ với số lượng cực lớn và trao đổi một lượng dữ liệu rất lớn, bus PCIe có thể nhanh chóng bị quá tải và gây ra tắc nghẽn, suy giảm hiệu năng.

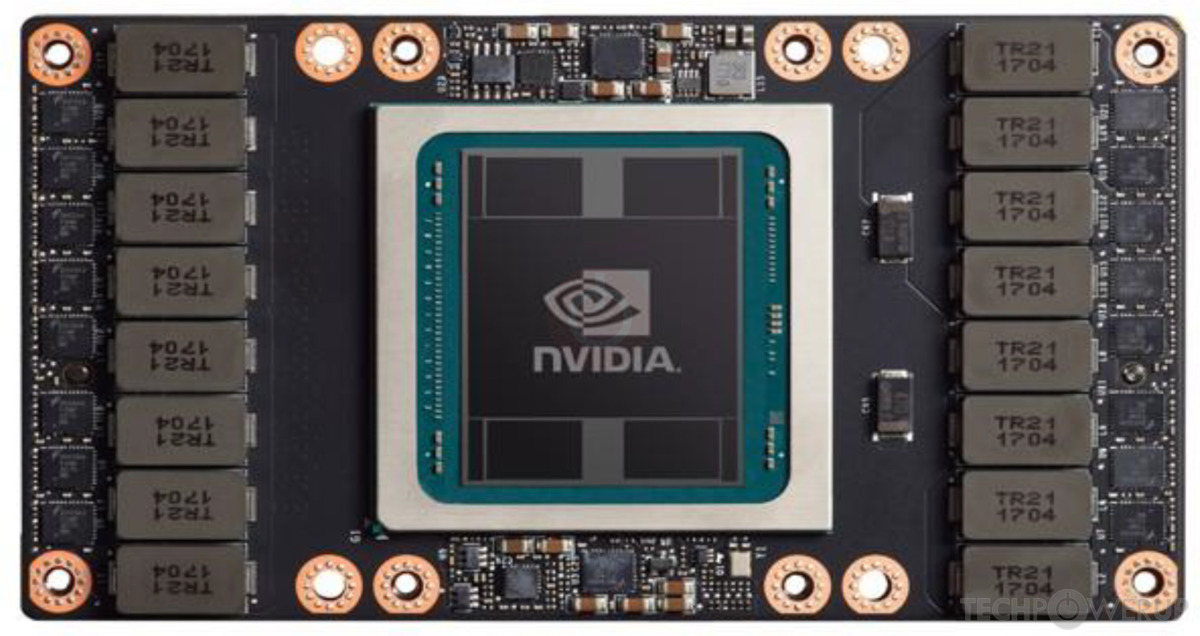

Để giải quyết những vấn đề này với PCIe, NVIDIA đã giới thiệu một đầu nối lửng SXM2 mới (mezzanine connector). Đầu nối SXM2 của NVIDIA cho phép GPU tận dụng NVIDIA® NVLink™, kết nối băng thông cao, tiết kiệm năng lượng của NVIDIA, cho phép CPU giao tiếp cực nhanh đến GPU hoặc giữa các GPU với nhau (CPU-to-GPU, GPU-to-GPU). Các máy chủ được thiết kế cho SXM2 tận dụng lợi thế kênh truyền GPU-to-GPU để khai thác tối đa hiệu suất xử lý của GPU. Thiết kế SXM2 cho phép GPU hoạt động vượt ra ngoài giới hạn của bus PCIe để chúng có thể đạt được tiềm năng hiệu suất tối đa của chúng.

THÔNG LƯỢNG TỐI ĐA CHO phép HIỆU SUẤT ỨNG DỤNG VƯỢT TRỘI

NVLink cung cấp đường truyền tốc độ cao giữa các GPU, cho phép chúng giao tiếp tốc độ dữ liệu cao nhất 300 gigabyte mỗi giây (GB/s), tốc độ nhanh hơn 10 lần so với PCIe. Không giống như PCIe, với NVLink, một thiết bị có nhiều kênh truyền để lựa chọn và thay vì chia sẻ chung một hub trung tâm để liên lạc, thay vào đó, chúng sử dụng một mạng lưới (mesh) cho phép trao đổi dữ liệu băng thông cao nhất giữa các GPU. Điều này tăng tốc đáng kể các ứng dụng và mang lại hiệu năng tính toán thô lớn hơn nhiều so với GPU sử dụng PCIe. Bằng cách tăng tổng băng thông giữa GPU và các bộ phận khác của hệ thống, luồng dữ liệu và tổng thông lượng hệ thống được cải thiện để nâng cao hiệu suất của khối lượng công việc.

Module GPU tăng tốc NVIDIA® Tesla® V100 được chế tạo chuyên dụng cho HPC và Deep Learning, dựa trên kiến trúc Volta đột phá mới của NVIDIA. Tesla V100 có sẵn cả dưới dạng bảng tăng tốc GPU truyền thống cho các máy chủ dựa trên PCIe và cả dạng module SXM2 cho các máy chủ được tối ưu hóa NVLink. Định dạng truyền thống cho phép các trung tâm dữ liệu HPC triển khai các GPU tiên tiến nhất trong các node dựa trên PCIe, cho phép chúng hỗ trợ kết hợp khối lượng công việc của CPU và GPU với phần cứng hiện có của chúng. Các máy chủ được tối ưu hóa NVLink cung cấp hiệu suất tốt nhất và mở rộng quy mô cho các trung tâm dữ liệu siêu tính toán và HPC chạy các ứng dụng mở rộng ra nhiều GPU, chẳng hạn như Deep Learning.

Các máy chủ được thiết kế cho NVidia SXM2 có thể kể đến như Supermicro SYS-4029GP-TVRT, HPE Apollo sx40, HPE SGI 8600, NVidia DGX-1 / DGX-2 hỗ trợ các module accelerator dựa trên kiến trúc Volta mới của NVIDIA và SXM2 form factor, mở ra rất nhiều lựa chọn cho các trung tâm nghiên cứu trí tuệ nhân tạo chuyên sâu.

Bài viết liên quan

- NVIDIA NGC‑ready Low‑latency Edge AI: Giải pháp cho Retail, Manufacturing và Smart Cities

- So sánh sức mạnh của máy tính AI DGX Spark với các card GPU máy trạm chuyên nghiệp của NVIDIA

- Từ Orin đến Thor: Bước nhảy vọt kiến trúc của NVIDIA JetPack 7.0 và tương lai của robot hình người

- Tại sao gọi NVIDIA DGX Spark là Siêu máy tính AI cá nhân?

- Cơ chế quản lý bộ nhớ trên các nền tảng phần cứng nhất quán – Hardware-coherent

- Kiến trúc NVIDIA Blackwell với GB200 NVL72: Định nghĩa lại điện toán AI cấp độ Exascale