Training AI (Huấn luyện AI) là quá trình cung cấp dữ liệu cho một mô hình AI để nó có thể học cách thực hiện một nhiệm vụ cụ thể. Dữ liệu này có thể bao gồm văn bản, hình ảnh, âm thanh, video hoặc bất kỳ loại dữ liệu nào khác có liên quan đến nhiệm vụ. Sau khi được huấn luyện, mô hình AI có thể sử dụng kiến thức đã học để thực hiện nhiệm vụ đó mà không cần sự can thiệp của con người.

Quá trình training AI thường bao gồm các bước sau:

- Xác định mục tiêu: Xác định rõ ràng nhiệm vụ mà mô hình AI cần thực hiện.

- Thu thập dữ liệu: Thu thập dữ liệu chất lượng cao và có liên quan đến nhiệm vụ.

- Chuẩn bị dữ liệu: Sửa chữa và chuẩn bị dữ liệu để phù hợp với mô hình AI.

- Lựa chọn mô hình AI: Lựa chọn mô hình AI phù hợp với nhiệm vụ và dữ liệu.

- Huấn luyện mô hình AI: Huấn luyện mô hình AI bằng cách cung cấp cho nó dữ liệu đã được chuẩn bị.

- Đánh giá mô hình AI: Đánh giá hiệu suất của mô hình AI trên dữ liệu chưa từng thấy trước đây.

- Cải thiện mô hình AI: Cải thiện mô hình AI bằng cách điều chỉnh các thông số hoặc thu thập thêm dữ liệu.

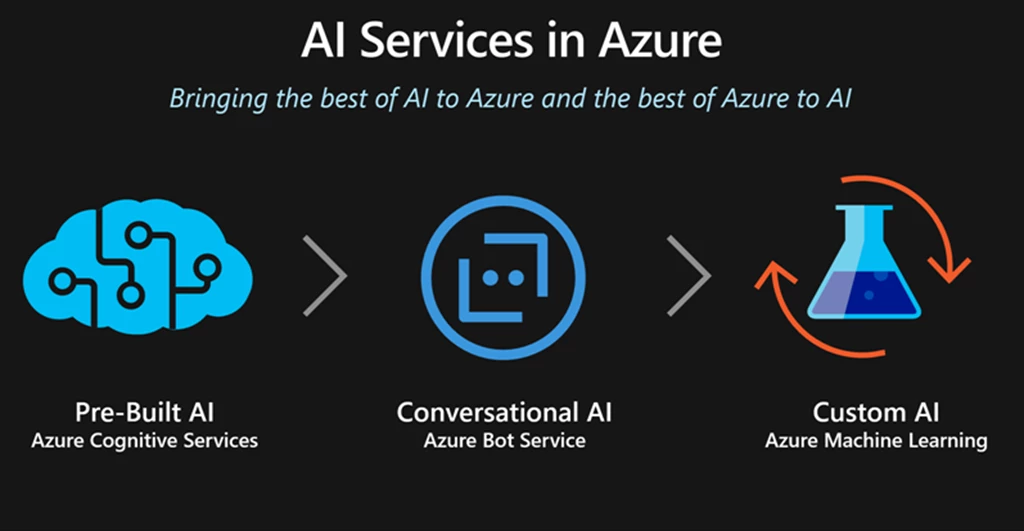

Hiện nay có rất nhiều nền tảng hỗ trợ training AI, bao gồm:

- Nền tảng đám mây: Google Cloud AI, Amazon Web Services (AWS) AI, Microsoft Azure AI

- Nền tảng mã nguồn mở: TensorFlow, PyTorch, MXNet

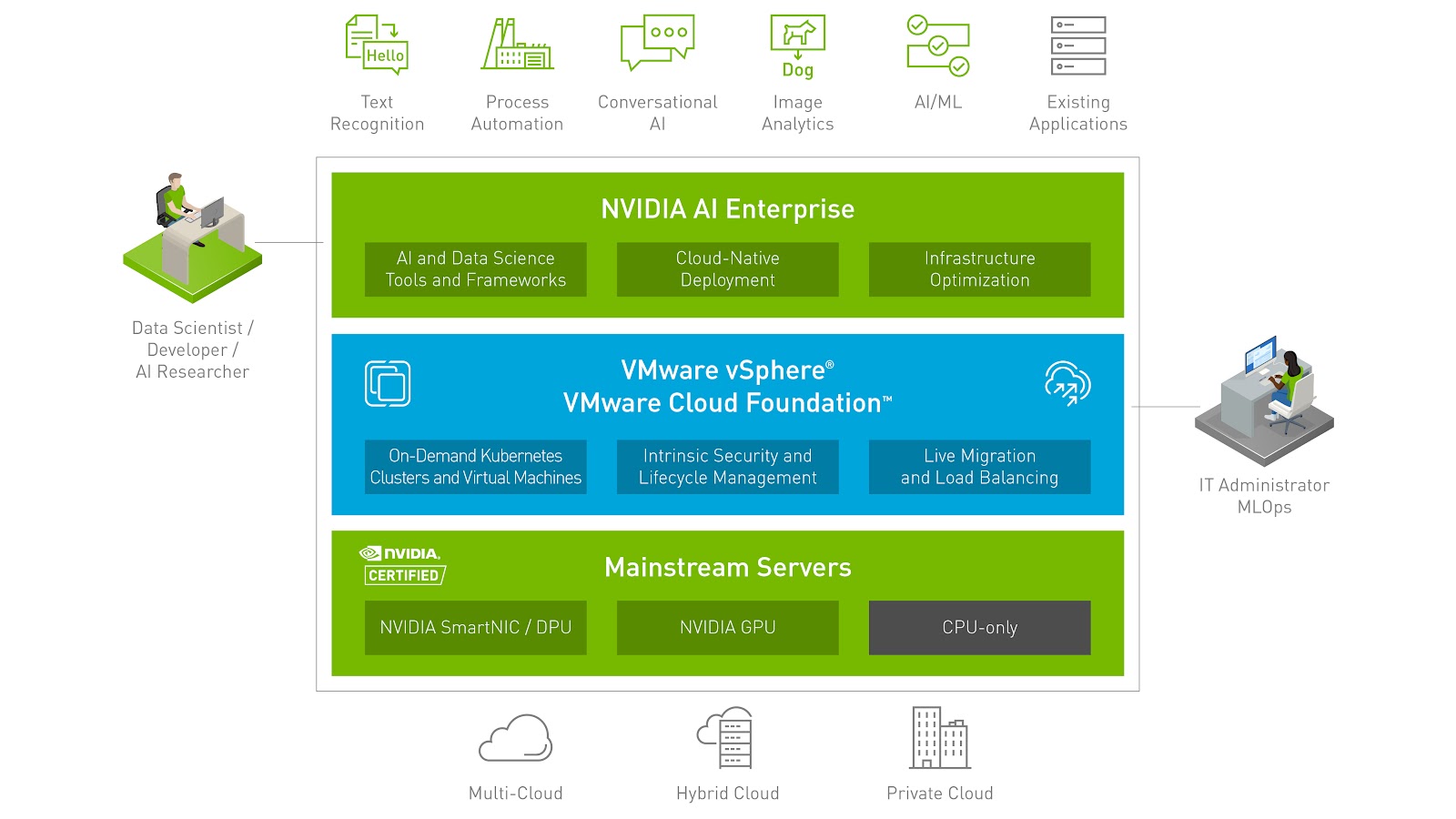

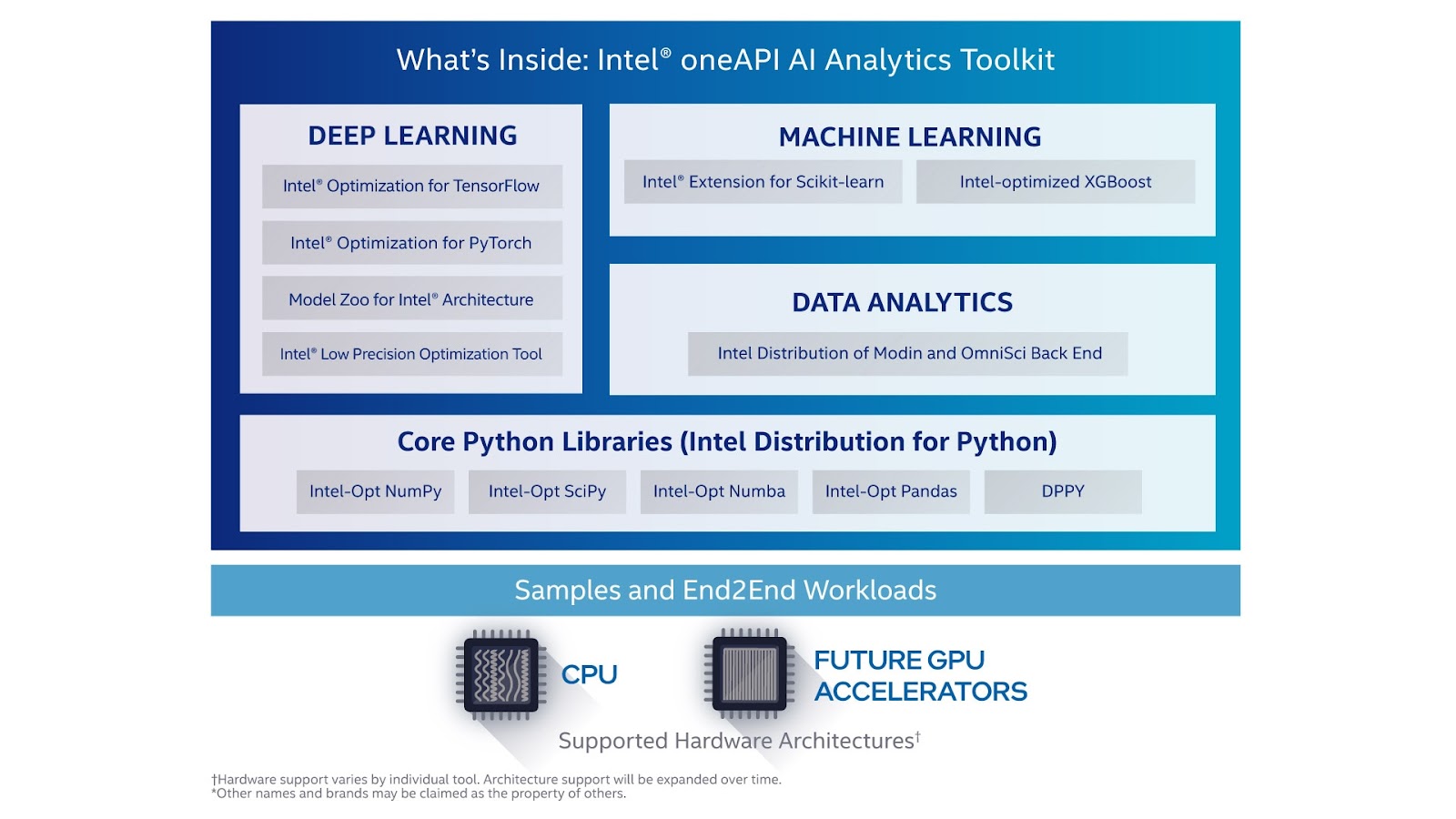

- Nền tảng chuyên dụng: NVIDIA AI Enterprise, Intel AI Toolkit

Lựa chọn nền tảng training AI phù hợp phụ thuộc vào nhiều yếu tố, bao gồm:

- Mục tiêu training: Mục tiêu training là gì?

- Loại dữ liệu: Loại dữ liệu nào được sử dụng để training?

- Kỹ năng: Kỹ năng lập trình và kiến thức về AI của người dùng là gì?

- Ngân sách: Ngân sách cho việc training AI là bao nhiêu?

Dưới đây là một số ví dụ về nền tảng training AI phổ biến:

- Google Cloud AI: Google Cloud AI là một nền tảng đám mây cung cấp nhiều dịch vụ AI, bao gồm dịch vụ training AI, dịch vụ nhận diện giọng nói, dịch vụ dịch thuật và dịch vụ phân tích ảnh. Google Cloud AI phù hợp cho các doanh nghiệp có nhu cầu training AI quy mô lớn.

- Amazon Web Services (AWS) AI: AWS AI là một nền tảng đám mây cung cấp nhiều dịch vụ AI, bao gồm dịch vụ training AI, dịch vụ robot và dịch vụ blockchain. AWS AI phù hợp cho các doanh nghiệp có nhu cầu sử dụng nhiều dịch vụ AI khác nhau.

- Microsoft Azure AI: Microsoft Azure AI là một nền tảng đám mây cung cấp nhiều dịch vụ AI, bao gồm dịch vụ training AI, dịch vụ nhận diện khuôn mặt và dịch vụ chatbot. Microsoft Azure AI phù hợp cho các doanh nghiệp sử dụng các sản phẩm Microsoft khác.

- TensorFlow: TensorFlow là một thư viện mã nguồn mở được sử dụng để training AI. TensorFlow được sử dụng phổ biến bởi các nhà nghiên cứu và nhà phát triển AI.

- PyTorch: PyTorch là một thư viện mã nguồn mở khác được sử dụng để training AI. PyTorch được sử dụng phổ biến bởi các nhà phát triển AI vì nó dễ sử dụng hơn TensorFlow.

- MXNet: MXNet là một thư viện mã nguồn mở được sử dụng để training AI. MXNet được sử dụng phổ biến bởi các nhà nghiên cứu AI vì nó có hiệu suất cao.

- NVIDIA AI Enterprise: NVIDIA AI Enterprise là một nền tảng chuyên dụng được sử dụng để training AI trên card đồ họa NVIDIA. NVIDIA AI Enterprise phù hợp cho các doanh nghiệp có nhu cầu training AI hiệu suất cao.

- Intel AI Toolkit: Intel AI Toolkit là một nền tảng chuyên dụng được sử dụng để training AI trên chip Intel. Intel AI Toolkit phù hợp cho các doanh nghiệp sử dụng chip Intel để training AI.

Ngoài ra, còn có rất nhiều nền tảng training AI khác được cung cấp bởi các công ty khởi nghiệp và các tổ chức nghiên cứu. Việc lựa chọn nền tảng training AI phù hợp phụ thuộc vào nhu cầu cụ thể của mỗi người dùng, doanh nghiệp…

Các ứng dụng của Training AI:

Training AI có rất nhiều ứng dụng trong nhiều lĩnh vực khác nhau, bao gồm:

1. Chăm sóc sức khỏe:

- Chẩn đoán bệnh: Training AI có thể được sử dụng để phân tích hình ảnh y tế, chẳng hạn như ảnh X-quang, MRI và CT scan, để chẩn đoán các bệnh.

- Phát triển thuốc: Training AI có thể được sử dụng để xác định các hợp chất mới có thể có tác dụng điều trị bệnh.

- Cá nhân hóa y tế: Training AI có thể được sử dụng để tạo ra các kế hoạch điều trị cá nhân hóa cho từng bệnh nhân.

2. Tài chính:

- Phát hiện gian lận: Training AI có thể được sử dụng để phát hiện các giao dịch gian lận trong lĩnh vực tài chính.

- Quản lý rủi ro: Training AI có thể được sử dụng để đánh giá rủi ro cho các khoản đầu tư.

- Tư vấn tài chính: Training AI có thể được sử dụng để cung cấp tư vấn tài chính cho khách hàng.

3. Sản xuất:

- Dự đoán sự cố: Training AI có thể được sử dụng để dự đoán sự cố thiết bị trong các nhà máy sản xuất.

- Tối ưu hóa quy trình: Training AI có thể được sử dụng để tối ưu hóa quy trình sản xuất.

- Kiểm soát chất lượng: Training AI có thể được sử dụng để kiểm tra chất lượng sản phẩm.

4. Bán lẻ:

- Đề xuất sản phẩm: Training AI có thể được sử dụng để đề xuất sản phẩm cho khách hàng dựa trên lịch sử mua hàng của họ.

- Cá nhân hóa trải nghiệm mua sắm: Training AI có thể được sử dụng để cá nhân hóa trải nghiệm mua sắm cho từng khách hàng.

- Phân tích hành vi khách hàng: Training AI có thể được sử dụng để phân tích hành vi khách hàng và hiểu rõ hơn về nhu cầu của họ.

5. Giao thông vận tải:

- Xe tự lái: Training AI đóng vai trò quan trọng trong việc phát triển xe tự lái.

- Quản lý giao thông: Training AI có thể được sử dụng để quản lý giao thông và giảm tắc nghẽn.

- Logistics: Training AI có thể được sử dụng để tối ưu hóa các tuyến đường vận chuyển và giảm chi phí logistics.

6. Nông nghiệp:

- Dự đoán năng suất: Training AI có thể được sử dụng để dự đoán năng suất cây trồng.

- Phát hiện sâu bệnh: Training AI có thể được sử dụng để phát hiện sâu bệnh hại cây trồng.

- Quản lý nước: Training AI có thể được sử dụng để quản lý nước tưới cho cây trồng một cách hiệu quả.

7. Giáo dục:

- Cá nhân hóa việc học: Training AI có thể được sử dụng để cá nhân hóa việc học cho từng học sinh.

- Đánh giá học tập: Training AI có thể được sử dụng để đánh giá học tập của học sinh một cách tự động.

- Cung cấp hỗ trợ cho học sinh: Training AI có thể được sử dụng để cung cấp hỗ trợ cho học sinh gặp khó khăn trong việc học tập.

8. Giải trí:

- Đề xuất phim: Training AI có thể được sử dụng để đề xuất phim cho người xem dựa trên sở thích của họ.

- Tạo nhạc: Training AI có thể được sử dụng để tạo nhạc.

- Viết truyện: Training AI có thể được sử dụng để viết truyện.

- Đây chỉ là một số ví dụ về các ứng dụng của Training AI. Training AI là một công nghệ mạnh mẽ có tiềm năng cách mạng hóa nhiều ngành công nghiệp và lĩnh vực khác nhau.

Chọn máy chủ phù hợp để Huấn Luyện AI

Để triển khai và tối ưu hóa hoạt động, hiệu suất cho hệ thống Training AI, các doanh nghiệp cần trang bị các GPU Server với những NVIDIA GPU chuyên dụng cho khả năng đào tạo Training AI. Những Máy chủ GPU được thiết kế để thực thi khối lượng công việc suy luận có thể được triển khai ở biên hoặc trong trung tâm dữ liệu. Mỗi vị trí máy chủ có bộ yêu cầu tuân thủ và môi trường riêng.

Hiểu được cách hoạt động của huấn luyện AI, sau đây là các nhu cầu tính toán cụ thể để thực hiện tác vụ này nhanh nhất và hiệu quả nhất.

GPU

Trực tâm của Học sâu là GPU (bộ xử lý đồ họa). Quá trình tính toán các giá trị cho mỗi lớp của mạng lưới là một tập hợp khổng lồ các phép nhân ma trận. Dữ liệu cho mỗi lớp thường có thể được xử lý song song, với các bước phối hợp giữa các lớp.

GPU được thiết kế để thực hiện phép nhân ma trận theo cách song song rất lớn và đã được chứng minh là lý tưởng để đạt được tốc độ vượt trội cho Học sâu.

Đối với việc huấn luyện, kích thước của mô hình là yếu tố then chốt, do đó các GPU có bộ nhớ lớn và nhanh hơn, chẳng hạn như NVIDIA A100 Tensor Core GPU, có thể xử lý các lô dữ liệu huấn luyện nhanh hơn.

CPU

Các tính toán chuẩn bị và xử lý trước dữ liệu cần thiết cho huấn luyện Học sâu thường được thực hiện trên CPU, mặc dù các đổi mới gần đây cho phép thực hiện nhiều hơn trên GPU.

Điều quan trọng là phải sử dụng CPU hiệu năng cao để duy trì các hoạt động này ở tốc độ đủ nhanh để GPU không bị thiếu dữ liệu xử lý. CPU nên là loại dành cho doanh nghiệp, chẳng hạn như từ dòng bộ xử lý Intel Xeon Scalable hoặc AMD EPYC, và tỷ lệ lõi CPU trên GPU phải đủ lớn để duy trì hoạt động của chuỗi xử lý.

Bộ nhớ Hệ thống

Đặc biệt đối với các mô hình lớn nhất hiện nay, huấn luyện Học sâu chỉ hoạt động khi có một lượng dữ liệu đầu vào cực kỳ lớn để huấn luyện. Dữ liệu này được truy xuất từ bộ nhớ lưu trữ thành các lô và sau đó được CPU xử lý trong bộ nhớ hệ thống trước khi được đưa vào GPU.

Để duy trì quá trình này ở tốc độ ổn định, bộ nhớ hệ thống phải đủ lớn để tốc độ xử lý của CPU có thể khớp với tốc độ xử lý dữ liệu của GPU. Điều này có thể được thể hiện bằng tỷ lệ giữa bộ nhớ hệ thống với bộ nhớ GPU (trên tất cả các GPU trong máy chủ).

Các mô hình và thuật toán khác nhau yêu cầu tỷ lệ khác nhau, nhưng tốt hơn nên có tỷ lệ cao hơn để GPU không bao giờ phải chờ dữ liệu.

Card mạng Network

Với sự phát triển của các mô hình Học sâu ngày càng lớn, các kỹ thuật huấn luyện sử dụng nhiều GPU hoạt động cùng nhau đã ra đời. Khi có nhiều hơn một GPU trong máy chủ, chúng có thể giao tiếp với nhau qua bus PCIe. Tuy nhiên, để đạt hiệu suất cao nhất, các công nghệ chuyên dụng hơn như NVLink và NVSwitch có thể được sử dụng.

Huấn luyện đa GPU cũng có thể mở rộng để hoạt động trên nhiều máy chủ. Trong trường hợp này, card mạng trở thành thành phần then chốt trong thiết kế của máy chủ. Để giảm thiểu tắc nghẽn do truyền dữ liệu khi thực hiện huấn luyện Học sâu đa nút (multi-node), cần sử dụng các card mạng Gigabit Ethernet băng thông cao hoặc InfiniBand.

Các nền tảng Học sâu sử dụng các thư viện như NCCL để phối hợp hoạt động giữa các GPU một cách tối ưu và hiệu quả. Các công nghệ như GPUDirect RDMA cho phép truyền dữ liệu từ mạng trực tiếp đến GPU mà không cần qua CPU, do đó loại bỏ CPU như một nguồn gây trễ.

Lý tưởng nhất, nên có một card mạng cho mỗi một hoặc hai GPU trong hệ thống để giảm thiểu xung đột khi cần truyền dữ liệu.

Lưu trữ

Dữ liệu huấn luyện Học sâu thường nằm trên các mảng lưu trữ ngoài. Ổ đĩa NVMe trên máy chủ có thể đẩy nhanh đáng kể quá trình huấn luyện bằng cách cung cấp phương tiện để lưu trữ tạm dữ liệu.

Các mẫu I/O của Học sâu thường bao gồm nhiều lần lặp lại của việc đọc dữ liệu huấn luyện. Lượt đầu tiên, hoặc epoch, của quá trình huấn luyện sẽ đọc dữ liệu được sử dụng để bắt đầu huấn luyện mô hình. Nếu có bộ nhớ cache cục bộ đủ dung lượng trên nút, các lượt đọc dữ liệu tiếp theo có thể tránh đọc lại dữ liệu từ bộ nhớ lưu trữ từ xa.

Để tránh xung đột khi truy xuất dữ liệu từ bộ nhớ lưu trữ từ xa, nên có một ổ đĩa NVMe cho mỗi CPU.

Giải pháp Phần Mềm

Cùng với phần cứng phù hợp, các doanh nghiệp cũng cần lựa chọn giải pháp phần mềm được hỗ trợ cho khối lượng công việc AI. NVIDIA AI Enterprise là một bộ phần mềm phân tích dữ liệu và AI toàn diện, chạy trên nền tảng đám mây. Nó được tối ưu hóa để mọi tổ chức có thể thành công trong lĩnh vực AI, được chứng nhận để triển khai ở bất cứ đâu, từ trung tâm dữ liệu doanh nghiệp đến đám mây công cộng. AI Enterprise bao gồm dịch vụ hỗ trợ toàn cầu để đảm bảo các dự án AI luôn diễn ra suôn sẻ.

Bằng cách chạy NVIDIA AI Enterprise trên các máy chủ được cấu hình tối ưu, bạn có thể yên tâm rằng mình đang tận dụng tối đa khoản đầu tư vào phần cứng và phần mềm.

Hiện nay Nhất Tiến Chung đang cung cấp những loại máy chủ GPU đã được xác thực bởi NVIDIA cho việc triển khai hệ thống Training AI với nhiều cấp độ để phù hợp và tối ưu hóa cho nhiều mô hình Training AI mà các doanh nghiệp cần trang bị:

Máy chủ Supermicro SYS-120GQ-TNRT

|

|

| Form factor | 1U rackmount |

| Processor Support | • Dual sockets P+ (LGA-4189) 3rd Gen Intel® Xeon® Scalable processors • Up to 40C/80T; Up to 60MB Cache per CPU |

| Memory Slots & Capacity | 16 DIMMs up to 6TB 3DS ECC DDR4-3200: LRDIMM/RDIMM/Intel® Intel® DCPMM |

| GPU Support | • Up to 4 double-width GPU(s) • NVIDIA PCIe: L40s • NVIDIA PCIe: A30 • NVIDIA PCIe: A100 • NVIDIA PCIe: H100 |

| Storage | Total 4 bay(s) 2 front hot-swap 2.5″ NVMe drive bay(s) 2 internal fixed 3.5″ SATA drive bay(s) |

| Network Interface | 2 RJ45 10GbE, 1 dedicated IPMI LAN |

| Power Supply | 2000W Redundant Titanium Level power supplies |

| Frameworks Supported | • TensorFlow • PyTorch • TensorRT • MXNet • CUDA & cuDNN • RAPIDS • Jax • Hugging Face Transformers • XGBoost • NVIDIA NGC |

Máy chủ Supermicro SYS-220GP-TNR

|

|

| Form factor | 2U rackmount |

| Processor Support | • Dual sockets P+ (LGA-4189) 3rd Gen Intel® Xeon® Scalable processors • Up to 40C/80T; Up to 60MB Cache per CPU |

| Memory Slots & Capacity | 16 DIMMs up to 6TB 3DS ECC DDR4-3200: LRDIMM/RDIMM/Intel® Intel® DCPMM |

| GPU Support | • Up to 6 double-width GPU(s) • NVIDIA PCIe: L40s • NVIDIA PCIe: A30 • NVIDIA PCIe: A100 • NVIDIA PCIe: H100 |

| Storage | Total 10 bay(s) 6 front hot-swap 2.5″ SAS*/SATA drive bay(s) 4 front hot-swap 2.5″ NVMe drive bay(s) |

| Network Interface | Flexible networking options, 1 dedicated IPMI LAN |

| Power Supply | 2600W Redundant Titanium Level power supplies |

| Frameworks Supported | • TensorFlow • PyTorch • TensorRT • MXNet • CUDA & cuDNN • RAPIDS • Jax • Hugging Face Transformers • XGBoost • NVIDIA NGC |

Máy chủ Supermicro SYS-420GP-TNR

|

|

| Form factor | 4U rackmount |

| Processor Support | • Dual sockets P+ (LGA-4189) 3rd Gen Intel® Xeon® Scalable processors • Up to 40C/80T; Up to 60MB Cache per CPU |

| Memory Slots & Capacity | 32 DIMMs up to 8TB 3DS ECC DDR4-3200: LRDIMM/RDIMM/Intel® Intel® DCPMM |

| GPU Support | • Up to 10 double-width GPU(s) • NVIDIA PCIe: L40s • NVIDIA PCIe: A30 • NVIDIA PCIe: A100 • NVIDIA PCIe: H100 |

| Storage | Total 24 bay(s) 8 front hot-swap 2.5″ NVMe drive bay(s) 16 front hot-swap 2.5″ SAS/SATA drive bay(s) 24 front hot-swap 2.5″ NVMe*/SAS/SATA drive bay(s) |

| Network Interface | 2 RJ45 1GbE with Intel® I350, Flexible networking options, 1 dedicated IPMI LAN |

| Power Supply | 4x 2000W Redundant Titanium Level power supplies |

| Frameworks Supported | • TensorFlow • PyTorch • TensorRT • MXNet • CUDA & cuDNN • RAPIDS • Jax • Hugging Face Transformers • XGBoost • NVIDIA NGC |

Máy chủ HPE DL380 Gen 10+

|

|

| Form factor | 2U rackmount |

| Processor Support | Up to two 3rd Generation Intel Xeon Scalable processors, with up to 40 cores per processor |

| Memory Slots & Capacity | • 32 DDR4 DIMM slots, supports 3200 MT/s HPE DDR4 Smart Memory up to 8.0 TB |

| GPU Support | • Up to 3 double-width GPU(s) • NVIDIA PCIe: L40s • NVIDIA PCIe: A30 • NVIDIA PCIe: A100 • NVIDIA PCIe: H100 |

| Storage | 8 SFF with options for aditional 2 SFF drive bays: 12G x1 SAS/SATA, 24G x4 Tri-Mode or 16G x4 NVMe 8 LFF |

| Network Interface | Broadcom BCM57412 Ethernet 10Gb 2-port SFP+ OCP3 Adapter |

| Power Supply | • HPE 500W • HPE 800W • HPE 1600W • HPE 1800W-2200W |

| Frameworks Supported | • TensorFlow • PyTorch • TensorRT • MXNet • CUDA & cuDNN • RAPIDS • Jax • Hugging Face Transformers • XGBoost • NVIDIA NGC |

Máy chủ Dell R750XA

|

|

| Form factor | 2U rackmount |

| Processor Support | Up to two 3rd Generation Intel Xeon Scalable processors, with up to 40 cores per processor |

| Memory Slots & Capacity | • 32 DDR4 DIMM slots, supports RDIMM 2 TB max or LRDIMM 8 TB max, speeds up to 3200 MT/s • Up to 16 Intel Persistent Memory 200 series (BPS) slots, 12 TB max • Supports registered ECC DDR4 DIMMs only |

| GPU Support | • Up to 4 double-width GPU(s) • NVIDIA PCIe: L40s • NVIDIA PCIe: A30 • NVIDIA PCIe: A100 • NVIDIA PCIe: H100 |

| Storage | Front bays: • Up to 8 x 2.5-inch SAS/SATA/NVMe (HDD/SSD) max 122.88 TB • Up to 6 x 2.5-inch NVMe (SSD) direct-attach max 92.1 TB |

| Network Interface | 2 x 1 GbE LOM, 1 x OCP 3.0 |

| Power Supply | • 1400 W Platinum AC/240 mixed mode • 1800 W Titanium HLAC/240 mixed mode • 2400 W Platinum AC/240 mixed mode • 2800 W Titanium HLAC/240 mixed mode |

| Frameworks Supported | • TensorFlow • PyTorch • TensorRT • MXNet • CUDA & cuDNN • RAPIDS • Jax • Hugging Face Transformers • XGBoost • NVIDIA NGC |

Máy chủ Supermicro SYS-741GE-TNRT

|

|

| Form factor | Tower / Rackmountable |

| Processor Support | • Dual sockets E (LGA-4677) 5th and 4th Gen Intel® Xeon® Scalable processors • Up to 64C/128T; Up to 320MB Cache per CPU |

| Memory Slots & Capacity | 16 DIMMs up to 4TB 3DS ECC DDR5-5600: RDIMM |

| GPU Support | •• Up to 4 double-width GPU(s) • NVIDIA PCIe: L40s • NVIDIA PCIe: A30 • NVIDIA PCIe: A100 • NVIDIA PCIe: H100 |

| Storage | Total 8 bay(s) 8 front hot-swap 3.5″ NVMe/SAS/SATA drive bay(s) |

| Network Interface | 2 RJ45 10GbE with Intel® X550-AT2, 1 dedicated IPMI LAN |

| Power Supply | 2000W Redundant Titanium Level power supplies |

| Frameworks Supported | • TensorFlow • PyTorch • TensorRT • MXNet • CUDA & cuDNN • RAPIDS • Jax • Hugging Face Transformers • XGBoost • NVIDIA NGC |

Máy chủ Supermicro SYS-221GE-NR

|

|

| Form factor | 2U Rackmount |

| Processor Support | • Dual sockets E (LGA-4677) 5th and 4th Gen Intel® Xeon® Scalable processors • Up to 56C/112T; Up to 112.5MB Cache per CPU |

| Memory Slots & Capacity | 32 DIMMs up to 8TB 3DS ECC DDR5-5600: RDIMM |

| GPU Support | •• Up to 4 double-width GPU(s) • NVIDIA PCIe: L40s • NVIDIA PCIe: A30 • NVIDIA PCIe: A100 • NVIDIA PCIe: H100 |

| Storage | Total 8 bay(s) 8 front hot-swap E1.S NVMe drive bay(s) |

| Network Interface | 1 RJ45 1GbE, 1 dedicated IPMI LAN |

| Power Supply | 2000W Redundant Titanium Level power supplies |

| Frameworks Supported | • TensorFlow • PyTorch • TensorRT • MXNet • CUDA & cuDNN • RAPIDS • Jax • Hugging Face Transformers • XGBoost • NVIDIA NGC |

Máy chủ Supermicro SYS-421GE-TNRT

|

|

| Form factor | 4U Rackmount |

| Processor Support | • Dual sockets E (LGA-4677) 5th and 4th Gen Intel® Xeon® Scalable processors • Up to 64C/128T; Up to 320MB Cache per CPU |

| Memory Slots & Capacity | 32 DIMMs up to 8TB 3DS ECC DDR5-5600: RDIMM |

| GPU Support | •• Up to 10 double-width GPU(s) • NVIDIA PCIe: L40s • NVIDIA PCIe: A30 • NVIDIA PCIe: A100 • NVIDIA PCIe: H100 |

| Storage | Total 16 bay(s) 8 front hot-swap 2.5″ NVMe drive bay(s) 8 front hot-swap 2.5″ SATA drive bay(s) Option A: Total 24 bay(s) 8 front hot-swap 2.5″ NVMe drive bay(s) 8 front hot-swap 2.5″ NVMe* drive bay(s) 8 front hot-swap 2.5″ SATA drive bay(s) |

| Network Interface | 2 RJ45 10GbE with Intel® X710-AT2, 1 dedicated IPMI LAN |

| Power Supply | 4x 2700W Redundant Titanium Level power supplies |

| Frameworks Supported | • TensorFlow • PyTorch • TensorRT • MXNet • CUDA & cuDNN • RAPIDS • Jax • Hugging Face Transformers • XGBoost • NVIDIA NGC |

Máy chủ Supermicro SYS-521GE-TNRT

|

|

| Form factor | 5U Rackmount |

| Processor Support | • Dual sockets E (LGA-4677) 5th and 4th Gen Intel® Xeon® Scalable processors • Up to 64C/128T; Up to 320MB Cache per CPU |

| Memory Slots & Capacity | 32 DIMMs up to 8TB 3DS ECC DDR5-5600: RDIMM |

| GPU Support | •• Up to 10 double-width GPU(s) • NVIDIA PCIe: L40s • NVIDIA PCIe: A30 • NVIDIA PCIe: A100 • NVIDIA PCIe: H100 |

| Storage | Total 16 bay(s) 8 front hot-swap 2.5″ NVMe drive bay(s) 8 front hot-swap 2.5″ SATA drive bay(s) Option A: Total 24 bay(s) 8 front hot-swap 2.5″ NVMe drive bay(s) 8 front hot-swap 2.5″ NVMe* drive bay(s) 8 front hot-swap 2.5″ SATA drive bay(s) |

| Network Interface | 2 RJ45 10GbE with Intel® X710-AT2, 1 dedicated IPMI LAN |

| Power Supply | 4x 2700W Redundant Titanium Level power supplies |

| Frameworks Supported | • TensorFlow • PyTorch • TensorRT • MXNet • CUDA & cuDNN • RAPIDS • Jax • Hugging Face Transformers • XGBoost • NVIDIA NGC |

Máy chủ HPE DL380 Gen 11

|

|

| Form factor | 2U rackmount |

| Processor Support | • Dual sockets E (LGA-4677) 5th and 4th Gen Intel® Xeon® Scalable processors, up to 64 cores |

| Memory Slots & Capacity | • 32 DDR4 DIMM slots, supports 5600 MT/s HPE DDR5 Smart Memory, up to 8.0 TB |

| GPU Support | • Up to 3 double-width GPU(s) • NVIDIA PCIe: L40s • NVIDIA PCIe: A30 • NVIDIA PCIe: A100 • NVIDIA PCIe: H100 |

| Storage | 8 SFF with options for aditional 2 SFF drive bays: 12G x1 SAS/SATA, 24G x4 Tri-Mode or 16G x4 NVMe 8 LFF |

| Network Interface | Broadcom BCM57412 Ethernet 10Gb 2-port SFP+ OCP3 Adapter |

| Power Supply | • HPE 500W • HPE 800W • HPE 1600W • HPE 1800W-2200W |

| Frameworks Supported | • TensorFlow • PyTorch • TensorRT • MXNet • CUDA & cuDNN • RAPIDS • Jax • Hugging Face Transformers • XGBoost • NVIDIA NGC |

Máy chủ Dell R760XA

|

|

| Form factor | 2U rackmount |

| Processor Support | Up to two 4th Generation Intel Xeon Scalable processors, with up to 56 cores and optional Intel® QuickAssist Technology |

| Memory Slots & Capacity | • 32 DDR5 DIMM slots, supports RDIMM 8 TB max, speeds up to 4800 MT/s • Supports registered ECC DDR5 DIMMs only |

| GPU Support | • Up to 4 double-width GPU(s) • NVIDIA PCIe: L40s • NVIDIA PCIe: A30 • NVIDIA PCIe: A100 • NVIDIA PCIe: H100 |

| Storage | Front bays: • Up to 8 x 2.5-inch SAS/SATA/NVMe (HDD/SSD) max 122.88 TB • Up to 6 x 2.5-inch NVMe (SSD) direct-attach max 92.1 TB |

| Network Interface | 2 x 1 GbE LOM, 1 x OCP 3.0 |

| Power Supply | • 1400 W Platinum AC/240 mixed mode • 1800 W Titanium HLAC/240 mixed mode • 2400 W Platinum AC/240 mixed mode • 2800 W Titanium HLAC/240 mixed mode |

| Frameworks Supported | • TensorFlow • PyTorch • TensorRT • MXNet • CUDA & cuDNN • RAPIDS • Jax • Hugging Face Transformers • XGBoost • NVIDIA NGC |

Máy chủ Supermicro AS-4125GS-TNRT2

|

|

| Form factor | 4U rackmount |

| Processor Support | • Dual 4th Generation AMD EPYC™ 9004 Series Processors • Up to 128C/256T |

| Memory Slots & Capacity | 24 DIMMs Up to 6TB 4800MT/s ECC DDR5 RDIMM |

| GPU Support | • Up to 10 double-width GPU(s) • NVIDIA PCIe: L40s • NVIDIA PCIe: A30 • NVIDIA PCIe: A100 • NVIDIA PCIe: H100 |

| Storage | Total 10 bay(s) 8 front hot-swap 2.5″ NVMe drive bay(s) 2 front hot-swap 2.5″ SATA drive bay(s) |

| Network Interface | 2 RJ45 10GbE, 1 dedicated IPMI LAN |

| Power Supply | 4x 2000W Redundant Titanium Level power supplies |

| Frameworks Supported | • TensorFlow • PyTorch • TensorRT • MXNet • CUDA & cuDNN • RAPIDS • Jax • Hugging Face Transformers • XGBoost • NVIDIA NGC |

Với những cấu hình máy chủ GPU dành cho Huấn luyện Training AI trên, Nhất Tiến Chung có thể hỗ trợ các doanh nghiệp xây dựng những hệ thống Training AI tại trung tâm dữ liệu, tại các văn phòng chi nhánh hay tại biên để tối ưu hóa hiệu quả suy luận AI cho từng doanh nghiệp với những lựa chọn máy chủ linh hoạt và tối ưu chi phí.

Để biết thêm thông tin chi tiết, vui lòng liên hệ đội ngũ Nhất Tiến Chung để được tư vấn cụ thể hơn về hệ thống training đào tạo và huấn luyện AI cho doanh nghiệp của bạn.

Đội ngũ của Nhất Tiến Chung sẵn sàng tư vấn giải pháp, chạy BOM, báo giá mọi nhu cầu CNTT của Quý doanh nghiệp. Vui lòng liên hệ:

Hotline: 1900 558879 #2

Email: presales@nhattienchung.vn

Bài viết liên quan

- PowerScale: Nền tảng kiến trúc cho các tác vụ Generative AI

- NVIDIA Hopper tiếp tục dẫn đầu hiệu suất Generative AI trong MLPerf

- NVIDIA hỗ trợ hành trình hướng tới Generative AI thuận lợi hơn cho các doanh nghiệp

- NVIDIA NIM: Vi dịch vụ suy luận tối ưu hóa cho triển khai mô hình AI quy mô lớn

- Đơn giản hóa phát triển Generative AI tuỳ chỉnh với NVIDIA NeMo Microservices