Kiến thức cơ bản về bộ nhớ GPU

Khi nói đến bộ xử lý đồ họa (GPU), đặc biệt là đối với các tải xử lý nhạy cảm về độ trễ, chủng loại bộ nhớ có tác động đáng kể đến hiệu suất của hệ thống. Bộ nhớ GPU thường được gọi là VRAM, Video Random Access Memory. Bộ nhớ GPU tương tự như bộ nhớ CPU và RAM truyền thống, nơi dữ liệu được lưu trữ cục bộ để truy cập và thực thi nhanh chóng cho các tác vụ trong tương lai có thể tận dụng cùng một dữ liệu. Dung lượng VRAM lớn hơn có nghĩa là có thể lưu trữ nhiều dữ liệu hơn trên bộ nhớ GPU, cho phép truy cập bộ nhớ ngắn hạn nhanh chóng và ít cần phải truy cập liên tục vào bộ nhớ vật lý dài hạn từ ổ cứng HDD hoặc SSD của máy tính.

Có hai loại bộ nhớ nổi bật dành cho GPU: GDDR (có trong GPU dòng consumer và cả chuyên nghiệp) và HBM hoặc bộ nhớ băng thông cao (chỉ có trong GPU trung tâm dữ liệu và phần cứng chuyên dụng). Để giúp bạn chọn GPU phù hợp cho hệ thống của mình, bài viết này sẽ định nghĩa hai loại bộ nhớ GDDR và HBM cho GPU và đưa ra giải pháp phù hợp cho hệ thống của bạn.

Bộ nhớ GDDR là gì?

GDDR là viết tắt của Graphics Double Data Rate và là loại bộ nhớ được thiết kế đặc biệt để sử dụng trong card đồ họa. Bộ nhớ GDDR tương tự như bộ nhớ DDR, được sử dụng trong hầu hết các máy tính, nhưng nó đã được tối ưu hóa để sử dụng trong card đồ họa. Bộ nhớ GDDR thường nhanh hơn bộ nhớ DDR và có băng thông cao hơn, điều đó có nghĩa là nó có thể truyền nhiều dữ liệu hơn cùng một lúc.

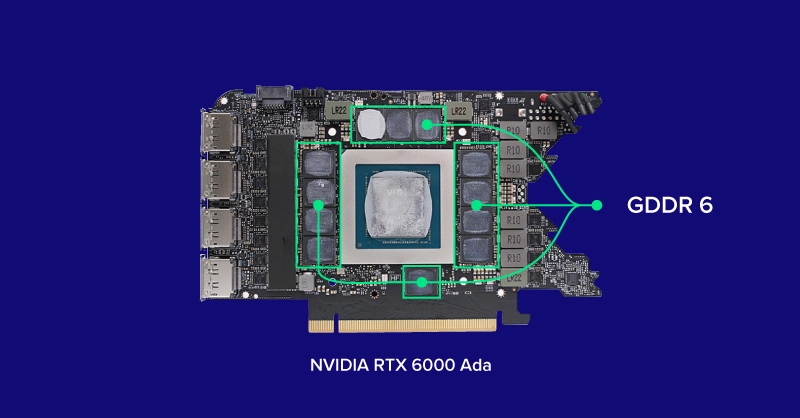

GDDR6 là tiêu chuẩn bộ nhớ mới nhất dành cho GPU với tốc độ dữ liệu/1 pin cao nhất là 16Gb/s và độ rộng bus bộ nhớ tối đa là 384 bit. Được tìm thấy trong phần lớn các GPU bao gồm NVIDIA RTX 6000 Ada và AMD Radeon PRO W7900, GDDR6 là chuẩn bộ nhớ cho các GPU hiện đại vào năm 2024. GPU phổ thông nhanh nhất được trang bị GDDR6 là RTX 6000 Ada với tốc độ băng thông bộ nhớ cao nhất là 960GB/s, khả năng xử lý gần 1 TB dữ liệu mỗi giây.

Bộ nhớ GDDR là các chip riêng lẻ được hàn vào PCB xung quanh khối GPU (GPU die). Một số phiên bản GPU có thể có dung lượng bộ nhớ khác nhau bằng cách hàn thêm chip VRAM hoặc sử dụng chip có dung lượng lớn hơn. Bộ nhớ GDDR6X 24GB của NVIDIA RTX 4090 và GDDR6 ECC 48GB của RTX 6000 Ada đều sử dụng khối GPU AD102 nhưng có các ứng dụng khác nhau dựa trên cấu hình bộ nhớ của chúng. RTX 6000 Ada tăng gấp đôi bộ nhớ bằng cách bổ sung thêm nhiều chip VRAM ở mặt sau PCB để có nhiều tải xử lý phụ thuộc vào kích thước bộ nhớ hơn như CAD, Thiết kế 3D và đào tạo AI, trong khi RTX 4090 sử dụng chip GDDR6X nhanh hơn cho tải xử lý phụ thuộc vào tốc độ bộ nhớ và gaming.

Ứng dụng của bộ nhớ GDDR

GPU được trang bị bộ nhớ GDDR thường dễ tiếp cận hơn và rẻ hơn vì chúng là loại bộ nhớ GPU phổ biến. Do độ phức tạp của GDDR được hàn trực tiếp trên PCB thay vì khối GPU, nên các khối GPU khác nhau có thể có dung lượng VRAM khác nhau. Hãy xem qua mẫu GPU NVIDIA RTX 4060 Ti, có biến thể 8GB và 16GB sử dụng cùng một con chip.

Đối với các tải xử lý, bộ nhớ GDDR phù hợp với 90% ứng dụng mà hầu hết các ứng dụng phổ thông không thể phát huy tối đa hoặc sử dụng toàn bộ băng thông bộ nhớ. Mặc dù điều này có thể hạn chế các GPU cấp thấp hơn như RTX 4060 Ti, nhưng các mẫu cao cấp nhất như RTX 6000 Ada không nên bị ràng buộc bởi băng thông bộ nhớ trong hầu hết các ứng dụng.

Xin nhắc lại, phần lớn các ứng dụng được tối ưu hóa để sử dụng loại bộ nhớ phổ biến này và sẽ không gặp vấn đề gì với GPU được trang bị GDDR. Tốc độ băng thông ở RTX 6000 Ada, NVIDIA L40S, RTX 4090 trở lên có thể mang lại hiệu quả kỳ diệu và việc tăng băng thông chỉ có thể dẫn đến những cải thiện nhỏ về tốc độ. Nhưng khi cần tận dụng những cải tiến nhỏ về tốc độ đó thì đó chính là lúc bộ nhớ băng thông cao tỏa sáng.

HBM là gì?

HBM là viết tắt của High Bandwidth Memory, bộ nhớ băng thông cao. HBM được thiết kế để cung cấp độ rộng bus bộ nhớ lớn hơn bộ nhớ GDDR, dẫn đến các gói dữ liệu lớn hơn được truyền cùng lúc. Một chip bộ nhớ HBM đơn lẻ chậm hơn một chip GDDR6 nhưng độ rộng bus rộng hơn, dung lượng nhỏ hơn và khả năng xếp chồng/khả năng mở rộng của chip HBM khiến nó mạnh mẽ hơn, hiệu quả hơn và nhanh hơn bộ nhớ GDDR. Tiêu chuẩn HBM được áp dụng mới nhất là HBM3, có trong GPU Tensor Core NVIDIA H100 80GB SXM5 với bus 5120-bit và băng thông bộ nhớ lên tới 3,35TB/s.

HBM nằm bên trong khối GPU và được xếp chồng lên nhau – ví dụ GPU NVIDIA A800 40GB Active có 5 stack hoạt động gồm 8 khối HBM DRAM (8‑Hi), mỗi stack có 2 channel 512‑bit trên mỗi khối với tổng chiều rộng là 5120 bit (5 active stack * 2 channel * 512 bit). Bởi vì HBM được tích hợp vào khối GPU nên sẽ có ít lỗi và module hơn. Đối với phiên bản khối GPU, HBM không thể cấu hình giống như cách GPU được trang bị GDDR, trong đó mỗi chip bộ nhớ được hàn vào PCB (nhưng nhà cung cấp có thể vô hiệu hóa HBM stack để đảm bảo yêu cầu về độ ổn định và nguồn điện).

Ứng dụng của HBM

GPU được trang bị HBM thường khó tiếp cận hơn, đặc thù hơn, đắt tiền hơn và chỉ có trong các bộ tăng tốc top đầu như H100, A800 40GB Active và các GPU trung tâm dữ liệu khác. Vì bộ nhớ được đặt trực tiếp trên khối GPU nên các GPU sẽ không có dung lượng khác nhau (nhưng có thể được vô hiệu hóa).

HBM thường chỉ được sử dụng trong HPC và các tải xử lý đặc biệt đòi hỏi nhiều băng thông nhất trong đó tốc độ truy cập dữ liệu cao là điều bắt buộc. Chúng có thể bao gồm các tải xử lý mô phỏng, đào tạo AI, phân tích, điện toán biên và suy luận, v.v. HBM có hiệu quả cao và cung cấp độ rộng bus lớn hơn đáng kể để song song hóa tốc độ trên mỗi pin. Nhưng hầu hết các ứng dụng hiệu năng cao sẽ không thể tối đa hóa hiệu suất.

Một lý do khác khiến hầu hết các GPU của trung tâm dữ liệu sử dụng HBM là khả năng kết nối giữa các node điện toán. Công nghệ NVLink của NVIDIA H100 yêu cầu tốc độ băng thông bộ nhớ GPU nhanh và đó là lý do tại sao HBM lại phổ biến trong hệ thống NVIDIA DGX. Dữ liệu được lưu trữ và giải quyết cần được truyền từ GPU này sang GPU khác một cách nhanh chóng và hiệu quả. Do đó, cần có một chuẩn bộ nhớ nhanh, độ trễ thấp, băng thông cao để giảm tình trạng tắc nghẽn trong việc truyền dữ liệu.

So sánh GDDR6 và HBM2

Hầu hết các ứng dụng sẽ không bao giờ cần dến HBM. GPU RTX Ada nhanh nhất được trang bị GDDR6 có thể tăng tốc hầu hết tải xử lý. NVIDIA RTX 6000 Ada là GPU hàng đầu có hiệu năng cao, hoàn hảo cho các tải xử lý đào tạo, kết xuất, phân tích, mô phỏng và sử dụng nhiều dữ liệu với quy mô vừa và nhỏ về AI với băng thông bộ nhớ cao 960GB/s. Đặt một máy chủ hoặc máy trạm có thiết lập nhiều GPU và công việc có thể được song song hóa và phân chia để có hiệu suất cao hơn nữa (nếu có thể áp dụng trong ứng dụng/tải xử lý).

Tuy nhiên, các GPU được trang bị HBM như NVIDIA A800 40GB Active và GPU NVIDIA H100 Tensor Core có thể tăng đáng kể năng suất (mặc dù với chi phí cao hơn) cho các hoạt động triển khai của doanh nghiệp nhằm tiết kiệm thời gian. Hiệu suất cao hơn và ít chờ đợi hơn có thể tạo ra những đột phá nhanh hơn. Các tải xử lý như mô phỏng cho CFD, biến dạng cơ học, đào tạo AI và phân tích thời gian thực, những thứ bắt buộc khả năng truy cập vào bộ nhớ, có thể sử dụng khả năng truy cập nhanh vào HBM của NVIDIA A800 40GB Active.

Thế Giới Máy Chủ dành phần lớn ưu tiên về hàng hóa cho GPU hiệu suất cao mà bạn có thể chọn khi cấu hình hệ thống. Dưới đây là danh sách các GPU NVIDIA hàng đầu mà bạn có thể đặt trong máy trạm và/hoặc máy chủ khi cấu hình hệ thống và so sánh tốc độ băng thông và độ rộng bus của chúng:

| GPU | Memory Type | Memory Bus Width | Memory Bandwidth |

|---|---|---|---|

| RTX 6000 Ada | GDDR6 | 384-bits | 960 GB/s |

| GeForce RTX 4090 | GDDR6X | 384-bits | 1008 GB/s (1 TB/s) |

| NVIDIA L40S | GDDR6 | 384-bits | 864 GB/s |

| NVIDIA A800 40GB Active | HBM2 | 5120-bits | 1555 GB/s (1.5 TB/s) |

| NVIDIA H100 80GB PCIe | HBM2e | 5120-bits | 2039 GB/s (2 TB/s) |

| NVIDIA H100 80G SXM5 | HBM3 | 5120-bits | 3350 GB/s (3.35 TB/s) |

Kết luận

Các hoạt động triển khai cấp cao, như ChatGPT, tận dụng việc sử dụng các cụm H100 hoạt động song song để thực hiện các tác vụ suy luận theo thời gian thực và AI tạo sinh cho hàng triệu người dùng cùng lúc đưa ra các dòng prompts và cung cấp kết quả đầu ra theo thời gian thực. Nếu không có HBM cực nhanh cho phép kết nối GPU với GPU, thì chỉ cần một sự trì hoãn tối thiểu cũng có thể gây ra và khiến toàn bộ hoạt động triển khai của doanh nghiệp gần như không thể sử dụng được. Hãy xem xét việc ra mắt ChatGPT khi hạ tầng máy tính của họ không thể chứa được lượng lớn người dùng ngay cả khi sử dụng hệ thống NVIDIA DGX. Và một khi họ có thể mở rộng quy mô theo nhu cầu mở rộng, nó đã ổn định kể từ đó. Nhìn lại, ChatGPT thậm chí có thể sẽ không thể tồn tại nếu không sử dụng các GPU kết nối bộ nhớ băng thông cao này.

Cả bộ nhớ GDDR và HBM đều có những ưu điểm và nhược điểm. GPU được trang bị GDDR dễ tiếp cận hơn và ít tốn kém hơn (so với GPU được trang bị HBM) và là lựa chọn tốt cho các ứng dụng yêu cầu băng thông cao nhưng không yêu cầu hiệu suất cao nhất. GPU được trang bị HBM phù hợp hơn và đắt tiền hơn nhưng hiệu suất mà nó mang lại có thể là điều tối quan trọng đối với một số ứng dụng nhất định có yêu cầu nó. Khi chọn giữa hai loại bộ nhớ này, điều quan trọng là phải xem xét loại ứng dụng và ngân sách, cần đánh giá xem thời gian tiết kiệm được có ảnh hưởng đến tải xử lý của bạn hay không.

Bài viết liên quan