Phân tích cảm nghĩ

Phân tích cảm nghĩ (Sentiment Analysis) là hoạt động diễn dịch và phân loại tự động các cảm xúc (tích cực, tiêu cực hoặc trung tính) từ dữ liệu văn bản như các bài đánh giá bằng chữ, các bài đăng trên mạng xã hội.

Sentiment Analysis – Phân tích cảm nghĩ là gì?

Phân tích cảm nghĩ là một tập hợp con của xử lý ngôn ngữ tự nhiên (NLP) sử dụng học máy để phân tích và phân loại giọng điệu cảm xúc của dữ liệu văn bản. Các mô hình cơ bản chủ yếu tập trung vào việc phân loại các trạng thái tích cực, tiêu cực và trung lập nhưng cũng có thể xét đến những cảm xúc cơ bản của người nói (vui mừng, tức giận, phẫn nộ), cũng như các ý định mua hàng.

Bối cảnh sẽ thêm sự phức tạp vào quá trình Phân tích cảm nghĩ. Ví dụ: câu cảm thán “không có gì!” có ý nghĩa khác nhau đáng kể tùy thuộc vào việc người nói đang bình luận về những gì người đó thích hay không thích về một sản phẩm. Để hiểu cụm từ “Tôi thích nó”, hệ thống phải có khả năng gỡ rối ngữ cảnh để hiểu “nó” ám chỉ điều gì. Ý nghĩ “mỉa mai” cũng rất phổ biến vì người nói có thể đang nói điều gì đó tích cực nhưng lại có ý ngược lại.

Có một số loại Phân tích cảm nghĩ khác nhau. Phân tích cảm nghĩ dựa trên góc nhìn (aspect-based) đi sâu hơn một cấp để xác định các đặc điểm hoặc góc nhìn cụ thể nào đang tạo ra cảm xúc tích cực, trung lập hoặc tiêu cực. Các doanh nghiệp có thể sử dụng thông tin nắm bắt này để xác định những thiếu sót trong sản phẩm, hoặc ngược lại, các đặc điểm tạo ra sự nhiệt tình bất ngờ. Phân tích cảm nghĩ (Emotion) là một biến thể cố gắng xác định cường độ cảm xúc của người nói xung quanh một chủ đề. Phân tích ý định (Intent) xác định khả năng thực hiện hành động.

Tại sao nên sử dụng Phân tích cảm nghĩ?

Các doanh nghiệp có thể sử dụng thông tin nắm bắt (insights) từ Phân tích cảm nghĩ để cải thiện sản phẩm của họ, điều chỉnh thông điệp tiếp thị, sửa chữa những quan niệm sai lầm và xác định những người có ảnh hưởng tích cực.

Phương tiện truyền thông xã hội đã cách mạng hóa cách mọi người đưa ra quyết định về sản phẩm và dịch vụ. Trong các thị trường như du lịch, khách sạn và điện tử tiêu dùng, đánh giá của khách hàng hiện được coi là quan trọng tương đương với đánh giá của các nhà đánh giá chuyên nghiệp. Các nguồn như xếp hạng và đánh giá của Amazon trên TripAdvisor, Google và Yelp có thể tạo ra hoặc phá vỡ sản phẩm theo đúng nghĩa đen. Những nơi như Blog, Twitter, Facebook và Instagram cũng có thể là nguồn thông tin nắm bắt hữu ích về cảm nghĩ của khách hàng, cũng như các phản hồi về tính năng và dịch vụ của sản phẩm đã truyền cảm hứng khen ngợi hoặc chỉ trích.

Việc phân tích thủ công lượng văn bản phong phú do các khách hàng hoặc người mua tiềm năng này tạo ra thường rất tốn thời gian. Phân tích cảm nghĩ chung trên các phương tiện truyền thông xã hội, email, các ticket yêu cầu trợ giúp, trò chuyện, các đánh giá và gợi ý mua sản phẩm đã trở thành một nguồn tài nguyên quý giá được sử dụng trong hầu hết các ngành dọc. Nó rất hữu ích trong việc giúp các doanh nghiệp nắm bắt thị hiếu và hiểu khách hàng hơn, dự đoán và nâng cao trải nghiệm của khách hàng, điều chỉnh các chiến dịch tiếp thị và hỗ trợ ra quyết định.

Các ứng dụng của Phân tích cảm nghĩ

Một số ví dụ về ứng dụng của Phân tích cảm nghĩ bao gồm:

- Các nhà thiết kế sản phẩm sử dụng Phân tích cảm nghĩ để xác định tính năng nào đang gây được tiếng vang với khách hàng và do đó xứng đáng được đầu tư và tập trung hơn. Ngược lại, họ có thể tìm hiểu khi nào một sản phẩm hoặc tính năng không còn giá trị và điều chỉnh để ngăn chặn tồn kho tăng cao.

- Các công ty tiếp thị chủ yếu dựa vào Phân tích cảm nghĩ để giúp họ điều chỉnh thông điệp, khám phá những người có ảnh hưởng trên mạng (KoLs) và xây dựng chiến dịch marketing truyền miệng tích cực.

- Các tổ chức bán lẻ khai thác Phân tích cảm nghĩ để xác định sản phẩm nào có khả năng bán chạy và điều chỉnh hàng tồn kho cũng như khuyến mãi cho phù hợp.

- Các nhà đầu tư có thể xác định các xu hướng mới nổi lên trong các cuộc trò chuyện trực tuyến, dự báo trước các cơ hội thị trường.

- Các chính trị gia sử dụng nó để lấy mẫu thái độ của cử tri về các vấn đề quan trọng.

Phân tích cảm nghĩ hoạt động như thế nào?

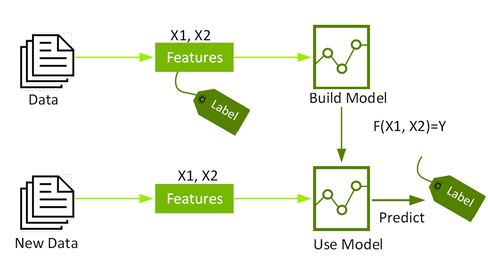

Feature Engineering trong học máy

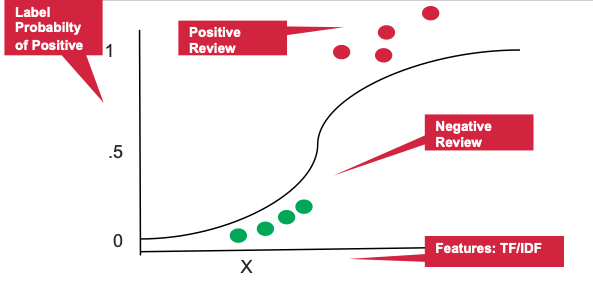

Feature Engineering là quá trình chuyển đổi dữ liệu thô thành đầu vào cho thuật toán học máy. Để được sử dụng trong các thuật toán học máy, các đặc điểm (feature) phải được đưa vào các vectors đặc trưng, là các vectors số đại diện cho giá trị của từng đặc điểm. Để phân tích cảm nghĩ, dữ liệu văn bản phải được đưa vào các vectors từ ngữ, là vectors của các số biểu thị giá trị cho mỗi ký tự. Văn bản đầu vào có thể được mã hóa thành các vectors ký tự bằng cách sử dụng các kỹ thuật đếm như Bag of Words (BoW), bag-of-ngrams hoặc Term Frequency/Inverse Document Frequency (TF-IDF).

Phân loại cảm xúc bằng cách sử dụng học máy có giám sát (Supervised ML)

Sau khi văn bản đầu vào đã được chuyển đổi thành vectors từ ngữ, thuật toán học máy phân loại có thể được sử dụng để phân loại cảm xúc. Phân loại là một nhóm các thuật toán học máy được giám sát để xác định chủng loại nào mà một item thuộc về (chẳng hạn như văn bản là tiêu cực hay tích cực) dựa trên dữ liệu được gắn nhãn (chẳng hạn như văn bản được gắn nhãn là tích cực hay tiêu cực).

Các thuật toán học máy phân loại có thể được sử dụng để phân tích cảm nghĩ bao gồm:

- Naïve Bayes là một bộ các thuật toán xác suất xác định xác suất có điều kiện của lớp dữ liệu đầu vào.

- Support Vector Machines tìm thấy một “hyperplane” trong không gian N chiều (N là số lượng đối tượng địa lý) phân loại rõ ràng các điểm dữ liệu.

- Logistic regression sử dụng hàm logistic để mô hình hóa xác suất của một cấp nhất định.

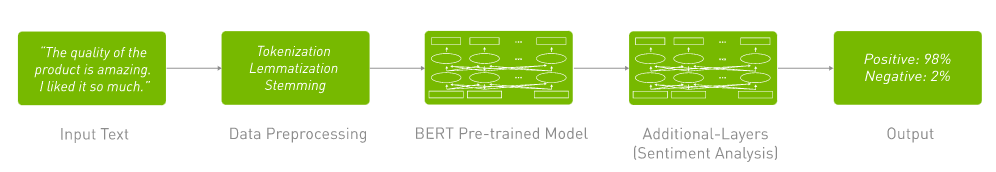

Phân tích cảm nghĩ bằng cách sử dụng Deep Learning

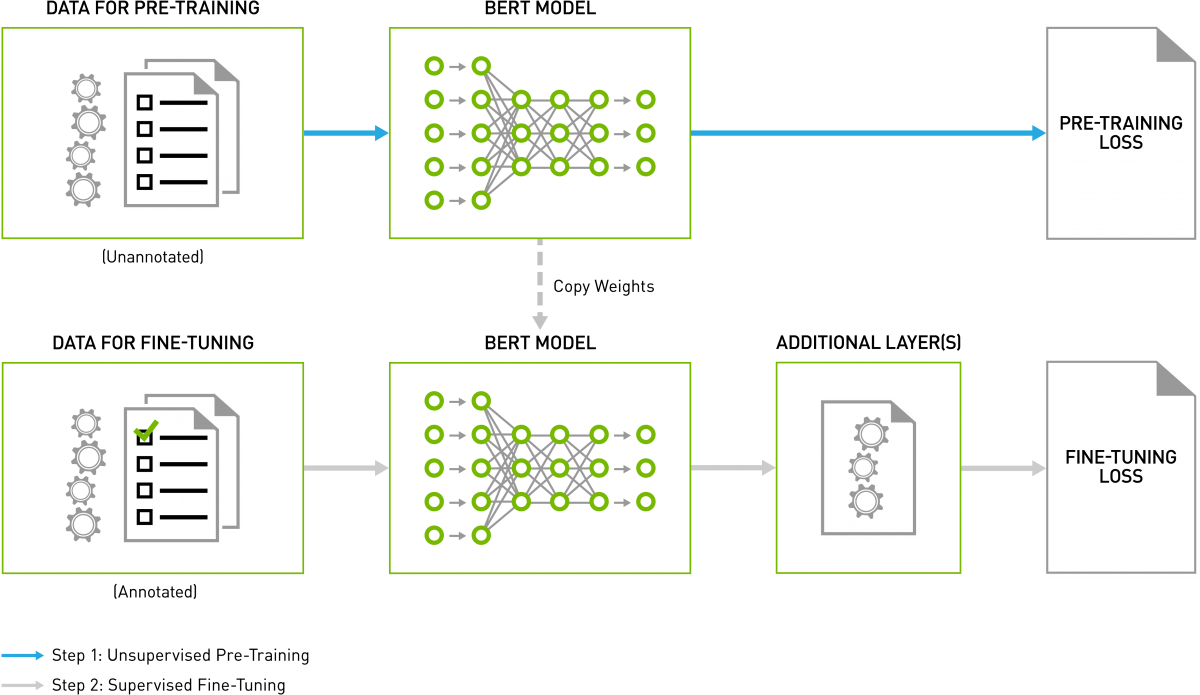

Học sâu (DL) là một tập hợp con của học máy (ML) sử dụng các neural networks để mang lại độ chính xác cao nhất trong các tác vụ như NLP và các tác vụ khác. Các kỹ thuật nhúng từ DL chẳng hạn như Word2Vec mã hóa các ký tự theo những cách có ý nghĩa bằng cách học các liên kết ký tự, ý nghĩa, ngữ nghĩa và cú pháp . Các thuật toán DL cũng cho phép đào tạo từ đầu đến cuối các mô hình NLP mà không cần phải thiết kế thủ công các tính năng từ dữ liệu thô đầu vào.

Có nhiều biến thể khác nhau của thuật toán học sâu. Recurrent neural networks là công cụ toán học để phân tích các mẫu ngôn ngữ và dữ liệu được sắp xếp theo trình tự. Chúng là bộ não xử lý ngôn ngữ tự nhiên mang đến thính giác và lời nói cho Alexa của Amazon và được sử dụng trong dịch thuật ngôn ngữ, dự đoán chứng khoán và giao dịch thuật toán. Các mô hình học sâu, chẳng hạn như BERT (Đại diện bộ mã hóa hai chiều từ Transformer), là một giải pháp thay thế cho Recurrent neural networks áp dụng kỹ thuật phân tích cú pháp một câu bằng cách focusing attention trên những ký tự có liên quan nhất đến trước và sau nó. BERT đã cách mạng hóa tiến trình trong NLP bằng cách cung cấp độ chính xác có thể so sánh với lộ trình cơ sở của con người trên các điểm chuẩn để nhận biết ý định, phân tích tình cảm, v.v. Nó mang tính hai chiều sâu sắc và có thể hiểu cũng như giữ lại ngữ cảnh tốt hơn so với các cơ chế mã hóa văn bản khác. Một thách thức chính với các mô hình ngôn ngữ đào tạo là thiếu dữ liệu được dán nhãn. BERT được đào tạo về unsupervised tasks và thường sử dụng bộ dữ liệu phi cấu trúc từ kho sách, Wikipedia tiếng Anh, v.v.

Tăng tốc NLP và Phân tích cảm nghĩ bằng GPU

Động lực thúc đẩy sự phát triển của NLP là những tiến bộ và đột phá gần đây và đang diễn ra trong quá trình xử lý ngôn ngữ tự nhiên, đặc biệt là việc triển khai GPU để vượt qua các mô hình ngôn ngữ ngày càng lớn và rất phức tạp.

GPU bao gồm hàng trăm core có thể xử lý song song hàng nghìn threads. GPU đã trở thành nền tảng được lựa chọn để đào tạo các mô hình ML và DL cũng như thực hiện suy luận vì chúng có thể mang lại hiệu suất cao hơn gấp 10 lần so với các nền tảng chỉ có CPU.

Deep Learning Neural Networks tiên tiến nhất có thể có từ hàng triệu đến hơn một tỷ tham số để điều chỉnh thông qua lan truyền ngược. Chúng cũng yêu cầu một lượng lớn dữ liệu huấn luyện để đạt được độ chính xác cao, nghĩa là hàng trăm nghìn đến hàng triệu mẫu đầu vào sẽ phải được chạy qua cả hai lần tiến và lùi. Bởi vì mạng lưới thần kinh được tạo ra từ một số lượng lớn các tế bào thần kinh giống hệt nhau, nên về bản chất chúng có tính song song cao. Sự song song này ánh xạ tự nhiên tới GPU, cung cấp khả năng tăng tốc tính toán đáng kể so với quá trình đào tạo chỉ dành cho CPU. Vì lý do này, GPU đã trở thành nền tảng được lựa chọn để đào tạo các hệ thống dựa trên Neural Network phức tạp và bản chất song song của các hoạt động suy luận cũng phù hợp để thực thi trên GPU. Ngoài ra, các mô hình học sâu dựa trên Transformer, chẳng hạn như BERT, không yêu cầu xử lý dữ liệu tuần tự theo thứ tự, cho phép thực hiện song song hóa nhiều hơn và giảm thời gian đào tạo trên GPU so với RNN.

AI Libraries được tăng tốc bởi GPU NVIDIA

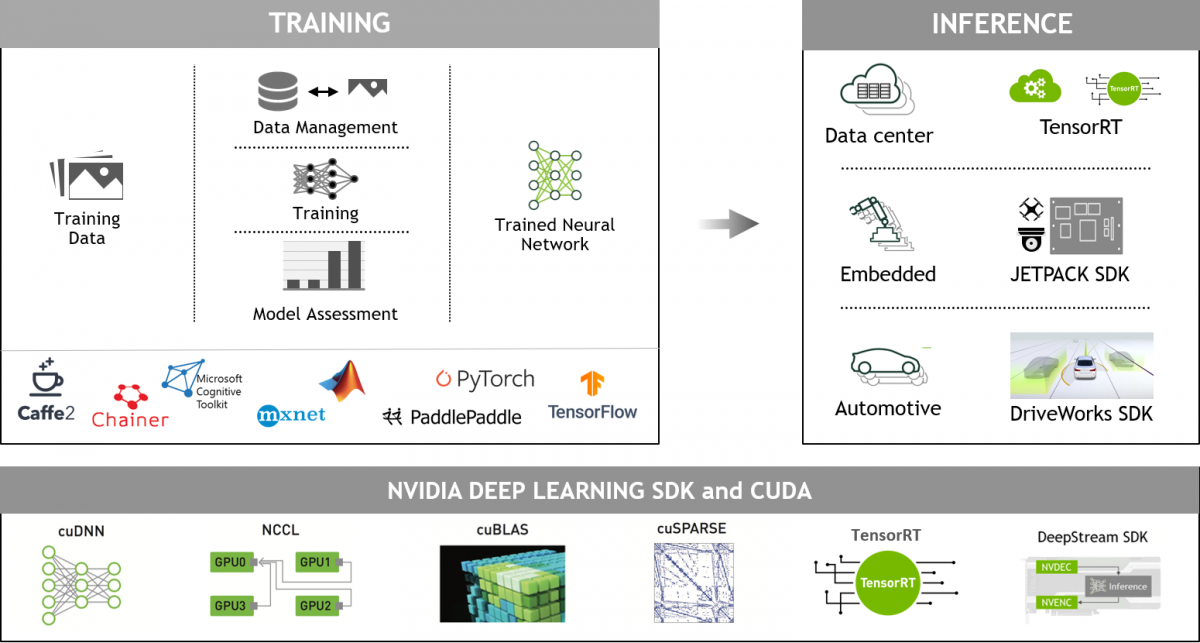

Với GPU NVIDIA và CUDA-X AI libraries, các mô hình ngôn ngữ khổng lồ, hiện đại nhất có thể được đào tạo và tối ưu hóa nhanh chóng để chạy suy luận chỉ trong vài mili giây hoặc một phần nghìn giây. Đây là một bước tiến lớn hướng tới việc chấm dứt sự đánh đổi giữa một mô hình AI nhanh đối với một mô hình lớn và phức tạp. Khả năng xử lý song song và kiến trúc Tensor Core của GPU NVIDIA cho phép thông lượng và khả năng mở rộng cao hơn khi làm việc với các mô hình ngôn ngữ phức tạp cho phép hiệu suất thiết lập cho cả quá trình đào tạo và suy luận của BERT.

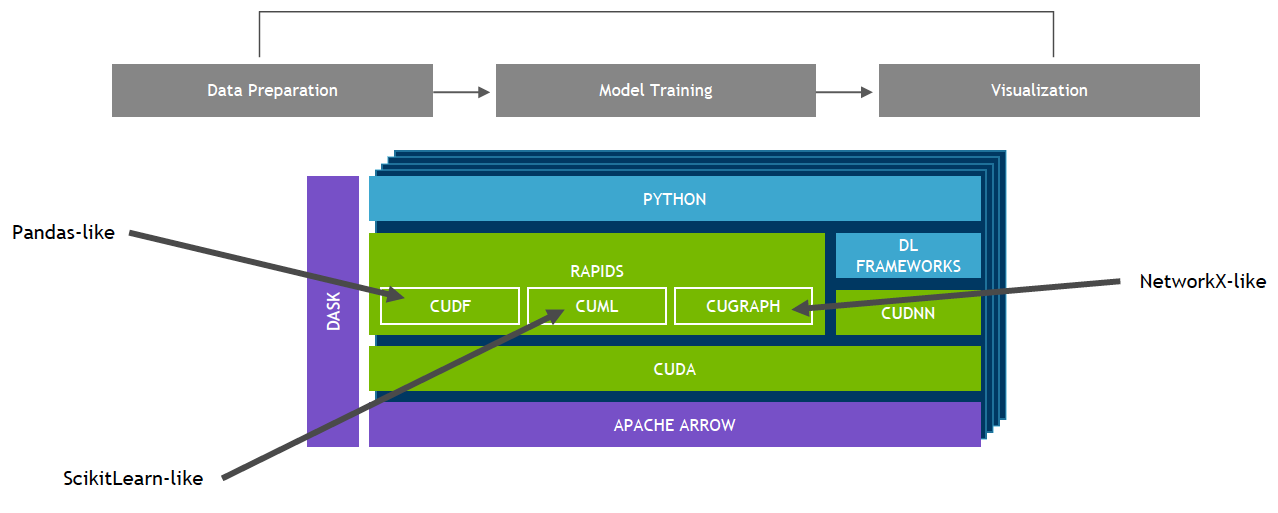

Khoa học dữ liệu toàn diện, được tăng tốc bởi NVIDIA GPU

Bộ thư viện phần mềm NVIDIA RAPIDS, được xây dựng trên CUDA-X AI, cho phép người dùng tự do thực hiện các quy trình phân tích và khoa học dữ liệu từ đầu đến cuối hoàn toàn trên GPU. Nó dựa trên các nguyên mẫu NVIDIA CUDA để tối ưu hóa điện toán ở mức độ thấp, nhưng thể hiện tính song song của GPU và tốc độ bộ nhớ băng thông cao thông qua giao diện Python thân thiện với người dùng.

Framework học sâu được GPU tăng tốc của NVIDIA

Các framework DL được tăng tốc bằng GPU mang lại sự linh hoạt trong việc thiết kế và huấn luyện các mạng thần kinh sâu tùy biến, đồng thời cung cấp giao diện cho các ngôn ngữ lập trình thường được sử dụng như Python và C/C++. Các framework học sâu được sử dụng rộng rãi như MXNet, PyTorch, TensorFlow và các framework khác dựa vào thư viện tăng tốc GPU NVIDIA để cung cấp chương trình đào tạo tăng tốc đa GPU, hiệu suất cao.

Bước tiếp theo

- NVIDIA cung cấp các gói phần mềm được tối ưu hóa để tăng tốc các giai đoạn đào tạo và suy luận của quy trình học sâu. Tìm hiểu thêm trên trang chủ về học sâu của NVIDIA .

- Các nhà phát triển, nhà nghiên cứu và nhà khoa học dữ liệu có thể dễ dàng truy cập vào các container chứa framework học sâu được tối ưu hóa của NVIDIA với các ví dụ về học sâu được điều chỉnh và thử nghiệm hiệu suất cho GPU NVIDIA. Điều này giúp loại bỏ nhu cầu quản lý các gói và phần phụ thuộc hoặc xây dựng các khung học sâu từ nguồn. Hãy truy cập NVIDIA NGC để tìm hiểu thêm và bắt đầu.

- Được thiết kế đặc biệt cho deep learning, Tensor Cores trên GPU NVIDIA Volta và Turing mang lại hiệu suất suy luận và đào tạo cao hơn đáng kể. Tìm hiểu thêm về cách truy cập triển khai tham chiếu .

- Viện học sâu NVIDIA (DLI) cung cấp chương trình đào tạo thực hành cho các nhà phát triển, nhà khoa học dữ liệu và nhà nghiên cứu về AI và điện toán tăng tốc.

- Để biết tin tức và tài nguyên dành cho nhà phát triển, hãy xem trang web dành cho nhà phát triển NVIDIA .

Bài viết liên quan

- 5 điều bạn cần biết về NVIDIA DGX Spark – Chiếc máy tính mơ ước của các nhà phát triển AI

- NVIDIA NVLink Thế hệ thứ 5: Bước nhảy vọt về băng thông cho kỷ nguyên AI nghìn tỷ tham số

- SLM và AI tại biên: Bình minh của một kỷ nguyên mới hay chỉ là cơn sốt nhất thời?

- So sánh sự khác biệt giữa NVIDIA H200 NVL và NVIDIA H200 HGX

- Mở rộng quy mô cho hạ tầng GenAI on-premise

- CPU NVIDIA Grace C1 được hỗ trợ rộng rãi cho điện toán biên, ngành viễn thông và các hệ thống lưu trữ