Kỹ thuật tăng cường dữ liệu cho phép mô hình AI mô phỏng tác phẩm nghệ thuật từ một tập dữ liệu nhỏ từ Bảo tàng Nghệ thuật Metropolitan – và mở ra các ứng dụng tiềm năng mới trong các lĩnh vực như chăm sóc sức khỏe.

Mô hình AI mới nhất của NVIDIA Research là một đột phá trong số các mạng hiện có. Sử dụng một phần tư liệu nghiên cứu cần thiết của một GAN điển hình, nó có thể học các kỹ năng phức tạp như mô phỏng các họa sĩ nổi tiếng và tái tạo hình ảnh của mô ung thư.

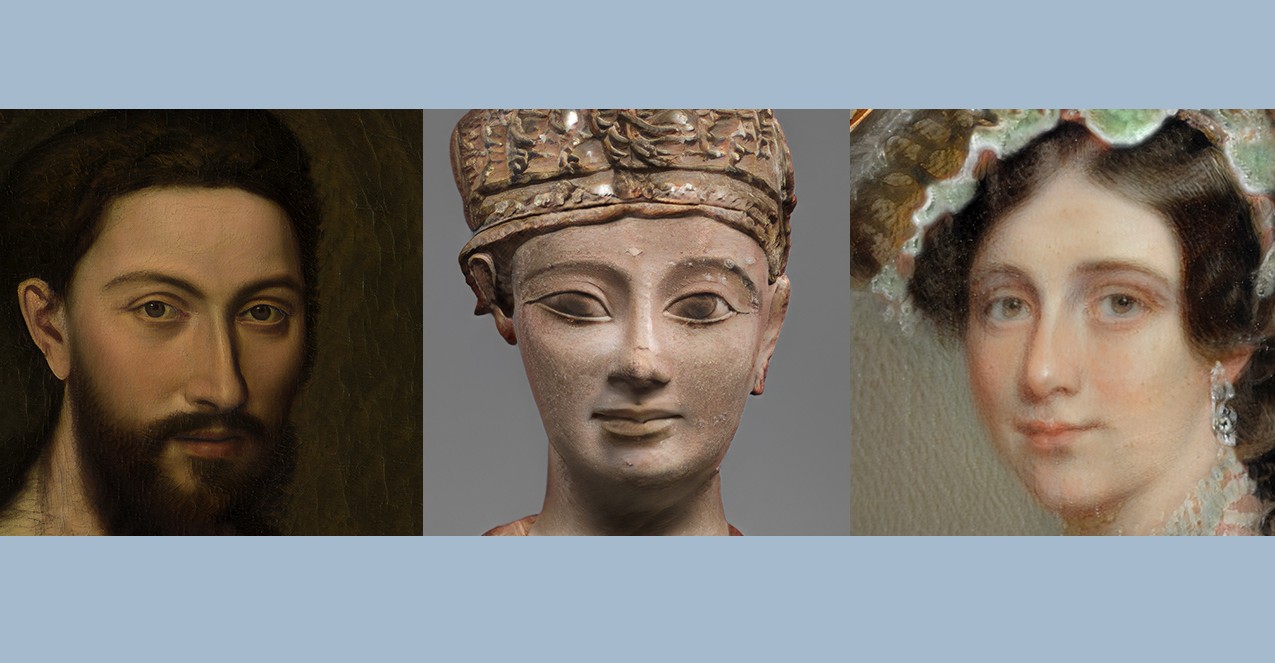

Bằng cách áp dụng kỹ thuật đào tạo mạng thần kinh đột phá cho mô hình NVIDIA StyleGAN2 phổ biến, các nhà nghiên cứu NVIDIA đã “mường tượng” lại tác phẩm nghệ thuật dựa trên ít hơn 1.500 hình ảnh từ Bảo tàng Nghệ thuật Metropolitan. Sử dụng hệ thống NVIDIA DGX để đẩy nhanh quá trình đào tạo, họ đã tạo ra nghệ thuật AI mới lấy cảm hứng từ các bức chân dung lịch sử.

Kỹ thuật – được gọi là tăng cường phân biệt thích ứng, hoặc ADA – giảm số lượng hình ảnh đào tạo xuống 10-20 lần trong khi vẫn thu được kết quả tuyệt vời. Phương pháp tương tự một ngày nào đó có thể có tác động đáng kể trong việc chăm sóc sức khỏe, chẳng hạn bằng cách tạo ra hình ảnh mô học ung thư để giúp đào tạo các mô hình AI khác.

David Luebke, phó chủ tịch nghiên cứu đồ họa của NVIDIA cho biết: “Những kết quả này có nghĩa là mọi người có thể sử dụng GAN để giải quyết các vấn đề trong đó số lượng lớn dữ liệu quá tốn thời gian hoặc khó lấy”. “Tôi nóng lòng muốn xem các nghệ sĩ, chuyên gia y tế và nhà nghiên cứu sử dụng nó để làm gì.”

Bài báo nghiên cứu đằng sau dự án này sẽ được trình bày trong tuần này tại Hội nghị thường niên về Hệ thống xử lý thông tin thần kinh, được gọi là NeurIPS. Đây là một trong 28 bài báo kỷ lục của Nghiên cứu NVIDIA được chấp nhận tham dự hội nghị uy tín.

Phương pháp mới này là phương pháp mới nhất trong di sản đổi mới GAN của các nhà nghiên cứu NVIDIA, những người đã phát triển các mô hình dựa trên GAN đột phá cho ứng dụng vẽ tranh AI GauGAN, công cụ bắt chước công cụ trò chơi GameGAN và biến hình ảnh thú cưng GANimal. Tất cả đều có trên NVIDIA AI Playground .

Thế lưỡng nan về dữ liệu đào tạo

Giống như hầu hết các mạng nơron, GAN từ lâu đã tuân theo một nguyên tắc cơ bản: càng nhiều dữ liệu huấn luyện, mô hình càng tốt. Đó là bởi vì mỗi GAN bao gồm hai mạng hợp tác – một bộ tạo, tạo ra hình ảnh tổng hợp và một bộ phân biệt, tìm hiểu hình ảnh thực tế trông như thế nào dựa trên dữ liệu đào tạo.

Bộ phân biệt huấn luyện trình tạo, đưa ra phản hồi từng pixel để giúp nó cải thiện tính chân thực của các hình ảnh tổng hợp. Nhưng với dữ liệu đào tạo hạn chế để học hỏi từ đó, một người phân biệt sẽ không thể giúp người tạo phát huy hết tiềm năng của nó – giống như một huấn luyện viên tân binh có kinh nghiệm trận đấu ít hơn nhiều so với một chuyên gia dày dạn.

Thông thường, mất 50.000 đến 100.000 hình ảnh đào tạo để đào tạo một GAN chất lượng cao. Nhưng trong nhiều trường hợp, các nhà nghiên cứu chỉ đơn giản là không có hàng chục hoặc hàng trăm nghìn hình ảnh mẫu theo ý của họ.

Chỉ với vài nghìn hình ảnh để đào tạo, nhiều GAN sẽ chùn bước trong việc tạo ra kết quả thực tế. Sự cố này, được gọi là overfitting, xảy ra khi bộ phân biệt chỉ ghi nhớ các hình ảnh đào tạo và không cung cấp phản hồi hữu ích cho bộ tạo.

Trong các nhiệm vụ phân loại hình ảnh, các nhà nghiên cứu xoay quanh việc trang bị quá nhiều dữ liệu, một kỹ thuật mở rộng các tập dữ liệu nhỏ hơn bằng cách sử dụng các bản sao của hình ảnh hiện có bị bóp méo ngẫu nhiên bởi các quy trình như xoay, cắt hoặc lật – buộc mô hình phải tổng quát hóa tốt hơn.

Nhưng những nỗ lực trước đây để áp dụng tăng cường cho hình ảnh huấn luyện GAN đã dẫn đến việc tạo ra một bộ tạo có thể bắt chước những biến dạng đó, thay vì tạo ra những hình ảnh tổng hợp đáng tin cậy.

GAN trong một nhiệm vụ

Phương pháp ADA của NVIDIA Research áp dụng tăng cường dữ liệu một cách thích ứng, có nghĩa là lượng tăng dữ liệu được điều chỉnh tại các điểm khác nhau trong quá trình đào tạo để tránh trang bị quá mức. Điều này cho phép các mô hình như StyleGAN2 đạt được kết quả đáng kinh ngạc bằng cách sử dụng thứ tự hình ảnh đào tạo có cường độ nhỏ hơn.

Do đó, các nhà nghiên cứu có thể áp dụng GAN cho các ứng dụng không thực tế trước đây khi các ví dụ quá khan hiếm, quá khó để lấy hoặc quá tốn thời gian để thu thập thành một tập dữ liệu lớn.

Các phiên bản khác nhau của StyleGAN đã được các nghệ sĩ sử dụng để tạo ra các cuộc triển lãm tuyệt đẹp và sản xuất một bộ truyện tranh mới dựa trên phong cách của họa sĩ minh họa huyền thoại Osamu Tezuka. Nó thậm chí còn được Adobe áp dụng để tăng sức mạnh cho công cụ AI mới của Photoshop, Bộ lọc thần kinh.

Với ít dữ liệu đào tạo hơn cần thiết để bắt đầu, StyleGAN2 với ADA có thể được áp dụng cho các tác phẩm nghệ thuật hiếm, chẳng hạn như tác phẩm của nhóm nghệ thuật AI có trụ sở tại Paris. Rõ ràng trên mặt nạ Kota châu Phi.

Một ứng dụng đầy hứa hẹn khác nằm trong lĩnh vực chăm sóc sức khỏe, nơi các hình ảnh y tế về các bệnh hiếm gặp có thể rất ít và xa vì hầu hết các xét nghiệm đều trở lại bình thường. Việc tích lũy một tập dữ liệu hữu ích về các slide bệnh lý bất thường sẽ đòi hỏi các chuyên gia y tế phải ghi nhãn nhiều giờ.

Hình ảnh tổng hợp được tạo bằng GAN sử dụng ADA có thể lấp đầy khoảng trống đó, tạo ra dữ liệu đào tạo cho một mô hình AI khác giúp các bác sĩ bệnh học hoặc bác sĩ X quang phát hiện các tình trạng hiếm gặp trên hình ảnh bệnh lý hoặc nghiên cứu MRI. Một phần thưởng bổ sung: Với dữ liệu do AI tạo ra, không có dữ liệu bệnh nhân hoặc mối quan tâm về quyền riêng tư, giúp các tổ chức chăm sóc sức khỏe chia sẻ tập dữ liệu dễ dàng hơn.

NVIDIA Research tại NeurIPS

Nhóm nghiên cứu NVIDIA bao gồm hơn 200 nhà khoa học trên toàn cầu, tập trung vào các lĩnh vực bao gồm AI, thị giác máy tính, ô tô tự lái, người máy và đồ họa. Hơn hai chục bài báo của các nhà nghiên cứu NVIDIA sẽ được giới thiệu tại NeurIPS, hội nghị nghiên cứu AI lớn nhất trong năm, diễn ra hầu như từ ngày 6 đến ngày 12 tháng 12.

Xem toàn bộ các bài báo của NVIDIA Research tại NeurIPS.

Bài viết liên quan

- Virtual Factory và cách chúng biến Số hóa Công nghiệp thành hiện thực

- Tạo chatbot trên dữ liệu của riêng bạn với NVIDIA ChatRTX

- NVIDIA với ý tưởng về “Premium AI PC” được hỗ trợ bởi GPU GeForce

- Máy chủ Supermicro X14: Hiệu suất mạnh mẽ, hiệu quả tối đa cho AI, Cloud, Storage, 5G/Edge

- NVIDIA Omniverse ft Apple Vision Pro: Mở rộng thế giới quan với VR/AR

- Tôi có cần CPU kép không?