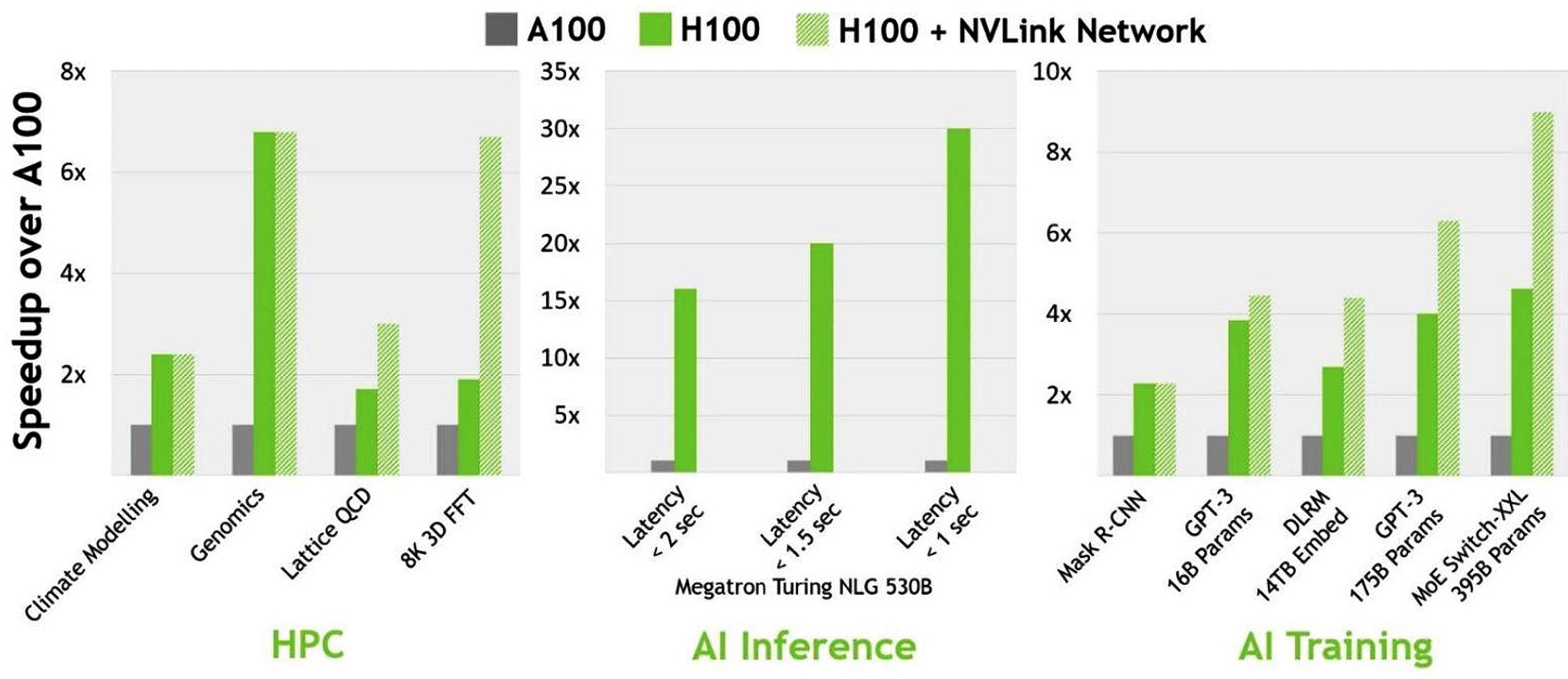

H100 được xây dựng trên kiến trúc GPU NVIDIA Hopper tiên tiến nhất hiện nay, đây là lựa chọn lý tưởng cho các ứng dụng yêu cầu sức mạnh tính toán nhanh chớp nhoáng. Với Tensor Cores thế hệ thứ tư, H100 mang đến khả năng đào tạo AI nhanh hơn đến 5 lần và tốc độ suy luận AI nhanh hơn 30 lần trên các mô hình ngôn ngữ lớn so với thế hệ A100 trước đó, giúp nó trở thành một trong những GPU tiên tiến nhất trên thị trường và là sự kết hợp hoàn hảo cho các máy chủ GPU PCIe.

Bài viết này sẽ đi sâu vào kiến trúc và hệ thống phân cấp của H100, đồng thời khám phá một số ứng dụng thú vị mà GPU này là lý tưởng. Cho dù bạn đang làm việc với các mô hình AI phức tạp hay yêu cầu điện toán hiệu năng cao cho nghiên cứu khoa học, GPU H100 là giải pháp mang tính thay đổi cuộc chơi, sẽ giúp bạn đạt được các mục tiêu nhanh hơn và hiệu quả hơn bao giờ hết.

Kiến trúc và sơ đồ phân cấp của GPU H100

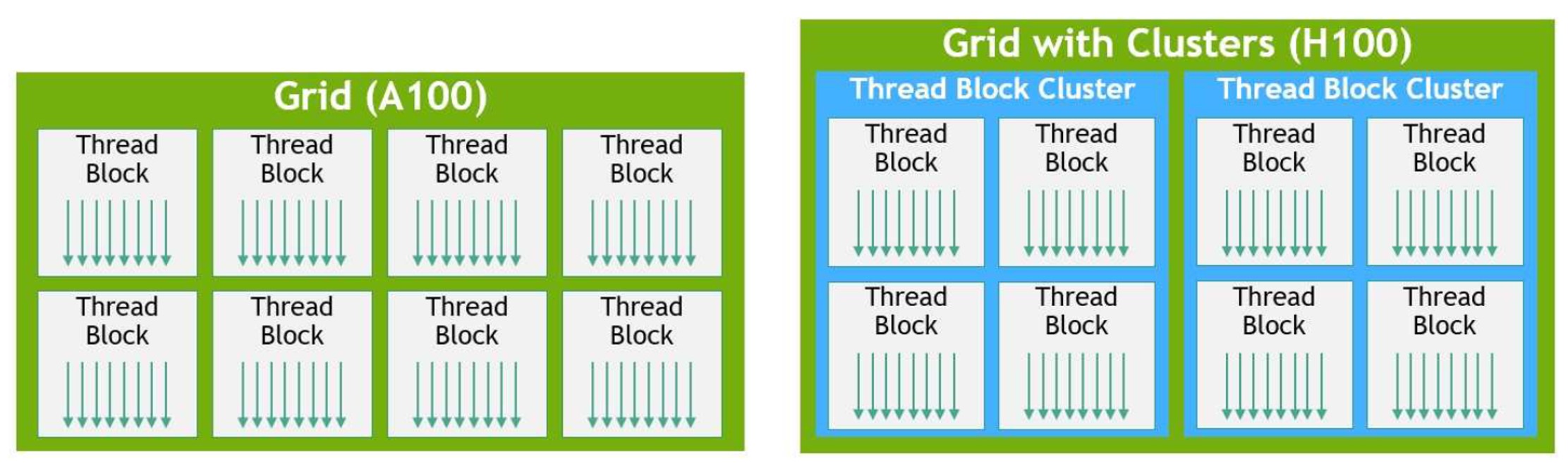

Những tiến bộ nhanh chóng trong kiến trúc điện toán GPU đã mang lại sự tiến hóa đáng kể trong hệ thống phân cấp GPU H100 mới nhất của NVIDIA. Trong khi mô hình lập trình CUDA dựa vào các Grids và Thread Blocks để đạt được hiệu quả cục bộ trong nhiều năm, cách tiếp cận Thread Block thông thường đã trở nên không phù hợp với độ phức tạp ngày càng tăng của các chương trình và sự xuất hiện của GPU với hơn 100 Streaming Multiprocoessors (SM).

Để giải quyết vấn đề này, NVIDIA đã giới thiệu kiến trúc Thread Block Cluster cải tiến với GPU H100. Kiến trúc này cung cấp mức độ kiểm soát cục bộ cao hơn, cho phép mức độ chi tiết lớn hơn so với một Thread Block đơn trên một SM. Với Thread Block Cluster, mô hình lập trình CUDA đã mở rộng lên một cấp độ mới, bổ sung thêm Thread, Thread Block, Thread Block Cluster và Grid vào hệ thống phân cấp lập trình vật lý của GPU.

Vậy chính xác thì Thread Block Cluster là gì? Nói một cách đơn giản, nó là tập hợp các Thread Block được lên lịch đồng thời trên một nhóm SM. Kiến trúc mới này nhằm mục đích tạo điều kiện cho sự hợp tác hiệu quả của các Thread trên nhiều SM, dẫn đến cải thiện hiệu suất và hiệu quả thực thi.

GPU NVIDIA H100 có rất nhiều cải tiến, giúp nó trở thành cỗ máy đầy sức mạnh cho các lĩnh vực ứng dụng điện toán hiệu năng cao (HPC). Dựa trên kiến trúc GPU Hopper mới, H100 được tích hợp nhiều tính năng tiên tiến giúp nó mạnh hơn, hiệu quả hơn và có khả năng lập trình cao hơn bất kỳ GPU nào trước đó.

Một trong những cải tiến quan trọng nhất ở H100 là Tensor Core thế hệ thứ tư, thực hiện tính toán ma trận nhanh hơn và hiệu quả hơn bao giờ hết. Điều này cho phép H100 xử lý nhiều tác vụ AI và HPC một cách dễ dàng.

Các ứng dụng của GPU H100

NVIDIA H100 được thiết kế cho các tải xử lý điện toán hiệu năng cao và phù hợp với nhiều ứng dụng. Một số ứng dụng phổ biến nhất cho H100 bao gồm:

- Deep Learning: NVIDIA H100 là sự lựa chọn tuyệt vời cho các ứng dụng deep learning nhờ Tensor Cores mạnh mẽ. GPU có thể xử lý các tập dữ liệu lớn và thực hiện các phép tính phức tạp cần thiết để đào tạo mạng lưới thần kinh sâu.

- Điện toán hiệu suất cao: H100 cũng phù hợp với tải xử lý tính toán hiệu suất cao, chẳng hạn như mô phỏng khoa học, dự báo thời tiết và lập mô hình tài chính với băng thông bộ nhớ cao và khả năng xử lý mạnh mẽ.

- Suy luận AI: NVIDIA H100 cũng có thể được sử dụng cho tải xử lý suy luận AI, chẳng hạn như nhận dạng hình ảnh và giọng nói. Tensor Core mạnh mẽ của GPU cho phép GPU xử lý lượng lớn dữ liệu một cách nhanh chóng, là lựa chọn tuyệt vời cho các ứng dụng suy luận thời gian thực.

- Thị giác máy tính: H100 cũng có thể được sử dụng cho các ứng dụng thị giác máy tính, chẳng hạn như phát hiện đối tượng và phân đoạn hình ảnh. Tensor Core của GPU cho phép nó xử lý lượng lớn dữ liệu hình ảnh một cách nhanh chóng.

- Nghiên cứu sinh học (Computational Biology): H100 cũng hữu ích cho các ứng dụng Computational Biology, chẳng hạn như giải trình tự bộ gen và mô phỏng gấp protein. Khả năng xử lý tập lệnh DPX mạnh mẽ và băng thông bộ nhớ cao giúp GPU H100 rất phù hợp với các loại ứng dụng này.

Kết luận

NTC tự hào đã triển khai, cung cấp các hệ thống NVIDIA DGX H100 và cụm DGX SuperPOD cho các đối tác lớn tại Việt Nam với chuyên môn và nghiệp vụ triển khai được NVIDIA chứng nhận.

H100 là GPU cao cấp có nhiều cải tiến và công nghệ nâng cao, giúp nó trở thành lựa chọn lý tưởng cho các ứng dụng đòi hỏi năng lực điện toán đồ sộ của khách hàng. Với kiến trúc tiên tiến và Tensor Core thế hệ thứ tư, H100 là một trong những GPU mạnh mẽ, có thể lập trình và tiết kiệm năng lượng nhất cho đến nay, cho phép người dùng và ứng dụng luôn sử dụng tối đa tất cả các đơn vị GPU H100 của họ.

Chúng tôi tin rằng H100 là sự lựa chọn tuyệt vời cho các tổ chức yêu cầu khả năng tính toán hiệu năng cao. Sức mạnh xử lý và băng thông bộ nhớ giúp nó trở nên lý tưởng để xử lý các tải xử lý đòi hỏi khắt khe nhất, đồng thời khả năng cung cấp tốc độ suy luận và đào tạo AI nhanh như chớp trên các mô hình ngôn ngữ lớn khiến nó trở thành giải pháp mang tính thay đổi cuộc chơi cho các tổ chức làm việc với các mô hình AI phức tạp.

Bài viết liên quan

- NVIDIA NGC‑ready Low‑latency Edge AI: Giải pháp cho Retail, Manufacturing và Smart Cities

- So sánh sức mạnh của máy tính AI DGX Spark với các card GPU máy trạm chuyên nghiệp của NVIDIA

- Từ Orin đến Thor: Bước nhảy vọt kiến trúc của NVIDIA JetPack 7.0 và tương lai của robot hình người

- Tại sao gọi NVIDIA DGX Spark là Siêu máy tính AI cá nhân?

- Cơ chế quản lý bộ nhớ trên các nền tảng phần cứng nhất quán – Hardware-coherent

- Kiến trúc NVIDIA Blackwell với GB200 NVL72: Định nghĩa lại điện toán AI cấp độ Exascale