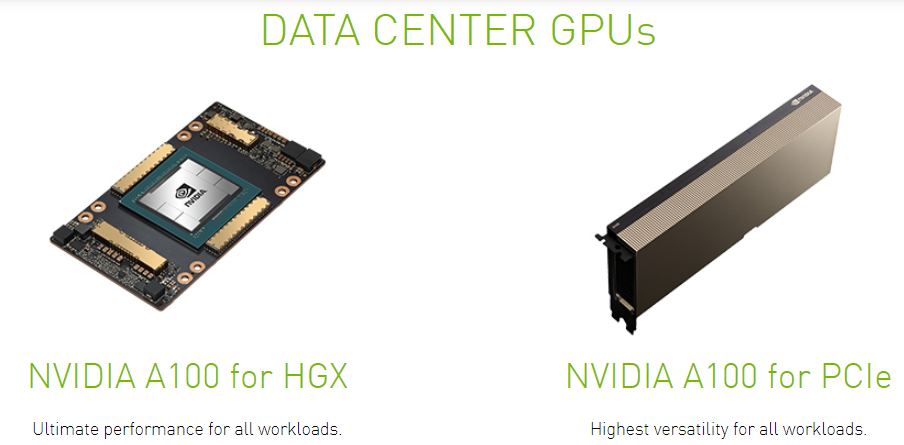

Sau sự kiện ra mắt của kiến trúc Ampere và GPU tăng tốc AI A100 mới, NVIDIA cũng đã công bố phiên bản PCIe của bộ tăng tốc này để bắt đầu cho sự kiện ảo ISC Digital. GPU A100 PCIe được ra mắt vào tháng 6 năm 2020, xây dựng trên tiến trình 7nm và dựa trên bộ xử lý đồ họa GA100, card không hỗ trợ DirectX nên nó có thể không chạy được tất cả các trò chơi mới nhất. A100 GPU có 432 lõi tensor giúp cải thiện tốc độ của các ứng dụng học máy. NVIDIA đã ghép nối bộ nhớ HBM2e 40GB với A100 PCIe, được kết nối bằng giao diện bộ nhớ 5120-bit. GPU đang hoạt động ở tần số 765 MHz, có thể được boost lên 1410 MHz, bộ nhớ hoạt động ở tần số 1215 MHz, mang đến hiệu suất tính toán đa nhiệm mạnh mẽ hơn.

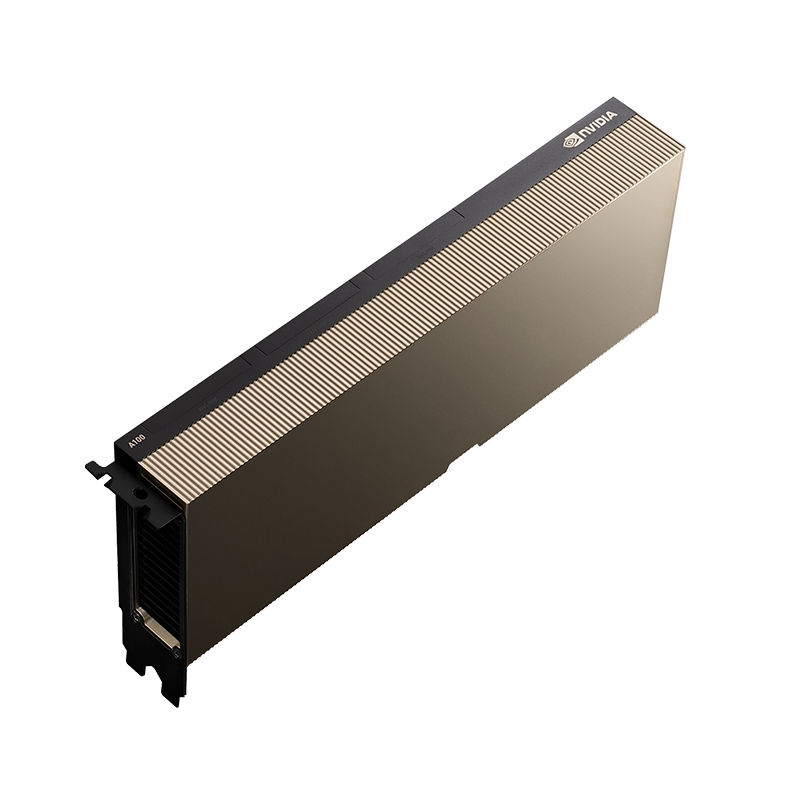

Là một GPU có kích thước 2 khe cắm (double-width), NVIDIA A100 PCIe cần cung cấp nguồn điện là một nguồn EPS 8 chân duy nhất, với mức tiêu thụ điện năng tối đa là 250W. GPU này không có cổng màn hình, vì nó không được thiết kế để có màn hình kết nối. A100 PCIe được kết nối với phần còn lại của hệ thống bằng giao diện PCI-Express 4.0 x16. Card có chiều dài 267mm và giao tiếp PCIe truyền thống, giúp đáp ứng những khách hàng chỉ cần cắm vào máy chủ thiết kế tiêu chuẩn. Nhìn chung, A100 PCIe cung cấp hiệu năng cao nhất tương tự như SXM4 A100, cung cấp khoảng 90% hiệu suất so với phiên bản SXM4 trên workload GPU đơn, do TDP giảm mạnh. Điều này giúp cho A100 PCIe phù hợp hơn với các hệ thống AI trong Data Center mật độ cao nhưng tiết kiệm hơn về TCO.

NVIDIA GPU A100 PCIe chính là kiến trúc A100 hoàn chỉnh, chỉ khác là nằm trong một form-factor PCIe và có TDP phù hợp hơn. Về hiệu năng, A100 PCIe cũng sẽ nhanh tương đương phiên bản SXM4. Do đó, phiên bản PCIe mang tất cả mọi thứ mà A100 cung cấp vào bên trong nó, với cùng trọng tâm tập trung vào các phép toán tensor, bao gồm các chuẩn FP32 và FP64 có độ chính xác cao hơn, cũng như suy luận số nguyên nhanh hơn.

Bảng so sánh thông số kỹ thuật các bộ tăng tốc NVIDIA

| A100 (PCIe) |

A100 (SXM4) |

V100 (PCIe) |

P100 (PCIe) |

|

| FP32 CUDA Cores | 6912 | 6912 | 5120 | 3584 |

| Boost Clock | 1.41GHz | 1.41GHz | 1.38GHz | 1.3GHz |

| Memory Clock | 2.4Gbps HBM2 | 2.4Gbps HBM2 | 1.75Gbps HBM2 | 1.4Gbps HBM2 |

| Memory Bus Width | 5120-bit | 5120-bit | 4096-bit | 4096-bit |

| Memory Bandwidth | 1.6TB/sec | 1.6TB/sec | 900GB/sec | 720GB/sec |

| VRAM | 40GB | 40GB | 16GB/32GB | 16GB |

| Single Precision | 19.5 TFLOPs | 19.5 TFLOPs | 14.1 TFLOPs | 9.3 TFLOPs |

| Double Precision | 9.7 TFLOPs (1/2 FP32 rate) |

9.7 TFLOPs (1/2 FP32 rate) |

7 TFLOPs (1/2 FP32 rate) |

4.7 TFLOPs (1/2 FP32 rate) |

| INT8 Tensor | 624 TOPs | 624 TOPs | N/A | N/A |

| FP16 Tensor | 312 TFLOPs | 312 TFLOPs | 112 TFLOPs | N/A |

| TF32 Tensor | 156 TFLOPs | 156 TFLOPs | N/A | N/A |

| Relative Performance (SXM Version) | 90% | 100% | N/A | N/A |

| Interconnect | NVLink 3 6 Links? (300GB/sec?) |

NVLink 3 12 Links (600GB/sec) |

NVLink 2 4 Links (200GB/sec) |

NVLink 1 4 Links (160GB/sec) |

| GPU | GA100 (826mm2) |

GA100 (826mm2) |

GV100 (815mm2) |

GP100 (610mm2) |

| Transistor Count | 54.2B | 54.2B | 21.1B | 15.3B |

| TDP | 250W | 400W | 250W | 300W |

| Manufacturing Process | TSMC 7N | TSMC 7N | TSMC 12nm FFN | TSMC 16nm FinFET |

| Interface | PCIe 4.0 | SXM4 | PCIe 3.0 | SXM |

| Architecture | Ampere | Ampere | Volta | Pascal |

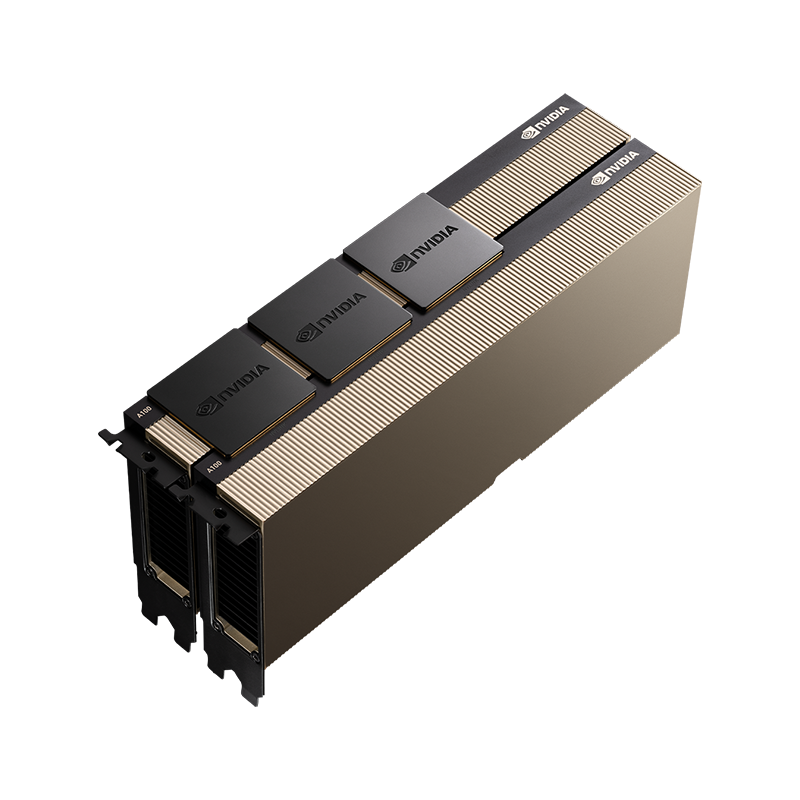

Ngoài sự thay đổi ở form-factor và TDP, khác biệt đáng chú ý ở A100 PCIe so với phiên bản SXM là khả năng kết nối NVLink. Đối với card PCIe , NVIDIA một lần nữa sử dụng các cầu nối NVLink để kết nối qua phía trên của các card A100, cho phép hai (và chỉ hai) card được liên kết với nhau qua NVlink Brigde. Với NVlink Brigde, A100 PCIe và 3 NVLink connector của nó có thể đạt tốc độ NVLink bandwidth lên đến 600GB/s, giúp hệ thống AI của bạn dễ dàng tăng tốc và nâng cao hiệu suất của các ứng dụng và workloads quan trọng.

Những kiến trúc đổi mới và đột phá của NVIDIA GPU AMPERE A100

Kiến trúc NVIDIA Ampere CUDA Cores

NVLINK THẾ HỆ TIẾP THEO

Tensor Cores Thế hệ Thứ 3

Bộ nhớ HBM2E

GPU MULTI-INSTANCE (MIG)

NVIDIA GPU A100 – Nền tảng trung tâm dữ liệu HPC và AI End-to-End mạnh mẽ nhất

GPU NVIDIA A100 là một phần của giải pháp trung tâm dữ liệu NVIDIA hoàn chỉnh, kết hợp các khối xây dựng trên phần cứng, mạng, phần mềm, thư viện cũng như các mô hình và ứng dụng AI được tối ưu hóa từ NGC ™. Đại diện cho nền tảng AI và HPC end-to-end mạnh mẽ nhất cho các trung tâm dữ liệu, nó cho phép các nhà nghiên cứu cung cấp kết quả trong thế giới thực và triển khai các giải pháp vào sản xuất trên quy mô lớn.

NVIDIA A100 cũng mang đến nền tảng tăng tốc hơn 1.800 ứng dụng, bao gồm mọi framework cần thiết cho học sâu deep learning. GPU NVIDIA A100 hiện có sẵn ở mọi nơi, từ máy tính để bàn, máy chủ, siêu máy tính đến các dịch vụ đám mây, mang lại cả hiệu suất hoạt động ấn tượng và tiết kiệm chi phí, phù hợp với nhiều nhu cầu sử dụng khác nhau của bạn và doanh nghiệp

NVIDIA A100 cũng mang đến nền tảng tăng tốc hơn 1.800 ứng dụng, bao gồm mọi framework cần thiết cho học sâu deep learning. GPU NVIDIA A100 hiện có sẵn ở mọi nơi, từ máy tính để bàn, máy chủ, siêu máy tính đến các dịch vụ đám mây, mang lại cả hiệu suất hoạt động ấn tượng và tiết kiệm chi phí, phù hợp với nhiều nhu cầu sử dụng khác nhau của bạn và doanh nghiệp

DEEP LEARNING TRAINING

Các mô hình AI đang bùng nổ về mức độ phức tạp khi chúng thực hiện các thử thách cấp độ tiếp theo như AI đàm thoại. Để Đào tạo chúng cần đòi hỏi sức mạnh tính toán lớn và khả năng mở rộng cao nhất có thể. NVIDIA A100 Tensor Cores với Tensor Float (TF32) cung cấp hiệu suất cao hơn gấp 20 lần so với NVIDIA Volta và tăng thêm 2 lần với độ chính xác hỗn hợp tự động và FP16. Khi kết hợp với NVIDIA ® NVLink ® , NVIDIA NVSwitch ™ , PCI Gen4, NVIDIA Mellanox InfiniBand và NVIDIA Magnum IO SDK, bạn có thể mở rộng quy mô lên hàng nghìn GPU A100.

Một khối lượng công việc đào tạo như BERT có thể được giải quyết trên quy mô dưới một phút bởi 2.048 GPU A100, một kỷ lục thế giới về thời gian để giải quyết một phép toán

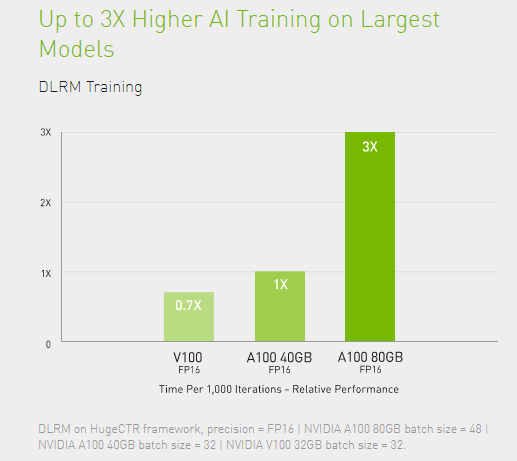

Đối với các mô hình lớn nhất có bảng dữ liệu khổng lồ như mô hình đề xuất học sâu (DLRM), A100 80GB đạt tới 1,3 TB bộ nhớ hợp nhất cho mỗi nút và tăng thông lượng gấp 3 lần so với A100 40GB. NVIDIA dẫn đầu trong MLPerf , thiết lập nhiều kỷ lục hiệu suất trong tiêu chuẩn toàn ngành về đào tạo AI.

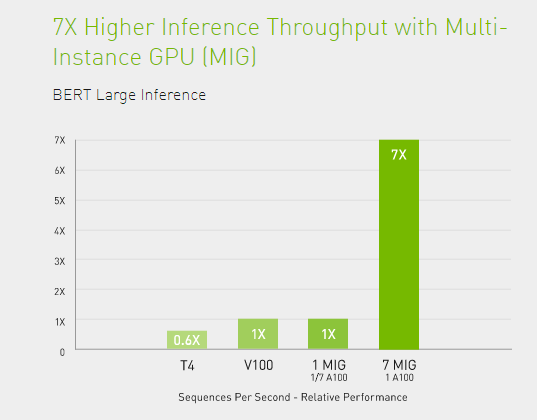

DEEP LEARNING INFERENCE

NVIDIA A100 giới thiệu các tính năng đột phá để tối ưu hóa khối lượng công việc suy luận. Nó tăng tốc độ chính xác đầy đủ, từ FP32 đến INT4. Công nghệ GPU đa trường hợp (MIG) cho phép nhiều mạng hoạt động đồng thời trên một A100 duy nhất để sử dụng tối đa và tối ưu tài nguyên máy tính. Và hỗ trợ cấu trúc thưa thớt mang lại hiệu suất cao hơn gấp 2 lần so với mức tăng hiệu suất suy luận khác của A100.

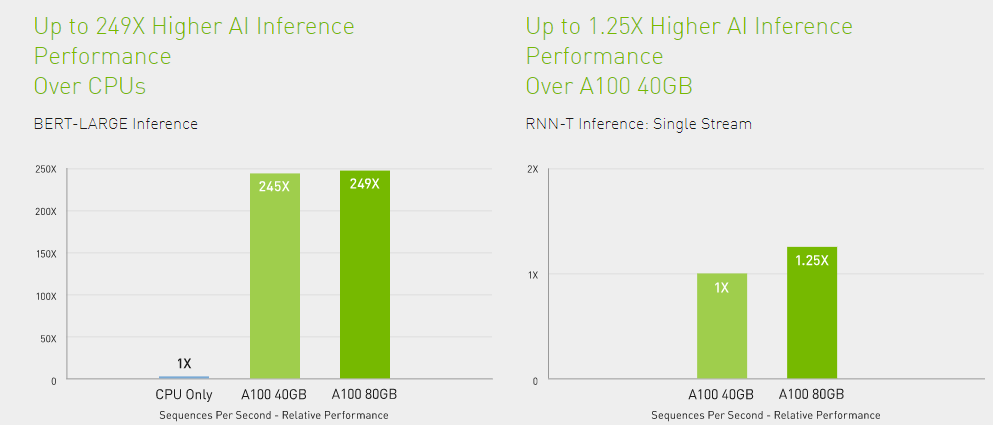

Trên các mô hình AI hội thoại hiện đại như BERT, NVIDIA A100 tăng tốc thông lượng suy luận lên đến 249 lần so với CPU.

Trên các mô hình phức tạp nhất bị giới hạn kích thước hàng loạt như RNN-T để nhận dạng giọng nói tự động, dung lượng bộ nhớ tăng lên của A100 80GB tăng gấp đôi kích thước của mỗi MIG và mang lại thông lượng cao hơn tới 1,25 lần so với A100 40GB. Và hiệu suất dẫn đầu thị trường của NVIDIA đã được chứng minh trong MLPerf Inference của NVIDIA

HIGH-PERFORMANCE COMPUTING

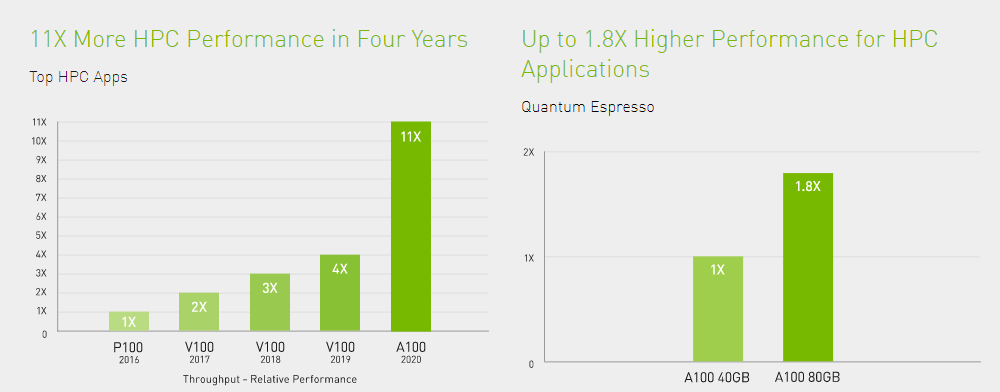

Để mở ra những khám phá điều mới mẻ trong thế hệ mới , các nhà khoa học tìm đến các mô phỏng để hiểu rõ hơn về thế giới xung quanh chúng ta. NVIDIA A100 giới thiệu Lõi Tensor với độ chính xác gấp đôi để mang lại bước nhảy vọt lớn nhất về hiệu suất HPC kể từ khi GPU ra đời. Kết hợp với 80GB bộ nhớ GPU nhanh nhất, các nhà nghiên cứu có thể giảm 10 giờ mô phỏng với tính chính xác gấp đôi xuống dưới 4 giờ trên GPU A100. Các ứng dụng HPC cũng có thể tận dụng TF32 để đạt được thông lượng cao hơn tới 11 lần cho các hoạt động nhân ma trận dày đặc.

Đối với các ứng dụng HPC có bộ dữ liệu lớn nhất, bộ nhớ bổ sung của A100 80GB giúp tăng thông lượng lên gấp 2 lần với Quantum Espresso, một mô phỏng vật liệu. Bộ nhớ lớn và băng thông bộ nhớ tốc độ cao này làm cho A100 80GB trở thành nền tảng lý tưởng cho khối lượng công việc thế hệ tiếp theo.

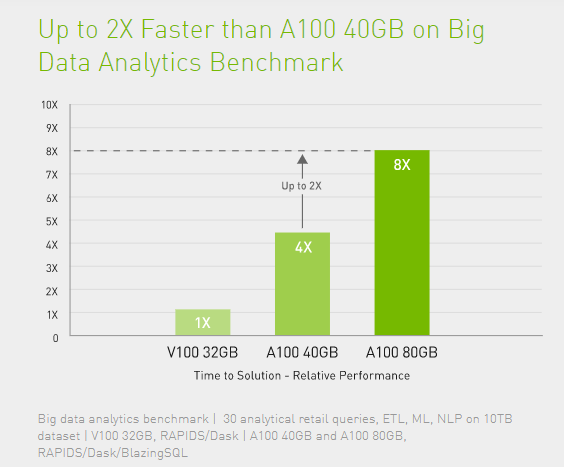

HIGH-PERFORMANCE DATA ANALYTICS

Các nhà khoa học dữ liệu cần có khả năng phân tích, hình dung và biến các bộ dữ liệu khổng lồ thành thông tin chi tiết. Nhưng các giải pháp mở rộng quy mô thường bị sa lầy bởi các bộ dữ liệu nằm rải rác trên nhiều máy chủ.

Máy chủ GPU được tăng tốc với NVIDIA A100 cung cấp sức mạnh tính toán cần thiết cùng với bộ nhớ lớn, băng thông bộ nhớ trên 2 TB / giây và khả năng mở rộng với NVIDIA NVLink và NVSwitch ™ , để giải quyết các khối lượng công việc này. Được kết hợp với InfiniBand, NVIDIA Magnum IO ™ và bộ thư viện mã nguồn mở RAPIDS ™ , bao gồm RAPIDS Accelerator cho Apache Spark để phân tích dữ liệu tăng tốc GPU, nền tảng trung tâm dữ liệu NVIDIA tăng tốc khối lượng công việc khổng lồ này ở mức hiệu suất và hiệu suất chưa từng có.

Trên điểm chuẩn phân tích dữ liệu lớn, A100 80GB cung cấp thông tin chi tiết với mức tăng gấp 2 lần so với A100 40GB, khiến nó trở nên lý tưởng cho các khối lượng công việc mới nổi với kích thước tập dữ liệu bùng nổ.

ENTERPRISE-READY UTILIZATION

GPU NVIDIA A100 với MIG giúp tối đa hóa việc sử dụng cơ sở hạ tầng tăng tốc GPU. Với MIG, GPU A100 có thể được phân chia thành bảy phiên bản độc lập, cho phép nhiều người dùng truy cập vào khả năng tăng tốc GPU. Với A100 40GB, mỗi phiên bản MIG có thể được phân bổ tối đa 5GB và với dung lượng bộ nhớ tăng lên 80GB của A100, kích thước đó được tăng gấp đôi lên 10GB.

MIG hoạt động với Kubernetes, vùng chứa và ảo hóa máy chủ dựa trên siêu giám sát . MIG cho phép các nhà quản lý cơ sở hạ tầng cung cấp một GPU có kích thước phù hợp với chất lượng dịch vụ (QoS) được đảm bảo cho mọi công việc, mở rộng phạm vi tiếp cận của các tài nguyên máy tính tăng tốc cho mọi người dùng.

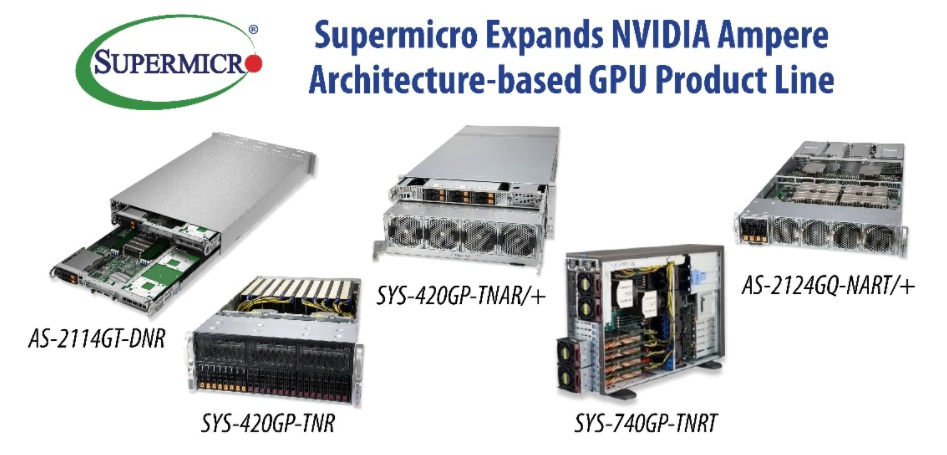

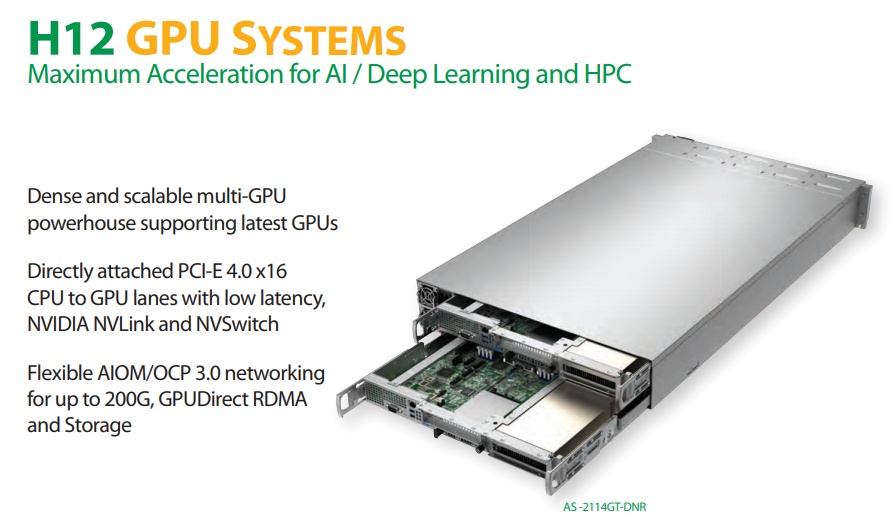

SUPERMICRO GPU Server tối ưu hóa cho GPU NVIDIA A100 PCIe

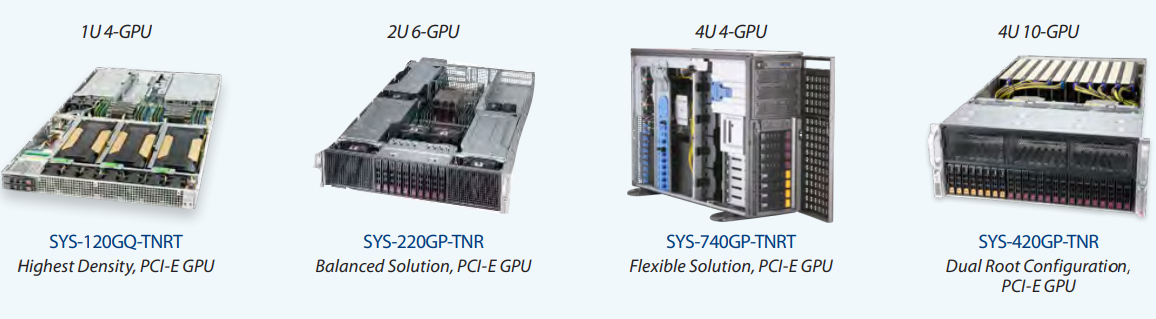

Ngay sau sự kiện ra mắt dòng máy chủ DGX A100 và GPU A100 của NVIDIA, Supermicro cũng đã công bố loạt máy chủ GPU cho Data Center của mình với hiệu năng dẫn đầu ngành. Đây là các hệ thống đào tạo AI mạnh mẽ nhất với các nền tảng GPU NVIDIA A100 mới ra mắt. Các hệ thống mới này tận dụng công nghệ NVIDIA AMPERE mới nhất, hỗ trợ đầy đủ cho GPU NVIDIA A100™ Tensor Core trên các máy chủ GPU của Supermicro với các hệ thống 1U, 2U và 4U dành cho Data Center.

Charles Liang, giám đốc điều hành và chủ tịch của Supermicro cho biết: Khi thị trường điện toán tăng tốc bằng GPU phát triển và tiếp tục chuyển dịch trong các trung tâm dữ liệu, Supermicro sẽ cung cấp cho khách hàng những hệ thống mới nhất cùng các công nghệ tiên tiến nhất để giúp họ đạt được khả năng tăng tốc tối đa ở mọi quy mô, tối ưu hóa việc sử dụng GPU. Những hệ thống mới này sẽ giúp gia tăng đáng kể hiệu suất cho các workload được tăng tốc ở các hệ thống HPC, phân tích dữ liệu, đào tạo học sâu, suy luận học sâu và trí tuệ nhân tạo.

Do đó, Khách hàng có thể mong đợi một sự gia tăng hiệu suất đáng kể trên toàn bộ danh mục máy chủ đa GPU của Supermicro khi chúng được trang bị GPU NVIDIA A100 PCIe mới. Danh mục sản phẩm này trải dài từ các hệ thống có form factor từ 1U cho đến 4U hay cả 8U, ngoài ra còn có cả dạng tháp Tower để phù hợp cho việc đặt hệ thống tại office của một số doanh nghiệp, chúng hỗ trợ cho bạn có thể lắp đặt và sử dụng từ 1 đến 10 GPU NVIDIA A100 PCIe trên 1 system duy nhất, giúp bạn tùy chọn linh hoạt về cấu hình của hệ thống và phù hợp với nhu cầu về AI của bạn và doanh nghiệp hơn…Để tăng tốc tối đa, hệ thống GPU Server mới của Supermicro hỗ trợ tối đa 10 GPU A100 PCIe thông qua các lane dữ liệu CPU-GPU-GPU-PCI-E 4.0 x16 gắn trực tiếp mà không cần chuyển đổi PCI-E với độ trễ thấp nhất và băng thông cao nhất. Những hệ thống này cũng các khe cắm mở rộng PCI-E 4.0 hiệu suất cao cho nhiều mục đích sử dụng khác nhau như kết nối mạng hiệu suất cao lên đến 100G-200G hay các thẻ mở rộng khác, nhằm tối đa hoa hiệu suất hoạt động của các hệ thống AI cần có hiện nay.

Và đặc biệt là chúng được hỗ trợ trên cả hai platform là Intel Xeon Scalable và AMD EYPC 7000 Series hiệu suất cao.

Về platform là Intel Xeon Scalable, GPU System của Supermicro đã có các SKU cho Intel Xeon Scalable Gen 3 mới nhất của Intel với thế hệ sản phẩm X12 hiệu năng cao. Điểm qua các Supermicro X12 GPU Server thì ta có SYS-120GQ-TNRT, thiết kế dạng rackmount 1U tiêu chuẩn, hỗ trợ Dual CPU Intel Xeon Scalable Gen 3 và có thể lắp được được 4 GPU NVIDIA A100 PCIe 40GB hoặc 80GB bộ nhớ Memory.

Cải tiến hơn một chút là SYS-220GP-TNR với thiết kế 2U, bạn có thể lắp đặt tối đa 6 GPU NVIDIA A100 PCIe trên một system 220GP-TNR này. Với nhu cầu mật độ GPU NVIDIA A100 PCIe nhiều hơn nữa, có thể từ 8-10 card thì Supermicro có system SYS-420GP-TNR, hỗ trợ tối đa lên đên 10 GPU NVIDIA A100 PCIe, cùng với đó là Dual CPU Intel Xeon Scalable Gen 3, hiệu suất lên đến 40 Cores/80 Threads trên một CPU, bộ nhớ Memory DDR4 hỗ trợ lên đến 12TB mang đến khả năng xử lý đa nhiệm tốc độ cao cho hệ thống AI của bạn, cùng với đó là khả năng lưu trữ mật độ cao với 24 ổ cứng HDD/SSD 2.5″ SAS/SATA/NVME, cung cấp khả năng lưu trữ lên đến gần 200TB, kết hợp sử dụng SSD NVME PCIE 4.0 nhằm tối đa hóa về hiệu suất lưu trữ tốc độ cao và độ trễ thấp, mang đến một giải pháp hoàn chỉnh cho hạ tầng AI kết hợp với BigData của bạn và doanh nghiệp.

Ngoài ra, X12 Supermicro còn có SYS-740GP-TNRT, thiết kế theo dạng tháp tower nhỏ gọn, có thể lắp đặt và sử dụng ở văn phòng làm việc của bạn, giúp tiết kiệm TCO về cơ sở vật chất Data Center, 740GP-TNRT,cung cấp hiệu suất mạnh mẽ với 2 CPU Intel Xeon Scalable Gen 3, bộ nhớ Memory lên đến 6TB DDR4 3200Mhz, và kết nối được 4 GPU NVIDIA A100 PCIe hiệu suất cao, phù hợp cho nhiều yêu cầu về AI của các doanh nghiệp hiện nay mà lại tiết kiệm được chi phí đầu tư về Data Center.

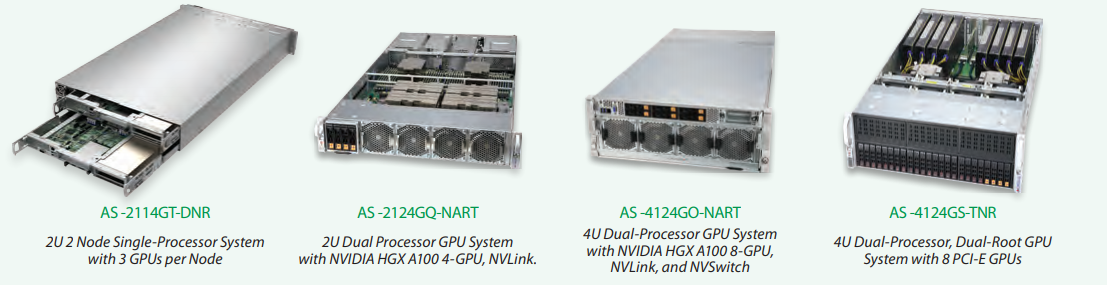

Cùng với X12 Server dựa trên nền tảng Intel Xeon Scalable Gen 3 thì GPU Server của Supermicro còn có các system hoạt động trên nền tảng EPYC 7000 Series của AMD, với nền tảng EPYC 7000 Series và mới nhất là 7003, AMD và Supermicro mang đến cho các khách hàng những sản phẩm GPU Server hiệu năng cực khủng, hỗ trợ lên đến 128 Cores/256 Threads, bộ nhớ RAM Memory hỗ trợ lên đến 8TB tốc độ cao 3200Mhz và khả năng lưu trữ linh hoạt với ổ cứng HDD/SSD mật độ cao và tốc độ nhanh chóng, và đặc biệt là khả năng kết nối linh hoạt các GPU NVIDIA A100 PCIe hiệu suất caom, từ đó mang đến một hệ thống hoàn chỉnh với hiệu suất và khả năng tính toán mạnh mẽ, giúp đáp ứng gần như là tất cả các workloads, applications chuyên dụng và tối ưu cho các hạ tầng về AI, HPC hiện nay của các doanh nghiệp.

Điểm qua một chút thì ta có AS -2114GT-DNR, thiết kế dạng Twin Dual-nodes với kích thước 2U tiêu chuẩn, 2114GT-DNR mang đến khả năng lắp đặt tối đa 3 GPU NVIDIA A100 PCIe cho mỗi node (total 6 GPU NVIDIA A100 PCIe). Với thiết kế dạng Twin, 2114GT-DNR còn giúp cho doanh nghiệp của bạn tiết kiệm thêm về chi phí cơ sở hạ tầng Data Center với thiết kế nhiều nodes của mình. Mật độ sử dụng nhiều GPU NVIDIA A100 PCIe hơn nữa thì có AS -4124GS-TNR, với khả năng hỗ trợ lên đến 8 GPU NVIDIA A100 PCIe trong một thiết kế 4U rackmount tiêu chuẩn Data Center, mang đến hiệu suất CPU 128 Cores/256 Threads, bộ nhớ RAM Memory hỗ trợ lên đến 8TB tốc độ cao 3200Mhz….Cung cấp một hệ thống AI mạnh mẽ nhất cho bạn với một mức đầu tư hợp lý và hiệu quả.

Và những GPU Server X12 và H12 trên của Supermicro đều đã được chứng thực bởi NVIDIA – Cerfified, để cung cấp một bộ giải pháp linh hoạt để hỗ trợ GPU NVIDIA NGC và NVIDIA A100, cho phép phát triển và phân phối AI để chạy các mô hình AI nhỏ và lớn. Sử dụng GPU NVIDIA A100 có hiệu suất cao nhất, các nhà phát triển giảm thiểu thời gian quý báu để chạy các mô hình AI của họ, cung cấp các tính năng AI nhanh chóng và hiệu quả về chi phí vào các sản phẩm và dịch vụ mới và hiện có, từ đó mang đến các hệ thống về AI/HPC mạnh mẽ và hiệu quả cho các doanh nghiệp dầu tư và sử dụng.

Ngoài những GPU System X12 và H12 thế hệ mới trên, danh mục GPU Server hỗ trợ và sử dụng tốt GPU NVIDIA A100 còn có rất nhiều sản phẩm thuộc thế hệ X11 với Intel Xeon Scalable Gen 1 & 2 hay H11 AMD EPYC 7001/7002 khác, chúng có nhiều cấu hình tùy chọn khác nhau, cùng khả năng hỗ trợ Multi-GPU, giúp bạn có thêm nhiều lựa chọn hơn nữa khi đầu tư và xây dựng hệ thống AI của mình với sức mạnh chủ đạo là GPU NVIDIA A100 PCIe.

Cấu hình tham khảo

Các máy chủ Supermicro phù hợp lắp đặt card GPU NVIDIA A100 PCIe được Thế Giới Máy Chủ lựa chọn.

| Mã | System | CPU | RAM | SSD"}">SSD | GPU | Ghi chú | Giá |

| 6029UTR4T-02A100 | SYS-6029U-TR4T | 2x Gold 5218R | 128GB | 2x 480GB | 2x NVIDIA A100 | Option Cable Power + GPU Kit | |

| 6029UTR4-02A100 | SYS-6029U-TR4 | 2x Gold 5218R | 128GB | 2x 480GB | 2x NVIDIA A100 | Option Cable Power + GPU Kit | |

| 6029UTRT-02A100 | SYS-6029U-TRT | 2x Gold 5218R | 128GB | 2x 480GB | 2x NVIDIA A100 | Option Cable Power + GPU Kit | |

| 6029UTRTP-02A100 | SYS-6029U-TRTP | 2x Gold 5218R | 128GB | 2x 480GB | 2x NVIDIA A100 | Option Cable Power + GPU Kit | |

| 6029UTR25M-02A100 | SYS-6029U-TR25M | 2x Gold 5218R | 128GB | 2x 480GB | 2x NVIDIA A100 | Option Cable Power + GPU Kit | |

| 6029UE1CR4T-02A100 | SYS-6029U-E1CR4T | 2x Gold 5218R | 128GB | 2x 480GB | 2x NVIDIA A100 | Option Cable Power + GPU Kit | |

| 6029UE1CR4-02A100 | SYS-6029U-E1CR4 | 2x Gold 5218R | 128GB | 2x 480GB | 2x NVIDIA A100 | Option Cable Power + GPU Kit | |

| 6029UE1CRT-02A100 | SYS-6029U-E1CRT | 2x Gold 5218R | 128GB | 2x 480GB | 2x NVIDIA A100 | Option Cable Power + GPU Kit | |

| 6029UE1CRTP-02A100 | SYS-6029U-E1CRTP | 2x Gold 5218R | 128GB | 2x 480GB | 2x NVIDIA A100 | Option Cable Power + GPU Kit | |

| 6029UE1CR25M-02A100 | SYS-6029U-E1CR25M | 2x Gold 5218R | 128GB | 2x 480GB | 2x NVIDIA A100 | Option Cable Power + GPU Kit | |

| 2029UTR4T-02A100 | SYS-2029U-TR4T | 2x Gold 5218R | 128GB | 2x 480GB | 2x NVIDIA A100 | Option Cable Power + GPU Kit | |

| 2029UTR4-02A100 | SYS-2029U-TR4 | 2x Gold 5218R | 128GB | 2x 480GB | 2x NVIDIA A100 | Option Cable Power + GPU Kit | |

| 2029UTRT-02A100 | SYS-2029U-TRT | 2x Gold 5218R | 128GB | 2x 480GB | 2x NVIDIA A100 | Option Cable Power + GPU Kit | |

| 2029UTRTP-02A100 | SYS-2029U-TRTP | 2x Gold 5218R | 128GB | 2x 480GB | 2x NVIDIA A100 | Option Cable Power + GPU Kit | |

| 2029UTR25M-02A100 | SYS-2029U-TR25M | 2x Gold 5218R | 128GB | 2x 480GB | 2x NVIDIA A100 | Option Cable Power + GPU Kit | |

| 2029UE1CR4T-02A100 | SYS-2029U-E1CR4T | 2x Gold 5218R | 128GB | 2x 480GB | 2x NVIDIA A100 | Option Cable Power + GPU Kit | |

| 2029UE1CR4-02A100 | SYS-2029U-E1CR4 | 2x Gold 5218R | 128GB | 2x 480GB | 2x NVIDIA A100 | Option Cable Power + GPU Kit | |

| 2029UE1CRT-02A100 | SYS-2029U-E1CRT | 2x Gold 5218R | 128GB | 2x 480GB | 2x NVIDIA A100 | Option Cable Power + GPU Kit | |

| 2029UE1CRTP-02A100 | SYS-2029U-E1CRTP | 2x Gold 5218R | 128GB | 2x 480GB | 2x NVIDIA A100 | Option Cable Power + GPU Kit | |

| 2029UE1CR25M-02A100 | SYS-2029U-E1CR25M | 2x Gold 5218R | 128GB | 2x 480GB | 2x NVIDIA A100 | Option Cable Power + GPU Kit | |

| 2029UTN24R4T-02A100 | SYS-2029U-TN24R4T | 2x Gold 5218R | 128GB | 2x 480GB | 2x NVIDIA A100 | Option Cable Power + GPU Kit | |

| 2024USTRT-02A40 | AS-2024US-TRT | 2x Milan 7313 | 128GB | 2x 480GB | 2x NVIDIA A40 | Option Cable Power + GPU Kit | |

| 2024USTRT-02A100 | AS-2024US-TRT | 2x Milan 7313 | 128GB | 2x 480GB | 2x NVIDIA A100 | Option Cable Power + GPU Kit | |

| 120GQTNRT-02A100 | SYS-120GQ-TNRT | 2x Gold 5320 | 256GB | 2x 480GB | 4x NVIDIA A100 | ||

| 7049GPTRT-04A100 | SYS-7049GP-TRT | 2x Gold 5218R | 256GB | 2x 480GB | 4x NVIDIA A100 | ||

| 740GPTNRT-04A100 | SYS-740GP-TNRT | 2x Silver 4316 | 256GB | 2x 480GB | 4x NVIDIA A100 | ||

| 120GQTNRT-04A40 | SYS-120GQ-TNRT | 2x Silver 4316 | 128GB | 2x 480GB | 4x NVIDIA A40 | ||

| 2114GT-DNR-06A40 | AS-2114GT-DNR | 2x Milan 7313 | 256GB | 2x 480GB | 6x NVIDIA A100 | ||

| 2029GPTR-06A40 | SYS-2029GP-TR | 2x Gold 5218R | 512GB | 2x 480GB | 6x NVIDIA A100 | Option SIOM Card | |

| 220GPTNR-06A100 | SYS-220GP-TNR | 2x Silver 4316 | 512GB | 2x 480GB | 6x NVIDIA A100 | Option SIOM Card | |

| 4029GPTRT-08A100 | SYS-4029GP-TRT | 2x Gold 5218R | 512GB | 2x 480GB | 8x NVIDIA A100 | ||

| 4029GPTRT3-09A100 | SYS-4029GP-TRT3 | 2x Gold 5218R | 512GB | 2x 480GB | 9x NVIDIA A100 | ||

| 4029GPTRT2-10A100 | SYS-4029GP-TRT2 | 2x Gold 5218R | 512GB | 2x 480GB | 10x NVIDIA A100 | ||

| 420GPTNR-10A100 | SYS-420GP-TNR | 2x Gold 5320 | 512GB | 2x 480GB | 10x NVIDIA A100 | ||

| 4124GSTNR-08A100 | AS-4124GS-TNR | 2x Milan 7443 | 512GB | 2x 480GB | 8x NVIDIA A100 |

→ Xem thêm: Các sản phẩm GPU NVIDIA

Bài viết liên quan

- NVIDIA NGC‑ready Low‑latency Edge AI: Giải pháp cho Retail, Manufacturing và Smart Cities

- So sánh sức mạnh của máy tính AI DGX Spark với các card GPU máy trạm chuyên nghiệp của NVIDIA

- Từ Orin đến Thor: Bước nhảy vọt kiến trúc của NVIDIA JetPack 7.0 và tương lai của robot hình người

- Tại sao gọi NVIDIA DGX Spark là Siêu máy tính AI cá nhân?

- Cơ chế quản lý bộ nhớ trên các nền tảng phần cứng nhất quán – Hardware-coherent

- Kiến trúc NVIDIA Blackwell với GB200 NVL72: Định nghĩa lại điện toán AI cấp độ Exascale