Hầu hết các chuyên gia đều nhận định rằng, không còn đủ công suất điện để xử lý AI trong tương lai tại các trung tâm dữ liệu, cả các nhà cung cấp siêu quy mô và các trung tâm colocation, khi nhu cầu về Generative AI (GenAI) tăng cao.

Nhu cầu năng lượng của AI tạo sinh đang chực chờ “hút” hết công suất của các trung tâm dữ liệu, buộc hầu hết các nhà cung cấp giải pháp AI phải trải rộng quy trình xử lý trên các thiết bị biên và thiết bị doanh nghiệp.

Dữ liệu của ngành cho thấy các nhà cung cấp dịch vụ đám mây và trung tâm colocation đang xây dựng và mở rộng trung tâm dữ liệu cho GenAI sẽ phải hợp tác với các tổ chức phát triển mô hình AI trên các hệ thống tại biên, máy tính doanh nghiệp, điện thoại thông minh và các thiết bị IoT.

Hầu hết các chuyên gia đều nhận định rằng không còn đủ công suất điện còn lại để thực hiện quá trình xử lý AI trong tương lai trong các trung tâm dữ liệu siêu quy mô (hyperscalers).

“Nhu cầu về AI hiện nay là rất lớn” Jacob Albers, người đứng đầu bộ phận Alternative Insights tại công ty dịch vụ bất động sản thương mại Cushman & Wakefield cho biết. “Và tất cả các nhà cung cấp dịch vụ đám mây lớn cũng như các trung tâm dữ liệu khác đang chạy đua để bắt kịp nhu cầu.”

Các nhà cung cấp trung tâm dữ liệu và các hyperscalers ký hợp đồng thuê điện với công suất 36 megawatt — điều hiếm thấy cách đây 5 năm — là chuyện bình thường ngày nay, cùng với hợp đồng thuê 72 MW, theo hãng Datacenterhawk. Việc cho thuê 100 MW không còn là điều xa lạ nữa.

Nhu cầu năng lượng ngày càng tăng do tăng trưởng GenAI dự kiến đã khiến các nhà khai thác trung tâm dữ liệu và các hyperscalers yêu cầu có điện ở bất kỳ khu vực nào có đất xây dựng và đủ băng thông mạng.

“Đang có một cuộc chạy đua về công suất điện rất lớn trong ngành”, Giám đốc điều hành ứng dụng kỹ thuật số Wes Cummins cho biết. “Điện đang được tìm kiếm ở khắp nơi.”

Wes Cummins Applied Digital, một nhà cung cấp trung tâm dữ liệu cho AI và điện toán hiệu năng cao (HPC), đã đưa ra chiến lược của họ là tìm kiếm năng lượng tái tạo – gió, thủy điện hoặc năng lượng mặt trời – được xây dựng bằng nguồn vốn từ dự luật về khí hậu mà Tổng thống Joe Biden đã ký năm ngoái.

Phó chủ tịch kỹ thuật của DataBank cho biết, kế hoạch của họ là chỉ xây dựng mới các cơ sở có mật độ cao cho HPC và GenAI. Các trung tâm dữ liệu này thường xuyên cung cấp 30W và 40W cho mỗi rack máy chủ do khách hàng lắp đặt. Đó là gần gấp đôi sức mạnh của rack truyền thống.

“Có lẽ yếu tố lớn nhất vào thời điểm này là: ‘Liệu có đủ điện không?’ ” Swartz nói. “Những người đứng đầu là những người có thể đảm bảo cung cấp đủ điện cho các máy chủ.”

Barry Buck, lãnh đạo tiếp thị của công ty xây dựng trung tâm dữ liệu DPR Construction cho biết, nhu cầu tính toán dựa trên AI đã tăng chậm trong 9 đến 12 tháng qua. Hạ tầng hiện tại đã đáp ứng được nhu cầu công suất điện của khách hàng, nhưng DPR nhận thấy các công ty đang phải xây dựng các địa điểm bên ngoài trung tâm dữ liệu chính của họ.

“Thiếu điện đã là một vấn đề ở các khu vực địa lý chính đối với nhu cầu điện toán truyền thống. Và chúng tôi đang thấy khách hàng xây dựng ở các khu vực địa lý cấp hai và cấp ba, nơi có nguồn điện sẵn sàng hơn”, Buck nói.

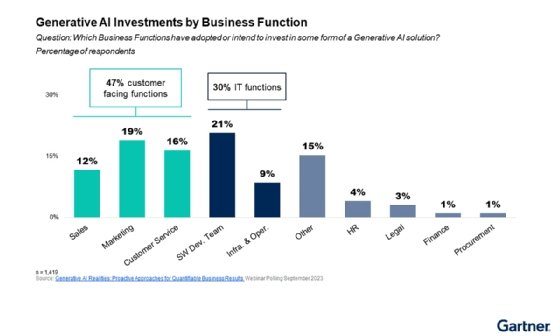

Gartner dự đoán hơn 80% doanh nghiệp sẽ sử dụng API, model và/hoặc ứng dụng GenAI vào năm 2026, tăng từ mức dưới 5% trong năm nay.

Các model được thu nhỏ cho biên

Jim McGregor, nhà phân tích và đối tác tại Tirias Research, không hiểu các nhà cung cấp điện sẽ đáp ứng nhu cầu về hạ tầng trung tâm dữ liệu tập trung vào AI như thế nào trong khi đang phải cấp điện cho người tiêu dùng và doanh nghiệp. Tirias dự đoán rằng với tốc độ triển khai hiện tại, chi phí hạ tầng GenAI sẽ vượt quá 76 tỷ USD mỗi năm vào năm 2028 và tiêu thụ 4,25 gigawatt, gần một nửa lượng điện năng sử dụng dự kiến bởi các trung tâm dữ liệu của Hoa Kỳ trong năm nay.

“Tổng chi phí sở hữu là rất lớn”, McGregor nói. “Tuy nhiên, mỗi khi chúng tôi gặp phải một thách thức kỹ thuật như thế này, sẽ có một sự thay đổi trong mô hình kinh doanh để vượt qua nó.”

Phản ứng của ngành công nghệ đối với các hạn chế về điện năng là xây dựng và đào tạo các mô hình ngôn ngữ lớn GenAI trong trung tâm dữ liệu AI và phân phối các mô hình có kích thước nhỏ chỉ để suy luận, xử lý dữ liệu thời gian thực, để trả lời các truy vấn hoặc thực hiện các tác vụ.

Albers cho biết các nhà cung cấp trung tâm dữ liệu và các hyperscalers đang triển khai các cơ sở có công suất từ 100 KW đến 5 MW để chạy các mô hình suy luận. DatacenterHawk báo cáo nhận thấy việc xây dựng công suất biên từ 1 MW đến 5 MW cho tải xử lý AI tại các thị trường như New Jersey, Houston và Minneapolis.

Các tổ chức xây dựng mô hình ngôn ngữ nhỏ có khả năng chạy ở biên bao gồm Abacus.AI, Cerebras và MosaicML, thuộc sở hữu của công ty khởi nghiệp quản lý và lưu trữ dữ liệu Databricks. Vào tháng 3, nhóm nghiên cứu Large Model Systems Organization đã giới thiệu Vicuna-13B, một chatbot mã nguồn mở được đào tạo trên 13 tỷ tham số, dữ liệu lịch sử được sử dụng để đào tạo các mô hình AI .

McGregor cho biết, các mô hình được đào tạo với ít hơn 50 tỷ tham số có thể chạy trên nhiều thiết bị biên và mang lại cơ hội tốt nhất để thực hiện xử lý GenAI.

“Tôi nghĩ điều tốt nhất chúng ta có thể làm hôm nay là tối ưu hóa và thu nhỏ các mô hình nhiều nhất có thể để giảm tải chúng khỏi các trung tâm dữ liệu”, ông nói.

Các nhà sản xuất chip PC đang chuẩn bị thực hiện xử lý GenAI trên máy tính của công ty để cung cấp phản hồi nhanh hơn cho các truy vấn. AMD và Intel gần đây đã giới thiệu CPU x86 và Qualcomm cũng đã ra mắt Snapdragon X Elite dựa trên Arm dành cho hệ thống suy luận AI trên PC, dự kiến sẽ được tung ra vào giữa năm 2024.

Nvidia đã lên kế hoạch ra mắt CPU dựa trên Arm để chạy hệ điều hành Windows của Microsoft, bao gồm trợ lý Copilot AI của họ.

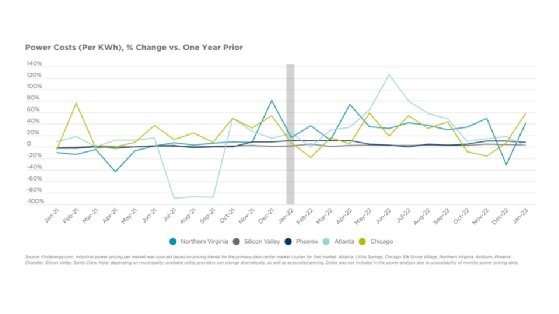

Chi phí điện năng là một nhân tố trong việc phổ biến AI trên các thiết bị biên và doanh nghiệp.

Doanh nghiệp chuẩn bị cho AI

“Đang có một cuộc tranh giành quyền lực lớn trong ngành. Mọi người đang tìm kiếm điện ở khắp mọi nơi.” – Giám đốc điều hành Ứng dụng kỹ thuật số của Wes Cummins.

Ngày nay, các doanh nghiệp chủ yếu thử nghiệm các dịch vụ và công nghệ GenAI khác nhau để xác định giá trị cũng như tác động của chúng đối với quyền riêng tư và bảo mật dữ liệu. Tuy nhiên, Gartner dự đoán rằng tỷ lệ doanh nghiệp sử dụng API, mô hình hoặc ứng dụng GenAI ở cấp độ production sẽ tăng từ khoảng 5% hiện tại lên hơn 80% trong năm 2026.

IDC dự kiến chi tiêu của doanh nghiệp cho phần mềm AI, hạ tầng phần cứng và dịch vụ CNTT sẽ tăng từ gần 16 tỷ USD trong năm nay lên 143 tỷ USD vào năm 2027. Đó là gấp đôi tỷ lệ chi tiêu cho AI tổng thể và cao hơn 13 lần so với tốc độ tăng trưởng hàng năm về chi tiêu cho CNTT toàn cầu.

Tỷ lệ áp dụng khổng lồ như vậy sẽ làm rung chuyển thị trường trung tâm dữ liệu và tạo ra các kiến trúc mới trải dài khắp biên giới, các thiết bị IoT, PC và thậm chí cả điện thoại thông minh.

“Chúng tôi biết [sự thay đổi] đang đến. Chỉ có điều, chưa chứng kiến rất nhiều thứ như thế mà thôi”, Buck nói.

Nguồn Tech Target

Bài viết liên quan

- Giới thiệu giải pháp Training AI trên các máy chủ thông dụng

- PowerScale: Nền tảng kiến trúc cho các tác vụ Generative AI

- NVIDIA Hopper tiếp tục dẫn đầu hiệu suất Generative AI trong MLPerf

- NVIDIA hỗ trợ hành trình hướng tới Generative AI thuận lợi hơn cho các doanh nghiệp

- NVIDIA NIM: Vi dịch vụ suy luận tối ưu hóa cho triển khai mô hình AI quy mô lớn

- Đơn giản hóa phát triển Generative AI tuỳ chỉnh với NVIDIA NeMo Microservices