GPU được gọi là những “kim loại hiếm” của trái đất, thậm chí có thể gọi là “vàng” đối với Trí tuệ Nhân tạo, bởi vì chúng là nền tảng cho kỷ nguyên AI tạo sinh (Generative AI) ngày nay.

Ba lý do về mặt kỹ thuật và nhiều câu chuyện sẽ giải thích tại sao lại như vậy. Mỗi lý do đều có nhiều khía cạnh đáng để tìm hiểu, nhưng ở mức độ cao:

- GPU sử dụng kỹ thuật xử lý song song (parallel processing).

- Các hệ thống GPU mở rộng quy mô lên cấp độ của siêu máy tính.

- Lớp phần mềm GPU dành cho AI rất sâu và rộng.

Kết quả cuối cùng là GPU thực hiện các phép tính kỹ thuật nhanh hơn và có hiệu quả sử dụng năng lượng cao hơn so với CPU. Nghĩa là chúng mang lại hiệu suất hàng đầu cho việc đào tạo và suy luận AI cũng như đạt được lợi ích trên nhiều ứng dụng sử dụng điện toán tăng tốc (accelerated computing).

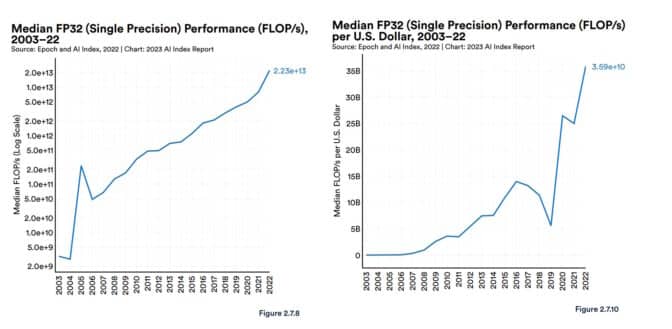

Trong báo cáo gần đây về AI, Human-Centered AI của Stanford đã cung cấp một số bối cảnh. Hiệu suất GPU đã tăng khoảng 7.000 lần kể từ năm 2003 và giá trên hiệu suất là cao hơn 5.600 lần.

Một báo cáo năm 2023 đã ghi nhận sự gia tăng mạnh mẽ về hiệu suất và giá/hiệu suất của GPU.

Báo cáo cũng trích dẫn phân tích từ Epoch, một nhóm nghiên cứu độc lập chuyên đo lường và dự báo những tiến bộ của AI.

“GPU là nền tảng điện toán vượt trội để tăng tốc các tác vụ Học máy (ML) và hầu hết (nếu không phải tất cả) các mô hình lớn nhất trong 5 năm qua đều đã được đào tạo trên các GPU… do đó chúng đã đóng góp tập trung cho sự phát triển gần đây trong lĩnh vực AI” – Epoch cho biết trên website của mình.

Một nghiên cứu năm 2020 đánh giá công nghệ AI đối với chính phủ Hoa Kỳ cũng đưa ra kết luận tương tự.

“Chúng tôi hy vọng các con chip AI hàng đầu sẽ tiết kiệm chi phí hơn từ một đến ba bậc so với các CPU máy chủ hàng đầu khi tính đến chi phí sản xuất và vận hành”.

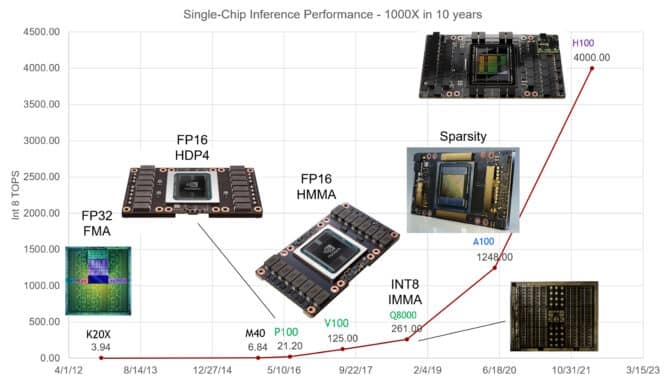

NVIDIA GPU đã tăng hiệu suất suy luận AI lên 1.000 lần trong mười năm qua – Bill Dally, nhà khoa học trưởng của công ty cho biết trong bài phát biểu quan trọng tại Hot Chips, cuộc hội họp thường niên của các kỹ sư hệ thống và bán dẫn.

ChatGPT và tác động lan truyền

ChatGPT đã cung cấp một ví dụ thuyết phục về tác dụng tuyệt vời của GPU đối với AI. Mô hình ngôn ngữ lớn (LLM), được đào tạo và chạy trên hàng nghìn NVIDIA GPU, chạy các dịch vụ GenAI được sử dụng bởi hơn 100 triệu người.

Kể từ khi ra mắt vào năm 2018, MLPerf, điểm chuẩn tiêu chuẩn ngành dành cho AI, đã cung cấp những con số chi tiết về hiệu suất hàng đầu của NVIDIA GPU trên cả đào tạo và suy luận AI.

NVIDIA Grace Hopper Superchips đã vượt qua round mới nhất của các bài test suy luận. NVIDIA TensorRT-LLM, phần mềm suy luận được phát hành kể từ thời điểm đó, mang lại hiệu suất tăng gấp 8 lần và giảm hơn 5 lần mức sử dụng năng lượng cũng như tổng chi phí sở hữu. Quả thực, NVIDIA GPU đã giành chiến thắng trong mọi vòng test suy luận và đào tạo MLPerf kể từ khi điểm chuẩn được phát hành vào năm 2019.

Vào tháng 2, NVIDIA GPU đã mang lại những kết quả suy luận hàng đầu, cung cấp hàng nghìn lần suy luận mỗi giây trên các mô hình có yêu cầu khắt khe nhất trong điểm chuẩn STAC-ML Markets, thước đo hiệu suất công nghệ quan trọng cho ngành dịch vụ tài chính.

Nhóm kỹ sư phần mềm RedHat đã trình bày ngắn gọn điều đó trong một blog: “GPU đã trở thành nền tảng của Trí tuệ nhân tạo”.

AI ở bên trong bức màn

Tìm hiểu một chút ở phía bên trong sẽ cho thấy lý do tại sao GPU và AI tạo nên sự kết hợp mạnh mẽ.

Một mô hình AI, còn được gọi là một mạng nơ-ron nhân tạo, về cơ bản là một món lasagna toán học, được tạo từ lớp này đến lớp khác của các phương trình đại số tuyến tính. Mỗi phương trình thể hiện khả năng một phần dữ liệu có liên quan đến phần khác.

Về phần mình, GPU chứa hàng nghìn lõi, các máy tính cực nhỏ hoạt động song song để xử lý phép toán tạo nên một mô hình AI. Ở cấp độ cao, đây là cách điện toán AI hoạt động.

Tensor Core được tinh chỉnh

Theo thời gian, các kỹ sư của NVIDIA đã điều chỉnh core GPU cho phù hợp với nhu cầu ngày càng tăng của các mô hình AI. Các GPU mới nhất bao gồm các Tensor Core mạnh hơn 60 lần so với các thiết kế thế hệ đầu tiên để xử lý việc sử dụng mạng lưới thần kinh toán học ma trận.

Ngoài ra, các NVIDIA Hopper Tensor Core GPU bao gồm Transformer Engine – có thể tự động điều chỉnh đến độ chính xác tối ưu cần thiết để xử lý các mô hình transformer, lớp mạng thần kinh đã tạo ra Generative AI.

Trong quá trình phát triển, mỗi thế hệ GPU đều có nhiều bộ nhớ hơn và các kỹ thuật được tối ưu hóa để lưu trữ toàn bộ mô hình AI trong một GPU hoặc một bộ GPU duy nhất.

Mô hình phát triển, hệ thống mở rộng

Độ phức tạp của các mô hình AI đang tăng lên gấp 10 lần mỗi năm.

LLM tiên tiến nhất hiện nay, GPT4, chứa hơn một nghìn tỷ tham số, một thước đo về mật độ toán học của nó. Con số này tăng từ mức dưới 100 triệu tham số cho một LLM phổ biến vào năm 2018.

Trong một cuộc nói chuyện gần đây tại Hot Chips, Nhà khoa học trưởng của NVIDIA, Bill Dally, đã mô tả hiệu suất GPU đơn trên suy luận AI đã tăng gấp 1.000 lần trong thập kỷ qua.

Các hệ thống GPU đã bắt kịp tốc độ bằng cách tập hợp các thách thức. Chúng mở rộng quy mô thành các siêu máy tính nhờ vào kết nối nội bộ (interconnect) NVLink và mạng NVIDIA Quantum InfiniBand cực nhanh.

DGX GH200, một siêu máy tính AI có bộ nhớ lớn, kết hợp đến 256 Siêu chip NVIDIA GH200 Grace Hopper thành một GPU với kích cỡ của một trung tâm dữ liệu với 144TB bộ nhớ dùng chung.

Mỗi siêu chip GH200 là một máy chủ đơn lẻ với 72 lõi CPU Arm Neoverse và 4 petaflops hiệu suất AI. Cấu hình hệ thống 4-way Grace Hopper mới đặt trong một compute node đơn lẻ với 288 Arm core, 16 petaflops hiệu suất AI và lên đến 2.3TB bộ nhớ tốc độ cao.

Và các NVIDIA H200 Tensor Core GPU được công bố vào tháng 11, đóng gói lên đến 288GB bộ nhớ công nghệ HBM3e mới nhất.

Phần mềm bao phủ rộng khắp

Một ‘đại dương’ phần mềm GPU ngày càng mở rộng đã phát triển từ năm 2007 để hỗ trợ mọi khía cạnh của AI, từ các tính năng công nghệ chuyên sâu đến các ứng dụng cấp cao.

Nền tảng NVIDIA AI bao gồm hàng trăm thư viện phần mềm và ứng dụng. Ngôn ngữ lập trình CUDA và thư viện cuDNN-X dành cho Học sâu (DL) cung cấp nền tảng để các nhà phát triển tạo ra phần mềm như NVIDIA NeMo, một framework cho phép người dùng xây dựng, tùy chỉnh và chạy suy luận trên các mô hình GenAI của riêng họ.

Nhiều thành phần trong số này có sẵn dưới dạng phần mềm nguồn mở, một phần thiết yếu của các nhà phát triển phần mềm. Hơn một trăm trong số chúng được đóng gói vào nền tảng NVIDIA AI Enterprise dành cho các công ty yêu cầu bảo mật và hỗ trợ đầy đủ. Càng ngày, chúng càng có sẵn từ các nhà cung cấp dịch vụ đám mây lớn dưới dạng API và dịch vụ trên NVIDIA DGX Cloud.

SteerLM, một trong những bản cập nhật phần mềm AI mới nhất dành cho các NVIDIA GPU, cho phép người dùng tinh chỉnh các mô hình trong quá trình suy luận.

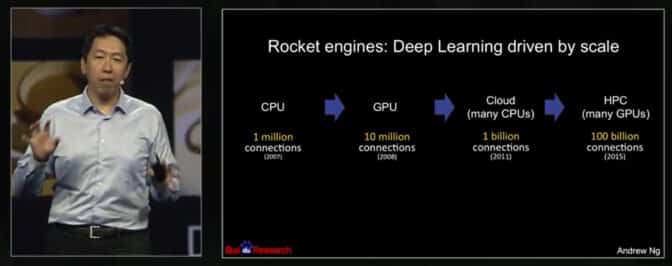

Tăng tốc gấp 70 lần vào năm 2008

Những câu chuyện thành công bắt nguồn từ một bài báo năm 2008 của nhà tiên phong về AI – Andrew Ng, khi đó là nhà nghiên cứu của Stanford. Bằng việc sử dụng hai GPU NVIDIA GeForce GTX 280, nhóm ba người của anh đã đạt được tốc độ tăng gấp 70 lần so với CPU khi xử lý mô hình AI có 100 triệu tham số, hoàn thành công việc mà trước đây phải mất vài tuần chỉ trong một ngày.

Họ báo cáo: “Bộ xử lý đồ họa hiện đại vượt xa khả năng tính toán của CPU đa lõi và có tiềm năng cách mạng hóa khả năng ứng dụng các phương pháp học sâu không giám sát (deep unsupervised learning)”.

Andrew Ng đã mô tả trải nghiệm của mình khi sử dụng GPU cho AI trong buổi trò chuyện tại GTC 2015.

Trong cuộc trò chuyện năm 2015 tại NVIDIA GTC, Ng đã mô tả cách anh tiếp tục sử dụng nhiều GPU hơn để mở rộng quy mô công việc của mình, chạy các mô hình lớn hơn tại Google Brain và Baidu. Sau đó, anh đã giúp thành lập Coursera, một nền tảng giáo dục trực tuyến nơi anh dạy hàng trăm nghìn sinh viên AI.

Ng đề cập đến Geoff Hinton, một trong những cha đỡ đầu của AI hiện đại, trong số những người mà ông đã ảnh hưởng. “Tôi nhớ đã đến gặp Geoff Hinton để nói rằng hãy kiểm tra CUDA, tôi nghĩ nó có thể giúp xây dựng các mạng lưới thần kinh lớn hơn,” anh ấy nói trong buổi trò chuyện tại GTC.

“Năm 2009, tôi nhớ đã có cuộc trò chuyện tại NIPS (nay là NeurIPS), nơi tôi đã nói với khoảng 1.000 nhà nghiên cứu rằng họ nên mua GPU vì GPU sẽ là tương lai của Machine Learning”, Hinton cho biết.

Tiến nhanh với GPU

Lợi ích của AI dự kiến sẽ lan tỏa khắp nền kinh tế toàn cầu.

Một Báo cáo của McKinsey vào tháng 6 ước tính rằng GenAI có thể tăng thêm số tiền tương đương từ 2.6 nghìn tỷ USD đến 4.4 nghìn tỷ USD hàng năm trong 63 trường hợp sử dụng mà nó đã phân tích trong các ngành như ngân hàng, y tế và bán lẻ. Vì vậy, không có gì ngạc nhiên khi báo cáo AI năm 2023 của Stanford cho biết phần lớn các nhà lãnh đạo doanh nghiệp mong muốn tăng cường đầu tư vào AI.

Hiện nay, hơn 40.000 công ty sử dụng NVIDIA GPU cho AI và điện toán tăng tốc, thu hút cộng đồng toàn cầu gồm 4 triệu nhà phát triển. Họ cùng nhau thúc đẩy khoa học, chăm sóc sức khỏe, tài chính và hầu hết mọi ngành công nghiệp.

Trong số những thành tựu mới nhất, NVIDIA đã mô tả mức tăng tốc gấp 700.000 lần khi sử dụng AI để giảm bớt biến đổi khí hậu bằng cách loại bỏ carbon dioxide khỏi khí quyển (xem video bên dưới). Đó là một trong nhiều cách NVIDIA đang áp dụng hiệu suất của GPU vào AI và hơn thế nữa.

Bài viết liên quan

- Giới thiệu giải pháp Training AI trên các máy chủ thông dụng

- PowerScale: Nền tảng kiến trúc cho các tác vụ Generative AI

- Hướng dẫn build một cụm GPU cho AI

- NVIDIA Hopper tiếp tục dẫn đầu hiệu suất Generative AI trong MLPerf

- GDDR6 vs HBM – Định nghĩa các loại bộ nhớ GPU

- NVIDIA hỗ trợ hành trình hướng tới Generative AI thuận lợi hơn cho các doanh nghiệp