GPU A100 của NVIDIA được giới thiệu vào năm ngoái mang lại hiệu suất ưu việt cho các trung tâm dữ liệu đám mây và siêu máy tính, nhưng thiết bị này quá mạnh mẽ và đắt tiền đối với nhiều workload thông thường. Chính vì vậy mà tại sự kiện GTC, NVIDIA đã giới thiệu hai người em cho chiếc GPU đầu bảng, đó là A30 dành cho máy chủ phân tích và AI chính thống, và A10 dành cho các workload đồ họa và tính toán hỗn hợp.

Bảng so sánh GPU trung tâm dữ liệu A100 của Nvidia với 2 phiên bản thấp hơn

| A100 for PCIe | A30 | A10 | |

| FP64 | 9.7 TFLOPS | 5.2 TFLOPS | – |

| FP64 Tensor Core | 19.5 TFLOPS | 10.3 TFLOPS | – |

| FP32 | 19.5 TFLOPS | 10.3 TFLOPS | 31.2 TFLOPS |

| TF32 | 156 TF | 82 TF | 62.5 TFLOPS |

| Bfloat16 | 312 TF | 165 TF | 125 TF |

| FP16 Tensor Core | 312 TF | 165 TF | 125 TF |

| INT8 | 624 TOPS | 330 TOPS | 250 TOPS |

| INT4 | 1248 TOPS | 661 TOPS | 500 TOPS |

| RT Cores | – | – | 72 |

| Memory | 40 GB HBM2 | 24 GB HBM2 | 24 GB GDDR6 |

| Memory Bandwidth | 1,555 GB/s | 933 GB/s | 600 GB/s |

| Interconnect | 12 NVLinks, 600 GB/s | ? NVLinks, 200 GB/s | – |

| Multi-Instance | 7 MIGs @ 5 GB | 4 MIGs @ 6 GB | – |

| Optical Flow Acceleration | – | 1 | – |

| NVJPEG | – | 1 decoder | ? |

| NVENC | – | ? | 1 encoder |

| NVDEC | – | 4 decoders | 1 decoder (+AV1) |

| Form-Factor | FHFL | FHFL | FHFL |

| TDP | 250W | 165W | 150W |

Nvidia A30: Một GPU xử lý cho suy luận AI

Card GPU NVIDIA A30 là đứa em của A100 và dựa trên cùng một kiến trúc Ampere hướng đến các node xử lý chuyên dụng. Nó cũng hỗ trợ các tính năng tương tự, một loạt các phép toán cho AI cũng như các workload HPC (FP64, FP64TF, FP32, TF32, bfloat16, FP16, INT8, INT4) và thậm chí hỗ trợ Multi-Instant GPU (MIG) với phiên bản 6GB. Từ gốc độ hiệu suất, GPU A30 cung cấp hơn 50% hiệu suất của A100, với các chỉ số hiệu năng 10,3 FP32 TFLOPS, 5,2 FP64 TFLOPS và 165 FP16/bfloat16 TFLOPS.

Khi nói đến bộ nhớ, thiết bị được trang bị 24GB DRAM có băng thông 933GB/s (chúng tôi cho rằng NVIDIA sử dụng ba lớp HBM2 với tốc độ khoảng 2,4 GT/s, nhưng công ty chưa xác nhận điều này). Hệ thống con bộ nhớ dường như thiếu sự hỗ trợ cho ECC, đây có thể là một hạn chế đối với những người cần làm việc với bộ dữ liệu lớn. Một cách hiệu quả, NVIDIA muốn những khách hàng này nghĩ đến việc sử dụng A100 đắt tiền hơn.

NVIDIA theo truyền thống không tiết lộ thông số kỹ thuật chính xác của các sản phẩm GPU máy tính của mình khi ra mắt, nhưng chúng tôi nghi ngờ rằng A30 chính xác là ‘một nửa’ của A100 với 3456 lõi CUDA, mặc dù đây là điều chưa được xác nhận tại thời điểm này.

A30 của NVIDIA có kích thước full-height, full-length (FHFL) chiếm hai slot PCIe, với giao diện PCIe 4.0 x16 và TDP 165W, giảm từ 250W trong trường hợp của FHFL A100. Trong khi đó, A30 hỗ trợ một NVLink với tốc độ 200 GB / s (giảm từ 600 GB / s trong trường hợp của A100).

Nvidia A10: GPU cho AI, Đồ họa và Video

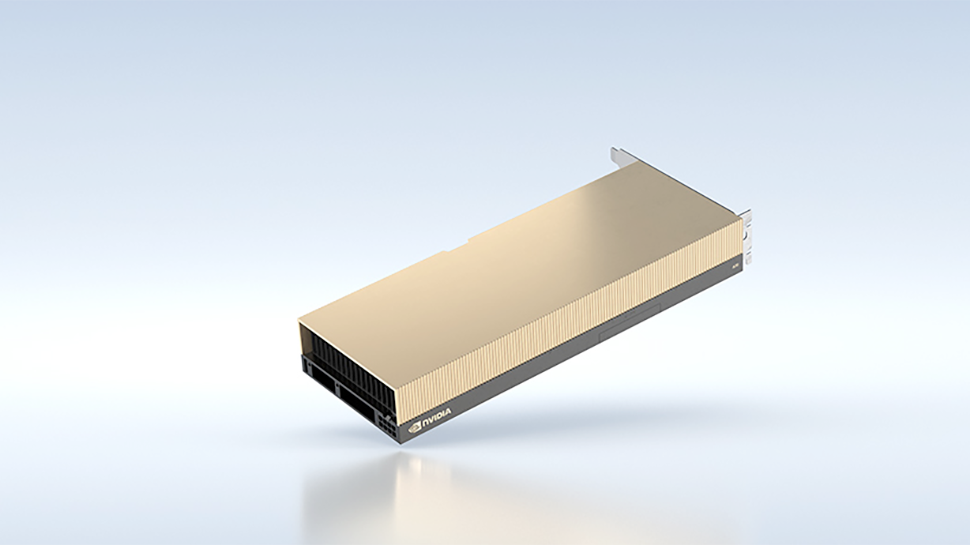

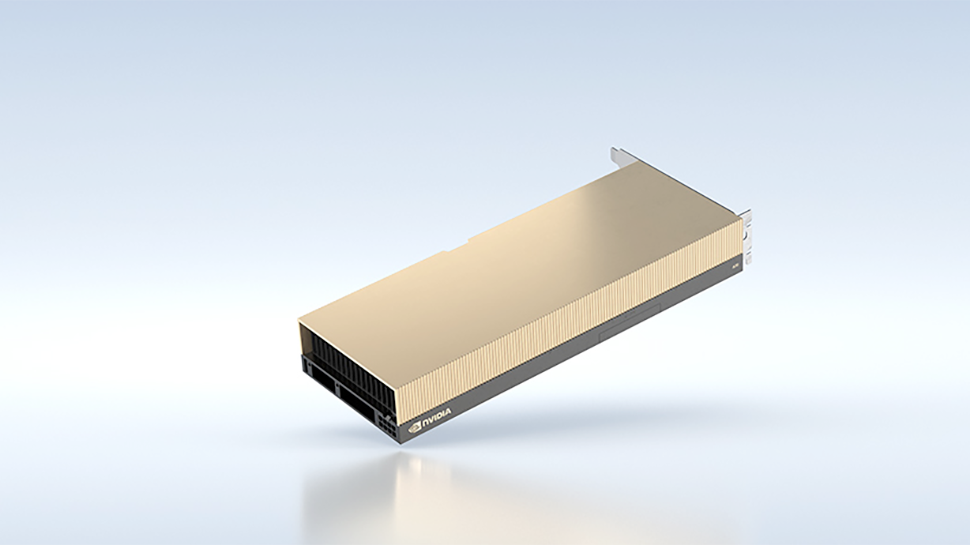

A10 của Nvidia không dựa trên A100 và A30, không hướng đến workload chuyên dụng, mà là một sản phẩm hoàn toàn khác có thể được sử dụng cho đồ họa, suy luận AI và các workload cho encode/decode (transcode) video. A10 hỗ trợ các định dạng FP32, TF32, blfoat16, FP16, INT8 và INT4 cho đồ họa và AI, nhưng không hỗ trợ FP64 cần cho HPC.

A10 là một card đồ họa FHFL một slot với giao diện PCIe 4.0 x16 sẽ cài đặt vào máy chủ chạy phần mềm Nvidia RTX Virtual Workstation (vWS) và cung cấp sức mạnh từ xa cho các máy trạm cần cả khả năng AI và đồ họa. Ở một mức độ lớn hơn, A10 được kỳ vọng là công cụ đắc lực để làm việc từ xa cho những nghệ sỹ, nhà thiết kế, kỹ sư và nhà khoa học (những người không cần FP64).

A10 của NVIDIA dường như dựa trên GA102 silicon, nhưng vì nó hỗ trợ các phân vùng INT8 và INT4, đây thực chất là cùng một bộ xử lý cung cấp sức mạnh cho GeForce RTX 3080/3090 và RTX A6000 của NVIDIA. Trong khi đó, hiệu suất của A10 (31,2 FP32 TFLOPS, 125 FP16 TFLOPS) nằm trong phạm vi của GeForce RTX 3080. Card được trang bị 24GB bộ nhớ GDDR6 băng thông lên đến 600GB/s, có thể là giao diện bộ nhớ của RTX 3090 nhưng không có xung nhịp GDDR6X.

Bài viết liên quan

- NVIDIA NGC‑ready Low‑latency Edge AI: Giải pháp cho Retail, Manufacturing và Smart Cities

- So sánh sức mạnh của máy tính AI DGX Spark với các card GPU máy trạm chuyên nghiệp của NVIDIA

- Từ Orin đến Thor: Bước nhảy vọt kiến trúc của NVIDIA JetPack 7.0 và tương lai của robot hình người

- Tại sao gọi NVIDIA DGX Spark là Siêu máy tính AI cá nhân?

- Cơ chế quản lý bộ nhớ trên các nền tảng phần cứng nhất quán – Hardware-coherent

- Kiến trúc NVIDIA Blackwell với GB200 NVL72: Định nghĩa lại điện toán AI cấp độ Exascale