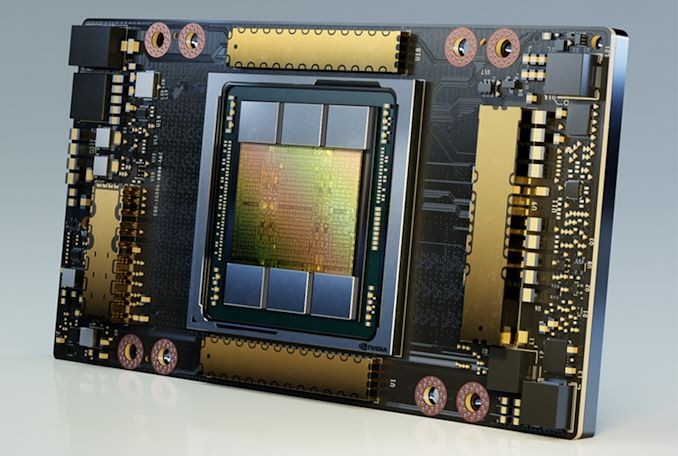

Khởi động phiên trình diễn trực tuyến về siêu máy tính SC20, NVIDIA vừa qua đã công bố phiên bản mới của máy bộ tăng tốc A100 hàng đầu của hãng. Mới ra mắt 6 tháng trước, NVIDIA đang chuẩn bị tung ra phiên bản cập nhật của bộ tăng tốc dựa trên GPU với 80 gigabyte bộ nhớ HBM2e, tăng gấp đôi dung lượng của phiên bản đầu tiên. Và như một cú hích nữa, NVIDIA cũng đẩy tốc độ xung bộ nhớ lên đáng kể, nâng phiên bản 80GB của A100 lên 3,2Gbps/pin, với tổng băng thông bộ nhớ lên đến 2TB/s.

Phiên bản 80GB của A100 sẽ tiếp tục được bán cùng với phiên bản 40GB – mà NVIDIA hiện đang gọi là A100 40GB – và nó chủ yếu nhắm đến những khách hàng có các dataset AI cực lớn. Điều này nghe có vẻ hơi không rõ ràng về giá trị của nó, nhưng với các khối lượng công việc học sâu đặc thù, dung lượng bộ nhớ có thể là một yếu tố ràng buộc cực kỳ quan trọng khi làm việc với các bộ dữ liệu đặc biệt lớn. Vì vậy, một bộ tăng tốc đủ lớn để giữ toàn bộ mô hình trong bộ nhớ cục bộ có thể nhanh hơn đáng kể so với một bộ tăng tốc thường xuyên phải hoán đổi dữ liệu với bên ngoài.

So sánh thông số kỹ thuật của các bộ tăng tốc GPU hàng đầu của NVIDIA |

|||

| A100 (80GB) | A100 (40GB) | V100 | |

| FP32 CUDA Cores | 6912 | 6912 | 5120 |

| Boost Clock | 1,41 GHz | 1,41 GHz | 1530MHz |

| Memory Clock | HBM2e 3,2Gb / giây | HBM2 2,4Gb / giây | 1,75Gb / giây HBM2 |

| Memory Bus Width | 5120-bit | 5120-bit | 4096-bit |

| Memory Bandwidth | 2.0TB / giây | 1,6TB / giây | 900GB / giây |

| VRAM | 80GB | 40GB | 16GB / 32GB |

| Single Precision | 19,5 TFLOPs | 19,5 TFLOPs | 15,7 TFLOPs |

| Double Precision | 9,7 TFLOPs (1/2 tỷ lệ FP32) |

9,7 TFLOPs (1/2 tỷ lệ FP32) |

7,8 TFLOPs (1/2 tỷ lệ FP32) |

| INT8 Tensor | 624 đầu trang | 624 đầu trang | N / A |

| FP16 Tensor | 312 TFLOPs | 312 TFLOPs | 125 TFLOPs |

| TF32 Tensor | 156 TFLOP | 156 TFLOP | N / A |

| Interconnect | NVLink 3 12 Liên kết (600GB / giây) |

NVLink 3 12 Liên kết (600GB / giây) |

NVLink 2 6 Liên kết (300GB / giây) |

| GPU | GA100 (826mm2) |

GA100 (826mm2) |

GV100 (815mm2) |

| Số lượng transistors | 54,2B | 54,2B | 21.1B |

| TDP | 400W | 400W | 300W / 350W |

| Tiến trình sản xuất | TSMC 7N | TSMC 7N | TSMC 12nm FFN |

| Giao diện | SXM4 | SXM4 | SXM2 / SXM3 |

| Kiến trúc | Ampere | Ampere | Volta |

Đi sâu vào thông số kỹ thuật, sự khác biệt duy nhất giữa phiên bản 40GB và 80GB của A100 sẽ là dung lượng bộ nhớ và băng thông bộ nhớ. Cả hai mẫu đều được xuất xưởng sử dụng GPU GA100 được kích hoạt chủ yếu với 108 SMs đang hoạt động và xung nhịp tăng 1,41GHz. Tương tự, TDP giữa hai mô hình cũng không thay đổi. Vì vậy, đối với thông lượng tính toán trên giấy, thuần túy, không có sự khác biệt giữa các bộ gia tốc.

Thay vào đó, những cải tiến cho A100 đi xuống dung lượng bộ nhớ và băng thông bộ nhớ lớn hơn. Khi A100 ban đầu trở lại vào tháng 5, NVIDIA đã trang bị cho nó sáu ngăn xếp 8GB bộ nhớ HBM2, với một trong những ngăn xếp đó bị tắt vì lý do năng suất. Điều này khiến A100 ban đầu có 40GB bộ nhớ và chỉ còn 1,6TB / giây băng thông bộ nhớ.

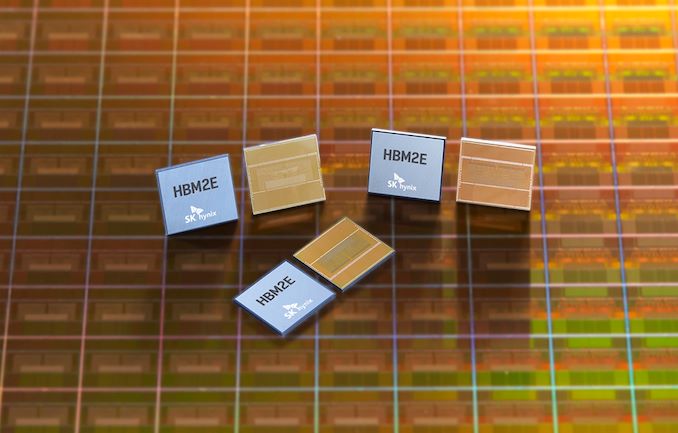

Đối với A100 80GB mới hơn, NVIDIA vẫn giữ nguyên cấu hình của 5 trong số 6 ngăn xếp bộ nhớ được kích hoạt, tuy nhiên bản thân bộ nhớ đã được thay thế bằng bộ nhớ HBM2E mới hơn. HBM2E là tên không chính thức được đặt cho bản cập nhật gần đây nhất cho tiêu chuẩn bộ nhớ HBM2, vào tháng 2 năm nay đã xác định tốc độ bộ nhớ tối đa mới là 3,2Gbps / pin. Cùng với việc cải thiện tần số đó, các cải tiến về sản xuất cũng cho phép các nhà sản xuất bộ nhớ tăng gấp đôi dung lượng của bộ nhớ, từ 1GB / die lên 2GB / die. Kết quả thực tế là HBM2E cung cấp cả dung lượng lớn hơn cũng như băng thông lớn hơn, hai điều mà NVIDIA đang tận dụng ở đây.

Với 5 ngăn xếp hoạt động 16GB, bộ nhớ 8-Hi, A100 được cập nhật có tổng cộng 80GB bộ nhớ. Chạy ở tốc độ 3.2Gbps / pin, hoạt động với băng thông bộ nhớ chỉ hơn 2TB / giây cho bộ tăng tốc, tăng 25% so với phiên bản 40GB. Điều này có nghĩa là bộ tăng tốc 80GB không chỉ cung cấp nhiều dung lượng lưu trữ cục bộ hơn, mà hiếm có kiểu máy dung lượng lớn hơn, nó còn cung cấp thêm một số băng thông bộ nhớ đi kèm. Điều đó có nghĩa là trong khối lượng công việc giới hạn băng thông bộ nhớ, phiên bản 80GB sẽ nhanh hơn phiên bản 40GB ngay cả khi không sử dụng dung lượng bộ nhớ bổ sung.

Việc có thể cung cấp một phiên bản A100 với nhiều băng thông bộ nhớ hơn dường như phần lớn là một tác phẩm của quá trình sản xuất chứ không phải là thứ do NVIDIA lên kế hoạch – Samsung và SK Hynix cuối cùng chỉ bắt đầu sản xuất hàng loạt HBM2E vào đầu năm nay – nhưng không kém phần chắc chắn sẽ được chào đón.

Nếu không, như đã đề cập trước đó, bộ nhớ bổ sung sẽ không thay đổi thông số TDP của A100. Vì vậy, A100 vẫn là một phần 400 Watt và trên danh nghĩa, phiên bản 80GB sẽ tiết kiệm điện hơn một chút vì nó cung cấp hiệu suất cao hơn bên trong cùng một TDP.

Trong khi đó, NVIDIA cũng đã xác nhận rằng dung lượng bộ nhớ lớn hơn của mô hình 80GB cũng sẽ có sẵn cho người dùng GPU Multi-Instance (MIG). A100 vẫn có giới hạn phần cứng là 7 phiên bản, vì vậy các phiên bản có kích thước bằng nhau hiện có thể có bộ nhớ chuyên dụng lên đến 10GB cho mỗi phiên bản.

Về hiệu suất, NVIDIA đưa ra một vài con số so sánh hai phiên bản của A100. Thực sự hơi ngạc nhiên khi họ nói về phiên bản 80GB khá nhiều, vì NVIDIA sẽ tiếp tục bán phiên bản 40GB. Nhưng với A100 80GB có khả năng đắt hơn (NVIDIA đã mua Arm ), chắc chắn vẫn có thị trường cho cả hai.

Cuối cùng, giống như sự ra mắt của A100 ban đầu vào đầu năm nay, trọng tâm trước mắt của NVIDIA với A100 80GB là cấu hình HGX và DGX. Bộ tăng tốc hệ số dạng lửng được thiết kế để cài đặt trong các hệ thống đa GPU, vì vậy đó là cách NVIDIA bán nó: như một phần của bo mạch mang HGX với 4 hoặc 8 GPU được cài đặt. Đối với những khách hàng cần A100 riêng lẻ, NVIDIA đang tiếp tục cung cấp PCIe A100, mặc dù không có cấu hình 80GB (ít nhất là chưa có).

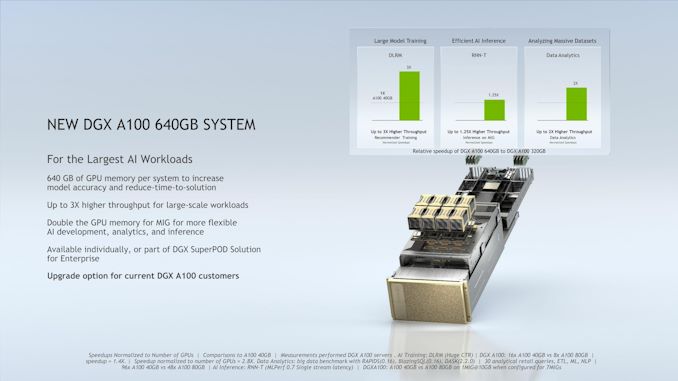

Cùng với việc cung cấp A100 80GB cho khách hàng HGX, NVIDIA cũng sẽ tung ra một số phần cứng DGX mới hôm nay. Ở phân khúc cao cấp, họ đang cung cấp phiên bản DGX A100 với bộ gia tốc mới, mà họ sẽ gọi là DGX A100 640GB. DGX A100 mới này cũng có DRAM và dung lượng lưu trữ nhiều gấp đôi so với người tiền nhiệm của nó, gấp đôi bản gốc theo nhiều cách.

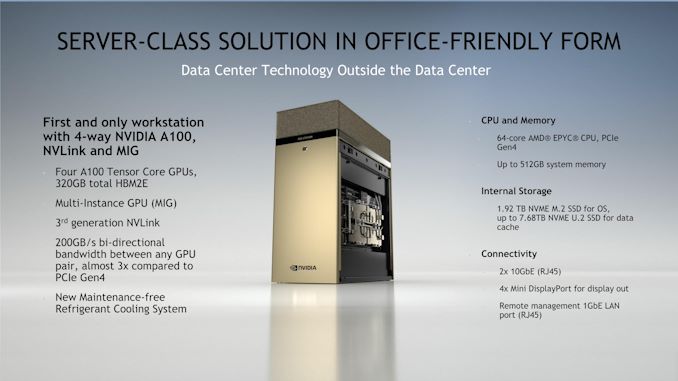

Trong khi đó NVIDIA đang tung ra một phiên bản máy trạm nhỏ hơn của DGX A100, mà họ đang gọi là DGX Station A100. Kế thừa của DGX Station gốc, dựa trên Volta, DGX Station A100 về cơ bản là một nửa của DGX A100, với 4 bộ gia tốc A100 và một bộ xử lý AMD EPYC duy nhất. Cuộc họp báo trước của NVIDIA không đề cập đến tổng mức tiêu thụ điện năng, nhưng tôi đã được thông báo rằng nó chạy bằng ổ cắm tường tiêu chuẩn, ít hơn nhiều so với 6,5kW của DGX A100.

NVIDIA cũng lưu ý rằng DGX Station sử dụng hệ thống làm lạnh bằng chất làm lạnh, có nghĩa là họ đang sử dụng hệ thống làm mát phụ (không giống như DGX Station ban đầu, chỉ đơn giản là làm mát bằng nước). NVIDIA hứa hẹn rằng mặc dù vậy, DGX Station A100 vẫn hoạt động êm ái, vì vậy sẽ rất thú vị khi xem điều đó đúng bao nhiêu phần trăm so với các vấn đề tiếng ồn thông thường liên quan đến việc gắn máy nén vào vòng làm mát máy tính.

Cả hai hệ thống DGX mới hiện đang được sản xuất. Theo NVIDIA, các hệ thống này đã được sử dụng cho một số cài đặt siêu máy tính đã được công bố trước đây của họ, chẳng hạn như hệ thống Cambridge-1. Nếu không, tính khả dụng thương mại sẽ bắt đầu vào tháng Giêng, với khả năng cung cấp rộng rãi hơn vào tháng Hai.

Bài viết liên quan

- NVIDIA NGC‑ready Low‑latency Edge AI: Giải pháp cho Retail, Manufacturing và Smart Cities

- So sánh sức mạnh của máy tính AI DGX Spark với các card GPU máy trạm chuyên nghiệp của NVIDIA

- Từ Orin đến Thor: Bước nhảy vọt kiến trúc của NVIDIA JetPack 7.0 và tương lai của robot hình người

- Tại sao gọi NVIDIA DGX Spark là Siêu máy tính AI cá nhân?

- Cơ chế quản lý bộ nhớ trên các nền tảng phần cứng nhất quán – Hardware-coherent

- Kiến trúc NVIDIA Blackwell với GB200 NVL72: Định nghĩa lại điện toán AI cấp độ Exascale