NVIDIA NeMo framework là gì?

NVIDIA NeMo, một phần của nền tảng NVIDIA AI, là một framework phát triển ứng dụng AI toàn diện cấp doanh nghiệp, cloud-native, xây dựng có mục đích cho việc tùy biến và triển khai các mô hình AI tạo sinh (Generative AI) với hàng tỷ tham số.

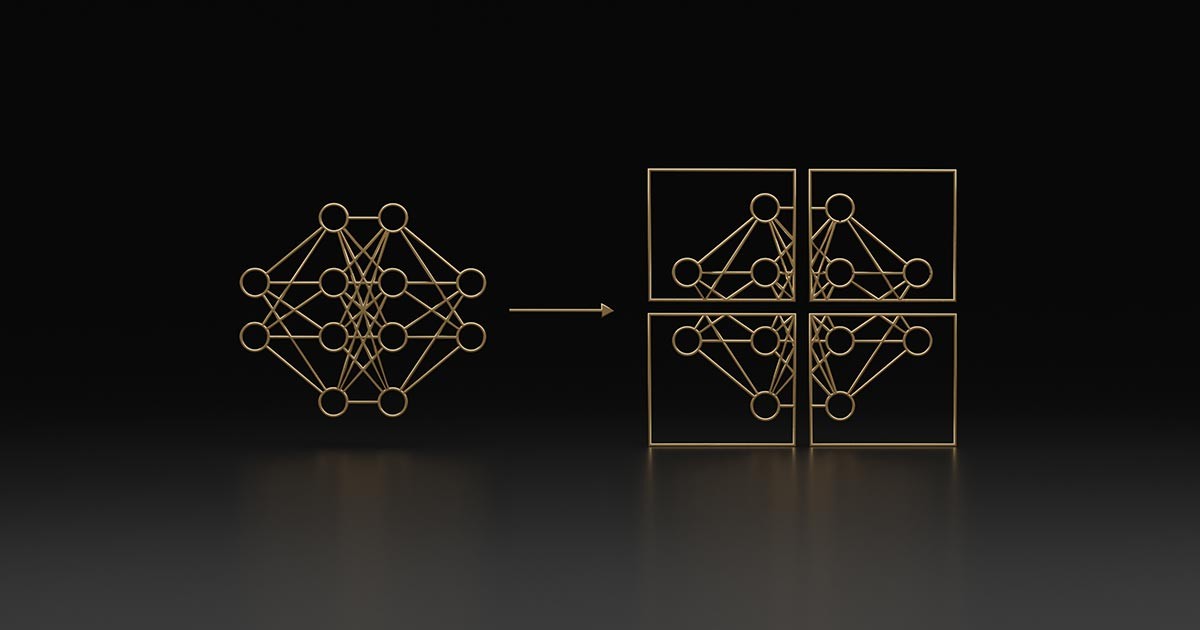

Framework NeMo cung cấp một quy trình làm việc tăng tốc cho đào tạo với các kỹ thuật xử lý song song 3D. Nó mang lại một số lựa chọn kỹ thuật tùy chỉnh và được tối ưu hóa cho việc suy luận các mô hình quy mô lớn của các ứng dụng ngôn ngữ và hình ảnh với các cấu hình multi-GPU và multi-node. NeMo giúp việc phát triển mô hình AI tạo sinh trở nên dễ dàng, tiết kiệm chi phí và nhanh chóng cho các doanh nghiệp.

Mặc dù framework NeMo là một công cụ mạnh mẽ để bắt đầu với các mô hình AI tạo sinh nhưng việc xây dựng một stack AI từ đầu đến cuối là một nhiệm vụ đầy thách thức. Khi các mô hình AI tạo sinh và sự phát triển của chúng phát triển và mở rộng nhanh chóng, sự phức tạp của stack AI và các phần phụ thuộc của nó cũng tăng lên.

Đối với một giải pháp full stack được tối ưu hoá, an toàn, được thiết kế để tăng tốc các doanh nghiệp với sự hỗ trợ, bảo mật và tính ổn định của API, NeMo có sẵn như một phần của NVIDIA AI Enterprise, cung cấp cho các doanh nghiệp con đường thành công để dẫn đầu về AI mà không gặp rủi ro tiềm ẩn của phần mềm nguồn mở (open-source).

Xây dựng các mô hình nền tảng cho các phương thức khác nhau

Framework NeMo hỗ trợ phát triển các mô hình nền tảng (foundation models) chuyển văn bản thành văn bản, văn bản thành hình ảnh và hình ảnh thành hình ảnh.

Ngôn ngữ

- BERT

- GPT-3

- T5

- T5-MoE

- Inform

Đa phương thức

- Stable Diffusion v1.5

- VisionTransformers (ViT)

- CLIP

- Instruct-Pix2Pix

- Imagen

Xây dựng các ứng dụng LLM đáng tin cậy, an toàn và bảo mật

Guardrails có thể lập trình dành cho các ứng dụng dựa trên LLM

NeMo Guardrails là một bộ công cụ để dễ dàng phát triển các hệ thống đàm thoại LLM (Mô hình ngôn ngữ lớn) đáng tin cậy, an toàn và bảo mật. Nó vốn hỗ trợ LangChain, bổ sung một lớp guardrails an toàn, bảo mật và tập trung vào topic cụ thể cho các ứng dụng đàm thoại dựa trên LLM.

→ Dùng thử NeMo Guardrails ngay bây giờ

Khám phá các lợi ích

Đào tạo nhanh nhất trên các GPU

Sử dụng các kỹ thuật đào tạo tiên tiến nhất để tối đa hóa thông lượng và giảm thiểu thời gian đào tạo cho các mô hình nền tảng với hàng tỷ hoặc hàng nghìn tỷ tham số.

Dễ sử dụng

Một framework cloud-native với tất cả các thành phần được đóng gói sẵn và cài đặt với các receipt đã được xác thực dành cho đào tạo các mô hình AI tạo sinh hình ảnh và ngôn ngữ để tập hợp và triển khai đối với suy luận (inference).

Hoàn toàn linh hoạt

Một cách tiếp cận nguồn mở cung cấp sự linh hoạt đầy đủ trên toàn bộ quy trình – từ xử lý dữ liệu, đến đào tạo cho đến suy luận về các mô hình Generative AI.

Chạy trên Cloud và tại chỗ

Đào tạo và triển khai các mô hình nền tảng ở mọi quy mô trên mọi hạ tầng GPU. Được hỗ trợ trên tất cả các hệ thống NVIDIA DGX™, NVIDIA DGX Cloud™, Microsoft Azure, Oracle Cloud Infrastructure và Amazon Web Services.

Tuỳ chỉnh

Cung cấp các công cụ để tùy chỉnh các mô hình nền tảng dành cho siêu cá nhân hóa (hyper-personalized) doanh nghiệp.

Hỗ trợ doanh nghiệp

Những container cứng (hardened), được kiểm tra (tested) và được xác thực (verified) – được xây dựng cho các doanh nghiệp.

Các tính năng chính để phát triển các Large Language Model

Kỹ thuật đào tạo hiện đại

Framework NeMo mang lại hiệu quả đào tạo ở mức cao, giúp đào tạo các mô hình nền tảng quy mô lớn, sử dụng các kỹ thuật song song 3D như:

- Tensor Parallelism để mở rộng các mô hình trong các node

- Data and pipeline parallelism để mở rộng dữ liệu và các mô hình trên hàng nghìn GPU

- Sequence Parallelism để phân phối bộ nhớ kích hoạt (activation) trên các thiết bị song song tensor

Ngoài ra, Selective Activation Recomputing sẽ tối ưu hóa việc tính toán lại và sử dụng bộ nhớ trên các thiết bị song song tensor trong quá trình lan truyền ngược (backpropagation).

Công cụ tùy chỉnh

Framework NeMo sẽ giúp cho AI doanh nghiệp trở nên thiết thực bằng việc cung cấp các công cụ để:

- Xác định trọng tâm và guardrails: Xác định guardrails và domain điều hành cho các mô hình doanh nghiệp siêu cá nhân hóa để ngăn LLM chuyển hướng sang các domain không mong muốn hoặc nói những điều không phù hợp, thông qua các kỹ thuật tinh chỉnh, học nhanh (prompt learning) và adapters.

- Bao gồm kiến thức theo domain cụ thể: Mã hóa và nhúng AI của bạn với thông tin theo thời gian thực của doanh nghiệp để cung cấp phản hồi mới nhất, sử dụng NVIDIA Inform.

- Bao gồm các kỹ năng chức năng: Thêm các kỹ năng chuyên biệt để giải quyết các vấn đề của khách hàng và doanh nghiệp. Nhận phản hồi tốt hơn bằng cách cung cấp ngữ cảnh cho các trường hợp sử dụng siêu cá nhân hóa với kỹ thuật học nhanh.

- Liên tục cải tiến mô hình: Những kỹ thuật học tăng cường (reinforcement learning) với phản hồi của con người (RLHF) cho phép mô hình doanh nghiệp của bạn trở nên thông minh hơn theo thời gian, phù hợp với ý định của con người.

Suy luận AI được tối ưu hóa với NVIDIA Triton

Triển khai các mô hình Generative AI dành cho suy luận bằng NVIDIA Triton Inference Server™. Với khả năng tối ưu hóa mạnh mẽ từ FasterTransformer, bạn có thể đạt được hiệu suất suy luận thông lượng, độ trễ và độ chính xác hiện đại trên các cấu hình single-GPU, multi-GPU và multi-node.

Xử lý dữ liệu theo quy mô

Mang bộ dữ liệu của riêng bạn và token hoá dữ liệu sang định dạng dễ xử lý. NeMo bao gồm các khả năng tiền xử lý toàn diện để lọc dữ liệu, chống trùng lặp, trộn và định dạng trên những bộ dữ liệu ngôn ngữ, trên Piles và C4 đa ngôn ngữ (mC4). Những điều này giúp các nhà nghiên cứu và kỹ sư tiết kiệm thời gian vài tháng để phát triển và tính toán, cho phép họ tập trung vào việc xây dựng các ứng dụng.

Các công thức và công cụ dễ sử dụng dành cho Generative AI

Framework NeMo giúp cho AI tạo sinh trở nên khả thi ngay từ ngày đầu tiên với các tập lệnh, ví dụ tham khảo và tài liệu được đóng gói sẵn trên toàn bộ quy trình.

Việc xây dựng các mô hình nền tảng cũng được thực hiện dễ dàng thông qua công cụ cấu hình tự động (auto-configurator), công cụ này sẽ tự động tìm kiếm các cấu hình siêu tham số tốt nhất để tối ưu hóa quá trình đào tạo và suy luận đối với mọi hạn chế về cấu hình, đào tạo hoặc triển khai multi-GPU nhất định.

Dễ dàng tùy chỉnh và sử dụng các mô hình Generative AI bằng các Dịch vụ ngôn ngữ và hình ảnh của NVIDIA NeMo

Dịch vụ ngôn ngữ NeMo

Dịch vụ đám mây dành cho siêu cá nhân hóa doanh nghiệp và triển khai theo quy mô về các Mô hình ngôn ngữ lớn thông minh.

→ Tìm hiểu thêm về dịch vụ NeMo LLM

→ Đăng ký truy cập sớm ngay bây giờ

Dịch vụ Picasso

Dịch vụ đám mây tăng tốc dành cho các doanh nghiệp sử dụng các mô hình Generative AI tùy chỉnh để tạo hình ảnh, video và nội dung 3D có độ phân giải cao, chân thực.

Khách hàng đang tăng tốc các ứng dụng Generative AI và LLM với NVIDIA NeMo Framework

Tăng tốc các ứng dụng công nghiệp với LLM

AI Sweden đã tăng tốc các ứng dụng công nghiệp LLM bằng việc tạo ra sức mạnh của mô hình 100 tỷ tham số cho các ngôn ngữ địa phương – có thể dễ dàng truy cập đến hệ sinh thái của Bắc Âu. AI Sweden đang số hóa các ghi chép lịch sử của Thụy Điển và xây dựng các mô hình ngôn ngữ từ dữ liệu phi cấu trúc này để có thể thương mại hóa trong các ứng dụng doanh nghiệp.

Tạo trải nghiệm khách hàng mới với LLM

Nhà điều hành di động hàng đầu của Hàn Quốc xây dựng các LLM hàng tỷ tham số được đào tạo với nền tảng NVIDIA DGX SuperPOD và framework NeMo để hỗ trợ cho loa thông minh và các call center của khách hàng.

Khám phá thêm các tài nguyên

Triển khai Mô hình 1.3B GPT-3 với NVIDIA NeMo Framework

Tìm hiểu cách tải xuống, tối ưu hóa và triển khai mô hình GPT-3 có 1.3 tỷ tham số với framework NeMo và Generative AI của NVIDIA.

Đào tạo theo quy mô và triển khai hiệu quả các LLM với NeMo Framework

Tìm hiểu cách xử lý trước dữ liệu trong môi trường multi-node, tự động chọn siêu tham số tốt nhất để giảm thiểu thời gian đào tạo cho nhiều cấu hình GPT-3 và T5, đào tạo mô hình theo quy mô và triển khai mô hình trong cài đặt sản xuất multi-node với một bộ tập lệnh dễ sử dụng.

Lab thực hành miễn phí trên NVIDIA LaunchPad

Tìm hiểu cách đào tạo và triển khai các LLM dành cho nghiên cứu và phát triển thuốc với hướng dẫn về cách tạo mô hình dự đoán downstream sử dụng các thành phần đã được học hỏi. Nâng cao hiểu biết của doanh nghiệp bạn về việc sử dụng bộ mã hóa và bộ giải mã để tạo ra các phân tử mới bằng cách lấy mẫu latent space của mô hình.

Theo NVIDIA

Bài viết liên quan

- NVIDIA NGC‑ready Low‑latency Edge AI: Giải pháp cho Retail, Manufacturing và Smart Cities

- So sánh sức mạnh của máy tính AI DGX Spark với các card GPU máy trạm chuyên nghiệp của NVIDIA

- Từ Orin đến Thor: Bước nhảy vọt kiến trúc của NVIDIA JetPack 7.0 và tương lai của robot hình người

- Tại sao gọi NVIDIA DGX Spark là Siêu máy tính AI cá nhân?

- Cơ chế quản lý bộ nhớ trên các nền tảng phần cứng nhất quán – Hardware-coherent

- Kiến trúc NVIDIA Blackwell với GB200 NVL72: Định nghĩa lại điện toán AI cấp độ Exascale