Sẽ không có gì ngạc nhiên nếu bạn đang tự hỏi một máy chủ AI khác với một máy trạm AI như thế nào. Rất nhiều người khác cũng đang thắc mắc như thế. Giả sử các ứng dụng AI chỉ yêu cầu một khối lượng xử lý tăng tốc (qua GPU) tối thiểu, sự khác biệt rõ ràng là không đáng kể. Về mặt kỹ thuật, bạn có thể sử dụng thay thế lẫn nhau, cái này cũng như cái kia. Tuy nhiên, kết quả từ mỗi loại sẽ hoàn toàn khác nhau dựa trên quy mô của khối lượng xử lý mà mỗi bên được yêu cầu thực hiện. Vì lý do này, một điều cần thiết là phải hiểu rõ được sự khác biệt như thế nào giữa máy chủ và máy trạm chuyên cho AI.

Tạm gác AI sang một bên, các máy chủ nói chung có xu hướng được kết nối mạng và luôn luôn sẵn sàng như một tài nguyên được chia sẻ để chạy các dịch vụ có thể truy cập qua mạng. Ngược lại, các máy trạm thường nhằm thực hiện các yêu cầu của một Người dùng, Ứng dụng hoặc Mục đích cụ thể.

Một máy trạm có thể hoạt động như một máy chủ hay một máy chủ như một máy trạm? Câu trả lời là “có”, nhưng bỏ qua mục đích thiết kế của máy trạm hoặc máy chủ là một việc không nên. Ví dụ: cả máy trạm và máy chủ đều có thể hỗ trợ khối lượng công việc đa luồng, nhưng nếu một máy chủ có thể hỗ trợ nhiều luồng hơn 20 lần so với một máy trạm (tất cả những thứ khác đều giống nhau), thì máy chủ sẽ phù hợp hơn với các ứng dụng tạo nhiều luồng để bộ xử lý làm việc đồng thời.

Máy chủ được tối ưu hóa để mở rộng quy mô với vai trò là loại tài nguyên qua mạng cho các client. Các máy trạm thường không được tối ưu hóa cho quy mô lớn, khả năng chia sẻ, xử lý song song và kết nối mạng.

Sự khác biệt cụ thể: Máy chủ và máy trạm cho AI

Máy chủ thường chạy hệ điều hành được thiết kế đặc thù cho môi trường máy chủ, trong khi máy trạm chạy hệ điều hành dành cho máy Desktop. Ví dụ: hãy xem xét Microsoft Windows 10 cho Desktop và mục đích sử dụng cá nhân, trong khi Microsoft Windows Server được chạy trên các máy chủ chuyên dụng cho các dịch vụ mạng được chia sẻ.

Về nguyên tắc là giống nhau đối với các máy chủ và máy trạm AI. Phần lớn các máy trạm AI được sử dụng cho học máy, học sâu và phát triển AI đều dựa trên nền tảng Linux. Điều này cũng đúng với các máy chủ AI. Vì mục đích sử dụng của máy trạm và máy chủ là khác nhau, máy chủ có thể được trang bị cụm vi xử lý, tài nguyên bộ nhớ CPU và GPU lớn hơn, nhiều lõi xử lý hơn, khả năng đa luồng và mạng lớn hơn.

Lưu ý rằng do nhu cầu xử lý cực cao lên máy chủ như một tài nguyên được chia sẻ, nên chúng thường đòi hỏi dung lượng lưu trữ rất lớn, hiệu năng lưu trữ flash và hạ tầng mạng truy cập nhanh.

GPU: Thành phần thiết yếu

GPU đã trở thành một yếu tố thiết yếu trong các máy trạm AI và máy chủ AI hiện đại. Không giống như CPU, GPU có khả năng cho phép gia tăng thông lượng dữ liệu và số lượng các phép tính đồng thời trong một ứng dụng.

GPU ban đầu được thiết kế để tăng tốc độ kết xuất/render đồ họa. Bởi vì GPU có thể xử lý đồng thời nhiều phần dữ liệu, chúng đã tìm thấy những ứng dụng hiện đại mới trong học máy, chỉnh sửa video, lái xe tự động và rất nhiều thứ khác.

Mặc dù khối lượng công việc của AI có thể được chạy trên CPU, nhưng thời gian cho kết quả với GPU có thể nhanh hơn từ 10 lần đến 100 lần. Ví dụ, sự phức tạp của việc học sâu trong xử lý ngôn ngữ tự nhiên, công cụ đề xuất và phân loại hình ảnh, được hưởng lợi rất nhiều từ việc tăng tốc qua GPU.

Hiệu suất là cần thiết để đào tạo ban đầu về mô hình học máy và học sâu. Hiệu suất cũng là bắt buộc khi phản hồi thời gian thực (như đối với AI đàm thoại) đang chạy ở chế độ suy luận.

Ứng dụng cho các doanh nghiệp

Điều quan trọng là các máy chủ và máy trạm AI hoạt động liền mạch với nhau trong một doanh nghiệp và với đám mây. Và mỗi loại có một vị trí nhất định trong một tổ chức hay doanh nghiệp.

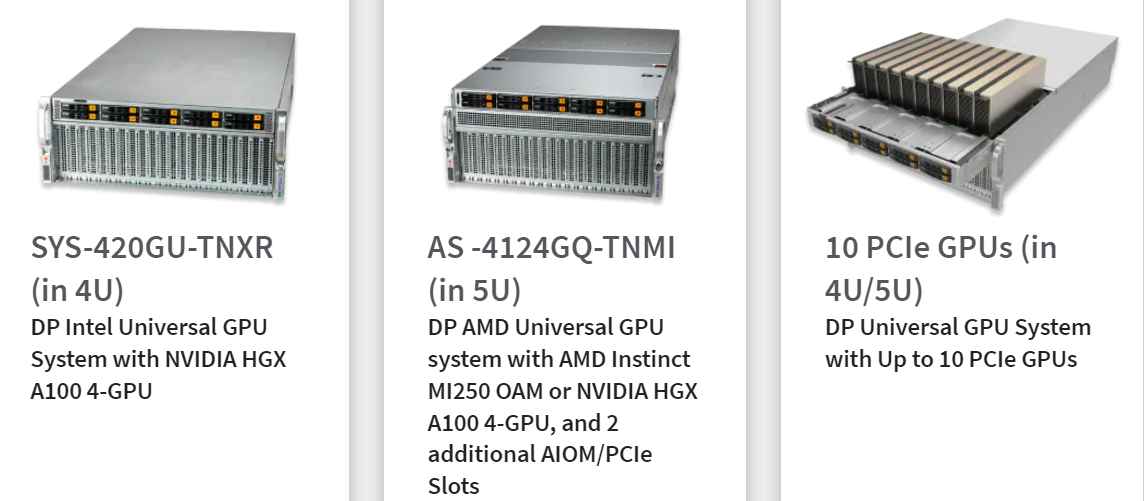

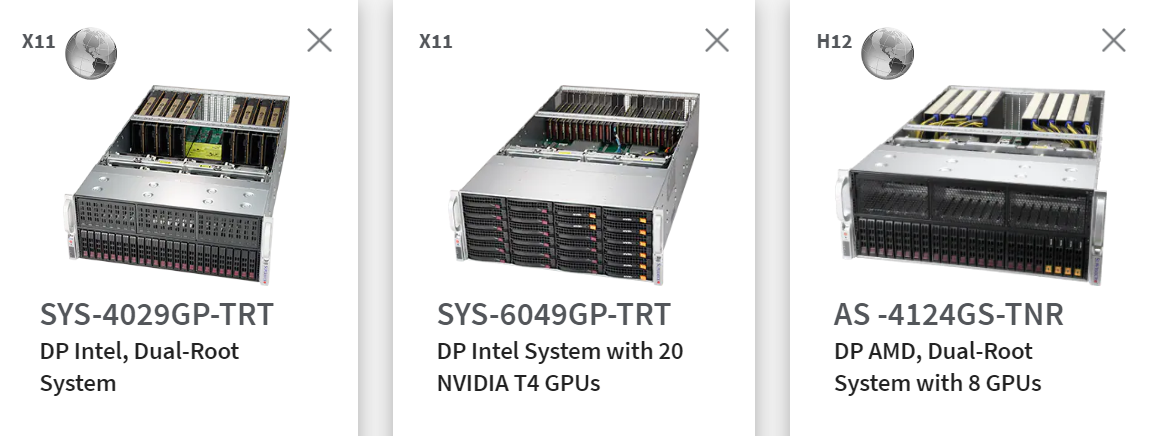

Máy chủ AI

Trong trường hợp máy chủ AI, các mô hình lớn được đào tạo hiệu quả hơn trên các máy chủ và cụm máy chủ hỗ trợ GPU. Chúng cũng có thể được đào tạo hiệu quả bằng cách sử dụng các phiên bản đám mây hỗ trợ GPU, đặc biệt là đối với các bộ dữ liệu lớn và các mô hình yêu cầu độ phân giải cao. Máy chủ AI thường được giao nhiệm vụ hoạt động như nền tảng hội nghị AI chuyên dụng cho nhiều ứng dụng AI khác nhau.

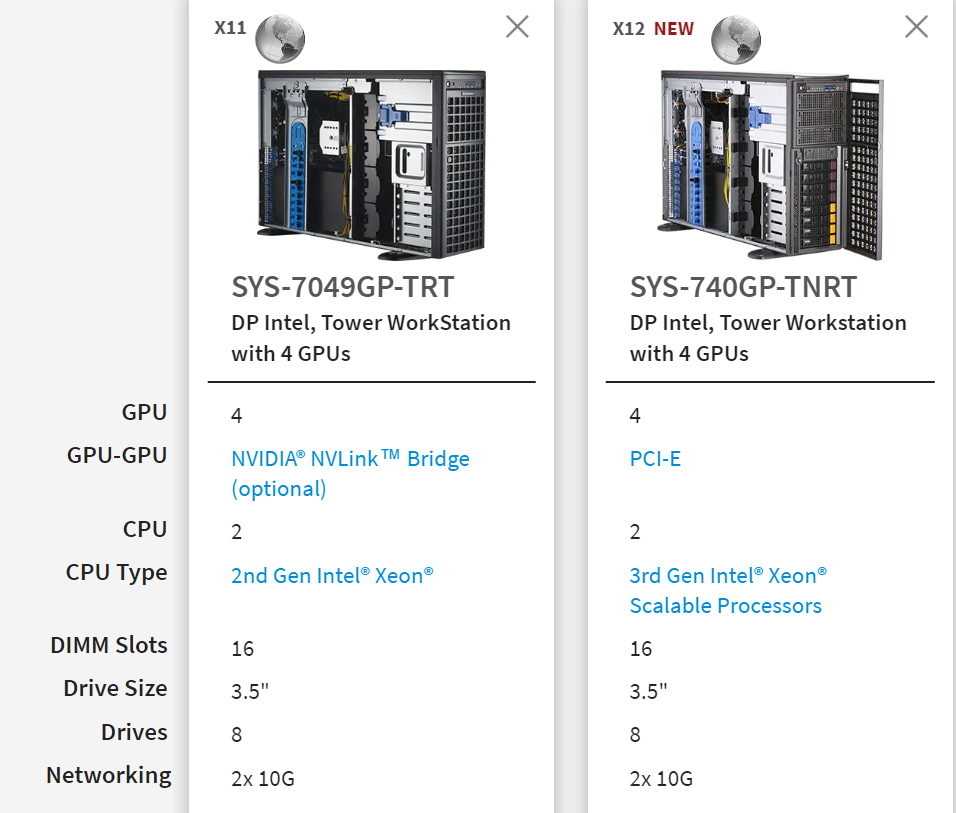

Máy trạm AI

Các nhà khoa học dữ liệu cá nhân, kỹ sư dữ liệu và nhà nghiên cứu AI thường sử dụng máy trạm khoa học dữ liệu hoặc AI cá nhân trong quá trình xây dựng và duy trì các ứng dụng AI. Điều này có xu hướng bao gồm việc chuẩn bị dữ liệu, thiết kế mô hình và đào tạo mô hình sơ bộ. Các máy trạm được tăng tốc GPU giúp bạn có thể xây dựng các nguyên mẫu mô hình hoàn chỉnh bằng cách sử dụng một tập hợp con thích hợp của một tập dữ liệu lớn. Điều này thường được thực hiện trong vài giờ đến một hoặc hai ngày.

Khả năng tương thích phần cứng được chứng nhận cùng với khả năng tương thích liền mạch giữa các công cụ AI là rất quan trọng. Máy chủ và Máy chủ và Máy trạm được Chứng nhận NVIDIA cung cấp sự liền mạch và mạnh mẽ cho doanh nghiệp đã được thử nghiệm trên các nền tảng được chứng nhận.

→ Xem thêm: Máy chủ Supermicro được chứng nhận cho GPU NVIDIA A100 PCIe

→ Xem thêm: Các sản phẩm GPU NVIDIA

Bài viết liên quan

- NVIDIA NGC‑ready Low‑latency Edge AI: Giải pháp cho Retail, Manufacturing và Smart Cities

- So sánh sức mạnh của máy tính AI DGX Spark với các card GPU máy trạm chuyên nghiệp của NVIDIA

- Từ Orin đến Thor: Bước nhảy vọt kiến trúc của NVIDIA JetPack 7.0 và tương lai của robot hình người

- Tại sao gọi NVIDIA DGX Spark là Siêu máy tính AI cá nhân?

- Cơ chế quản lý bộ nhớ trên các nền tảng phần cứng nhất quán – Hardware-coherent

- Kiến trúc NVIDIA Blackwell với GB200 NVL72: Định nghĩa lại điện toán AI cấp độ Exascale