Tuần này Supermicro vừa tung ra dòng máy chủ trí tuệ nhân tạo mới với tên mã SYS-6049GP-TRT, nhắm vào phân khúc cao nhất, mạnh mẽ nhất trong các hệ thống GPU cho deep learning, trí tuệ nhân tạo. Máy chủ mới này hỗ trợ lên tới 20x GPU NVIDIA Tesla T4. Chưa có nhiều thông tin từ hãng nhưng chúng tôi sẽ đưa ra một số thông số thú vị. Điểm nổi bật nhất là với 20 x GPU NVIDIA Tesla T4 sẽ cần tổng cộng 320 x PCIe 3.0 lanes để chạy ở tốc độ tối đa. Nền tảng Intel Xeon Scalable dual-socket có tối đa 96 lanes, cộng với con số theo thông tin từ chipset. AMD EPYC có tới 128 x PCIe lanes (trừ một số dành riêng cho các thiết bị ngoại vi). Ngoài ra còn có câu hỏi về vấn đề bố trí các GPU. Nhưng như các bạn biết, Supermicro biết mình cần phải làm gì để “đóng” tất cả vào một khối.

NVIDIA Tesla T4

Một lý do mà dòng GPU mới NVIDIA Tesla T4 tạo ra rất nhiều bàn tán là vì dòng GPU mới này là dạng low profile card, cho phép khả năng hỗ trợ tích hợp vào các máy chủ dạng general purpose.

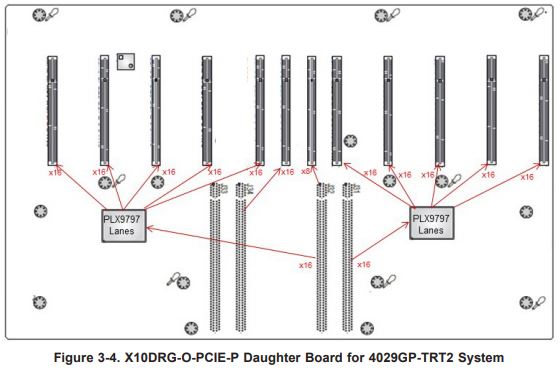

Sơ đồ bố trí dưới đây có thể được sử dụng trong Supermicro SYS-6049GP-TRT, nó gợi ý một bố trí PCB mà hệ thống sử dụng:

Chúng tôi nghĩ rằng Supermicro SYS-6049GP-TRT đang sử dụng PCB với các PCIe switch bổ sung giúp tăng thêm các khe cắm mở rộng PCIe. Thay vì để mười khe PCIe, Supermicro có một PCB khác với 8 hoặc 9 khe PCIe bổ sung. Có thể có một tổ hợp switch PCIe cỡ lớn, hoặc mỗi GPU dùng ít PCIe lane hơn.

Có vẻ việc lắp 20x single-width card là khả thi trong thiết kế chassis chuẩn của Supermicro. Với tổng nguồn cung cấp 8kW bằng cách sử dụng 4x bộ nguồn 2kW, Supermicro SYS-6049GP-TRT chắc chắn có thể xử lý số lượng GPU NVIDIA Tesla T4 đó để phục vụ xử lý suy luận – inference.

Bài viết liên quan

- NVIDIA NGC‑ready Low‑latency Edge AI: Giải pháp cho Retail, Manufacturing và Smart Cities

- So sánh sức mạnh của máy tính AI DGX Spark với các card GPU máy trạm chuyên nghiệp của NVIDIA

- Từ Orin đến Thor: Bước nhảy vọt kiến trúc của NVIDIA JetPack 7.0 và tương lai của robot hình người

- Tại sao gọi NVIDIA DGX Spark là Siêu máy tính AI cá nhân?

- Cơ chế quản lý bộ nhớ trên các nền tảng phần cứng nhất quán – Hardware-coherent

- Kiến trúc NVIDIA Blackwell với GB200 NVL72: Định nghĩa lại điện toán AI cấp độ Exascale