1. Giới thiệu: Cuộc cách mạng kết nối trong Điện toán Hiệu năng cao

1.1. Bối cảnh: Điểm nghẽn PCIe và Nhu cầu Bùng nổ của AI/HPC

Sự bùng nổ của trí tuệ nhân tạo (AI) và điện toán hiệu năng cao (HPC) đã thúc đẩy nhu cầu về khả năng xử lý và truyền dữ liệu chưa từng có. Trong nhiều thập kỷ, PCIe (Peripheral Component Interconnect Express) đã là một chuẩn giao tiếp phổ biến và hiệu quả để truyền dữ liệu giữa CPU, GPU và các linh kiện khác trong một hệ thống máy tính.Tuy nhiên, trước sự phát triển theo cấp số nhân của các mô hình AI, đặc biệt là các mô hình ngôn ngữ lớn (LLMs) với hàng tỷ, thậm chí hàng nghìn tỷ tham số, PCIe đã bộc lộ những giới hạn nghiêm trọng về băng thông và độ trễ.

Để giải quyết điểm nghẽn này, NVIDIA đã phát triển NVLink, một công nghệ kết nối tốc độ cao được thiết kế để thay thế hoặc bổ sung cho chuẩn PCIe. NVLink ra đời như một “cầu siêu tốc” giúp các bộ xử lý truyền dữ liệu với nhau nhanh hơn nhiều so với đường PCIe thông thường, với khả năng truyền dữ liệu qua nhiều đường cùng lúc và đồng bộ bộ nhớ giữa các GPU.Công nghệ này đã trở thành nền tảng then chốt cho các hệ thống AI, HPC và đồ họa chuyên sâu, giúp các tác vụ này hoạt động mượt mà và hiệu quả hơn nhiều so với việc chỉ dựa vào PCIe.

1.2. Định nghĩa ban đầu: NVLink Fusion – Bước tiến chiến lược của NVIDIA

NVLink Fusion được NVIDIA giới thiệu vào năm 2025, đánh dấu một bước tiến chiến lược quan trọng.Đây là một chương trình cấp phép IP (Intellectual Property) mới, cho phép các bộ xử lý (CPU) và bộ tăng tốc tùy chỉnh (ASIC) từ các nhà sản xuất bên thứ ba như AMD và Intel kết nối trực tiếp với GPU NVIDIA thông qua công nghệ NVLink.Nếu NVLink là công nghệ kết nối độc quyền, NVLink Fusion chính là một chương trình mở rộng hệ sinh thái, cho phép các đối tác tích hợp công nghệ này vào chip của họ, từ đó tạo ra một hệ sinh thái AI đa dạng và linh hoạt hơn.

1.3. Vị thế và mục tiêu: Dẫn dắt kỷ nguyên “nhà máy AI”

Với sự ra mắt của NVLink Fusion, NVIDIA đã phá bỏ rào cản trước đây khi chỉ giới hạn NVLink cho các GPU và CPU của riêng mình. Động thái này được nhận định là một bước đi chiến lược nhằm duy trì vị thế trung tâm của NVIDIA trong cuộc đua phát triển AI và điện toán hiệu năng cao. Mục tiêu chính của NVLink Fusion là giúp các nhà cung cấp hạ tầng quy mô lớn (hyperscaler) xây dựng các “nhà máy AI” (AI factories) bán tùy chỉnh một cách nhanh chóng và hiệu quả hơn, bằng cách tận dụng các giải pháp silicon đa dạng mà vẫn chuẩn hóa xung quanh kiến trúc rack và công nghệ kết nối của NVIDIA.

2. Nền tảng kỹ thuật: NVLink và NVSwitch – Những “viên gạch” cơ bản

2.1. NVLink: Cuộc cách mạng hóa giao tiếp GPU

NVLink là nền tảng kỹ thuật cốt lõi cho các giải pháp hiệu năng cao của NVIDIA. Công nghệ này mang lại hai lợi thế chính so với chuẩn PCIe truyền thống: băng thông vượt trội và độ trễ cực thấp.

Thế hệ NVLink 5 (dành cho kiến trúc Blackwell) hỗ trợ băng thông hai chiều lên đến 1.8 TB/s cho mỗi GPU, nhanh hơn 14 lần so với băng thông của một kết nối PCIe Gen 5 (~128 GB/s). Sự chênh lệch này đặc biệt quan trọng trong các tác vụ AI và HPC, nơi dữ liệu khổng lồ cần được trao đổi liên tục giữa các bộ xử lý. Hơn nữa, NVLink giảm đáng kể độ trễ bằng cách thiết lập các kết nối trực tiếp giữa các GPU hoặc giữa GPU và CPU, bỏ qua hệ thống bus chung của PCIe. Kiến trúc này cũng hỗ trợ cache coherence, một tính năng cốt lõi giúp đảm bảo tính nhất quán dữ liệu trên toàn bộ không gian bộ nhớ được chia sẻ, từ đó đơn giản hóa mô hình lập trình cho các nhà phát triển.

NVLink cho phép nhiều GPU giao tiếp trực tiếp với nhau, hỗ trợ các mô hình liên kết đa dạng như mesh và ring để tối ưu hóa hiệu suất cho các loại tải công việc khác nhau. Sự linh hoạt này là yếu tố then chốt để xây dựng các hệ thống đa GPU hiệu quả, đặc biệt trong các tác vụ đòi hỏi sự phối hợp chặt chẽ giữa các bộ xử lý.

Bảng 1: So sánh Kỹ thuật: NVLink Gen 5 vs. PCIe Gen 5

| Đặc điểm Kỹ thuật | PCIe Gen 5 | NVLink Gen 5 (Blackwell) |

| Băng thông (song hướng) | ~128 GB/s | Lên đến 1.8 TB/s (mỗi GPU) |

| Tốc độ liên kết | 32-64 GB/s (mỗi link) | 100 GB/s (mỗi link) |

| Số liên kết tối đa | 16 làn | 18 liên kết (mỗi GPU) |

| Độ trễ | Cao hơn | Thấp hơn (kết nối trực tiếp) |

| Kiến trúc | Bus chung | Kết nối trực tiếp, điểm-tới-điểm |

| Phạm vi ứng dụng | Tổng quát | Chuyên biệt cho GPU-GPU, GPU-CPU |

| Các chip hỗ trợ | Tất cả các chip hiện đại | NVIDIA Blackwell, Hopper, Ampere |

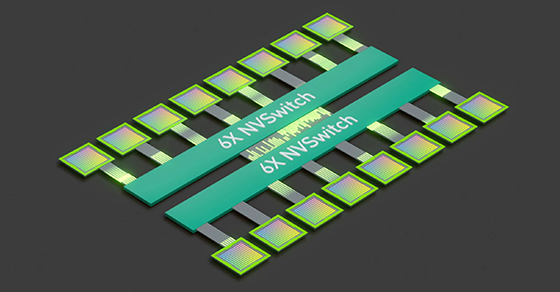

2.2. NVSwitch: Mở rộng quy mô vượt giới hạn server

Để mở rộng khả năng của NVLink vượt qua giới hạn của một server đơn lẻ, NVIDIA đã phát triển NVSwitch. NVSwitch là một chip chuyển mạch băng thông cao, tích hợp nhiều kết nối NVLink để tạo ra một môi trường đa node liền mạch, cho phép hàng chục, thậm chí hàng trăm GPU trong một rack hoạt động như một bộ xử lý duy nhất.

Vai trò cốt lõi của NVSwitch là tạo ra một kiến trúc giao tiếp “all-to-all non-blocking” (giao tiếp toàn bộ, không bị tắc nghẽn), đảm bảo mọi cặp GPU trong cụm đều có thể giao tiếp với nhau ở băng thông tối đa mà không bị phụ thuộc vào số lượng GPU đang giao tiếp. NVSwitch thế hệ 5, được thiết kế cho kiến trúc Blackwell, hỗ trợ kết nối tới 576 GPU trong một domain, với băng thông GPU-to-GPU đạt 1,800GB/s và tổng băng thông đạt 1 PB/s.Chip này cũng tích hợp SHARP (Scalable Hierarchical Aggregation and Reduction Protocol) để tối ưu hóa các collective operations (các phép toán đồng thời trên nhiều GPU) như all-reduce, vốn rất quan trọng trong huấn luyện deep learning và các tác vụ HPC.

Sự kết hợp giữa NVLink và NVSwitch đã tạo ra một giải pháp có khả năng mở rộng mạnh mẽ. Ví dụ, hệ thống GB200 NVL72, với 72 GPU được kết nối qua NVSwitch, có thể hoạt động như một bộ tăng tốc duy nhất, mang lại hiệu suất suy luận nhanh hơn 30 lần so với thế hệ trước. Điều này cho thấy vai trò không thể thiếu của NVSwitch trong việc tạo ra các cụm điện toán hiệu năng cao.

2.3. Khái niệm bộ nhớ hợp nhất (Unified memory) và bộ nhớ nhất quán (Memory coherence)

Một trong những tính năng mạnh mẽ nhất của NVLink là khả năng tạo ra một “bộ nhớ hợp nhất” (Unified Memory), cho phép các GPU chia sẻ bộ nhớ lẫn nhau. Tính năng này cho phép các nhà phát triển chạy các mô hình lớn vượt quá dung lượng VRAM của một GPU đơn lẻ, bằng cách sử dụng bộ nhớ của các GPU khác như một phần mở rộng. Khả năng này cũng đơn giản hóa đáng kể quá trình lập trình, vì các nhà phát triển không cần phải quản lý việc sao chép dữ liệu giữa các bộ nhớ riêng biệt.

Tuy nhiên, có một sự phân cấp rõ ràng trong việc triển khai tính năng này giữa các sản phẩm tiêu dùng và doanh nghiệp. Có một sự nhầm lẫn phổ biến rằng NVLink trên các GPU tiêu dùng có thể “làm phép” biến VRAM của nhiều GPU thành một pool duy nhất. Thực tế, NVLink trên các card như RTX 3090 chỉ là một bus giao tiếp tốc độ cao, giúp tăng tốc độ trao đổi dữ liệu giữa các GPU. Nó hữu ích cho các tác vụ huấn luyện với overhead truyền dữ liệu cao, nhưng không thực sự tạo ra một không gian bộ nhớ hợp nhất theo nghĩa kiến trúc.

Ngược lại, trên các hệ thống chuyên dụng như NVIDIA Grace Hopper (GH200), giao tiếp NVLink-C2C thực sự cho phép một mô hình bộ nhớ hợp nhất và nhất quán. Với NVLink-C2C, CPU và GPU có thể truy cập lẫn nhau một cách trong suốt, chia sẻ một không gian địa chỉ duy nhất. Điều này cho phép GPU tận dụng bộ nhớ LPDDR5X dung lượng lớn của CPU Grace, vượt qua giới hạn của bộ nhớ HBM3/HBM3e. Các cơ chế như ATS (Address Translation Services) và cache coherency đảm bảo tính nhất quán của dữ liệu, giảm đáng kể độ trễ và sự cần thiết của việc sao chép dữ liệu thủ công. Sự phân biệt này nhấn mạnh tầm quan trọng của việc làm rõ sự phân cấp công nghệ trong hệ sinh thái của NVIDIA, nơi các tính năng kiến trúc cao cấp được dành riêng cho các sản phẩm trung tâm dữ liệu.

3. NVLink Fusion: Tích hợp đột phá và hệ sinh thái mở rộng

3.1. NVLink Fusion là gì? Phân tích kỹ thuật và vai trò của chiplet

Về mặt kỹ thuật, NVLink Fusion không phải là một công nghệ mới hoàn toàn, mà là một chương trình cấp phép và một bộ IP cho phép các nhà sản xuất chip tích hợp các cổng NVLink và giao thức bộ nhớ nguyên tử (memory atomic protocol) vào sản phẩm của họ. Việc tích hợp này được thực hiện thông qua công nghệ chiplet, sử dụng NVLink-C2C (Chip-to-Chip), một giao thức die-to-die hiệu năng cao, làm nền tảng kỹ thuật. Điều này cho phép các die khác nhau từ các nhà sản xuất khác nhau được kết nối liền mạch trên cùng một package hoặc bo mạch.

Chương trình NVLink Fusion cho phép các hyperscaler và các nhà sản xuất chip xây dựng các giải pháp bán tùy chỉnh (semi-custom) để tối ưu hóa hiệu suất và chi phí. Điều này đánh dấu một sự thay đổi trong chiến lược của NVIDIA, từ việc cung cấp các hệ thống hoàn chỉnh, khép kín sang việc mở rộng khả năng tương thích với các sản phẩm của bên thứ ba, tuy nhiên, vẫn trong một khuôn khổ được kiểm soát chặt chẽ.

Bảng 2: Tổng quan về Kiến trúc và Vai trò của các công nghệ liên quan

| Công nghệ | Vai trò và Kiến trúc | Phạm vi Ứng dụng |

| NVLink | Giao tiếp tốc độ cao, điểm-tới-điểm giữa các GPU, hoặc giữa CPU và GPU. Hỗ trợ băng thông lên tới 1.8 TB/s. | Trong chip hoặc trên bo mạch chủ, kết nối các bộ xử lý gần nhau. |

| NVLink-C2C | Giao tiếp die-to-die (chip-to-chip) tốc độ cao, độ trễ thấp, có hỗ trợ tính nhất quán bộ nhớ. Là nền tảng cho Grace Hopper Superchip. | Kết nối các die trong một package duy nhất (ví dụ: CPU Grace và GPU Hopper). |

| NVSwitch | Chip chuyển mạch băng thông cao, cho phép giao tiếp all-to-all non-blocking giữa nhiều GPU. Mở rộng NVLink lên quy mô server và rack. | Kết nối các GPU trong một server, rack, hoặc cụm nhiều server. |

| NVLink Fusion | Chương trình cấp phép và bộ IP cho phép các nhà sản xuất bên thứ ba tích hợp giao thức NVLink vào chip tùy chỉnh của họ. | Cho phép các nhà sản xuất như MediaTek, Marvell, Fujitsu, Qualcomm kết nối CPU/ASIC của họ với GPU NVIDIA. |

3.2. Hai cấu hình tích hợp chính

NVLink Fusion hỗ trợ hai cấu hình chính cho việc tích hợp, thể hiện sự linh hoạt nhưng có kiểm soát của NVIDIA.

- Tích hợp CPU tùy chỉnh với GPU NVIDIA: Các đối tác như Qualcomm và Fujitsu có thể xây dựng CPU của riêng họ và kết nối trực tiếp với GPU Blackwell của NVIDIA. Điều này cho phép các hyperscaler tận dụng các kiến trúc CPU tùy chỉnh, tối ưu hóa cho các công việc cụ thể của họ (ví dụ: các tác vụ tiền xử lý dữ liệu) mà vẫn khai thác được hiệu suất tính toán hàng đầu của GPU NVIDIA

- Tích hợp CPU NVIDIA (Grace) với bộ tăng tốc tùy chỉnh: CPU Grace của NVIDIA có thể kết nối với các bộ tăng tốc tùy chỉnh (ASIC) từ các đối tác như Alchip.5 Cấu hình này mở rộng phạm vi ứng dụng của CPU Grace ra ngoài các hệ thống DGX mặc định của NVIDIA, tạo ra các giải pháp bán tùy chỉnh (semi-custom) cho những khách hàng có nhu cầu đặc biệt.

3.3. Hệ sinh thái đối tác và các dự án tiên phong

NVIDIA đã xây dựng một hệ sinh thái đối tác mạnh mẽ để triển khai NVLink Fusion. Các đối tác sản xuất chip AI tùy chỉnh đã cấp phép công nghệ này bao gồm MediaTek, Marvell, Alchip, Astera Labs, Synopsys và Cadence.

- MediaTek và Marvell đang hợp tác để cung cấp các dịch vụ thiết kế ASIC (Application Specific Integrated Circuit), tận dụng kinh nghiệm sâu rộng của họ trong các kết nối tốc độ cao để xây dựng thế hệ hạ tầng AI tiếp theo.

- Alchip hỗ trợ việc tích hợp NVLink Fusion thông qua hệ sinh thái thiết kế và sản xuất, đảm bảo các mô hình AI thế hệ mới có thể được huấn luyện và triển khai hiệu quả.

- Fujitsu và Qualcomm là hai trong số những nhà sản xuất CPU hàng đầu đã công bố kế hoạch tích hợp NVLink Fusion vào các CPU trung tâm dữ liệu của họ. Việc này mang lại sự linh hoạt cho các nhà xây dựng hệ thống khi có thể kết hợp CPU không phải của NVIDIA với GPU của NVIDIA.

- GUC, một công ty thiết kế chip, cũng tham gia vào hệ sinh thái này để giúp khách hàng tích hợp các XPU (bộ xử lý bất kỳ, ví dụ CPU/GPU/ASIC) tùy chỉnh vào hạ tầng MGX của NVIDIA.

Mặc dù bề ngoài đây là một động thái “mở”, phân tích kỹ lưỡng cho thấy NVIDIA đang thực hiện một chiến lược củng cố vị thế của mình. Các nguồn tin cho biết để sử dụng NVLink Fusion, hệ thống vẫn phải có một sản phẩm của NVIDIA. Hơn nữa, NVIDIA vẫn duy trì quyền kiểm soát đối với phần mềm và các giao thức cốt lõi, bao gồm cả việc quản lý các liên kết NVLink thông qua các bộ điều khiển và lớp vật lý (PHY). Điều này cho thấy chiến lược của NVIDIA không phải là tạo ra một sân chơi hoàn toàn tự do, mà là củng cố vai trò “không thể thay thế” của mình bằng cách biến các đối thủ cạnh tranh thành một phần của hệ sinh thái khép kín do họ dẫn dắt.

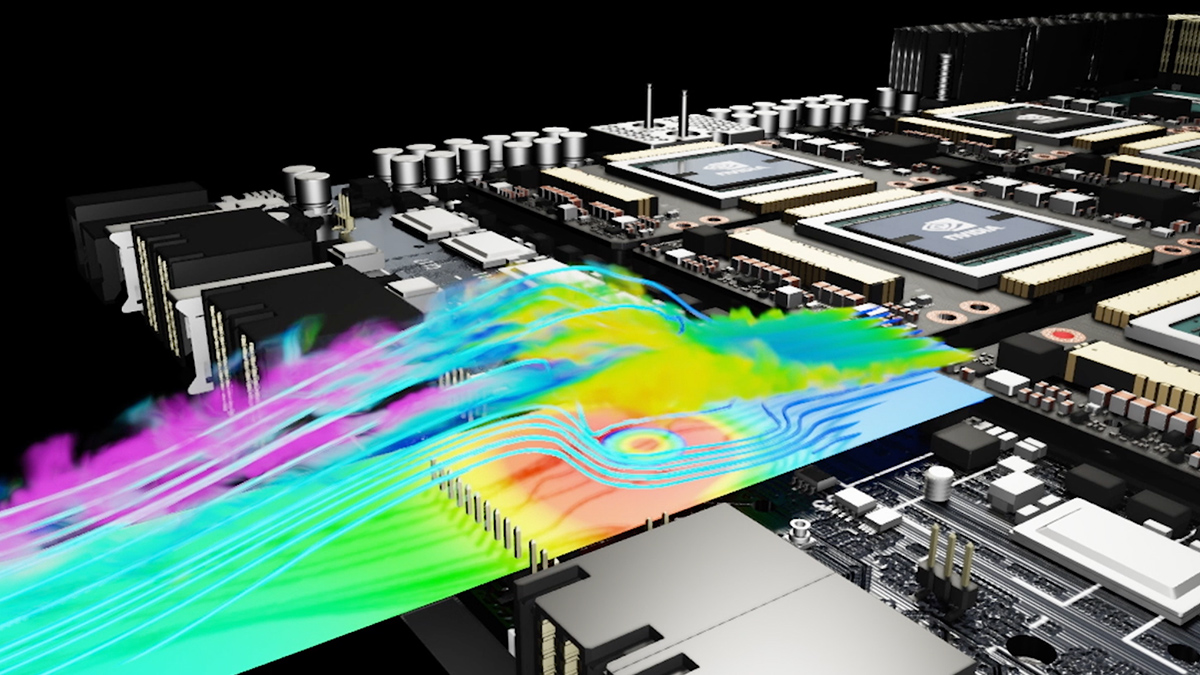

4. Các ứng dụng và hiệu suất của nó trong AI và HPC

4.1. Tác động đến huấn luyện và suy luận mô hình ngôn ngữ lớn (LLMs)

Một trong những thách thức lớn nhất trong việc làm việc với các mô hình LLM khổng lồ là chúng thường vượt quá dung lượng bộ nhớ của một GPU đơn lẻ. Để giải quyết vấn đề này, các kỹ thuật như phân song song mô hình (model parallelism) và phân song song tensor (tensor parallelism) được sử dụng, đòi hỏi sự giao tiếp liên tục và tốc độ cao giữa các GPU. NVLink, với băng thông 1.8 TB/s và độ trễ cực thấp, là yếu tố then chốt để đảm bảo hiệu suất không bị sụt giảm do tắc nghẽn giao tiếp.

NVSwitch đóng vai trò quan trọng trong việc nâng cao hiệu suất bằng cách cho phép giao tiếp “all-to-all non-blocking,” giúp các hoạt động tập thể (collective operations) như all-reduce diễn ra cực nhanh.Điều này giảm đáng kể thời gian chờ đợi giữa các bước tính toán, từ đó rút ngắn chu kỳ huấn luyện và suy luận. Ví dụ, hệ thống GB200 NVL72 được thiết kế để tất cả 72 GPU có thể hoạt động như một GPU duy nhất, mang lại hiệu suất suy luận nhanh hơn 30 lần cho các mô hình hàng nghìn tỷ tham số so với thế hệ trước.

4.2. Ứng dụng trong Trung tâm Dữ liệu và Siêu máy tính

NVLink Fusion giúp các hyperscaler triển khai các giải pháp quy mô rack dễ dàng hơn, đồng thời chuẩn hóa xung quanh một thiết kế rack chung để đơn giản hóa việc quản lý và tăng tốc độ đưa các “nhà máy AI” ra thị trường.

Các dự án siêu máy tính thực tế đã chứng minh khả năng mở rộng của công nghệ này.

- JUPITER, siêu máy tính mạnh nhất châu Âu, xếp hạng 4 trên bảng xếp hạng TOP500 và dẫn đầu Green500 về hiệu suất trên mỗi watt. Nó sử dụng kiến trúc NVIDIA Grace Hopper (GH200) với gần 24,000 GH200 Superchip, chứng minh khả năng mở rộng cực lớn để giải quyết các thách thức khoa học và AI.

- Alps, một siêu máy tính khác sử dụng GH200, cũng xếp hạng 8 trên TOP500. Các nghiên cứu hiệu suất trên hệ thống này cho thấy lợi thế vượt trội của bộ nhớ HBM3 so với LPDDR5X (DDR) trong các tác vụ suy luận LLM, với tốc độ nhanh hơn tới bốn lần.

Bảng 3: Thông số Kỹ thuật của Siêu máy tính Nổi bật sử dụng Grace Hopper (GH200)

| Tên Siêu máy tính | Vị trí TOP500 (T6/2025) | Rmax (PFlop/s) | Rpeak (PFlop/s) | CPU & GPU | Số lượng chip GH200 |

| JUPITER | 4 | 793.40 | 930.00 | NVIDIA Grace Hopper GH200 | ~23,752 |

| Alps | 8 | 434.90 | 574.84 | NVIDIA Grace Hopper GH200 | 10,400 |

| Isambard-AI phase 2 | 11 | 216.50 | 278.58 | NVIDIA Grace Hopper GH200 | – |

| Discovery 6 | 17 | 118.60 | 222.86 | NVIDIA Grace Hopper GH200 | – |

| Venado | 19 | 98.51 | 130.44 | NVIDIA Grace Hopper GH200 | – |

4.3. Giá trị của nó trong HPC và Mô phỏng Khoa học

Ngoài AI, NVLink và NVSwitch còn là những thành phần cốt lõi trong lĩnh vực HPC và mô phỏng khoa học.1 Chúng được sử dụng trong các siêu máy tính hàng đầu như Selene, Fugaku, và Summit, nơi cần hàng nghìn GPU để xử lý khối lượng dữ liệu khổng lồ với độ trễ cực thấp. Công nghệ này cho phép xử lý các mô phỏng thời tiết phức tạp, nghiên cứu y sinh, vật lý lượng tử và dự báo tài chính một cách hiệu quả hơn nhiều so với việc chỉ dựa vào PCIe.

5. Phân tích cạnh tranh và vị thế thị trường của NVIDIA

5.1. So sánh NVLink Fusion với các đối thủ chính

Để đánh giá toàn diện NVLink Fusion, cần đặt nó vào bối cảnh cạnh tranh với các công nghệ kết nối khác trên thị trường.

- NVLink vs. CXL (Compute Express Link):

- NVLink là một công nghệ độc quyền, được tối ưu hóa cho các cụm bộ tăng tốc đồng nhất (homogeneous) và các tác vụ song song quy mô lớn như huấn luyện deep learning.

- CXL là một chuẩn mở, được hỗ trợ rộng rãi bởi nhiều nhà sản xuất lớn như Intel, AMD và các nhà cung cấp cloud. CXL đặc biệt lý tưởng cho các kiến trúc hỗn hợp (mixed-architecture) và đặc biệt xuất sắc trong việc mở rộng bộ nhớ với tính nhất quán dữ liệu. Ban đầu, NVLink và CXL có vẻ là đối thủ cạnh tranh trực tiếp, nhưng xu hướng hiện nay lại cho thấy sự hợp nhất thay vì thay thế. Các thiết kế mới đang kết hợp cả hai công nghệ, sử dụng CXL cho các kết nối tổng quát và quản lý bộ nhớ phân tán, trong khi NVLink được dành cho giao tiếp tốc độ cao, độ trễ thấp giữa các GPU trong cùng một cụm.

- NVLink vs. AMD Infinity Fabric:

- NVLink chuyên biệt cho giao tiếp GPU-to-GPU, với băng thông cực cao lên đến 900 GB/s (trên H100) và 1.8 TB/s (trên Blackwell).

- AMD Infinity Fabric là một công nghệ kết nối linh hoạt hơn, được sử dụng trong cả CPU (EPYC) và GPU (Instinct), hỗ trợ cả CPU-GPU và GPU-GPU. Băng thông của Infinity Fabric cũng rất cao, lên tới 896 GB/s trên các chip MI300 series. Tuy nhiên, trong các cấu hình chỉ có GPU, độ trễ của Infinity Fabric có thể cao hơn NVLink.

Bảng 4: So sánh Băng thông và Hệ sinh thái: NVLink vs. CXL vs. Infinity Fabric.

| Công nghệ | Băng thông (Latest Gen) | Kiến trúc | Mục đích Sử dụng Chính | Nhà sản xuất/Đối tác |

| NVLink Fusion | 1.8 TB/s (tổng) | Độc quyền, nhưng mở qua cấp phép IP | GPU-GPU, GPU-CPU, CPU-ASIC trong các cụm đồng nhất | NVIDIA, MediaTek, Marvell, Fujitsu, Qualcomm, Astera Labs, Alchip, Synopsys, Cadence |

| CXL | Lên đến 256 GB/s (roadmap) | Chuẩn mở | Mở rộng bộ nhớ, hệ thống hỗn hợp, máy chủ tổng quát | Intel, AMD, NVIDIA, và toàn bộ CXL Consortium |

| Infinity Fabric | 896 GB/s (GPU-GPU) | Độc quyền | CPU-GPU, GPU-GPU trong các hệ thống dị thể | AMD |

5.2. Chiến lược “mở” của NVIDIA: Vị trí trung tâm được củng cố

Việc cấp phép NVLink Fusion cho các đối thủ cạnh tranh như AMD và Intel có thể được xem là một động thái “mở cửa” táo bạo. Tuy nhiên, các phân tích chuyên sâu cho thấy đây là một chiến lược tinh vi để củng cố vị thế của NVIDIA. Các nguồn tin chỉ ra rằng để sử dụng NVLink Fusion, hệ thống vẫn phải có một sản phẩm của NVIDIA. Điều này đảm bảo rằng các đối tác không thể xây dựng một stack hoàn toàn độc lập với các công nghệ của NVIDIA. Hơn nữa, NVIDIA vẫn kiểm soát phần mềm và các giao thức cốt lõi, bao gồm cả các lớp vật lý và bộ điều khiển quản lý kết nối.

Với chiến lược này, NVIDIA không tạo ra một sân chơi hoàn toàn tự do. Thay vào đó, họ cho phép các đối tác sử dụng chip tùy chỉnh của họ, nhưng lại biến họ thành một phần của hệ sinh thái khép kín do NVIDIA dẫn dắt. Điều này vừa ngăn cản các đối thủ phát triển một giải pháp cạnh tranh toàn diện, vừa mở rộng phạm vi ảnh hưởng của NVIDIA ra toàn bộ thị trường trung tâm dữ liệu. Kết quả là, NVIDIA duy trì được vị trí trung tâm không thể thay thế trong chuỗi giá trị AI, từ phần cứng đến phần mềm và kết nối.

6. Kết luận và triển vọng tương lai

NVLink Fusion là một bước tiến mang tính chiến lược, mở rộng công nghệ NVLink từ một kết nối độc quyền trở thành một nền tảng tích hợp cho các kiến trúc điện toán dị thể. Đây không chỉ là một cải tiến về tốc độ và băng thông mà còn là một động thái kinh doanh nhằm định hình lại thị trường trung tâm dữ liệu AI.

Bằng cách cho phép các nhà sản xuất chip bên thứ ba tích hợp công nghệ NVLink vào sản phẩm của họ, NVIDIA đang thúc đẩy sự đổi mới trong lĩnh vực thiết kế chip tùy chỉnh và rút ngắn thời gian đưa các “nhà máy AI” ra thị trường. NVLink Fusion sẽ là nền tảng cho thế hệ siêu máy tính tiếp theo, các giải pháp AI quy mô lớn và các trung tâm dữ liệu thế hệ mới.1

Tương lai của điện toán hiệu năng cao sẽ không chứng kiến một công nghệ nào thay thế hoàn toàn công nghệ khác. Thay vào đó, sự hợp tác và cạnh tranh sẽ đan xen. Các công nghệ như NVLink và CXL có khả năng sẽ cùng tồn tại, mỗi loại phục vụ một mục đích khác nhau trong một kiến trúc phân cấp phức tạp. NVIDIA, thông qua NVLink Fusion, đã đặt mình vào vị trí trung tâm của cuộc chơi này, đảm bảo rằng dù các chip từ các nhà sản xuất khác có được sử dụng, thì kiến trúc và hệ sinh thái do họ tạo ra vẫn sẽ là nền tảng cốt lõi cho cuộc cách mạng AI toàn cầu.

Nguồn trích dẫn

- NVIDIA NVLink: How It Works, Use Cases & Critical Best Practices – Atlantic.Net, https://www.atlantic.net/gpu-server-hosting/nvidia-nvlink-how-it-works-use-cases-and-critical-best-practices/

- NVIDIA NVLink Fusion: Building Semi-Custom AI Infrastructure – YouTube, https://www.youtube.com/watch?v=BLLf4e9BqXs

- Scaling AI Inference Performance and Flexibility with NVIDIA NVLink and NVLink Fusion, https://developer.nvidia.com/blog/scaling-ai-inference-performance-and-flexibility-with-nvidia-nvlink-and-nvlink-fusion/

- Nvidia unlocks NVLink for third-party CPUs from Qualcomm, Fujitsu …, https://www.capacitymedia.com/article/nvidia-unlocks-nvlink-for-third-party-cpus-from-qualcomm-fujitsu

- Nvidia Licenses NVLink Memory Ports To CPU And Accelerator …, https://www.nextplatform.com/2025/05/19/nvidia-licenses-nvlink-memory-ports-to-cpu-and-accelerator-makers/

- Build Semi-Custom AI Infrastructure | NVIDIA NVLink Fusion, https://www.nvidia.com/en-us/data-center/nvlink-fusion/

- NVLink & NVSwitch: Fastest HPC Data Center Platform | NVIDIA, https://www.nvidia.com/en-us/data-center/nvlink/

- NVIDIA NVLink and NVIDIA NVSwitch Supercharge Large Language Model Inference,https://developer.nvidia.com/blog/nvidia-nvlink-and-nvidia-nvswitch-supercharge-large-language-model-inference/

- Advanced Optimization Strategies for LLM Training on NVIDIA Grace Hopper, https://developer.nvidia.com/blog/advanced-optimization-strategies-for-llm-training-on-nvidia-grace-hopper/

- Simplify System Memory Management with the Latest NVIDIA GH200 NVL2 Enterprise RA, https://resources.nvidia.com/en-us-certified-systems/simplify-system-memo

- Grace Hopper Superchip – NVIDIA Docs, https://docs.nvidia.com/clara/parabricks/latest/gettingstarted/gracehopper.html

- NVIDIA Unveils NVLink Fusion for Industry to Build Semi-Custom AI Infrastructure With NVIDIA Partner Ecosystem, https://nvidianews.nvidia.com/news/nvidia-nvlink-fusion-semi-custom-ai-infrastructure-partner-ecosystem

- Marvell and NVIDIA to Provide Custom Solutions for Advanced AI …, truy cập vào tháng 9 10, 2025, https://www.marvell.com/company/newsroom/marvell-nvidia-provide-to-custom-solutions-advanced-ai-infrastructure.html

- DistriFusion: Distributed Parallel Inference for High-Resolution Diffusion Models – arXiv, truy cập vào tháng 9 10, 2025, https://arxiv.org/html/2402.19481v1

- How does NVIDIA’s NVLink technology improve large language model training performance? – Massed Compute, truy cập vào tháng 9 10, 2025, https://massedcompute.com/faq-answers/?question=How%20does%20NVIDIA%27s%20NVLink%20technology%20improve%20large%20language%20model%20training%20performance?

- Jupiter Boots Up: Europe’s Fastest Supercomputer Runs on NVIDIA Grace Hopper, truy cập vào tháng 9 10, 2025, https://www.techpowerup.com/340711/jupiter-boots-up-europes-fastest-supercomputer-runs-on-nvidia-grace-hopper

- TOP500 List – June 2025 | TOP500, truy cập vào tháng 9 10, 2025, https://top500.org/lists/top500/list/2025/06/

- NVIDIA Grace Hopper Superchip Powers JUPITER, định hình một lớp máy tính siêu – technologyMAG.net, truy cập vào tháng 9 10, 2025, https://www.technologymag.net/wp-content/uploads/2024/01/NVIDIA-Grace-Hopper-Superchip-Powers-JUPITER-di%CC%A3nh-hi%CC%80nh-mo%CC%A3%CC%82t-lo%CC%9B%CC%81p-ma%CC%81y-ti%CC%81nh-sie%CC%82u-ma%CC%A3nh-mo%CC%9B%CC%81i-de%CC%82%CC%89-thu%CC%81c-da%CC%82%CC%89y-tri%CC%81-tue%CC%A3%CC%82-nha%CC%82n-ta%CC%A3o-trong-li%CC%83nh-vu%CC%9B%CC%A3c-nghie%CC%82n-cu%CC%9B%CC%81u-khoa-ho%CC%A3c.pdf

- Researchers Benchmark Nvidia’s GH200 Supercomputing Chips, truy cập vào tháng 9 10, 2025, https://www.hpcwire.com/2024/09/04/researchers-benchmark-nvidias-gh200-supercomputing-chips/

- TOP500 – Wikipedia, truy cập vào tháng 9 10, 2025, https://en.wikipedia.org/wiki/TOP500

- CXL vs NVLink: Next-Gen Server Interconnect Battle – Varidata, truy cập vào tháng 9 10, 2025, https://www.varidata.com/blog-en/cxl-vs-nvlink-next-gen-server-interconnect-battle/

- Compute Express Link – Wikipedia, truy cập vào tháng 9 10, 2025, https://en.wikipedia.org/wiki/Compute_Express_Link

- Panmnesia pushes unified memory and interconnect design for AI superclusters, truy cập vào tháng 9 10, 2025, https://blocksandfiles.com/2025/07/18/panmnesia-cxl-over-xlink-ai-supercluster-architecture/

- What is the difference between NVIDIA NVLink and AMD Infinity Fabric in terms of bandwidth? – Massed Compute, truy cập vào tháng 9 10, 2025, https://massedcompute.com/faq-answers/?question=What%20is%20the%20difference%20between%20NVIDIA%20NVLink%20and%20AMD%20InfinityFabric%20in%20terms%20of%20bandwidth?

- How do NVLink and Infinity Fabric compare in terms of scalability for multi-GPU configurations? – Massed Compute, truy cập vào tháng 9 10, 2025, https://massedcompute.com/faq-answers/?question=How%20do%20NVLink%20and%20Infinity%20Fabric%20compare%20in%20terms%20of%20scalability%20for%20multi-GPU%20configurations?

- Chip AMD là gì? Đặc điểm & So sánh giữa CPU AMD & CPU Intel – InterData, truy cập vào tháng 9 10, 2025, https://interdata.vn/blog/chip-amd-la-gi/

- So sánh chip AMD và Intel: Chip nào mang lại hiệu suất ổn định nhất? – MemoryZone, truy cập vào tháng 9 10, 2025, https://memoryzone.com.vn/so-sanh-chip-amd-va-intel

Bài viết liên quan

- NVIDIA NGC‑ready Low‑latency Edge AI: Giải pháp cho Retail, Manufacturing và Smart Cities

- So sánh sức mạnh của máy tính AI DGX Spark với các card GPU máy trạm chuyên nghiệp của NVIDIA

- Từ Orin đến Thor: Bước nhảy vọt kiến trúc của NVIDIA JetPack 7.0 và tương lai của robot hình người

- Tại sao gọi NVIDIA DGX Spark là Siêu máy tính AI cá nhân?

- Cơ chế quản lý bộ nhớ trên các nền tảng phần cứng nhất quán – Hardware-coherent

- Kiến trúc NVIDIA Blackwell với GB200 NVL72: Định nghĩa lại điện toán AI cấp độ Exascale