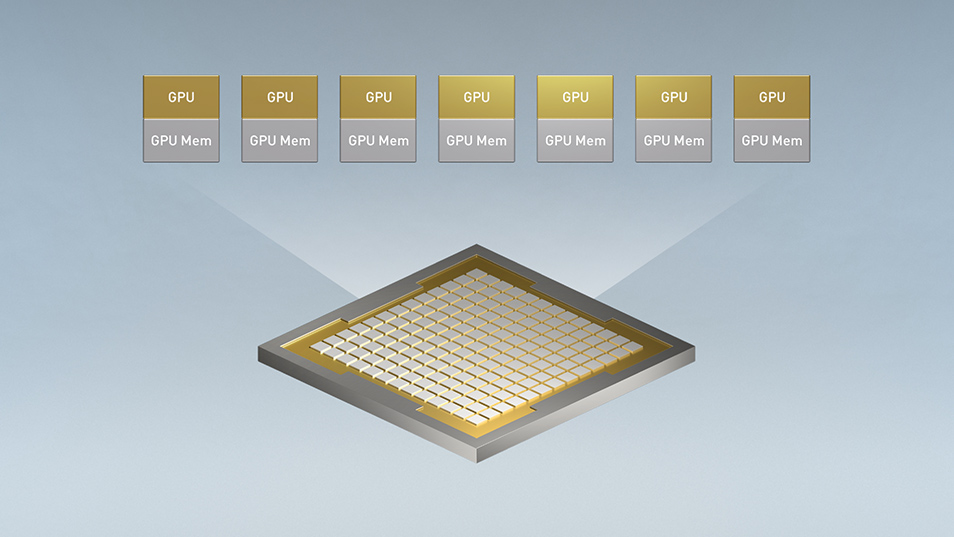

Bảy thực thể (instance) độc lập tạo ra từ một GPU

Multi-Instance GPU (MIG) mở rộng hiệu năng và giá trị của từng GPU NVIDIA A100 Tensor Core. MIG có thể phân vùng GPU A100 thành tối đa bảy thực thể, mỗi thực thể được cô lập hoàn toàn với bộ nhớ băng thông cao, bộ nhớ cache và lõi xử lý. Giờ đây, quản trị viên có thể hỗ trợ mọi khối lượng công việc, từ nhỏ nhất đến lớn nhất, cung cấp GPU có kích thước phù hợp với chất lượng dịch vụ (QoS) được đảm bảo cho mọi công việc, tối ưu hóa việc sử dụng và mở rộng phạm vi tài nguyên máy tính được tăng tốc cho mọi người dùng.

TỔNG QUAN VỀ LỢI ÍCH

Mở rộng quyền truy cập GPU đến nhiều người dùng hơn

Với MIG, bạn có thể đạt được gấp 7 lần tài nguyên GPU trên một GPU A100. MIG cung cấp cho các nhà nghiên cứu và nhà phát triển nhiều tài nguyên và tính linh hoạt hơn bao giờ hết.

Tối ưu hóa việc sử dụng GPU

MIG cung cấp tính linh hoạt để chọn nhiều kích thước thực thể khác nhau, cho phép cung cấp các GPU instance có kích thước phù hợp cho từng workload, cuối cùng mang lại hiệu quả sử dụng tối ưu và tối đa hóa đầu tư trung tâm dữ liệu.

Chạy khối lượng công việc hỗn hợp đồng thời

MIG cho phép khối lượng công việc suy luận, đào tạo và tính toán hiệu năng cao (HPC) chạy cùng lúc trên một GPU với độ trễ và thông lượng xác định.

CÔNG NGHỆ HOẠT ĐỘNG NHƯ THẾ NÀO

Không có MIG, các công việc khác nhau chạy trên cùng một GPU, chẳng hạn như các yêu cầu suy luận AI khác nhau, cạnh tranh cùng một tài nguyên chẳng hạn như băng thông bộ nhớ. Một tác vụ tiêu tốn băng thông bộ nhớ lớn hơn khiến các tác vụ khác chết đói, dẫn đến một số tác vụ bị trễ so với mục tiêu. Với MIG, các công việc chạy đồng thời trên các thực thể khác nhau, mỗi thực thể có tài nguyên chuyên biệt về xử lý, bộ nhớ và băng thông bộ nhớ, dẫn đến hiệu suất có thể định đoán được với chất lượng dịch vụ và mức sử dụng GPU tối đa.

Cho phép sự linh hoạt tối đa của trung tâm dữ liệu

GPU NVIDIA A100 có thể được phân vùng thành các MIG instance có kích thước khác nhau. Ví dụ: quản trị viên có thể tạo hai instance với bộ nhớ 20 gigabyte (GB)/instance hoặc ba instance với 10 GB hoặc bảy instance với 5 GB. Hoặc trộn lẫn nhiều kích cỡ. Vì vậy, Sysadmin có thể cung cấp GPU có kích thước phù hợp cho người dùng cho các loại khối lượng công việc khác nhau.

Các MIG instance cũng có thể được cấu hình lại một cách linh hoạt, cho phép quản trị viên thay đổi tài nguyên GPU để đáp ứng nhu cầu thay đổi của người dùng và doanh nghiệp. Ví dụ, bảy trường hợp MIG có thể được sử dụng vào ban ngày để suy luận thông lượng thấp và được cấu hình lại thành một trường hợp MIG lớn vào ban đêm để đào tạo học tập sâu.

Cung cấp chất lượng dịch vụ vượt trội

Mỗi phiên bản MIG có một bộ tài nguyên phần cứng chuyên dụng để tính toán, bộ nhớ và bộ đệm, cung cấp chất lượng dịch vụ (QoS) được đảm bảo và cách ly lỗi cho khối lượng công việc. Điều đó có nghĩa là lỗi trong một ứng dụng chạy trên một cá thể không ảnh hưởng đến các ứng dụng chạy trên các cá thể khác. Và các trường hợp khác nhau có thể chạy các loại khối lượng công việc khác nhau Phát triển mô hình tương tác, đào tạo học sâu, suy luận AI hoặc các ứng dụng HPC. Do các cá thể chạy song song, nên các khối lượng công việc cũng chạy song song với nhau nhưng tách biệt và tách biệt trên cùng một GPU A100 vật lý.

MIG rất phù hợp với khối lượng công việc như phát triển mô hình AI và suy luận độ trễ thấp. Các khối lượng công việc này có thể tận dụng tối đa các tính năng của A100 và phù hợp với bộ nhớ được phân bổ của từng trường hợp.

Được thiết kế để phục vụ cho bộ phận IT và DevOps

MIG được xây dựng để dễ dàng triển khai bởi các nhóm IT và DevOps.

Mỗi MIG-instance hoạt động giống như một GPU độc lập cho các ứng dụng, do đó không có thay đổi nào đối với nền tảng CUDA®. Các mô hình AI và các ứng dụng được đóng gói HPC, chẳng hạn như các ứng dụng từ NGC™ , có thể chạy trực tiếp trên một cá thể MIG với NVIDIA Container Runtime. Các phiên bản MIG xuất hiện dưới dạng tài nguyên GPU bổ sung trong bộ điều phối bộ chứa như Kubernetes, có thể lên lịch cho khối lượng công việc được chứa để chạy trong các phiên bản GPU cụ thể. Tính năng này sẽ sớm được cung cấp thông qua plugin thiết bị NVIDIA cho Kubernetes.

Các tổ chức có thể tận dụng lợi ích quản lý, giám sát và vận hành của ảo hóa máy chủ dựa trên nền tảng ảo hóa, bao gồm di chuyển trực tiếp và thuê nhiều người, trên các phiên bản GPU MIG với Máy chủ tính toán ảo NVIDIA (vComputeServer).

Bài viết liên quan

- NVIDIA NGC‑ready Low‑latency Edge AI: Giải pháp cho Retail, Manufacturing và Smart Cities

- So sánh sức mạnh của máy tính AI DGX Spark với các card GPU máy trạm chuyên nghiệp của NVIDIA

- Từ Orin đến Thor: Bước nhảy vọt kiến trúc của NVIDIA JetPack 7.0 và tương lai của robot hình người

- Tại sao gọi NVIDIA DGX Spark là Siêu máy tính AI cá nhân?

- Cơ chế quản lý bộ nhớ trên các nền tảng phần cứng nhất quán – Hardware-coherent

- Kiến trúc NVIDIA Blackwell với GB200 NVL72: Định nghĩa lại điện toán AI cấp độ Exascale