Giám đốc điều hành trung tâm dữ liệu của Intel, Navin Shenoy, đã khởi động chiến dịch Data-Centric Innovation Summit của công ty, chương trình dài hơi dành cho chiến lược trung tâm dữ liệu của Intel, với các cập nhật về sản phẩm và công nghệ, bao gồm một kiến trúc Xeon 14nm chủ lực khác, được gọi là Cooper Lake.

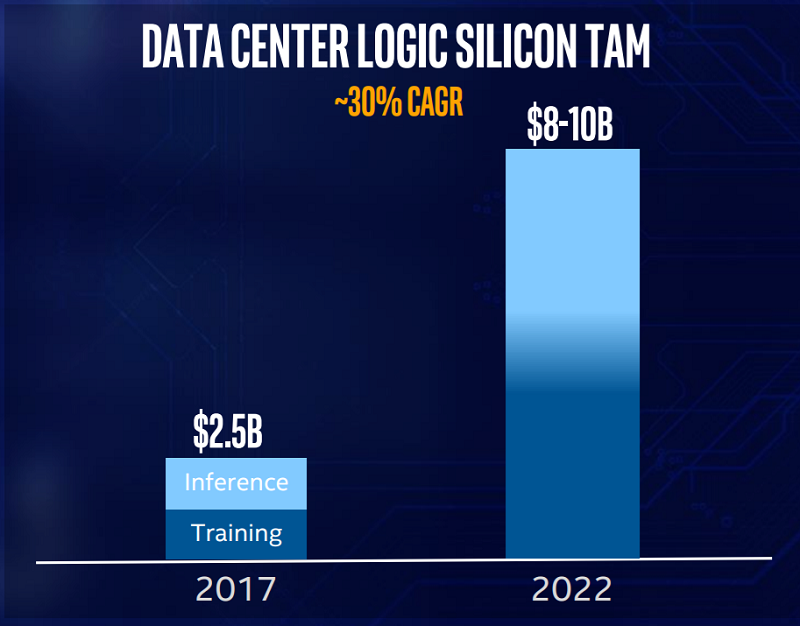

Một báo cáo ấn tượng vừa được công bố là mảng chip của Intel đã đạt doanh thu 1 tỷ USD riêng cho lĩnh vực trí tuệ nhân tạo trong năm 2017. Phần lớn trong số đó đến từ mảng tính toán suy luận – inference workloads, Intel tiết lộ, lưu ý rằng mảng FGPA và IoT không được tính trong báo cáo đó. Hãng cho rằng tiềm năng của AI sẽ tăng lên 10 tỷ USD vào năm 2022.

Nguồn: Intel

“Sẽ có một phần [trong tổng số thị phần được xác định] đó là mảng đào tạo – training và một phần là mảng tính toán suy luận”, người đứng đầu Intel về sản phẩm AI Naveen Rao nói. “Tuy nhiên, sẽ có những chuyển dịch và bạn có thể thấy lằn ranh phân biệt ngày càng mờ đi. Chúng tôi hy vọng rằng việc học tăng cường – reinforcement learning – sẽ bắt đầu xuất hiện một cách mạnh mẽ, kết hợp với khả năng mô phỏng, học tập chuyển giao và các mô hình hybrid. Sẽ có một tương lai mà việc học sẽ được phân phối từ end-point đến các edge, rồi đến cloud”.

Theo tính toán của Intel và đánh giá của họ về AI TAM, công ty đã chiếm được thị phần chi phối trong mảng tính toán suy luận. Nvidia có lẽ sẽ không đồng ý với điều này.

Được yêu cầu nhận xét, nhà phân tích ngành công nghiệp Patrick Moorhead, chủ tịch và nhà phân tích chính của Moor Insights & Strategy, cho biết: “Trên mặt trận AI, nếu đi xem sự kiện của Intel, bạn sẽ nghĩ ngay Intel là một công ty lớn trong ngành công nghiệp AI. Nhưng tôi phải nói, tôi không hề nghe nhiều về Intel trong AI từ bất kỳ ai khác ngoài Intel. Vân, 1 tỷ USD là 1 tỷ USD. Nhưng bạn có thể sẽ nói rằng Nvidia mới thực sự là cái tên thống trị? Và liệu chúng ta có thể rút ra từ sự kiện hôm nay mà Intel không tuyên bố mình có là hãng chủ lực trong mảng đào tạo của AI? ”

Dựa trên sự tăng trưởng của AI và các phân tích, Intel cho biết họ đang sửa đổi kế hoạch phát triển thị phần mảng data center từ 160 tỷ USD năm 2021 lên 200 tỷ USD vào năm 2022. Đây là cơ hội lớn nhất trong lịch sử của công ty, Shenoy nói.

Với việc kiến trúc 10nm Ice Lake bị trì hoãn cho đến năm 2020, Intel đang tiếp tục mở rộng và phát triển thế hệ 14nm. “Chúng tôi đang tiếp tục cải tiến kiến trúc vi xử lý này, cùng với đó là thúc đẩy việc phát triển về phần mềm”, Shenoy nói.

Trong việc xây dựng lộ trình cho nền tảng Xeon của mình, công ty đã thông báo việc bổ sung Cooper Lake 14nm nhắm vào việc ra mắt vào cuối năm 2019. “Chúng tôi đã tạo ra một nền tảng linh hoạt, giàu tính năng cho phép khách hàng của chúng tôi lựa chọn đúng CPU cho khối lượng công việc của họ, sẽ hỗ trợ cả CPU 14nm mới được gọi là Cooper Lake và sản phẩm 10nm Ice Lake”, Shenoy cho biết. Cooper Lake sẽ “đem đến những cải tiến đáng kể về mặt hiệu suất ở cấp độ kiến trúc”, theo giám đốc điều hành.

Xeon thế hệ tiếp theo, tên mã là Cascade Lake, đang đi đúng kế hoạch để ra mắt vào cuối năm 2018. Dựa trên công nghệ 14nm, Cascade Lake sẽ cung cấp phần mở rộng mới về AI cho Xeon gọi là Intel Deep Learning Boost (DL Boost) phát triển trên Intel AVX 512, thêm một module vector neural network instruction (VNNI) có thể xử lý các convolutions INT8 với số lệnh ít hơn. Trong một buổi trình diễn hiệu năng sử dụng một phiên bản mô phỏng* của Cascade Lake trong tương lai với DL Boost đã đạt được tốc độ trung bình khoảng 11x so với Skylake, chạy Caffe ResNet-50, một AI workload phổ biến để phân loại hình ảnh.

Cascade Lake cũng ra mắt bộ nhớ dài hạn Intel Optane DC và cung cấp các tính năng bảo mật nâng cao để giải quyết các lỗ hổng của Spectre và Meltdown.

Bộ nhớ dài hạn Intel Optane DC được công bố gần đây là một phân lớp bộ nhớ lưu trữ mới cung cấp một kênh lưu dữ liệu dài hạn giữa DRAM và SSD. Nó có hiệu năng gấp tám lần cấu hình chỉ với DRAM, theo Intel. Các đơn vị sản xuất đầu tiên của bộ nhớ dài hạn Optane đã được chuyển tới Google và theo kế hoạch sẽ sẵn sàng triển khai rộng rãi vào năm 2019.

Tiếp theo là Cascade Lake, Cooper Lake, ra mắt một phần mở rộng AI mới khác: bfloat16. Là một phần của dòng sản phẩm DL Boost, nó tăng cường ngưỡng chấp nhận của AI ở phép toán chính xác thấp và chủ yếu sẽ được sử dụng cho các thuật toán đào tạo. “Chúng tôi đang tiêu chuẩn hóa mạnh mẽ trên bfloat16 và truyền nó vào tất cả các sản phẩm của chúng tôi trong Xeon và Neural Network Processor (NNP) của chúng tôi”, Shenoy nói, và vì vậy bạn có thể mong đợi chúng tôi […] thúc đẩy một sự thúc đẩy tích cực trong quá trình nửa cuối năm nay vào năm 2019 và 2020″.

Tại hội nghị phát triển AI tại San Francisco vào tháng 5, Intel đã công bố kế hoạch cho sản phẩm Nervana thương mại đầu tiên, NNP L-1000 (có tên mã Spring Crest), cho biết cung cấp hiệu suất đào tạo 3-4x của sản phẩm phát triển, Lake Crest. Spring Crest được dự đoán vào cuối năm 2019, và Intel cho biết họ cũng đang xây dựng một biến thể cho thị trường suy luận, nhưng chưa sẵn sàng tiết lộ bất kỳ chi tiết nào.

Nói về sự cạnh tranh cho thị phần AI, Rao nói rằng ông muốn cắt giảm thông qua những huyền thoại rằng GPU là thứ duy nhất ngoài kia dành cho AI. “Thực tế gần như là tất cả suy luận trên thế giới chạy trên Xeon ngày nay và khoảng cách hiệu suất giữa máy tính đa năng và các loại máy tính cụ thể như GPU không phải là khoảng cách khổng lồ như 100x, nó lớn hơn 3x, và điều đó không sao”, ông nói . “Vì máy tính có mục đích chung có quy mô mà một giải pháp cụ thể không thể thực sự đạt được. Mọi thứ đều có vị trí của nó. Khi AI bắt đầu tiến vào máy tính đa năng, chúng tôi đã đạt được quy mô với công nghệ mới mà chúng tôi không thể thực hiện trước đây, vì vậy chúng tôi liên tục phát triển nền tảng của mình để làm cho nó trở nên tốt nhất AI cũng như mọi thứ khác mà Xeon làm hôm nay.

“Xeon không được tối ưu hóa tốt [cho AI] từ góc độ phần mềm, từ cách đây hai năm”, Rao nói thêm. “Nhưng chỉ từ sự kiện ra mắt của Skylake vào tháng 7 năm 2017, chúng tôi đã tăng hiệu suất suy luận thêm 5.4x* và đào tạo là 1.4x*. Chúng tôi đã thêm những thứ như phép nhân vector và ma trận và các lệnh SIMD khi Skylake được tung ra để tiếp tục các cải tiến gen-on-gen. Với Cascade Lake, chúng tôi đã bổ sung DL Boost, dòng sản phẩm với các khả năng mới và cho bạn thấy một cải tiến, được dự kiến, gấp 11x”.

Sự kiện Intel đã tập trung rộng rãi vào chiến lược data center và AI, nhưng chưa đưa ra thông tin chi tiết về các kế hoạch công nghệ cụ thể của HPC. Trong khi dòng sản phẩm Phi [TM] đã gần đến hết đời, Intel đang dựa vào sự kế thừa của Phi cho kế hoạch exascale của họ và đang trong quá trình đi đến một hệ thống cấp độ exascale, hoặc ít nhất là exaflops, cho Argonne Lab vào năm 2021 (mặc dù hợp đồng vẫn chưa được ký). Một roadmap bị rò rỉ của Intel rộ lên vài tuần trước (thông qua AnandTech) cho thấy rằng, ngoài Xeon Phi tiếp nối bởi Cascade Lake-AP (AP = Advanced Processor), dự định ra mắt trong nửa đầu năm 2019, tiếp theo là “AP thế hệ kế tiếp” dự kiến ra mắt vào giữa năm 2020.

Một số slide bị rò rỉ cũng cho thấy sự kế thừa của Omni-Path, OPA 200, xuất hiện vào cuối năm 2019. Các sản phẩm được lên kế hoạch bao gồm switch 64 port, 2.048 director port và adapter PCIe4 x 16 Host Fabric Interface (HFI) ).

Bài viết liên quan

- Huấn luyện mô hình hàng trăm tỷ tham số ngay tại bàn với MSI EdgeXpert

- NVIDIA Merlin: Tổng quan về toolkit cho hệ thống gợi ý quy mô lớn

- OpenAI lần đầu phát hành miễn phí mô hình ngôn ngữ mới với tên gọi là GPT-OSS

- 5 điều bạn cần biết về NVIDIA DGX Spark – Chiếc máy tính mơ ước của các nhà phát triển AI

- SLM và AI tại biên: Bình minh của một kỷ nguyên mới hay chỉ là cơn sốt nhất thời?

- NVIDIA tại Computex 2025: “Gã khổng lồ xanh” đặt cược tất cả vào AI, GeForce liệu có bị ra rìa?