Vừa quan NVIDIA đã ra mắt GPU H200 mới, một bộ xử lý đồ họa (GPU) được thiết kế để đào tạo và triển khai các loại mô hình Trí tuệ Nhân tạo đang thúc đẩy làn sóng bùng nổ AI.

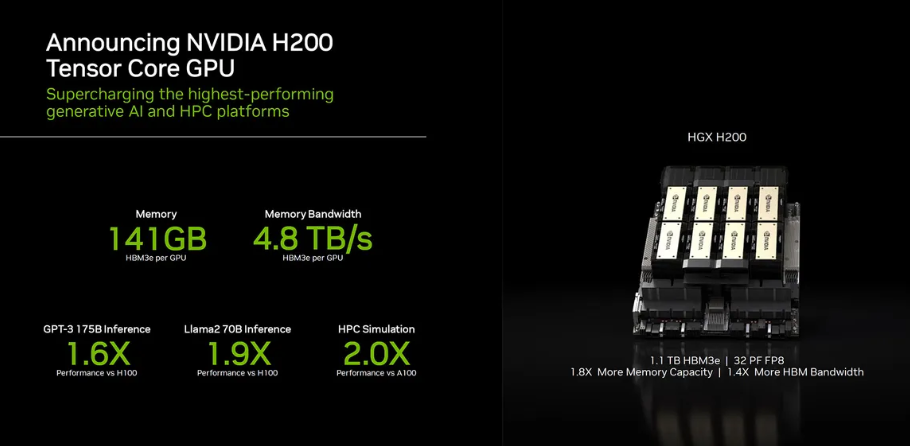

NVIDIA H200 Tensor Core GPU đẩy mạnh khả năng tính toán của trí tuệ nhân tạo tạo sinh và công việc máy tính hiệu suất cao (HPC) với hiệu suất và khả năng lưu trữ đổi mới. Là GPU đầu tiên tích hợp công nghệ HBM3e, bộ nhớ lớn và nhanh hơn của H200 đưa ra động lực cho việc tăng tốc của trí tuệ nhân tạo tạo sinh và các mô hình ngôn ngữ lớn (LLMs), đồng thời đẩy mạnh tính toán khoa học cho công việc HPC.

Hiệu suất mạnh mẽ, Bộ nhớ lớn và nhanh hơn

Dựa trên kiến trúc NVIDIA Hopper, NVIDIA H200 là GPU đầu tiên cung cấp 141 gigabyte (GB) bộ nhớ HBM3e với tốc độ 4.8 terabyte mỗi giây (TB/s) — gần như gấp đôi dung lượng của GPU Tensor Core NVIDIA H100 với băng thông bộ nhớ tăng 1.4 lần. Bộ nhớ lớn và nhanh hơn của H200 thúc đẩy tăng tốc trí tuệ nhân tạo tạo sinh và các mô hình ngôn ngữ lớn (LLMs), đồng thời nâng cao tính toán khoa học cho công việc HPC với hiệu quả năng lượng cao và chi phí sở hữu tổng cộng thấp hơn.

Mở khóa kiến thức với Infer LLMs hiệu suất cao

Trong cảnh đối diện với sự phát triển không ngừng của trí tuệ nhân tạo, doanh nghiệp phải dựa vào LLMs để đáp ứng nhu cầu đa dạng của quá trình suy luận. Một bộ gia tốc suy luận trí tuệ nhân tạo phải cung cấp thông lượng cao nhất với chi phí sở hữu thấp nhất khi triển khai quy mô lớn cho một lượng người dùng khổng lồ.

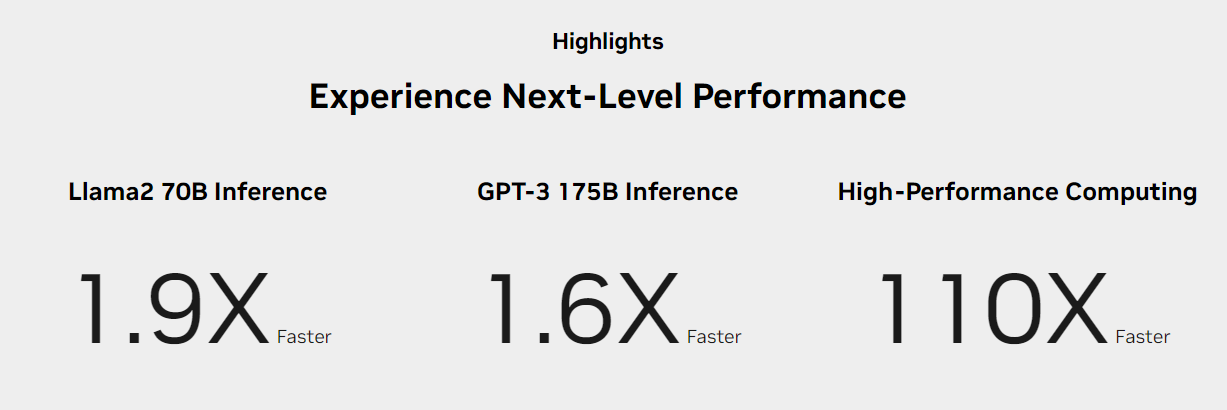

H200 tăng tốc độ suy luận lên đến 2 lần so với GPU H100 khi xử lý LLMs như Llama2.

Đẩy mạnh tính toán Hiệu suất cao HPC

Băng thông bộ nhớ quyết định cho các ứng dụng HPC vì nó tăng tốc quá trình truyền dữ liệu, giảm thiểu các chướng ngại về xử lý phức tạp. Đối với các ứng dụng HPC yêu cầu nhiều bộ nhớ như mô phỏng, nghiên cứu khoa học và trí tuệ nhân tạo, băng thông bộ nhớ cao của H200 đảm bảo dữ liệu có thể được truy cập và xử lý một cách hiệu quả, dẫn đến thời gian đạt kết quả nhanh hơn lên đến 110 lần so với CPU.

Giảm năng lượng và Chi phí

Với sự ra mắt của H200, hiệu quả năng lượng và chi phí sở hữu đạt đến mức độ mới. Công nghệ tiên tiến này mang lại hiệu suất vô song, tất cả trong cùng một hồ sơ năng lượng như H100. Những nhà máy trí tuệ nhân tạo và hệ thống siêu máy tính không chỉ nhanh chóng mà còn thân thiện với môi trường, mang lại một lợi thế kinh tế đẩy mạnh cộng đồng trí tuệ nhân tạo và khoa học về phía trước.

Đổi mới liên tục mang lại những bước tiến vững chắc

Kiến trúc NVIDIA Hopper mang đến một bước nhảy hiệu suất chưa từng có so với phiên bản trước đó và tiếp tục nâng tầm với những cải tiến liên tục thông qua việc cập nhật phần mềm cho H100, bao gồm việc phát hành gần đây các thư viện mã nguồn mở mạnh mẽ như NVIDIA TensorRT-LLM™.

Sự xuất hiện của H200 tiếp tục đà tăng cường với hiệu suất cao hơn. Đầu tư vào nó đảm bảo lãnh đạo về hiệu suất không chỉ trong hiện tại mà còn trong tương lai, qua những cải tiến liên tục của phần mềm được hỗ trợ.

NVIDIA H200 Tensor Core GPU Specs:

| Form Factor | H200 SXM¹ |

|---|---|

| FP64 | 34 TFLOPS |

| FP64 Tensor Core | 67 TFLOPS |

| FP32 | 67 TFLOPS |

| TF32 Tensor Core | 989 TFLOPS² |

| BFLOAT16 Tensor Core | 1,979 TFLOPS² |

| FP16 Tensor Core | 1,979 TFLOPS² |

| FP8 Tensor Core | 3,958 TFLOPS² |

| INT8 Tensor Core | 3,958 TFLOPS² |

| GPU Memory | 141GB |

| GPU Memory Bandwidth | 4.8TB/s |

| Decoders | 7 NVDEC 7 JPEG |

| Max Thermal Design Power (TDP) | Up to 700W (configurable) |

| Multi-Instance GPUs | Up to 7 MIGs @16.5GB each |

| Form Factor | SXM |

| Interconnect | NVIDIA NVLink®: 900GB/s PCIe Gen5: 128GB/s |

| Server Options | NVIDIA HGX™ H200 partner and NVIDIA-Certified Systems™ with 4 or 8 GPUs |

| NVIDIA AI Enterprise | Add-on |

→ Siêu máy tính NVIDIA H200/H100 hiện đã sẵn sàng và có thể đặt hàng, vui lòng liên hệ tại đây để được hỗ trợ tốt nhất.

→ Để biết thêm thông tin và xem toàn bộ dòng sản phẩm NVIDIA, vui lòng truy cập tại đây.

Bài viết liên quan

- NVIDIA NGC‑ready Low‑latency Edge AI: Giải pháp cho Retail, Manufacturing và Smart Cities

- So sánh sức mạnh của máy tính AI DGX Spark với các card GPU máy trạm chuyên nghiệp của NVIDIA

- Từ Orin đến Thor: Bước nhảy vọt kiến trúc của NVIDIA JetPack 7.0 và tương lai của robot hình người

- Tại sao gọi NVIDIA DGX Spark là Siêu máy tính AI cá nhân?

- Cơ chế quản lý bộ nhớ trên các nền tảng phần cứng nhất quán – Hardware-coherent

- Kiến trúc NVIDIA Blackwell với GB200 NVL72: Định nghĩa lại điện toán AI cấp độ Exascale