Kỷ nguyên của AI PC đã đến và nó được hỗ trợ bởi những công nghệ NVIDIA RTX và GeForce RTX. Cùng với đó là một cách mới để đánh giá hiệu suất cho các tác vụ được tăng tốc bởi AI và một ngôn ngữ mới có thể gây khó khăn để giải mã khi lựa chọn giữa máy tính để bàn và máy tính xách tay hiện có.

Trong khi các game thủ PC hiểu về FPS và các thông số thống kê tương tự, thì việc đo lường hiệu suất AI lại yêu cầu các số liệu mới.

TOPS là gì?

TOPS (Trillions of Operations Per Second) tức là hàng nghìn tỷ phép toán mỗi giây. Nghìn tỷ là từ quan trọng ở đây – số lượng hoạt động xử lý đằng sau các tác vụ AI tạo sinh (Generative AI) là cực kỳ lớn. Hãy coi TOPS như một thước đo hiệu suất thô, tương tự như xếp hạng mã lực (horsepower) của động cơ. Càng nhiều càng tốt.

Ví dụ: So sánh dòng Copilot+ PC được Microsoft công bố gần đây, bao gồm các bộ xử lý thần kinh (NPU) có thể thực hiện lên tới 40 TOPS. Thực hiện 40 TOPS là đủ cho một số tác vụ nhẹ được AI hỗ trợ, chẳng hạn như việc hỏi các chatbot local về các mẫu ghi chú của ngày hôm qua nằm ở đâu.

Nhưng sẽ có nhiều tác vụ GenAI đòi hỏi nhiều hơn thế. NVIDIA RTX và GeForce RTX GPU mang lại hiệu suất chưa từng có trên tất cả các tác vụ tạo sinh – GPU GeForce RTX 4090 cung cấp hơn 1.300 TOPS. Đây là một loại ‘mã lực’ cần thiết để xử lý việc tạo nội dung số được AI hỗ trợ, độ phân giải AI siêu cao trong trò chơi trên PC, tạo hình ảnh từ văn bản hoặc video, truy vấn các mô hình ngôn ngữ lớn (LLM) cục bộ,…

Token là gì?

TOPS chỉ là khởi đầu của câu chuyện. Hiệu suất LLM được đo bằng số lượng token được tạo ra bởi mô hình.

Token là đầu ra của LLM. Một token có thể là một từ trong câu hoặc thậm chí là một phần nhỏ hơn như dấu câu hoặc khoảng trắng. Hiệu suất cho các tác vụ được AI tăng tốc có thể được đo bằng số lượng token trên mỗi giây (tokens per second).

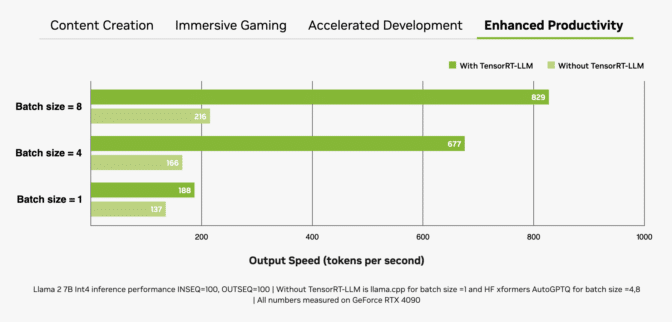

Một yếu tố quan trọng khác là batch size hay số lượng đầu vào được xử lý đồng thời trong một lượt suy luận. Vì LLM sẽ là cốt lõi của nhiều hệ thống AI hiện đại nên khả năng xử lý nhiều đầu vào (từ một ứng dụng đơn hoặc trên nhiều ứng dụng) sẽ là điểm khác biệt chính. Mặc dù batch size lớn hơn cải thiện hiệu suất cho các đầu vào đồng thời nhưng chúng cũng yêu cầu nhiều bộ nhớ hơn, đặc biệt khi kết hợp với các mô hình lớn hơn.

RTX GPU đặc biệt phù hợp với các LLM nhờ có lượng lớn bộ nhớ truy cập ngẫu nhiên video chuyên dụng (VRAM), Tensor Cores và phần mềm TensorRT-LLM.

GeForce RTX GPU cung cấp VRAM tốc độ cao lên tới 24GB và NVIDIA RTX GPU lên tới 48GB – có thể xử lý các mô hình lớn hơn và cho phép batch size cao hơn. RTX GPU cũng tận dụng Tensor Cores – những ‘bộ tăng tốc’ AI chuyên dụng giúp tăng tốc đáng kể các hoạt động tính toán chuyên sâu cần thiết cho các mô hình GenAI và Deep Learning. Hiệu suất tối đa này có thể dễ dàng đạt được khi một ứng dụng sử dụng bộ phát triển phần mềm (SDK) NVIDIA TensorRT, bộ công cụ này sẽ mang đến GenAI hiệu suất cao nhất trên hơn 100 triệu Windows PC và workstation được hỗ trợ bởi RTX GPU.

Sự kết hợp giữa bộ nhớ, bộ tăng tốc AI chuyên dụng và phần mềm được tối ưu hóa mang lại cho RTX GPU mức tăng thông lượng lớn, đặc biệt là khi batch size tăng lên.

Text-to-Image nhanh hơn bao giờ hết

Đo lường tốc độ tạo hình ảnh là một cách khác để đánh giá hiệu suất. Một trong những cách đơn giản nhất là sử dụng Stable Diffusion, một mô hình AI dựa trên hình ảnh phổ biến – cho phép người dùng dễ dàng chuyển đổi mô tả văn bản thành các đại diện trực quan phức tạp.

Với Stable Diffusion, người dùng có thể nhanh chóng tạo và tinh chỉnh hình ảnh từ lời nhắc văn bản (text prompt) để đạt được kết quả mong muốn. Khi sử dụng một RTX GPU, những kết quả này có thể được tạo ra nhanh hơn so với việc xử lý mô hình AI trên CPU hoặc NPU.

Hiệu suất đó thậm chí còn cao hơn khi sử dụng tiện ích mở rộng TensorRT cho giao diện Automatic1111 phổ biến. Người dùng RTX có thể tạo hình ảnh từ prompt nhanh hơn gấp 2 lần với SDXL Base checkpoint – chuẩn hoá đáng kể quy trình của Stable Diffusion.

ComfyUI, một giao diện người dùng Stable Diffusion phổ biến khác, đã bổ sung khả năng tăng tốc TensorRT vào tuần trước. Người dùng RTX giờ đây có thể tạo hình ảnh từ prompt nhanh hơn tới 60% và thậm chí có thể chuyển đổi những hình ảnh này thành video bằng cách sử dụng Stable Video Diffuson nhanh hơn tới 70% với TensorRT.

Khả năng tăng tốc TensorRT có thể được thử nghiệm trong điểm chuẩn UL Procyon AI Image Generation mới, mang lại tốc độ tăng 50% trên GPU GeForce RTX 4080 SUPER so với cách triển khai không có TensorRT nhanh nhất.

Tính năng tăng tốc TensorRT sẽ sớm được phát hành cho Stable Diffusion 3 – mô hình chuyển văn bản thành hình ảnh mới, rất được mong đợi của Stability AI – tăng hiệu suất lên 50%. Ngoài ra, TensorRT-Model Optimizer mới cho phép tăng tốc hiệu suất hơn nữa. Việc này giúp tăng tốc 70% so với triển khai non-TensorRT, đồng thời giảm 50% mức tiêu thụ bộ nhớ.

Tất nhiên, nhìn thấy mới tin tưởng – thử nghiệm thực sự nằm trong trường hợp sử dụng trong thế giới thực của việc lặp đi lặp lại prompt ban đầu. Người dùng có thể tinh chỉnh việc tạo hình ảnh bằng cách điều chỉnh prompt nhanh hơn đáng kể trên GPU RTX, mất vài giây mỗi lần lặp lại so với vài phút trên Macbook Pro M3 Max. Ngoài ra, người dùng còn có được cả tốc độ và khả năng bảo mật với mọi thứ vẫn riêng tư khi chạy cục bộ trên PC hoặc workstation hỗ trợ RTX.

The Results Are in and Open Sourced

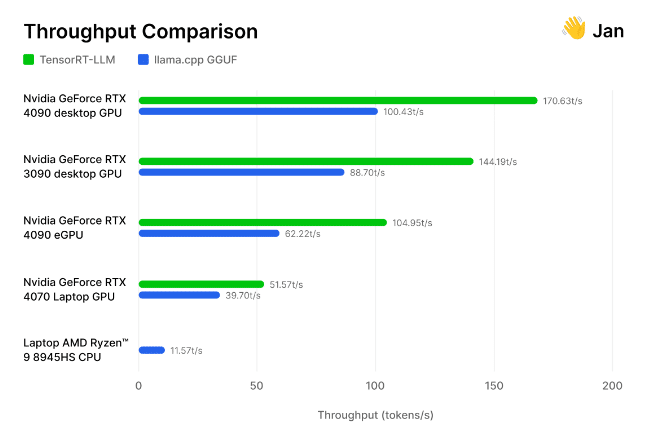

Nhưng đừng chỉ tin lời chúng tôi. Nhóm các nhà nghiên cứu và kỹ sư AI đằng sau Jan.ai mã nguồn mở gần đây đã tích hợp TensorRT-LLM vào ứng dụng chatbot cục bộ của mình, sau đó tự họ thử nghiệm những tối ưu hóa này.

Các nhà nghiên cứu đã thử nghiệm việc triển khai TensorRT-LLM dựa trên engine suy luận llama.cpp mã nguồn mở trên nhiều loại GPU và CPU được cộng đồng sử dụng. Họ nhận thấy rằng TensorRT “nhanh hơn 30-70% so với llama.cpp trên cùng một phần cứng” cũng như hiệu quả hơn trong các lần xử lý liên tiếp. Nhóm cũng đưa vào phương pháp của mình, mời một số nhóm khác đo lường hiệu suất GenAI cho chính họ.

Từ trò chơi cho đến AI tạo sinh, tốc độ sẽ chiến thắng. TOPS, images per second, tokens per second và batch size đều là những yếu tố cần cân nhắc khi xác định nhà vô địch về hiệu suất.

Bài viết liên quan

- NVIDIA NIM: Biến ý tưởng ứng dụng AI thành hiện thực trong tầm tay

- Từ “Sáng tạo” Đến “Hành động”: Khám phá sự khác biệt giữa Generative AI và Agentic AI

- NVIDIA DGX Spark: Giải phóng sức mạnh AI, ngay trên bàn làm việc!

- Tìm hiểu các công nghệ mạng của NVIDIA: Nền tảng cho HPC và AI

- 5 điều bạn cần biết về NVIDIA DGX Spark – Chiếc máy tính mơ ước của các nhà phát triển AI

- NVIDIA NVLink Thế hệ thứ 5: Bước nhảy vọt về băng thông cho kỷ nguyên AI nghìn tỷ tham số