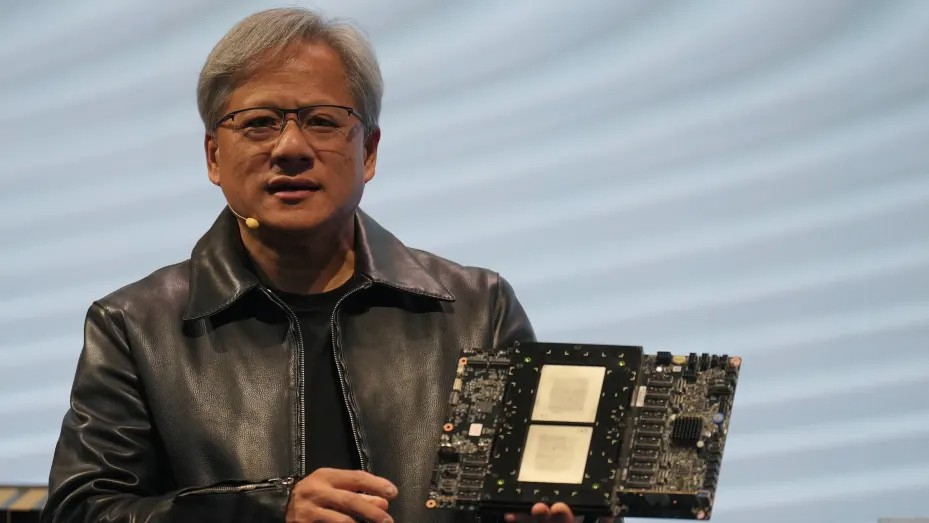

NVIDIA hôm thứ Hai vừa qua đã tiết lộ H200, một bộ xử lý đồ họa (GPU) được thiết kế để đào tạo và triển khai các loại mô hình Trí tuệ Nhân tạo đang thúc đẩy làn sóng bùng nổ AI.

Mẫu GPU mới là bản nâng cấp từ H100, con chip mà OpenAI đã sử dụng để đào tạo mô hình ngôn ngữ lớn tiên tiến nhất của hãng, GPT-4. Các công ty lớn, các công ty khởi nghiệp và các cơ quan chính phủ đều đang cạnh tranh để có được nguồn cung chip đang rất hạn chế này.

Theo ước tính của Raymond James, chip H100 có giá từ 25.000 đến 40.000 USD và cần đến hàng nghìn con chip này hoạt động cùng nhau để tạo ra những mô hình lớn nhất trong một quy trình gọi là “đào tạo” (training).

Sự hào hứng đối với GPU AI của NVIDIA đã khiến cổ phiếu của công ty tăng vọt, tăng hơn 230% tính đến thời điểm hiện tại trong năm 2023. NVIDIA kỳ vọng doanh thu khoảng 16 tỷ USD trong quý tài chính thứ ba, tăng 170% so với một năm trước.

Cải tiến quan trọng của H200 là nó bao gồm 141GB bộ nhớ HBM3 thế hệ mới sẽ giúp con chip thực hiện “suy luận” (inference), tức là sử dụng một mô hình lớn sau khi được đào tạo để tạo ra văn bản, hình ảnh hoặc cho ra các dự báo.

NVIDIA cho biết H200 sẽ tạo ra kết quả nhanh gần gấp đôi so với H100. Điều đó dựa trên một thử nghiệm sử dụng mô hình Llama 2 LLM của Meta.

H200 dự kiến xuất xưởng vào quý 2 năm 2024 và sẽ cạnh tranh với GPU MI300X của AMD. Con chip của AMD tương tự như H200 có bộ nhớ bổ sung so với các phiên bản trước đó, giúp nó thích hợp với các mô hình lớn trên phần cứng để chạy các hoạt động suy luận.

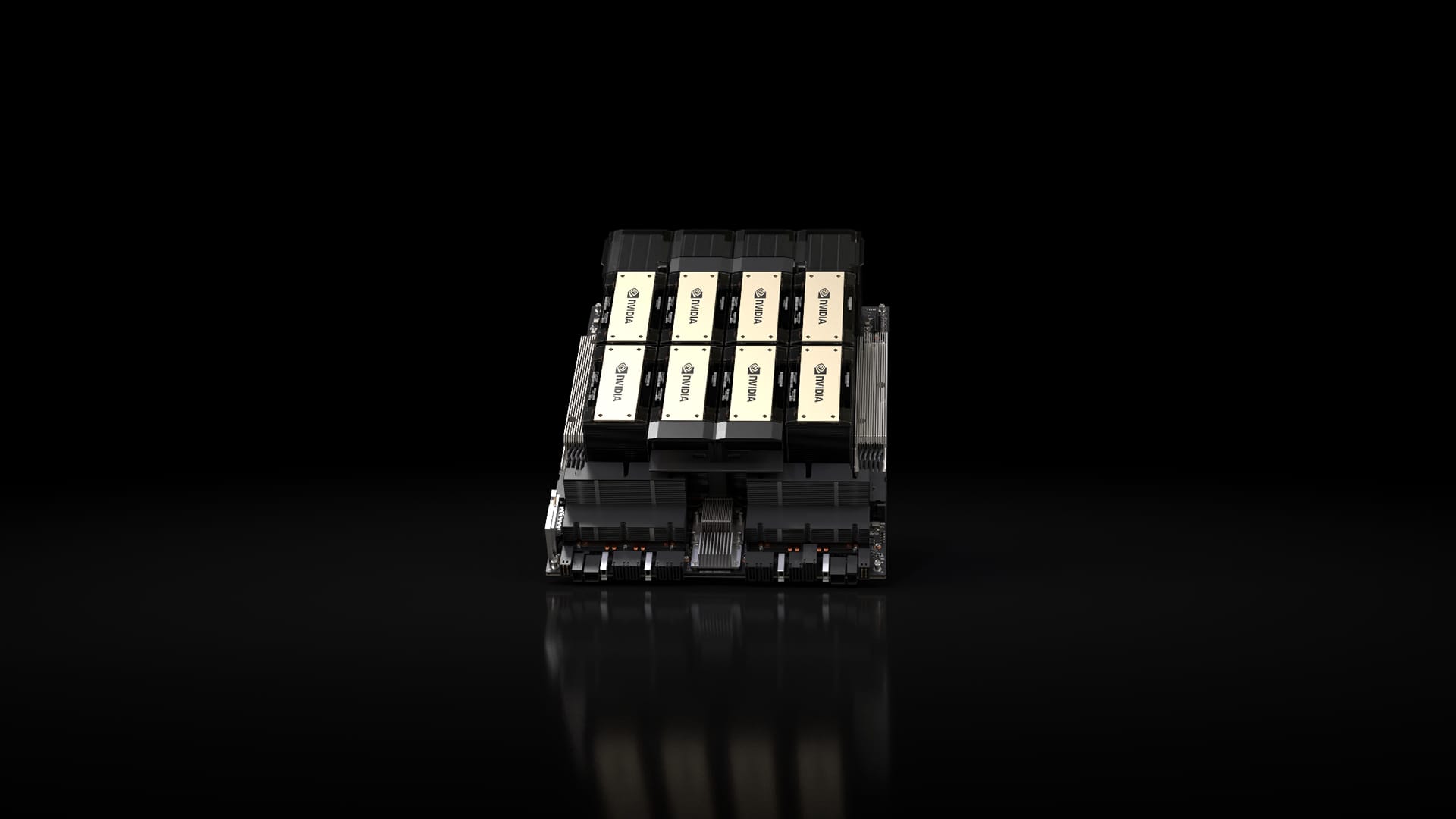

Chip NVIDIA H200 trong hệ thống NVIDIA HGX 8x GPU.

NVIDIA cho biết H200 sẽ tương thích với H100, nghĩa là các công ty AI đang đào tạo với model trước đó sẽ không cần thay đổi hệ thống máy chủ hoặc phần mềm của họ để sử dụng phiên bản mới.

NVIDIA cho biết nó sẽ được cung cấp ở cấu hình máy chủ 4x GPU hoặc 8x GPU trên các hệ thống HGX hoàn chỉnh của hãng, cũng như nằm trong một con siêu chip có tên GH200, kết hợp giữa GPU H200 với một bộ xử lý dựa trên Arm .

Tuy nhiên, H200 có thể sẽ không giữ được ngôi vương chip AI NVIDIA nhanh nhất trong thời gian dài.

Trong khi các công ty như NVIDIA cung cấp nhiều cấu hình chip khác nhau, ngành bán dẫn thường sẽ có một bước tiến lớn cứ sau mỗi hai năm, khi các nhà sản xuất chuyển sang một kiến trúc khác giúp mang lại hiệu suất tăng đáng kể hơn so với việc thêm bộ nhớ hoặc các tối ưu hóa nhỏ hơn khác. Cả H100 và H200 đều dựa trên kiến trúc Hopper của NVIDIA.

Vào tháng 10, NVIDIA đã thông báo với các nhà đầu tư rằng họ sẽ chuyển từ mô hình kiến trúc 2-năm sang mô hình phát hành 1-năm do nhu cầu cao về GPU. Công ty đã trình chiếu một slide gợi ý rằng họ sẽ công bố và phát hành chip B100, dựa trên kiến trúc Blackwell sắp ra mắt vào năm 2024.

Nguồn CNBC

Bài viết liên quan

- 5 điều bạn cần biết về NVIDIA DGX Spark – Chiếc máy tính mơ ước của các nhà phát triển AI

- NVIDIA NVLink Thế hệ thứ 5: Bước nhảy vọt về băng thông cho kỷ nguyên AI nghìn tỷ tham số

- So sánh sự khác biệt giữa NVIDIA H200 NVL và NVIDIA H200 HGX

- Mở rộng quy mô cho hạ tầng GenAI on-premise

- CPU NVIDIA Grace C1 được hỗ trợ rộng rãi cho điện toán biên, ngành viễn thông và các hệ thống lưu trữ

- Khi AI và Đồ họa hội tụ: GPU NVIDIA Blackwell PRO tăng tốc cho các ứng dụng AI thế hệ mới