Bước nhảy vọt về quy mô trong điện toán tăng tốc

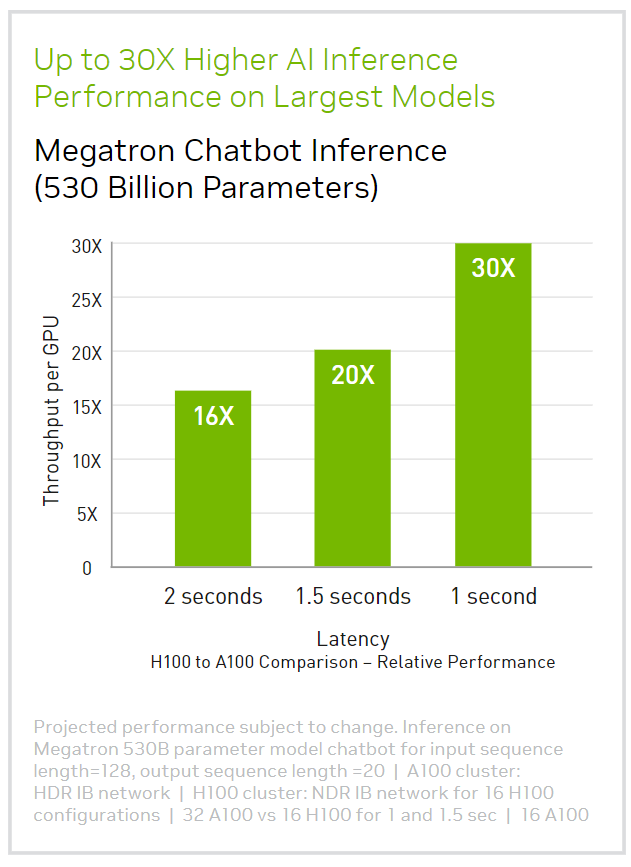

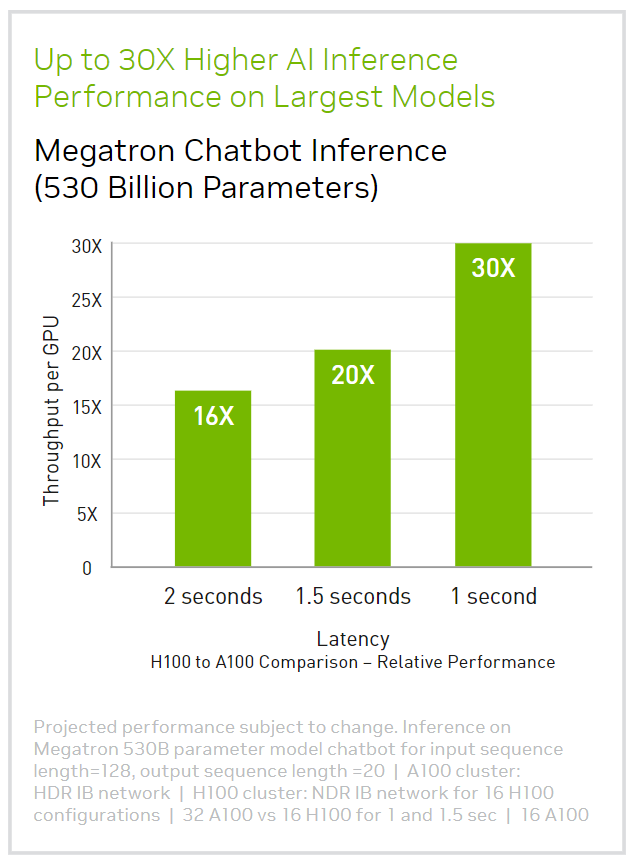

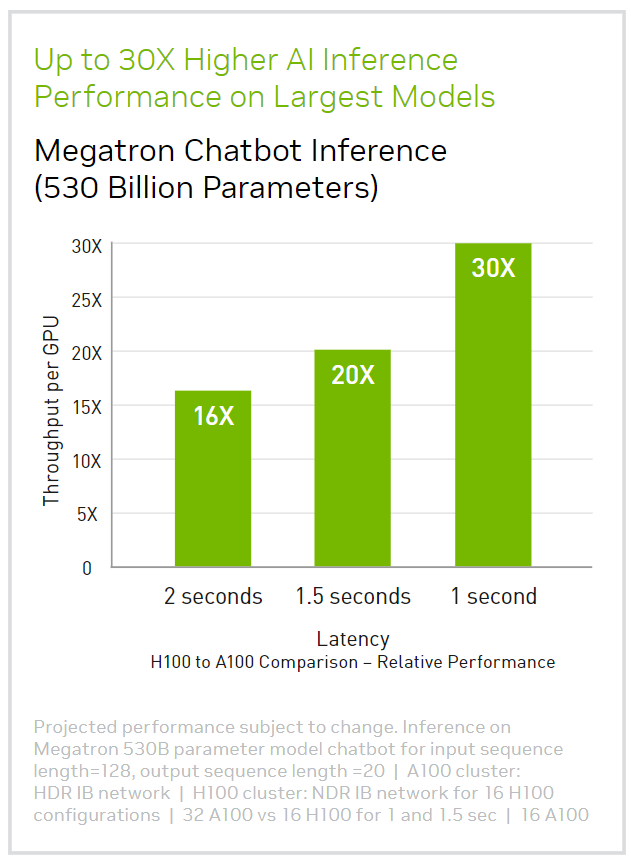

GPU NVIDIA H100 Tensor Core mang lại hiệu suất, khả năng mở rộng và bảo mật chưa từng có cho mọi workload. Với công nghệ switch NVIDIA NVLink, có thể kết nối tối đa đến 256 GPU H100 để tăng tốc tải công việc ở quy mô lớn, trong khi Transformer Engine chuyên dụng hỗ trợ các mô hình ngôn ngữ cấp ‘nghìn tỷ’ tham số. H100 sử dụng những cải tiến đột phá trong kiến trúc NVIDIA Hopper để cung cấp AI đàm thoại hàng đầu trong ngành, tăng tốc các mô hình ngôn ngữ lớn lên 30 lần so với thế hệ trước.

Sẵn sàng cho AI doanh nghiệp?

GPU NVIDIA H100 Tensor Core cho các máy chủ phổ thông đi kèm với gói đăng ký phần mềm 5 năm, bao gồm hỗ trợ cấp doanh nghiệp, cho bộ phần mềm NVIDIA AI Enterprise, giúp đơn giản hóa việc áp dụng AI với hiệu suất cao nhất. Điều này đảm bảo các tổ chức có quyền truy cập vào các framework và công cụ AI mà họ cần để xây dựng quy trình làm việc AI được tăng tốc bởi H100, chẳng hạn như AI chatbots, công cụ đề xuất, Vision AI,… Truy cập trang đăng ký sử dụng phần mềm NVIDIA AI Enterprise và các lợi ích hỗ trợ liên quan cho NVIDIA H100 tại đây.

Tăng tốc an toàn tải công việc từ quy mô doanh nghiệp sang exascale

GPU NVIDIA H100 có Lõi Tensor thế hệ thứ tư và Transformer Engine với độ chính xác FP8, mở rộng hơn nữa khả năng dẫn đầu về AI trên thị trường của NVIDIA với khả năng đào tạo nhanh hơn tới 9X và tốc độ suy luận gấp 30 lần trên các mô hình ngôn ngữ lớn (LLM). Đối với các ứng dụng điện toán hiệu suất cao (HPC), H100 tăng gấp ba lần floating-point operations per second (FLOPS) của FP64 và bổ sung các lệnh lập trình động (DPX) để mang lại hiệu suất cao hơn gấp 7 lần. Với Multi-Instance GPU (MIG) thế hệ thứ hai, tính năng NVIDIA confidential-computing tích hợp và NVIDIA NVLink switch, H100 tăng tốc an toàn tất cả workload cho mọi trung tâm dữ liệu, từ doanh nghiệp đến cấp exascale.

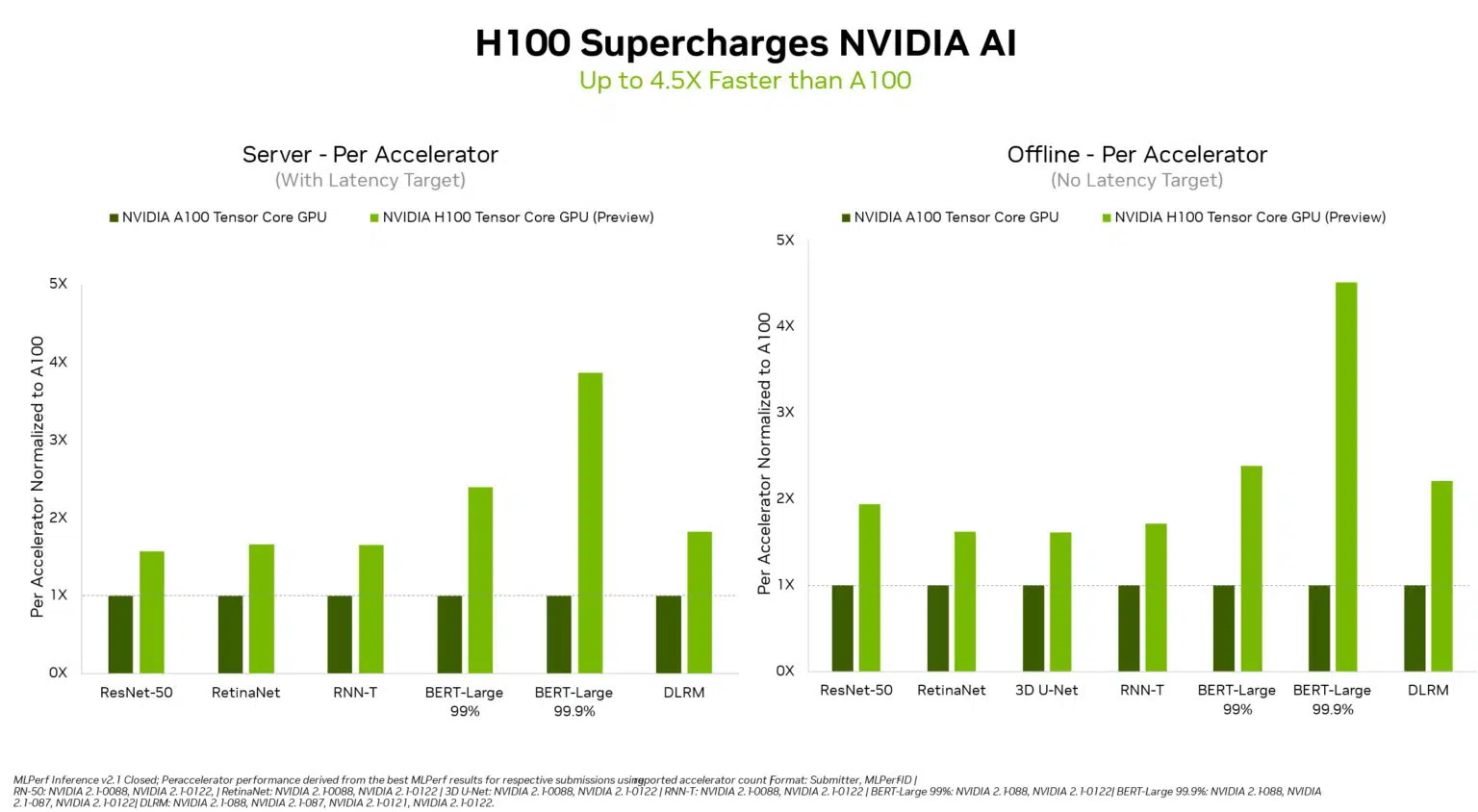

So sánh hiệu năng của GPU NVIDIA H100 với NVIDIA A100 Tensor Core:

Những đột phá công nghệ của NVIDIA Hopper

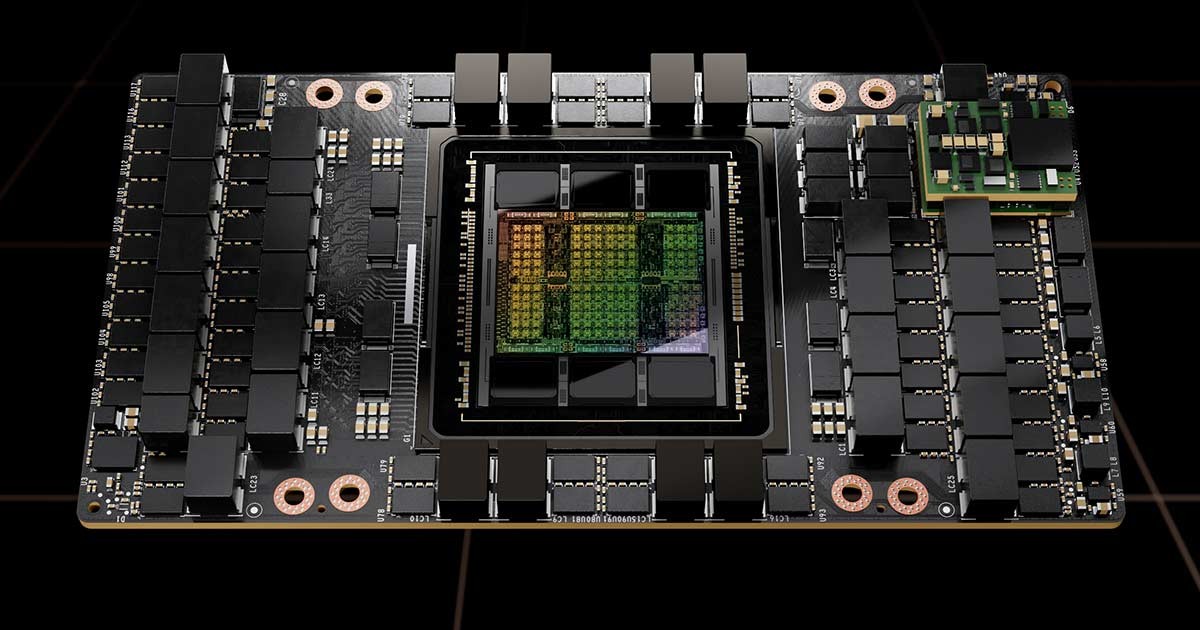

GPU NVIDIA H100 Tensor Core

Được xây dựng với 80 tỷ transistor sử dụng quy trình TSMC 4N tiên tiến tùy chỉnh phù hợp với nhu cầu xử lý tăng tốc của NVIDIA, H100 là chip tiên tiến nhất thế giới từng được chế tạo. Nó sỡ hữu những tiến bộ lớn để tăng tốc AI, HPC, băng thông bộ nhớ, kết nối và giao tiếp ở quy mô trung tâm dữ liệu.

Transformer Engine

Transformer Engine sử dụng phần mềm và công nghệ Hopper Tensor Core được thiết kế để tăng tốc đào tạo cho các mô hình được xây dựng từ các mảnh ghép mô hình AI quan trọng nhất thế giới, Transformer Engine. Hopper Tensor Core có thể áp dụng hỗn hợp độ chính xác FP8 và FP16 để tăng tốc đáng kể các xử lý AI cho Transformer Engine.

Hệ thống chuyển mạch NVLink Switch

NVIDIA NVLink Switch cho phép mở rộng input/output đa (IO) GPU trên nhiều máy chủ với tốc độ 900 gigabyte mỗi giây (GB/s) hai chiều trên mỗi GPU, gấp 7 lần băng thông của PCIe Gen5. Hệ thống hỗ trợ các cụm mát chủ lên đến 256 GPU H100 và cung cấp băng thông cao hơn 9X so với InfiniBand HDR trên kiến trúc NVIDIA Ampere.

NVIDIA Confidential Computing

NVIDIA Confidential Computing là một tính năng bảo mật được tích hợp sẵn của Hopper giúp NVIDIA H100 trở thành bộ tăng tốc đầu tiên trên thế giới có khả năng ứng dụng cho điện toán an toàn (Confidential Computing). Người dùng có thể bảo vệ tính bí mật và toàn vẹn của dữ liệu và ứng dụng của họ đang được sử dụng trong khi vẫn nhận được khả năng tăng tốc vượt trội của GPU H100.

Multi-Instance GPU (MIG) thế hệ thứ hai

MIG thế hệ thứ hai của kiến trúc Hopper hỗ trợ cấu hình đa người thuê, nhiều người dùng trong môi trường ảo hóa, phân vùng GPU một cách an toàn thành các instance riêng biệt, đúng kích thước để tối đa hóa chất lượng dịch vụ (QoS) cho các người thuê (tenants), được bảo mật hơn gấp 7 lần.

DPX Instructions

Các tập lệnh DPX của Hopper tăng tốc các thuật toán lập trình động lên gấp 40 lần so với CPU và 7 lần so với GPU kiến trúc NVIDIA Ampere. Khả năng này giúp đẩy nhanh thời gian chẩn đoán bệnh, tối ưu hóa real-time routing và phân tích đồ thị cũng nhanh hơn đáng kể.

Sự hội tụ của GPU và SmartNIC

NVIDIA H100 CNX kết hợp sức mạnh của NVIDIA H100 với khả năng kết nối mạng tiên tiến của card giao tiếp mạng thông minh NVIDIA ConnectX®-7 (SmartNIC) trong một nền tảng duy nhất. Sự hội tụ này mang lại hiệu suất cực cao cho các khối lượng công việc chuyên sâu về IO được hỗ trợ bởi GPU, chẳng hạn như đào tạo AI phân tán trong trung tâm dữ liệu doanh nghiệp và xử lý 5G ở biên. Tìm hiểu thêm về NVIDIA H100 CNX.

Tăng tốc mọi workload, ở mọi nơi

NVIDIA H100 là một phần không thể thiếu của nền tảng trung tâm dữ liệu NVIDIA. Được xây dựng cho AI, HPC và phân tích dữ liệu, nền tảng này tăng tốc hơn 3.000 ứng dụng và khả dụng ở mọi nơi từ trung tâm dữ liệu đến vùng biên, mang lại hiệu suất vượt trội và cả cơ hội tiết kiệm chi phí.

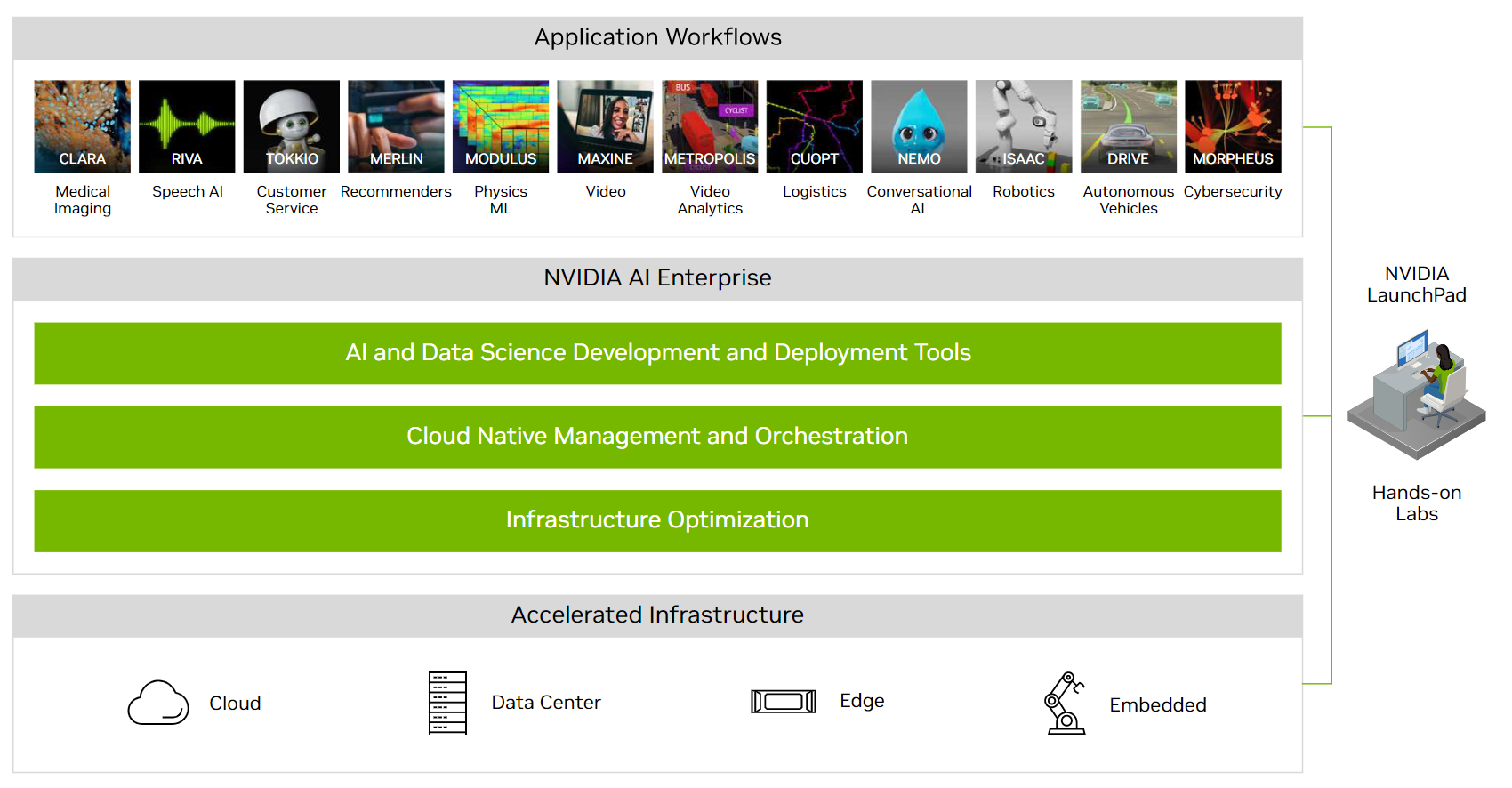

Triển khai H100 với nền tảng NVIDIA AI

NVIDIA AI là nền tảng mở end-to-end dành cho AI môi trường production được xây dựng trên GPU NVIDIA H100. Nó bao gồm cơ sở hạ tầng điện toán tăng tốc NVIDIA, một software stack nhằm tối ưu hóa cơ sở hạ tầng, phát triển và triển khai AI, và quy trình làm việc ứng dụng để tăng tốc thời gian đưa ra thị trường. Trải nghiệm NVIDIA AI và NVIDIA H100 trên NVIDIA LaunchPad thông qua các lab thực hành miễn phí.

Bài viết liên quan

- 5 điều bạn cần biết về NVIDIA DGX Spark – Chiếc máy tính mơ ước của các nhà phát triển AI

- NVIDIA NVLink Thế hệ thứ 5: Bước nhảy vọt về băng thông cho kỷ nguyên AI nghìn tỷ tham số

- So sánh sự khác biệt giữa NVIDIA H200 NVL và NVIDIA H200 HGX

- Mở rộng quy mô cho hạ tầng GenAI on-premise

- CPU NVIDIA Grace C1 được hỗ trợ rộng rãi cho điện toán biên, ngành viễn thông và các hệ thống lưu trữ

- Khi AI và Đồ họa hội tụ: GPU NVIDIA Blackwell PRO tăng tốc cho các ứng dụng AI thế hệ mới