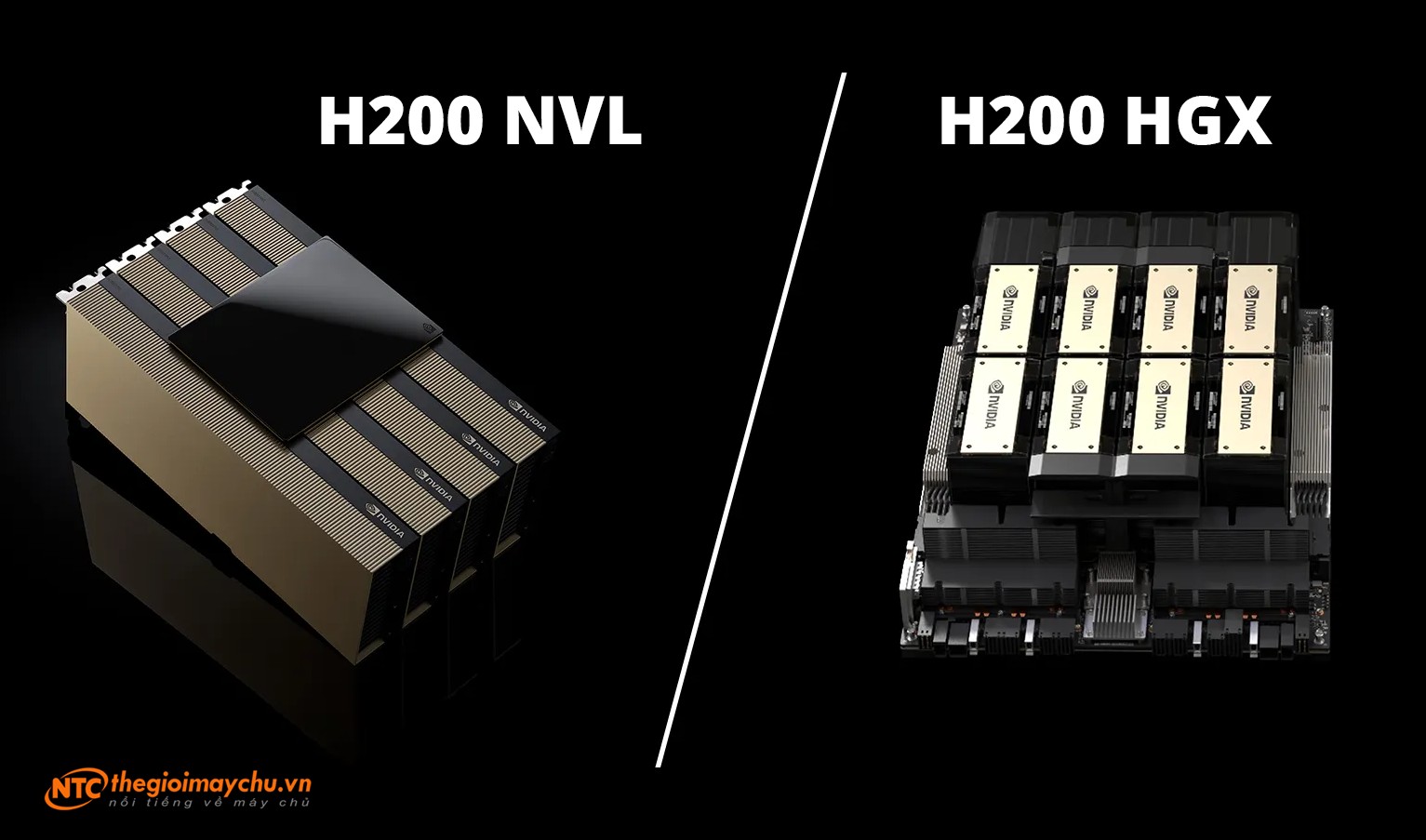

NVIDIA HGX™ H200 mang lại hiệu suất tối đa cho môi trường AI và HPC, trong khi H200 NVL cung cấp giải pháp làm mát bằng không khí, tiêu thụ điện năng thấp hơn với 1, 2, 4 hoặc 8 GPU PCIe được kết nối bằng NVIDIA® NVLink®, mang lại tính linh hoạt cho các trung tâm dữ liệu doanh nghiệp với cấu hình rack hiện hữu.

Sự khác biệt giữa NVIDIA HGX H200 và H200 NVL là gì?

Kiến trúc Hopper của NVIDIA đã định nghĩa lại AI và điện toán hiệu năng cao (HPC), với các dòng GPU như NVIDIA HGX H200 và NVIDIA H200 NVL mới đáp ứng các nhu cầu khác nhau trong các lĩnh vực doanh nghiệp và nghiên cứu. Trong khi HGX H200 cung cấp nền tảng hiệu suất cao cho cả môi trường làm mát bằng chất lỏng và không khí, H200 NVL mang đến một tùy chọn tiết kiệm chi phí, công suất thấp hơn và được thiết kế cho các tủ rack doanh nghiệp được làm mát bằng không khí.

Tổng quan về NVIDIA H200 NVL

NVIDIA H200 NVL

NVIDIA H200 NVL

NVIDIA H200 NVL là một giải pháp PCIe cung cấp một cách tiếp cận khác, phục vụ cho các trung tâm dữ liệu có thiết kế rack làm mát bằng không khí, công suất thấp hơn. Với các tính năng:

- GPU PCIe được kết nối thông qua NVIDIA NVLink để giao tiếp GPU-to-GPU nhanh hơn, cung cấp băng thông liên GPU nhanh hơn 7 lần so với PCIe Gen5.

- Được tối ưu hóa cho các tủ rack dưới 20kW, một cấu hình phổ biến trong môi trường doanh nghiệp.

- Hiệu suất suy luận nhanh hơn 1,7 lần và hiệu suất HPC tốt hơn 1,3 lần so với thế hệ H100 NVL trước đó.

- Cấu hình linh hoạt, cho phép triển khai với 1, 2, 4 hoặc 8 GPU, cung cấp cho doanh nghiệp khả năng mở rộng dựa trên nhu cầu của khối lượng công việc.

- Hiệu quả năng lượng, với tùy chọn chạy GPU ở mức điện năng thấp (thấp tới 400W), duy trì hiệu suất trong khi giảm chi phí điện năng.

Tổng quan về NVIDIA HGX H200

NVIDIA HGX H200

NVIDIA HGX H200

NVIDIA HGX H200 được khẳng định là giải pháp hàng đầu cho môi trường AI và HPC hiệu suất cao. Nó được xây dựng có mục đích cho các doanh nghiệp và tổ chức yêu cầu cấp độ điện toán tiên tiến và khả năng mở rộng trong tương lai.

Các tính năng chính bao gồm:

- Bộ nhớ HBM3e 141 GB và băng thông 4,8 TB/giây cho phép xử lý dữ liệu nhanh chóng.

- Hiệu suất FP8 lên đến 4 petaFLOPS, đảm bảo xử lý mượt mà các mô hình ngôn ngữ lớn và mô phỏng HPC.

- Tùy chọn khả năng mở rộng cho cấu hình làm mát bằng chất lỏng và không khí, hỗ trợ thiết lập 4 hoặc 8 GPU trong các hệ thống được chứng nhận NVIDIA HGX như Supermicro HGX H200 4-GPU SYS-221GE-TNHT-LCC hay Supermicro HGX H200 8-GPU SYS-421GE-TNHR2-LCC.

HGX H200 hiện là giải pháp phù hợp cho nhiều khối lượng công việc đòi hỏi cao như đào tạo mô hình AI tạo sinh, mô phỏng khoa học và suy luận quy mô lớn tại chỗ.

So sánh NVIDIA HGX H200 và H200 NVL

Các tính năng chính

| NVIDIA HGX H200 | NVIDIA H200 NVL | |

|---|---|---|

| Memory | 141 GB HBM3e | 141 GB HBM3e |

| GPU Configuration | 8 GPUs (SXM-based) | 1-8 GPUs (PCIe-based) |

| Cooling | Liquid or air cooling | Air cooling |

| Performance | Maximum scalability and power | Energy-efficient flexibility |

| Connectivity | NVLink (900 GB/s) | NVLink PCIe bridge (900 GB/s) |

| Form Factor | NVIDIA HGX-certified servers | Standard enterprise racks |

| Power Range | Fixed | Configurable (400W-600W) |

Thông số kỹ thuật

| Feature | H200 SXM | H200 NVL |

|---|---|---|

| FP64 | 34 TFLOPS | 30 TFLOPS |

| FP64 Tensor Core | 67 TFLOPS | 60 TFLOPS |

| FP32 | 67 TFLOPS | 60 TFLOPS |

| TF32 Tensor Core² | 989 TFLOPS | 835 TFLOPS |

| BFLOAT16 Tensor Core² | 1,979 TFLOPS | 1,671 TFLOPS |

| FP16 Tensor Core² | 1,979 TFLOPS | 1,671 TFLOPS |

| FP8 Tensor Core² | 3,958 TFLOPS | 3,341 TFLOPS |

| INT8 Tensor Core² | 3,958 TFLOPS | 3,341 TFLOPS |

| GPU Memory | 141 GB | 141 GB |

| GPU Memory Bandwidth | 4.8 TB/s | 4.8 TB/s |

| Decoders | 7 NVDEC / 7 JPEG | 7 NVDEC / 7 JPEG |

| Confidential Computing | Supported | Supported |

| Max Thermal Design Power (TDP) | Up to 700W (configurable) | Up to 600W (configurable) |

| Multi-Instance GPUs (MIG) | Up to 7 MIGs @ 18 GB each | Up to 7 MIGs @ 16.5 GB each |

| Form Factor | SXM | PCIe (Dual-slot air-cooled) |

| Interconnect | NVIDIA NVLink™: 900 GB/sPCIe Gen5: 128 GB/s | 2- or 4-way NVIDIA NVLink bridge:900 GB/s per GPUPCIe Gen5: 128 GB/s |

| Server Options | NVIDIA HGX™ H200 systems with 4 or 8 GPUs | NVIDIA MGX™ H200 NVL systems with up to 8 GPUs |

| NVIDIA AI Enterprise | Add-on | Included |

Chọn GPU phù hợp với nhu cầu của bạn

Khi quyết định giữa HGX H200 và H200 NVL, hãy cân nhắc các yêu cầu của trung tâm dữ liệu mà bạn đang thiết triển khai:

- Hãy chọn HGX H200 nếu khối lượng công việc của bạn đòi hỏi hiệu suất, khả năng mở rộng và tính linh hoạt cao nhất cho môi trường làm mát bằng chất lỏng hoặc không khí.

- Hãy chọn H200 NVL nếu tổ chức doanh nghiệp của bạn ưu tiên mức tiêu thụ điện năng thấp, làm mát bằng không khí và có cấu hình rack linh hoạt.

NTC đơn giản hóa việc triển khai GPU của bạn như thế nào

NTC chuyên tư vấn và triển khai các giải pháp AI và HPC sử dụng GPU hiệu suất cao của NVIDIA. Cho dù tích hợp HGX H200 cho nghiên cứu quy mô lớn hay triển khai H200 NVL cho các trung tâm dữ liệu doanh nghiệp, NTC cung cấp:

- Cấu hình máy chủ tùy biến theo yêu cầu workload của bạn.

- Dịch vụ triển khai và hỗ trợ nhằm đảm bảo hiệu suất tối ưu ngay từ ngày đầu tiên.

- Giải pháp làm mát tiên tiến, bao gồm cấu hình làm mát bằng chất lỏng và không khí.

Với chuyên môn của NTC, khách hàng có thể tối đa hóa năng lực của GPU NVIDIA Hopper đồng thời tối ưu hóa hiệu quả sử dụng điện năng và chi phí.

Mở khóa hiệu suất AI và HPC với NVIDIA và NTC

Cả NVIDIA HGX H200 và H200 NVL đều cung cấp năng lực điện toán thuộc top đầu cho AI và HPC. HGX H200 được thiết kế để có hiệu suất cao nhất và tính linh hoạt trong làm mát, trong khi H200 NVL cung cấp tùy chọn linh hoạt cho các thiết lập doanh nghiệp làm mát bằng không khí.

NTC sẽ giúp hướng dẫn doanh nghiệp của bạn lựa chọn, triển khai và tối ưu hóa các giải pháp GPU NVIDIA.

💡 Hãy liên hệ với chúng tôi để tìm hiểu cách NTC có thể đẩy nhanh quy trình làm việc AI và HPC của bạn.

Bài viết liên quan

- Mở rộng quy mô cho hạ tầng GenAI on-premise

- CPU NVIDIA Grace C1 được hỗ trợ rộng rãi cho điện toán biên, ngành viễn thông và các hệ thống lưu trữ

- Khi AI và Đồ họa hội tụ: GPU NVIDIA Blackwell PRO tăng tốc cho các ứng dụng AI thế hệ mới

- NVIDIA tại Computex 2025: “Gã khổng lồ xanh” đặt cược tất cả vào AI, GeForce liệu có bị ra rìa?

- AI Blueprint: Nền tảng phân tích video cho các ứng dụng tìm kiếm và tóm tắt video