Dù có những lợi ích của nó, Generative AI (AI tạo sinh) đặt ra nhiều thách thức bảo mật – và có thể gây tốn kém – cho các công ty. Cùng xem xét các mối đe dọa có thể xảy ra và các kinh nghiệm hay nhất để giảm thiểu rủi ro.

Việc áp dụng nhanh chóng các mô hình AI tạo sinh sau sự ra mắt của ChatGPT hứa hẹn sẽ thay đổi hoàn toàn cách các doanh nghiệp kinh doanh và tương tác với khách hàng và nhà cung cấp.

AI tạo sinh có thể hỗ trợ cho nhiều nhu cầu kinh doanh, chẳng hạn như viết nội dung tiếp thị, cải thiện dịch vụ khách hàng, tạo mã nguồn cho các ứng dụng phần mềm và tạo báo cáo kinh doanh. Vô số lợi ích của các công cụ AI tạo sinh – đặc biệt là giảm chi phí, nâng cao tốc độ và chất lượng công việc – đã khuyến khích các doanh nghiệp cũng như cá nhân thử nghiệm khả năng của những công cụ đó trong công việc của họ.

Tuy nhiên, giống như bất kỳ công nghệ mới nào, việc triển khai nhanh chóng có thể tiềm ẩn nhiều rủi ro, mở ra cơ hội cho các tác nhân đe dọa khai thác lỗ hổng của doanh nghiệp. Trong bối cảnh của các mối nguy công nghệ ngày nay, việc sử dụng các công cụ AI tạo sinh mà không cân nhắc kỹ lưỡng có thể dẫn đến hậu quả lớn cho doanh nghiệp.

Rủi ro bảo mật liên quan đến việc sử dụng AI tạo sinh trong môi trường doanh nghiệp

Hiểu được những rủi ro tiềm ẩn của việc sử dụng AI tạo sinh trong bối cảnh doanh nghiệp là rất quan trọng để khai thác lợi ích từ công nghệ này trong khi vẫn duy trì tuân thủ quy định và tránh các vi phạm về dữ liệu. Hãy lưu ý những rủi ro sau khi lập kế hoạch triển khai AI tạo sinh.

1. Nhân viên tiết lộ thông tin công việc nhạy cảm

Trong môi trường doanh nghiệp, người dùng nên thận trọng với bất kỳ phần dữ liệu nào họ chia sẻ với người khác – bao gồm cả ChatGPT và các chatbot hỗ trợ AI khác.

Một sự cố đáng chú ý gần đây là vụ rò rỉ dữ liệu do nhân viên Samsung chia sẻ dữ liệu nhạy cảm với ChatGPT. Các kỹ sư tại Samsung đã tải mã nguồn bí mật lên mô hình ChatGPT, ngoài ra họ còn có thể sử dụng dịch vụ này để tạo ghi chú cuộc họp và tóm tắt báo cáo kinh doanh chứa các thông tin nhạy cảm liên quan đến công việc.

Trường hợp của Samsung chỉ là một ví dụ được công bố rộng rãi về việc rò rỉ thông tin nhạy cảm cho các chatbot được hỗ trợ bởi AI. Nhiều công ty và nhân viên khác sử dụng các công cụ AI tạo sinh có thể mắc lỗi tương tự khi tiết lộ thông tin công việc nhạy cảm, chẳng hạn như mã nguồn nội bộ, tài liệu có bản quyền, bí mật thương mại, thông tin nhận dạng cá nhân (PII) và thông tin kinh doanh bí mật.

Chính sách tiêu chuẩn của OpenAI dành cho ChatGPT là lưu giữ hồ sơ của người dùng trong 30 ngày để theo dõi những hành vi lạm dụng có thể xảy ra, ngay cả khi người dùng chọn tắt lịch sử trò chuyện. Đối với các công ty tích hợp ChatGPT vào quy trình kinh doanh của họ, điều này có nghĩa là tài khoản ChatGPT của nhân viên có thể chứa thông tin nhạy cảm. Do đó, kẻ tấn công xâm nhập thành công tài khoản ChatGPT của nhân viên có thể truy cập bất kỳ dữ liệu nhạy cảm nào có trong truy vấn của người dùng đó và các phản hồi của AI.

2. Lỗ hổng bảo mật trong công cụ AI

Giống như bất kỳ phần mềm nào khác, bản thân các công cụ AI tạo sinh có thể chứa các lỗ hổng khiến các công ty gặp phải các mối đe dọa mạng.

Ví dụ: vào tháng 3, OpenAI đã cho “offline” dịch vụ ChatGPT để sửa lỗi trong thư viện nguồn mở của chatbot đã cho phép một số người dùng xem tiêu đề trò chuyện từ lịch sử trò chuyện của người dùng đang hoạt động khác. Cũng có thể xem tin nhắn đầu tiên của cuộc trò chuyện mới tạo trong lịch sử trò chuyện của người khác nếu cả hai người dùng đều hoạt động cùng một lúc.

Ngoài ra, lỗi tương tự còn tiết lộ thông tin liên quan đến thanh toán của 1,2% người đăng ký ChatGPT Plus đã hoạt động trong một khoảng thời gian cụ thể, bao gồm họ và tên, địa chỉ email và bốn chữ số cuối của thẻ tín dụng. Trong một vụ việc khác gần đây, công ty tình báo mạng Group-IB đã phát hiện hơn 100.000 tài khoản ChatGPT bị xâm nhập được rao bán trên các thị trường mạng đen.

3. Ngộ độc và đánh cắp dữ liệu

Các công cụ AI tạo sinh phải được cung cấp lượng dữ liệu khổng lồ để hoạt động chính xác. Dữ liệu đào tạo này đến từ nhiều nguồn khác nhau, nhiều nguồn trong số đó được công khai trên internet – và trong một số trường hợp, có thể bao gồm các tương tác trước đây của doanh nghiệp với khách hàng.

Trong một cuộc tấn công xâm phạm dữ liệu, các tác nhân đe dọa có thể thao túng giai đoạn pre-train trong quá trình phát triển mô hình AI. Bằng cách đưa thông tin độc hại vào tập dữ liệu huấn luyện, đối thủ có thể ảnh hưởng đến hành vi dự đoán của mô hình về sau, dẫn đến phản hồi sai hoặc có hại.

Một rủi ro khác liên quan đến dữ liệu liên quan đến việc các tác nhân đe dọa đánh cắp tập dữ liệu được sử dụng để huấn luyện mô hình AI tạo sinh. Nếu không có đủ mã hóa và kiểm soát xung quanh việc truy cập dữ liệu, mọi thông tin nhạy cảm có trong dữ liệu huấn luyện của mô hình đều có thể hiển thị đối với những kẻ tấn công lấy được tập dữ liệu.

4. Vi phạm nghĩa vụ tuân thủ

Khi sử dụng chatbot hỗ trợ AI trong môi trường doanh nghiệp, nhà quản lý CNTT nên đánh giá các rủi ro sau liên quan đến việc vi phạm các quy định:

- Phản hồi không chính xác. Các công cụ được hỗ trợ bởi AI đôi khi đưa ra những câu trả lời sai hoặc hời hợt. Việc để khách hàng tiếp xúc với những thông tin sai lệch có thể làm phát sinh trách nhiệm pháp lý bên cạnh việc ảnh hưởng tiêu cực đến uy tín của doanh nghiệp.

- Rò rỉ dữ liệu. Nhân viên có thể chia sẻ thông tin công việc nhạy cảm, bao gồm PII của khách hàng hoặc thông tin sức khỏe được bảo vệ (PHI), trong các cuộc trò chuyện với chatbot AI. Ngược lại, điều này có thể vi phạm các tiêu chuẩn quy định như GDPR, PCI DSS và HIPAA, có nguy cơ bị phạt và hành động pháp lý.

- Tính thiên vị. Phản hồi của mô hình AI đôi khi thể hiện sự thiên vị dựa trên chủng tộc, giới tính hoặc các đặc điểm được bảo vệ khác, điều này có thể vi phạm luật chống phân biệt đối xử.

- Vi phạm luật sở hữu trí tuệ và bản quyền. Các công cụ hỗ trợ AI được đào tạo dựa trên lượng dữ liệu khổng lồ và thường không thể cung cấp chính xác các nguồn cụ thể cho phản hồi của chúng. Một số dữ liệu đào tạo đó có thể bao gồm các tài liệu có bản quyền , chẳng hạn như sách, tạp chí và tập san học thuật. Việc sử dụng đầu ra AI dựa trên các tác phẩm có bản quyền mà không có trích dẫn có thể khiến doanh nghiệp bị phạt theo pháp luật.

- Luật liên quan đến việc sử dụng chatbot. Nhiều doanh nghiệp đã bắt đầu tích hợp ChatGPT và các công cụ AI tạo sinh khác vào ứng dụng của họ, một số doanh nghiệp sử dụng chatbot được hỗ trợ bởi AI để trả lời ngay lập tức các câu hỏi của khách hàng. Nhưng làm như vậy mà không thông báo trước cho khách hàng sẽ có nguy cơ bị phạt theo các đạo luật như luật tiết lộ bot của California .

- Quyền riêng tư dữ liệu. Một số doanh nghiệp có thể muốn phát triển các mô hình AI tạo sinh của riêng mình , một quá trình có thể liên quan đến việc thu thập lượng lớn dữ liệu đào tạo. Nếu tác nhân đe dọa xâm nhập thành công hạ tầng CNTT của doanh nghiệp và có được quyền truy cập trái phép vào dữ liệu đào tạo, thì việc lộ thông tin nhạy cảm có trong các bộ dữ liệu bị xâm phạm có thể vi phạm luật bảo mật dữ liệu.

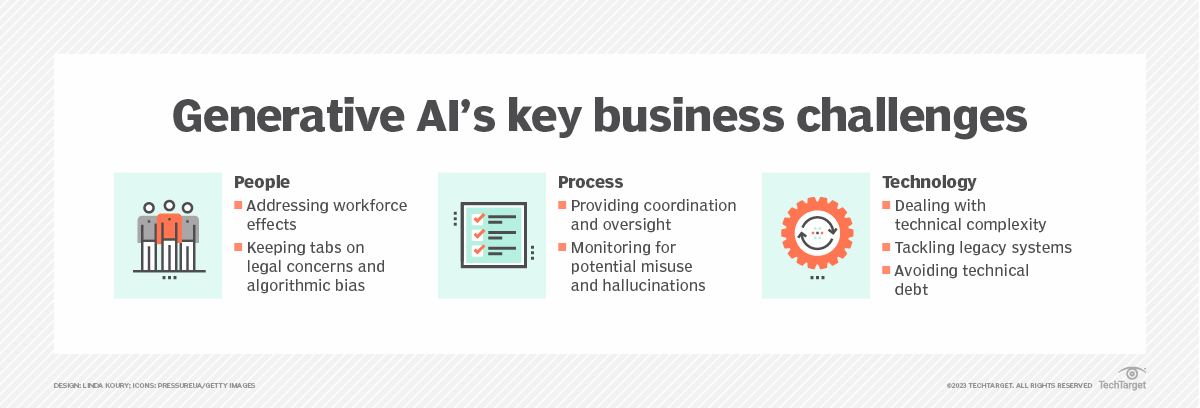

Bên cạnh bảo mật, AI tạo sinh cũng đặt ra những thách thức như sai lệch thuật toán, ảo giác và độ phức tạp về mặt kỹ thuật.

Các kinh nghiệm hay nhất để bảo mật khi sử dụng các công cụ AI tạo sinh trong doanh nghiệp

Để giải quyết nhiều rủi ro bảo mật liên quan đến Generative AI, doanh nghiệp nên ghi nhớ các chiến lược sau khi triển khai các công cụ Generative AI.

1. Phân loại, ẩn danh và mã hóa dữ liệu trước khi xây dựng hoặc tích hợp AI tạo sinh

Các doanh nghiệp nên phân loại dữ liệu của mình trước khi đưa dữ liệu đó vào chatbot hoặc sử dụng dữ liệu đó để đào tạo các mô hình AI tạo sinh. Xác định dữ liệu nào được chấp nhận cho các ứng dụng đó và không chia sẻ bất kỳ thông tin nào khác với hệ thống AI.

Tương tự, ẩn danh dữ liệu nhạy cảm trong tập dữ liệu huấn luyện để tránh tiết lộ thông tin nhạy cảm. Mã hóa tập dữ liệu cho các mô hình AI và tất cả các kết nối với chúng, đồng thời bảo vệ dữ liệu nhạy cảm nhất của tổ chức bằng các chính sách và biện pháp kiểm soát bảo mật mạnh mẽ.

2. Đào tạo nhân viên về các rủi ro bảo mật AI tạo sinh và tạo chính sách sử dụng nội bộ

Đào tạo nhân viên là biện pháp bảo vệ quan trọng nhất để giảm thiểu nguy cơ xảy ra các cuộc tấn công mạng toàn diện liên quan đến AI. Để triển khai Generative AI một cách có trách nhiệm, các tổ chức phải giáo dục nhân viên về những rủi ro liên quan đến việc sử dụng công nghệ này.

Các tổ chức có thể đặt ra các hướng dẫn cho việc sử dụng AI tạo sinh tại nơi làm việc bằng cách phát triển chính sách sử dụng được chấp nhận và bảo mật . Mặc dù các chi tiết cụ thể sẽ khác nhau tùy theo từng tổ chức nhưng cách thực hành tốt nhất nói chung là cần có sự giám sát của con người. Không tự động tin cậy nội dung do AI tạo ra; con người nên xem xét và chỉnh sửa mọi thứ mà công cụ AI tạo ra.

Các chính sách bảo mật và sử dụng AI cũng nên đề cập cụ thể những dữ liệu nào có thể được đưa vào các truy vấn tới chatbot và những dữ liệu nào không được phép. Ví dụ: các nhà phát triển không bao giờ được cung cấp tài sản trí tuệ, tài liệu có bản quyền, PII hoặc PHI vào các công cụ AI.

3. Các công cụ AI tạo sinh của Vet để bảo mật

Tiến hành kiểm tra bảo mật và thực hiện kiểm tra thâm nhập thường xuyên đối với các công cụ AI tạo sinh để xác định các lỗ hổng bảo mật trước khi triển khai chúng vào sản xuất.

Các nhóm bảo mật cũng có thể đào tạo các công cụ AI để nhận biết và chống lại các nỗ lực tấn công bằng cách cung cấp cho chúng các ví dụ về các cuộc tấn công mạng. Điều này làm giảm khả năng tin tặc khai thác thành công hệ thống AI của tổ chức.

4. Quản lý quyền truy cập của nhân viên vào dữ liệu công việc nhạy cảm

Áp dụng nguyên tắc đặc quyền tối thiểu trong môi trường doanh nghiệp, chỉ cho phép những nhân viên được ủy quyền truy cập vào bộ dữ liệu đào tạo AI và hạ tầng CNTT cơ bản.

Việc sử dụng công cụ quản lý danh tính và quyền truy cập có thể giúp tập trung và kiểm soát thông tin xác thực cũng như quyền truy cập của nhân viên. Tương tự như vậy, việc triển khai xác thực đa yếu tố có thể giúp bảo vệ hệ thống AI và quyền truy cập dữ liệu.

5. Đảm bảo mạng và hạ tầng cơ bản được an toàn

Triển khai hệ thống AI trên một phân khúc mạng chuyên dụng . Việc sử dụng một phân đoạn mạng riêng biệt với quyền truy cập hạn chế vào các công cụ AI lưu trữ giúp tăng cường cả tính bảo mật và tính khả dụng.

Đối với các tổ chức lưu trữ các công cụ AI trên đám mây, hãy chọn nhà cung cấp đám mây uy tín thực hiện các biện pháp kiểm soát bảo mật nghiêm ngặt và có chứng nhận tuân thủ hợp lệ. Đảm bảo tất cả các kết nối đến và đi từ hạ tầng đám mây đều được mã hóa.

6. Theo dõi các yêu cầu tuân thủ, bao gồm cả việc thường xuyên kiểm tra các nhà cung cấp

Các quy định tuân thủ không ngừng phát triển và với sự gia tăng áp dụng AI của doanh nghiệp, các tổ chức có thể sẽ thấy nhiều yêu cầu tuân thủ hơn liên quan đến công nghệ AI tạo sinh.

Các doanh nghiệp nên giám sát chặt chẽ các quy định tuân thủ ảnh hưởng đến ngành của mình để phát hiện bất kỳ thay đổi nào liên quan đến việc sử dụng hệ thống AI. Là một phần của quy trình này, khi sử dụng các công cụ AI từ nhà cung cấp bên thứ ba, hãy thường xuyên xem xét các biện pháp kiểm soát bảo mật và đánh giá lỗ hổng bảo mật của nhà cung cấp đó. Điều này giúp đảm bảo mọi điểm yếu về bảo mật trong hệ thống của nhà cung cấp không xâm nhập vào môi trường CNTT của doanh nghiệp.

Bài viết liên quan

- GPU NVIDIA RTX A400 và A1000 mới giúp nâng cao hiệu quả quy trình thiết kế được hỗ trợ bởi AI

- Giới thiệu giải pháp Training AI trên các máy chủ thông dụng

- PowerScale: Nền tảng kiến trúc cho các tác vụ Generative AI

- NVIDIA Hopper tiếp tục dẫn đầu hiệu suất Generative AI trong MLPerf

- NVIDIA hỗ trợ hành trình hướng tới Generative AI thuận lợi hơn cho các doanh nghiệp

- NVIDIA NIM: Vi dịch vụ suy luận tối ưu hóa cho triển khai mô hình AI quy mô lớn