Theo một cuộc khảo sát gần đây, ngành dịch vụ tài chính phụ thuộc rất nhiều vào các kỹ thuật học máy (Machine Learning) và học sâu (Deep Learning) với 3/4 tổ chức trên thế giới dựa vào các công nghệ này. Để đo lường hiệu suất trong lĩnh vực này, điểm chuẩn benchmark (benchmark) có tên STAC-ML đã được đưa ra để đánh giá độ trễ của suy luận mô hình bộ nhớ ngắn hạn dài (LSTM), cụ thể là thời gian giữa việc nhận dữ liệu mới và kết quả đầu ra của các mô hình này.

Trong bài kiểm tra điểm chuẩn này, GPU NVIDIA A100 Tensor Core, được lắp trong các máy chủ Supermicro, đã đạt được kết quả cao nhất về độ trễ và thông lượng. Phân vị thứ 99 cho thấy kết quả độ trễ thấp trong cả ba mô hình LSTM ngày càng phức tạp.

NVIDIA A100 cũng cho thấy kết quả ấn tượng trong điểm chuẩn STAC-A2 để khám phá giá quyền chọn và điểm chuẩn STAC-A3 để kiểm tra lại mô hình, cho thấy tính linh hoạt của điện toán NVIDIA AI trong môi trường giao dịch hiện đại. Tacana Suite của điểm chuẩn, đo suy luận trên cửa sổ trượt, là sản phẩm đầu tiên được NVIDIA gửi và kết quả rất đáng chú ý khi không có ngoại lệ lớn về độ trễ và khả năng thực hiện hàng nghìn suy luận mỗi giây.

Đối với Sumaco Suite, đo lường suy luận trên một tập hợp dữ liệu mới, NVIDIA đã gửi một cấu hình được tối ưu hóa thông lượng, phục vụ hơn 1,7 triệu suy luận mỗi giây trên LSTM ít phức tạp nhất và lên tới 12.800 suy luận trên LSTM phức tạp nhất.

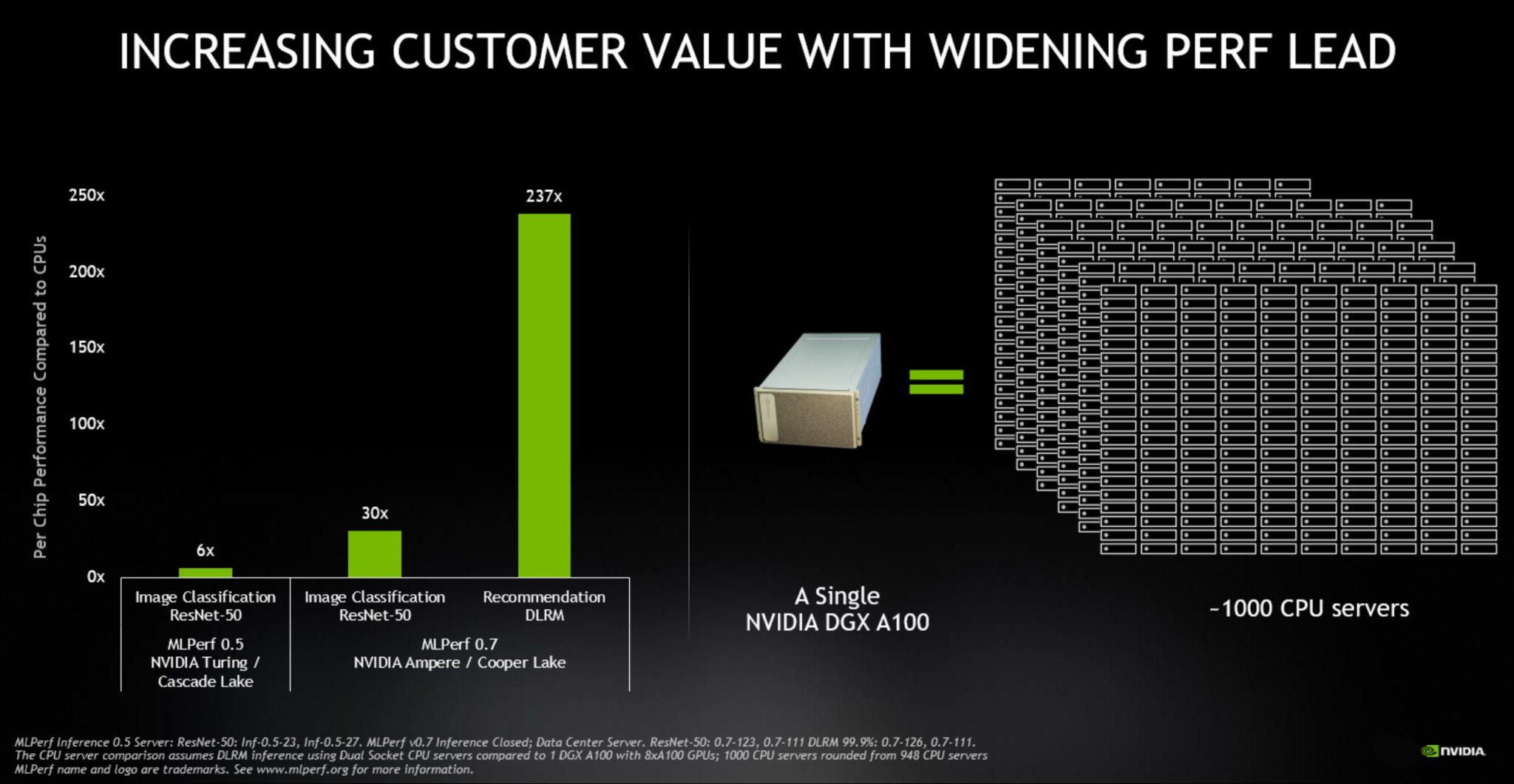

Ngoài ra, NVIDIA còn cung cấp các lợi thế giúp giảm tổng chi phí sở hữu đối với các kho giao dịch điện tử. NVIDIA AI cung cấp một nền tảng duy nhất cho cả đào tạo và suy luận, đồng thời cho phép phát triển và triển khai các ứng dụng trên nhiều thiết bị khác nhau bằng mô hình lập trình CUDA. Ngành dịch vụ tài chính cũng được hưởng lợi từ việc giảm chi phí vận hành, chẳng hạn như sử dụng năng lượng, với A100 vượt quá 17.700 suy luận mỗi giây mỗi kilowatt trong khi chỉ tiêu thụ 722 watt.

Nhìn chung, kết quả điểm chuẩn xác nhận rằng GPU NVIDIA A100 là nổi trội hoàn toàn về thông lượng, độ trễ và hiệu quả sử dụng năng lượng đối với các tải xử lý đòi hỏi khắt khe như kiểm tra lại và mô phỏng.

Bài viết liên quan

- NVIDIA NGC‑ready Low‑latency Edge AI: Giải pháp cho Retail, Manufacturing và Smart Cities

- So sánh sức mạnh của máy tính AI DGX Spark với các card GPU máy trạm chuyên nghiệp của NVIDIA

- Từ Orin đến Thor: Bước nhảy vọt kiến trúc của NVIDIA JetPack 7.0 và tương lai của robot hình người

- Tại sao gọi NVIDIA DGX Spark là Siêu máy tính AI cá nhân?

- Cơ chế quản lý bộ nhớ trên các nền tảng phần cứng nhất quán – Hardware-coherent

- Kiến trúc NVIDIA Blackwell với GB200 NVL72: Định nghĩa lại điện toán AI cấp độ Exascale