Các nhà khoa học, nhà nghiên cứu và kỹ sư đang giải quyết những thách thức quan trọng nhất về khoa học, các ngành công nghiệp và dữ liệu lớn trên thế giới bằng AI và máy tính hiệu suất cao (HPC). Các doanh nghiệp, thậm chí cả ngành công nghiệp liên quan, khai thác sức mạnh của AI để trích xuất những hiểu biết mới từ các tập dữ liệu khổng lồ, cả tại chỗ và trên đám mây. Các sản phẩm dựa trên kiến trúc NVIDIA Ampere, như NVIDIA A100 hoặc NVIDIA RTX A6000, được thiết kế cho thời đại của điện toán linh hoạt, mang đến những đột phá bằng cách cung cấp khả năng tăng tốc chưa từng có ở mọi quy mô, cho phép các nhà sáng tạo vượt qua ranh giới của kiến thức và sự sáng tạo của con người để hướng về phía trước.

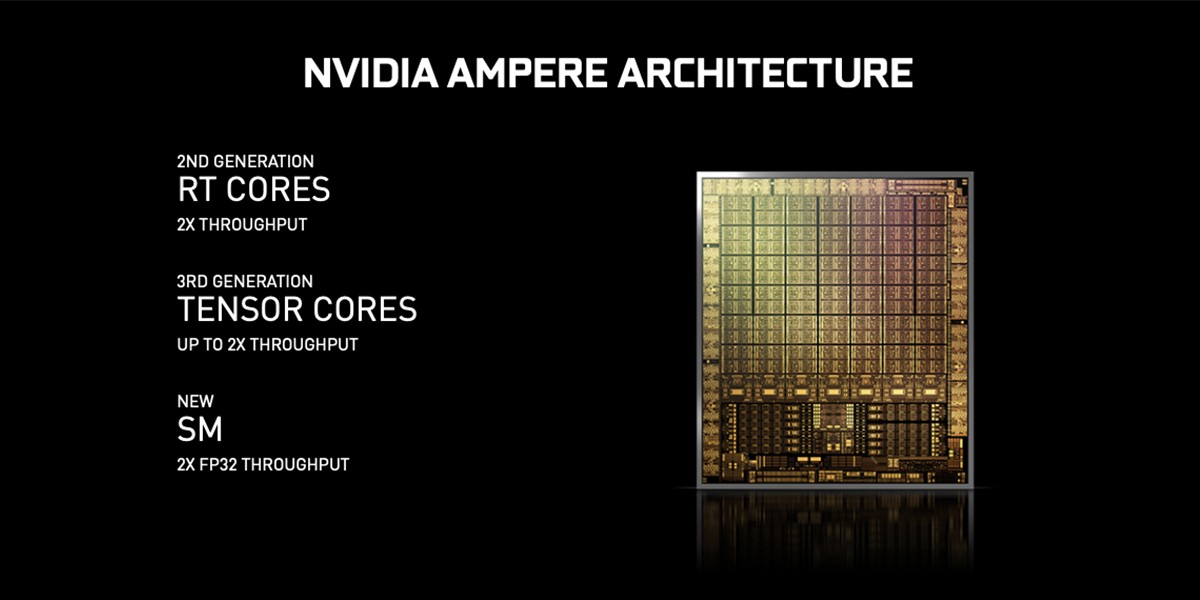

Các sản phẩm dựa trên kiến trúc NVIDIA Ampere thực hiện những cải tiến đột phá. Tensor Core thế hệ thứ ba cung cấp tốc độ đáng kể cho AI, giảm thời gian đào tạo từ hàng tuần xuống hàng giờ và cung cấp khả năng tăng tốc suy luận rất lớn. Hai khu vực mới – Tensor Float (TF32) và Floating Point 64 (FP64, chỉ dành cho NVIDIA A100) tăng tốc việc áp dụng AI và mở rộng sức mạnh của Tensor Cores cho HPC.

TF32 hoạt động giống như FP32 trong khi cung cấp tốc độ lên đến 10 lần cho AI mà không yêu cầu bất kỳ thay đổi nào về mã chương trình khi tận dụng tính chất thưa thớt. Độ chính xác hỗn hợp tự động (Automatic Mixed Precision) và FP16 có thể được sử dụng để tối ưu hóa hiệu suất bằng cách chỉ thêm một vài dòng mã. Với sự hỗ trợ cho bfloat16, INT8 và INT4, Tensor Core thế hệ thứ ba của NVIDIA là một bộ tăng tốc cực kỳ linh hoạt để đào tạo và suy luận AI. Bằng cách mang sức mạnh của Tensor Core cho HPC, NVIDIA A100 cho phép các phép tính ma trận với độ chính xác lên đến cấp độ FP64 toàn diện, đạt chứng nhận IEEE.

Mọi ứng dụng AI, khoa học dữ liệu và HPC đều có thể hưởng lợi từ khả năng tăng tốc, nhưng không phải ứng dụng nào cũng cần hiệu suất của GPU dựa trên kiến trúc Ampere toàn phần. Với Multi-Instant GPU (MIG), được hỗ trợ bởi A100, GPU có thể được phân thành tối đa 7 instant GPU khác nhau, được cô lập và bảo mật hoàn toàn ở cấp phần cứng với bộ nhớ băng thông cao, bộ nhớ đệm và lõi xử lý của riêng chúng. Điều này mang lại khả năng tăng tốc đột phá cho tất cả các ứng dụng lớn nhỏ và mang lại chất lượng dịch vụ được đảm bảo. Các quản trị viên IT có thể cung cấp khả năng tăng tốc GPU đúng kích cỡ để sử dụng tối ưu và mở rộng quyền truy cập cho mọi người dùng và ứng dụng trên cả môi trường ảo hóa và bare-metal.

Cấu hình A100 SXM4 với 40 GB bộ nhớ GPU mang lại hiệu suất xử lý khổng lồ cho các trung tâm dữ liệu. Để giữ cho các công cụ xử lý này được sử dụng đầy đủ, DGX A100 cung cấp băng thông bộ nhớ cao nhất lên đến 1,6 terabyte mỗi giây (TB/s), tăng 67% so với thế hệ trước. A100 cũng có bộ nhớ trên chip nhiều hơn đáng kể, bao gồm bộ nhớ cache level 2 40MB – lớn hơn 7 lần so với thế hệ trước – để tối đa hóa hiệu suất xử lý. Phiên bản PCIe vẫn giữ nguyên bộ nhớ GPU HBM2 40 GB, với chiều rộng bus bộ nhớ là 5120 bit và băng thông bộ nhớ tối đa lên đến 1555 GB/s, dễ dàng vượt qua kỷ lục hiệu năng từ Tesla V100 thế hệ trước.

Các ứng dụng mở rộng quy mô trên nhiều GPU yêu cầu dữ liệu di chuyển cực nhanh. NVIDIA NVLink thế hệ thứ ba trong A100 SXM4 tăng gấp đôi băng thông trực tiếp GPU-to-GPU lên 600 gigabyte mỗi giây (GB/s), cao hơn gần 10 lần so với PCIe Gen 4. Việc triển khai PCIe 4.0 A100 cũng có tổng băng thông NVLink tối đa là 600 GB/s. Máy chủ NVIDIA DGX A100 có thể tận dụng lợi thế của công nghệ NVLink và NVSwitch thông qua board mạch nền NVIDIA HGX A100 để mang lại khả năng mở rộng lớn hơn cho khối lượng công việc HPC và AI. Đối với những người thích triển khai bo mạch chủ PCIe, tùy chọn NVIDIA A100 PCIe cũng hỗ trợ đầy đủ chuẩn NVLink.

Các mạng lưới AI ngày nay ngày càng mở rộng về quy mô, với hàng triệu (trong một số trường hợp là hàng tỷ) tham số. Không phải tất cả những điều này đều cần thiết cho các dự đoán và suy luận chính xác, và một số có thể được chuyển đổi thành số không để làm cho các mô hình “thưa thớt” (sparsity) mà không ảnh hưởng đến độ chính xác. Tensor Core dựa trên kiến trúc Ampere trong NVIDIA A100 hoặc RTX A6000 cung cấp hiệu suất cao hơn tới 10 lần cho các mô hình thưa thớt. Mặc dù tính năng thưa thớt có lợi hơn cho khả năng suy luận của AI, nhưng nó cũng có thể được sử dụng để cải thiện hiệu suất đào tạo mô hình.

Các lõi RT thế hệ thứ hai dựa trên kiến trúc NVIDIA Ampere trong GPU NVIDIA RTX A6000 và NVIDIA A40 cung cấp tốc độ lớn cho các trường hợp sử dụng phân tích dữ liệu lớn, khoa học dữ liệu, AI và HPC trong đó việc nhìn thấy (visualize) vấn đề là cần thiết để giải quyết vấn đề. RT Cores cho phép ray-tracing theo thời gian thực để có kết quả ảnh thực và hoạt động đồng bộ với Tensor Cores nhằm cung cấp các tính năng làm giảm nhiễu AI và các tính năng nâng cao hiệu suất khác.

NVIDIA GTC 21, một sự kiện trực tuyến diễn ra từ ngày 12 đến ngày 16 tháng 4 năm 2021 cung cấp một nguồn tài nguyên tuyệt vời để bổ sung thông tin về cách các GPU dựa trên kiến trúc NVIDIA Ampere đang chuyển đổi khoa học dữ liệu và phân tích dữ liệu lớn. PNY thực sự khuyên bạn nên đăng ký tham gia cuộc họp sắp tới của những bộ óc giỏi nhất và sáng giá nhất trong các lĩnh vực này bằng cách truy cập trang web của NVIDIA tại www.nvidia.com/en-us/gtc.

Bài viết liên quan

- NVIDIA NGC‑ready Low‑latency Edge AI: Giải pháp cho Retail, Manufacturing và Smart Cities

- So sánh sức mạnh của máy tính AI DGX Spark với các card GPU máy trạm chuyên nghiệp của NVIDIA

- Từ Orin đến Thor: Bước nhảy vọt kiến trúc của NVIDIA JetPack 7.0 và tương lai của robot hình người

- Tại sao gọi NVIDIA DGX Spark là Siêu máy tính AI cá nhân?

- Cơ chế quản lý bộ nhớ trên các nền tảng phần cứng nhất quán – Hardware-coherent

- Kiến trúc NVIDIA Blackwell với GB200 NVL72: Định nghĩa lại điện toán AI cấp độ Exascale