Tại hội nghị NVIDIA GTC gần đây, các giám đốc điều hành và diễn giả thường xuyên nhắc đến cụm từ “nhà máy AI” (AI Factory). Đây là một trong những từ thông dụng nhận được nhiều sự chú ý sau khi Jensen Huang, CEO của NVIDIA, nhấn mạnh trong bài phát biểu quan trọng kéo dài hai giờ của mình.

NVIDIA hình dung mô hình để tạo ra các hệ thống AI ở quy mô lớn như nhà máy AI. Khái niệm này đưa ra sự tương tự song song giữa phát triển AI và quy trình công nghiệp nơi dữ liệu thô được đưa vào, được tinh chỉnh thông qua tính toán và tạo ra các sản phẩm có giá trị thông qua hiểu biết sâu sắc và mô hình thông minh.

Trong bài viết này, tôi sẽ cố gắng xem xét kỹ hơn tầm nhìn của NVIDIA về công nghiệp hóa việc sản xuất trí thông minh, tập trung vào nhà máy AI.

Nhà máy AI – Nơi dữ liệu trở thành trí thông minh

Về bản chất, nhà máy AI là hạ tầng điện toán chuyên biệt được thiết kế để tạo ra giá trị từ dữ liệu bằng cách quản lý toàn bộ vòng đời AI – từ thu thập dữ liệu và đào tạo đến tinh chỉnh và hoạt động suy luận với khối lượng lớn. Trong các nhà máy truyền thống, nguyên liệu thô được chuyển đổi thành hàng hóa thành phẩm. Trong nhà máy AI, dữ liệu thô được chuyển đổi thành trí thông minh ở quy mô lớn. Điều này có nghĩa là đầu ra chính của nhà máy AI là thông tin nắm bắt (insights) hoặc các quyết định, thường được đo bằng thông lượng của AI token – về cơ bản là tốc độ mà hệ thống AI tạo ra các dự đoán hoặc phản hồi thúc đẩy các hành động kinh doanh.

Không giống như một trung tâm dữ liệu chung chạy hỗn hợp nhiều tải xử lý, một nhà máy AI được xây dựng có mục đích cho AI. Nó điều phối toàn bộ quy trình phát triển AI bên trong một tổ hợp, cho phép thời gian tạo ra kết quả nhanh hơn đáng kể. Jensen Huang đã nhấn mạnh rằng bản thân NVIDIA đã “phát triển từ việc bán chip sang xây dựng các nhà máy AI khổng lồ”, mô tả NVIDIA là một công ty hạ tầng AI xây dựng các nhà máy hiện đại này.

Các nhà máy AI không chỉ lưu trữ và xử lý dữ liệu – chúng tạo ra các token biểu hiện cho văn bản, hình ảnh, video và các kết quả nghiên cứu. Sự chuyển đổi này thể hiện sự thay đổi từ việc chỉ truy xuất dữ liệu dựa trên các tập dữ liệu đào tạo sang tạo nội dung được thiết kế riêng bằng AI. Đối với các nhà máy AI, trí thông minh không phải là sản phẩm phụ mà là đầu ra chính, được đo bằng thông lượng tạo ra AI token – các dự đoán theo thời gian thực thúc đẩy các quyết định, tự động hóa và các dịch vụ hoàn toàn mới.

Mục tiêu là các công ty đầu tư vào nhà máy AI sẽ biến AI từ một dự án nghiên cứu dài hạn thành động lực trực tiếp của lợi thế cạnh tranh, giống như một nhà máy công nghiệp trực tiếp đóng góp vào doanh thu. Tóm lại, tầm nhìn của nhà máy AI coi AI là một quy trình sản xuất tạo ra trí thông minh một cách tin cậy, hiệu quả và có quy mô.

Ba quy luật mở rộng (scaling) chính thúc đẩy nhu cầu điện toán AI

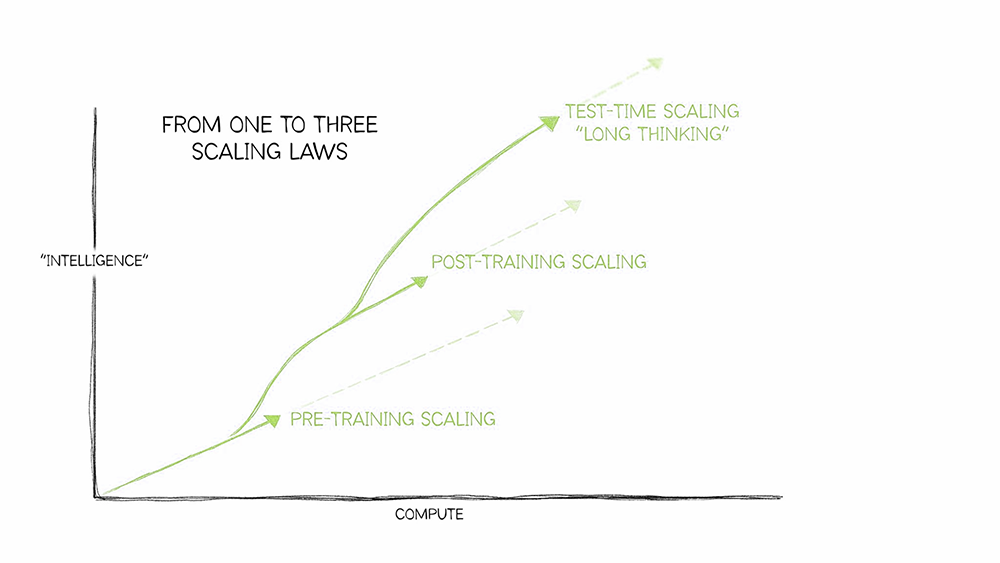

Trí tuệ nhân tạo tạo sinh (GenAI) liên tục phát triển. Từ việc tạo token cơ bản đến lý luận nâng cao, các mô hình ngôn ngữ đã trưởng thành đáng kể trong vòng ba năm qua. Các phiên bản mới của các mô hình AI đòi hỏi hạ tầng cung cấp khả năng và quy mô chưa từng có, được thúc đẩy bởi ba quy luật scaling chủ yếu:

- Pre-training scaling: Các tập dữ liệu lớn hơn và các tham số mô hình mang lại mức gia tăng trí tuệ có thể dự đoán được nhưng đòi hỏi tài nguyên điện toán khổng lồ. Trong năm năm qua, hoạt động Pre-training Scaling đã làm tăng yêu cầu điện toán lên 50 triệu lần.

- Post-training scaling: Việc tinh chỉnh các mô hình AI cho các ứng dụng thực tế cụ thể đòi hỏi phải xử lý nhiều hơn 30 lần trong quá trình suy luận AI so với trước khi đào tạo. Khi các tổ chức điều chỉnh các mô hình hiện có cho nhu cầu riêng của họ, nhu cầu tích lũy về hạ tầng AI tăng vọt.

- Test-time scaling (long thinking): Các ứng dụng AI tiên tiến như Agentic AI hoặc Physical AI đòi hỏi phải suy luận lặp đi lặp lại, khám phá nhiều phản hồi có thể trước khi chọn phản hồi tốt nhất. Điều này tiêu tốn tài nguyên điện toán nhiều hơn tới 100 lần so với suy luận truyền thống.

Các trung tâm dữ liệu truyền thống không thể xử lý hiệu quả các nhu cầu theo cấp số nhân này. Các nhà máy AI được thiết kế riêng để tối ưu hóa và duy trì nhu cầu điện toán khổng lồ này, cung cấp hạ tầng lý tưởng cho suy luận và triển khai AI.

Nền tảng của AI Factory – GPU, DPU và Network

Xây dựng một nhà máy AI đòi hỏi một bộ xương sống phần cứng mạnh mẽ. NVIDIA cung cấp “thiết bị nhà máy” thông qua các chip tiên tiến và các hệ thống tích hợp. Trọng tâm của mọi nhà máy AI là điện toán hiệu suất cao – cụ thể là GPU của NVIDIA, vượt trội về khả năng xử lý song song cần thiết cho AI. Kể từ khi GPU đi vào các trung tâm dữ liệu vào những năm 2010, chúng đã cách mạng hóa thông lượng, mang lại hiệu suất cao hơn gấp nhiều lần trên mỗi watt và trên mỗi đô la so với các máy chủ chỉ có CPU.

Các GPU trung tâm dữ liệu hàng đầu hiện nay, như Hopper của NVIDIA và kiến trúc Blackwell mới hơn, được mệnh danh là động cơ của cuộc cách mạng công nghiệp mới này. Các GPU này thường được triển khai trong các hệ thống NVIDIA DGX, là sản phẩm siêu máy tính AI chìa khóa trao tay. Trên thực tế, NVIDIA DGX SuperPOD, một cụm gồm nhiều máy chủ DGX, được mô tả là “hình mẫu của nhà máy AI chìa khóa trao tay” dành cho doanh nghiệp. Nó đóng gói những gì tốt nhất của điện toán tăng tốc của NVIDIA vào một trung tâm dữ liệu AI sẵn sàng sử dụng giống như một nhà máy chế tạo sẵn để tính toán AI.

Ngoài sức mạnh tính toán thô, cấu trúc mạng của nhà máy AI cũng rất quan trọng. Tải xử lý AI liên quan đến việc di chuyển nhanh chóng lượng dữ liệu khổng lồ giữa các bộ xử lý phân tán. NVIDIA giải quyết vấn đề này bằng các công nghệ như NVLink và NVSwitch – các kết nối tốc độ cao cho phép GPU trong máy chủ chia sẻ dữ liệu ở băng thông cực lớn. Để mở rộng quy mô trên các máy chủ, NVIDIA cung cấp kết nối mạng cực nhanh trong các bộ chuyển mạch Ethernet InfiniBand và Spectrum-X, thường được kết hợp với các đơn vị xử lý dữ liệu (DPU) BlueField để giảm tải các tác vụ mạng và lưu trữ. Phương pháp kết nối tốc độ cao từ đầu đến cuối này loại bỏ các điểm nghẽn, cho phép hàng nghìn GPU hoạt động cùng nhau như một máy tính khổng lồ. Về bản chất, NVIDIA coi toàn bộ trung tâm dữ liệu là đơn vị điện toán mới, kết nối chặt chẽ các chip, máy chủ và rack để nhà máy AI hoạt động như một siêu máy tính khổng lồ duy nhất.

Một cải tiến phần cứng khác trong bộ sản phẩm của NVIDIA là Grace Hopper Superchip, kết hợp một CPU NVIDIA Grace với một GPU NVIDIA Hopper trong một gói duy nhất. Thiết kế này cung cấp 900 GB/giây băng thông chip-to-chip thông qua NVLink, tạo ra một nhóm bộ nhớ thống nhất cho các ứng dụng AI. Bằng cách kết hợp chặt chẽ CPU và GPU, Grace Hopper loại bỏ tình trạng tắc nghẽn PCIe truyền thống giữa các bộ xử lý, cho phép truyền dữ liệu nhanh hơn và các mô hình lớn hơn trong bộ nhớ. Ví dụ, các hệ thống được xây dựng trên Grace Hopper cung cấp thông lượng cao hơn 7 lần giữa CPU và GPU so với các kiến trúc tiêu chuẩn.

Loại tích hợp này rất quan trọng đối với các nhà máy AI, vì nó đảm bảo rằng các GPU đang cần dữ liệu sẽ không bao giờ bị thiếu dữ liệu. Nhìn chung, từ GPU và CPU đến DPU và mạng, danh mục phần cứng của NVIDIA, thường được lắp ráp thành các hệ thống DGX hoặc dịch vụ đám mây, tạo nên hạ tầng vật lý của nhà máy AI.

Software Stack – CUDA, NVIDIA AI Enterprise và Omniverse

Chỉ riêng phần cứng thôi là không đủ – tầm nhìn của NVIDIA về nhà máy AI bao gồm một software stack đầu cuối để tận dụng hạ tầng này. Thành phần cơ bản là CUDA, một nền tảng điện toán song song và mô hình lập trình của NVIDIA cho phép các nhà phát triển khai thác khả năng tăng tốc GPU. Các thư viện CUDA và CUDA-X (dành cho học sâu, phân tích dữ liệu, v.v.) đã trở thành ngôn ngữ chung cho điện toán GPU, giúp dễ dàng xây dựng các thuật toán AI chạy hiệu quả trên phần cứng NVIDIA. Hàng nghìn ứng dụng AI và điện toán hiệu suất cao được xây dựng trên nền tảng CUDA, giúp nền tảng này trở thành nền tảng được lựa chọn cho nghiên cứu và phát triển học sâu. Trong bối cảnh của một nhà máy AI, CUDA cung cấp các công cụ cấp thấp để tối đa hóa hiệu suất của thế hệ nhà máy AI mới.

Bên trên nền tảng này, NVIDIA cung cấp NVIDIA AI Enterprise, một bộ phần mềm thuần đám mây để chuẩn hóa quá trình phát triển và triển khai AI cho các doanh nghiệp. NVIDIA AI Enterprise tích hợp hơn 100 frameworks, pre-trained models và các công cụ – tất cả đều được tối ưu hóa cho GPU NVIDIA – thành một nền tảng gắn kết với dịch vụ hỗ trợ cấp doanh nghiệp. Nó đẩy nhanh từng bước của quy trình AI, từ chuẩn bị dữ liệu và đào tạo mô hình đến phục vụ suy luận, đồng thời đảm bảo tính bảo mật và độ tin cậy cho mục đích sử dụng ở cấp độ sản xuất. Trên thực tế, AI Enterprise giống như hệ điều hành và phần mềm trung gian của nhà máy AI. Nó cung cấp các thành phần sẵn sàng sử dụng như NVIDIA Inference Microservices – các mô hình AI được chứa trong container có thể triển khai nhanh chóng để phục vụ các ứng dụng – và NVIDIA NeMo Framework để tùy biến các mô hình ngôn ngữ lớn. Bằng cách cung cấp các khối xây dựng này, AI Enterprise giúp các công ty theo dõi nhanh quá trình phát triển các giải pháp AI và chuyển đổi chúng từ nguyên mẫu sang sản xuất một cách suôn sẻ.

Bộ phần mềm của NVIDIA bao gồm các công cụ để quản lý và điều phối hoạt động của nhà máy AI. Ví dụ, NVIDIA Base Command và các công cụ từ các đối tác như Run:AI giúp lên lịch công việc trên một cụm, quản lý dữ liệu và giám sát việc sử dụng GPU trong môi trường nhiều người dùng. NVIDIA Mission Control (được xây dựng trên công nghệ Run:AI) cung cấp một bảng điều khiển duy nhất để giám sát tải xử lý và hạ tầng, với trí thông minh để tối ưu hóa việc sử dụng và đảm bảo độ tin cậy. Các công cụ này mang lại sự linh hoạt của các dịch vụ đám mây cho bất kỳ ai điều hành một nhà máy AI, để ngay cả các đội ngũ IT nhỏ hơn cũng có thể vận hành một cụm AI quy mô của siêu máy tính một cách hiệu quả.

Một thành tố quan trọng khác là NVIDIA Omniverse, đóng vai trò độc đáo trong tầm nhìn của nhà máy AI. Omniverse là một nền tảng mô phỏng và cộng tác cho phép nhà sáng tạo và kỹ sư xây dựng các bản sao kỹ thuật số – bản sao ảo của các hệ thống trong thế giới thực – với mô phỏng chính xác về mặt vật lý. Đối với các nhà máy AI, NVIDIA đã giới thiệu Omniverse Blueprint for AI Factory Design and Operations, cho phép các kỹ sư thiết kế và tối ưu hóa các trung tâm dữ liệu AI trong môi trường ảo trước khi triển khai phần cứng. Nói cách khác, Omniverse cho phép các doanh nghiệp và nhà cung cấp dịch vụ đám mây mô phỏng một nhà máy AI (từ bố trí hẹ thống làm mát đến kết nối mạng) dưới dạng mô hình 3D, kiểm tra các thay đổi và khắc phục sự cố ảo trước khi cài đặt một máy chủ đơn lẻ. Điều này giúp giảm rủi ro và tăng tốc triển khai hạ tầng AI mới. Ngoài thiết kế trung tâm dữ liệu, Omniverse còn được sử dụng để mô phỏng rô-bốt, xe tự hành và các máy móc chạy bằng AI khác trong thế giới ảo một cách chân thực. Điều này vô cùng hữu ích để phát triển các mô hình AI trong các ngành công nghiệp như rô-bốt và ô tô, hoạt động hiệu quả như một xưởng mô phỏng của một nhà máy AI. Bằng cách tích hợp Omniverse với hệ thống AI của mình, NVIDIA đảm bảo rằng nhà máy AI không chỉ đào tạo các mô hình nhanh hơn mà còn thu hẹp khoảng cách với việc triển khai trong thế giới thực thông qua mô phỏng bản sao kỹ thuật số.

Nhà máy AI là tương lai của AI tạo sinh

Jensen Huang đã định vị AI như một hạ tầng công nghiệp tương tự như điện hoặc điện toán đám mây – không chỉ là một sản phẩm mà còn là động lực kinh tế cốt lõi sẽ thúc đẩy mọi thứ từ IT doanh nghiệp đến các nhà máy tự động hóa. Điều này không gì khác hơn là một cuộc cách mạng công nghiệp mới được thúc đẩy bởi AI tạo sinh.

Bộ phần mềm của NVIDIA dành cho nhà máy AI trải dài từ lập trình GPU cấp thấp (CUDA) đến các nền tảng doanh nghiệp toàn diện (AI Enterprise) và các công cụ mô phỏng (Omniverse). Phương pháp tiếp cận toàn diện này cung cấp cho các tổ chức áp dụng mô hình nhà máy AI một hệ sinh thái “một cửa”. Họ có thể có được phần cứng NVIDIA và sử dụng phần mềm được tối ưu hóa của NVIDIA để quản lý dữ liệu, đào tạo, suy luận và thậm chí là thử nghiệm ảo với khả năng tương thích và hỗ trợ được đảm bảo. Nó thực sự giống như một sàn nhà máy tích hợp, nơi mỗi thành phần được tinh chỉnh để hoạt động cùng nhau. NVIDIA và các đối tác của họ liên tục cải tiến bộ phần mềm này với các khả năng mới. Kết quả là một nền tảng phần mềm vững chắc cho phép các nhà khoa học dữ liệu và nhà phát triển tập trung vào việc tạo ra các giải pháp AI thay vì vật lộn với hạ tầng của mình.

Bài viết liên quan

- NVIDIA NGC‑ready Low‑latency Edge AI: Giải pháp cho Retail, Manufacturing và Smart Cities

- So sánh sức mạnh của máy tính AI DGX Spark với các card GPU máy trạm chuyên nghiệp của NVIDIA

- Từ Orin đến Thor: Bước nhảy vọt kiến trúc của NVIDIA JetPack 7.0 và tương lai của robot hình người

- Tại sao gọi NVIDIA DGX Spark là Siêu máy tính AI cá nhân?

- Cơ chế quản lý bộ nhớ trên các nền tảng phần cứng nhất quán – Hardware-coherent

- Kiến trúc NVIDIA Blackwell với GB200 NVL72: Định nghĩa lại điện toán AI cấp độ Exascale