AI đang nhen nhóm cho một cuộc cách mạng công nghiệp mới – một cuộc cách mạng được thúc đẩy bởi các Nhà máy AI (AI Factory).

Không giống như các trung tâm dữ liệu truyền thống, các nhà máy AI không chỉ lưu trữ và xử lý dữ liệu — chúng sản xuất trí thông minh ở quy mô lớn, chuyển đổi dữ liệu thô thành thông tin chi tiết theo thời gian thực. Đối với các doanh nghiệp và quốc gia trên toàn thế giới, điều này có nghĩa là thời gian tạo ra giá trị nhanh hơn đáng kể — biến AI từ khoản đầu tư dài hạn thành động lực trực tiếp của lợi thế cạnh tranh. Các công ty đầu tư vào các nhà máy AI được xây dựng có mục đích ngày nay sẽ dẫn đầu về khả năng đổi mới, tính hiệu quả và sự khác biệt trên thị trường ngày trong tương lai.

Trong khi một trung tâm dữ liệu truyền thống thường xử lý nhiều tải xử lý khác nhau và được xây dựng cho mục đích điện toán chung, các nhà máy AI được tối ưu hóa để tạo ra giá trị từ AI. Chúng điều phối toàn bộ vòng đời AI — từ thu thập dữ liệu đến đào tạo, tinh chỉnh và quan trọng nhất là suy luận khối lượng lớn.

Đối với các nhà máy AI, trí thông minh không phải là sản phẩm phụ mà là sản phẩm chính. Trí thông minh này được đo bằng thông lượng của các AI token — các dự đoán thời gian thực thúc đẩy các quyết định, tự động hóa và các dịch vụ hoàn toàn mới.

Mặc dù các trung tâm dữ liệu truyền thống sẽ không sớm biến mất, nhưng việc chúng có phát triển thành nhà máy AI hay kết nối với chúng hay không tùy thuộc vào mô hình kinh doanh của doanh nghiệp.

Bất kể các doanh nghiệp chọn cách thích ứng như thế nào, các nhà máy AI do NVIDIA cung cấp hiện đang sản xuất trí thông minh ở quy mô lớn, chuyển đổi cách thức xây dựng, tinh chỉnh và triển khai AI.

Các quy luật mở rộng thúc đẩy nhu cầu tính toán

Trong vài năm qua, AI đã xoay quanh việc đào tạo các mô hình lớn. Nhưng với sự gia tăng gần đây của các mô hình lý luận AI, suy luận đã trở thành động lực chính của kinh tế AI. Ba quy luật mở rộng chính nêu bật lý do tại sao:

- Mở rộng quy mô đào tạo trước (pre-training): Các tập dữ liệu lớn và các tham số mô hình mang lại mức tăng độ thông minh có thể dự đoán được, nhưng để đạt đến giai đoạn này đòi hỏi phải đầu tư đáng kể vào các chuyên gia lành nghề, việc quản lý dữ liệu và tài nguyên tính toán. Trong năm năm qua, việc mở rộng quy mô pre-training đã làm tăng yêu cầu tính toán lên 50 triệu lần. Tuy nhiên, sau khi một mô hình được đào tạo, nó sẽ làm giảm đáng kể rào cản đối với người ứng dụng khác khi xây dựng dựa trên mô hình đó.

- Mở rộng quy mô sau đào tạo (post-training): Việc tinh chỉnh các mô hình AI cho các ứng dụng thực tế cụ thể đòi hỏi phải tính toán nhiều hơn 30 lần trong quá trình suy luận AI so với quá trình đào tạo trước. Khi các tổ chức điều chỉnh các mô hình hiện có cho nhu cầu riêng của họ, nhu cầu tích lũy về hạ tầng AI tăng vọt.

- Mở rộng thời gian thử nghiệm (hay còn gọi là suy nghĩ dài hạn): Các ứng dụng AI tiên tiến như AI tác nhân hoặc AI vật lý đòi hỏi phải suy luận lặp đi lặp lại, trong đó các mô hình khám phá nhiều phản hồi có thể xảy ra trước khi chọn phản hồi tốt nhất. Điều này tiêu tốn nhiều hơn tới 100 lần khả năng tính toán so với suy luận truyền thống.

Các trung tâm dữ liệu truyền thống không được thiết kế cho kỷ nguyên AI mới này. Nhưng với các nhà máy AI, chúng được xây dựng có mục đích để tối ưu hóa và duy trì nhu cầu điện toán khổng lồ này, cung cấp một con đường lý tưởng để suy luận và triển khai AI.

Tái định hình các ngành công nghiệp và nền kinh tế bằng Token

Trên khắp thế giới, các chính phủ và doanh nghiệp đang chạy đua xây dựng các nhà máy AI để thúc đẩy tăng trưởng kinh tế, đổi mới sáng tạo và hiệu quả.

Liên doanh điện toán hiệu suất cao châu Âu (European High Performance Computing Joint Undertaking) gần đây đã công bố kế hoạch xây dựng bảy nhà máy AI hợp tác với 17 quốc gia thành viên Liên minh châu Âu.

Sự kiện này diễn ra sau làn sóng đầu tư vào nhà máy AI trên toàn thế giới khi các doanh nghiệp và quốc gia đẩy nhanh tăng trưởng kinh tế do AI thúc đẩy trên mọi ngành và khu vực:

- Ấn Độ: Yotta Data Services đã hợp tác với NVIDIA để ra mắt Shakti Cloud Platform, giúp phổ cập hóa quyền truy cập vào các tài nguyên GPU tiên tiến. Bằng cách tích hợp phần mềm NVIDIA AI Enterprise với các công cụ nguồn mở, Yotta cung cấp một môi trường liền mạch để phát triển và triển khai AI.

- Nhật Bản: Các nhà cung cấp dịch vụ đám mây hàng đầu — bao gồm GMO Internet, Highreso, KDDI, Rutilea và SAKURA Internet — đang xây dựng hạ tầng AI do NVIDIA cung cấp để chuyển đổi các ngành công nghiệp như robot, ô tô, y tế và viễn thông.

- Na Uy: Telenor đã ra mắt nhà máy AI do NVIDIA hỗ trợ để đẩy nhanh việc áp dụng AI trên khắp khu vực Bắc Âu, tập trung vào việc nâng cao kỹ năng và tính bền vững của lực lượng lao động.

Những sáng kiến này nhấn mạnh một thực tế toàn cầu: Các nhà máy AI đang nhanh chóng trở thành hạ tầng quốc gia thiết yếu, ngang bằng với viễn thông và năng lượng.

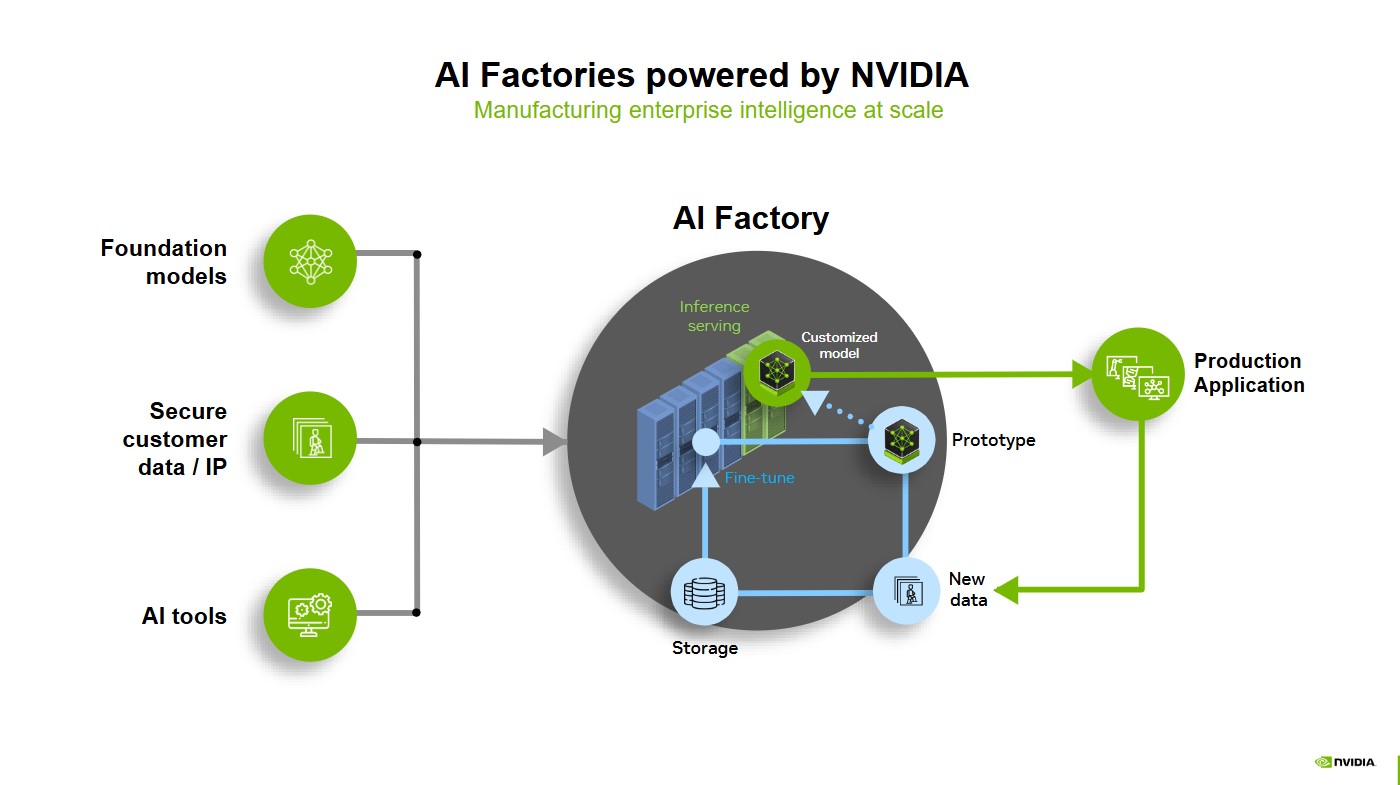

Bên trong một nhà máy AI: Nơi trí thông minh được sản xuất

Các mô hình nền tảng, dữ liệu khách hàng an toàn và các công cụ AI cung cấp nguyên liệu thô để thúc đẩy các nhà máy AI, nơi phục vụ suy luận, tạo mẫu và tinh chỉnh hình thành các mô hình mạnh mẽ, tùy biến, sẵn sàng đưa vào sản xuất.

Khi các mô hình này được triển khai vào các ứng dụng thực tế, chúng liên tục học hỏi từ dữ liệu mới, được lưu trữ, tinh chỉnh và đưa trở lại hệ thống bằng cách sử dụng bánh đà dữ liệu. Chu kỳ tối ưu hóa này đảm bảo AI vẫn thích ứng, hiệu quả và luôn cải thiện — thúc đẩy trí tuệ doanh nghiệp ở quy mô chưa từng có.

Các nhà máy AI do NVIDIA cung cấp để sản xuất trí tuệ doanh nghiệp ở quy mô lớn.

Các nhà máy AI do NVIDIA cung cấp để sản xuất trí tuệ doanh nghiệp ở quy mô lớn.

Lợi thế của Nhà máy AI với nền tảng NVIDIA AI toàn diện

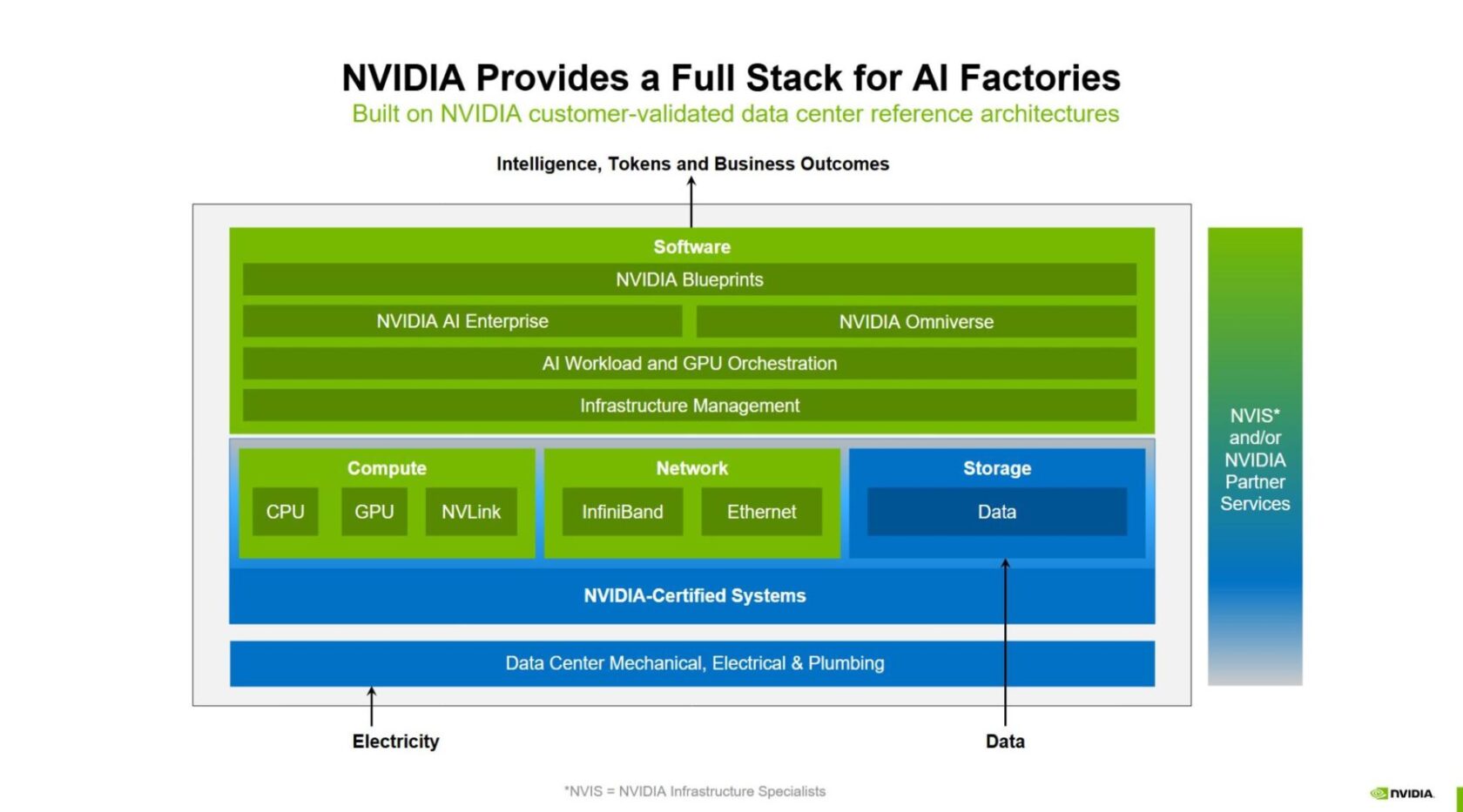

NVIDIA cung cấp một nền tảng nhà máy AI toàn diện (full-stack), tích hợp, trong đó mọi lớp — từ phần cứng đến phần mềm — đều được tối ưu hóa để đào tạo, tinh chỉnh và suy luận ở quy mô lớn. Cách tiếp cận full-stack này đảm bảo các doanh nghiệp có thể triển khai các nhà máy AI tiết kiệm chi phí, hiệu suất cao và được bảo vệ trong tương lai cho sự tăng trưởng theo cấp số nhân của AI.

Cùng với các đối tác trong hệ sinh thái của mình, NVIDIA đã tạo ra các khối xây dựng cho nhà máy AI full-stack, cung cấp:

- Hiệu suất tính toán mạnh mẽ

- Kết nối mạng nâng cao

- Quản lý hạ tầng và điều phối tải xử lý

- Hệ sinh thái suy luận AI lớn nhất

- Nền tảng dữ liệu và lưu trữ

- Bộ khung cho việc thiết kế và tối ưu hóa

- Kiến trúc tham khảo

- Triển khai linh hoạt cho mọi doanh nghiệp

Hiệu suất tính toán mạnh mẽ

Trái tim của bất kỳ nhà máy AI nào chính là sức mạnh tính toán của nó. Từ NVIDIA Hopper đến NVIDIA Blackwell, NVIDIA cung cấp khả năng điện toán tăng tốc mạnh mẽ nhất thế giới cho cuộc cách mạng công nghiệp mới này. Với giải pháp NVIDIA Blackwell Ultra-based GB300 NVL72 rack-scale, các nhà máy AI có thể đạt được công suất đầu ra gấp 50 lần cho lý luận AI, thiết lập một tiêu chuẩn mới về hiệu quả và quy mô.

NVIDIA DGX SuperPOD là ví dụ điển hình về nhà máy AI chìa khóa trao tay dành cho doanh nghiệp, tích hợp những tính năng tốt nhất của điện toán tăng tốc NVIDIA. NVIDIA DGX Cloud cung cấp một nhà máy AI cung cấp khả năng điện toán tăng tốc NVIDIA với hiệu suất cao trên nền tảng đám mây.

Các đối tác hệ thống toàn cầu đang xây dựng các nhà máy AI đầy đủ tính năng cho khách hàng của họ dựa trên công nghệ điện toán tăng tốc của NVIDIA — hiện bao gồm các giải pháp rack-scale NVIDIA GB200 NVL72 và GB300 NVL72.

Kết nối mạng nâng cao

Việc di chuyển trí thông minh ở quy mô lớn đòi hỏi kết nối liền mạch, hiệu suất cao trên toàn bộ các lớp của nhà máy AI. NVIDIA NVLink và NVLink Switch cho phép giao tiếp đa GPU tốc độ cao, tăng tốc độ di chuyển dữ liệu trong và giữa các node.

Các nhà máy AI cũng đòi hỏi một trục xương sống mạng mạnh mẽ. Các nền tảng mạng NVIDIA Quantum InfiniBand, NVIDIA Spectrum-X Ethernet và NVIDIA BlueField giúp giảm thiểu tình trạng tắc nghẽn, đảm bảo trao đổi dữ liệu hiệu quả, thông lượng cao trên các cụm GPU lớn. Sự tích hợp đầu cuối này rất cần thiết để mở rộng tải xử lý AI lên mức hàng triệu GPU, cho phép hiệu suất đột phá trong đào tạo và suy luận.

Quản lý hạ tầng và điều phối tải xử lý

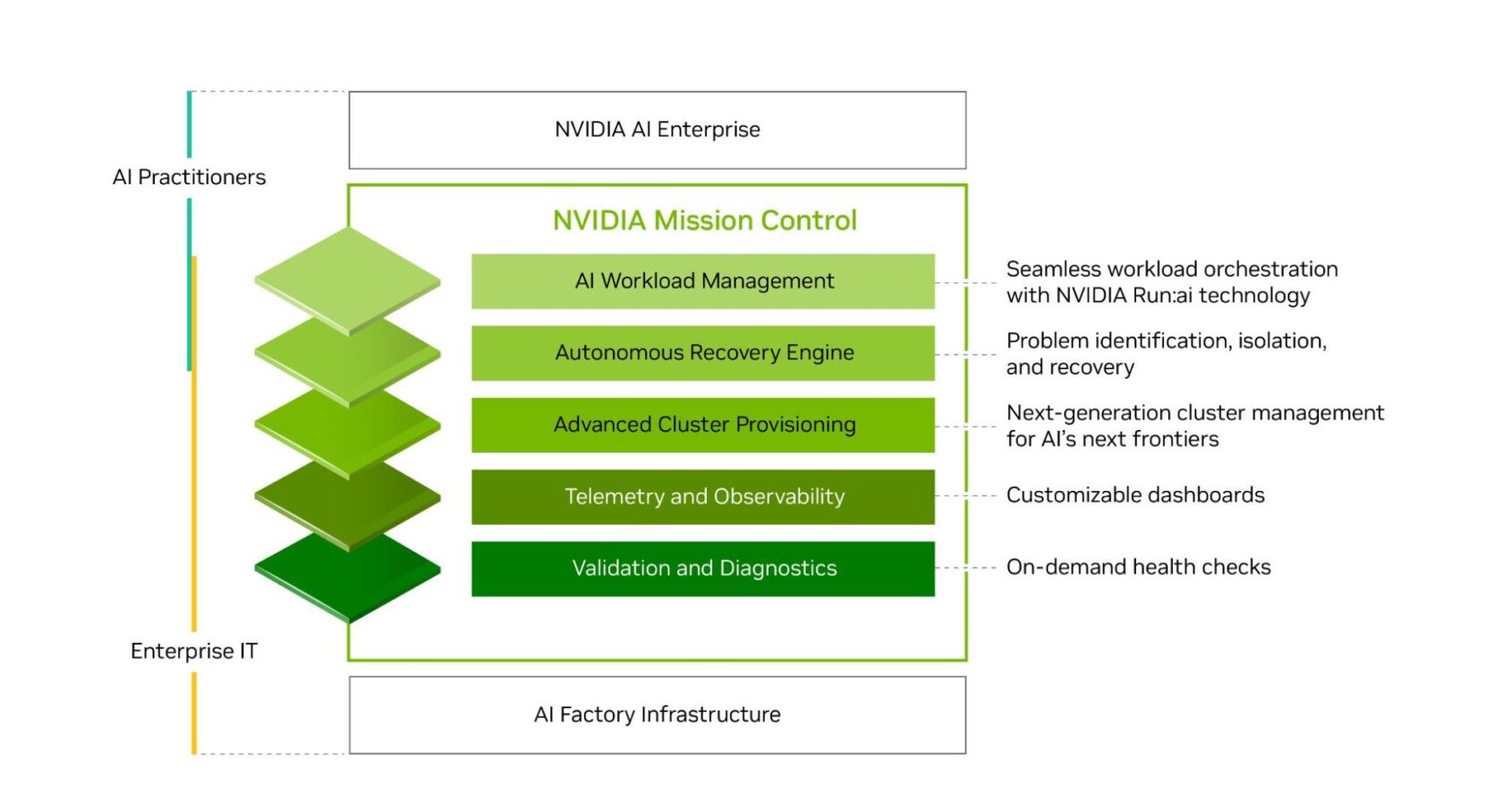

Các doanh nghiệp cần tìm cách khai thác sức mạnh của hạ tầng AI với sự nhanh nhẹn, hiệu quả và quy mô của một công ty cấp độ “hyperscale”, nhưng không phải chịu gánh nặng về chi phí, độ phức tạp và chuyên môn cho IT.

Với giải pháp NVIDIA Run:ai, các tổ chức có thể hưởng lợi từ việc sắp xếp tải xử lý AI liền mạch và quản lý GPU, tối ưu hóa việc sử dụng tài nguyên trong khi tăng tốc thử nghiệm AI và mở rộng tải xử lý. Phần mềm NVIDIA Mission Control, bao gồm công nghệ NVIDIA Run:ai, chuẩn hóa hoạt động của nhà máy AI từ tải xử lý đến hạ tầng, trong khi cung cấp trí thông minh toàn diện mang lại khả năng phục hồi hạ tầng đẳng cấp thế giới.

NVIDIA Mission Control chuẩn hóa quy trình làm việc trên toàn bộ nhà máy AI.

NVIDIA Mission Control chuẩn hóa quy trình làm việc trên toàn bộ nhà máy AI.

Hệ sinh thái suy luận AI lớn nhất

Các nhà máy AI cần các công cụ phù hợp để biến dữ liệu thành trí thông minh. Nền tảng suy luận AI của NVIDIA, bao gồm hệ sinh thái NVIDIA TensorRT, các microservice NVIDIA Dynamo và NVIDIA NIM — tất cả đều là một phần (hoặc sắp trở thành một phần) của nền tảng phần mềm NVIDIA AI Enterprise — cung cấp bộ thư viện tăng tốc AI và phần mềm được tối ưu hóa toàn diện nhất trong ngành. Nó mang lại hiệu suất suy luận tối đa, độ trễ cực thấp và thông lượng cao.

Nền tảng lưu trữ và dữ liệu

Dữ liệu thúc đẩy các ứng dụng AI, nhưng quy mô và độ phức tạp ngày càng tăng nhanh của dữ liệu doanh nghiệp thường khiến việc khai thác hiệu quả trở nên quá tốn kém và mất thời gian. Để phát triển trong kỷ nguyên AI, các doanh nghiệp phải khai thác hết tiềm năng của dữ liệu.

NVIDIA AI Data Platform là thiết kế tham chiếu có thể tùy biến để xây dựng một lớp hạ tầng AI mới cho tải xử lý suy luận AI đòi hỏi khắt khe. Các đối tác lưu trữ được NVIDIA chứng nhận đang hợp tác với NVIDIA để tạo ra các nền tảng dữ liệu AI tùy biến có thể khai thác dữ liệu doanh nghiệp cho việc lý luận và phản hồi các truy vấn phức tạp.

Bộ khung cho việc thiết kế và tối ưu hóa

Để thiết kế và tối ưu hóa các nhà máy AI, các nhóm có thể sử dụng NVIDIA Omniverse Blueprint cho thiết kế và vận hành nhà máy AI. Bộ khung này cho phép các kỹ sư thiết kế, thử nghiệm và tối ưu hóa hạ tầng nhà máy AI trước khi triển khai bằng cách sử dụng bản sao kỹ thuật số (digital twin). Bằng cách giảm rủi ro và sự không chắc chắn, bộ khung giúp ngăn ngừa thời gian chết tốn kém — một yếu tố quan trọng đối với các nhà điều hành nhà máy AI.

Đối với một nhà máy AI quy mô 1 gigawatt, mỗi ngày ngừng hoạt động có thể tốn hơn 100 triệu đô la. Bằng cách giải quyết sự phức tạp ngay từ đầu và cho phép các nhóm riêng biệt về CNTT, cơ khí, điện, năng lượng và mạng làm việc song song, bộ khung này đẩy nhanh quá trình triển khai và đảm bảo khả năng phục hồi hoạt động.

Kiến trúc tham khảo

NVIDIA Enterprise Reference Architectures và NVIDIA Cloud Partner Reference Architectures cung cấp lộ trình cho các đối tác thiết kế và triển khai các nhà máy AI. Chúng giúp các doanh nghiệp và nhà cung cấp dịch vụ đám mây xây dựng hạ tầng AI có khả năng mở rộng, hiệu suất cao và an toàn dựa trên NVIDIA-Certified Systems với bộ phần mềm NVIDIA AI và hệ sinh thái đối tác.

Nhà máy AI đầy đủ của NVIDIA, được xây dựng trên kiến trúc tham chiếu của NVIDIA. (*NVIS = chuyên gia về hạ tầng của NVIDIA)

Nhà máy AI đầy đủ của NVIDIA, được xây dựng trên kiến trúc tham chiếu của NVIDIA. (*NVIS = chuyên gia về hạ tầng của NVIDIA)

Mỗi stack của nhà máy AI đều dựa vào điện toán hiệu quả để đáp ứng nhu cầu AI ngày càng tăng. Điện toán tăng tốc NVIDIA đóng vai trò là nền tảng trên toàn bộ các stack, mang lại hiệu suất cao nhất trên mỗi watt để đảm bảo các nhà máy AI hoạt động ở hiệu suất năng lượng cao nhất . Với kiến trúc tiết kiệm năng lượng và làm mát bằng chất lỏng, các doanh nghiệp có thể mở rộng quy mô AI trong khi vẫn kiểm soát được chi phí năng lượng.

Triển khai linh hoạt cho mọi doanh nghiệp

Với công nghệ toàn diện của NVIDIA, các doanh nghiệp có thể dễ dàng xây dựng và triển khai các nhà máy AI, phù hợp với mô hình tiêu thụ CNTT và nhu cầu vận hành ưa thích của khách hàng.

Một số tổ chức lựa chọn nhà máy AI tại chỗ để duy trì toàn quyền kiểm soát dữ liệu và hiệu suất, trong khi những tổ chức khác sử dụng các giải pháp dựa trên đám mây để có khả năng mở rộng và linh hoạt. Nhiều tổ chức cũng chuyển sang các đối tác hệ thống toàn cầu đáng tin cậy của họ để có các giải pháp tích hợp sẵn giúp đẩy nhanh quá trình triển khai.

NVIDIA DGX GB300 là hạ tầng nhà máy AI có hiệu suất cao nhất và quy mô lớn nhất hiện có dành cho các doanh nghiệp được xây dựng cho kỷ nguyên suy luận AI.

NVIDIA DGX GB300 là hạ tầng nhà máy AI có hiệu suất cao nhất và quy mô lớn nhất hiện có dành cho các doanh nghiệp được xây dựng cho kỷ nguyên suy luận AI.

Tại doanh nghiệp (onpremises)

NVIDIA DGX SuperPOD là giải pháp hạ tầng nhà máy AI chìa khóa trao tay cung cấp hạ tầng được tăng tốc với hiệu suất có thể mở rộng cho các tải xử lý đào tạo và suy luận AI đòi hỏi khắt khe nhất. Nó có sự kết hợp được tối ưu hóa về mặt thiết kế giữa tính toán AI, cấu trúc mạng, lưu trữ và phần mềm NVIDIA Mission Control, giúp các doanh nghiệp đưa các nhà máy AI vào hoạt động trong vài tuần thay vì vài tháng — và với thời gian hoạt động, khả năng phục hồi và khả năng sử dụng tốt nhất trong phân khúc.

Các giải pháp AI factory cũng được cung cấp thông qua hệ sinh thái toàn cầu của NVIDIA gồm các đối tác công nghệ doanh nghiệp với NVIDIA-Certified System. Họ cung cấp công nghệ phần cứng và phần mềm hàng đầu, kết hợp với chuyên môn về hệ thống trung tâm dữ liệu và các cải tiến về làm mát bằng chất lỏng, để giúp các doanh nghiệp giảm thiểu rủi ro cho các nỗ lực AI của mình và đẩy nhanh lợi tức đầu tư cho việc triển khai AI factory của họ.

Các đối tác hệ thống toàn cầu này đang cung cấp các giải pháp toàn diện dựa trên kiến trúc tham chiếu của NVIDIA — tích hợp với điện toán tăng tốc, mạng hiệu suất cao và phần mềm AI của NVIDIA — để giúp khách hàng triển khai thành công các nhà máy AI và sản xuất trí thông minh ở quy mô lớn.

Trên đám Mây

Đối với các doanh nghiệp đang tìm kiếm giải pháp dựa trên đám mây cho nhà máy AI của mình, NVIDIA DGX Cloud cung cấp một nền tảng thống nhất trên các đám mây hàng đầu để xây dựng, tùy biến và triển khai các ứng dụng AI. Mỗi lớp của DGX Cloud đều được NVIDIA tối ưu hóa và quản lý hoàn toàn, cung cấp những gì tốt nhất của NVIDIA AI trên đám mây và có phần mềm cấp doanh nghiệp và các cụm liền kề, quy mô lớn trên các nhà cung cấp đám mây hàng đầu, cung cấp các tài nguyên tính toán có thể mở rộng lý tưởng cho ngay cả những tải xử lý đào tạo AI khắt khe nhất.

DGX Cloud cũng bao gồm một nền tảng suy luận không cần máy chủ (serverless) có khả năng mở rộng và năng động, mang lại thông lượng cao cho các AI token trên các môi trường đám mây hỗn hợp và đa đám mây, giúp giảm đáng kể độ phức tạp của hạ tầng và chi phí vận hành.

Bằng cách cung cấp nền tảng đầy đủ tích hợp phần cứng, phần mềm, đối tác hệ sinh thái và kiến trúc tham chiếu, NVIDIA đang giúp các doanh nghiệp xây dựng các nhà máy AI tiết kiệm chi phí, có khả năng mở rộng và hiệu suất cao — trang bị cho họ khả năng đáp ứng cuộc cách mạng công nghiệp tiếp theo.

Nguồn NVIDIA

Bài viết liên quan

- NVIDIA NGC‑ready Low‑latency Edge AI: Giải pháp cho Retail, Manufacturing và Smart Cities

- So sánh sức mạnh của máy tính AI DGX Spark với các card GPU máy trạm chuyên nghiệp của NVIDIA

- Từ Orin đến Thor: Bước nhảy vọt kiến trúc của NVIDIA JetPack 7.0 và tương lai của robot hình người

- Tại sao gọi NVIDIA DGX Spark là Siêu máy tính AI cá nhân?

- Cơ chế quản lý bộ nhớ trên các nền tảng phần cứng nhất quán – Hardware-coherent

- Kiến trúc NVIDIA Blackwell với GB200 NVL72: Định nghĩa lại điện toán AI cấp độ Exascale