Với 400.000 USD, bạn có thể nhận được khoảng 400 chiếc iPhone X, 300 chiếc laptop Surface Pro hoặc 11 chiếc ô tô điện Tesla Series 3. Nhưng bạn phải mất tối thiểu 400.000 USD đó (tương đương với 9,2 tỷ VNĐ) để chỉ có được một chiếc máy chủ AI Nvidia DGX-2, được coi là “hệ thống AI mạnh nhất thế giới cho những thách thức về AI phức tạp nhất”.

Nhưng DGX-2 có đáp ứng được yêu cầu đó không – và có máy chủ nào thực sự đáng giá như vậy không?

Tiếp tục với DGX

Để trả lời những câu hỏi đó, trước tiên bạn phải hiểu rằng DGX-2 không phải là máy chủ Nvidia đầu tiên được nhắm mục tiêu vào AI. Vinh dự đó thuộc về DGX-1, dựa trên sự kết hợp của bộ xử lý Intel Xeon và GPU kiến trúc Tesla V100 Volta, được tối ưu hóa cho AI của Nvidia. DGX-2 tiếp tục cách tiếp cận đó, nhưng thay vì tám bộ Tesla V100 được kết nối bằng bus dữ liệu NVLink của Nvidia, DGX-2 đi kèm với 16 GPU mạnh mẽ này được kết nối bằng công nghệ NVswitch có khả năng mở rộng tốt hơn. Theo Nvidia, thiết lập này cho phép DGX-2 xử lý deep learning (học sâu) và các workload AI hay HPC đòi hỏi nhanh hơn gấp 10 lần so với người anh em nhỏ hơn của nó.

Mặc dù nó được công bố cùng lúc với DGX-1, nhưng phải mất thêm hơn sáu tháng sau đó để có thể ra mắt. Một trong những nơi đầu tiên ở Vương quốc Anh đã được cài đặt nó là trong phòng thí nghiệm của một đối tác của Nvidia, Boston Limited. Họ hỏi chúng tôi có muốn xem qua nó: chúng tôi đã làm một chuyến, và đây là những gì chúng tôi quan sát được.

“Đập hộp” DGX-2

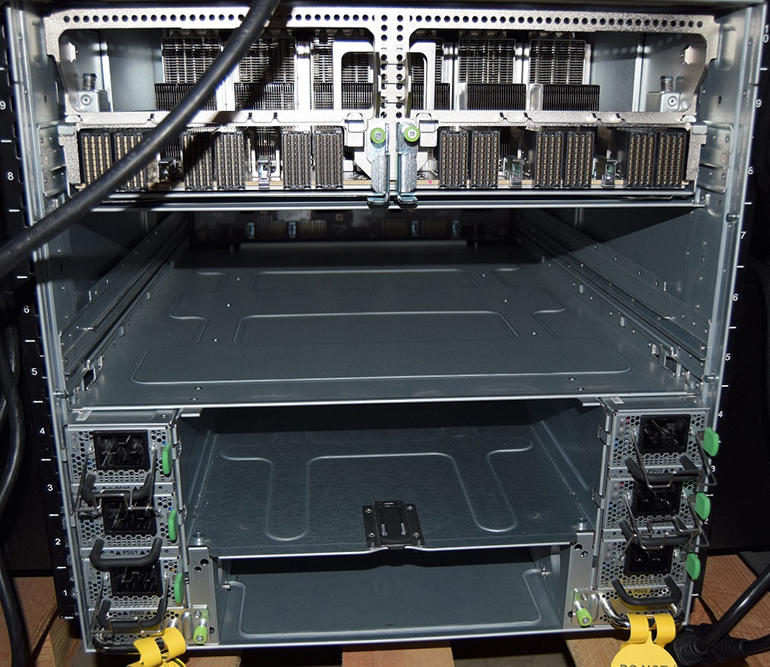

Cũng như hiệu suất, kích thước là một điểm khác biệt lớn với DGX-2, có viền vàng hoàn thiện giống như DGX-1 nhưng lớn hơn rất nhiều, nặng đến 154,2kg so với 60,8kg của DGX-1 và chiếm đến 10U không gian rack, thay vì chỉ 3 ở DGX-1.

Việc phân phối nguồn do một bộ sáu Power Supply Unit (PSU) với tính năng hot-swap và redundant, cắm vào phía sau chassis cùng với các module khác nhau tạo nên phần còn lại của hệ thống. Việc làm mát được đảm nhiệm bởi một dãy 10 quạt tản nhiệt nằm phía sau tấm panel mặt trước, có không gian ở hai bên cho 16 ổ cứng lưu trữ 2,5 inch, tám slot mỗi bên.

Nvidia đã cho lắp tám ổ cứng NVMe Micron 9200 Pro 3,84TB trong cấu hình chuẩn, tương đương với hơn 30TB dung lượng lưu trữ hiệu năng cao. Tuy vậy, cấu hình này chủ yếu là để xử lý dữ liệu cục bộ, với các bộ lưu trữ bổ sung trên bo mạch chủ chính cho hệ điều hành và ứng dụng. Nó cũng chừa lại tám bay trống để thêm dung lượng nếu cần. Ngoài ra, DGX-2 được trang bị các network interface băng thông cao để kết nối với nhiều không gian lưu trữ hơn và xây dựng các cụm máy chủ khi cần.

Phần của Intel

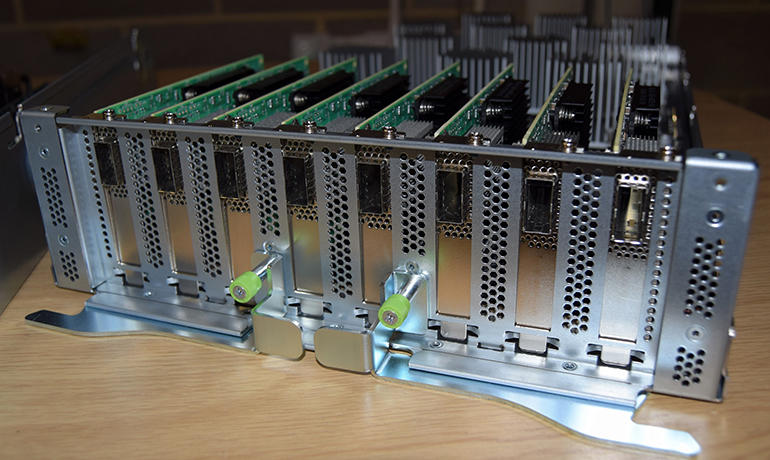

Bất kể thông số kỹ thuật như thế nào, bộ xử lý Xeon nằm ở giữa bo mạch chủ được bao quanh bởi 24 khe DIMM đã được lắp đầy, mang đến cho người mua một bộ RAM DDR4 lên đến 1,5TB để vận hành. Bên cạnh đó là một cặp ổ cứng NVMe stick 960GB được cấu hình RAID 1 để khởi động HĐH (Ubuntu Linux), cung cấp không gian cho software stack của DGX và các ứng dụng khác.

Network và USB controller thông thường cũng được tích hợp sẵn, với hai cổng Gigabit RJ-45 ở phía sau – một cho remote management và một cho kết nối chung. Một trong hai khe cắm mở rộng PCIe có sẵn cũng được trang bị bộ chuyển đổi Mellanox ConnectX-5 dual-port có thể lắp các bộ thu phát Ethernet lên đến 100GbE để mở rộng thêm băng thông mạng.

Phần của Nvidia

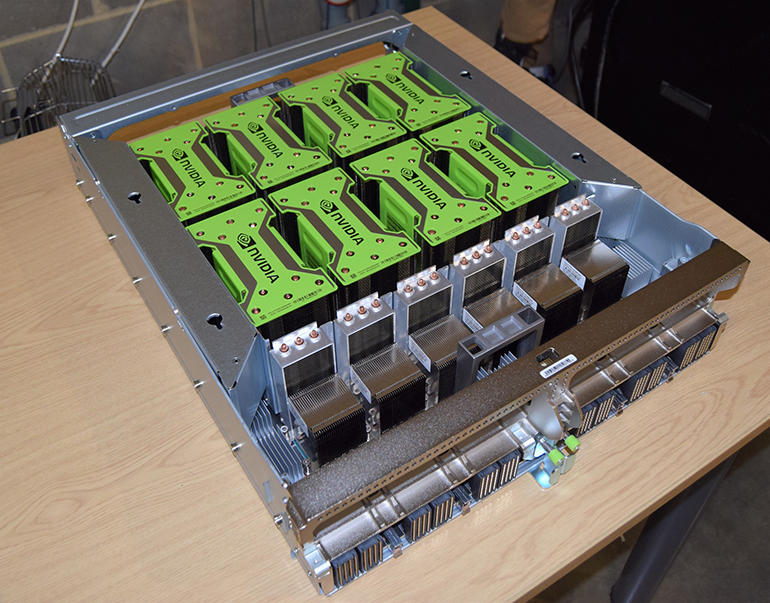

Và bây giờ phần mà có lẽ bạn đang chờ đợi nhất – 16 GPU Nvidia Tesla V100, vì các tản nhiệt lớn (xem bên dưới), mà chúng phải được chia thành hai bảng nền.

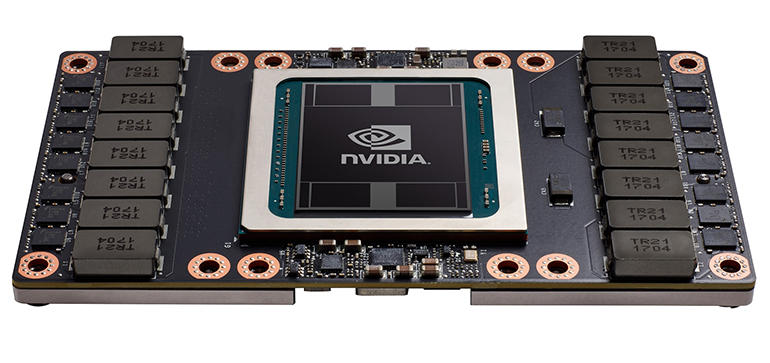

Để tiện hình dung, dưới đây là hình ảnh của module Tesla Volta 100:

Bản thân các GPU Tesla V100 có nhiều module SXM giống như trong hệ thống DGX-1 mới nhất. Mỗi chiếc được trang bị bộ nhớ HBM2 32GB cho mỗi GPU, do đó, với 16 GPU được lắp đặt, bộ nhớ GPU tăng lên gấp đôi – 512GB.

Mỗi GPU cũng có 5.120 lõi xử lý CUDA core cũng như 640 Tensor core được tối ưu hóa và chuyên dụng cho AI hơn. Nhân với 16, chúng cung cấp tổng cộng 10.240 Tensor core và 81.920 CUDA core tương ứng. Tất cả tạo ra rất nhiều sức mạnh xử lý, được tăng cường hơn nữa bởi băng thông kết nối lên đến 2,4TB/s tạo ra từ công nghệ NVSwitch với khả năng mở rộng hơn nữa trong tương lai.

Vấn đề hiệu năng

Phần cứng đã được đề cập đến nhiều. Ngoài ra, bạn cũng phải cần đến các bộ công cụ AI được cài đặt sẵn để tăng sức mạnh và sẵn sàng làm việc.

Khi xem xét đến một máy chủ, ở lúc này chúng ta thường sẽ bắt đầu nói về hiệu năng và kết quả của các bài kiểm tra mà chúng ta thường sẽ chạy để xem cách thức chúng xử lý. Tuy nhiên, việc chạy benchmark trên DGX-2 là một nhiệm vụ không hề dễ dàng, với mô hình deep learning và các workload HPC nói chung khác có liên quan, sẽ yêu cầu các phiên làm việc dài ngày. Vì vậy, thay vào đó, chúng tôi sẽ phải dựa vào các công bố của Nvidia, cùng với phản hồi từ các chuyên gia tại Boston.

Cuối cùng thì con số nổi bật cho DGX-2 là sức mạnh xử lý 2 petaFLOPS (PFLOPS) ấn tượng được cung cấp chủ yếu bởi các Tensor core để xử lý các workload đào tạo AI hỗn hợp. Con số này tăng lên 2.1 PFLOPS trên DGX-2H sử dụng các module Tesla V100 450W nhanh hơn.

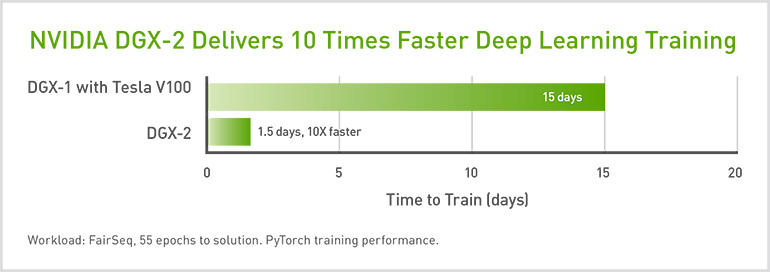

Để hình dung, sức mạnh xử lý này đã cho phép DGX-2 hoàn thành chỉ số benchmark FairSeq PyTorch chỉ trong 1,5 ngày – nhanh hơn 10 lần so với 15 ngày cần thiết cho thử nghiệm tương tự trên DGX-1 chỉ sáu tháng trước đó. Hơn nữa, Nvidia cho rằng để có được kết quả tương tự bằng công nghệ x86 sẽ cần 300 máy chủ Xeon dual-socket, chiếm 15 rack unit và tiêu tốn khoảng 2,7 triệu USD.

Tất cả điều đó làm cho DGX-2 có vẻ như một món hời ở mức giá khoảng 400.000 USD, ngay cả khi bạn phải trả thêm các chi phí hỗ trợ. Mặc dù có mức giá cao ngất ngưỡng, các công ty đã đầu tư vào AI sẽ thấy điều này là rất hợp lý so với các giải pháp thay thế, bao gồm việc thuê thời gian xử lý trong các trung tâm dữ liệu hoặc đám mây chia sẻ. Nvidia cũng muốn nhấn mạnh rằng DGX-2 cũng có thể được sử dụng để xử lý các HPC workload hiệu quả hơn, bên cạnh nhiệm vụ AI của mình.

Cũng cần nhớ rằng, mặc dù DGX-1 và DGX-2 đang có những bước tiến mới, các lựa chọn thay thế đang dần lộ diện từ các nhà cung cấp khác. Với Supermicro, trên trang web của họ đã liệt kê một máy chủ dựa trên cùng model tham chiếu Nvidia HGX-2 như DGX-2. Những hãng khác, chẳng hạn như Lenovo, cũng không tụt lại phía sau và những lựa chọn thay thế này chắc chắn sẽ có tác dụng làm giảm giá bán. Chúng tôi sẽ tiếp tục theo dõi những bước tiến triển này trong suốt năm 2019.

Bài viết liên quan

- NVIDIA NGC‑ready Low‑latency Edge AI: Giải pháp cho Retail, Manufacturing và Smart Cities

- So sánh sức mạnh của máy tính AI DGX Spark với các card GPU máy trạm chuyên nghiệp của NVIDIA

- Từ Orin đến Thor: Bước nhảy vọt kiến trúc của NVIDIA JetPack 7.0 và tương lai của robot hình người

- Tại sao gọi NVIDIA DGX Spark là Siêu máy tính AI cá nhân?

- Cơ chế quản lý bộ nhớ trên các nền tảng phần cứng nhất quán – Hardware-coherent

- Kiến trúc NVIDIA Blackwell với GB200 NVL72: Định nghĩa lại điện toán AI cấp độ Exascale