Cộng đồng Machine Learning, đặc biệt trong lĩnh vực thị giác máy tính và xử lý ngôn ngữ, đang gặp vấn đề về văn hóa trong việc sử dụng dữ liệu. Đó là theo một cuộc khảo sát nghiên cứu về thực tiễn thu thập và sử dụng tập dữ liệu của cộng đồng được công bố vào đầu tháng này.

Điều cần thiết là cần có một thay đổi khỏi sự phụ thuộc vào các bộ dữ liệu lớn, được quản lý kém, sử dụng để đào tạo các mô hình Machine Learning. Thay vào đó, nghiên cứu đề xuất một nền văn hóa quan tâm đến những cá nhân hiện diện bên trong bộ dữ liệu và tôn trọng quyền riêng tư cũng như tài sản của họ. Nhưng trong môi trường Machine Learning ngày nay, các tác giả khảo sát cho biết, “bất cứ điều gì cũng có thể xảy ra”.

Trong bài báo “Dữ liệu và nội dung của nó: Một cuộc khảo sát về việc phát triển và sử dụng tập dữ liệu trong Machine Learning” được viết bởi các nhà ngôn ngữ học Amandalynne Paullada và Emily Bender của Đại học Washington, Inioluwa Deborah Raji, đồng sáng lập của của Mozilla Foundation, và các nhà khoa học nghiên cứu của Google là Emily Denton và Alex Hanna. Bài báo kết luận rằng các mô hình ngôn ngữ lớn có khả năng duy trì các định kiến và thành kiến đối với một loạt các cộng đồng bị thiệt thòi và rằng các bộ dữ liệu được chú thích kém là một phần của vấn đề.

Công việc cũng yêu cầu các thực hành quản lý dữ liệu và tài liệu nghiêm ngặt hơn. Các tập dữ liệu được thực hiện theo cách này chắc chắn sẽ đòi hỏi nhiều thời gian, tiền bạc và nỗ lực hơn nhưng sẽ “khuyến khích việc nghiên cứu các phương pháp tiếp cận Machine Learning vượt ra ngoài mô hình hiện tại của các kỹ thuật theo quy mô thần tượng hóa”.

“Chúng tôi lập luận rằng các bản sửa lỗi tập trung giới hạn vào việc cải thiện tập dữ liệu bằng cách làm cho chúng đại diện hơn hoặc thách thức hơn, có thể mất đi các điểm chung mà những đánh giá này nêu ra và chúng ta sẽ bị mắc kẹt trong trò chơi tập dữ liệu thay vì tiến bộ, miễn là khái niệm về ‘tiến độ’ được xác định phần lớn bởi hiệu suất trên bộ dữ liệu, “bài báo viết. “Nếu điều này xảy ra, chúng tôi dự đoán rằng Machine Learning như một lĩnh vực sẽ được định vị tốt hơn để hiểu cách công nghệ của nó tác động đến con người và thiết kế các giải pháp hoạt động với độ trung thực và công bằng trong bối cảnh triển khai của họ.”

Các sự kiện trong năm qua đã làm sáng tỏ những thiếu sót của cộng đồng Machine Learning và thường gây hại cho những người thuộc các cộng đồng bị thiệt thòi. Sau khi Google sa thải Timnit Gebru, một sự cố mà nhân viên Google gọi là một trường hợp “kiểm duyệt nghiên cứu chưa từng có”, Reuters đưa tin hôm thứ Tư rằng công ty đã bắt đầu thực hiện đánh giá các bài nghiên cứu về “chủ đề nhạy cảm” và ít nhất ba lần, các tác giả Theo truyền thông nội bộ và những người quen thuộc với vấn đề này, đã được yêu cầu không đặt công nghệ của Google dưới góc độ tiêu cực . Chưa có hồ sơ Washington Post của Gebru tuần này tiết lộ rằng Giám đốc AI của Google, Jeff Dean đã yêu cầu cô điều tra tác động tiêu cực của các mô hình ngôn ngữ lớn vào mùa thu năm nay.

Trong các cuộc trò chuyện về GPT-3, đồng tác giả Emily Bender trước đó đã cho hay rằng cô muốn thấy cộng đồng NLP ưu tiên cho một ngành khoa học tốt đẹp hơn. Bender là đồng tác giả của một bài báo với Gebru đã được đưa ra công chúng vào đầu tháng này sau khi Google sa thải Gebru. Bài báo đó đã xem xét việc sử dụng các mô hình ngôn ngữ lớn có thể tác động đến các cộng đồng bị thiệt thòi như thế nào. Tuần trước, các nhà tổ chức hội nghị Công bằng, Trách nhiệm và Minh bạch (FAccT) đã chấp nhận bài báo để xuất bản.

Cũng trong tuần trước, Hanna đã tham gia cùng các đồng nghiệp trong nhóm Đạo đức AI tại Google và gửi một thông báo tới ban lãnh đạo Google yêu cầu khôi phục Gebru. Cùng ngày, các thành viên của Quốc hội quen thuộc với thiên vị thuật toán đã gửi một lá thư đến Giám đốc điều hành Google Sundar Pichai yêu cầu câu trả lời.

Quyết định của công ty trong việc kiểm duyệt các nhà nghiên cứu AI và sa thải Gebru có thể mang hàm ý chính sách. Hiện tại, Google, MIT và Stanford là một số nhà sản xuất tích cực hoặc có ảnh hưởng nhất đối với nghiên cứu AI được công bố tại các hội nghị học thuật lớn hàng năm. Các thành viên của Quốc hội đã đề xuất quy định để bảo vệ chống lại sự thiên vị thuật toán, trong khi các chuyên gia kêu gọi tăng thuế đối với Big Tech, một phần để tài trợ cho nghiên cứu độc lập. VentureBeat gần đây đã nói chuyện với sáu chuyên gia về AI, đạo đức và luật pháp về những cách mà cuộc khủng hoảng đạo đức AI của Google có thể ảnh hưởng đến chính sách.

Đầu tháng này, “Dữ liệu và các nội dung của nó” đã nhận được giải thưởng từ các nhà tổ chức của hội thảo ML Retrospectives, Surveys and Meta-analyzes tại NeurIPS, một hội nghị nghiên cứu về AI thu hút 22.000 người tham dự. Gần 2.000 bài báo đã được xuất bản tại NeurIPS năm nay, bao gồm các công việc liên quan đến phát hiện lỗi cho các hệ thống quan trọng về an toàn ; phương pháp nhân giống ngược nhanh hơn, hiệu quả hơn ; và sự khởi đầu của một dự án coi biến đổi khí hậu như một thách thức lớn của Machine Learning .

Một bài báo khác của Hanna, được trình bày tại hội thảo Resistance AI, kêu gọi cộng đồng Machine Learning vượt ra ngoài quy mô khi xem xét cách giải quyết các vấn đề xã hội có hệ thống và khẳng định rằng cần phải chống lại tư duy quy mô. Hanna đã nói chuyện với VentureBeat vào đầu năm nay về việc sử dụng lý thuyết chủng tộc quan trọng khi xem xét các vấn đề liên quan đến chủng tộc, danh tính và sự công bằng .

Trong xử lý ngôn ngữ tự nhiên trong những năm gần đây, các mạng được thực hiện bằng cách sử dụng kiến trúc mạng thần kinh Transformer và kho dữ liệu ngày càng lớn đã đạt được các điểm hiệu suất (benchmark) cao trong các điểm chuẩn như GLUE. BERT của Google và các dẫn xuất của BERT dẫn đầu, theo sau là các mạng như MT-DNN của Microsoft , Megatron của Nvidia và GPT-3 của OpenAI . Được giới thiệu vào tháng 5, GPT-3 là mô hình ngôn ngữ lớn nhất cho đến nay. Một bài báo về hiệu suất của mô hình đã giành được một trong ba giải thưởng giấy tốt nhất được trao cho các nhà nghiên cứu tại NeurIPS năm nay.

Quy mô của các bộ dữ liệu khổng lồ khiến cho việc xem xét kỹ lưỡng nội dung của chúng trở nên khó khăn. Điều này dẫn đến các ví dụ lặp đi lặp lại về sự thiên vị thuật toán trả lại các kết quả thiên vị khiêu dâm về người Hồi giáo, những người kỳ lạ hoặc không phù hợp với bản dạng giới mong đợi, những người khuyết tật, phụ nữ và người Da đen, trong số các nhân khẩu học khác.

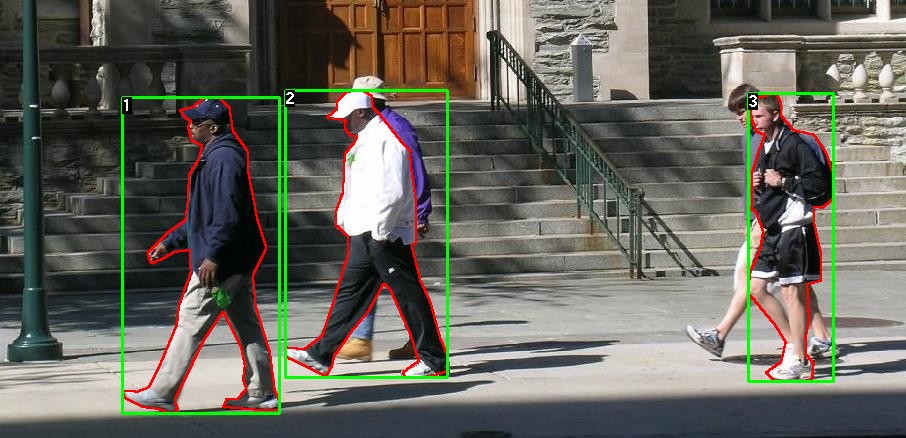

Sự nguy hiểm của các bộ dữ liệu lớn cũng được chứng minh trong lĩnh vực thị giác máy tính, bằng chứng là các nhà nghiên cứu của Đại học Stanford thông báo vào tháng 12 năm 2019 rằng họ sẽ xóa các nhãn và hình ảnh xúc phạm khỏi ImageNet. Mô hình StyleGAN, do Nvidia phát triển, cũng cho kết quả sai lệch sau khi đào tạo trên một tập dữ liệu hình ảnh lớn. Và sau khi phát hiện ra các hình ảnh và nhãn phân biệt giới tính và phân biệt chủng tộc, những người tạo ra 80 triệu Hình ảnh nhỏ đã xin lỗi và yêu cầu các kỹ sư xóa và không sử dụng tài liệu này nữa.

Bài viết liên quan

- Phân tích video thông minh – Intelligent Video Analytics: Tương lai của mọi ngành

- Tổng quan về Computer Vision – Thị giác máy tính

- Hệ sinh thái NVIDIA Metropolis mở rộng với các công cụ phát triển tiên tiến để tăng tốc Vision AI

- AI on the Football: Ứng dụng Computer Vision để phân tích dữ liệu của cầu thủ

- Computer Vision: Một sự dịch chuyển sắp diễn ra?

- Computer Vision – Thị giác máy tính là gì?