Hơn bao giờ hết, câu hỏi cụ thể nhất mà một tổ chức CNTT phải trả lời về mọi workload của trung tâm dữ liệu mới đó là chạy nó ở đâu? Các workload mới nhất trong doanh nghiệp hiện nay là các biến thể của machine learning, hoặc AI, hoặc đó có thể là mô hình đào tạo (training) deep learning hoặc suy luận (inference), và đã có rất nhiều lựa chọn cho cơ sở hạ tầng AI mà việc tìm ra lựa chọn tốt nhất là không hề dễ dàng gì đối với một doanh nghiệp.

Có nhiều tùy chọn phần cứng AI trên thị trường, một loạt các dịch vụ đám mây AI đang phát triển nhanh chóng và nhiều tùy chọn trung tâm dữ liệu khác nhau để lưu trữ phần cứng AI. Một công ty với dày đặc các thành phần trong toàn bộ hệ sinh thái cơ sở hạ tầng machine learning này là Nvidia, công ty không chỉ sản xuất và bán phần lớn các bộ xử lý cho AI workload trên thế giới (Nvidia GPU), mà còn xây dựng rất nhiều phần mềm chạy trên các hệ thống đó, ngoài ra họ còn sản xuất và cung cấp siêu máy tính AI của riêng mình và gần đây hơn, các nhà cung cấp trung tâm dữ liệu bảo vệ trước để giúp khách hàng tìm thấy những máy tính có khả năng lưu trữ máy AI của họ.

Gần đây chúng tôi đã có dịp nói chuyện với Charlie Boyle, giám đốc tiếp thị cho dòng sản phẩm siêu máy tính DGX AI của Nvidia, để nói về những xu hướng mới nhất trong phần cứng AI và thế giới cơ sở hạ tầng AI rộng lớn hơn. Dưới đây là cuộc phỏng vấn của chúng tôi, đã được biên tập cho rõ ràng và ngắn gọn:

DCK: Làm thế nào để các công ty quyết định có nên sử dụng dịch vụ đám mây cho khối lượng công việc học máy của họ hoặc mua phần cứng AI của riêng họ không?

Và đó là bởi vì thật khó để di chuyển nhiều dữ liệu vào và ra khỏi đám mây?

Đó là, nhưng nó cũng phụ thuộc vào cách bạn tạo dữ liệu của mình. Hầu hết dữ liệu của khách hàng khá năng động, vì vậy họ luôn thêm vào dữ liệu đó và vì vậy, nếu họ thu thập tất cả dữ liệu đó tại cơ sở trong hệ thống, thì việc tiếp tục xử lý dữ liệu tại cơ sở sẽ dễ dàng hơn. Nếu họ tổng hợp nhiều dữ liệu vào các dịch vụ đám mây, thì họ sẽ xử lý nó trong các dịch vụ đám mây.

Và đó thực sự là cho các trường hợp sử dụng sản xuất. Rất nhiều trường hợp sử dụng thử nghiệm có thể bắt đầu trong đám mây – bạn chỉ cần kích hoạt trình duyệt và bạn có quyền truy cập vào cơ sở hạ tầng AI – nhưng khi họ chuyển sang sản xuất, khách hàng đưa ra quyết định địa phương, quyết định tài chính, quyết định bảo mật, liệu có tốt hơn không họ để xử lý nó tại cơ sở hoặc trên đám mây.

Khách hàng của Nvidia thường thực hiện một số khóa đào tạo mô hình AI tại cơ sở, bởi vì đó là nơi chứa dữ liệu lịch sử của họ. Họ xây dựng một mô hình tuyệt vời, nhưng mô hình đó sau đó được phục vụ bởi các dịch vụ trực tuyến của họ – suy luận tăng tốc họ làm trong đám mây dựa trên mô hình mà họ xây dựng tại chỗ.

Đối với những người chạy khối lượng công việc AI trên phần cứng của chính họ tại cơ sở hoặc trong các trung tâm dữ liệu colocation, bạn đã thấy cách tiếp cận làm mát nào, với những hộp này có độ dày như thế nào?

Việc làm mát bằng chất lỏng so với không khí so với hỗn hợp luôn là một cuộc tranh luận tích cực, một vấn đề mà chúng tôi luôn nghiên cứu. Nói chung, nơi chúng ta ngày nay – mọi người đang vận hành rất nhiều hệ thống, có thể lên tới 50 hoặc hơn – chỉ cần làm mát không khí thông thường hoạt động tốt. Khi chúng ta bắt đầu đi vào các giá đỡ mật độ cao hơn, bạn sẽ biết các giá đỡ 30, 40, 50 kilowatt, chúng ta thường nhìn thấy các bộ trao đổi nhiệt làm mát bằng nước phía sau, đặc biệt là cửa sau hoạt động. Và đó là những gì chúng tôi thực hiện trong các trung tâm dữ liệu mới nhất của mình, bởi vì theo cách đó, bạn không thay đổi hệ thống ống nước trên chính hệ thống vật lý.

Nhưng chúng tôi đang ở cùng với hầu hết các nhà cung cấp dịch vụ colocation – và thậm chí hầu hết các trung tâm dữ liệu hiện đại mà mọi người đang xây dựng trong năm nay và có thể trong năm tới – đó là nước lạnh hoặc nhiệt độ nước xung quanh chỉ ở mức giá đỡ để hỗ trợ cửa sau.

Direct-to-chip là vấn đề của ngành và hoạt động. Công nghệ là có, chúng ta có thể làm điều đó ngày hôm nay, nhưng sau đó bạn làm thế nào để phục vụ nó? Đó sẽ là một đường cong học tập cho những người hoạt động bình thường của bạn.

Các hệ thống DGX và phần cứng AI hỗ trợ GPU khác của bạn sẽ dày đặc đến mức bạn sẽ không thể làm mát chúng bằng không khí, theo thời gian?

Tất cả các hệ thống tôi đang tìm kiếm trong tương lai gần có thể là làm mát bằng không khí, cửa nhiệt phía sau nước hoặc không khí trong giá đỡ. Chủ yếu là vì đó là nơi tôi thấy hầu hết các khách hàng doanh nghiệp đang ở. Không có gì vốn có trong những gì chúng ta cần làm trong mật độ nói rằng chúng ta không thể làm không khí hoặc hỗn hợp trong tương lai gần, chủ yếu là vì hầu hết mọi người sẽ bị giới hạn bởi bao nhiêu sức mạnh vật lý mà họ có thể đặt vào một giá đỡ.

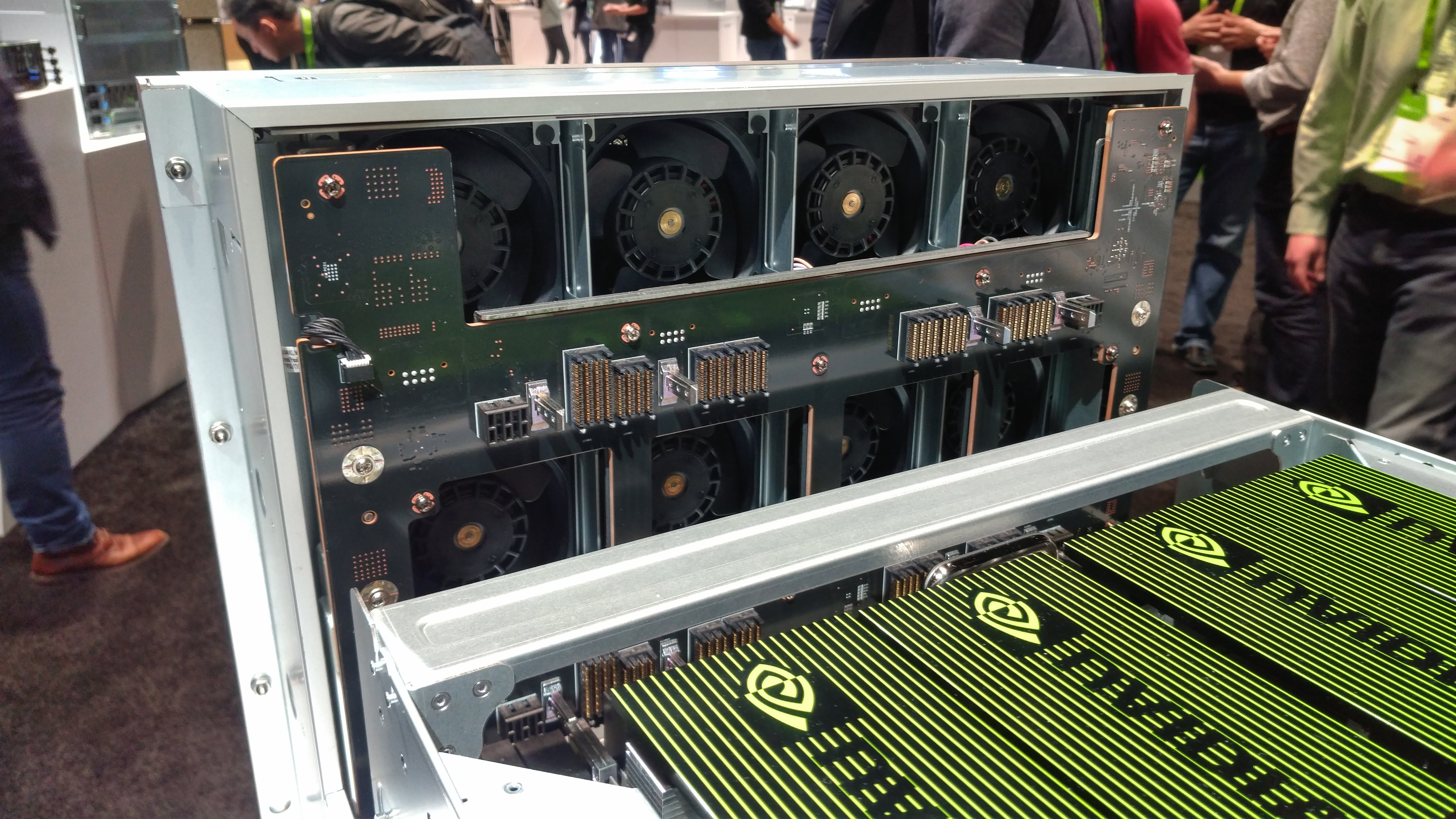

Quạt làm mát của hệ thống Nvidia DGX-2 được trưng bày tại GTC 2018

Quạt làm mát của hệ thống Nvidia DGX-2 được trưng bày tại GTC 2018

Ngay bây giờ, chúng tôi đang chạy các giá đỡ 30-40kW. Bạn có thể chạy các giá 100kW, giá 200kW, nhưng không ai có mật độ đó ngày hôm nay. Chúng tôi có thể đến điểm mà bạn cần làm mát nước? Có thể, nhưng đó thực sự là về lựa chọn hiệu quả nhất cho mỗi khách hàng. Chúng tôi thấy khách hàng thực hiện các phương pháp lai, nơi họ đang thu hồi nhiệt thải và những thứ khác như thế. Chúng tôi tiếp tục xem xét điều đó, tiếp tục làm việc với những người đang xây dựng mọi thứ trong những không gian đó để xem nó có hợp lý không.

Sản phẩm máy trạm của chúng tôi, trạm DGX, được làm mát bằng nước, vì vậy một trong những sản phẩm của chúng tôi đã được làm mát bằng nước khép kín. Nhưng từ phía máy chủ, cơ sở hạ tầng trung tâm dữ liệu đó, hầu hết mọi người chưa có.

Hầu hết các trung tâm dữ liệu doanh nghiệp không có khả năng làm mát ngay cả giá đỡ 30kW và 40kW. Đó có phải là rào cản cho doanh số DGX?

Nó thực sự không có. Đó là một điểm trò chuyện, nhưng đó cũng là lý do tại sao chúng tôi đã công bố giai đoạn thứ hai của chương trình sẵn sàng DGX . Nếu bạn chỉ nói về việc đưa một vài hệ thống vào, bất kỳ trung tâm dữ liệu nào cũng có thể hỗ trợ một vài hệ thống, nhưng khi bạn truy cập vào hệ thống 50-100, thì bạn đang xem xét việc thiết kế lại trung tâm dữ liệu hoặc đến nhà cung cấp colo đã có nó

Đó là lý do tại sao chúng tôi thực sự cố gắng loại bỏ những lực cản ra khỏi hệ thống, hợp tác với các nhà cung cấp colo này, để nhóm trung tâm dữ liệu của chúng tôi thực hiện trách nhiệm với họ, để họ có mật độ, họ đã có hệ thống làm mát nước ở cửa sau cần thiết, để khách hàng có thể nhấc điện thoại lên và nói rằng, tôi cần chỗ cho 50 DGX-2 và nhà cung cấp trung tâm dữ liệu đã có dữ liệu đó, đặt nó vào máy tính của họ và nói, OK, chúng tôi có thể có nó cho bạn tuần tới.

Vì vậy, đã có những cản trở nhất định?

Khi chúng tôi tung ra các sản phẩm này ba năm trước, khi mọi người mua một vài hệ thống cùng một lúc, họ đã đặt câu hỏi về việc thực hiện quy mô này và một số khách hàng của chúng tôi đã chọn xây dựng cơ sở hạ tầng mới, trong khi những người khác tìm đến chúng tôi để đề xuất một nhà cung cấp colocation gần chất lượng tốt. Chúng tôi đã xây dựng chương trình trung tâm dữ liệu DGX-Ready để khách hàng không phải chờ đợi.

Ngay cả đối với những khách hàng có cơ sở trung tâm dữ liệu tuyệt vời, nhiều lần phía doanh nghiệp sẽ gọi cho trung tâm dữ liệu và nói, ồ, tôi cần bốn giá đỡ 30kW. Nhóm trung tâm dữ liệu sẽ nói, thật tuyệt, chúng tôi có thể làm điều đó, nhưng đó là sáu tháng; cách khác, chúng tôi có thể đến một trong những đối tác colo của chúng tôi và họ có thể lấy nó vào tuần tới.

Bạn có thấy khách hàng chọn colo ngay cả khi họ có sẵn không gian trung tâm dữ liệu của mình không?

Vì AI nói chung là một khối lượng công việc mới cho hầu hết khách hàng, nên họ không cố gắng phù hợp với cơ sở hạ tầng hiện có. Họ đang mua tất cả cơ sở hạ tầng mới cho AI, vì vậy đối với họ, điều đó thực sự không quan trọng nếu đó là trong trung tâm dữ liệu của họ hoặc trong nhà cung cấp dịch vụ colocation gần với họ – miễn là hiệu quả về chi phí và họ có thể hoàn thành công việc nhanh chóng. Và đó thực sự là một phần lớn trong hầu hết các dự án AI của mọi người: họ muốn thể hiện thành công rất nhanh.

Ngay cả tại Nvidia, chúng tôi sử dụng nhiều nhà cung cấp trung tâm dữ liệu ngay gần văn phòng của chúng tôi (DCK: ở Santa Clara, California), vì chúng tôi có không gian văn phòng, nhưng chúng tôi không có không gian trung tâm dữ liệu. May mắn thay, ở Thung lũng Silicon, có những nhà cung cấp tuyệt vời xung quanh chúng ta.

Nvidia đang tiếp thị DGX như một siêu máy tính cho AI. Kiến trúc của nó có khác với siêu máy tính cho khối lượng công việc HPC truyền thống không?

Khoảng năm năm trước, mọi người đã thấy một sự khác biệt rất khác biệt giữa HPC và hệ thống AI, nhưng nếu bạn nhìn vào danh sách Top500 cuối cùng , rất nhiều khả năng đó đã được hợp nhất. Trước đây, mọi người đều nghĩ về siêu máy tính là 64 bit, độ chính xác gấp đôi, mã khoa học cho thời tiết, khí hậu và tất cả những thứ khác nhau. Và sau đó khối lượng công việc AI chủ yếu là độ chính xác hỗn hợp 32 bit hoặc 16 bit. Và hai loại ở lại trong hai trại khác nhau.

Những gì bạn thấy bây giờ là một siêu máy tính điển hình sẽ chạy một vấn đề trên rất nhiều nút và trong khối lượng công việc AI, mọi người đang làm điều tương tự. MLPerf(DCK: điểm chuẩn hiệu suất phần cứng AI) vừa được công bố, với số lượng lớn các nút thực hiện một công việc. Khối lượng công việc giữa AI và HPC thực sự rất giống nhau. Với các GPU mới nhất của chúng tôi, cùng một GPU có độ chính xác kép HPC truyền thống, độ chính xác AI 32 bit và độ chính xác hỗn hợp AI tăng tốc.

Và các trung tâm siêu máy tính truyền thống hiện đang làm AI. Họ có thể đã chế tạo một siêu máy tính cổ điển, nhưng tất cả họ đều đang chạy các tác vụ siêu máy tính cổ điển và AI trên cùng một hệ thống.

Kiến trúc giống nhau cho cả hai. Trước đây, siêu máy tính sử dụng mạng khác với AI truyền thống. Bây giờ tất cả đã hội tụ. Đó là một phần lý do tại sao chúng tôi mua Mellanox . Ngay bây giờ, xương sống của cơ sở hạ tầng siêu máy tính, InfiniBand, thực sự quan trọng đối với cả hai bên. Mọi người nghĩ về nó như là một thứ HPC bí truyền. Nhưng không, nó là chủ đạo; bây giờ nó là doanh nghiệp, là xương sống cho các hệ thống AI của họ.

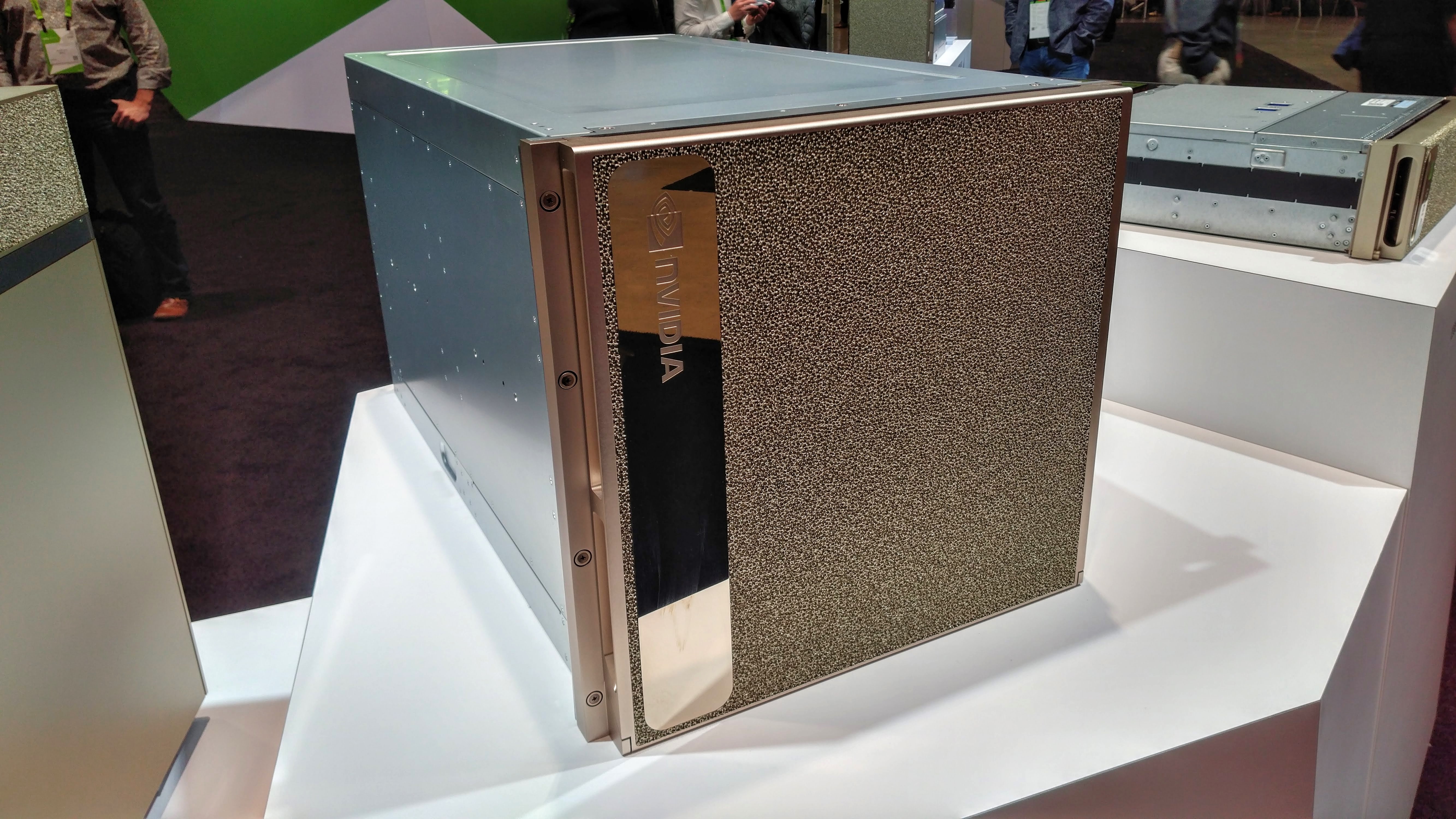

Yevgeniy Sverdlik Siêu máy tính DGX-2 của Nvidia được trưng bày tại GTC 2018

Siêu máy tính DGX-2 của Nvidia được trưng bày tại GTC 2018

Sự cạnh tranh từ tất cả các phần cứng AI thay thế (chẳng hạn như TPU, GPU, silicon tùy chỉnh khác được thiết kế bởi các nhà cung cấp đám mây và khởi nghiệp) có phải là mối quan tâm của Nvidia không?

Chúng tôi luôn theo dõi sự cạnh tranh, nhưng nếu bạn nhìn vào các đối thủ của mình, họ sẽ không so sánh với nhau. Họ điểm chuẩn chống lại chúng tôi. Một phần lý do khiến chúng tôi rất phát triển trong ngành là chúng tôi ở khắp mọi nơi. Trong cùng một đám mây Google, bạn đã có GPU Nvidia; trong cùng một đám mây Amazon, bạn đã có GPU Nvidia.

Nếu máy tính xách tay của bạn có GPU Nvidia, bạn có thể đào tạo về điều đó. GPU của chúng tôi chỉ chạy mọi thứ. Ngăn xếp phần mềm bạn có thể thực hiện đào tạo học sâu trên máy tính xách tay của mình là cùng ngăn xếp phần mềm chạy trên 22 siêu máy tính hàng đầu của chúng tôi.

Đó là một vấn đề lớn khi tất cả những người khởi nghiệp và những người khác nhau chọn một điểm chuẩn: Sốt Chúng tôi thực sự giỏi về ResNet 50. Nếu bạn chỉ làm ResNet 50, đó là một phần nhỏ trong khối lượng công việc AI tổng thể của bạn, do đó có tính linh hoạt của phần mềm và có khả năng lập trình là một tài sản lớn đối với chúng tôi. Và chúng tôi đã xây dựng một hệ sinh thái trong thập kỷ qua cho việc này.

Đó là thách thức lớn nhất tôi nghĩ đối với các công ty khởi nghiệp trong không gian này: bạn có thể xây dựng một con chip, nhưng việc hàng triệu nhà phát triển sử dụng chip của bạn khi nó không có sẵn trong máy tính xách tay của bạn và trong mọi đám mây là khó khăn. Khi bạn xem TPU (chip AI tùy chỉnh của Google), kết quả MLPerf mới nhất của chúng tôi, chúng tôi đã gửi trong mọi danh mục ngoại trừ một danh mục, trong đó TPU chỉ gửi trong một số khối lượng công việc mà họ cho rằng chúng tốt.

Thật tốt khi có sự cạnh tranh, nó giúp bạn trở nên tốt hơn, nhưng với công nghệ chúng ta có, hệ sinh thái mà chúng ta có, chúng ta đã có một lợi thế thực sự.

Kiến trúc HPC truyền thống hội tụ với AI có nghĩa là các nhà cung cấp HPC truyền thống hiện đang cạnh tranh với DGX. Điều đó có làm cho công việc của bạn khó khăn hơn?

Tôi hoàn toàn không coi chúng là đối thủ, bởi vì tất cả chúng đều sử dụng GPU Nvidia. Nếu chúng tôi bán một hệ thống cho khách hàng, hoặc HPE, Dell hoặc Cray bán một hệ thống cho khách hàng, miễn là khách hàng hài lòng, chúng tôi không có vấn đề gì.

Chúng tôi tạo ra cùng một phần mềm mà chúng tôi xây dựng để chạy trên vài nghìn hệ thống DGX của riêng chúng tôi có sẵn thông qua cơ sở hạ tầng NGC của chúng tôi (DCK: NGC là trung tâm phân phối trực tuyến của Nvidia cho phần mềm được tối ưu hóa GPU), vì vậy tất cả các khách hàng OEM của chúng tôi đều có thể gỡ bỏ những thứ đó các thùng chứa, sử dụng cùng một phần mềm, vì chúng tôi chỉ muốn mọi người có trải nghiệm tốt nhất về GPU.

Tôi không xem bất kỳ ai trong số họ là đối thủ cạnh tranh. Là chủ sở hữu dòng sản phẩm, tôi chia sẻ rất nhiều với các đối tác OEM của mình. Chúng tôi luôn xây dựng DGX trước vì chúng tôi cần chứng minh nó hoạt động. Và sau đó chúng tôi lấy những bài học kinh nghiệm đó và đưa chúng cho các đối tác của chúng tôi để rút ngắn chu kỳ phát triển của chúng.

Tôi sẽ có cuộc họp với bất kỳ OEM nào và nếu họ đang tìm cách xây dựng một hệ thống mới, tôi sẽ nói với họ OK, trong hai tháng qua tôi đã cố gắng xây dựng một hệ thống mới, đây là những gì tôi chạy vào và đây là cách bạn có thể tránh những vấn đề tương tự.

Có IP Nvidia duy nhất nào trong DGX không được chia sẻ với các OEM không?

IP duy nhất là cơ sở hạ tầng đáng kinh ngạc mà chúng tôi xây dựng bên trong Nvidia cho nghiên cứu và phát triển của riêng chúng tôi: tất cả các xe tự trị của chúng tôi, tất cả các nghiên cứu sâu của chúng tôi, tất cả đã được thực hiện trên một vài nghìn hệ thống DGX, vì vậy chúng tôi học hỏi từ tất cả những điều đó và vượt qua về những bài học cho khách hàng của chúng tôi. Công nghệ tương tự mà bạn có thể tìm thấy trong một hệ thống HPE, Dell hoặc Cray.

Một trong những điều phổ biến chúng tôi nghe được từ khách hàng là ‘Này Nvidia, tôi muốn sử dụng thứ bạn sử dụng.’ Chà, nếu bạn muốn sử dụng thứ mà chúng ta sử dụng hàng ngày, đó là hệ thống DGX. Nếu bạn là cửa hàng HPE và bạn thích sử dụng các hệ thống HPE vì cơ sở hạ tầng quản lý của họ, điều đó thật tuyệt. Họ đã xây dựng một chiếc hộp tuyệt vời và nhà cung cấp mà bạn giao dịch là HPE tại thời điểm đó, không phải Nvidia.

Nhưng từ góc độ bán hàng và thị trường, chúng tôi rất vui miễn là mọi người mua GPU.

Google gần đây đã công bố một thuật toán nén mới cho phép khối lượng công việc AI chạy trên điện thoại thông minh. Có một tương lai nơi cần ít GPU hơn trong trung tâm dữ liệu vì điện thoại có thể thực hiện tất cả các tính toán AI?

Thế giới luôn luôn cần nhiều máy tính hơn. Vâng, điện thoại sẽ trở nên tốt hơn, nhưng cơn khát điện toán của thế giới ngày càng lớn. Nếu chúng ta đặt nhiều máy tính vào điện thoại, điều đó có nghĩa là gì? Dịch vụ phong phú hơn trong trung tâm dữ liệu.

Nếu bạn đi du lịch nhiều, có lẽ bạn đã chạy vào một hệ thống trả lời bằng giọng nói của United hoặc American Airlines: nó sẽ tốt hơn rất nhiều trong vài năm qua, vì AI đang cải thiện phản hồi bằng giọng nói. Khi nó trở nên tốt hơn, bạn chỉ mong đợi nhiều dịch vụ hơn trên đó. Nhiều dịch vụ hơn có nghĩa là sức mạnh tính toán theo cấp số nhân. Định luật Moore đã chết vào thời điểm này, vì vậy tôi cần GPU để hoàn thành nhiệm vụ đó. Vì vậy, các tính năng tốt hơn bạn đặt trên điện thoại, kinh doanh tốt hơn cho chúng tôi. Và tôi nghĩ điều đó đúng với tất cả các dịch vụ tiêu dùng.

Bạn đã thấy các trường hợp sử dụng thuyết phục cho việc học máy ở rìa mạng di động chưa?

Tôi nghĩ rằng đó là trực tuyến. Chúng tôi đang tham gia với rất nhiều công ty viễn thông ở rìa và cho dù bạn nghĩ gì về phát trực tuyến trò chơi, cho dù bạn nghĩ về dịch vụ định vị cá nhân, công ty viễn thông luôn cố gắng đưa khách hàng đến gần hơn để họ không cần sự hỗ trợ càng nhiều Tôi đã từng làm việc cho các công ty viễn thông cách đây một thập kỷ hoặc lâu hơn, và khát khao chuyển đồ đạc ra rìa luôn luôn tồn tại. Bây giờ chúng ta mới thấy một số ứng dụng học máy sẽ chạy ở rìa. Khi 5G ra mắt, bạn sẽ chỉ thấy nhiều hơn những thứ đó.

Những loại khối lượng công việc máy học được thử nghiệm telcos hoặc triển khai ở rìa?

Đó là tất cả mọi thứ cho các dịch vụ dành riêng cho người dùng. Nếu bạn ở trong một khu vực, các ứng dụng trên điện thoại của bạn đã biết bạn đang ở trong khu vực đó và có thể cung cấp cho bạn các đề xuất tốt hơn hoặc xử lý tốt hơn. Và sau đó, khi mọi người bắt đầu tiêu thụ nội dung ngày càng phong phú, khi băng thông được cải thiện, việc xử lý sẽ chuyển sang cạnh xa hơn.

Trong khi các công ty viễn thông là những người đẩy tính toán ra rìa, thì họ cũng sẽ là những người cung cấp tất cả các dịch vụ phong phú mà bạn đang đề cập đến?

Đôi khi họ đang xây dựng dịch vụ, đôi khi họ mua dịch vụ. Đó là một sự pha trộn và tôi nghĩ đó là sự bùng nổ của các ứng dụng AI và ML ngày nay. Bạn đã có hàng tấn công ty khởi nghiệp xây dựng các dịch vụ cụ thể mà công ty viễn thông đang tiêu thụ vào thời điểm này. Họ đang đưa ra những ý tưởng tuyệt vời và mạng lưới phân phối telco là nơi lý tưởng để đưa các loại dịch vụ đó. Rất nhiều trong số các dịch vụ đó cần rất nhiều sức mạnh tính toán, vì vậy các GPU ở rìa tôi nghĩ sẽ là một điều hấp dẫn trong tương lai.

Theo DataCenterKnowledge (DCK)

Bài viết liên quan

- NVIDIA NGC‑ready Low‑latency Edge AI: Giải pháp cho Retail, Manufacturing và Smart Cities

- So sánh sức mạnh của máy tính AI DGX Spark với các card GPU máy trạm chuyên nghiệp của NVIDIA

- Từ Orin đến Thor: Bước nhảy vọt kiến trúc của NVIDIA JetPack 7.0 và tương lai của robot hình người

- Tại sao gọi NVIDIA DGX Spark là Siêu máy tính AI cá nhân?

- Cơ chế quản lý bộ nhớ trên các nền tảng phần cứng nhất quán – Hardware-coherent

- Kiến trúc NVIDIA Blackwell với GB200 NVL72: Định nghĩa lại điện toán AI cấp độ Exascale