Các mô hình AI đã được đào tạo trước (tiền huấn luyện/pre-trained) là những mô hình học sâu đã được huấn luyện trên một tập dữ liệu rất lớn cho một tác vụ cụ thể. Nhờ quá trình đào tạo chuyên sâu này, các mô hình này đã học được những đặc trưng và kiến thức chung hữu ích, có thể áp dụng cho nhiều tác vụ liên quan khác.

Lợi ích của việc sử dụng mô hình AI đã đào tạo trước

Việc sử dụng các mô hình AI đã được đào tạo trước mang lại nhiều lợi ích đáng kể:

- Tiết kiệm thời gian và tài nguyên: Thay vì phải xây dựng và đào tạo một mô hình từ đầu (tốn rất nhiều thời gian, công sức và tài nguyên tính toán), bạn có thể bắt đầu với một mô hình đã được đào tạo sẵn.

- Cải thiện hiệu suất: Các mô hình được đào tạo trên tập dữ liệu lớn thường có hiệu suất cao và đã học được các đặc trưng mạnh mẽ, giúp nâng cao độ chính xác cho tác vụ mới.

- Ít dữ liệu hơn: Khi sử dụng kỹ thuật học chuyển giao (transfer learning) với mô hình đã đào tạo trước, bạn chỉ cần một lượng dữ liệu tương đối nhỏ để điều chỉnh mô hình cho tác vụ cụ thể của mình.

- Dễ tiếp cận: Nhiều mô hình đã đào tạo trước được cung cấp dưới dạng mã nguồn mở hoặc thông qua các thư viện, nền tảng dễ sử dụng.

Kỹ thuật đào tạo lại: Học chuyển giao (Transfer Learning)

Kỹ thuật chính để sử dụng các mô hình đã đào tạo trước với bộ dữ liệu mới là học chuyển giao (Transfer Learning). Thay vì đào tạo lại toàn bộ mô hình, bạn có thể:

- Sử dụng mô hình như một bộ trích xuất đặc trưng (Feature Extractor): Giữ nguyên các lớp đầu tiên của mô hình đã đào tạo trước (được coi là học các đặc trưng chung) và chỉ đào tạo lại các lớp cuối cùng (lớp đầu ra) trên bộ dữ liệu mới của bạn. Điều này đặc biệt hữu ích khi bộ dữ liệu mới có kích thước nhỏ.

- Điều chỉnh tinh chỉnh (Fine-tuning): Mở đóng băng (unfreeze) một số hoặc tất cả các lớp của mô hình đã đào tạo trước và tiếp tục đào tạo chúng với tốc độ học (learning rate) nhỏ hơn trên bộ dữ liệu mới của bạn. Kỹ thuật này giúp mô hình thích nghi tốt hơn với đặc điểm của dữ liệu mới, đồng thời vẫn giữ được kiến thức đã học trước đó.

Các mô hình AI đã đào tạo trước phổ biến có thể tải về và đào tạo lại

Dưới đây là một số loại mô hình AI đã được đào tạo trước phổ biến, có thể tải về và điều chỉnh cho các tác vụ khác nhau:

1. Mô hình xử lý ngôn ngữ tự nhiên (Natural Language Processing – NLP)

Các mô hình này được đào tạo trên lượng lớn văn bản để hiểu và tạo ra ngôn ngữ. Chúng có thể được điều chỉnh cho các tác vụ như phân loại văn bản, dịch máy, tóm tắt văn bản, trả lời câu hỏi, v.v.

- BERT (Bidirectional Encoder Representations from Transformers): Được phát triển bởi Google, BERT là một trong những mô hình tiên phong trong việc hiểu ngữ cảnh hai chiều của từ.

- GPT (Generative Pre-trained Transformer) Series (ví dụ: GPT-2, GPT-3): Được phát triển bởi OpenAI, các mô hình GPT nổi tiếng với khả năng tạo văn bản tự nhiên, dịch thuật, tóm tắt và nhiều tác vụ sáng tạo khác.

- RoBERTa (Robustly Optimized BERT approach): Một phiên bản tối ưu hóa của BERT.

- XLNet: Một mô hình tự hồi quy (autoregressive) kết hợp các ý tưởng từ BERT và Transformer-XL.

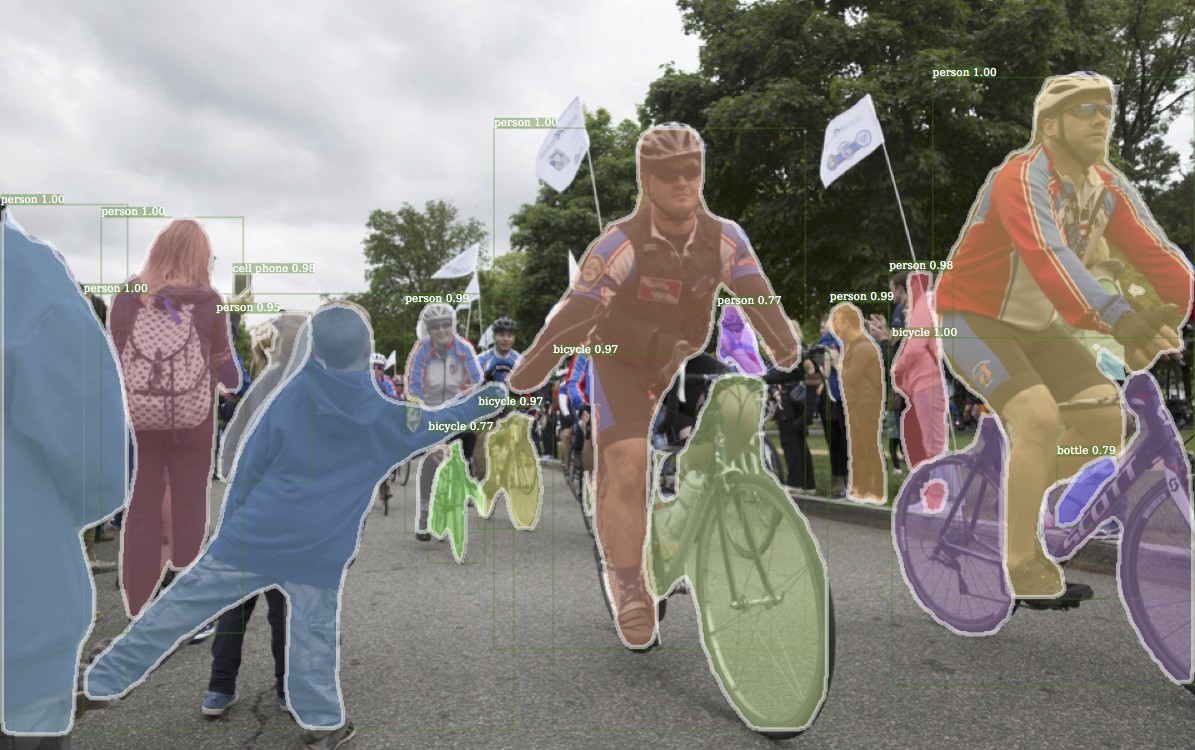

2. Mô hình thị giác máy tính (Computer Vision)

Các mô hình này được đào tạo trên tập dữ liệu hình ảnh khổng lồ (như ImageNet) để nhận diện đối tượng, phân loại hình ảnh, phát hiện vật thể, phân đoạn hình ảnh, v.v.

- VGG (Visual Geometry Group): Các phiên bản như VGG-16, VGG-19 là các mạng nơ-ron tích chập (CNN) có kiến trúc đơn giản nhưng hiệu quả.

- ResNet (Residual Network): Các phiên bản như ResNet-50, ResNet-101 giải quyết vấn đề gradient vanishing trong mạng sâu bằng cách sử dụng kết nối bỏ qua (skip connections).

- Inception (GoogLeNet): Các phiên bản như Inceptionv3 tập trung vào việc sử dụng các mô-đun “inception” để trích xuất đặc trưng đa quy mô.

- EfficientNet: Một họ mô hình CNN được thiết kế để tối ưu hóa hiệu quả về cả độ chính xác và tài nguyên tính toán.

- YOLO (You Only Look Once): Các phiên bản như YOLOv5, YOLOv8 là các mô hình phát hiện vật thể thời gian thực phổ biến.

3. Mô hình xử lý âm thanh (Audio Processing)

Các mô hình này được đào tạo trên dữ liệu âm thanh để nhận dạng giọng nói, phân loại âm thanh, tổng hợp giọng nói, v.v.

- Wav2Vec: Được phát triển bởi Facebook AI, Wav2Vec là một mô hình học biểu diễn âm thanh không giám sát, rất hiệu quả cho nhận dạng giọng nói.

- Whisper: Một mô hình nhận dạng giọng nói tự động mã nguồn mở từ OpenAI, được đào tạo trên lượng lớn dữ liệu âm thanh và văn bản.

Nơi tìm kiếm và tải về các mô hình đã đào tạo trước

Bạn có thể tìm và tải về các mô hình đã đào tạo trước từ các nguồn sau:

NVIDIA NGC: Một thư viện dành cho phát triển phần mềm AI đã được tối ưu hóa cho GPU, các mô hình và ví dụ của Jupyter Notebook – bao gồm các pretrained model và phương thức đào tạo được tối ưu hóa để sử dụng với nền tảng AI của NVIDIA.

NVIDIA AI Enterprise: Bộ phần mềm AI và phân tích dữ liệu thuần đám mây (cloud-native), được quản lý đầy đủ, an toàn, tích hợp sẵn các mô hình được đào tạo trước, không bị mã hóa. Điều này cho phép các nhà phát triển và doanh nghiệp muốn tích hợp các mô hình được NVIDIA đào tạo trước vào các ứng dụng AI tùy chỉnh của họ để xem trọng số và độ lệch của mô hình, cải thiện khả năng giải thích và gỡ lỗi dễ dàng.

- Hugging Face Transformers: Đây là một thư viện và nền tảng cộng đồng rất lớn, cung cấp hàng ngàn mô hình đã đào tạo trước cho NLP, thị giác máy tính và các lĩnh vực khác, cùng với công cụ để dễ dàng tải về và điều chỉnh.

- TensorFlow Hub: Một thư viện của TensorFlow cung cấp nhiều mô hình đã đào tạo trước.

- PyTorch Hub: Tương tự như TensorFlow Hub, PyTorch Hub cung cấp các mô hình đã đào tạo trước cho PyTorch.

- Keras Applications: Một phần của Keras, cung cấp các kiến trúc mạng phổ biến với trọng số đã được đào tạo trên ImageNet.

- GitHub: Nhiều nhà nghiên cứu và tổ chức phát hành mã nguồn và trọng số của các mô hình đã đào tạo trước trên GitHub.

Việc tận dụng các mô hình AI đã đào tạo trước là một cách hiệu quả để đẩy nhanh quá trình phát triển AI, giảm thiểu chi phí và đạt được kết quả ấn tượng ngay cả với nguồn lực hạn chế.

Bài viết liên quan