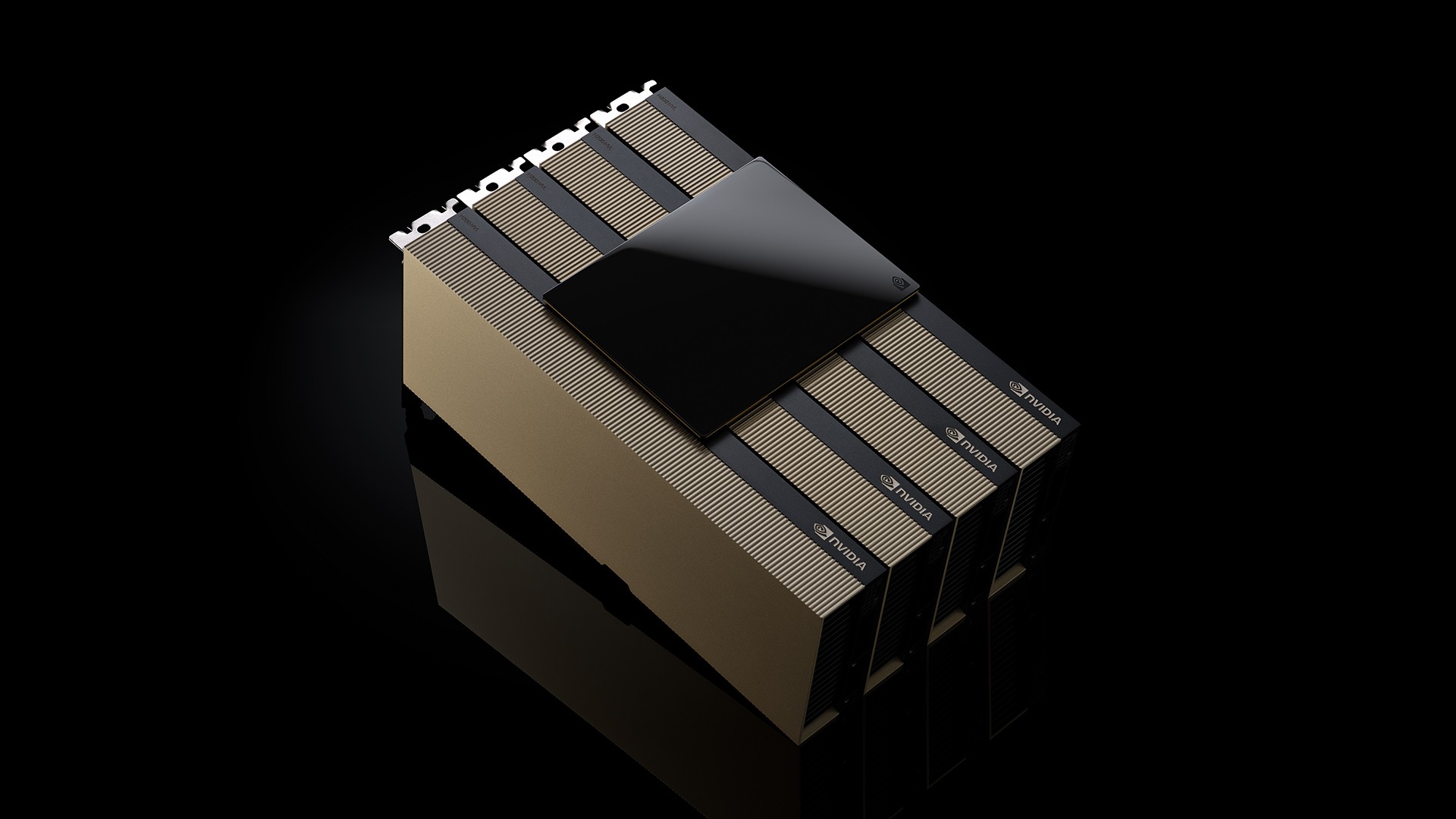

NVIDIA H200 NVL PCIe là dòng GPU hoàn hảo cho các hệ thống máy chủ doanh nghiệp làm mát bằng không khí, tiêu thụ ít điện năng và cung cấp khả năng suy luận mô hình ngôn ngữ lớn nhanh hơn đến 1,7 lần và hiệu suất cao hơn 1,3 lần trên các ứng dụng điện toán hiệu suất cao.

Kể từ khi ra mắt, kiến trúc NVIDIA Hopper đã thay đổi bối cảnh AI và điện toán hiệu suất cao (HPC), giúp các doanh nghiệp, các đơn vị nghiên cứu và nhà phát triển giải quyết những thách thức phức tạp nhất với hiệu suất cao hơn và hiệu quả năng lượng tốt hơn.

GPU NVIDIA H200 NVL PCIe được NVIDIA ra mắt vào sự kiện Supercomputing năm 2024. Mẫu GPU này lý tưởng cho các tổ chức có sở hữu trung tâm dữ liệu đang tìm kiếm giải pháp máy chủ rack doanh nghiệp làm mát bằng không khí, công suất thấp với cấu hình linh hoạt để tăng tốc cho mọi tải xử lý AI và HPC ở mọi quy mô.

Theo một cuộc khảo sát gần đây, khoảng 70% máy chủ rack doanh nghiệp có công suất 20kW trở xuống và sử dụng làm mát bằng không khí. Điều này làm cho GPU PCIe trở nên thiết yếu, vì chúng cung cấp khả năng triển khai theo node, cho dù sử dụng một, hai, bốn hay tám GPU — cho phép các trung tâm dữ liệu đóng gói nhiều sức mạnh tính toán hơn vào không gian nhỏ hơn. Sau đó, các công ty có thể sử dụng máy chủ rack hiện có của mình và chọn số lượng GPU phù hợp nhất với nhu cầu của họ.

Các doanh nghiệp có thể sử dụng H200 NVL để tăng tốc các ứng dụng AI và HPC, đồng thời cải thiện hiệu quả năng lượng thông qua việc giảm mức tiêu thụ điện năng. Với bộ nhớ tăng 1,5 lần và băng thông tăng 1,2 lần so với NVIDIA H100 NVL, các công ty có thể sử dụng H200 NVL để tinh chỉnh LLM trong vòng vài giờ và cung cấp hiệu suất suy luận nhanh hơn tới 1,7 lần. Đối với tải xử lý HPC, hiệu suất được tăng lên tới 1,3 lần so với H100 NVL và 2,5 lần so với thế hệ kiến trúc NVIDIA Ampere.

Bổ sung cho sức mạnh của H200 NVL là công nghệ NVIDIA NVLink. Thế hệ NVLink mới nhất cung cấp giao tiếp GPU-to-GPU nhanh hơn 7 lần so với PCIe thế hệ thứ năm — mang lại hiệu suất cao hơn để đáp ứng nhu cầu của HPC, suy luận mô hình ngôn ngữ lớn và tinh chỉnh model.

NVIDIA H200 NVL khi được kết hợp với các công cụ phần mềm mạnh mẽ sẽ cho phép các doanh nghiệp tăng tốc các ứng dụng từ AI sang HPC. Nó đi kèm với gói đăng ký 5 năm cho NVIDIA AI Enterprise, một nền tảng phần mềm thuần đám mây để phát triển và triển khai AI cấp độ sản xuất. NVIDIA AI Enterprise bao gồm các microservice NVIDIA NIM để triển khai suy luận mô hình AI hiệu suất cao một cách an toàn và tin cậy.

Các công ty khai thác sức mạnh của H200 NVL

Với H200 NVL, NVIDIA cung cấp cho các doanh nghiệp một nền tảng đầy đủ để phát triển và triển khai tải xử lý AI và HPC của họ.

Khách hàng đang nhận thấy tác động đáng kể đối với nhiều ứng dụng AI và HPC trong nhiều ngành, chẳng hạn như Agentic AI trực quan và chatbot dành cho dịch vụ khách hàng, thuật toán giao dịch dành cho tài chính, hình ảnh y tế để cải thiện khả năng phát hiện bất thường trong y tế, nhận dạng mẫu hình trong lĩnh vực sản xuất và hình ảnh địa chấn cho các tổ chức khoa học.

Dropbox đang khai thác sức mạnh điện toán tăng tốc của NVIDIA cho các dịch vụ và hạ tầng của mình.

“Dropbox xử lý lượng lớn nội dung, đòi hỏi khả năng AI và học máy tiên tiến”, Ali Zafar, Phó chủ tịch hạ tầng tại Dropbox cho biết. “Chúng tôi đang khám phá H200 NVL để liên tục cải thiện dịch vụ của mình và mang lại nhiều giá trị hơn cho khách hàng”.

Đại học New Mexico đã sử dụng công nghệ điện toán tăng tốc của NVIDIA trong nhiều ứng dụng nghiên cứu và học thuật khác nhau.

“Là một trường đại học nghiên cứu công lập, cam kết của chúng tôi đối với AI giúp trường đại học này đi đầu trong các tiến bộ khoa học và công nghệ”, Giáo sư Patrick Bridges, giám đốc Trung tâm nghiên cứu máy tính tiên tiến của UNM cho biết. “Khi chúng tôi chuyển sang H200 NVL, chúng tôi sẽ có thể đẩy nhanh nhiều ứng dụng khác nhau, bao gồm các sáng kiến khoa học dữ liệu, nghiên cứu tin sinh học và hệ gen, mô phỏng vật lý và thiên văn học, mô hình khí hậu, v.v.”

H200 NVL đã có sẵn trên toàn hệ sinh thái

Dell Technologies, Hewlett Packard Enterprise, Supermicro và Lenovo hiện tại đã cung cấp nhiều cấu hình hỗ trợ H200 NVL. Ngoài ra, H200 NVL còn có mặt trên các nền tảng của ASUS, AIC, GIGABYTE, MSI,…

Thế Giới Máy Chủ hiện có thể cung cấp trực tiếp các dòng GPU PCIe hiệu suất cao của NVIDIA như H200 NVL, H100 NVL, L40, L40S và L4.

Khách hàng có nhu cầu vui lòng liên hệ để được tư vấn.

Hotline: 1900 558879

Một số hệ thống dựa trên kiến trúc module NVIDIA MGX, cho phép các nhà sản xuất máy tính xây dựng nhanh chóng và tiết kiệm chi phí nhiều thiết kế hạ tầng trung tâm dữ liệu.

Các hệ thống hỗ trợ H200 NVL hiện đã có sẵn từ các đối tác sản xuất máy chủ toàn cầu của NVIDIA. Ngoài ra, bổ sung cho lựa chọn từ các đối tác toàn cầu, NVIDIA cũng đã phát triển một kiến trúc tham chiếu cấp doanh nghiệp cho các hệ thống H200 NVL.

Kiến trúc tham chiếu sẽ kết hợp chuyên môn và nguyên tắc thiết kế của NVIDIA, do đó các đối tác và khách hàng có thể thiết kế và triển khai hạ tầng AI hiệu suất cao dựa trên H200 NVL ở quy mô lớn. Chúng bao gồm các khuyến nghị về phần cứng và phần mềm đầy đủ, với hướng dẫn chi tiết về cấu hình máy chủ, cụm và kết nối mạng tối ưu. Mạng được tối ưu hóa để có hiệu suất cao nhất với nền tảng NVIDIA Spectrum-X Ethernet.

Bài viết liên quan

- NVIDIA NGC‑ready Low‑latency Edge AI: Giải pháp cho Retail, Manufacturing và Smart Cities

- So sánh sức mạnh của máy tính AI DGX Spark với các card GPU máy trạm chuyên nghiệp của NVIDIA

- Từ Orin đến Thor: Bước nhảy vọt kiến trúc của NVIDIA JetPack 7.0 và tương lai của robot hình người

- Tại sao gọi NVIDIA DGX Spark là Siêu máy tính AI cá nhân?

- Cơ chế quản lý bộ nhớ trên các nền tảng phần cứng nhất quán – Hardware-coherent

- Kiến trúc NVIDIA Blackwell với GB200 NVL72: Định nghĩa lại điện toán AI cấp độ Exascale