GTC24 – Đánh dấu một kỷ nguyên mới của tính toán, tại sự kiện này NVIDIA đã thông báo ra mắt NVIDIA Blackwell — cho phép các tổ chức trên toàn thế giới xây dựng và vận hành Trí tuệ Nhân tạo tạo ngẫu nhiên thời gian thực trên các mô hình ngôn ngữ lớn với tỷ lệ tham số lên tới hàng nghìn tỷ với chi phí và tiêu thụ năng lượng ít hơn tới 25 lần so với thế hệ trước.

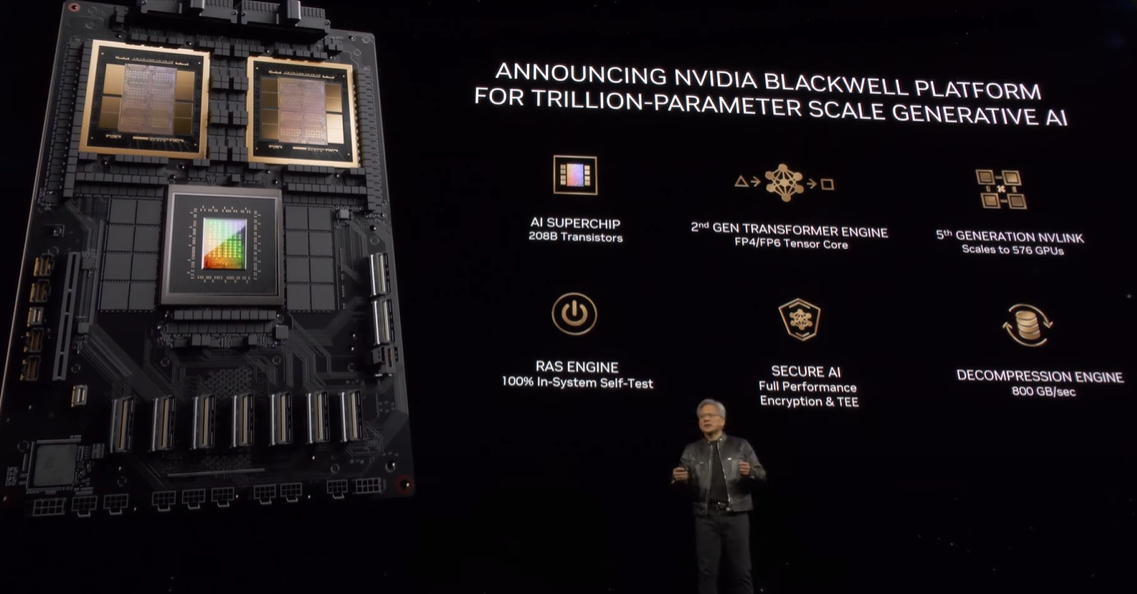

Kiến trúc GPU Blackwell đặc trưng bởi sáu công nghệ biến đổi cho tính toán tăng tốc, sẽ giúp mở khóa những bước đột phá trong xử lý dữ liệu, mô phỏng kỹ thuật, tự động hóa thiết kế điện tử, thiết kế thuốc hỗ trợ máy tính và trí tuệ nhân tạo tạo ngẫu nhiên — tất cả đều là cơ hội ngành công nghiệp mới nổi cho NVIDIA.

“Trong ba thập kỷ qua, chúng tôi đã theo đuổi tính toán tăng tốc, với mục tiêu là tạo điều kiện cho những đột phá biến đổi như học sâu và trí tuệ nhân tạo,” Jensen Huang, người sáng lập và CEO của NVIDIA nói. “Trí tuệ nhân tạo tạo ngẫu nhiên là công nghệ xác định của thời đại chúng ta. Blackwell là động cơ để thúc đẩy cuộc cách mạng công nghiệp mới này. Hợp tác với những công ty động động nhất trên thế giới, chúng tôi sẽ thực hiện hứa hẹn của trí tuệ nhân tạo cho mọi ngành công nghiệp.”

Trong số nhiều tổ chức dự kiến sẽ áp dụng Blackwell có Amazon Web Services, Dell Technologies, Google, Meta, Microsoft, OpenAI, Oracle, Tesla và xAI.

Sundar Pichai, CEO của Alphabet và Google: “Mở rộng các dịch vụ như Tìm kiếm và Gmail cho hàng tỷ người dùng đã giúp chúng tôi nắm rõ nhiều điều về việc quản lý cơ sở hạ tầng tính toán. Khi chúng ta bước vào sự chuyển đổi của nền tảng trí tuệ nhân tạo, chúng tôi tiếp tục đầu tư sâu vào cơ sở hạ tầng cho các sản phẩm và dịch vụ của chính mình, và cho khách hàng Cloud của chúng tôi. Chúng tôi may mắn khi có một mối quan hệ đối tác lâu dài với NVIDIA, và mong chờ mang lại các khả năng đột phá của GPU Blackwell cho các khách hàng và nhóm của Google Cloud, bao gồm cả Google DeepMind, để tăng tốc các phát hiện trong tương lai.”

Andy Jassy, Tổng giám đốc điều hành của Amazon: “Sự hợp tác chặt chẽ của chúng tôi với NVIDIA đã kéo dài hơn 13 năm, khi chúng tôi ra mắt phiên bản đám mây đầu tiên trên thế giới có GPU trên AWS. Ngày nay, chúng tôi cung cấp loạt giải pháp GPU rộng nhất có sẵn bất cứ nơi nào trên đám mây, hỗ trợ các khối lượng công việc được tăng tốc công nghệ tiên tiến nhất thế giới.

Đó là lý do tại sao GPU Blackwell mới sẽ hoạt động tốt trên AWS và là lý do mà NVIDIA đã chọn AWS để cùng phát triển Dự án Ceiba, kết hợp Chip siêu mạnh của NVIDIA thế hệ tiếp theo Grace Blackwell với Hệ thống Nitro tiên tiến của AWS trong ảo hóa và mạng kết nối Adapter vải Elastic siêu nhanh, để nghiên cứu và phát triển trí tuệ nhân tạo của riêng NVIDIA. Thông qua nỗ lực chung giữa các kỹ sư của AWS và NVIDIA, chúng tôi tiếp tục đổi mới cùng nhau để làm cho AWS trở thành nơi tốt nhất cho bất kỳ ai muốn chạy GPU NVIDIA trên đám mây.”

Michael Dell, người sáng lập và CEO của Dell Technologies: “Trí tuệ nhân tạo tạo ngẫu nhiên quan trọng để tạo ra các hệ thống thông minh, đáng tin cậy và hiệu quả hơn. Dell Technologies và NVIDIA đang cùng nhau hình thành tương lai của công nghệ. Với việc ra mắt Blackwell, chúng tôi sẽ tiếp tục cung cấp các sản phẩm và dịch vụ tăng tốc thế hệ kế tiếp cho khách hàng của chúng tôi, cung cấp cho họ những công cụ họ cần để thúc đẩy sự đổi mới qua các ngành công nghiệp.”

Demis Hassabis, cộng sự sáng lập và CEO của Google DeepMind: “Tiềm năng biến đổi của trí tuệ nhân tạo là không thể tin được, và nó sẽ giúp chúng tôi giải quyết một số vấn đề khoa học quan trọng nhất trên thế giới. Các khả năng công nghệ đột phá của Blackwell sẽ cung cấp tính toán quan trọng cần thiết để giúp các tâm trí sáng dạ khắc phục những phát hiện khoa học mới.”

Mark Zuckerberg, người sáng lập và CEO của Meta: “Trí tuệ nhân tạo đã điều khiển mọi thứ từ các mô hình ngôn ngữ lớn của chúng tôi đến các gợi ý nội dung, quảng cáo và hệ thống an toàn, và nó chỉ càng trở nên quan trọng hơn trong tương lai. Chúng tôi mong chờ sử dụng NVIDIA Blackwell để giúp huấn luyện các mô hình Llama mã nguồn mở của chúng tôi và xây dựng thế hệ tiếp theo của trí tuệ nhân tạo và sản phẩm tiêu dùng của Meta.”

Satya Nadella, Chủ tịch điều hành và CEO của Microsoft: “Chúng tôi cam kết cung cấp cho khách hàng của mình cơ sở hạ tầng tiên tiến nhất để nâng cấp khối lượng công việc trí tuệ nhân tạo của họ. Bằng cách mang bộ xử lý GB200 Grace Blackwell đến các trung tâm dữ liệu của chúng tôi trên toàn cầu, chúng tôi đang tiếp tục xây dựng trên lịch sử lâu dài của mình về tối ưu hóa GPU NVIDIA cho đám mây của chúng tôi, khi chúng tôi làm cho hứa hẹn của trí tuệ nhân tạo trở nên thực tế đối với mọi tổ chức.”

Sam Altman, CEO của OpenAI: “Blackwell mang lại những bước tiến lớn về hiệu suất, và sẽ tăng tốc khả năng của chúng tôi trong việc cung cấp các mô hình tiên tiến. Chúng tôi rất hào hứng để tiếp tục hợp tác với NVIDIA để cải thiện tính toán trí tuệ nhân tạo.”

Larry Ellison, Chủ tịch và Giám đốc công nghệ của Oracle: “Sự hợp tác chặt chẽ của Oracle với NVIDIA sẽ tạo điều kiện cho những đột phá chất lượng và lượng trong trí tuệ nhân tạo, học máy và phân tích dữ liệu. Để khách hàng có thể khám phá ra nhiều thông tin hành động hơn, một động cơ mạnh mẽ như Blackwell được cần đến, được xây dựng với mục đích cho tính toán tăng tốc và trí tuệ nhân tạo tạo ngẫu nhiên.”

Elon Musk, CEO của Tesla và xAI: “Hiện tại không có gì tốt hơn phần cứng của NVIDIA cho trí tuệ nhân tạo.”

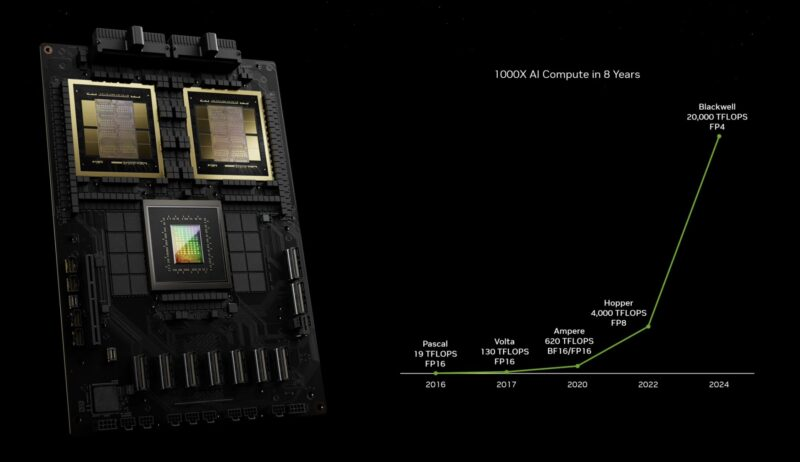

Được đặt theo tên của David Harold Blackwell — một nhà toán học chuyên về lý thuyết trò chơi và thống kê, và là học giả đen đầu tiên được vào Viện Hàn Lâm Khoa học Quốc gia — kiến trúc mới này kế thừa kiến trúc NVIDIA Hopper™, ra mắt hai năm trước.

Các công nghệ đột phá của Blackwell

Sáu công nghệ đột phá của Blackwell cùng nhau hỗ trợ huấn luyện AI và suy luận LLM theo thời gian thực cho các mô hình lên tới 10 nghìn tỷ tham số, bao gồm:

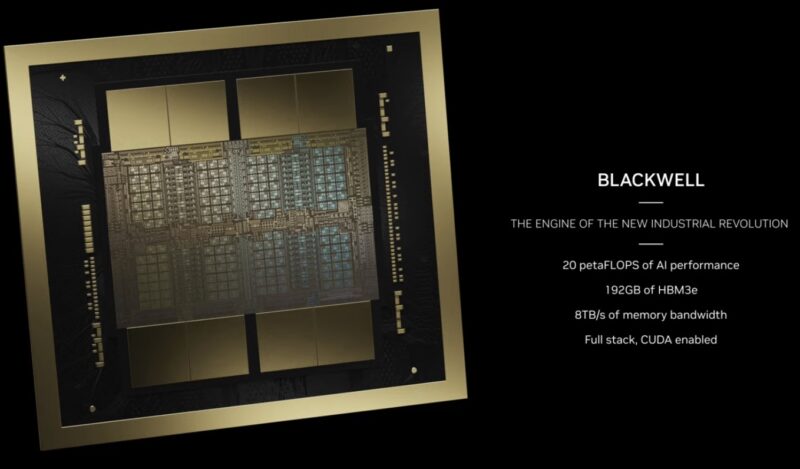

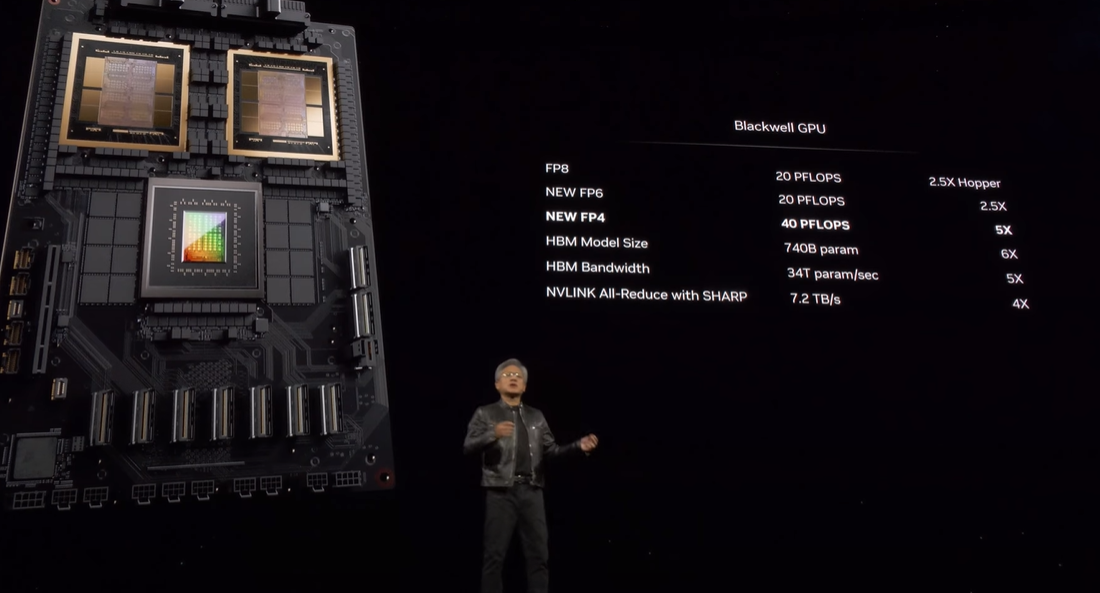

- Chip Mạnh Mẽ Nhất Thế Giới: Được tích hợp 208 tỷ bóng bán dẫn, GPU dựa trên kiến trúc Blackwell được sản xuất bằng quy trình 4NP TSMC tùy chỉnh với hai khuôn GPU giới hạn hai lưới kết nối bằng liên kết chip-to-chip 10 TB/giây thành một GPU thống nhất duy nhất.

- Bộ Máy Transformer Thế Hệ Thứ Hai: Được hỗ trợ bởi khả năng mở rộng vi mô tensor mới và các thuật toán quản lý dải động học tiên tiến của NVIDIA tích hợp trong các khung NVIDIA TensorRT™-LLM và NeMo Megatron, Blackwell sẽ hỗ trợ gấp đôi khả năng tính toán và kích thước mô hình với khả năng suy luận AI dấu phẩy động 4-bit mới.

- NVLink Thế Hệ Thứ Năm: Để tăng tốc hiệu suất cho các mô hình AI hỗn hợp chuyên gia và đa nghìn tỷ tham số, phiên bản mới nhất của NVIDIA NVLink® cung cấp thông lượng song hướng đột phá 1.8TB/giây trên mỗi GPU, đảm bảo giao tiếp tốc độ cao liền mạch giữa tối đa 576 GPU cho các LLM phức tạp nhất.

- Công Nghệ RAS: GPU được hỗ trợ bởi Blackwell bao gồm một động cơ chuyên dụng cho độ tin cậy, tính khả dụng và khả năng bảo trì. Ngoài ra, kiến trúc Blackwell bổ sung các khả năng ở cấp độ chip để tận dụng bảo trì dự phòng dựa trên AI nhằm chạy chẩn đoán và dự báo các vấn đề về độ tin cậy. Điều này tối đa hóa thời gian hoạt động của hệ thống và cải thiện khả năng phục hồi cho các triển khai AI quy mô lớn, chạy không gián đoạn trong nhiều tuần hoặc thậm chí nhiều tháng và giảm chi phí vận hành.

- AI An Toàn: Khả năng tính toán bảo mật tiên tiến bảo vệ các mô hình AI và dữ liệu của khách hàng mà không ảnh hưởng đến hiệu suất, với hỗ trợ cho các giao thức mã hóa giao diện gốc mới, điều cần thiết cho các ngành nhạy cảm về quyền riêng tư như y tế và dịch vụ tài chính.

- Công Nghệ Giải Nén: Công nghệ giải nén chuyên dụng hỗ trợ các định dạng mới nhất, tăng tốc các truy vấn cơ sở dữ liệu để mang lại hiệu suất cao nhất trong phân tích dữ liệu và khoa học dữ liệu. Trong những năm tới, việc xử lý dữ liệu, lĩnh vực mà các công ty chi hàng chục tỷ đô la mỗi năm, sẽ ngày càng được tăng tốc bằng GPU.

Siêu chip GB200 Grace Blackwell – cỗ máy siêu tốc dành cho AI

Siêu vi chip NVIDIA GB200 Grace Blackwell kết nối hai GPU Lõi Tensor NVIDIA B200 với CPU Grace của NVIDIA thông qua đường kết nối chip-to-chip NVLink 900GB/s năng lượng cực thấp.

Để đạt hiệu suất AI tối cao, các hệ thống sử dụng GB200 có thể kết nối với các nền tảng InfiniBand NVIDIA Quantum-X800 và Ethernet Spectrum™-X800, cũng được công bố ngày hôm nay, mang lại khả năng kết nối mạng tiên tiến với tốc độ lên đến 800Gb/s.

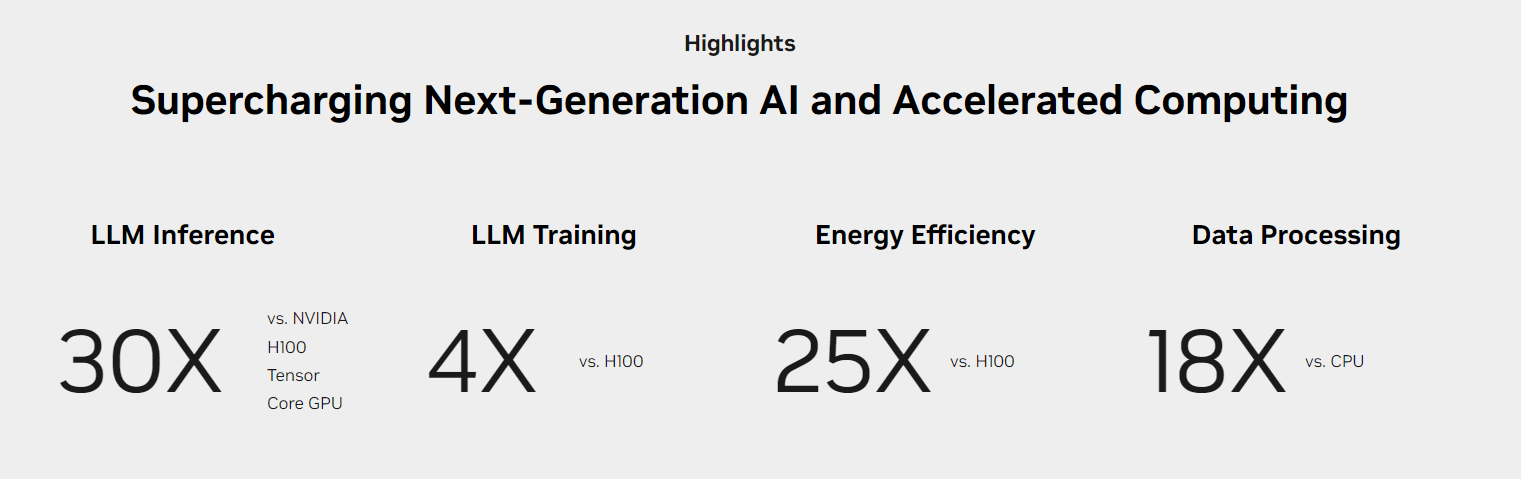

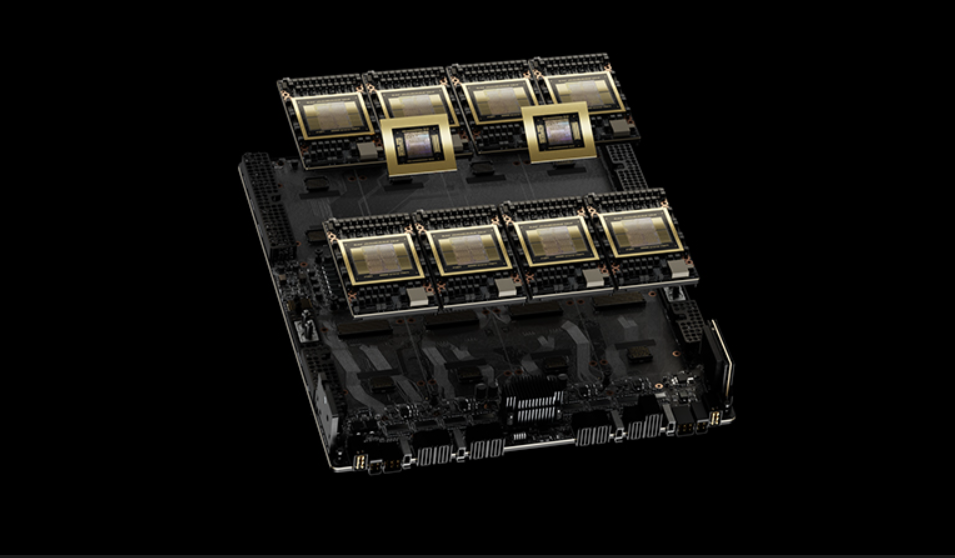

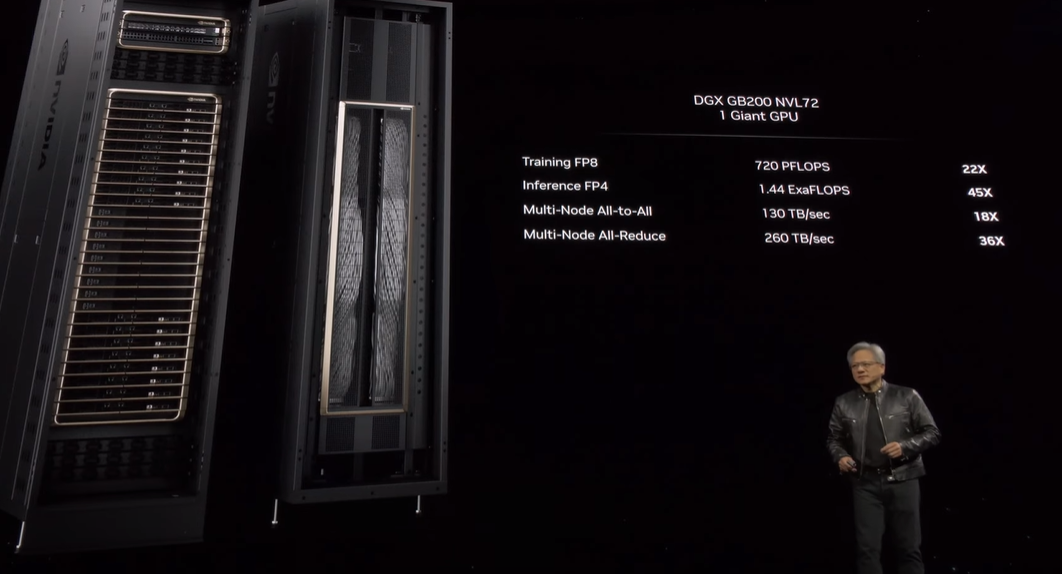

GB200 là thành phần cốt lõi của NVIDIA GB200 NVL72, một hệ thống đa nút, làm mát bằng chất lỏng, theo kích thước rack, dành cho các khối lượng công việc đòi hỏi tính toán khắt khe nhất. Hệ thống này kết hợp 36 Siêu vi chip Grace Blackwell, bao gồm 72 GPU Blackwell và 36 CPU Grace được kết nối bởi NVLink thế hệ thứ năm. Ngoài ra, GB200 NVL72 còn bao gồm các đơn vị xử lý dữ liệu NVIDIA BlueField®-3 để cho phép tăng tốc mạng đám mây, lưu trữ linh hoạt, bảo mật zero-trust và tính đàn hồi tính toán GPU trong các đám mây AI quy mô lớn. So với cùng số lượng GPU Lõi Tensor NVIDIA H100 cho khối lượng công việc suy luận LLM, GB200 NVL72 cung cấp hiệu suất tăng tới 30 lần, đồng thời giảm chi phí và tiết kiệm năng lượng lên tới 25 lần.

Nền tảng này hoạt động như một GPU đơn với hiệu suất AI 1.4 exaflop và bộ nhớ nhanh 30TB, đồng thời là khối xây dựng cho DGX SuperPOD mới nhất.

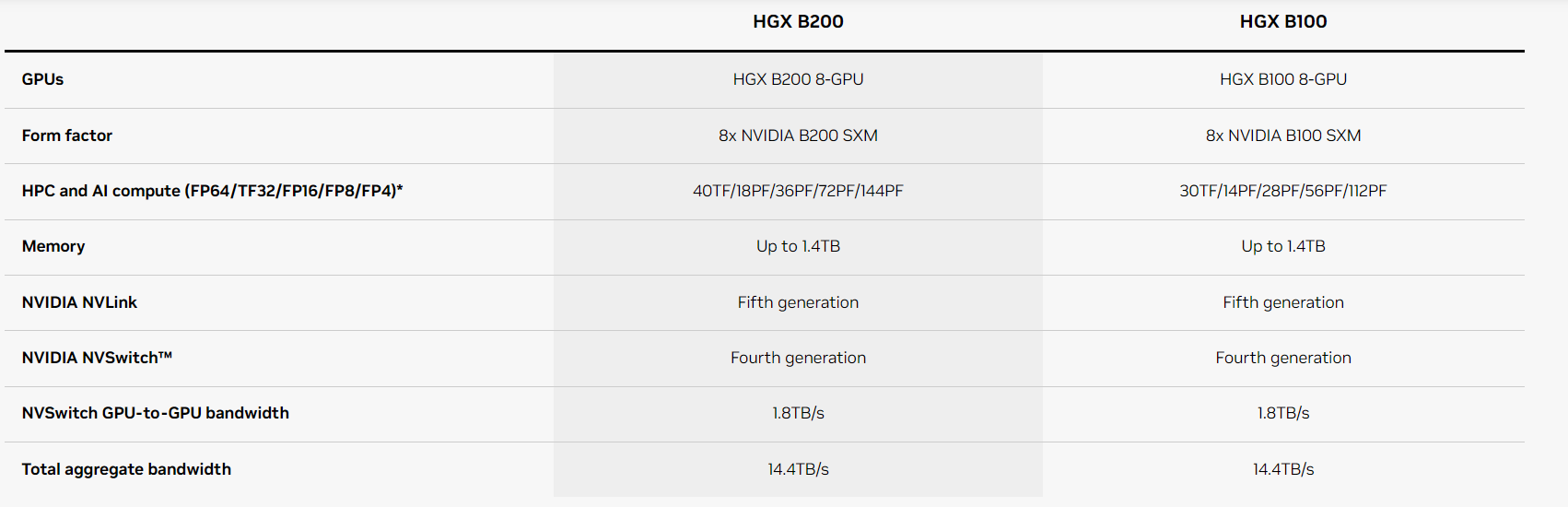

NVIDIA cũng cung cấp HGX B200, bo mạch máy chủ kết nối tám GPU B200 thông qua NVLink để hỗ trợ các nền tảng AI tổng hợp dựa trên x86. HGX B200 hỗ trợ tốc độ mạng lên tới 400Gb/s thông qua các nền tảng mạng InfiniBand NVIDIA Quantum-2 và Ethernet Spectrum-X.

Mạng lưới đối tác toàn cầu của Blackwell

Các sản phẩm dựa trên Blackwell sẽ được các đối tác cung cấp bắt đầu từ cuối năm nay.

AWS, Google Cloud, Microsoft Azure và Oracle Cloud Infrastructure sẽ là những nhà cung cấp dịch vụ đám mây đầu tiên cung cấp các phiên bản được trang bị bởi Blackwell, cũng như các công ty trong chương trình Đối tác Đám Mây của NVIDIA như Applied Digital, CoreWeave, Crusoe, IBM Cloud và Lambda. Các đám mây trí tuệ nhân tạo độc lập cũng sẽ cung cấp các dịch vụ và cơ sở hạ tầng đám mây dựa trên Blackwell, bao gồm Indosat Ooredoo Hutchinson, Nebius, Nexgen Cloud, Oracle EU Sovereign Cloud, Oracle US, UK, và Australian Government Clouds, Scaleway, Singtel, Taiga Cloud của Northern Data Group, Shakti Cloud của Yotta Data Services và YTL Power International.

GB200 cũng sẽ có sẵn trên NVIDIA DGX™ Cloud, một nền tảng trí tuệ nhân tạo được hợp tác cùng các nhà cung cấp dịch vụ đám mây hàng đầu, cung cấp cho các nhà phát triển doanh nghiệp quyền truy cập riêng biệt vào cơ sở hạ tầng và phần mềm cần thiết để xây dựng và triển khai các mô hình trí tuệ nhân tạo tạo ngẫu nhiên tiên tiến. AWS, Google Cloud và Oracle Cloud Infrastructure dự định tổ chức các phiên bản mới được trang bị bởi NVIDIA Grace Blackwell vào cuối năm nay.

Cisco, Dell, Hewlett Packard Enterprise, Lenovo và Supermicro được dự đoán sẽ cung cấp một loạt rộng các máy chủ dựa trên các sản phẩm Blackwell, cũng như Aivres, ASRock Rack, ASUS, Eviden, Foxconn, GIGABYTE, Inventec, Pegatron, QCT, Wistron, Wiwynn và ZT Systems.

Ngoài ra, một mạng lưới ngày càng lớn của các nhà sản xuất phần mềm, bao gồm Ansys, Cadence và Synopsys – các nhà lãnh đạo toàn cầu trong mô phỏng kỹ thuật – sẽ sử dụng các bộ xử lý dựa trên Blackwell để tăng tốc phần mềm của họ cho việc thiết kế và mô phỏng các hệ thống và bộ phận điện, cơ học và sản xuất. Khách hàng của họ có thể sử dụng trí tuệ nhân tạo tạo ngẫu nhiên và tính toán tăng tốc để đưa sản phẩm ra thị trường nhanh hơn, với chi phí thấp hơn và hiệu suất năng lượng cao hơn.

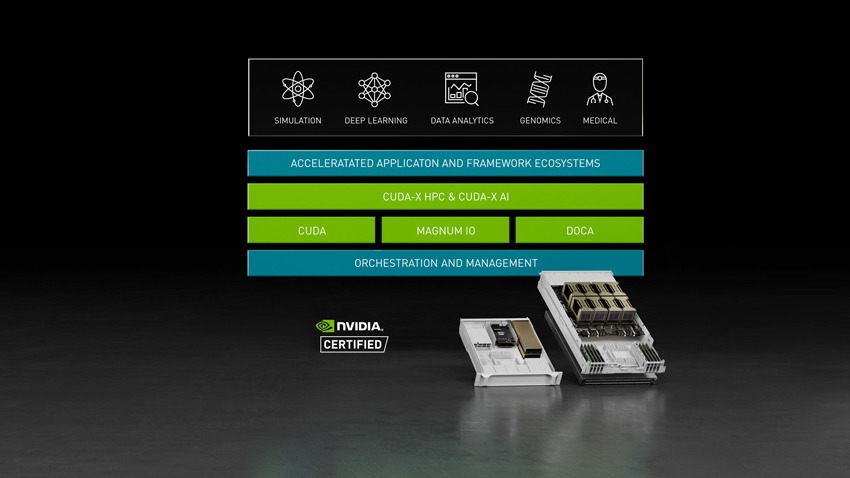

Hỗ trợ phần mềm của NVIDIA

Dòng sản phẩm Blackwell được hỗ trợ bởi NVIDIA AI Enterprise, hệ thống hoạt động từ đầu đến cuối cho trí tuệ nhân tạo sản xuất. NVIDIA AI Enterprise bao gồm NVIDIA NIM™, dịch vụ suy luận microservice — cũng được công bố vào hôm nay — cũng như các framework, thư viện và công cụ trí tuệ nhân tạo mà các doanh nghiệp có thể triển khai trên các đám mây, trung tâm dữ liệu và máy trạm được tăng tốc bởi NVIDIA.

→ Để biết thêm thông tin về nền tảng NVIDIA Blackwell, hãy xem lại bài phát biểu quan trọng của GTC 24 tại đây: https://thegioimaychu.vn/blog/ai-hpc/tom-tat-buoi-keynote-cua-nvidia-gtc-2024-p19257/

Bài viết liên quan