Tại GTC 24 vừa được khai mạc ở San Jose, NVIDIA đã công bố siêu máy tính AI thế hệ tiếp theo của mình. NVIDIA DGX SuperPOD, hệ thống được trang bị dòng siêu chip NVIDIA GB200 Grace Blackwell, được thiết kế để xử lý các mô hình hàng tỷ tham số với thời gian hoạt động liên tục cho các tải huấn luyện và suy luận generative AI siêu lớn.

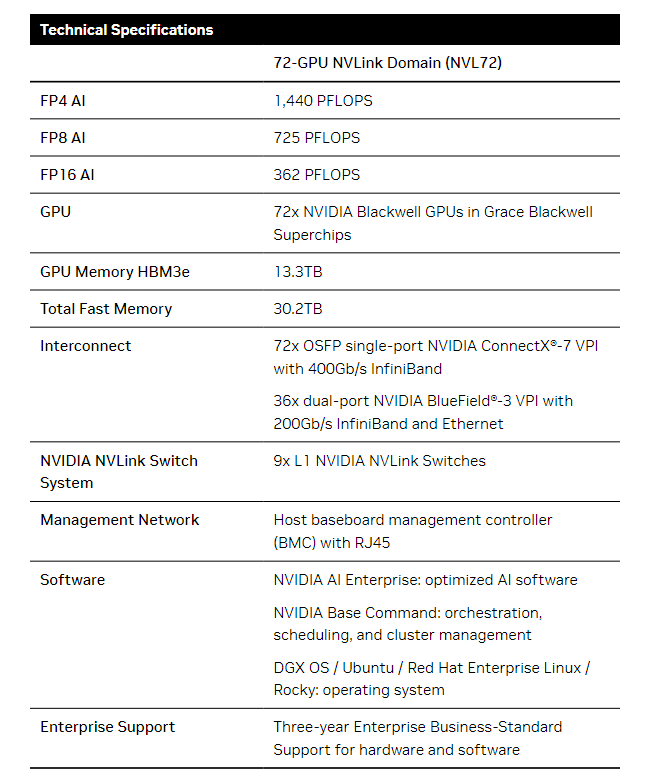

Với kiến trúc mới có hiệu quả cao và được làm mát bằng chất lỏng, DGX SuperPOD mới được xây dựng với các hệ thống NVIDIA DGX GB200 và cung cấp năng lực điện toán AI lên đến 11.5 exaflops ở độ chính xác FP4 và 240 terabyte bộ nhớ nhanh — có thể mở rộng thêm với các rack bổ sung.

Mỗi hệ thống DGX GB200 có 36 NVIDIA GB200 Superchips bao gồm 36 CPU Grace của NVIDIA và 72 GPU Blackwell của NVIDIA — được kết nối như một siêu máy tính thông qua kết nối thế hệ thứ năm NVIDIA NVLink®. GB200 Superchips mang lại tăng hiệu suất lên đến 30 lần so với GPU Tensor Core H100 của NVIDIA cho các khối công việc suy luận mô hình ngôn ngữ lớn.

“Siêu máy tính AI NVIDIA DGX là nhà máy của cách mạng công nghiệp AI,” Jensen Huang, người sáng lập và CEO của NVIDIA nói. “DGX SuperPOD mới kết hợp các tiến bộ mới nhất trong tính toán tăng tốc của NVIDIA, mạng lưới và phần mềm để cho phép mọi công ty, ngành và quốc gia tinh chỉnh và tạo ra AI của riêng họ.”

DGX SuperPOD được trang bị bộ vi xử lý Grace Blackwell và có thể mở rộng đến hàng chục nghìn GB200 Superchips được kết nối thông qua Quantum InfiniBand của NVIDIA. Để tạo ra không gian bộ nhớ chung khổng lồ để năng lượng cho các mô hình AI thế hệ tiếp theo, khách hàng có thể triển khai một cấu hình kết nối 576 GPU Blackwell trong tám hệ thống DGX GB200 được kết nối qua NVLink.

Kiến trúc DGX SuperPOD mới cho thời đại của AI sáng tạo

DGX SuperPOD mới với các hệ thống DGX GB200 có một mạng lưới tính toán thống nhất. Ngoài việc sử dụng NVIDIA NVLink thế hệ thứ năm, mạng lưới này bao gồm cả DPU BlueField®-3 của NVIDIA và sẽ hỗ trợ mạng lưới Quantum-X800 InfiniBand của NVIDIA, được thông báo một cách riêng biệt vào hôm nay. Kiến trúc này cung cấp tới 1,800 gigabyte mỗi giây băng thông cho mỗi GPU trên nền tảng.

Ngoài ra, công nghệ NVIDIA Scalable Hierarchical Aggregation and Reduction Protocol (SHARP)™ thế hệ thứ tư cung cấp 14.4 teraflops của tính toán In-Network, tăng gấp 4 lần so với kiến trúc DGX SuperPOD thế hệ tiếp theo so với thế hệ trước đó.

Kiến trúc độc quyền kết hợp với phần mềm siêu tiên tiến

DGX SuperPOD mới là một siêu máy tính AI toàn diện, quy mô trung tâm dữ liệu, tích hợp với lưu trữ hiệu suất cao từ các đối tác được chứng nhận bởi NVIDIA để đáp ứng các yêu cầu của các khối công việc AI tạo hình. Mỗi hệ thống được xây dựng, cáp và kiểm tra tại nhà máy để tăng tốc độ triển khai tại các trung tâm dữ liệu của khách hàng.

DGX SuperPOD được trang bị khả năng quản lý dự đoán thông minh để liên tục giám sát hàng nghìn điểm dữ liệu trên phần cứng và phần mềm để dự đoán và chặn nguồn gốc của thời gian chết và không hiệu quả — tiết kiệm thời gian, năng lượng và chi phí tính toán.

Phần mềm có thể xác định các khu vực đang gây lo ngại và lập kế hoạch cho việc bảo dưỡng, điều chỉnh linh hoạt tài nguyên tính toán, và tự động lưu và tiếp tục công việc để ngăn chặn thời gian chết, ngay cả khi không có quản trị hệ thống hiện diện.

Nếu phần mềm phát hiện rằng cần phải thay thế một thành phần, cụm sẽ kích hoạt khả năng dự phòng để đảm bảo công việc hoàn thành đúng thời gian. Bất kỳ sự thay thế phần cứng nào cần thiết có thể được lên kế hoạch để tránh thời gian chết không được lên kế hoạch.

NVIDIA DGX B200 – Siêu máy tính ai nâng cao cho các ngành công nghiệp

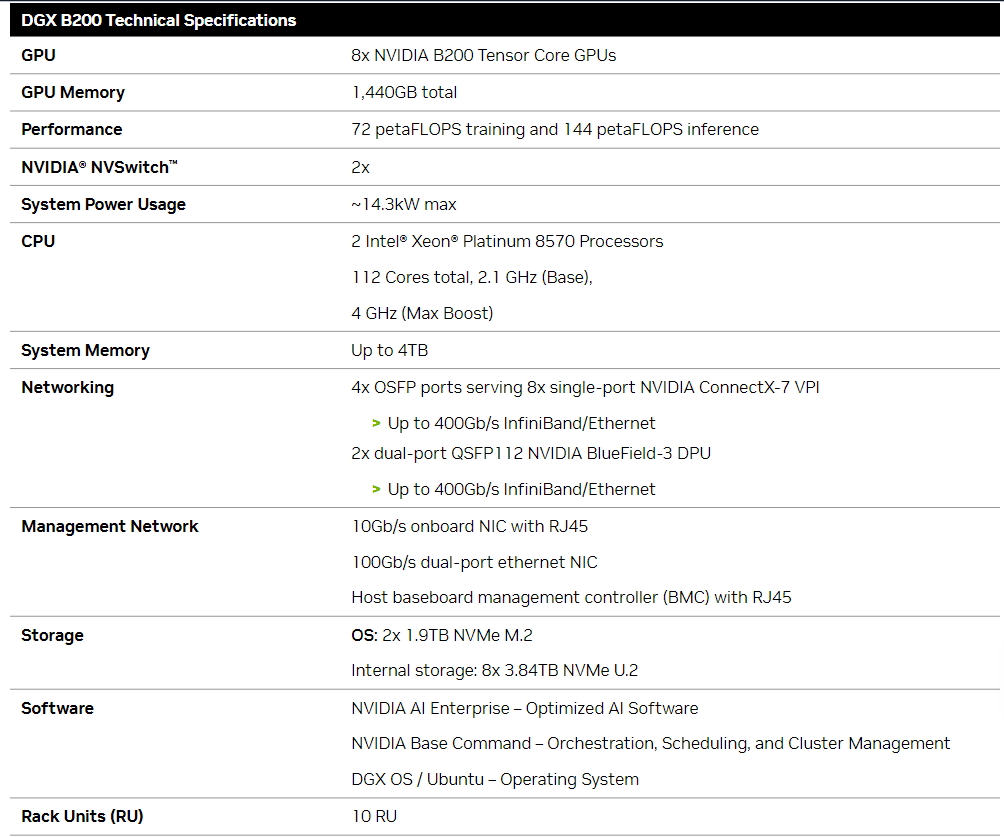

NVIDIA cũng đã giới thiệu hệ thống NVIDIA DGX B200, một nền tảng siêu máy tính AI thống nhất cho việc huấn luyện mô hình AI, điều chỉnh và suy luận.DGX B200 là thế hệ thứ sáu của các thiết kế DGX được làm mát bằng không khí, gắn trên rack truyền thống được sử dụng bởi các ngành công nghiệp trên toàn thế giới.

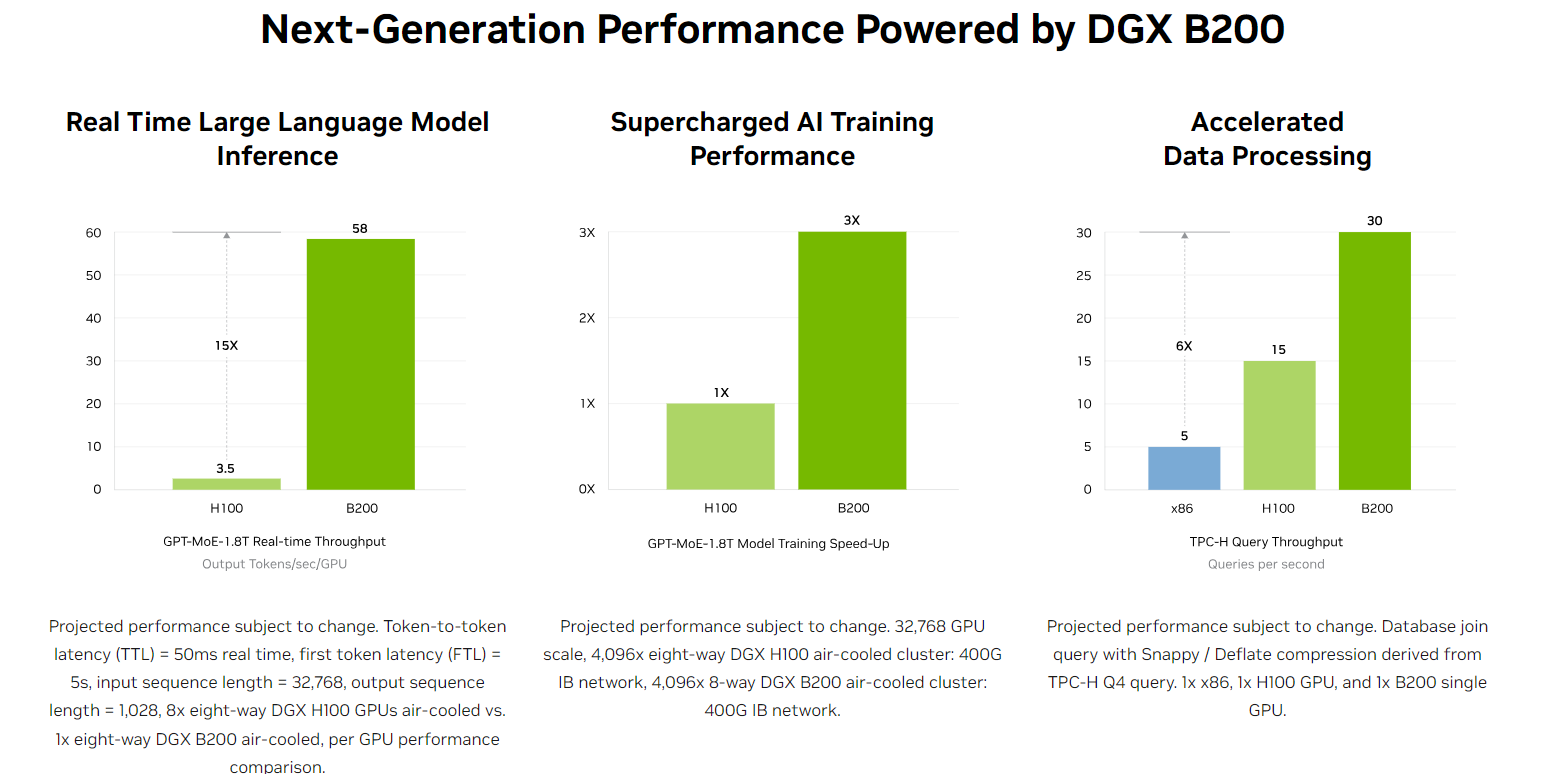

Hệ thống DGX B200 mới sử dụng kiến trúc Blackwell bao gồm tám GPU Blackwell của NVIDIA và hai bộ xử lý Intel® Xeon® thế hệ thứ 5. Khách hàng cũng có thể xây dựng DGX SuperPOD bằng cách sử dụng các hệ thống DGX B200 để tạo ra các Trung Tâm Tinh Thần AI có thể năng lượng cho công việc của các nhóm phát triển lớn chạy nhiều công việc khác nhau.

Các hệ thống DGX B200 bao gồm tính năng độ chính xác FP4 trong kiến trúc Blackwell mới, cung cấp lên đến 144 petaflops của hiệu suất AI, một lượng bộ nhớ GPU lớn là 1.4TB và băng thông bộ nhớ 64TB/s. Điều này mang lại hiệu suất suy luận thời gian thực nhanh hơn 15 lần cho các mô hình tỷ tham số so với thế hệ trước đó.

Các hệ thống DGX B200 bao gồm mạng lưới tiên tiến với tám NIC NVIDIA ConnectX™-7 và hai DPU BlueField-3. Chúng cung cấp tới 400 gigabit mỗi giây băng thông cho mỗi kết nối — cung cấp hiệu suất AI nhanh chóng với các nền tảng mạng InfiniBand Quantum-2 của NVIDIA và Spectrum™-X Ethernet của NVIDIA.

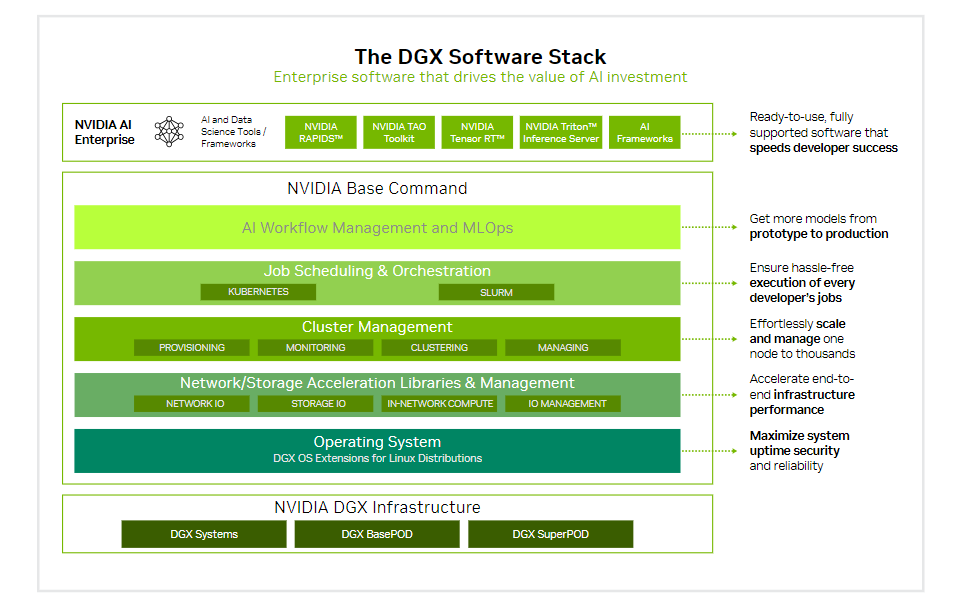

Phần mềm và hỗ trợ chuyên gia để mở rộng AI

Tất cả các nền tảng NVIDIA DGX đều bao gồm phần mềm NVIDIA AI Enterprise để phát triển và triển khai cấp doanh nghiệp. Khách hàng DGX có thể tăng tốc công việc của họ với các mô hình nền tảng được đào tạo trước của NVIDIA, các framework, bộ công cụ và dịch vụ micro mới của NVIDIA NIM được bao gồm trong nền tảng phần mềm.

Các chuyên gia DGX của NVIDIA và một số đối tác được chứng nhận của NVIDIA hỗ trợ các khách hàng trong mọi bước triển khai, giúp họ nhanh chóng chuyển đổi AI vào sản xuất. Khi các hệ thống hoạt động, các chuyên gia DGX tiếp tục hỗ trợ khách hàng trong việc tối ưu hóa các đường ống AI và cơ sở hạ tầng của họ.

Tính sẵn sàng

Dự kiến rằng NVIDIA DGX SuperPOD với các hệ thống DGX GB200 và DGX B200 sẽ có sẵn vào cuối năm nay từ các đối tác toàn cầu của NVIDIA.

→ Để biết thêm thông tin, hãy xem lại bài phát biểu quan trọng của GTC 24 tại đây: https://thegioimaychu.vn/blog/ai-hpc/tom-tat-buoi-keynote-cua-nvidia-gtc-2024-p19257/

Bài viết liên quan

- NVIDIA NGC‑ready Low‑latency Edge AI: Giải pháp cho Retail, Manufacturing và Smart Cities

- So sánh sức mạnh của máy tính AI DGX Spark với các card GPU máy trạm chuyên nghiệp của NVIDIA

- Từ Orin đến Thor: Bước nhảy vọt kiến trúc của NVIDIA JetPack 7.0 và tương lai của robot hình người

- Tại sao gọi NVIDIA DGX Spark là Siêu máy tính AI cá nhân?

- Cơ chế quản lý bộ nhớ trên các nền tảng phần cứng nhất quán – Hardware-coherent

- Kiến trúc NVIDIA Blackwell với GB200 NVL72: Định nghĩa lại điện toán AI cấp độ Exascale