Phiên Keynote của GTC 2024 do CEO NVIDIA Jensen Huang trình bày vừa diễn ra vào lúc 3:00 AM ngày 19/3/2024, giờ Việt Nam. Đây sẽ là một năm quan trọng đối với NVIDIA khi các sản phẩm thế hệ Hopper và Ampere hiện tại của họ ngày càng cũ hơn trên thị trường và trong khi động lực về nhu cầu AI đang bùng nổ hơn bao giờ hết. GTC 2024 được coi là cơ hội để công ty tạo khoảng cách giữa các sản phẩm của mình với tất cả các đối thủ đang cố gắng giành thị phần. Sẽ có rất nhiều thứ ở đây sẽ được công bố.

Đây là bài tường thuật tại chỗ phiên keynote, vì vậy xin vui lòng bỏ qua các lỗi chính tả nếu có. Bạn có thể xem lại buổi live stream qua kênh Youtube chính thức của NVIDIA tại đây:

Phiên Keynote của NVIDIA bắt đầu

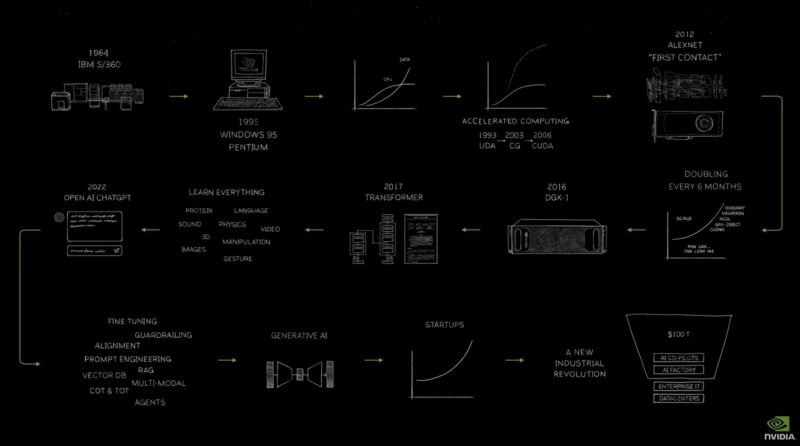

Keynote của Jensen bắt đầu với hành trình của công ty trong hơn hai thập kỷ qua.

Hành trình của NVIDIA đến năm 2024

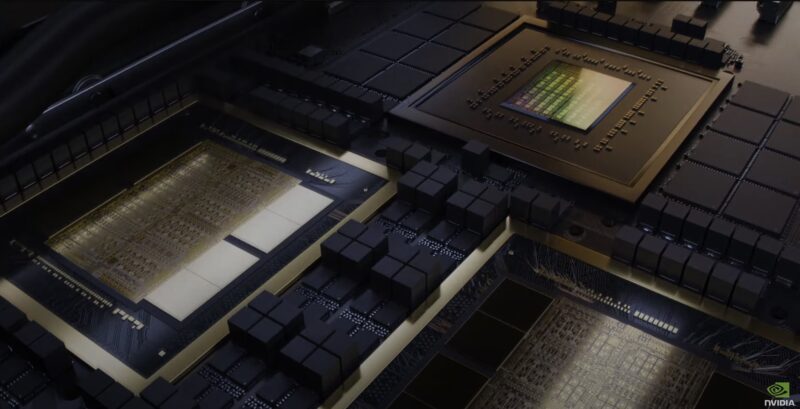

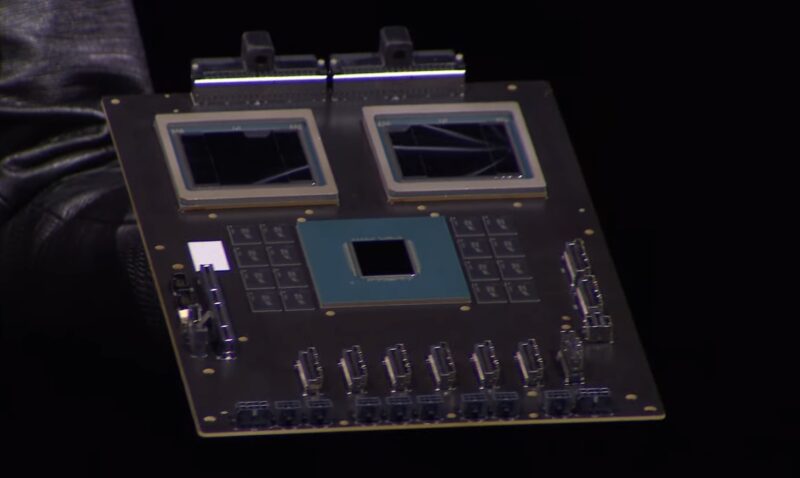

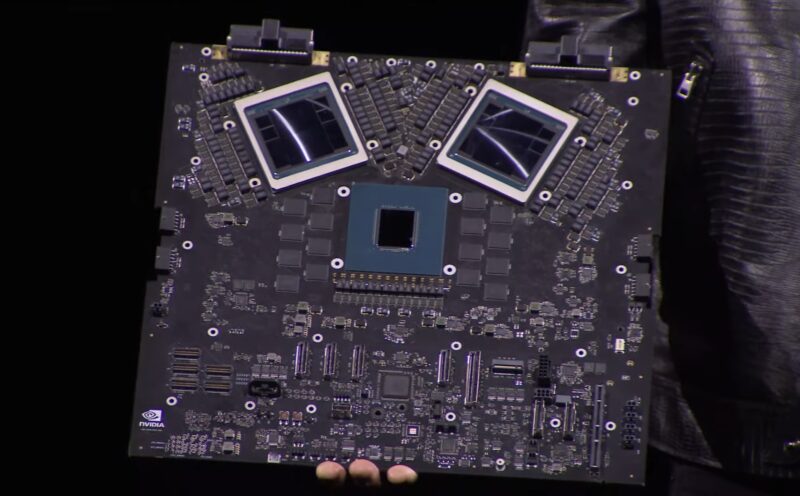

NVIDIA Grace Blackwell sẽ xuất hiện sớm trong Keynote. Ở đây chúng ta có thể thấy CPU Arm được bao quanh bởi các bộ DRAM và hai GPU thế hệ tiếp theo được liên kết. Mỗi GPU Blackwell dường như có tám bộ HBM và hai khối compute trong ảnh này.

Cận cảnh NVIDIA Grace Blackwell

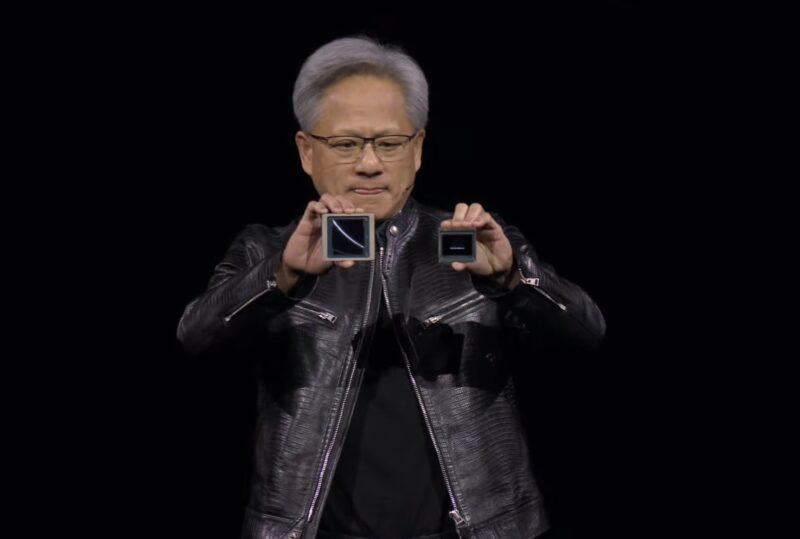

Đây là Blackwell và Hopper ở cạnh nhau.

NVIDIA Blackwell và Hopper

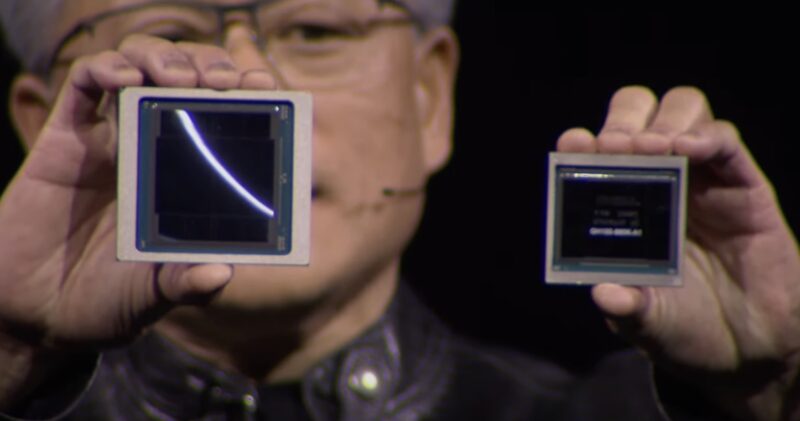

Đây là ảnh cận cảnh.

Cận cảnh NVIDIA Blackwell và Hopper

NVIDIA có thiết kế GPU Blackwell cho các hệ thống DGX/HGX hiện có, DGX B100 và HGX B100 dành cho máy chủ x86. Nó được thiết kế với công suất ~700W để có thể hoạt động trong các hệ thống hiện có.

NVIDIA Blackwell HGX B100

Đây là NVIDIA Grace Blackwell với hai GPU Blackwell và một CPU Grace có bộ nhớ cho mỗi GPU. Có thể thấy NVLink ở đầu bo mạch và PCIe ở cuối bo mạch.

Board mạch của NVIDIA Grace Blackwell GB200  NVIDIA ConnectX 8

NVIDIA ConnectX 8

Đây là Arm và NVIDIA trong tương lai. Đây là board phát triển bên dưới với board sản xuất bên trên.

Board phát triển NVIDIA Grace Blackwell

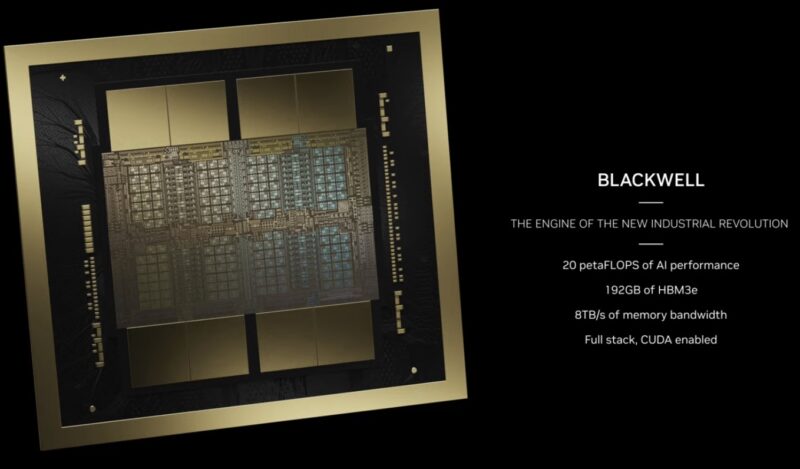

Dưới đây là thông số kỹ thuật trên GPU Blackwell với 192GB HBM3e, trông giống như lớp HBM 8x 8-hi.

Thông số kỹ thuật Blackwell NVIDIA B100

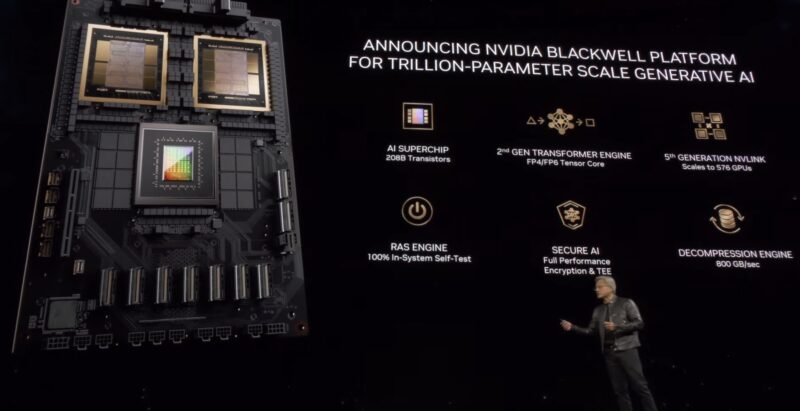

Có những tính năng mới như transformer engine mới có thể xử lý FP4 và FP6. NVLink thế hệ thứ 5, RAS, Secure AI và engine giải nén.

Các tính năng của nền tảng NVIDIA Blackwell

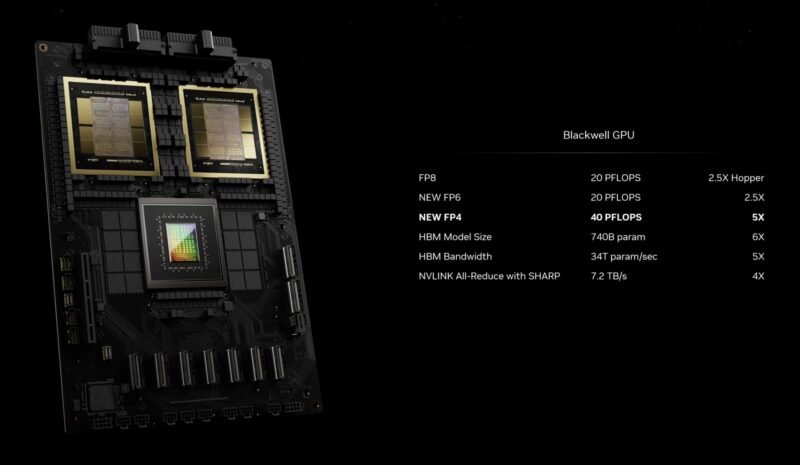

FP4 và FP6 tăng thêm hiệu suất đáng kể so với Hopper.

Hiệu suất NVIDIA Blackwell

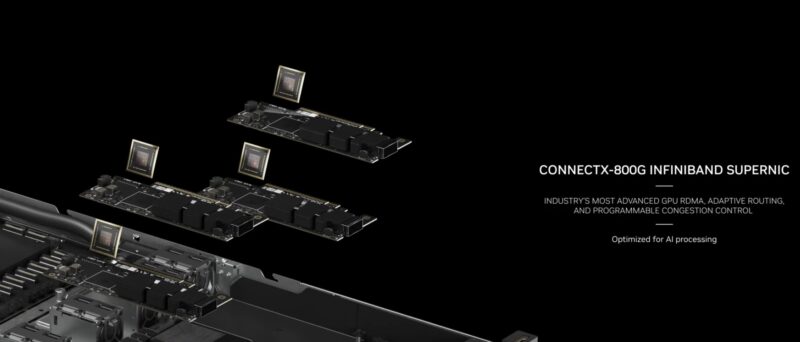

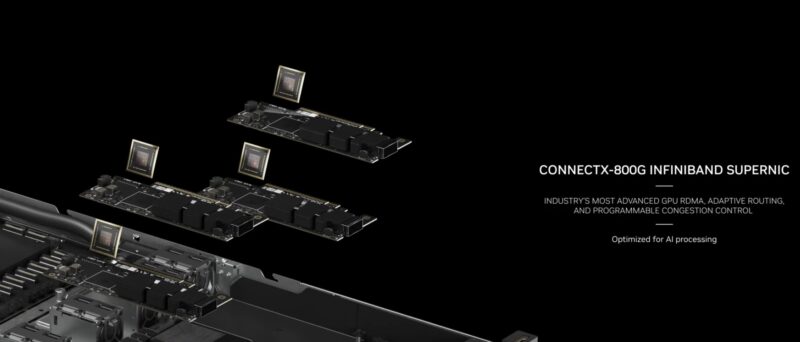

NVIDIA cũng đã công bố ConnectX-8/ConnectX-800G Infiniband. Mạng 800GBps đã có ở đây, vì vậy đây chỉ có thể là PCIe Gen6.

NVIDIA ConnectX 8

Điều thú vị là NVIDIA vẫn đang sử dụng DPU BlueField-3 chứ không phải thế hệ mới hơn. Điều này có vẻ kỳ lạ vì mọi thứ khác đều đã có bản sửa đổi.

Đây là bộ switch NVIDIA Quantum Infiniband 800Gbps.

Switch Quantum 800Gbps của NVIDIA

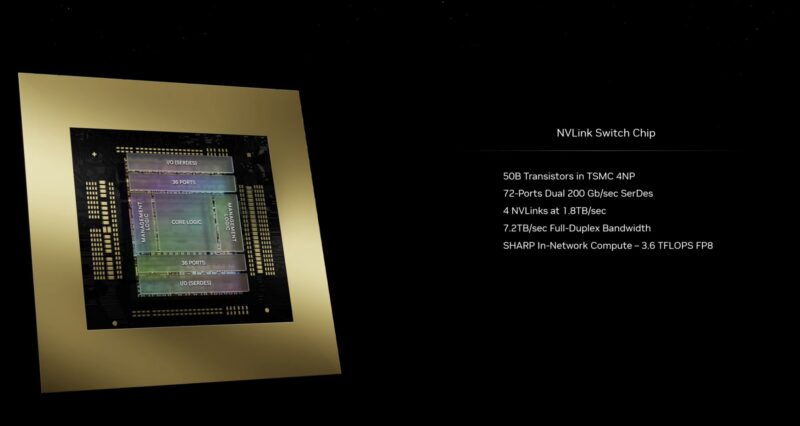

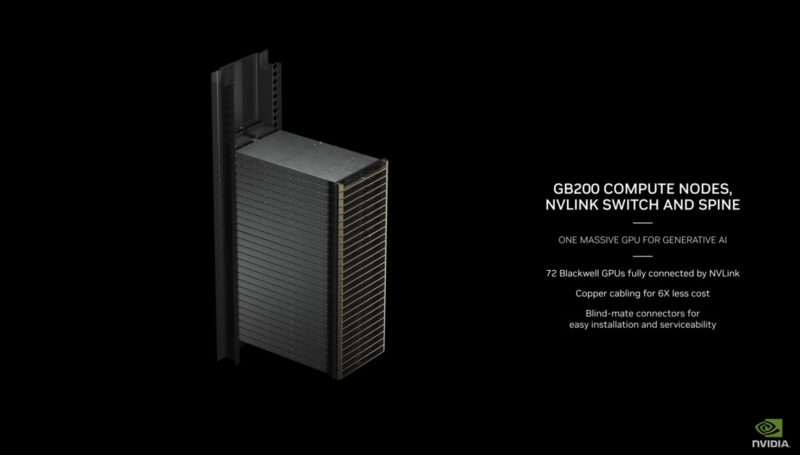

Đây là chip switch NVLink mới. Nó là một nhân tố quan trọng vì những hãng khác trong ngành không có giải pháp scaling tương tự như thế này.

Chip NVLink switch

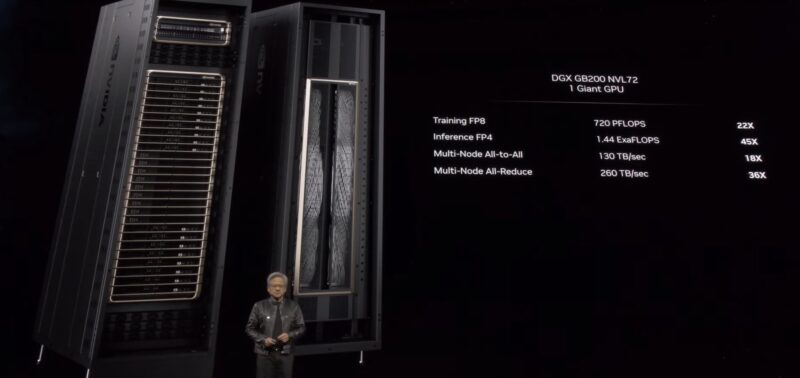

Đây là NVIDIA DGX GB200 NVL72 mới. Với 72 GPU Blackwell được kết nối bởi NVLink.

GPU NVIDIA GB200 72 Blackwell được kết nối hoàn toàn bởi NVLink

Đây là hệ thống DGX được làm mát bằng chất lỏng và hỗ trợ NVLink. Điều này khác biệt hơn nhiều so với các hệ thống DGX hiện tại. Nó nằm ở khoảng 120kW.

NVIDIA DGX GB200 NVL72

Đây là bó cáp NVLink bằng đồng giúp tiết kiệm được khoảng 20kW điện năng.

NVIDIA DGX GB200 NVL72 NVLink Spine không có sợi quang

Ngoài ra còn có các switch trong chassis NVIDIA GB200 với hai tổ hợp GB200.

Bộ chuyển mạch NVLink nội bộ NVIDIA GB200

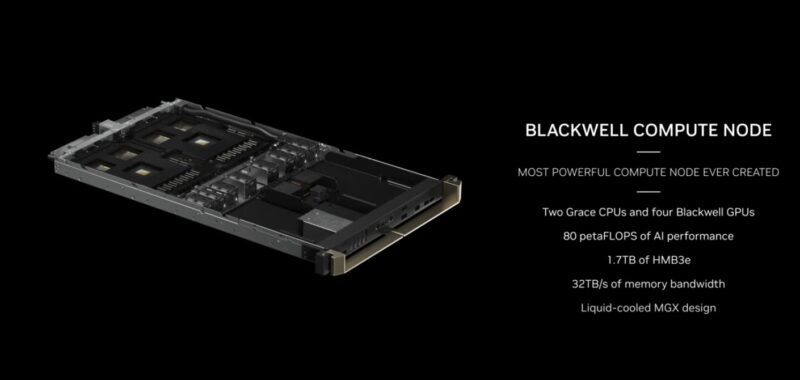

Dưới đây là tổng quan về conpute node NVIDIA Blackwell.

Compute node NVIDIA Blackwell

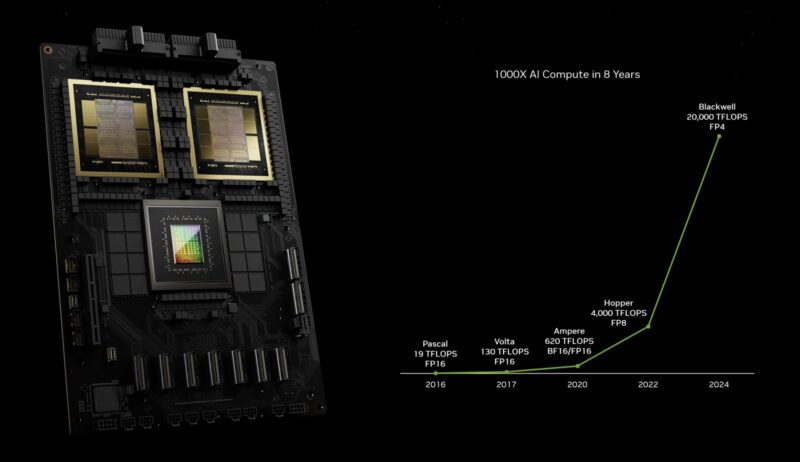

Đây là tác động của chỉ riêng GPU đến hiệu suất của Pascal. NVIDIA đã làm rất nhiều việc như thêm Tensor Core, thay đổi độ chính xác, v.v. để đạt được điều này, ngoài việc thu nhỏ tiến trình và nhồi nhét thêm transistor vào một con chip.

NVIDIA Pascal To Blackwell Compute – Mở rộng quy mô cho AI

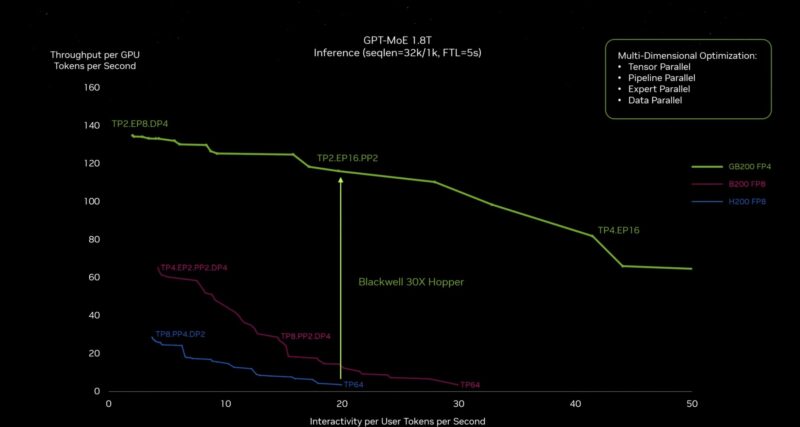

NVIDIA cho biết Blackwell có hiệu suất gấp khoảng 30 lần Hopper nhờ NVSwitch mới và transformer engine FP4 mới. Đường màu tím sẽ là điều sẽ xảy ra nếu NVIDIA chế tạo một Hopper lớn hơn với nhiều bóng bán dẫn hơn.

NVIDIA Blackwell To Hopper – Hiệu suất suy luận

Nếu bạn là một công ty khác sản xuất máy tính tăng tốc cho AI có quy mô tương đương NVIDIA, điều này sẽ khiến bạn lo lắng. AWS, Google, Microsoft và các OEM/ODM là khách hàng của Blackwell.

NVIDIA vừa cho thấy Apple Vision Pro hoạt động trong Omniverse. Điều đó sẽ mở ra một thị trường lớn cho Apple.

Apple Vision Pro và NVIDIA Omniverse

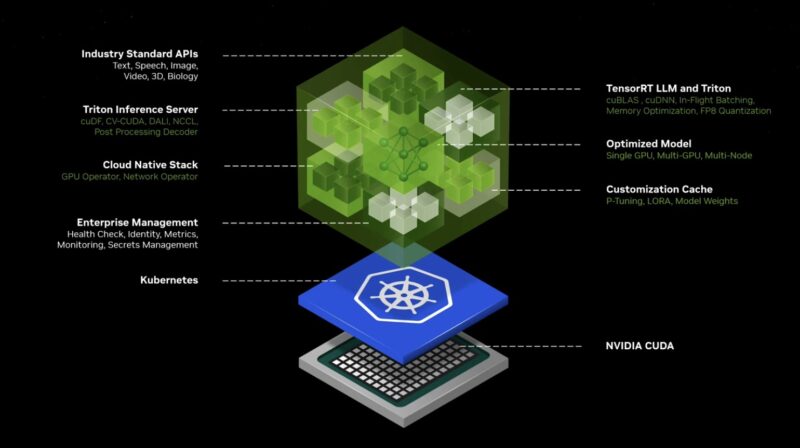

NVIDIA đang đóng gói các mô hình được đào tạo trước với các phần phụ thuộc và giúp dễ dàng triển khai các dịch vụ mà họ gọi là NVIDIA Inference Microservices hay NIMS. Đây không chỉ là CUDA. Điều này làm cho các mô hình trở nên dễ thực hiện.

NVIDIA Inference Microservice NIMS

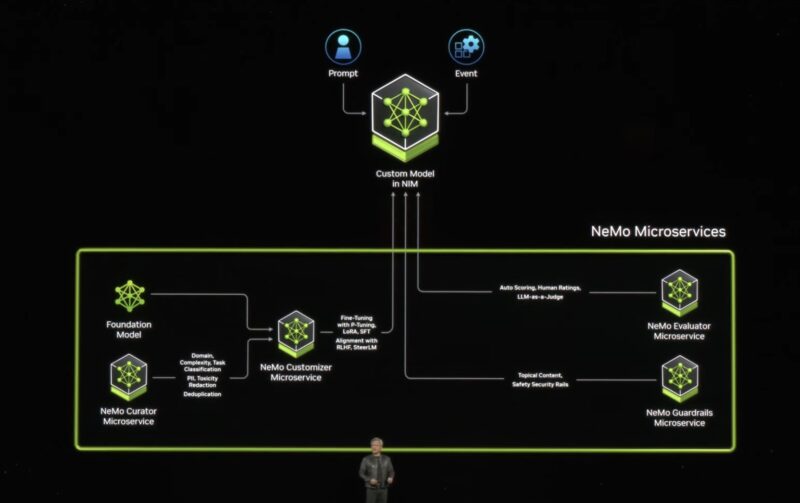

NVIDIA sẽ giúp tinh chỉnh mô hình hoặc tùy biến mô hình cho các công ty và ứng dụng.

NVIDIA NeMo Microservices

Với NVIDIA DGX Cloud, NVIDIA mong muốn trở thành nhà xưởng AI (AI foundry), giống như “TSMC cho AI”.

NVIDIA Drive Thor sẽ được BYD áp dụng cùng với những hãng khác.

Ổ đĩa NVIDIA Thor

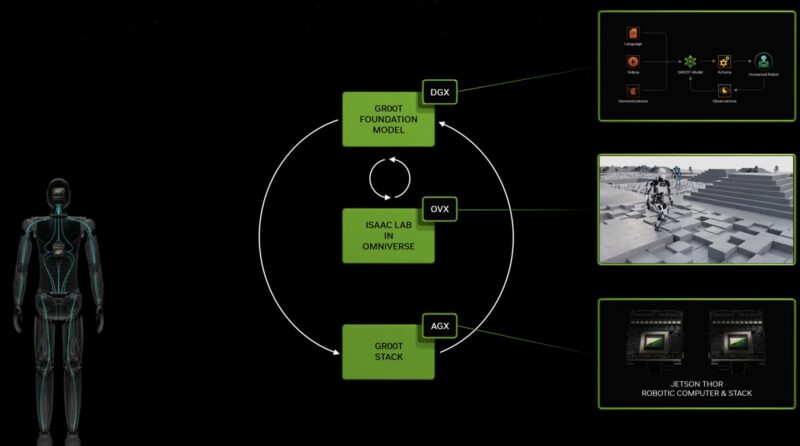

NVIDIA Jetson Thor dành cho robot cập nhật mới NVIDIA Jetson Orin. Một trong những vụ đặt cược lớn mà NVIDIA đang thực hiện là thế hệ tiếp theo có thể điều khiển robot hình người. NVIDIA cũng đang xây dựng một kho phần mềm cho việc này.

NVIDIA Jeton Thor dành cho robot hình người

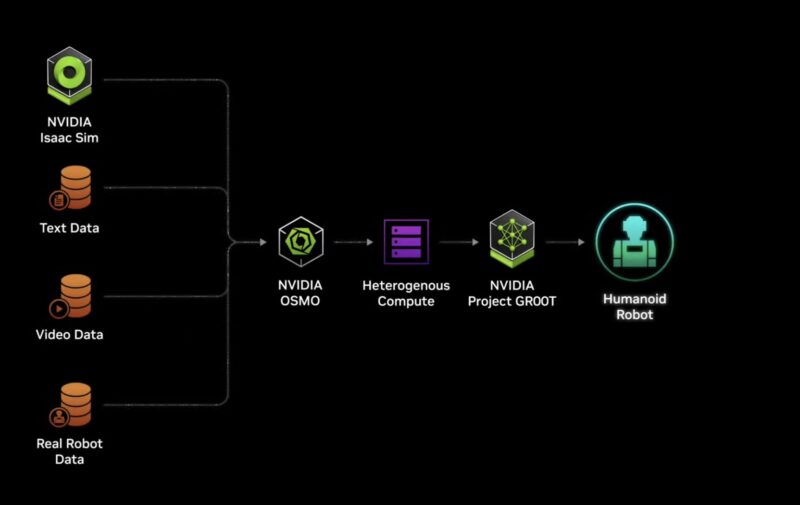

Thế giới được tạo ra cho con người, vì vậy ý tưởng là các robot hình người mới sử dụng NVIDIA Thor và phần mềm từ NVIDIA Project GR00T để huấn luyện và quản lý chúng.

NVIDIA GR00T

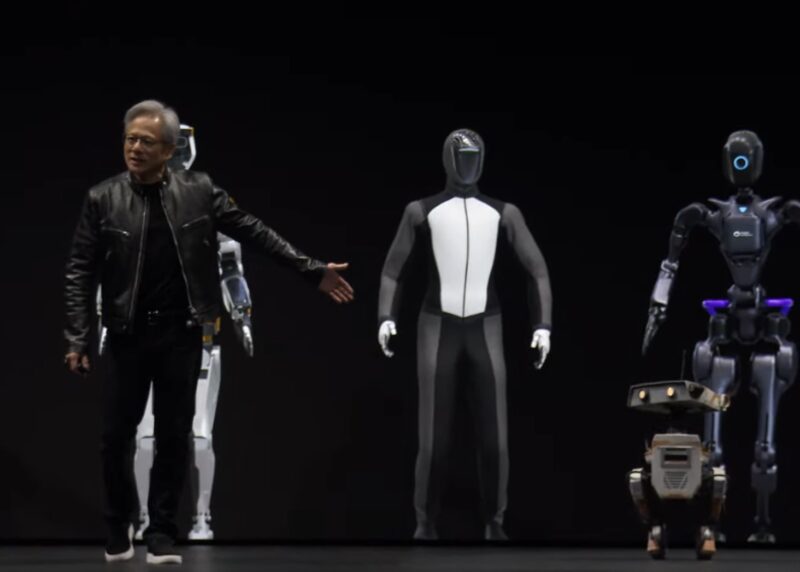

Jensen bước lên sân khấu với các robot hình người do công ty cung cấp, bao gồm cả các robot nhỏ hơn của Disney đã học cách đi bộ trong NVIDIA Isaac SIM.

NVIDIA GR00T và Robot

NVIDIA đang cố gắng kết nối thế giới kỹ thuật số với thế giới vật lý thông qua robot. Đi từ các sản phẩm trung tâm dữ liệu của công ty đến biên. Đó là tầm nhìn từ GTC này.

Lời cuối

NVIDIA hiện đã phác thảo danh mục sản phẩm mới của mình trên các lĩnh vực mạng, kết nối AI tốc độ cao, CPU trung tâm dữ liệu, GPU, cụm máy chủ, AI tại biên, robot, y tế, v.v. Trong vài tuần và tháng tới, tất cả các đối thủ cạnh tranh của NVIDIA sẽ cần phải có phản hồi của riêng họ. Trong nhiều năm qua, có thể thấy rằng rất khó cho các đối thủ để cạnh tranh với NVIDIA nhằm cố gắng làm điều gì đó tương tự.

NTC Tổng hợp

Bài viết liên quan

- NVIDIA NGC‑ready Low‑latency Edge AI: Giải pháp cho Retail, Manufacturing và Smart Cities

- So sánh sức mạnh của máy tính AI DGX Spark với các card GPU máy trạm chuyên nghiệp của NVIDIA

- Từ Orin đến Thor: Bước nhảy vọt kiến trúc của NVIDIA JetPack 7.0 và tương lai của robot hình người

- Tại sao gọi NVIDIA DGX Spark là Siêu máy tính AI cá nhân?

- Cơ chế quản lý bộ nhớ trên các nền tảng phần cứng nhất quán – Hardware-coherent

- Kiến trúc NVIDIA Blackwell với GB200 NVL72: Định nghĩa lại điện toán AI cấp độ Exascale